用更少GPU完成更多计算量,中文巨量模型源1.0比GPT-3强在哪里?

关注并星标

从此不迷路

计算机视觉研究院

公众号ID|ComputerVisionGzq

学习群|扫码在主页获取加入方式

计算机视觉研究院专栏

作者:Edison_G

语言大模型的终极目标是什么?

转自《机器之心》

在自然语言处理(NLP)领域,暴力美学仍在延续。

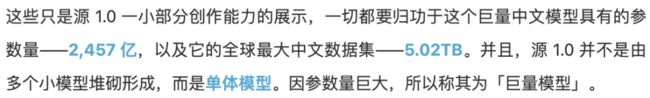

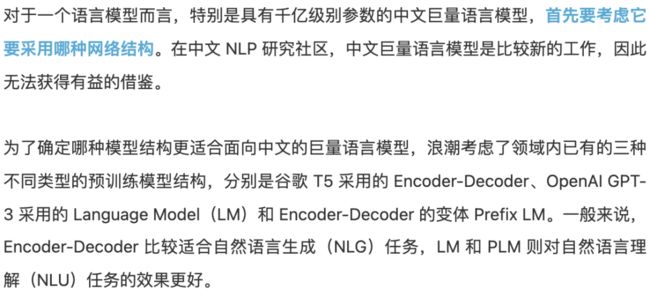

源 1.0 与 GPT-3 的参数量、算力对比。

训练源 1.0 解决的二三难事

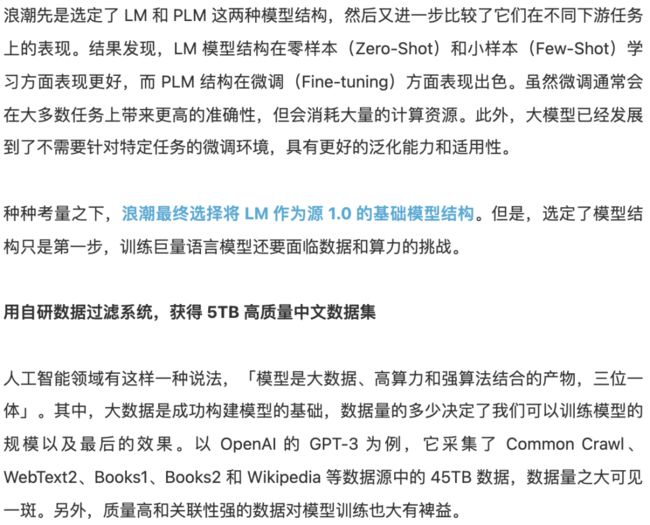

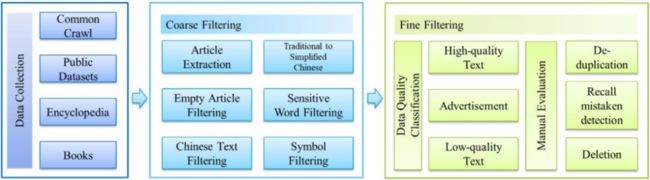

MDFS 系统的流程图。

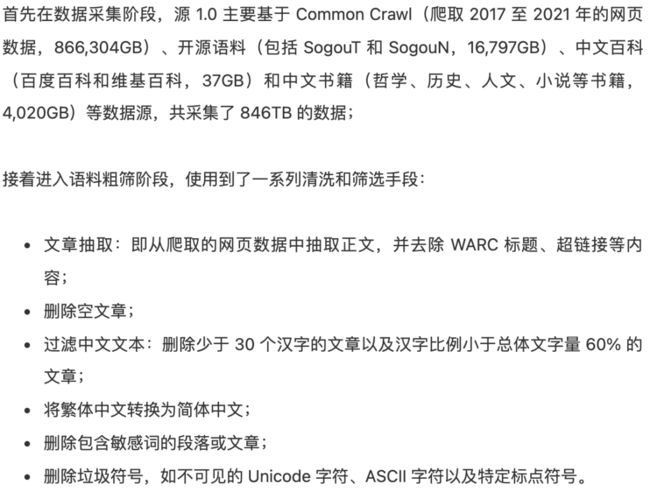

精筛后数据大小与原始语料大小对比。

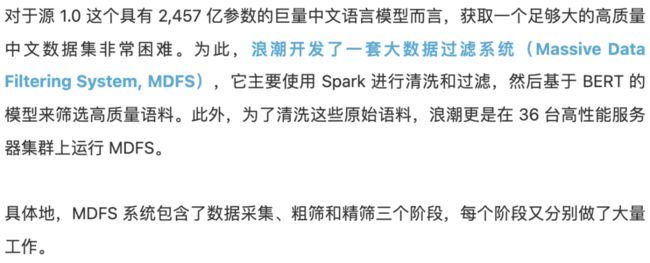

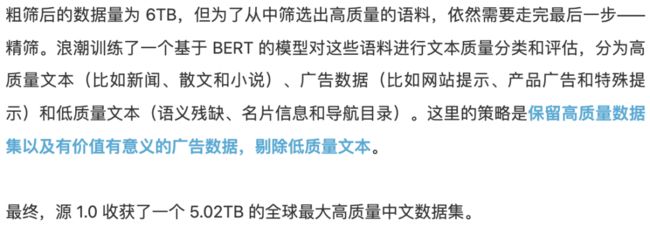

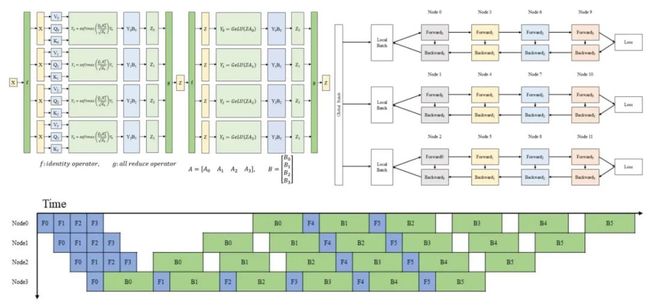

图上左为张量并行,上右为数据并行,图下 为流水线并行。

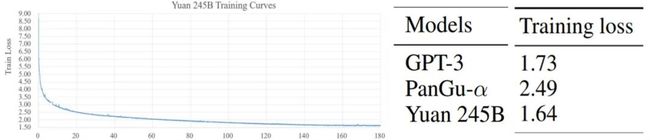

源 1.0 的模型训练损失(training loss)曲线如下,可以看到,loss 值在前 10B 个 tokens 期间迅速下降,之后下降较慢并趋于稳定,形成一个长尾。并且,源 1.0 的训练损失数值(1.64)小于 GPT-3(1.73)和 PanGu-α(2.49)。

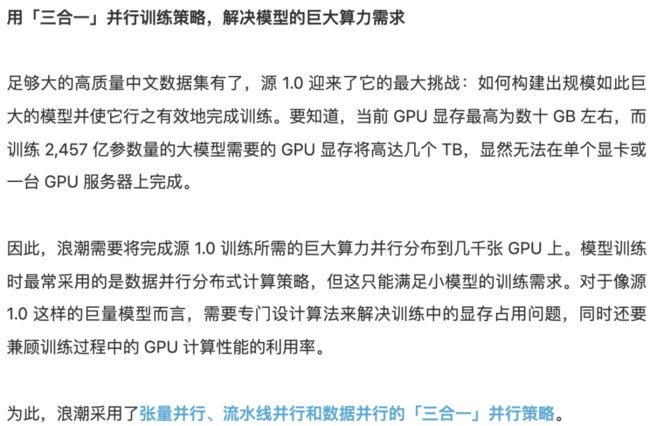

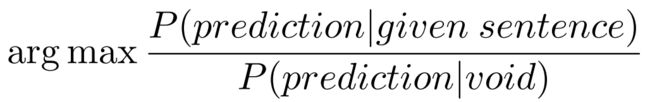

以 Tnews 任务为例,计算 sentence-lable 中 label 的概率。

原始:新闻:sentence。这条新闻是关于 label。

校准:新闻:N/A。这条新闻是关于 label。

代入上述计算公式后,如下所示:

通过这种空文本替换的方式,源 1.0 能够避免在固定句式表达学习上出现过拟合现象,实现小样本学习效果。

另一方面,在零样本或小样本设置下,标签在语料中出现的频率差异会对模型预测结果产生影响。理想状态下,所有标签在词表中的位置,即在语料中的出现频率,应该大致相同,但手动选择符合条件的标签非常困难。源 1.0 使用了一个涵盖 800 万个中文单词和短语的嵌入语料库,基于相似度为每个标签扩展 5 个同义词,从而扩充数据集,缓解标签分布不平衡问题,消除单个标签词带来的偏差。

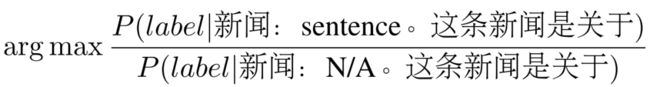

概率校准和标签扩充提升了源 1.0 在零样本或小样本学习设置下的精度。以 Csldcp 和 Tnews 多分类任务以及 Eprstmt 情感分类任务为例,概率校准和标签扩充为模型带来了精度的提升。

源 1.0 到底有多强大?

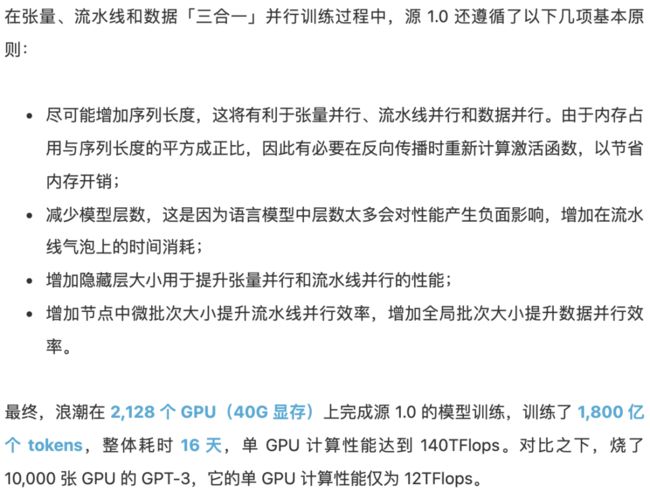

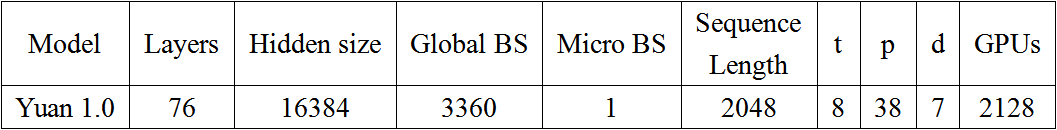

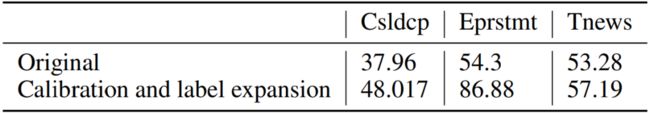

2,457 亿参数、5TB 高质量中文数据集、2,128 张 GPU 上训练 16 天……,这些都为源 1.0 强大的语言智能打好了基础。源 1.0 也不负众望,在中文语言理解测评基准 CLUE 中取得了优异的表现。

在 ZeroCLUE 零样本学习榜中,源 1.0 在文献分类(CSLDCP)、新闻分类(TNEWSF)、长文本分析(IFLYTEKF)、成语阅读理解(CHIDF)、文献摘要识别(CSLF)和名词代词关系(CLUEWSCF)六项任务上摘得榜首。其中,在成语阅读理解单项任务上甚至超越了人类水平。

榜单详情参见:https://www.cluebenchmarks.com/zeroclue.html

在 FewCLUE 小样本学习榜中,源 1.0 在文献摘要识别(CSLF)和名词代词关系(CLUEWSCF)两项任务上摘得榜首。

榜单详情参见:https://www.cluebenchmarks.com/fewclue.html

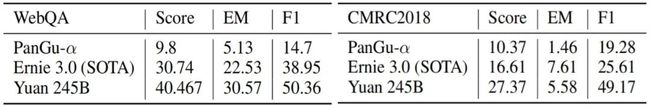

此外,源 1.0 在闭卷问答任务 WebQA 和文本提取任务 CMRC2018 中也表现得非常好。在这两个任务的测试中,模型直接回答 WebQA 和 CMRC2018 的问题,并且不提供任何辅助信息。

在与 PanGu-α 和 Ernie 3.0(SOTA)的比较结果可知,在 WebQA 任务上,源 1.0 在平均分数、EM 和 F1 上均实现了显著提升;对于 CMRC2018 任务,源 1.0 刷新了最优的平均分数和 F1 分数,只在 EM 分数上稍逊于 Ernie 3.0。

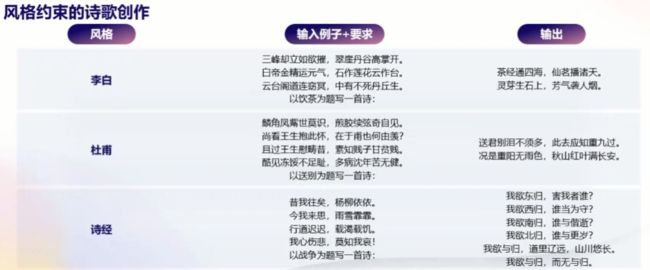

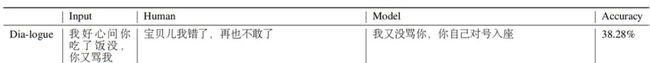

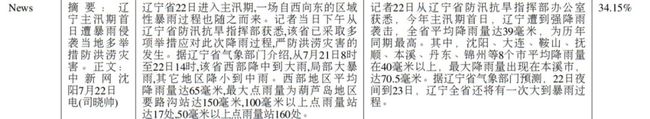

刷榜只是语言模型性能强弱的一个侧面体现,源 1.0 的创作能力在对话、故事、新闻、诗歌和对联等多样性场景中得到了进一步验证。在这些场景任务中,浪潮创建了一场「图灵测试」,用于比较源 1.0 模型生成的文本与人类创作的真实文本,并分辨出这些文本哪些「由模型生成」哪些「由人类创作」。

具体地,浪潮任意选择了源 1.0 生成的 24 篇文章,包括 4 副对联、5 首中文传统和现代诗歌、5 篇新闻文章、5 个故事和 5 段对话。其中,对联、诗歌和对话的创作被视为短文本任务,新闻和故事生成被视为长文本任务。与这些对比的人类创作的文章出自名家所作的诗歌、经典小说、搜狐新闻的新闻文章和 LCCC-large 数据集中的对话。对此,浪潮共收集了 83 份有效问卷。

结果显示,源 1.0 生成的文章只有 49.16% 的概率被正确识别为「由模型生成」,这意味着受访者难以区分人类和模型生成的文章,尤其是在对话和新闻生成这两个场景,误判率分别为 54.32% 和 57.88%。不过可以看到,由于源 1.0 的预训练语料中没有加强古汉语,源 1.0 在诗歌和对联生成场景表现相对不佳,但仍具备生成带有一定格式和格律的文本的能力。

目前,源 1.0 能够生成多种高质量的文本,如对话、新闻稿件、故事续写等。对于这些类别的任务,模型生成的文本与人类创作的内容相差无几,甚至达到了以假乱真的程度。

先以如下对话场景为例,受访者正确分辨出「由模型生成」答案的概率仅为 38.28 %,这意味着源 1.0 在对话任务上做到了非常情景化,回答也接近人的讲话风格。

再来看新闻生成场景,给出摘要,然后续写正文,受访者正确分辨出「由模型生成」新闻的概率为 34.15 %。源 1.0 生成的文本不仅较人类撰写的篇幅更多,显然也更符合新闻用语环境。

但应看到,源 1.0 等大模型的应用场景绝对不会止步于此。12 月 11 日,机器之心举办了 NeurIPS MeetUp China,浪潮信息副总裁、人工智能 & 高性能计算 (AI&HPC) 产品线总经理刘军做了主题为《AI 大模型时代的浪潮思考与实践》演讲。他认为,未来大模型还将可能在更多应用场景中发布作用,如运营商文本类日志和报告的提取和总结、元宇宙中 AI Robot 的语言生成、理解和对话等。

语言大模型的极限在哪里?目前似乎没有哪家科技企业能够清楚地指明。浪潮的源 1.0 中文巨量语言模型,在探索 AI 拟人能力这条路上走出了坚实的一步。

最后,对刘军演讲内容感兴趣的读者,请戳以下视频:

© The Ending

转载请联系本公众号获得授权

计算机视觉研究院学习群等你加入!

计算机视觉研究院主要涉及深度学习领域,主要致力于人脸检测、人脸识别,多目标检测、目标跟踪、图像分割等研究方向。研究院接下来会不断分享最新的论文算法新框架,我们这次改革不同点就是,我们要着重”研究“。之后我们会针对相应领域分享实践过程,让大家真正体会摆脱理论的真实场景,培养爱动手编程爱动脑思考的习惯!

扫码关注

计算机视觉研究院

公众号ID|ComputerVisionGzq

学习群|扫码在主页获取加入方式

往期推荐

优于FCOS:在One-Stage和Anchor-Free目标检测中以最小的成本实现最小的错位(代码待开源)

改进的YOLOv5:AF-FPN替换金字塔模块提升目标检测精度

用于吸烟行为检测的可解释特征学习框架(附论文下载)

图像自适应YOLO:恶劣天气下的目标检测(附源代码)

新冠状病毒自动口罩检测:方法的比较分析(附源代码)

NÜWA:女娲算法,多模态预训练模型,大杀四方!(附源代码下载)