A Survey on Neural Speech Synthesis

neural TTS的3个关键组件

文本分析器

文本分析即为将文本转化为语言特征(phoneme和韵律特征)

主要任务:

- 文本归一化(将原始书面语(非标准词)通过文本规范化转化为口语词汇)

- 分词(检测单词边界)

- 词性标注(POS)

- 韵律(语音的节奏、重音和语调,对应着音节时长、响度和音高的变化)

- 预测和字素-音素转换[主要负责生成词汇表外单词的发音(英)/多音音消歧(汉)]

声学模型

声学模型从语言特征或直接从音素或字符生成声学特征

声学模型分为两个时期

- SPSS 中的声学模型

通常从语言特征中预测 MGC、BAP 和 F0 等声学特征;

2.基于神经的端到端 TTS 中的声学模型

从音素或字素预测梅尔谱图/更高维的线性频谱图

其中Tacotron 1/2, DeepVoice 3和TransformerTTS都存在自回归mel谱图生成速度慢,生成的语音通常存在大量的跳过、重复和问题(主要是由于在基于编码器-注意-解码器的自回归生成中,文本和mel谱图之间的注意对齐不准确造成的)。

因此,提出了FastSpeech来解决这些问题,FastSpeech通过并行生成mel谱图,大大加快了合成过程;FastSpeech使用音素持续时间预测器减少了跳过单词和重复单词的比率。

总结:声学模型越fully端到端越好、越非自回归越好、预测时长优于自注意力机制对齐

声码器

声学模型分为两个时期

- SPSS 中的声学模型:

- 以WORLD声码器为例,WORLD声码器包括声码器分析和声码器合成步骤,在声码器分析中,它对语音进行分析,得到梅尔倒谱系数、频带非周期性和F0等声学特征。在声码合成中,它从这些声学特征生成语音波形。

2.神经声码器包括:

- 自回归声码器

例WaveNet几乎不包含有关音频信号的先验知识,并且纯粹依赖于端到端学习实现了良好的语音质量,但它的推理速度很慢

- 基于流的声码器

- 基于 GAN 的声码器

- 基于 VAE 的声码器(variational auto-encoder变分自编码器)

- 基于扩散的声码器

其基本思想是用扩散过程和逆过程来制定数据与潜在分布的映射关系:在扩散过程中,波形数据样本逐渐加入一些随机噪声即高斯噪声;在逆过程中,随机高斯噪声逐步被逐步去噪为波形数据样本。生成语音质量高,迭代速度慢

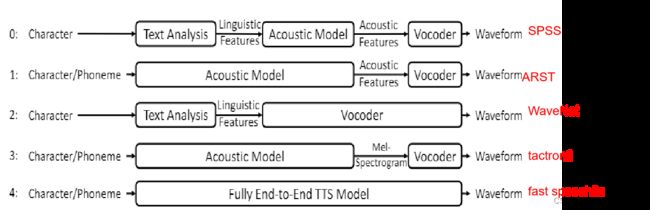

TTS模型的逐步端到端过程以及TTS管道中的数据流:

可研究的前沿topic

| 可研究的前沿topic |

产生原因 |

可使用的技术/方法 |

| 加速train和interference |

非自回归生成利用并行计算来加速推理、轻量化的模型、相关领域知识(数字信号处理中的FFT变换在保持小模型的同时提高语音质量) |

|

| 在low 数据集上训练 |

自监督训练、利用资源丰富语言中的配对数据预训练、将其他说话人的声音转换为目标声音来增加训练数据、语音链和反向转换(利用额外的未配对文本和语音数据来提高TTS和ASR的性能)、用语音增强 去噪和解纠缠等技术来提高挖掘wild语音数据的质量 |

|

| 鲁棒性TTS(能合成自然度很高且不跳词不重复的TTS) |

很难学习characters/phonemes和mel频谱之间的对齐 |

增强注意机制、(去除注意力机制)预测语音持续时间以弥补文本和语音长度的不匹配 |

| 暴露偏差和误差传播 |

改进自回归(数据增强)、使用非自回归生成 |

|

| 合成有表现力的语音(表现力是由内容、音色、韵律、情感、风格等多重特征决定的。) |

对variance information进行建模、控制、转换、从声音中分离(对抗训练) |

|

| 自适应语音合成[合成适应不同风格/不同和说话人的语音/跨语言(比如在只有英文语音的时候想合成普通话语音,但训练数据中只有英文语音),高效自适应(用很少数据及很少的参数生成质量高的语音)] |

情感语音合成的两种方式

- 将情感信息编码到语言信息中,使用语言信息和情感信息直接合成目标情感语音;

- 在没有任何表达信息下合成中性语音,然后使用一个合适声音转换技术添加期望的情感表达信息。

情感语音合成的发展历程

传统的情感语音合成方法可分为基于波形拼接合成(基于数据驱动合成)、基于共振峰合成(也称基于规则合成)和基于HMM合成法。

Unit Select

特点:需要一个大语音数据库支撑

不足:这种启发式的方法通常不能够产生任意讲话人的情感,语音合成的质量较低。

基于共振峰合成

特点:完全通过对各种情感语音的声学相关的规则来创建声学语音数据。

优缺点:尽管降低了自然度,但可以高度的灵活的对声学参数进行控制。

基于隐马尔可夫模型(Hidden Markov model,HMM)的方法

优缺点:受人为干扰的影响较小,但由于其生成的是均值矢量参数序列,合成的声音过于平滑,无法有效表达需要的情感。

基于神经网络和韵律修改的端到端情感语音合成(对与情感表达有关的variance information进行建模)

Expressive TTS

variance information分类

内容、说话人特征、韵律、通道效应四个类别

韵律

韵律包括语调、重音和语音节奏,并表示如何说出文本。韵律是提高语音表达能力的关键信息,而绝大多数关于表达性TTS的工作都集中在提高语音的韵律上

与韵律特征有关的声学特征:基频、能量、时长、第一共振峰频率、第二共振峰频率、第三共振峰频率和 mfcc

韵律特征和声学特征之间的关系:

- 基频决定音调,音调高情感的激活度高

- 时长决定语速,语速快情感的激活度高

- 能量决定强度,能量变化幅度大情感的激活度高

对显式variance information建模

我们直接使用variance information作为输入来增强表达合成的模型,如Fast Speech,Fast Speech2,Fast Speech2s可手动控制合成音频的音高、持续时间和能量。

对隐式variance information建模

- Reference encoder

在推断过程中,它可以使用参考音频来提取 prosody embeddings,或简单地选择一个或一些style tokens来合成语音。例如GST-Tacotron、Prosoty-Tacotron

2.Advanced generative models

使用高级生成模型(如VEW,Flow,GAN,Diffusion)隐式学习variance information,从而更好地对多模态分布进行建模

现有方法的不足:利用参考编码器或显式韵律特征(例如,音高、持续时间、能量)进行variance information建模,在推理中具有良好的可控性和可转移性,但由于训练中使用的ground-truth参考语音或韵律特征通常在推理中不可用,因此存在训练/推理不匹配的问题。Advance TTS 模型隐含地捕获变化信息,在合成语音中具有良好的表现力,但在控制和传输方面表现不佳,因为从潜在空间采样不能明确和精确地控制和传输每个韵律特征(例如,音调、风格)。

对different information granularity的variance information建模

不同的信息粒度:

- Language/Speaker Level

- Paragraph Level

- Utterance Level

- Fine-grained information:Word/Syllable Level 、Character/Phoneme Level 、Frame Level

利用覆盖不同粒度的分层结构对方差信息进行建模有助于有表现力的语音合成

TTS的未来研究方向

高质量的语音合成

(决定于清晰度、自然度、表现力、韵律、情感、风格、鲁棒性、可控性)

高质量TTS提升空间:

- 更加强大的生成模型

- 更好的文本和语音表示

- 可以泛化的合成跨文本域的语音

- 更好的variance information建模(更好的控制合成特定风格、更好的转移风格、更好的表现力)

- 随意自发风格(更像人类说话)

高效率的语音合成

少数据少参数低能源效率[训练服务TTS少排碳,减小FLOPS(全称是floating point of per second每秒浮点运算次数)]

References

| 参考文献 | ||||

| ESS方法 | 文献名称 | 收录情况 | 发表时间 | |

| 传统ESS方法 | Algorithms and Methods for Emotional Mandarin Speech Synthesis | ADVANCED RESEARCH ON COMPUTER EDUCATION, SIMULATION AND MODELING | 2011 | |

| 基于神经网络和variance information的ESS |

对显式variance information建模 | FASTSPEECH 2: FAST AND HIGH-QUALITY END-TOEND TEXT TO SPEECH | ICLR(International Conference on Learning Representation) | 2021 |

| 对隐式variance information建模 | Learning latent representations for style control and transfer in end-to-end speech synthesis | international conference on acoustics, speech, and signal processing | 2019 | |

| Expressive Speech Synthesis via Modeling Expressions with Variational Autoencoder | conference of the international speech communication association | 2018 | ||

| Towards Transfer Learning for End-to-End Speech Synthesis from Deep Pre-Trained Language Models | arXiv: Computation and Language | 2019 | ||

| 对different information granularity的variance information建模 | Multi-SpectroGAN: High-Diversity and High-Fidelity Spectrogram Generation with Adversarial Style Combination for Speech Synthesis | national conference on artificial intelligence | 2020 | |

| A Survey on Neural Speech Synthesis | arXiv: Audio and Speech Processing | 2012 | ||