【西瓜书】第六章支持向量机---学习笔记

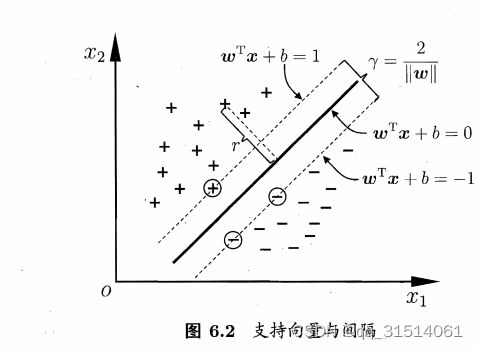

1.间隔与支持向量

1.1算法原理:

对于线性可分数据集,从几何角度,支持向量机就是找距离正负样本都最远的超平面,相比于感知机,其解是唯一的,泛化性能更好。

1.2点 x x x到超平面的距离

r = ∣ w T x + b ∣ ∣ ∣ w ∣ ∣ r = \frac{|w^Tx + b|}{||w||} r=∣∣w∣∣∣wTx+b∣,

假设超平面 ( w , b ) (w,b) (w,b)能将训练样本正确分类,即对于 ( x i , y i ) ∈ D (x_i,y_i)\in D (xi,yi)∈D,则若 y i = + 1 y_i = +1 yi=+1,有 w T x i + b > 0 w^Tx_i + b >0 wTxi+b>0;则若 y i = − 1 y_i = -1 yi=−1,有 w T x i + b < 0 w^Tx_i + b <0 wTxi+b<0;

两个异类支持向量到超平面的距离之和为:

r = 2 ∣ ∣ w ∣ ∣ r = \frac{2}{||w||} r=∣∣w∣∣2

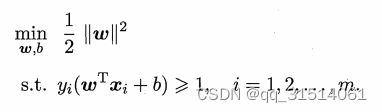

为了最大化间隔,仅需要最大化 ∣ ∣ w ∣ ∣ − 1 ||w||^{-1} ∣∣w∣∣−1于是支持向量机的基本型为:

2.对偶问题

最大间隔划分超平面的模型:

f ( x ) = w T x + b f(x) = w^T x + b f(x)=wTx+b,其中 w 和 b w和b w和b是模型参数,对每条约束添加拉格朗日乘子 α i ≥ 0 \alpha_i \ge0 αi≥0该问题的拉格朗日函数可写为:

L ( w , b , α ) = 1 2 ∣ ∣ w ∣ ∣ 2 + ∑ i = 1 n α i ( 1 − y i ( w T x i + b ) ) L(w,b,\alpha) = \frac{1}{2}||w||^2 + \sum\limits_{i=1}^n\alpha_i(1 - y_i(w^Tx_i + b)) L(w,b,α)=21∣∣w∣∣2+i=1∑nαi(1−yi(wTxi+b))

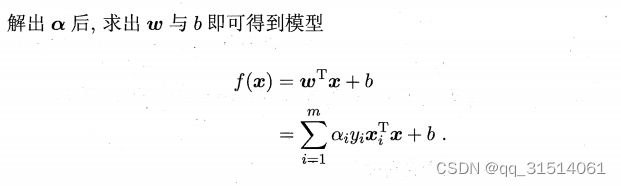

其中 α = ( α 1 ; α 2 ; . . . ; α m ; ) \alpha = (\alpha_1;\alpha_2;...;\alpha_m;) α=(α1;α2;...;αm;).令 L ( w , b , α ) L(w,b,\alpha) L(w,b,α)对 w w w和 b b b的偏导为零可得:

w = ∑ i = 1 m α i y i x i w = \sum\limits_{i=1}^m\alpha_iy_ix_i w=i=1∑mαiyixi

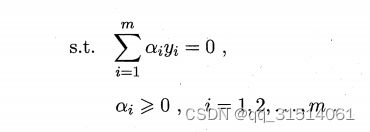

消去 w 和 b w和b w和b,再考虑约束就可以得到对偶问题

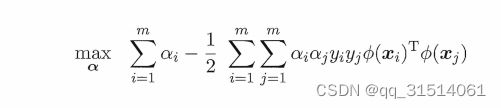

m a x α ∑ i = 1 m α i − 1 2 ∑ i = 1 m ∑ j = 1 m α i α j y i y j x i T x j max_{\alpha} \sum\limits_{i=1}^m\alpha_i - \frac{1}{2}\sum\limits_{i=1}^m\sum\limits_{j=1}^m\alpha_i\alpha_jy_iy_jx_i^Tx_j maxαi=1∑mαi−21i=1∑mj=1∑mαiαjyiyjxiTxj

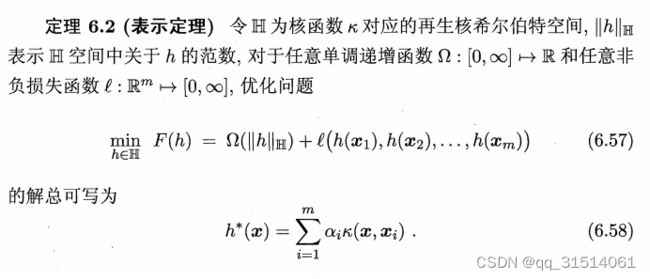

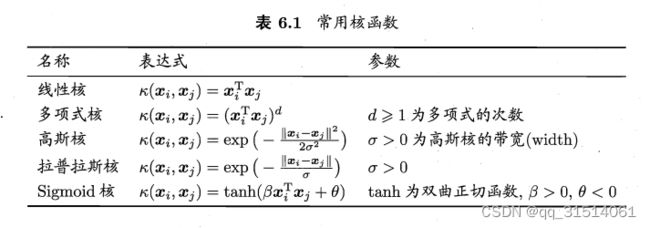

3.核函数

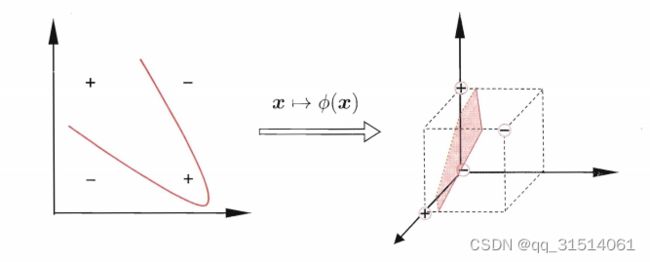

现实中,"异或"问题不线性可分,如下图

解决方法:将样本从原始空间映射到 一个更高维的特征空间,使得

样本在这个特征空间内线性可分.

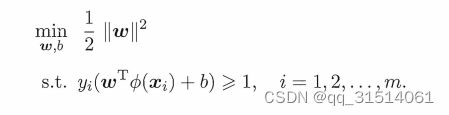

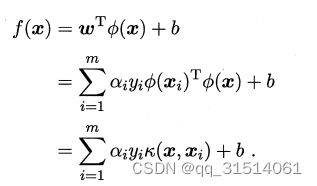

令 ϕ ( x ) \phi(x) ϕ(x)表示将 x x x映射后的特征向量,于是,在特征空间中划分超平面所对应的模型可表示为

f ( x ) = w T ϕ ( x ) + b f(x) = w^T\phi(x) + b f(x)=wTϕ(x)+b

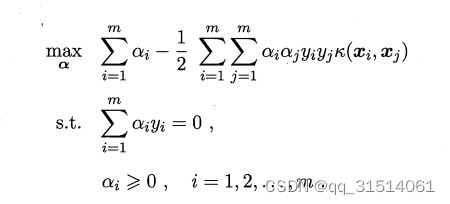

其对偶问题是:

求解后可得到

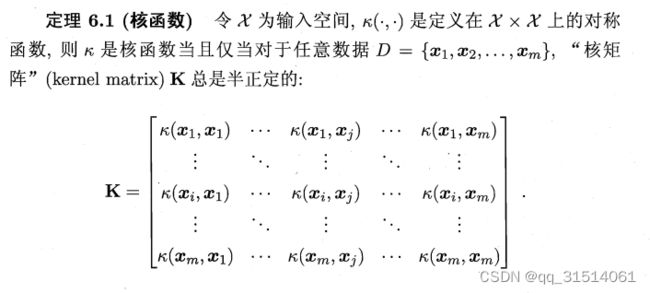

只要一个对称函数所对应的核矩阵半正定,它就能作为核

函数使用

此外,还可通过函数组合得到

此外,还可通过函数组合得到

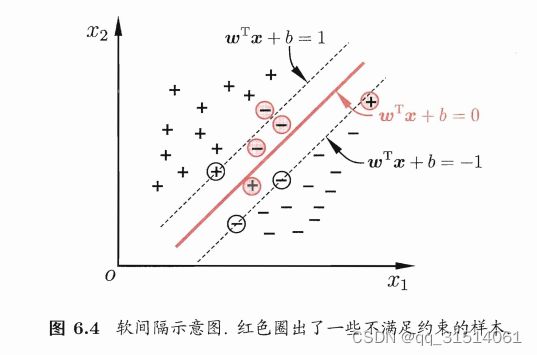

4.软间隔与正则化

抛出问题:在现实任务中,往往很难确定合适的核函数使得训练样本在特征空间中线性可分.

解决办法:允许支持向量机在一些样本上出错,为此称为"软间隔"

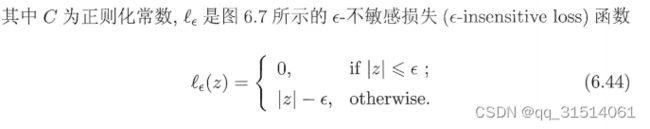

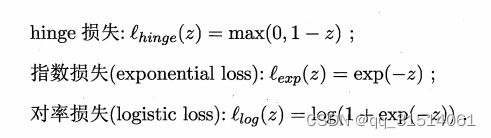

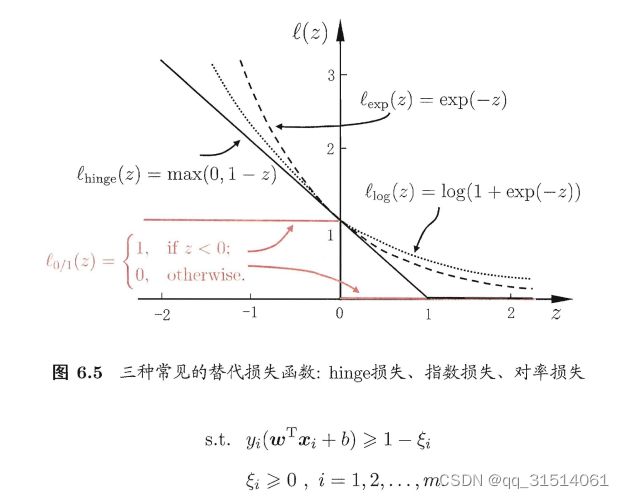

m i n w , b 1 2 ∣ ∣ w ∣ ∣ 2 + C ∑ i = 1 m ℓ 0 / 1 ( y i ( w T x i + b ) − 1 ) min_{w,b} \frac{1}{2}||w||^2 + C\sum\limits_{i=1}^m\ell_{0/1}(y_i(w^Tx_i +b) -1) minw,b21∣∣w∣∣2+Ci=1∑mℓ0/1(yi(wTxi+b)−1)

其中C>0是一个常数, ℓ 0 / 1 是 损 失 函 数 \ell_{0/1}是损失函数 ℓ0/1是损失函数

ℓ 0 / 1 ( z ) = { 1 x < 0 0 x ≥ 0 \ell_{0/1}(z)=\begin{cases}1&x<0\\0&x\ge0\end{cases} ℓ0/1(z)={10x<0x≥0

显然,当C为无穷大时,迫使是所有样本满足约束;C取有限值时,允许一些样本不满足约束.

常用的软间隔支持向量机

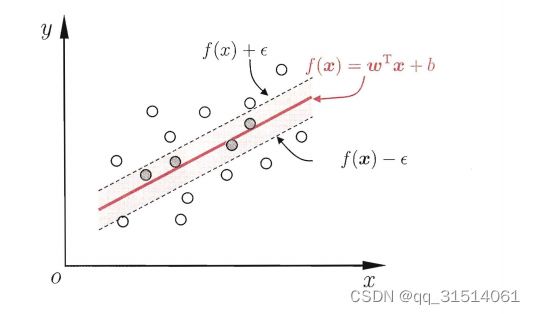

5.支持向量回归

支持向量回归假设 f ( x ) f(x) f(x)与真实输出y之间最多有 ϵ \epsilon ϵ的偏差.

SVR的问题可形式化: