场景文本识别中的字符感知采样与校正(Character-Aware Sampling and Rectification for Scene Text Recognition)

摘要

由于形状和纹理变化较大,曲面场景文本识别在多媒体社会中是一项具有挑战性的任务。以前的方法通过等距离采样提取和校正文本行来解决这一问题,这忽略了字符级别信息并导致字符失真。为了解决这个问题,本文提出了一个字符感知采样和校正(CASR)模块,该模块根据每个字符的位置和方向信息来校正不规则文本实例。具体而言,CASR将每个字符视为基本单元,并预测用于采样和校正的字符级属性。我们的模块不仅利用详细的字符信息来获得更好的文本行纠正,而且在训练过程中采用字符级监督。此外,CASR提供了一个即插即用模块,可以很容易地集成到现有的文本识别流水线中。在几个基准测试上的大量实验表明,我们的方法获得了更准确的校正文本实例,并取得了令人满意的性能。我们将在未来发布我们的代码和模型。

1. introduction

在野外阅读文本是多媒体社会的一项基本任务,也是一项具有挑战性的任务,其目标是将文本实例的图像转换为一系列机器可读符号。作为一种重要的图像分析技术,该任务已广泛应用于各种现实世界应用,如自动驾驶、人机交互和视觉辅助。近年来,由于深度学习技术的成功,场景文本识别得到了显著的改进。这些识别模型的标准原理是使用编码网络来提取视觉上下文信息,然后使用解码模型来将特征向量转换成目标序列。解码模块主要基于一维序列到序列模型,该模型在处理不规则文本实例方面具有固有的局限性,特别是对于透视文本和弯曲文本,这为将文本图像转换为文本符号带来了新的挑战。

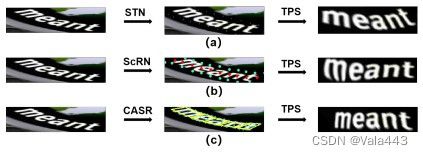

为了解决不规则文本识别问题,近年来提出了几种方法,大致可分为两类:基于二维(2D)注意力的方法和基于纠正的方法。对于2D注意力机制,生成2D注意力图用于特征对齐和序列解码。然而,由于注意力图不准确,识别性能受到限制。对于基于校正的方法,设计了特定的采样机制来生成控制点,用于通过薄板样条(TPS)将不规则文本实例校正为规范文本实例。例如,ASTER使用空间变换网络(STN)以弱监督的方式直接预测文本实例边界上的控制点,ScRN通过在校正模块中添加额外的监督来扩展这项工作。ASTER和ScRN的校正流水线如图1(a)和(b)所示。

图1:ASTER(a)、ScRN(b)和CASR(c)(我们的)的校正流水线

图1:ASTER(a)、ScRN(b)和CASR(c)(我们的)的校正流水线

尽管使用了几个局部属性来获得精确的文本行,但文本级等距离采样过程在很大程度上忽略了字符级信息,并可能导致字符失真。由于字符是文本实例的基本单位,因此文本识别的关键是正确翻译每个字符。对于透视文本和曲线文本,识别性能高度依赖于单个字符是否被精确地纠正为规范形式。此外,由于TPS严格地将所选控制点转换到相应的预定义位置,因此控制点及其周围环境的纠正结果更为准确。基于以上观察,我们假设基于字符级采样策略的不规则文本实例纠正可以获得更好的结果,因为它将在纠正过程中包含更多的字符特定指导。

基于上述讨论,我们提出了一种新颖的字符感知采样和校正(CASR)模块,该模块根据每个字符的位置和方向信息来校正不规则文本实例。具体而言,CASR将每个字符视为一个基本单元,并使用基于分割的网络来预测字符特定的几何属性,包括每个字符的掩码、高度、宽度和角度。由于文本实例中的字符彼此非常接近,导致分离的困难,我们的模块预测了一组大小不同的字符级掩码,以避免粘连。然后,使用连接组件选择算法(CCSA)来获得不同掩码上每个单独字符的中心。基于这些几何属性,可以重建字符级文本实例,并生成用于图像校正的精确控制点,如图1(c)所示。因此,基于字符的采样过程可以确保每个字符在校正后保持接近水平,然后识别模块可以容易地将文本实例转换为序列。

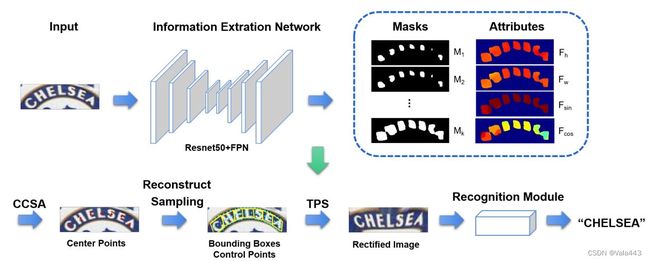

我们将我们提出的CASR纳入常用的基于注意力的识别平台,以构建字符感知采样和校正网络(CASR-Net),整体流程如图2所示。已经进行了大量实验,以证明我们的CASR-Net在各种公共基准上的有效性。我们的CASR-Net在许多文本识别数据集,尤其是在不规则文本数据集(如ICDAR2015、SVTP和CUTE80)上取得了令人满意的性能。

图2:我们CASR网络的整体流水线。信息提取网络是具有特征金字塔网络结构的Resnet50(详细结构如图4所示)。输出是k+4个通道的分割图。M1至Mk表示不同比例的字符级掩码,其中M1是最小的掩码,Mk是最大的掩码。k是我们使用的掩码数量。Fh、Fw、Fsin和Fcos表示包含每个字符的高度、宽度、字符角度的正弦和余弦值的分割图。提出了连通分量选择算法(CCSA),通过找到每个字符的连通分量来获得每个字符的中心。给定上述字符信息,可以重建边界框并对控制点进行采样。在生成控制点之后,可以执行薄板样条(TPS)以获得校正图像。最后,识别模块将识别该图像上的文本。

图2:我们CASR网络的整体流水线。信息提取网络是具有特征金字塔网络结构的Resnet50(详细结构如图4所示)。输出是k+4个通道的分割图。M1至Mk表示不同比例的字符级掩码,其中M1是最小的掩码,Mk是最大的掩码。k是我们使用的掩码数量。Fh、Fw、Fsin和Fcos表示包含每个字符的高度、宽度、字符角度的正弦和余弦值的分割图。提出了连通分量选择算法(CCSA),通过找到每个字符的连通分量来获得每个字符的中心。给定上述字符信息,可以重建边界框并对控制点进行采样。在生成控制点之后,可以执行薄板样条(TPS)以获得校正图像。最后,识别模块将识别该图像上的文本。

本文的主要贡献总结如下:

- 我们注意到,特定于字符的采样是获得更准确的校正文本实例的一种合理且有前景的方法,并提出了字符感知采样和校正(CASR)模块来执行字符级校正。

- CASR是一个即插即用模块,我们将该模块纳入基于注意力的识别平台,以构建字符感知采样和校正网络(CASR-Net)

- 实验结果验证了我们的CASR网络的有效性,该网络在许多公共数据集(如SVT、ICDAR2013、ICDAR2015、SVTP和CUTE80数据集)上实现了令人满意的性能。

2. 相关工作

场景文本检测和识别形成了一个连续的流水线来定位文本区域和识别文本实例,这对于机器从场景图像中读取文本至关重要。检测模型被用于定位自然图像上的文本区域,而识别模型被进一步用于将文本实例转换为符号序列,这两者在该信息翻译过程中都很重要,本文重点关注场景文本识别。

A. 场景文本识别

在自然场景中阅读文本是一项具有挑战性的任务,并受到了业界和学术界的广泛关注。近年来提出了各种方法,可分为两种方法:基于自下而上的方法和基于自上而下的方法。在本节中,我们将简要介绍几种最先进的模型,并在[16]中对场景文本识别的发展进行了全面研究。

自下而上的方法首先生成字符级别预测,然后将每个字符连接到相应的序列中。文本信息由手工制作的特征提取模块提取,如描边生成和半马尔可夫条件随机场,然后使用分类器来预测文本实例中的每个字符。最近,几种基于深度学习的方法通过用神经网络替代手工制作的特征提取方法,显著提高了性能。例如,LCSegNet利用分割模型为每个字符生成逐像素预测,并使用条件随机场平滑标签分配,这在几个公共基准测试中实现了令人满意的性能。

自顶向下的方式采用另一种哲学来识别文本实例,它直接读取整个文本实例,而不需要对单个字符进行任何预测。受图像分类任务的启发,Jaderberg等人设计了一个具有90k个类别的分类网络,以识别90k个单词。然而,由于词汇表外的单词和分类网络中的巨大类别,这种方法不能被广泛使用。对于任意长度的文本实例,本文提出了序列方法,大致可分为两类:基于连接的时间分类(CTC)方法和基于注意力的方法。基于CTC的方法通常使用深度网络来编码视觉上下文和序列信息,然后使用CTC来获得任意长度文本的条件概率。近年来,注意力机制已广泛应用于识别模型中,该模型为文本区域中的每个字符位置生成聚焦图,以提高识别性能。

B. 不规则文本实例的识别

由于基于CTC和基于注意力的模型的成功,在常规和近水平文本中阅读文本已取得了可接受的性能,并已广泛应用于各种现实应用中。然而,由于序列模型的固有局限性,对不规则文本实例的识别仍然是一项具有挑战性的任务,尤其是对透视文本和曲线文本。最近,已经提出了几种方法,它们可以分为两类。第一种方法通过使用2D注意力模型来对齐特征并解码相应的序列,将一维(1D)序列模型推广为二维(2D)版本。对于这种方法,识别性能与深度网络生成的不准确注意力图相矛盾,因此需要进一步改进。第二种方法采用了一个校正模块,将不规则文本实例转换为规则和接近水平的文本实例。ASTER使用空间变换网络(STN)[12]来直接预测输入图像上的控制点。由于缺乏指导,这种无监督方法无法足够精确地预测控制点。ScRN通过在整流模块中添加额外的监督来扩展ASTER。它预测具有多个几何属性的文本中心线(TCL),并通过在TCL上等距采样生成文本级控制点。然而,这种方法忽略了可以为TPS转换提供更准确信息的字符级信息。[34]通过提出渐进校正网络以迭代方式识别不规则文本实例来扩展ASTER。[34]和我们的模型的主要区别有两个:1.[34]是一种多步骤方法,它将在每个步骤估计转换参数以提高识别性能,而我们的方法是一种单步方法。2.我们的方法为每个字符引入几何监督,以预测更准确的字符信息,然后基于每个单独的字符生成转换参数。

考虑到字符是文本实例的基本单元,我们提出了一种新的采样模块,该模块对不规则文本实例执行字符级校正。

3. 方法

本节将详细描述我们提出的方法。如图2所示,我们的CASR网络采用了一个新颖的字符级采样和校正模块来校正不规则文本实例。首先,利用基于分割的深度网络来预测一组特定于字符的属性,以重建每个单独的字符。其次,执行校正以基于字符感知信息获得规范文本实例。最后,通过常用的识别网络识别纠正的实例。

A. 图像校正模块

如前一节所讨论的,由于字符是文本实例的基本单位,通过准确地纠正每个字符,识别性能将大大提高。因此,我们首先讨论了模型中每个角色所需的几何属性。在仔细分析现有不规则文本识别数据集中的文本实例后,我们发现单个字符可以用平行四边形边界框很好地表示。因此,我们选择角色中心、角度、高度和宽度来构建平行四边形边界框。在本文中,对于每个单独的字符j,我们将字符中心![]() 定义为给定边界框的中心点。字符的角度定义为字符方向和地平线之间的角度,由其正弦值

定义为给定边界框的中心点。字符的角度定义为字符方向和地平线之间的角度,由其正弦值![]() 和余弦值

和余弦值![]() 表示。字符的高度

表示。字符的高度![]() 和宽度

和宽度![]() 通过计算对应点之间的平均距离获得。

通过计算对应点之间的平均距离获得。

在本节中,我们提出了一个字符感知采样和校正模块(CASR),以将特定于字符的指导纳入校正过程,该模块包括提取字符级信息的深度网络和采样控制点的按字符构建方法。

1):字符级信息提取

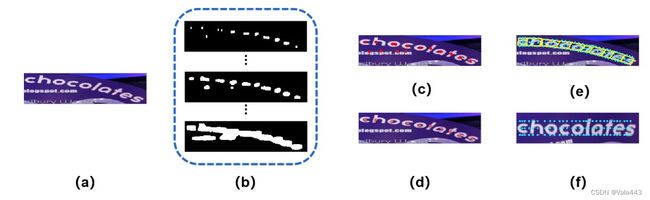

在我们的模型中,获得准确的字符特定信息是基础,因此使用基于分割的深度网络来预测一组几何属性,包括每个字符的掩码、高度、宽度和角度。在上述属性中,生成准确的字符/非字符掩码是最具挑战性的,因为生成的掩码存在粘附和缺失问题。由于文本实例中的字符彼此封闭,相应的掩码将彼此粘附,导致字符分离困难,如图3(b)所示。一个可行的解决方案是通过缩小字符级掩码来扩展相邻字符之间的边界。然而,与较大的掩码相比,使用较小的掩码意味着只有高概率区域将被预测为字符区域。因此,概率相对较低的字符区域将被忽略,导致掩码丢失(例如:第一个和最后一个字母的掩码在图3(c)中未被预测)。因此,为了解决粘连和缺失问题,我们回归了一组具有不同字符大小的分割掩码。

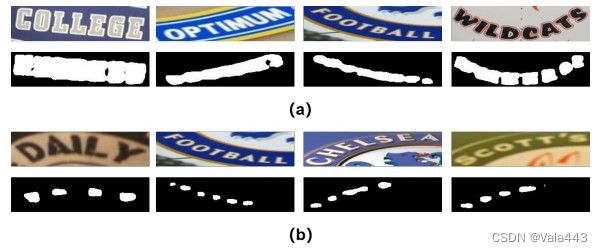

图3:分割遮罩的可视化。(a)是输入图像 (b)(c)(d)是不同字符大小的掩码。具体而言,(b)表示与原始字符大小相同的掩码。(c) 表示最小尺寸的掩模。(d) 表示中等大小的掩模。

图3:分割遮罩的可视化。(a)是输入图像 (b)(c)(d)是不同字符大小的掩码。具体而言,(b)表示与原始字符大小相同的掩码。(c) 表示最小尺寸的掩模。(d) 表示中等大小的掩模。

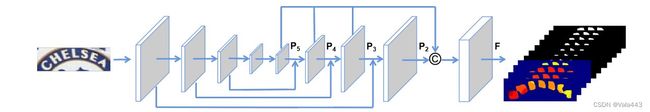

如图4所示,我们修改了特征金字塔网络(FPN)[35]作为骨干,以提取字符级信息。利用简单而有效的分割头对多尺度掩模和几何属性进行密集预测。具体而言,在融合特征图P2、P3、P4和P5之后,采用3×3卷积将通道数从1024减少到256。采用1×1卷积生成与输入图像相同分辨率的具有k+4通道的最终分割图。k个通道是表示字符位置的多尺寸字符级分割掩码(标记为M1至Mk),而四个额外通道用于对高度Fh、宽度Fw和角度(Fsin和Fcos)的分割图执行密集预测。具体而言,Fh、Fw、Fsin和Fcos表示包含这些几何信息的分割图,而![]() 表示第j个字符的特定几何值。

表示第j个字符的特定几何值。

图4:我们的特征提取器网络的详细主干。主干是由FPN修改的Resnet50。符号C表示连接操作。P2、P3、P4和P5是在FPN的不同阶段获得的特征图。F是由P2、P3、P4和P5融合的特征图。输出是与输入图像具有相同分辨率的具有k+4个通道的分割图,包括k个多尺度字符掩模和4个包含几何信息的特征图(Fh、Fw、Fsin、Fcos)。

图4:我们的特征提取器网络的详细主干。主干是由FPN修改的Resnet50。符号C表示连接操作。P2、P3、P4和P5是在FPN的不同阶段获得的特征图。F是由P2、P3、P4和P5融合的特征图。输出是与输入图像具有相同分辨率的具有k+4个通道的分割图,包括k个多尺度字符掩模和4个包含几何信息的特征图(Fh、Fw、Fsin、Fcos)。

为了获得准确的字符级掩码,通过在不同掩码上选择每个字符的连接组件,开发了连接组件选择算法(CCSA)。CCSA搜索从最小掩码M1到最大掩码Ml的连接组件,并记录在先前掩码中与其他组件不重叠的每个连接组件(CC)。l是超参数,表示算法中使用了多少掩码,可以从1设置到k。

如图5所示,(b)(c)和(d)的顶部图像分别表示最小掩模(M1)、第三掩模(M3)和第五掩模(M5)。在(b)中,我们只使用最小掩码来检测字符,因此错过了第一个字符“U”和最后一个字符“Y”。最终的校正图像因此失真。然后在(c)和(d)中,我们分别用超参数l=3和l=5实现CCSA,因此我们可以恢复这两个缺失的字符。详细信息算法概述在算法1。

图5:CCSA的可视化。(a) 表示CASR的输入图像。(b)(c)(d)的第一行表示不同层的分割掩模,其分别表示最小掩模(M1)、第三掩模(M3)和第五掩模(M5)。第二行表示打印在原始图像中的重建和采样结果。黄色线是重建的边界框,蓝色点是控制点。第三行显示了整改结果。

图5:CCSA的可视化。(a) 表示CASR的输入图像。(b)(c)(d)的第一行表示不同层的分割掩模,其分别表示最小掩模(M1)、第三掩模(M3)和第五掩模(M5)。第二行表示打印在原始图像中的重建和采样结果。黄色线是重建的边界框,蓝色点是控制点。第三行显示了整改结果。  算法1

算法1

利用第j个字符![]() 的精确连通分量,中心点可以用

的精确连通分量,中心点可以用![]() 的圆心表示,并且字符的几何属性可以通过

的圆心表示,并且字符的几何属性可以通过 来计算,其中θ表示字符连接信息,包括高度、宽度、角度(sin和cos)。

来计算,其中θ表示字符连接信息,包括高度、宽度、角度(sin和cos)。![]() 和

和![]() 表示所选连通分量掩码

表示所选连通分量掩码![]() 中像素(x,y)的值和分割结果

中像素(x,y)的值和分割结果![]() 。

。

由于SynthText(ST)数据集中提供了字符级注释,因此可以通过字符级标签计算几何属性。根据提供的边界框和几何值,我们通过将相应的值填充到字符区域来生成高度Gh、宽度Gw、角度(Gsin和Gcos)的ground truth。此外,我们使用几个不同的预定义大小来收缩边界框,作为标记为G1到Gk的字符/非字符掩码的ground truth。利用上述注释,损失函数为L=L_mask+L_geo,分别表示缩放掩码和几何属性的损失函数。

对于损失函数L_mask,由于背景(非字符)像素在图像中占主导地位,特别是对于具有小字符的图像,训练样本的不平衡将成为训练过程中的一个严重问题。采用Dice系数D(Mi,Gi)来解决这个问题,该问题可以表示为: ,

,![]() 分别表示第i个掩码中像素(x,y)的值和相应的ground truth。此外,我们实施了在线硬示例挖掘(OHEM),以进一步提高掩模预测的性能。因此,掩模预测的最终损失函数可以表示为

分别表示第i个掩码中像素(x,y)的值和相应的ground truth。此外,我们实施了在线硬示例挖掘(OHEM),以进一步提高掩模预测的性能。因此,掩模预测的最终损失函数可以表示为 ,其中k表示我们使用的缩放掩码的数量,O表示OHEM给出的训练掩码。

,其中k表示我们使用的缩放掩码的数量,O表示OHEM给出的训练掩码。

实现平滑L1损失以获得字符区域中几何属性的准确预测,其可通过以下公式计算:![]() ,其中Mmax表示最大掩码,θ表示字符级别信息,包括高度、宽度和角度(sin和cos)。

,其中Mmax表示最大掩码,θ表示字符级别信息,包括高度、宽度和角度(sin和cos)。

2):字符重建与采样

由于背景的复杂性,分割头不可避免地会将一些非字符区域预测为正。如图6(b)所示,由于背景中的文本行非常小,因此预测了不相关的连接组件。图6(c)包含CCSA后生成的所有中心点,不可能基于这些混沌点重建字符。因此,当残余误差大于预定阈值时,采用二次函数来拟合所有点并贪婪地消除波动点。具体而言,在获得混沌点集之后,使用二次曲线拟合所有点,并生成残差值。如果该值大于预定义阈值,则将消除导致残差值最大增加的点,直到整个残差值很小。结果中心点如图6(d)所示。经过上述改进,图6(e)中的重建结果和图6(f)中的校正结果都令人满意。

图6:精炼效果。(a) 表示输入图像。(b) 表示我们预测的掩码集。(c) 显示了我们可以从网络中获得的中心点。(d) 细化后,将人物中心可视化。(e) 显示了我们如何采样,(f)是我们的校正结果。

图6:精炼效果。(a) 表示输入图像。(b) 表示我们预测的掩码集。(c) 显示了我们可以从网络中获得的中心点。(d) 细化后,将人物中心可视化。(e) 显示了我们如何采样,(f)是我们的校正结果。

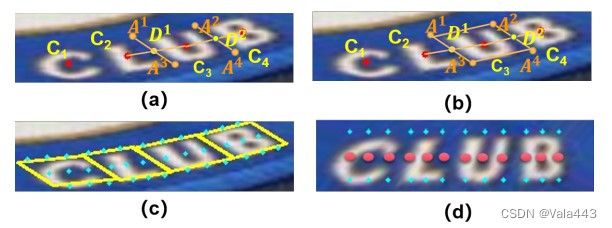

然后可以基于预测的几何属性重建文本实例。对于弯曲和透视文本实例,矩形边界框不适用,因此我们用一个通用的平行四边形重建每个单独的角色。详细过程如图7所示,其中Cx是第x个字符的中心点。我们首先在线段C2C3上找到分界点D1,其中C2D1/C2C3=W2/(W2+W3)。(W2、W3表示字符C2和C3的预测宽度)。此步骤进一步规范每个字符的预测宽度。然后用提供的角度和高度绘制一条穿过该点D1的线段,以形成图7(a)中的边界框边界A1A4。通过相同的过程生成段A2A3。最后,我们连接A1A2和A3A4以形成图7(b)所示的平行四边形边界框。

图7:Cj是第j个字符的中心点。(a) 和(b)表示重建字符“U”的过程。D1和D2是线段C2C3和C3C4的分界点。A1、A2、A3和A4是边界框的角点。(c)中的黄色线是构建的边界框,蓝色点是集合P中的控制点,集合P是TPS之前的控制点。(d) P′点是TPS后的相应控制点。

图7:Cj是第j个字符的中心点。(a) 和(b)表示重建字符“U”的过程。D1和D2是线段C2C3和C3C4的分界点。A1、A2、A3和A4是边界框的角点。(c)中的黄色线是构建的边界框,蓝色点是集合P中的控制点,集合P是TPS之前的控制点。(d) P′点是TPS后的相应控制点。

构造完成后,使用薄板样条(TPS)变换来校正文本实例,该文本实例由一对点集P={p_1,p_2,…,p_9n}(n表示字符数)和P′确定,其中P和P′分别表示TPS之前和之后的控制点。对于平行四边形边界框,我们在上下边界框边界上各采样3个点,以及图7(c)所示的角色中心线上的3个点。因此,每个字符的总共9个控制点被生成为P。

与P类似,P′={P′_1,P′_2,…,P′_9n}由相同的几何属性生成。我们首先确定字符中心点的位置,其y坐标位于校正图像的中心线上,x坐标与原始图像中相应的中心点相同。基于这些点,我们根据每个字符的宽度生成左、右点,每个字符的这3个点由图7(d)中的红色点表示。最后,我们根据角色的高度向上和向下移动这些点,以形成图7(d)所示的P′中的所有对应点。

B. 文本识别模块

为了验证CASR的有效性和可移植性,我们实现了ASTER和DRNet作为识别模块。ASTER和DRNet都是基于一维注意力的识别器,其中校正模块严重影响性能。我们用CASR替换这两个识别器的原始校正模块,并保持其他配置不变。

1):ASTER

使用基于注意力的序列到序列识别模型来预测校正文本实例中的字符序列。将校正后的图像重新调整大小为32×100,然后使用深度残差网络将视觉信息编码到相应的特征序列中。在前两个残差块中,使用步长2×2卷积来向下采样特征图并放大接收野。对于以下块,步长变为2×1,以在水平方向保留更多局部细节。采用两层双向长短期存储器(BiLSTM)将特征图进一步编码成序列。最后,在步骤t使用注意力解码器迭代地预测字符符号yt,得到序列y={y1,y2,…,yt},其中t是字符的数量。损失函数可以表示为 ,其中I表示输入图像。

,其中I表示输入图像。

2):DRNet

DRNet是另一种具有类似结构的基于注意力的序列到序列识别模型。ASTER中的正常残差块被DR块代替,DR块同时从低级特征中提取局部视觉和远程上下文关系。在每个DR块中,使用3×3卷积来提取局部特征,而使用h×3(h是每个阶段中输出特征的高度)卷积,然后使用双向LSTM来建模长期上下文关系。整个阶段配置保持与ASTER相同,包括每个阶段的下采样块和步长。

4. 实验

A. 数据集

我们在两个合成数据集Synth90K(Sy90)和SynthText(ST)上训练我们的模型。具体而言,识别模块在两个数据集上训练,而校正模块仅在具有字符注释的SynthText数据集上进行训练。不使用额外数据。

SynthText(ST)是一个合成文本图像数据集,最初用于场景文本检测。该数据集中不仅提供了文本级标签,还提供了字符级注释。通过根据给定的边界框裁剪文本实例来生成场景文本识别输入。我们的CASR模块仅在该数据集上训练其字符注释。

Synth90K(Sy90)是一个包含900万个单词框图像的合成数据集。它是通过在一些手工干扰下将单词渲染到背景而生成的,并广泛用于训练文本识别模型。

为了证明我们的CASR网络的有效性,我们使用了七个场景文本识别数据集来评估我们的方法,该方法可以分为规则数据集或不规则数据集。

常规数据集包括:

IIIT5K-Words (IIIT)包括从谷歌搜索中收集的3000张测试图像。

Street View Text (SVT)包含谷歌街景收集的647张户外街道图像。

ICDAR 2003 (IC03)在过滤后包含860个图像,这些图像包含非字母数字字符和少量字符。

ICDAR 2013 (IC13)包含1015个主要从IC03继承的场景文本图像。

不规则数据集包括:

ICDAR 2015 (IC15)包含2077个由谷歌眼镜拍摄的文本图像。此数据集中的图像模糊

SVT-Perspective (SVTP)包含645个测试图像。这里的图像被非正面视角严重扭曲。

CUTE80包含288个单词图像,集中于弯曲文本。

B. 实施详细细节

该方法在Pytorch平台上实现。对于图像校正模块,将训练样本调整为64×256作为输入图像。掩码的数量是一个超参数,我们通过遵循PSENet在我们的方法中设置k=7。PSENet为每个文本中心线使用7个掩码来定位文本实例,而我们为每个字符使用7个遮罩来分隔每个单独的字符。k=7是PSENet中的推荐配置,因此我们在模型中遵循此设置。我们从头开始训练模块,批量大小为512,持续6个epoch。初始学习率被设置为0.1,并且将在2、4和5个时期被除以10。掩模和几何属性的损失被同等加权,OHEM的负正比率被设置为3。网络通过随机梯度下降(SGD)进行优化,动量为0.99,权重衰减为0.0005.

识别模块在ST和Sy90数据集上进行训练。与原始ST和Sy90一起,我们通过CASR校正了两个数据集中的所有文本实例,作为我们的整体训练数据。

C. 遮罩黏附和遮罩缺失的可视化

为了更好地理解生成具有不同比例的字符掩码的必要性,我们对遭受掩码粘连和掩码丢失的图像进行了更多的可视化。如图8(a)所示,每个字符的掩码相互粘附,并形成整个文本行的连接掩码。当出现掩码粘连时,无法获得每个单独字符的中心点,因此无法以字符方式重建字符和采样控制点,这就是我们生成小规模掩码的原因。然而,当规模较小时,角色遮罩很容易丢失。图8(b)显示了掩码丢失的问题,我们生成的掩码少于图像中出现的字符。为了解决上述问题,我们生成了不同尺度的掩码,并提出了CCSA算法。

图8:掩模粘附(a)和掩模缺失(b)问题的可视化。

图8:掩模粘附(a)和掩模缺失(b)问题的可视化。

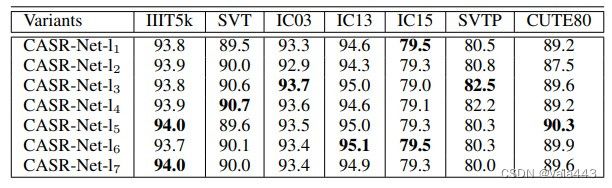

D. 连通部件选择算法的消融研究

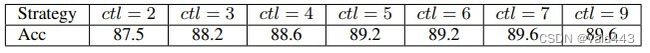

在本节中,我们进行了一系列广泛的实验,以详细讨论CCSA的效果。我们通过选择具有不同层数的连接组件来生成字符级掩码。实验结果如表2所示,其中超参数l表示我们使用的层数,从1到k。基线是CASR Net l1,它直接使用最小分割掩码来获得每个字符的中心。从表2中,我们可以得出两个结论:(1)具有多尺度分割掩模的CCSA可以显著提高SVT、SVTP和CUTE80的识别性能,分别约为1.2%、2.0%和1.1%。(2)性能表现出与l值的非线性相关性。当l=3时,整体性能将达到最高值,l值越高或越低,平均精度将下降。这种现象是合理的,因为CCSA将字符区域从最高可能性逐渐增加到较低,并且中等值达到平衡。

表2:使用不同层数的CCSA的模型之间识别精度的比较。

表2:使用不同层数的CCSA的模型之间识别精度的比较。

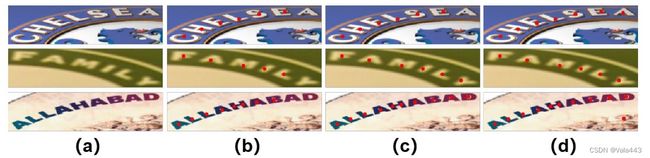

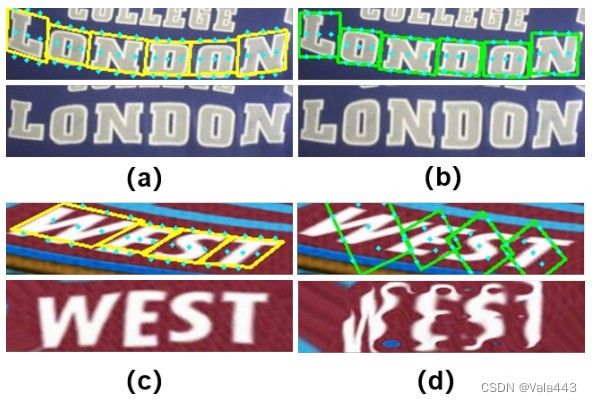

为了更好地证明改进,我们在图9中可视化了CCSA的结果。如图9(b)所示,如果没有CCSA,某些字符无法正确预测,导致纠正不令人满意。图9(c)显示,在实施CCSA后,将恢复丢失的字符。然而,包括较大的掩模将导致图9(d)中最低图像中所示的非字符区域的错误预测,这将使图像难以校正。

图9:CCSA的可视化结果。(a) 表示输入图像。(b) (c)(d)是从CCSA获得的中心点的可视化,超参数l分别设置为1、4和7。图像中的红点是中心点。

图9:CCSA的可视化结果。(a) 表示输入图像。(b) (c)(d)是从CCSA获得的中心点的可视化,超参数l分别设置为1、4和7。图像中的红点是中心点。

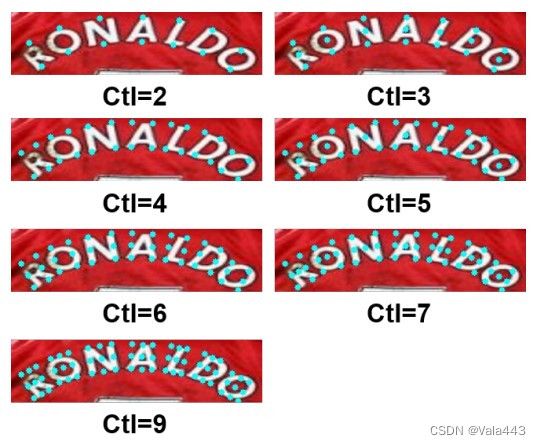

E. 控制点数量的消融研究

在本节中,我们进行了大量实验,以研究与控制点数量相关的曲线文本的识别精度。图10显示了本消融研究中不同采样策略的可视化,其中蓝色点为控制点。如表3所示,随着控制点的增加,识别精度首先相应地增加,但当控制点的数量达到7时,识别精度变得稳定。基于以上观察,我们认为我们的方法中的9个控制点是足够的。

图10:采样策略可视化。每个文本图像中的蓝色点是控制点。为了更好地显示控制点的差异,我们使用相同的文本图像进行比较。

图10:采样策略可视化。每个文本图像中的蓝色点是控制点。为了更好地显示控制点的差异,我们使用相同的文本图像进行比较。

表3:CUTE80数据集上不同样本策略的识别精度。ctl=k表示控制点的数量为k。

表3:CUTE80数据集上不同样本策略的识别精度。ctl=k表示控制点的数量为k。

F. 重建策略的消融研究

一旦我们获得了准确的字符特定属性,就可以通过相应的字符级几何信息重建文本实例。通常,两种不同类型的边界框被广泛用于构造字符,即基于平行四边形的边界框(抛物线)和基于矩形的边界框。为了进行比较,我们在图11中可视化了Parabb和Rect bb的重建结果。从图11中,我们可以得出以下结论:(1)如图11(b)所示,Rect bb表示的字符对于常规文本实例来说足够了,并且两种方法的校正结果几乎相同。(2)对于极度透视偏移或扭曲的图像,使用Rect bb重建将导致灾难,如(d)所示,而Para bb在(c)中表现良好。因此,为了获得更稳健和满意的结果,我们通过Para-bb重建不规则文本实例。

图11:Rect bb和Para bb的可视化。第一行是重建和采样的可视化,第二行是校正结果。(a) (c)在para bb中重建,(b)(d)在Rect bb中重建。从这个可视化中,使用矩形边框可能会导致图像严重失真。

图11:Rect bb和Para bb的可视化。第一行是重建和采样的可视化,第二行是校正结果。(a) (c)在para bb中重建,(b)(d)在Rect bb中重建。从这个可视化中,使用矩形边框可能会导致图像严重失真。

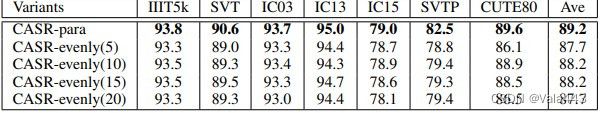

G. 字符感知采样的消融研究

基于字符特定采样方法的不规则文本实例校正是本工作的一个重要贡献。我们进行了消融实验,以验证我们的特征感知采样方法的有效性,实验结果如表4所示。括号中的数字表示使用的控制点对数。最后一列是这七个基准的平均准确度。与等距采样方法相比,无论使用多少对均匀采样的控制点,我们的方法都提高了所有七个基准点的识别性能。这清楚地表明,基于字符的采样方法优于等距采样方法,因为引入了更多的字符感知信息。

表4:等距采样与字符感知采样的识别精度比较。在CASR中,括号中的数字表示本实验中控制点对的数量。最后一列是基准面上的平均精度

表4:等距采样与字符感知采样的识别精度比较。在CASR中,括号中的数字表示本实验中控制点对的数量。最后一列是基准面上的平均精度

H. 校正结果可视化

在本节中,我们将CASR的校正结果可视化,如图12所示。与ASTER相比,我们的CASR可以根据字符感知几何属性准确校正文本实例。对于这些透视图像,ASTER可能会稍微弯曲文本线,如图12(a)(b)所示,而我们可以平滑地校正它们。对于那些严重弯曲的,ASTER无法对其进行校正,如图12(c)(d)所示。此外,它有时会裁剪一些有用的区域,并导致识别模块无法识别,如图12(e)(f)所示,而我们可以将它们转换为接近水平的文本。因此,我们的模型可以基于精确校正的图像获得更好的识别性能。更多可视化结果将在附录中介绍。

图12:整改结果可视化。第一行显示原始输入图像。第二行显示ASTER的校正结果。第三行显示了我们的校正结果。

图12:整改结果可视化。第一行显示原始输入图像。第二行显示ASTER的校正结果。第三行显示了我们的校正结果。

I. 与基线比较

尽管与ASTER相比,我们的模型在很大程度上提高了性能,但ASTER与最新的最先进模型之间的差距使我们的改进不明显。因此,为了证明CASR的效果和可移植性,我们将DRNet与ASTER一起实现为我们的另一个识别器。DRNet是一种基于1D注意力的识别器,它需要一个校正模块来规范输入图像。它同时从低级特征中提取局部视觉和远程上下文信息,提高了识别性能。与CASR-ASTER类似,我们只是将DRNet的整流模块替换为CASR,并将其表示为CASR-DRNet。

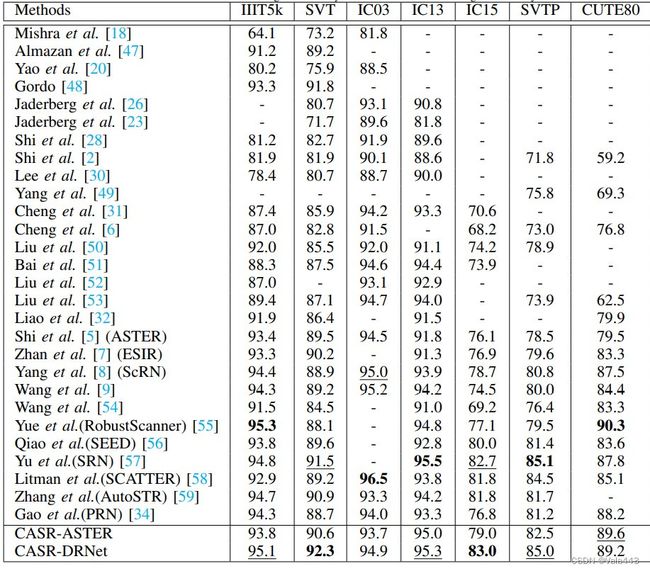

如表5所示,我们的CASR是一个即插即用模块,可用于任何一维文本识别模型。与基线相比,CASR-ASTER和CASR-DRNet都有稳定的改善,尤其是对于三个不规则数据集。CASR改进了ASTER并将DRNet提高到高性能。

表5:ASTER、CASR-ASTER、DRNet和CASR-DRNet识别精度的比较。

表5:ASTER、CASR-ASTER、DRNet和CASR-DRNet识别精度的比较。

J. 与最新技术的比较

为了证明我们的CASR的有效性,我们在本节中将我们的方法与最先进的模型进行了比较。如表6所示,我们的方法在所有不规则数据集(IC15、SVTP和CUTE80)中都取得了令人满意的性能,这证明了我们的CASRNet在识别透视和弯曲文本实例方面的优异性能。与其他基于校正的STR模型(包括ASTER、ESIR和ScRN)相比,我们的模型获得了最佳性能。改进表明,基于字符感知采样方法纠正不规则文本实例可以显著提高识别性能。此外,由于字符级属性预测的波动,特定于字符的校正模块可能会引入一些噪声,但我们的CASR-Net在常规数据集上仍然实现了优异的性能,特别是对于SVT数据集。

表6:多种方法和数据集的识别精度。最高精度用粗体表示,第二高精度用下划线表示。

表6:多种方法和数据集的识别精度。最高精度用粗体表示,第二高精度用下划线表示。

最后,整个模型的推理时间为每幅图像0.026秒,这是可以接受的,可以用于实时应用。

K. 测试用合成数据

尽管CUTE80数据集已被广泛用于评估弯曲文本的性能,但它缺少几个弯曲文本。因此,为了验证我们的模型在复杂波动文本上的识别性能,我们遵循并生成了更多的曲线文本,并在这些额外的合成数据中可视化了校正结果,如图13所示。在每一对中,上面的图像是原始输入,下面是校正后的图像。

图13:我们合成数据中的示例。在每对图像中,上面的图像是原始输入,下面的图像是校正后的图像。

图13:我们合成数据中的示例。在每对图像中,上面的图像是原始输入,下面的图像是校正后的图像。

我们的模型在此数据集上的性能达到了90.7%的识别准确率,而基线模型Aster达到了67.1%。我们的模型优于基线约23.6%,这证明了我们模型的有效性。

具体的合成过程如下:首先分析基准测试中出现的文本及其频率,然后选择前500个文本作为语料。给定背景图像,使用颜色分割方法将图像分离为几个平滑区域。然后从语料库中随机选择文本,并使用随机字体将字符放入图像的平滑区域。最后,使用泊松图像编辑将文本混合到场景中。

L. 与相关工程的比较

由于我们使用分割模型来预测每个字符的位置,因此掩模粘附是一个严重的问题,我们使用多尺度掩模来分离不同的字符。[62]处理了利用文本实例分割来定位不规则文本的类似问题,这发展了加权文本边界的概念来分离相邻文本实例。该方法使用文本中心线来定位每个文本的位置,并使用文本边界线来分隔相邻的文本实例。由于短边往往无法检测,作者开发了加权文本边界以生成可靠的边界预测。与这项工作相比,我们的特征提取模块仅使用多尺度字符掩模来分离每个单独的字符,而没有每个字符的边界,这比[62]简单且易于实现。

M. 局限性

虽然取得了最佳的纠正结果,但我们将一些不良案例可视化,以分析我们方法的局限性。我们将不良案例分为两类,如图14和图15所示,前者是由于整改不力造成的,后者是由于识别模块不完善造成的。

如图14所示,由于复杂的背景和模糊的文本,我们的CASR无法生成精确的几何属性,这导致相对较差的校正结果。

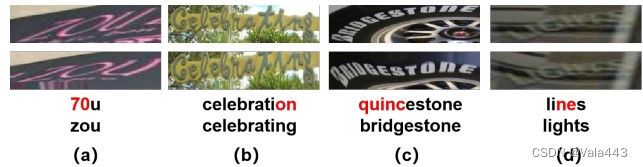

图14:不良案例的可视化。从上到下,行分别表示原始图像、校正图像、识别结果和ground truth。红色字符表示错误预测。

图14:不良案例的可视化。从上到下,行分别表示原始图像、校正图像、识别结果和ground truth。红色字符表示错误预测。

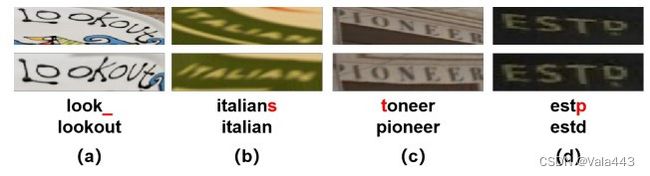

在本文中,我们发现大多数错误的预测图像属于第二类,如图15所示。在这种情况下,我们的CASR将文本图像校正为规范图像,但识别模块无法识别它们。尽管图15(a)的结果对人类读者来说足够清楚,但识别模块很难做到这一点。对于图15(b)的结果,图像太模糊,无法识别。此外,测试集中的一些文本图像不完善,无法识别。例如,图15(c)中的第一个字母被覆盖并导致错误预测,而图15(d)中的最后一个字母“d”由于下面的污渍而容易被预测为“p”。

图15:不良案例的可视化。从上到下,行分别表示原始图像、校正图像、识别结果和ground truth。红色字符表示错误预测,下划线表示缺少字符。

图15:不良案例的可视化。从上到下,行分别表示原始图像、校正图像、识别结果和ground truth。红色字符表示错误预测,下划线表示缺少字符。

N. 讨论

在该方法中,我们不考虑其他属性,例如每个单个角色的变形。原因有三个:(1)包含字符中心、角度和大小的属性足以重建边界框以表示每个字符。(2) 在现有的场景文本识别数据集中,字符的变形并不常见,平行四边形边界框在大多数情况下都足够了。(3) 预测更多属性将引入更多计算,并使流水线冗余。

5. 结论

在本文中,我们提出了一种字符感知采样和校正网络(CASR-Net),以通过字符的几何属性来校正和识别不规则文本。CASR-Net采用设计良好的基于分割的网络和连接组件选择算法(CCSA)来获得准确的字符级信息。基于预测的几何属性,可以重建字符级文本实例,并且可以生成用于图像校正的精确控制点。已经进行了大量实验,以证明我们的CASR网络在各种公共基准上的有效性,我们的CASRNet在许多文本识别数据集上取得了令人满意的性能。