sklearn专题五:用逻辑回归制作评分卡

目录

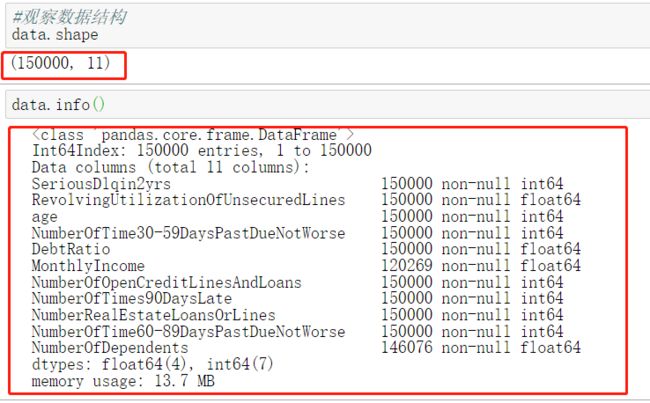

3.1 导库,获取数据

3.2 探索数据与数据预处理

3.2.1 去除重复值

3.2.2 填补缺失值

3.2.3 描述性统计处理异常值

3.2.4 为什么不统一量纲,也不标准化数据分布?

3.2.5 样本不均衡问题

3.2.6 分训练集和测试集

3.3 分箱

3.3.1 等频分箱

3.3.2【选学】 确保每个箱中都有0和1

3.3.3 定义WOE和IV函数

3.3.4 卡方检验,合并箱体,画出IV曲线

3.3.5 用最佳分箱个数分箱,并验证分箱结果

3.3.6 将选取最佳分箱个数的过程包装为函数

3.3.7 对所有特征进行分箱选择

3.4 计算各箱的WOE并映射到数据中

3.5 建模与模型验证

3.6 制作评分卡

3.1 导库,获取数据

%matplotlib inline

import numpy as np

import pandas as pd

from sklearn.linear_model import LogisticRegression as LR在银行系统中,这个数据通常使来自于其他部门的同事的收集,因此千万别忘记抓住给你数据的人,问问她/他各个项都是什么含义。通常来说,当特征非常多的时候(比如几百个),都会有一个附带的excel或pdf文档给到你,备注了各个特征都是什么含义。这种情况下其实要一个个去看还是非常困难,所以如果特征很多,建议先做降维,具体参考“2.2.2 逻辑回归中的特征工程”。

data = pd.read_csv(r"E:\数据分析师学习\data\rankingcard.csv"

,engine = 'python'

,index_col=0)3.2 探索数据与数据预处理

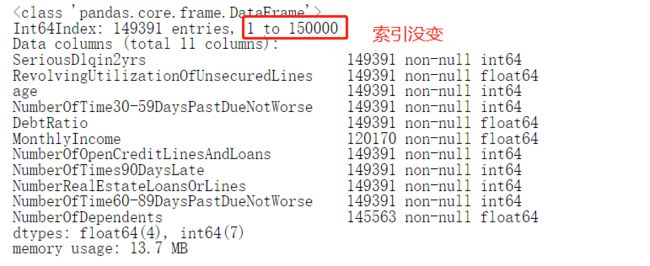

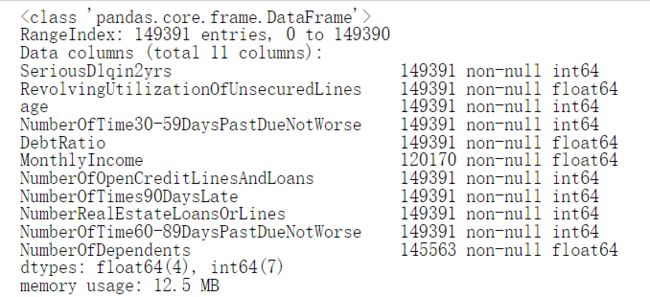

3.2.1 去除重复值

#去除重复值

data.drop_duplicates(inplace=True)

data.info()#删除之后千万不要忘记,恢复索引

data.index = range(data.shape[0])

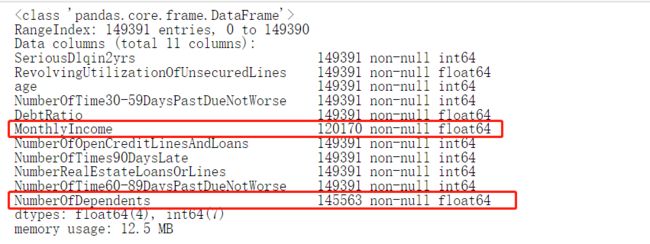

data.info()3.2.2 填补缺失值

#探索缺失值

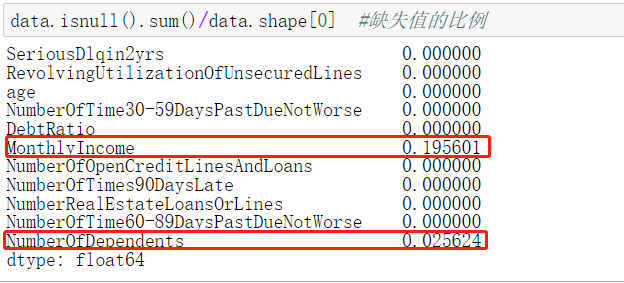

data.info()data["NumberOfDependents"].fillna(int(data["NumberOfDependents"].mean()),inplace=True) #如果你选择的是删除那些缺失了2.5%的特征,千万记得恢复索引哟~

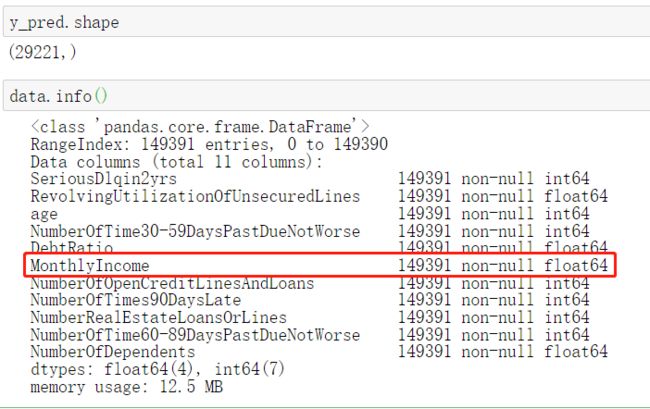

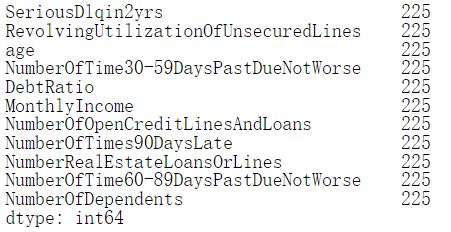

data.info()

data.isnull().sum()/data.shape[0]def fill_missing_rf(X,y,to_fill):

"""

使用随机森林填补一个特征的缺失值的函数

参数:

X:要填补的特征矩阵

y:完整的,没有缺失值的标签

to_fill:字符串,要填补的那一列的名称

"""

#构建我们的新特征矩阵和新标签

df = X.copy()

fill = df.loc[:,to_fill]

df = pd.concat([df.loc[:,df.columns != to_fill],pd.DataFrame(y)],axis=1)

# 找出我们的训练集和测试集

Ytrain = fill[fill.notnull()]

Ytest = fill[fill.isnull()]

Xtrain = df.iloc[Ytrain.index,:]

Xtest = df.iloc[Ytest.index,:]

#用随机森林回归来填补缺失值

from sklearn.ensemble import RandomForestRegressor as rfr

rfr = rfr(n_estimators=100)

rfr = rfr.fit(Xtrain, Ytrain)

Ypredict = rfr.predict(Xtest)

return YpredictX = data.iloc[:,1:]

y = data["SeriousDlqin2yrs"]

X.shape

#=====【TIME WARNING:1 min】=====#

y_pred = fill_missing_rf(X,y,"MonthlyIncome") #确认我们的结果合理之后,我们就可以将数据覆盖了

data.loc[data.loc[:,"MonthlyIncome"].isnull(),"MonthlyIncome"] = y_pred3.2.3 描述性统计处理异常值

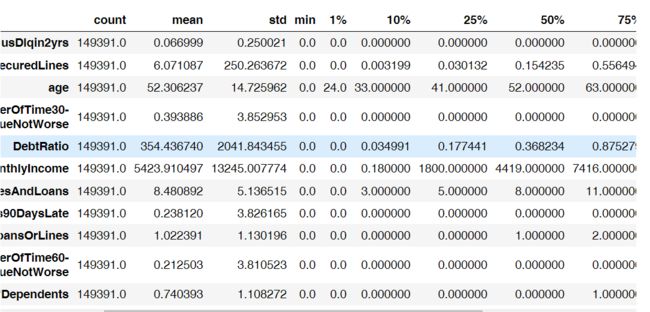

1.描述性统计

data.describe([0.01,0.1,0.25,.5,.75,.9,.99]).T(data["age"] == 0).sum() # 1data = data[data["age"] != 0]data[data.loc[:,"NumberOfTimes90DaysLate"] > 90].count()data=data[data.loc[:,"NumberOfTimes90DaysLate"] < 90]

data.info()恢复索引

data.index = range(data.shape[0])

data.info()3.2.4 为什么不统一量纲,也不标准化数据分布?

一旦我们将数据统一量纲,或者标准化了之后,数据大小和范围都会改变,统计结果是漂亮了,但是对于业务人员来说,他们完全无法理解,标准化后的年龄在0.00328~0.00467之间为一档是什么含义。并且,新客户填写的信息,天生就是量纲不统一的,我们的确可以将所有的信息录入之后,统一进行标准化,然后导入算法计算,但是最终落到业务人员手上去判断的时候,他们会完全不理解为什么录入的信息变成了一串统计上很美但实际上根本看不懂的数字。由于业务要求,在制作评分卡的时候,我们要尽量保持数据的原貌,年龄就是8~110的数字,收入就是大于0,最大值可以无限的数字,即便量纲不统一,我们也不对数据进行标准化处理。

3.2.5 样本不均衡问题

#探索标签的分布

X = data.iloc[:,1:]

y = data.iloc[:,0]

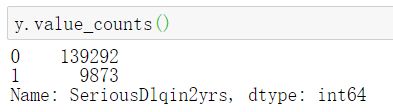

y.value_counts()

n_sample = X.shape[0]

n_1_sample = y.value_counts()[1]

n_0_sample = y.value_counts()[0]

print('样本个数:{}; 1占{:.2%}; 0占{:.2%}'.format(n_sample,n_1_sample/n_sample,n_0_sample/n_sample))

'''

样本个数:149165; 1占6.62%; 0占93.38%

'''#如果报错,就在prompt安装:pip install imblearn

import imblearn

#imblearn是专门用来处理不平衡数据集的库,在处理样本不均衡问题中性能高过sklearn很多

#imblearn里面也是一个个的类,也需要进行实例化,fit拟合,和sklearn用法相似

from imblearn.over_sampling import SMOTE

sm = SMOTE(random_state=42) #实例化

X,y = sm.fit_sample(X,y)

n_sample_ = X.shape[0]

pd.Series(y).value_counts()

n_1_sample = pd.Series(y).value_counts()[1]

n_0_sample = pd.Series(y).value_counts()[0]

print('样本个数:{}; 1占{:.2%}; 0占{:.2%}'.format(n_sample_,n_1_sample/n_sample_,n_0_sample/n_sample_))

'''

样本个数:278584; 1占50.00%; 0占50.00%

'''如此,我们就实现了样本平衡,样本量也增加了 .

3.2.6 分训练集和测试集

from sklearn.model_selection import train_test_split

X = pd.DataFrame(X)

y = pd.DataFrame(y)

X_train, X_vali, Y_train, Y_vali = train_test_split(X,y,test_size=0.3,random_state=420)

model_data = pd.concat([Y_train, X_train], axis=1)

model_data.index = range(model_data.shape[0])

model_data.columns = data.columns

vali_data = pd.concat([Y_vali, X_vali], axis=1)

vali_data.index = range(vali_data.shape[0])

vali_data.columns = data.columns

#保存数据集

model_data.to_csv(r"E:\数据分析师学习\data\model_data.csv")

vali_data.to_csv(r"E:\数据分析师学习\data\vali_data.csv")3.3 分箱

3.3.1 等频分箱

按照等频对需要分箱的列进行分箱

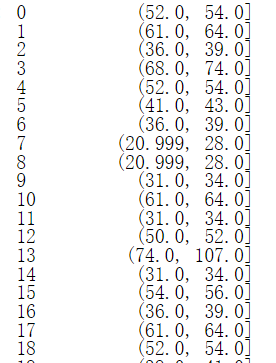

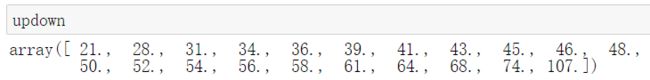

model_data["qcut"], updown = pd.qcut(model_data["age"], retbins=True, q=20)在这里时让model_data新添加一列叫做“分箱”,这一列其实就是每个样本所对应的箱子

model_data["qcut"]#在这里时让model_data新添加一列叫做“分箱”,这一列其实就是每个样本所对应的箱子

model_data["qcut"] #所有箱子的上限和下限

updown

# 统计每个分箱中0和1的数量

# 这里使用了数据透视表的功能groupby

coount_y0 = model_data[model_data["SeriousDlqin2yrs"] == 0].groupby(by="qcut").count()["SeriousDlqin2yrs"]

coount_y1 = model_data[model_data["SeriousDlqin2yrs"] == 1].groupby(by="qcut").count()["SeriousDlqin2yrs"]

#num_bins值分别为每个区间的上界,下界,0出现的次数,1出现的次数

num_bins = [*zip(updown,updown[1:],coount_y0,coount_y1)]

#注意zip会按照最短列来进行结合

num_bins3.3.2【选学】 确保每个箱中都有0和1

for i in range(20):

#如果第一个组没有包含正样本或负样本,向后合并

if 0 in num_bins[0][2:]:

num_bins[0:2] = [(

num_bins[0][0],

num_bins[1][1],

num_bins[0][2]+num_bins[1][2],

num_bins[0][3]+num_bins[1][3])]

continue

"""

合并了之后,第一行的组是否一定有两种样本了呢?不一定

如果原本的第一组和第二组都没有包含正样本,或者都没有包含负样本,那即便合并之后,第一行的组也还是没有

包含两种样本

所以我们在每次合并完毕之后,还需要再检查,第一组是否已经包含了两种样本

这里使用continue跳出了本次循环,开始下一次循环,所以回到了最开始的for i in range(20), 让i+1

这就跳过了下面的代码,又从头开始检查,第一组是否包含了两种样本

如果第一组中依然没有包含两种样本,则if通过,继续合并,每合并一次就会循环检查一次,最多合并20次

如果第一组中已经包含两种样本,则if不通过,就开始执行下面的代码

"""

#已经确认第一组中肯定包含两种样本了,如果其他组没有包含两种样本,就向前合并

#此时的num_bins已经被上面的代码处理过,可能被合并过,也可能没有被合并

#但无论如何,我们要在num_bins中遍历,所以写成in range(len(num_bins))

for i in range(len(num_bins)):

if 0 in num_bins[i][2:]:

num_bins[i-1:i+1] = [(

num_bins[i-1][0],

num_bins[i][1],

num_bins[i-1][2]+num_bins[i][2],

num_bins[i-1][3]+num_bins[i][3])]

break

#如果对第一组和对后面所有组的判断中,都没有进入if去合并,则提前结束所有的循环

else:

break

"""

这个break,只有在if被满足的条件下才会被触发

也就是说,只有发生了合并,才会打断for i in range(len(num_bins))这个循环

为什么要打断这个循环?因为我们是在range(len(num_bins))中遍历

但合并发生后,len(num_bins)发生了改变,但循环却不会重新开始

举个例子,本来num_bins是5组,for i in range(len(num_bins))在第一次运行的时候就等于for i in

range(5)

range中输入的变量会被转换为数字,不会跟着num_bins的变化而变化,所以i会永远在[0,1,2,3,4]中遍历

进行合并后,num_bins变成了4组,已经不存在=4的索引了,但i却依然会取到4,循环就会报错

因此在这里,一旦if被触发,即一旦合并发生,我们就让循环被破坏,使用break跳出当前循环

循环就会回到最开始的for i in range(20)中

此时判断第一组是否有两种标签的代码不会被触发,但for i in range(len(num_bins))却会被重新运行

这样就更新了i的取值,循环就不会报错了

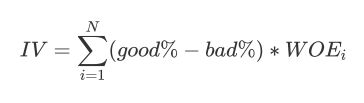

"""3.3.3 定义WOE和IV函数

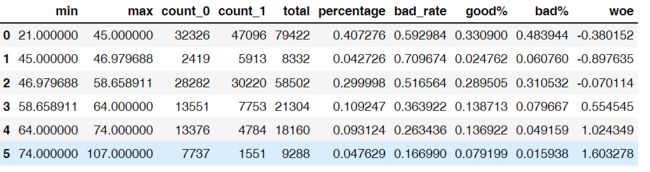

#计算WOE和BAD RATE

#BAD RATE与bad%不是一个东西

#BAD RATE是一个箱中,坏的样本所占的比例 (bad/total)

#而bad%是一个箱中的坏样本占整个特征中的坏样本的比例

def get_woe(num_bins):

# 通过 num_bins 数据计算 woe

columns = ["min","max","count_0","count_1"]

df = pd.DataFrame(num_bins,columns=columns)

df["total"] = df.count_0 + df.count_1

df["percentage"] = df.total / df.total.sum()

df["bad_rate"] = df.count_1 / df.total

df["good%"] = df.count_0/df.count_0.sum()

df["bad%"] = df.count_1/df.count_1.sum()

df["woe"] = np.log(df["good%"] / df["bad%"])

return df

#计算IV值

def get_iv(df):

rate = df["good%"] - df["bad%"]

iv = np.sum(rate * df.woe)

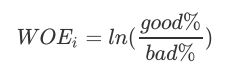

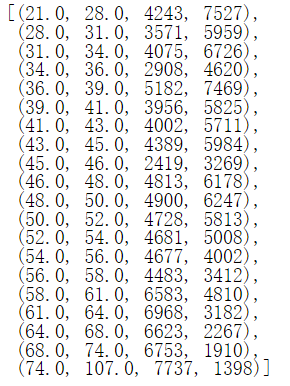

return iv3.3.4 卡方检验,合并箱体,画出IV曲线

num_bins_ = num_bins.copy()

import matplotlib.pyplot as plt

import scipy

IV = []

axisx = []

while len(num_bins_) > 2:#大于设置的最低分箱个数

pvs = []

#获取 num_bins_两两之间的卡方检验的置信度(或卡方值)

for i in range(len(num_bins_)-1):

x1 = num_bins_[i][2:]

x2 = num_bins_[i+1][2: ]

# 0 返回 chi2 值,1 返回 p 值。

pv = scipy.stats.chi2_contingency([x1,x2])[1]#p值

# chi2 = scipy.stats.chi2_contingency([x1,x2])[0]#计算卡方值

pvs.append(pv)

# 通过 p 值进行处理。合并 p 值最大的两组

i = pvs.index(max(pvs))

num_bins_[i:i+2] = [(

num_bins_[i][0],

num_bins_[i+1][1],

num_bins_[i][2]+num_bins_[i+1][2],

num_bins_[i][3]+num_bins_[i+1][3])]

bins_df = get_woe(num_bins_)

axisx.append(len(num_bins_))

IV.append(get_iv(bins_df))

plt.figure()

plt.plot(axisx,IV)

plt.xticks(axisx)

plt.xlabel("number of box")

plt.ylabel("IV")

plt.show()

#选择转折点处,也就是下坠最快的折线点,所以这里对于age来说选择箱数为63.3.5 用最佳分箱个数分箱,并验证分箱结果

def get_bin(num_bins_,n):

while len(num_bins_) > n:

pvs = []

for i in range(len(num_bins_)-1):

x1 = num_bins_[i][2:]

x2 = num_bins_[i+1][2:]

pv = scipy.stats.chi2_contingency([x1,x2])[1]

# chi2 = scipy.stats.chi2_contingency([x1,x2])[0]

pvs.append(pv)

i = pvs.index(max(pvs))

num_bins_[i:i+2] = [(

num_bins_[i][0],

num_bins_[i+1][1],

num_bins_[i][2]+num_bins_[i+1][2],

num_bins_[i][3]+num_bins_[i+1][3])]

return num_bins_

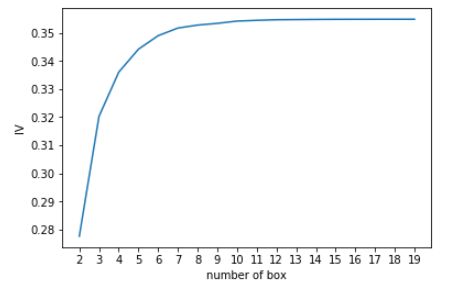

afterbins = get_bin(num_bins,6)

afterbins[(21.0, 36.0, 14797, 24832),

(36.0, 54.0, 39070, 51504),

(54.0, 61.0, 15743, 12224),

(61.0, 64.0, 6968, 3182),

(64.0, 74.0, 13376, 4177),

(74.0, 107.0, 7737, 1398)]bins_df = get_woe(num_bins)

bins_df

#希望每组的bad_rate相差越大越好;

# woe差异越大越好,应该具有单调性,随着箱的增加,要么由正到负,要么由负到正,只能有一个转折过程;

# 如果woe值大小变化是有两个转折,比如呈现w型,证明分箱过程有问题

# num_bins保留的信息越多越好3.3.6 将选取最佳分箱个数的过程包装为函数

def graphforbestbin(DF, X, Y, n=5,q=20,graph=True):

'''

自动最优分箱函数,基于卡方检验的分箱

参数:

DF: 需要输入的数据

X: 需要分箱的列名

Y: 分箱数据对应的标签 Y 列名

n: 保留分箱个数

q: 初始分箱的个数

graph: 是否要画出IV图像

区间为前开后闭 (]

'''

DF = DF[[X,Y]].copy()

DF["qcut"],bins = pd.qcut(DF[X], retbins=True, q=q,duplicates="drop")

coount_y0 = DF.loc[DF[Y]==0].groupby(by="qcut").count()[Y]

coount_y1 = DF.loc[DF[Y]==1].groupby(by="qcut").count()[Y]

num_bins = [*zip(bins,bins[1:],coount_y0,coount_y1)]

for i in range(q):

if 0 in num_bins[0][2:]:

num_bins[0:2] = [(

num_bins[0][0],

num_bins[1][1],

num_bins[0][2]+num_bins[1][2],

num_bins[0][3]+num_bins[1][3])]

continue

for i in range(len(num_bins)):

if 0 in num_bins[i][2:]:

num_bins[i-1:i+1] = [(

num_bins[i-1][0],

num_bins[i][1],

num_bins[i-1][2]+num_bins[i][2],

num_bins[i-1][3]+num_bins[i][3])]

break

else:

break

def get_woe(num_bins):

columns = ["min","max","count_0","count_1"]

df = pd.DataFrame(num_bins,columns=columns)

df["total"] = df.count_0 + df.count_1

df["percentage"] = df.total / df.total.sum()

df["bad_rate"] = df.count_1 / df.total

df["good%"] = df.count_0/df.count_0.sum()

df["bad%"] = df.count_1/df.count_1.sum()

df["woe"] = np.log(df["good%"] / df["bad%"])

return df

def get_iv(df):

rate = df["good%"] - df["bad%"]

iv = np.sum(rate * df.woe)

return iv

IV = []

axisx = []

while len(num_bins) > n:

pvs = []

for i in range(len(num_bins)-1):

x1 = num_bins[i][2:]

x2 = num_bins[i+1][2:]

pv = scipy.stats.chi2_contingency([x1,x2])[1]

pvs.append(pv)

i = pvs.index(max(pvs))

num_bins[i:i+2] = [(

num_bins[i][0],

num_bins[i+1][1],

num_bins[i][2]+num_bins[i+1][2],

num_bins[i][3]+num_bins[i+1][3])]

bins_df = pd.DataFrame(get_woe(num_bins))

axisx.append(len(num_bins))

IV.append(get_iv(bins_df))

if graph:

plt.figure()

plt.plot(axisx,IV)

plt.xticks(axisx)

plt.xlabel("number of box")

plt.ylabel("IV")

plt.show()

return bins_df3.3.7 对所有特征进行分箱选择

model_data.columns

for i in model_data.columns[1:-1]:

print(i)

graphforbestbin(model_data,i,"SeriousDlqin2yrs",n=2,q=20)我们发现,不是所有的特征都可以使用这个分箱函数,比如说有的特征,像家人数量,就无法分出20组。于是我们将可以分箱的特征放出来单独分组,不能自动分箱的变量自己观察然后手写:

auto_col_bins = {"RevolvingUtilizationOfUnsecuredLines":6,

"age":5,

"DebtRatio":4,

"MonthlyIncome":3,

"NumberOfOpenCreditLinesAndLoans":5}

#不能使用自动分箱的变量

hand_bins = {"NumberOfTime30-59DaysPastDueNotWorse":[0,1,2,13]

,"NumberOfTimes90DaysLate":[0,1,2,17]

,"NumberRealEstateLoansOrLines":[0,1,2,4,54]

,"NumberOfTime60-89DaysPastDueNotWorse":[0,1,2,8]

,"NumberOfDependents":[0,1,2,3]}

#保证区间覆盖使用 np.inf替换最大值,用-np.inf替换最小值

#原因:比如一些新的值出现,例如家庭人数为30,以前没出现过,改成范围为极大值之后,这些新值就都能分到箱里边了

hand_bins = {k:[-np.inf,*v[:-1],np.inf] for k,v in hand_bins.items()}接下来对所有特征按照选择的箱体个数和手写的分箱范围进行分箱:

bins_of_col = {}

# 生成自动分箱的分箱区间和分箱后的 IV 值

for col in auto_col_bins:

bins_df = graphforbestbin(model_data,col

,"SeriousDlqin2yrs"

,n=auto_col_bins[col]

#使用字典的性质来取出每个特征所对应的箱的数量

,q=20

,graph=False)

bins_list = sorted(set(bins_df["min"]).union(bins_df["max"]))

#保证区间覆盖使用 np.inf 替换最大值 -np.inf 替换最小值

bins_list[0],bins_list[-1] = -np.inf,np.inf

bins_of_col[col] = bins_list

#合并手动分箱数据

bins_of_col.update(hand_bins)

bins_of_col{'RevolvingUtilizationOfUnsecuredLines': [-inf,

0.09909043049999999,

0.29835392219821566,

0.4660431495395586,

0.9829753622760821,

0.9999998999999999,

inf],

'age': [-inf, 36.0, 54.0, 61.0, 74.0, inf],

'DebtRatio': [-inf,

0.017413871075204715,

0.32057964097944214,

1.4688993235185674,

inf],

'MonthlyIncome': [-inf, 0.10388691034195464, 6900.0, inf],

'NumberOfOpenCreditLinesAndLoans': [-inf, 1.0, 3.0, 5.0, 17.0, inf],

'NumberOfTime30-59DaysPastDueNotWorse': [-inf, 0, 1, 2, inf],

'NumberOfTimes90DaysLate': [-inf, 0, 1, 2, inf],

'NumberRealEstateLoansOrLines': [-inf, 0, 1, 2, 4, inf],

'NumberOfTime60-89DaysPastDueNotWorse': [-inf, 0, 1, 2, inf],

'NumberOfDependents': [-inf, 0, 1, 2, inf]}3.4 计算各箱的WOE并映射到数据中

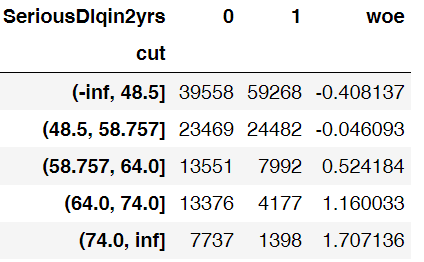

data = model_data.copy()

#函数pd.cut,可以根据已知的分箱间隔把数据分箱

#参数为 pd.cut(数据,以列表表示的分箱间隔)

data = data[["age","SeriousDlqin2yrs"]].copy()

data["cut"] = pd.cut(data["age"],[-np.inf, 48.49986200790144, 58.757170160044694, 64.0, 74.0, np.inf])

data.head()

#将数据按分箱结果聚合,并取出其中的标签值

data.groupby("cut")["SeriousDlqin2yrs"].value_counts()

#使用unstack()来将树状结构变成表状结构

data.groupby("cut")["SeriousDlqin2yrs"].value_counts().unstack()

bins_df = data.groupby("cut")["SeriousDlqin2yrs"].value_counts().unstack()

bins_df["woe"] = np.log((bins_df[0]/bins_df[0].sum())/(bins_df[1]/bins_df[1].sum()))

bins_df把以上过程包装成函数:

def get_woe(df,col,y,bins):

df = df[[col,y]].copy()

df["cut"] = pd.cut(df[col],bins)

bins_df = df.groupby("cut")[y].value_counts().unstack()

woe = bins_df["woe"] = np.log((bins_df[0]/bins_df[0].sum())/(bins_df[1]/bins_df[1].sum()))

return woe

#将所有特征的WOE存储到字典当中

woeall = {}

for col in bins_of_col:

woeall[col] = get_woe(model_data,col,"SeriousDlqin2yrs",bins_of_col[col])

woeall#不希望覆盖掉原本的数据,创建一个新的DataFrame,索引和原始数据model_data一模一样

model_woe = pd.DataFrame(index=model_data.index)

#将原数据分箱后,按箱的结果把WOE结构用map函数映射到数据中

model_woe["age"] = pd.cut(model_data["age"],bins_of_col["age"]).map(woeall["age"])

#对所有特征操作可以写成:

for col in bins_of_col:

model_woe[col] = pd.cut(model_data[col],bins_of_col[col]).map(woeall[col])

#将标签补充到数据中

model_woe["SeriousDlqin2yrs"] = model_data["SeriousDlqin2yrs"]

#这就是我们的建模数据了

model_woe.head()3.5 建模与模型验证

vali_woe = pd.DataFrame(index=vali_data.index)

for col in bins_of_col:

vali_woe[col] = pd.cut(vali_data[col],bins_of_col[col]).map(woeall[col])

vali_woe["SeriousDlqin2yrs"] = vali_data["SeriousDlqin2yrs"]

vali_X = vali_woe.iloc[:,:-1]

vali_y = vali_woe.iloc[:,-1]X = model_woe.iloc[:,:-1]

y = model_woe.iloc[:,-1]

from sklearn.linear_model import LogisticRegression as LR

lr = LR().fit(X,y)

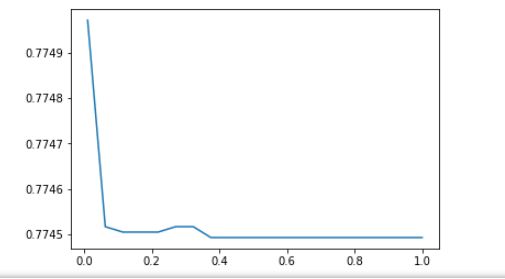

lr.score(vali_X,vali_y)#0.8641356370249832c_1 = np.linspace(0.01,1,20)

c_2 = np.linspace(0.01,0.2,20)

score = []

for i in c_1:

lr = LR(solver='liblinear',C=i).fit(X,y)

score.append(lr.score(vali_X,vali_y))

plt.figure()

plt.plot(c_1,score)

plt.show()

lr.n_iter_#array([7], dtype=int32)

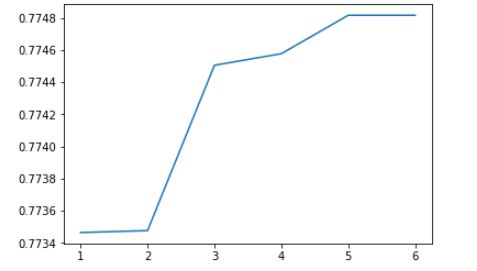

score = []

for i in [1,2,3,4,5,6]:

lr = LR(solver='liblinear',C=0.025,max_iter=i).fit(X,y)

score.append(lr.score(vali_X,vali_y))

plt.figure()

plt.plot([1,2,3,4,5,6],score)

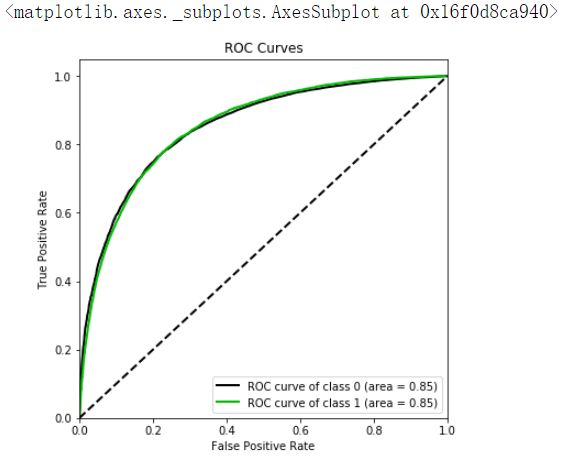

plt.show()import scikitplot as skplt

#%%cmd

#pip install scikit-plot

vali_proba_df = pd.DataFrame(lr.predict_proba(vali_X))

skplt.metrics.plot_roc(vali_y, vali_proba_df,

plot_micro=False,figsize=(6,6),

plot_macro=False)3.6 制作评分卡

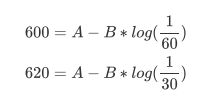

B = 20/np.log(2)

A = 600 + B*np.log(1/60)

B,A

'''

(28.85390081777927, 481.8621880878296)

'''base_score = A - B*lr.intercept_#lr.intercept_:截距

base_score#array([481.56390143])

score_age = woeall["age"] * (-B*lr.coef_[0][1])#lr.coef_:每一个特征建模之后得出的系数

score_age#"age"特征中每个箱对应的分数cut

(-inf, 36.0] -11.283828

(36.0, 54.0] -6.060951

(54.0, 61.0] 5.390654

(61.0, 74.0] 21.917238

(74.0, inf] 36.934580

dtype: float64file = "./ScoreData.csv"

#open是用来打开文件的python命令,第一个参数是文件的路径+文件名,如果你的文件是放在根目录下,则你只需要文件名就好

#第二个参数是打开文件后的用途,"w"表示用于写入,通常使用的是"r",表示打开来阅读

#首先写入基准分数

#之后使用循环,每次生成一组score_age类似的分档和分数,不断写入文件之中

with open(file,"w") as fdata:

fdata.write("base_score,{}\n".format(base_score))

for i,col in enumerate(X.columns):#[*enumerate(X.columns)]

score = woeall[col] * (-B*lr.coef_[0][i])

score.name = "Score"

score.index.name = col

score.to_csv(file,header=True,mode="a")