YOLOX进行目标检测(东北大学钢材表面缺陷数据集)

YOLOX训练数据集(东北大学数据集)

参考博文添加链接描述

1. 版本配置

cuda:11.6 #nvidia-smi查看自己电脑支持的版本

Python:3.9

torch-1.12.0+cu116-cp39-cp39-win_amd64.whl #下载地址https://download.pytorch.org/whl/torch_stable.html

torchvision-0.13.0+cu116-cp39-cp39-win_amd64.whl #下载地址https://download.pytorch.org/whl/torch_stable.html

2.配置环境并验证

2.1 YOLOX源码下载地址

https://github.com/Megvii-BaseDetection/YOLOX

2.2 执行安装

pip install -r requirements.txt

~~~~~~~~~~~~~~~~~~~~~~

#为支持Python3.9修改requirements.txt的onnx版本

onnx==1.9.0

#执行安装

python setup.py install

#安装apex,下载地址

https://github.com/NVIDIA/apex

#下载完成后,解压后,在Shell里,进入到apex-master中执行安装命令

pip install -r requirements.txt python setup.py install

#安装pycocotools

pip install pycocotools

#下载预训练模型放到根目录

https://github.com/Megvii-BaseDetection/YOLOX/releases/download/0.1.1rc0/yolox_s.pth。

#验证环境,执行

python tools/demo.py image -f exps/default/yolox_s.py -c ./yolox_s.pth

--path assets/dog.jpg --conf 0.3 --nms 0.65 --tsize 640 --save_result --device gpu

3.制作数据集

3.1下载数据集

按照测试集,训练集,验证集2:1:1的比例进行创建

链接:https://pan.baidu.com/s/1BeLQswzExLJ1tQrlWBhUcA?pwd=x04j

提取码:x04j

3.2转化为VOC2007数据集

新建data/VOCdevkit

将下载好的VOC2007数据集粘贴到此文件夹

4.训练自己的数据集

4.1 修改exps/example/yolox_voc/yolox_voc_s.py

- 本次使用的类别有6类,所以将num_classes修改为6。

- 修改文件路径,将data_dir修改为自己目录,删掉image_sets里面的2012

- 修改test路径,将data_dir修改为自己目录

4.2 打开yolox/data/datasets/voc_classes.py文件,修改为自己的类别名:

4.3 打开yolox/data/datasets/voc.py,去掉{}里的s,否则找不到文件路径

4.4 重新编译yolox

python setup.py install

4.5 命令行执行

python tools/train.py -f exps/example/yolox_voc/yolox_voc_s.py -d 1 -b 4 --fp16 -c yolox_s.pth

4.6 采用train.py文件执行

#修改批处理大小为4

parser.add_argument("-b", "--batch-size", type=int, default=4, help="batch size")

#修改设备数为1

parser.add_argument("-d", "--devices", default=1, type=int, help="device for training" )

#修改训练的模型声明文件

parser.add_argument(

"-f",

"--exp_file",

default='exps/example/yolox_voc/yolox_voc_s.py',

type=str,

help="plz input your experiment description file",

)

#上次训练的结果,继续训练和fine turning时填写check point路径

parser.add_argument("-c", "--ckpt", default='yolox_s.pth', type=str, help="checkpoint file")

#训练时采用混合精度

parser.add_argument(

"--fp16",

dest="fp16",

default=True,

action="store_true",

help="Adopting mix precision training.",

)

若在训练过程中终止,继续训练

#将其修改为True

parser.add_argument(

"--resume", default=True, action="store_true", help="resume training"

)

#上次训练的结果

parser.add_argument(

"-c", "--ckpt", default='YOLOX_outputs/yolox_voc_s/best_ckpt.pth', type=str, help="checkpoint file"

)

#修为自己想要开始的轮数

parser.add_argument(

"-e",

"--start_epoch",

default=None,

type=int,

help="resume training start epoch",

)

5.测试

5.1 修改参数

# 在yolox/data/datasets/__init__.py中导入“VOC_CLASSES”

from.voc_classes import VOC_CLASSES

#修改tools/demo.py中代码,将“COCO_CLASSES”,改为“VOC_CLASSES”

from yolox.data.datasets import COCO_CLASSES,VOC_CLASSES

#将“306”行的Predictor类初始化传入的“COCO_CLASSES”改为“VOC_CLASSES”

predictor = Predictor(

model, exp, VOC_CLASSES, trt_file, decoder,

args.device, args.fp16, args.legacy,

)

5.2 命令行测试

#重新执行编译

python setup.py install

#命令行测试,在.assets文件夹下新建NEU文件夹,保存测试用例

python tools/demo.py image -f exps/example/yolox_voc/yolox_voc_s.py -c

YOLOX_outputs/yolox_voc_s/latest_ckpt.pth --path ./assets/NEU --conf 0.3 --nms 0.65 --tsize 640 --save_result --device gpu

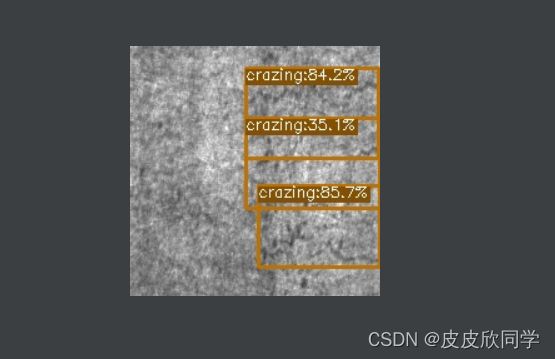

测试示例:

5.3 使用demo.py测试

#修改以下数据

parser.add_argument(

'-do', "--demo", default="image", help="demo type, eg. image, video and webcam"

)

#修改测试路径

parser.add_argument(

"--path", default="./assets/NEU", help="path to images or video"

)

#修改模型声明文件

parser.add_argument(

"-f",

"--exp_file",

default="exps/example/yolox_voc/yolox_voc_s.py",

type=str,

help="please input your experiment description file",

)

#修改训练结果路径

parser.add_argument(

"-c", "--ckpt", default="YOLOX_outputs/yolox_voc_s/best_ckpt.pth",

type=str, help="ckpt for eval")

#修改设备为gpu

parser.add_argument(

"--device",

default="gpu",

type=str,

help="device to run our model, can either be cpu or gpu",

)

#保存路径

parser.add_argument(

"--save_result",

default='.YOLOX_outputs/yolox_voc_s/vis_res',

action="store_true",

help="whether to save the inference result of image/video",

)

#修改nms和tsize

parser.add_argument("--nms", default=0.45, type=float, help="test nms threshold")

parser.add_argument("--tsize", default=640, type=int, help="test img size")

6.保存测试结果

打开yolox/utils.visualize.py文件,修改vis方法

#新增result_list数组

result_list = []

#在color自变量前增加以下代码

class_name = class_names[cls_id]

one_line = (str(x0), str(y0), str(x1), str(y1), class_name, str(float(score)))

str_one_line = " ".join(one_line)

result_list.append(str_one_line)

#增加返回值

return img,result_list

修改demo.py方法

#修改visual函数

#当未找到时

if output is None:

result_list=['NO MATCH!']

return img,result_list

#增加返回值

vis_res,result_list = vis(img, bboxes, scores, cls, cls_conf, self.cls_names)

return vis_res,result_list

#在image_demo方法中修改

result_image,result_list = predictor.visual(outputs[0], img_info, predictor.confthre)

print(result_list)

#写入文本文档

save_file_name = os.path.join(save_folder, os.path.basename(image_name))

logger.info("Saving detection result in {}".format(save_file_name))

txt_name = os.path.splitext(save_file_name)[0] + ".txt"

print(txt_name)

f = open(txt_name, "w")

for line in result_list:

f.write(str(line) + '\n')

f.close()

cv2.imwrite(save_file_name, result_image)

遇到的一些BUG

No module named 'tensorboard'

#更新pip,进行对应包的安装

python -m pip install --upgrade pip

pip install tensorboard

搜索data_num_workers变量,在yolox_base.py文件中将其修改为0,重新编译执行