XGBOOST集成树模型的原理梳理

0 前言

xgboost本身是集成树模型,在了解其原理之前,先对树模型的机器学习基础知识做一定介绍。

监督学习元素

(1)学习模型(即已知x,求出y的模型表达式)

比如:线性模型;

逻辑回归模型;

(2)参数

从数据当中学习得到模型参数。

(3)目标函数

包含两部分:损失函数+正则项

损失函数是衡量模型拟合训练数据的能力。

在训练数据上的损失函数,有多种形式:比如平方损失、逻辑回归损失;

正则项是衡量模型复杂度,有L1正则项,L2正则项;

目标函数包含两部分的原因就是:保证至少在训练数据上,该模型能较好地接近训练数据的分布,即拟合准确率高;同时,更简单的模型在测试集上预测会具有更小的方差,可以让模型更具稳定性。

集成学习方法

像GBM、随机森林等广泛被应用的,许多比赛中取得优异成绩的通常都是利用树的集成方法。

可以不用特征归一化,可以学习特征之间高阶关联,

在单个变量上学习一棵树

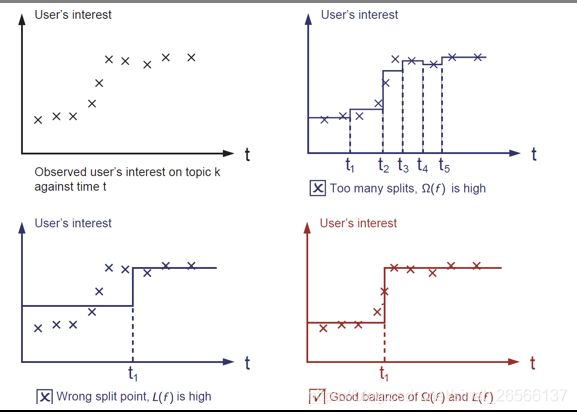

可以看到,最好的学习效果就是在损失函数和正则项之间达到一个很好的平衡。即树本身模型的损失函数和树的复杂度,通常咱们描述树的学习(以决策树为例),会提到如下几点,对应在模型中的提现见箭头后面:

(1)通过信息增益分裂 —> 损失函数

(2)剪枝 —> 通过定义的节点进行正则化项

(3)最大深度 —>在函数空间的约束

(4)使叶子结点的值变光滑 —>对叶子结点的L2正则化。

回归树不仅仅用来做回归

回归树集成定义了你可以怎样定义预测得分,可用来做分类、回归、排序…,取决于你怎样定义你的目标函数,目前我们了解到的目标函数:

平方损失函数:会导致梯度提升;

逻辑回归损失函数:会导致梯度对数提升

对于集成树模型,怎样学习模型?

我们不能用随机梯度下降的方法,去寻找下一个迭代值;因为我们的元素是一颗树,而不是数值向量。

解决办法就是:让模型从常数预测函数项开始,每次加入新的函数,新加入的函数就是我们需要决定的,通过加入这个新函数,让总体(目标函数+正则)达到最小;

1、XGBOOST原理

Xgboost是Boosting算法的其中一种,Boosting算法的思想是将许多弱分类器集成在一起,形成一个强分类器。因为Xgboost是一种提升树模型,所以它是将许多树模型集成在一起,形成一个很强的分类器。而所用到的树模型则是CART回归树模型。

Xgboost是在GBDT的基础上进行改进,使之更强大,适用于更大范围。

Xgboost一般和sklearn一起使用,但是由于sklearn中没有集成Xgboost,所以才需要单独下载安装。

2、XGBOOST的优点

正则化

实际上,Xgboost是以“正则化提升(regularized boosting)” 技术而闻名。Xgboost在代价函数里加入了正则项,用于控制模型的复杂度。正则项里包含了树的叶子节点个数,每个叶子节点上输出的score的L2模的平方和。从Bias-variance tradeoff角度来讲,正则项降低了模型的variance,使学习出来的模型更加简单,防止过拟合,这也是Xgboost优于传统GBDT的一个特征

并行处理

Xgboost工具支持并行。众所周知,Boosting算法是顺序处理的,也是说Boosting不是一种串行的结构吗?怎么并行的?注意Xgboost的并行不是tree粒度的并行。Xgboost也是一次迭代完才能进行下一次迭代的(第t次迭代的代价函数里包含)。Xgboost的并行式在特征粒度上的,也就是说每一颗树的构造都依赖于前一颗树。

我们知道,决策树的学习最耗时的一个步骤就是对特征的值进行排序(因为要确定最佳分割点),Xgboost在训练之前,预先对数据进行了排序,然后保存为block结构,后面的迭代中重复使用这个结构,大大减小计算量。这个block结构也使得并行成为了可能,在进行节点的分类时,需要计算每个特征的增益,大大减少计算量。这个block结构也使得并行成为了可能,在进行节点的分裂的时候,需要计算每个特征的增益,最终选增益最大的那个特征去做分裂,那么各个特征的增益计算就可以开多线程进行。

灵活性

Xgboost支持用户自定义目标函数和评估函数,只要目标函数二阶可导就行。它对模型增加了一个全新的维度,所以我们的处理不会受到任何限制。

缺失值处理

对于特征的值有缺失的样本,Xgboost可以自动学习出他的分裂方向。Xgboost内置处理缺失值的规则。用户需要提供一个和其他样本不同的值,然后把它作为一个参数穿进去,以此来作为缺失值的取值。Xgboost在不同节点遇到缺失值时采用不同的处理方法,并且会学习未来遇到缺失值时的处理方法。

剪枝

Xgboost先从顶到底建立所有可以建立的子树,再从底到顶反向机芯剪枝,比起GBM,这样不容易陷入局部最优解

内置交叉验证

Xgboost允许在每一轮Boosting迭代中使用交叉验证。因此可以方便的获得最优Boosting迭代次数,而GBM使用网格搜索,只能检测有限个值。

参考

https://www.cnblogs.com/wj-1314/p/9402324.html

https://zdkswd.github.io/2019/03/04/XGBoost%20%E4%B8%AA%E4%BA%BA%E6%80%BB%E7%BB%93/(内含陈天琦关于xgboost的高清PPT)