再一次突破技术边界 | re:Invent 2022 Peter DeSantis主题演讲首发

点击上方【凌云驭势 重塑未来】

一起共赴年度科技盛宴!

北京时间11月29日上午11:30,伴随着亚马逊云科技高级副总裁 Peter DeSantis 的精彩演讲,万众瞩目的“全球云计算风向标大会” 2022亚马逊云科技 re:lnvent 全球大会 正式拉开帷幕。

不负万千期待,Peter DeSantis 带着一系列充满惊喜的创新产品登场,其中包含 Nitro v5 系统、Graviton3E 芯片以及高性能计算实例 HPC7g、C7gn、网络优化机器学习实例 Trn1n。除此之外,在演讲中 Peter 也发布了包含计算、网络、算法及 Serverless 等最新功能特性。这场演讲究竟有多高能?让我们一起先睹为快。

1

性能优先,兼顾成本与安全

亚马逊云科技开启云服务的新可能

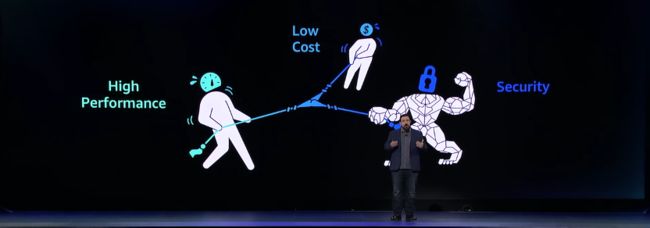

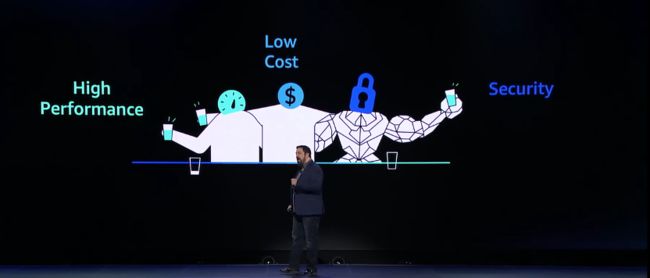

在开场时,Peter DeSantis 首先提到了云计算的基础理念,即:弹性、安全、性能、成本、可用性及可持续性,这也是亚马逊云科技在云计算领域的建设理念。Peter 从其中最重要的“性能”谈起,讲述亚马逊云科技是如何在不断强化云服务性能的基础上,来兼顾其他因素的。

一直以来,当用户期望在云计算服务中获得更高的性能表现时,可能会需要牺牲一些成本或安全。Peter DeSantis 认为:“以往情况下,如果客户不愿在安全性和成本等问题上做出让步,就很难实现性能。”

亚马逊云科技从不在这三方面进行妥协。在这个选择悖论中,亚马逊云科技给出了自己的答案:通过自身技术的不断演进和创新,让云计算可以兼顾高性能、高安全性和低成本。

![]()

“我们一直在创新” Peter DeSantis 说道,“在不需要牺牲安全的情况下,减少我们的成本,同时提高我们的性能,让客户及应用获得更好的体验。”

2

计算实例创新:多系列性能高幅提升

硬件创新

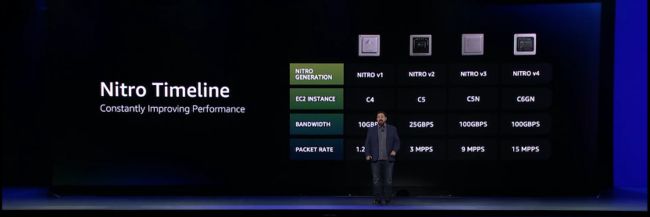

Peter DeSantis 回顾了 Nitro 的起源和发展的历程:从2017年起,为了让用户的应用能够获得更佳的性能表现,亚马逊云科技自研了 Nitro 系统,将计算、存储、网络等传统负载 Offload 到专属硬件层面,大幅提升虚拟化及客户实例的性能。

Nitro系统全面提升EC2实例的安全表现,并能更好地提升计算、存储和网络的性能。Nitro系统还支持裸金属EC2实例,能够让所有的服务器资源都充分调用到客户的负载上去。

Nitro 已经更新了4个版本,支持的实例从 C4 发展到 C6gn。亚马逊云科技一直通过系统和芯片的创新,来提升计算的性能。

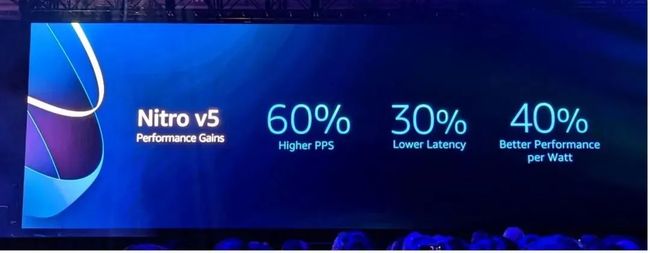

新发布!Nitro v5

今天,我们重磅发布Nitro v5!基于ARM架构的Nitro 芯片中的晶体管数量比前一代增加了一倍,提供了更多的计算性能,同时带来50%的 DRAM 内容性能提升,2倍的PCle 带宽提升。

相比于前一代产品,Nitro 将显著改善延迟30%,同时每瓦性能提高40%,PPS 提高60%。

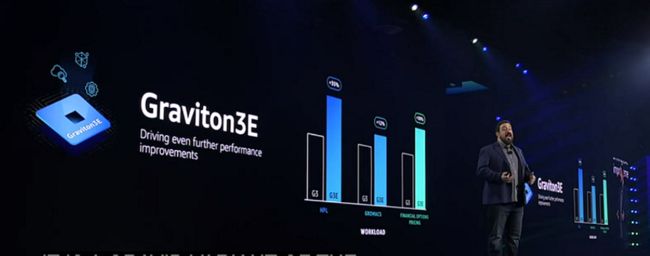

Graviton3E 芯片全新登场

新版本的基于 Arm 的定制 Graviton3E系列芯片,专为支持高性能计算工作负载而设计。新的Graviton3E 芯片,相比现有 Graviton 系列,有着更高的性能提升,对依赖矢量指令的工作负载的性能提高35%。

实例创新

高性能计算实例 HPC7g 和 C7gn

适配更多高性能计算场景需求

基于 Graviton3E 芯片,我们推出了面向高性能计算的 HPC7g ,适用于天气预报、生命科学、工程计算等高性能计算场景。这种新的实例类型有多种大小,最多具有64个 vCPU 和 128GiB 内存,这些实例将在2023年初正式投入商用。

为了适配更多网络密集型工作负载需求,亚马逊云科技还推出了新的 Graviton 3E 实例类型 C7gn。

相比于 C7g 实例,C7gn 实例为要求更为严苛的网络密集型工作负载而设计:包含网络虚拟设备(防火墙、虚拟路由器、负载均衡器等)、数据分析和紧密耦合的集群计算作业场景。

C7gn 由 Amazon Graviton3E 处理器提供支持,将支持高达 200Gbps 的网络带宽,并提高50%的数据包处理性能。

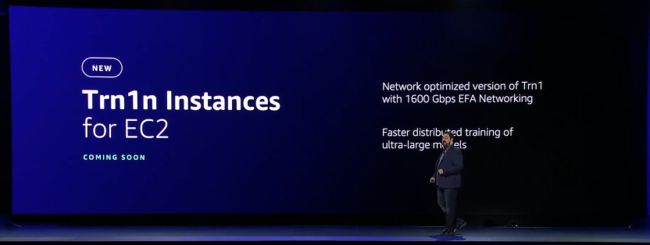

优化网络性能的 Trn1n 实例

应对超大规模分布式模型训练场景

在 AI 大模型训练中,从传统的几千参数的 Backprop,到百万级的 Bert,十亿级的 GPT-3、PAML,甚至超大规模的 Switch-C,都在对计算芯片提出新的需求,同时在数据网络层面,计算芯片也正面临着新的挑战。

面向下一代计算、内存加速、并行训练及低网络延迟的 AI 训练需求,我们推出了 Trn1n 实例,针对 Trn1 实例进行了网络优化,增加了1600Gbps EFA 网络功能,使之能够更快地面对超大规模分布式模型训练场景。

3

网络协议创新:新产品 新理念

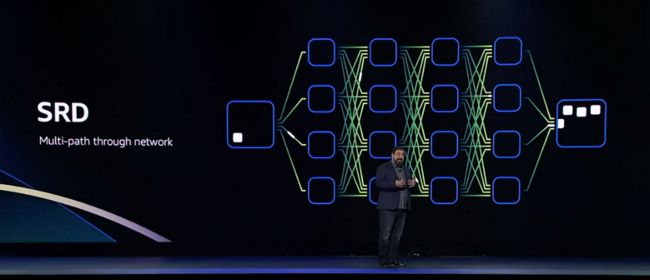

基于亚马逊自身网络经验,我们推出了新的产品和理念。首先,Peter DeSantis 表示,相比于传统的 TCP 单路径路由网络,亚马逊云科技自己的 SRD(Scalable Reliable Datagram )协议使用了多路径路由,这项协议不按顺序传输数据包,但可以在数据包乱序到达时进行整理。

Peter DeSantis 表示它将“以微秒而不是毫秒”重新传输丢弃的数据包,并加速托管在亚马逊云科技上的网络。

Peter DeSantis 同时也表示,它的性能优于 TCP,因为它基于 Nitro 硬件进行了调整和优化,亚马逊云科技通过 Nitro 系统将计算、网络和存储事务与主机隔离开来,以提升硬件性能。

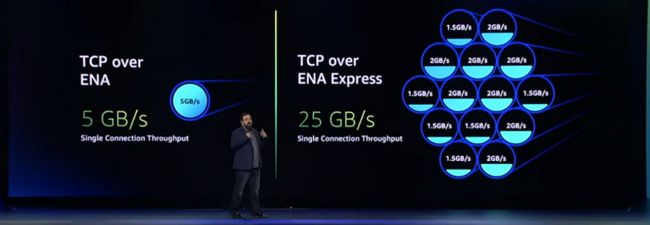

全新 ENA Express

大幅减少流量延迟

我们推出了全新的 ENA Express。ENA Express 以为 Elastic Fabric Adapters 提供支持的 SRD 协议为基础,将流量的 P99 延迟减少了50%,将 P99.9 延迟减少85%(与 TCP 相比),同时还将最大单流带宽从 5Gbps 到增加到了 25Gbps。最重要的是,从此您可以获得更多的每流带宽和更少的可变性。

您可以在新的和现有的 ENA 上启用 ENA Express,并立即利用此性能来处理在同一可用区中运行的 c6gn 实例之间的 TCP 和 UDP 流量。

Peter DeSantis 在小结中表示,SRD 作为亚马逊云科技的核心加速基础创新,已经不仅止步于网络加速功能,更在 EFA 高性能计算、EBS 存储上有所应用。未来所有的新 EBS io2 型存储将运行在 SRD 协议及环境上,以提升性能表现。

4

软件架构创新:从未止步 不负期待

最后,Peter DeSantis 回顾了 Serverless 计算的发展历史。2014年 Amazon.com 首席技术官Werner Vogels博士在 re:Invent 全球大会上发布了 Lambda 服务,重新定义了云计算的 Serverless 发展理念。至今,我们已累计发布了超过100款新的功能,活跃用户超过100万,同时每月的调用请求量超过100万亿次。获得客户和行业的广泛认可。

现在,我们面向 Lambda 的创新仍未止步。Peter 用 Lambda 的冷启动时间优化来说明这一点。

在通常情况下,当某个功能长时间不使用时,Lambda 会关闭虚拟机,尽管有了更快的 Firecracker microVM 等改进,但这仍然需要一段时间。

长期以来,冷启动 Cold Start 时间一直是对 Lambda 最大的优化需求之一,但正如 Peter DeSantis 提到的,面向尖峰工作负载几乎是 Lambda 的构建目标。曾经,凭借我们的 Firecracker MicroVM,已经将冷启动时间从几秒缩短到不到一秒。现在,我们推出了新的功能,可将冷启动时间缩短90%。

Lambda SnapStart

无惧巅峰业务挑战

现在,借助 SnapStart,我们可以通过创建客户 Lambda 函数快照来解决这个问题,只需启动它们而无需经过常规的初始化过程。这项新功能现在可供所有 Lambda 用户使用,通过现有的 Lambda 函数即可启动。目前,这项服务适用于使用 Corretto 运行时的 Java 函数。

启用后,当您首次运行该函数时,它将执行标准初始化。之后,它将创建内存和磁盘状态的加密快照并缓存以供重用。然后,当再次调用该函数时,Lambda 将获取缓存并启动该函数。缓存的快照在闲置14天后将被删除。

Peter DeSantis 最后介绍到,目前已经有很多客户在测试和使用 Lambda SnapStart,并反馈这项新技术已经明显降低了90%以上的延迟,该应用无需变更代码或架构,能够更快捷地通过 Lambda Serverless 服务面对巅峰业务的挑战。

最后,Peter DeSantis 总结到,亚马逊云科技一直在创新,在不需要牺牲安全的情况下,减少我们的成本,我们始终致力于提高我们的性能,让客户应用更好地在云上持续发展。

看完了 Peter 带来的众多创新发布

是不是更迫不及待地想看更多精彩内容了呢

本次2022 亚马逊云科技 re:Invent 全球大会中

还将迎来 DeepRacer 全球总决赛

三位中国选手已成功闯进决赛圈

黑马横空出世 又将如何搅弄风云

点击下方图片即刻参会

更多高能内容 即将轮番登场

听说,点完下面4个按钮

就不会碰到bug了!