学习BiLSTM

处理数据集【使用词汇新式】

torch.device()

以下两种方式为一个意思,经常我们会看见第一种同第二种

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

if torch.cuda.is_available():

device = torch.device("cuda")

else:

device = torch.device("cpu")

这个device的用处是作为Tensor或者Model被分配到的位置。

这个地方的cuda:0 实际上并不是0号GPU,他取决于CUDA_VISIBLE_DEVICES

然后逻辑GPU和物理GPU有一个对应关系

如果CUDA_VISIBLE_DEVICES为2,1,3

那么CUDA:0就是2号GPU, CUDA:1 就是1号GPU CUDA:3 就是3号GPU

return torch.device('cuda:0' if cuda else 'cpu')

torch.device代表将torch.Tensor分配到的设备的对象。torch.device包含一个设备类型(‘cpu’或‘cuda’)和可选的设备序号。如果设备序号不存在,则为当前设备。

n_hidden————# number of hidden units in one cell【一个单元格中的隐藏单元数】

append() 方法向列表末尾追加元素。

','.join('abc')“将字符串abc中的每个成员以字符’,'分隔开再拼接成一个字符串”,输出结果为:‘a,b,c’

vocab = list(set(" ".join(sentences).split()))

word2idx = {w: i for i, w in enumerate(vocab)}

vocab_size = len(word2idx)

##

def make_data(sentences):

inputs = []

for sen in sentences:

inputs.append(np.asarray([word2idx[n] for n in sen.split()]))

targets = []

for out in labels:

targets.append(out) # To using Torch Softmax Loss function

return torch.LongTensor(inputs), torch.LongTensor(targets)

inputs, targets = make_data(sentences)

dataset = Data.TensorDataset(inputs, targets)

loader = Data.DataLoader(dataset, batch_size, True)

介绍长短期记忆网络

转载:https://blog.csdn.net/zhengxqq27/article/details/90481590

递归神经网络的结果与传统神经网络有一些不同,它带有一个指向自身的环,用来表示它可以传递当前时刻处理的信息给下一时刻使用。

所有的递归神经网络都是由重复神经网络模块构成的一条链,可以看到它的处理层非常简单,通常是一个单tanh层,通过当前输入及上一时刻的输出来得到当前输出。与神经网络相比,经过简单地改造,它已经可以利用上一时刻学习到的信息进行当前时刻的学习了。

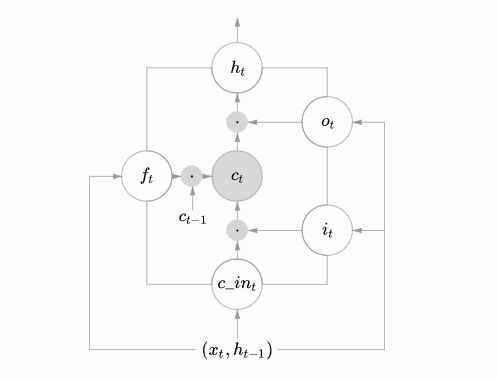

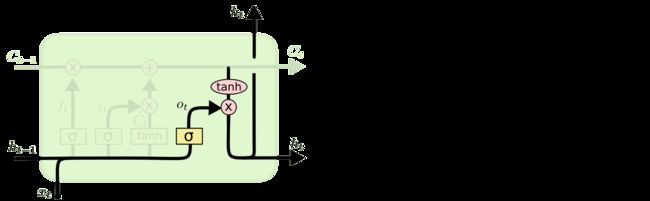

LSTM的结构与上面相似,不同的是它的重复模块会比较复杂一点,它有四层结构:

LSTM核心思想

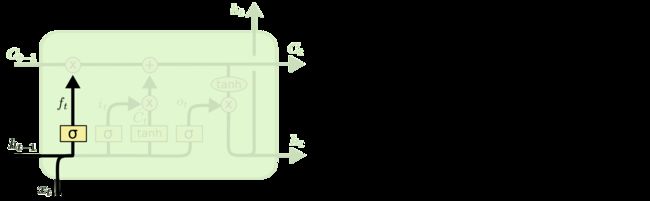

理解LSTMs的关键就是下面的矩形方框,被称为memory block(记忆块),主要包含了三个门(forget gate、input gate、output gate)与一个记忆单元(cell)。方框内上方的那条水平线,被称为cell state(单元状态),它就像一个传送带,可以控制信息传递给下一时刻。

这个矩形方框还可以表示为:

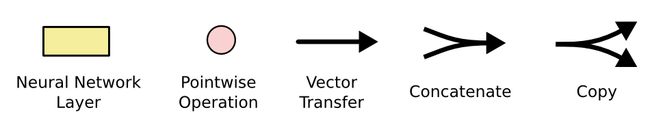

这两个图可以对应起来看,下图中心的 分别为遗忘门、输入门、输出门,用sigmoid层表示。上图中的两个tanh层则分别对应cell的输入与输出。

LSTM可以通过门控单元可以对cell添加和删除信息。通过门可以有选择地决定信息是否通过,它有一个sigmoid神经网络层和一个成对乘法操作组成,如下:

该层的输出是一个介于0到1的数,表示允许信息通过的多少,0 表示完全不允许通过,1表示允许完全通过。

逐步解析LSTM

LSTM第一步是用来决定什么信息可以通过cell state。这个决定由“forget gate”层通过sigmoid来控制,它会根据上一时刻的输出通过或部分通过。如下:

举个例子来说就是,我们在之前的句子中学到了很多东西,一些东西对当前来讲是没用的,可以对它进行选择性地过滤。

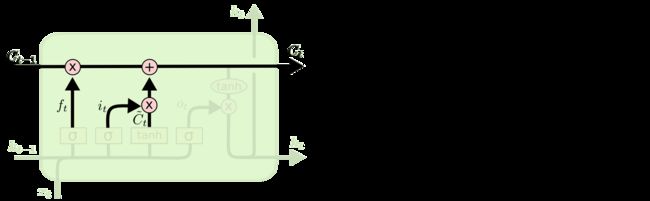

第二步是产生我们需要更新的新信息。这一步包含两部分,第一个是一个“input gate”层通过sigmoid来决定哪些值用来更新,第二个是一个tanh层用来生成新的候选值相加,得到了候选值。

一二步结合起来就是丢掉不需要的信息,添加新信息的过程:

举个例子就是,在前面的句子中我们保存的是张三的信息,现在有了新的李四信息,我们需要把张三的信息丢弃掉,然后把李四的信息保存下来。

最后一步是决定模型的输出,首先是通过sigmoid层来得到一个初始输出,然后使用tanh将

值缩放到-1到1间,再与sigmoid得到的输出逐对相乘,从而得到模型的输出。

这显然可以理解,首先sigmoid函数的输出是不考虑先前时刻学到的信息的输出,tanh函数是对先前学到信息的压缩处理,起到稳定数值的作用,两者的结合学习就是递归神经网络的学习思想。至于模型是如何学习的,那就是后向传播误差学习权重的一个过程了。

上面是对LSTM一个典型结构的理解,当然,它也会有一些结构上的变形,但思想基本不变,这里也就不多讲了。

BiLSTM

BiLSTM是Bi-directional Long Short-Term Memory的缩写,是由前向LSTM与后向LSTM组合而成。两者在自然语言处理任务中都常被用来建模上下文信息。

因为LSTM通过训练过程可以学到记忆哪些信息和遗忘哪些信息。

代码

转载

import torch

import numpy as np

import torch.nn as nn

import torch.optim as optim

import torch.nn.functional as F

import matplotlib.pyplot as plt

import torch.utils.data as Data

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

batch_size = 3

embedding_dim = 2

n_hidden = 5 # number of hidden units in one cell

num_classes = 2 # 0 or 1

# 3 words sentences (=sequence_length is 3)

sentences = ["i love you", "he loves me", "she likes baseball", "i hate you", "sorry for that", "this is awful"]

labels = [1, 1, 1, 0, 0, 0] # 1 is good, 0 is not good.

##

vocab = list(set(" ".join(sentences).split()))

word2idx = {w: i for i, w in enumerate(vocab)}

vocab_size = len(word2idx)

##

def make_data(sentences):

inputs = []

for sen in sentences:

inputs.append(np.asarray([word2idx[n] for n in sen.split()]))

targets = []

for out in labels:

targets.append(out) # To using Torch Softmax Loss function

return torch.LongTensor(inputs), torch.LongTensor(targets)

inputs, targets = make_data(sentences)

dataset = Data.TensorDataset(inputs, targets)

loader = Data.DataLoader(dataset, batch_size, True)

##数据集处理以上

class BiLSTM_Attention(nn.Module):

def __init__(self):

super(BiLSTM_Attention, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.lstm = nn.LSTM(embedding_dim, n_hidden, bidirectional=True)

self.out = nn.Linear(n_hidden * 2, num_classes)

def attention_net(self,lstm_output, final_state):

# lstm_output : [batch_size, n_step, n_hidden * num_directions(=2)], F matrix

# final_state : [num_layers(=1) * num_directions(=2), batch_size, n_hidden]

batch_size = len(lstm_output)

# hidden = final_state.view(batch_size,-1,1)

hidden = torch.cat((final_state[0],final_state[1]),dim=1).unsqueeze(2)

# hidden : [batch_size, n_hidden * num_directions(=2), n_layer(=1)]

attn_weights = torch.bmm(lstm_output, hidden).squeeze(2)

# attn_weights : [batch_size,n_step]

soft_attn_weights = F.softmax(attn_weights,1)

# context: [batch_size, n_hidden * num_directions(=2)]

context = torch.bmm(lstm_output.transpose(1,2),soft_attn_weights.unsqueeze(2)).squeeze(2)

return context, soft_attn_weights

def forward(self,X):

'''

:param X: [batch_size, seq_len]

:return:

'''

input = self.embedding(X) # input : [batch_size, seq_len, embedding_dim]

input = input.transpose(0, 1) # input : [seq_len, batch_size, embedding_dim]

# final_hidden_state, final_cell_state : [num_layers(=1) * num_directions(=2), batch_size, n_hidden]

# output : [seq_len, batch_size, n_hidden * num_directions(=2)]

output, (final_hidden_state, final_cell_state) = self.lstm(input)

output = output.transpose(0, 1) #output : [batch_size, seq_len, n_hidden * num_directions(=2)]

attn_output, attention = self.attention_net(output,final_hidden_state)

return self.out(attn_output),attention # attn_output : [batch_size, num_classes], attention : [batch_size, n_step]

model = BiLSTM_Attention().to(device)

criterion = nn.CrossEntropyLoss().to(device)

optimizer = optim.Adam(model.parameters(), lr=0.001)

for epoch in range(5000):

for x, y in loader:

x, y = x.to(device), y.to(device)

pred, attention = model(x)

loss = criterion(pred,y)

if (epoch + 1) % 1000 == 0:

print('Epoch:', '%04d' % (epoch + 1), 'cost =', '{:.6f}'.format(loss))

optimizer.zero_grad()

loss.backward()

optimizer.step()

test_text = 'i hate me'

tests = [np.asarray([word2idx[n] for n in test_text.split()])]

test_batch = torch.LongTensor(tests).to(device)

# Predict

predict, _ = model(test_batch)

predict = predict.data.max(1, keepdim=True)[1]

if predict[0][0] == 0:

print(test_text, "is Bad Mean...")

else:

print(test_text, "is Good Mean!!")

fig = plt.figure(figsize=(6, 6)) # [batch_size, n_step]

ax = fig.add_subplot(1, 1, 1)

ax.matshow(attention.cpu().data, cmap='viridis')

ax.set_xticklabels(['']+['first_word', 'second_word', 'third_word'], fontdict={'fontsize': 14}, rotation=90)

ax.set_yticklabels(['']+['batch_1', 'batch_2', 'batch_3', 'batch_4', 'batch_5', 'batch_6'], fontdict={'fontsize': 14})

plt.show()