视频目标分割总结

视频目标分割分类

最近听了阿里巴巴王文冠老师“基于深度学习技术的视频分割”的讲座(可能需要报名比赛才能观看),我感到受益匪浅,学习到了许多关于视频目标分割(VOS)的知识,在这里进行整理总结。关于视频目标分割的分类,有的综述文章分为无监督VOS,半监督VOS,交互式VOS,弱监督VOS等,这里将视频目标分割任务分类成无监督VOS,半监督VOS,交互式VOS,背景移除或运动物体分割,视频语义分割/实例分割。

1.无监督VOS:在测试阶段,不要求任何用户输入,通常是自动分割视频中最关键,最显著的目标。

2.半监督VOS:在测试阶段,用户提供第一帧或者关键帧的目标掩膜(mask),然后分割剩下帧中的目标。

3.交互式VOS:在测试阶段,依靠用户的迭代交互来分割感兴趣的对象,目的是获取高精度的分割结果,需要大量的人力参与。

4.背景移除或运动目标提取:通常假定摄像机静止或运动缓慢,然后自动分割出运动的前景目标。

5.视频语义分割/实例分割:是图像语义分割/实例分割的拓展,不仅要求分割出视频中感兴趣目标,还要根据语义或者实例关系区分不同目标。

值得注意的是,无监督VOS和半监督VOS的区分并不是根据监督学习和无监督学习的分类方式区分,这两者都可以利用有标签的视频数据进行训练,区分是根据测试阶段的用户参与方式来进行的,并且这两者关注的都是分割前景和背景,并不关注分割目标的类别信息。此外,单独把背景移除提出来,应该是想强调这里指的是基于深度学习的背景移除方法。这篇博客简单介绍各个方向的传统方法,着重介绍基于深度学习的视频目标分割。

解决思路总结

关于解决思路,这里主要讨论的是无监督VOS,半监督VOS和视频实例分割的基本方法。

- 无监督VOS

1.背景消除:早期视频分割方法主要是基于几何且局限于特定的运动背景。其思路是模拟每个像素的背景外观,并将快速变化的像素视为前景,图像和背景模型中的任何显著变化都代表一个移动的物体,利用连通分量算法估计与目标相对应的连通区域。基于混合高斯分布(GMM)背景/前景分割算法对视频帧上的任意坐标的像素值进行时间方向的统计,为每个坐标分配若干个高斯概率密度函数作为该位置的像素值概率分布模型,是十分经典的背景建模方法。

2.点轨迹:为了利用视频中的运动信息,这些方法首先生成点轨迹,然后使用轨迹的匹配矩阵对轨迹进行聚类,最后利用聚类轨迹作为先验信息得到视频目标分割结果。典型思路是基于光流的方法,光流是一个密集的位移向量场,反映了微小时间间隔内由于运动形成的图像变化,可以确定图像上点的运动方向和运动速率,通常用于获取视频目标的时空运动信息。

3.过分割:一些过分割方法基于颜色、亮度、光流或纹理相似性对像素进行分组,并生成时空分割图,绝大部分方法都是基于图来完成无监督视频目标分割。

4.”类似物体“分割:主要思想是通过”类似物体“区域(如显著性目标和目标候选区域)的学习模型,为视频的每一帧生成一个前景目标假设。

5.基于深度学习的方法:早期主要的视频目标分割方法首先通过互补卷积网络产生显著性目标,然后在视频中传播视频目标和基于超像素的邻域可逆流。Pyramid dilated deeper ConvLSTM for video salient object detection利用金字塔扩张(空洞)卷积结构提取多尺度空间特征,ConvLSTM模块提取不同尺度序列特征,然后concat经全卷积层输出saliency maps,在获得视频序列的显著性概率图的基础上,把分割任务视为能量函数最小化问题,根据基于fully connected CRF model(全连接条件随机场模型)的能量函数,以后处理的形式完成目标分割。

总之,背景消除和点轨迹方法简单地认为视频中待分割的目标是运动的前景,容易造成分割结果的碎片化,无法完整友好地表达物体级别信息。此外,个人感觉无监督VOS与针对视频序列的显著性目标检测非常相似,无监督VOS关注的是为视频的每一帧输出前景/背景的二值mask,显著性目标检测关心的是输出显著性概率图(saliency maps),当然这里认为两者考虑的都是不区分语义或实例的。查阅文献后发现,显著性目标估计可以为无监督VOS提供有意义的提示,视频显著性目标检测可以作为无监督VOS的预处理步骤。 - 半监督VOS

1.基于时空图的方法:早期方法通常是用手工设计的特征来解决一些时空图,包括外观、边界和光流,并在整个视频中传播前景区域。这些方法通常依赖于两个重要的提示:图结构的目标表达和时空连接关系。

2.基于卷积神经网络的方法

(1) 基于运动(传播)的方法:一般而言,该类方法利用了目标运动的时间相干性,阐明了掩模(mask)从第一帧或给定注释帧到后续帧的传播问题。MaskTrack将前一帧的掩膜分割结果和当前帧的图像结合在一起,形成四通道输入引导像素级分类网络分割感兴趣目标,为了提高模型的鲁棒性,还可以对前一帧的mask进行数据增强。然而基于一帧一帧传播的思路,当遇到待分割的感兴趣目标在视频序列中逐渐完全消失,随后又逐渐重新出现的情况时,因为目标消失帧没有办法获取mask,导致后续帧没有前一帧分割结果作为输入,会直接出现分割失败的现象,因此效果不是很优。

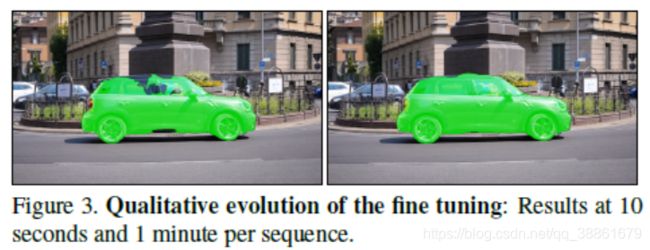

(2) 基于检测(在线学习)的方法:半监督VOS任务提供了第一帧目标的详细标注,有必要充分利用第一帧mask提供的信息。有些方法不使用时间信息,而是学习一个外观模型,在每一帧中对目标进行像素级检测和分割。在测试序列时,将第一帧图片和标注mask进行对应的数据增强,训练集上已经训练好的模型在这个扩充的第一帧上进行微调,能够更好的利用测试视频序列或者视频实例的特定信息,缺点就是十分耗时。

(3) 基于匹配的方法:首先对模板帧和视频中当前帧的特征进行像素级匹配,然后直接从匹配结果中对当前帧的每个像素进行分割。早期的想法如下图所示,给定视频的第一帧和当前帧,根据第一帧目标标注可以生成感兴趣目标的模板,而当前帧则可以生成很多候选目标,紧接着可以在候选目标和模板之间进行匹配,合适则分配id并分割,不合适则扔掉。这样的思路每次都是当前帧和第一帧目标进行匹配,不会有逐帧传播的累计误差,且会有更好的鲁棒性,受遮挡的影响会降低,即使中间一帧分割失败,也不会干扰其他帧,缺点是没有充分利用时空信息。

随着时间的推移,出现了更多优秀的工作。RANet结合了基于传播和基于匹配的思路,利用孪生网络encoder结构获取第一帧的模板特征和当前帧特征,通过Correlation操作获取相似性特征图,根据第一帧前景和背景,经过RAM模块筛选前景和背景特征,再与预测的前一帧mask合并,通过decoder结构获取最终分割mask。

基于匹配的STM方法首先通过一个encoder结构将第一帧和当前帧之前的所有帧及相应的mask生成对应的特征,并且concat在一起形成memory,对于当前帧也通过encoder结构生成特征,通过当前帧特征在memory中查询最相关,最有用的信息,整合到当前帧的特征中,再通过decoder结构获得分割结果。这种基于memory的方法可以利用之前分割的所有帧信息,共同帮助分割当前帧。

State-Aware Tracker融合视频目标跟踪和分割为一个真正统一的pipeline,其中跟踪和分割之间没有约束限制,两个任务紧密合作,相互促进。其思想是将感兴趣目标视作一个轨迹,根据上一帧跟踪分支预测出的bbox作为当前帧的搜索区域,与第一帧目标区域通过相似性encoder,结合saliency encoder分支联合分割当前帧,并设计一个评估器来判断当前帧分割的mask状态,根据mask的评估状态,一个分支反馈更新用于分割当前帧的全局特征,从而优化分割结果;另一个分支则是用来确定送入下一帧的搜索区域。跟踪结果好了,则有助于确定正确的搜索区域,促进了分割;分割结果好了,则有助于确定mask的分割状态,促进了跟踪。

- 视频实例分割

1.半监督视频实例分割:针对需要区分不同实例的半监督VOS任务,表明视频中需要分割的目标是多个,由于基于匹配的方法自带有Re-ID的能力,一种最直观的思路就是将单目标的半监督VOS重复多次,即针对每一个目标都运行一次视频目标分割。

2.无监督视频实例分割:不仅需要区分物体和背景,还要对不同的前景实例进行区分。这个研究任务的难点包括了半监督VOS的所有挑战,如匹配机制(ReID),在线学习以及视频处理的常见挑战(遮挡,运动模糊,形状变化等),还包括目标实例的确定。一种基本思想是在第一帧上分割目标级别的proposals,然后针对每一个proposal运行半监督VOS,这种思路是可行的,但是第一帧分割的目标mask质量决定了性能的上限。另一种思路如下图所示,有点类似于打比赛经常采取的模型stacking形式,一个分支(Mask R-CNN)用于生成每一帧的目标分割proposals,另一个分支(STM)根据Mask R-CNN生成的第一帧mask运行半监督VOS,然后根据两个分支产生的视频目标mask进行基于IOU的匹配,匹配上则根据规则筛选效果好的,匹配不上则认为Mask R-CNN分割了新目标,单独处理。

未来发展方向

- 当前主要挑战:

(1)半监督VOS(实例):如何快速让模型适应测试视频序列(在线学习);如何更好利用局部和全局信息;更好的准确率-速度平衡;一次性前向传播预测出多个实例分割结果;提高时间稳定性。

(2)无监督VOS(实例):所有半监督VOS挑战;有效的,端到端的解决方案。 - 潜在发展方向:

(1融合相关领域:多/单目标跟踪(MOT/SOT),视频目标检测(VOD),视频语义分割,Re-ID,度量学习等/

(2)多个任务统一解决方案:统一解决无监督VOS和半监督VOS的框架;统一解决VOS, VOD, MOT的框架等。

(3)更有效的学习范式:监督学习+自监督学习(从无标注的视频中学习)。

最后老师给出的关于参加竞赛的建议:

- 找到一个合理的解决方案,然后进行迭代式开发,避免一次性加入太多模块

- 重视数据,分析数据特点,进行可视化观察,特别是观察效果差的数据,分析原因。

- 好的Backbone

- 数据增强(人工合成等)

- 泛化性能(交叉验证等策略)

- 模型stacking,综合多个方法/策略的效果。

参考文献

[1] Chen, X., Li, Z., Yuan, Y., Yu, G., Shen, J., & Qi, D. (2020). State-Aware Tracker for Real-Time Video Object Segmentation. ArXiv, abs/2003.00482.

[2] Yao, R., Lin, G., Xia, S., Zhao, J., & Zhou, Y. (2019). Video Object Segmentation and Tracking: A Survey. ACM Transactions on Intelligent Systems and Technology (TIST).

[3] Yeong Jun Koh, Young-Yoon Lee, and Chang-Su Kim. 2018. Sequential Clique Optimization for Video Object Segmentation. In The European Conference on Computer Vision (ECCV).

[4] Ignas Budvytis, Vijay Badrinarayanan, and Roberto Cipolla. 2012. MoT-Mixture of Trees Probabilistic Graphical Model for Video Segmentation… In BMVC, Vol. 1. Citeseer, 7.

[5] ZiqinWang, Jun Xu, Li Liu, Fan Zhu, and Ling Shao. Ranet: Ranking attention network for fast video object segmentation. arXiv preprint arXiv:1908.06647, 2019.

[6] S. Caelles, K. . Maninis, J. Pont-Tuset, L. Leal-TaixÃl, D. Cremers, and L. V. Gool. 2017. One-Shot Video Object

Segmentation. In 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 5320–5329.

[7] Seoung Wug Oh, Joon-Young Lee, Ning Xu, and Seon Joo Kim. Video object segmentation using space-time memory networks. In Proceedings of the IEEE International Conference on Computer Vision, pages 9226–9235, 2019.

[8] Hongmei Song, Wenguan Wang, Sanyuan Zhao, Jianbing Shen, and Kin-Man Lam. 2018. Pyramid dilated deeper ConvLSTM for video salient object detection. In Proceedings of the European Conference on Computer Vision (ECCV). 715–731.