- uniapp相关地图 API调用

cherishSpring

uniappuni-appapache服务器

目录一、注意事项:manifest.json需增加配置二、获取用户收货地址[uni.chooseAddress]三、获取当前的地理位置、速度[uni.getLocation]四、打开地图选择位置、查看位置(导航)[uni.chooseLocation][uni.openLocation]五、使用腾讯地图逆地址解析接口实现城市自动定位回显一、注意事项:manifest.json需增加配置"mp-we

- 加入公会做直播有风险吗,谈谈我的感受

糖葫芦不甜

成为一名主播似乎成了一条充满魅力的道路。而在这个过程中,加入公会成为了不少主播的选择,它既能提供资源支持,又能加速成长,但同时,也伴随着一系列的风险与挑战。作为一名有过此经历的人,我想谈谈我的感受。免费加入,一对一指导扶持↓公会的最大优势在于其资源整合能力。从专业培训、内容策划到营销推广,公会能为主播提供全方位的支持。这不仅能够帮助主播快速提升专业技能,还能通过精准定位和有效推广,扩大其影响力和粉

- [Java实战]Spring Boot 3实战:使用QQ邮箱发送精美HTML邮件(四十三)

曼岛_

Java实战javaspringboot邮件

[Java实战]SpringBoot3实战:使用QQ邮箱发送精美HTML邮件(四十三)本文将详细介绍如何在SpringBoot3中配置QQ邮箱发送专业的HTML格式邮件,解决实际开发中的邮件发送问题。一、结果验证1.1接口调用1.2邮箱查收二、QQ邮箱配置关键点2.1QQ邮箱特殊配置要求QQ邮箱与其他邮箱服务不同,需要特别注意:必须使用授权码而非登录密码需要启用SSL加密连接端口使用465(SSL

- 2021-2-25晚间日记

潘驴邓小闲_

今天是个蜕变开始日子起床:5:40就寝:10:45天气:晴转多云心情:较愉悦纪念日:无叫我起床的不是闹钟是梦想年度目标及关键点:娶媳妇本月重要成果:加入奕龙公司人际的投入认识新同事,结交新朋友开卷有益-学习/读书喜马拉雅APP听叶武滨老师的时间管理100讲以及家慧库APP有关家庭的学习

- 关于线上技术学习的一点学习心得

GuangHui

我是**五期学员,和你分享一下我的学习心得,希望能够帮助到你.这是自己对于学习的思考和想法,因为我还在不断的学习和调整中,所以并不能说自己的所想都是正确的.我想即使我实现了成功的转行,也并不代表我说的我所选择的方式都是适合所有人的.每个人还需结合自己的实际情况,找到适合自己的最佳方法.我们一起努力.一.目标篇因为大数据需要学习的内容很多,所以学习过程中,一定要对进行定位,要做到有所取舍.针对自己的

- 2020-12-01 《每天学点儿逻辑学》404

我来自金星

空间认知的方法空间认知当然可以以一种非常简单的方式来进行。比如说就有一些低等的物种,它就可以在爬行的时候留下很多化学印记,跟着这个味道就能回到自己的老巢去了。但是这仅仅只能够用于寻找巢穴,而不能够用于复杂的认知构建。所以,在复杂的认知构建里面我们还要想想别的办法,有什么别的办法呢?我这里要指出的是,这些虽然是很多动物用来进行空间定位的方法或者导航的方法,但是在我们人类的日常生活中也是经常使用的。第

- 云端成本治理利器:亚马逊云科技智能仪表盘(AWS Cost Intelligence Dashboard)深度解析

AWS官方合作商

aws云计算

引言:在云计算的广阔天地中,资源弹性带来了业务敏捷性的飞跃,但也带来了成本管理的复杂性。多账户、多服务、按需付费的模式下,成本如何透明化?异常支出如何及时发现?优化机会如何精准定位?这些都是企业云端成本治理(CloudCostGovernance)面临的严峻挑战。亚马逊云科技提供的AWSCostIntelligenceDashboard,正是应对这些挑战的一把利器。本文将深度解析这一基于Amazo

- 昨日荒芜贺念成夏明月最新章节在线阅读_贺念成夏明月全本免费在线阅读

热门小说全文看

书名:昨日荒芜主角:贺念成夏明月简介:结婚六周年纪念日,老公说要为我准备个惊喜。我在山顶苦等三个多小时,直到大雨滂沱都没能等到他的出现。老公的小青梅却发了一条定位在半山酒店的动态。“小别胜新婚。”照片里,两人躺在撒满玫瑰花瓣的床上十指相扣。男人的无名指上空空如也。赤裸的胸膛上,却有几道红红的抓痕和浅浅的牙印。我一阵恶心,在底下评论道:“被狗咬了,记得打破伤风。”可以关注微信公众号【魔书朗阅】去回个

- opencv、torch、torchvision、tensorflow的区别

一、框架定位与核心差异PyTorch动态计算图:实时构建计算图支持Python原生控制流(如循环/条件),调试便捷。学术主导:2025年工业部署份额24%,适合快速原型开发(如无人机自动驾驶、情绪识别)。TensorFlow静态计算图优化:预编译图结构提升部署效率支持动态图(Eager模式)兼顾灵活性。工业部署首选:市场份额38%,擅长边缘计算(YOLO部署)和大规模项目(工业自动化)-59)。O

- DAY4精时力学习日志-【体力】冥想让你更健康更年轻

波斯菊

【精时力学习日志】本训练营:2021年100天精时力营·除法今日主题:1-4【体力】冥想让你更健康更年轻学习日期:2021年12月9日1、[我记]我学(客观)+我思(主观)+正反栗子+行动:1.1睡眠限制疗法&睡眠时间计划法1.1.1[我记]睡眠限制疗法的关键点在于不困就不上床睡觉,睡眠时间计划法的关键点在于推迟就寝时间以提升睡眠质量。1.1.2[我思]检视:这个知识点和我之前的认知是一致的吗?回

- 2023-03-22

小郭不会打篮球

3.21笔记一、定位作用:显示定在所有其他元素之上、可以让元素在浏览器中任意位置。a标准流块级元素独占一行→垂直布局行内元素/行内块元素一行显示多个→水平布局b浮动可以让原本垂直布局的块级元素变成水平布局c定位可以让元素自由的摆放在网页的任意位置一般用于盒子之间的层叠情况1、属性名:position静态定位:static相对定位:relative绝对定位:absolute固定定位:fixed向下移

- 《视野》杂志2020年11期内容目录

吃瓜的小花猫

《视野》杂志简介《视野》杂志创刊于1997年,是由兰州大学主办的综合性文摘类综合文化期刊,64页全彩印刷,以“新锐、人文、生活”为办刊理念,赢得了读者及社会大众的肯定与信赖,成为兰州大学的文化“名片”之一,也同时成长为甘肃省继《读者》之后的第二大品牌期刊。一流的编辑实力加目标读者群的精准定位,形成了视野卓越的市场影响力,《视野》已成为大中学校园里极具有专公信力和号召力的读物!《视野》2020年11

- 淘宝返利软件哪个佣金高?高省和省推哪个平台佣金高?

优惠券高省

高省app是杭州长孚科技有限公司旗下的一款电商导购应用,为用户打造一个电商购物优惠平台,用户可以在这个App中领取主流商城的商品隐藏优惠券以及获得返利。【高省】分会员和运营商,会员定位是自用的,而运营商是针对推广者的。另外还有一个城市合伙人,这个是在高级运营商的基础上,多了同城本地CPS的一些收益,而且无论粉丝是不是自己下面,城市合伙人都可以获得相应收益。其中运营商分为三个级别:1、团长2、运营商

- CSS定位属性全解析

代码的余温

css前端

CSS的position属性用于定义元素在文档中的定位方式,其属性值及作用如下:1.static(默认值)作用:元素遵循正常文档流,忽略top、right、bottom、left和z-index属性。特点:✓元素按源码顺序自然排列。✓无法通过方向属性调整位置。.element{position:static;}2.relative(相对定位)作用:元素相对于自身原位置进行偏移,原空间保留。特点:✓

- 2022-6-29晨间日记

645e2ce505ed

今天是什么日子:今天是6月29日起床:5点50分就寝:22点天气:雨心情:好纪念日:叫我起床的不是闹钟是梦想年度目标及关键点:在头条突破千粉。本月重要成果:今日三只青蛙/番茄钟成功日志-记录三五件有收获的事务一、每天写一篇日记。二、听书学习,了解中国文化历史背景。三、运动锻炼。财务检视人际的投入曾子曰:“吾日三省吾身,为人谋而不忠乎?与朋友交而不信乎?传不习乎?”能够以曾子的为人处事方式为座右铭,

- 麦吉丽贵妇膏能淡斑吗?

广州时尚王子

麦吉丽贵妇膏功效:收缩毛孔改善暗黄淡斑淡印它是一款可以代替BB霜,粉饼的保养品、护肤品,不堵塞毛孔,更不用担心浮粉“掉粉”,因为它成分天然,超好吸收护肤+美颜,一步搞定,秒变女神肌从根源改善肤色并护理肌肤麦吉丽代理的加入方式主要通过官方渠道进行申请qin201262。首先,想要成为麦吉丽的代理,需要了解麦吉丽的产品线、市场定位以及代理政策。这些信息通常可以通过麦吉丽的官方网站、社交媒体平台或线下宣

- 如何形成自己的直播风格

星尘梦羽

每个主播都有自己的风格,不同的风格会有不同的受众群,所以主播一定要在直播之初就给自己一个定位,合理的人设会让你捕捉到更多粉丝的心。但是,主播的风格要如何确立呢,观众更喜欢看那类主播?什么样的主播更能吸引眼球?确立一个主播的风格要注意哪些问题呢?一、以自身性格为基础一个主播的风格一定是建立在自己的性格特点基础上的,风格的确定与性格有密不可分的关联,绝不能与自己的性格背道而驰,如果你自己装出一种风格一

- 【大模型】结构化提示词:让AI高效完成复杂任务的“编程语言”

JosieBook

AI/大数据/云计算人工智能

文章目录前言:提示词一、不同提示词写作方法对比进阶技巧对比表实战组合策略二、三板斧:精准撰写提示词的黄金法则角色设定:为AI精准定位任务描述:明确行动指南输出要求:规范成果呈现三、魔法棒:零基础也能用的“AI需求翻译机”四、结构化:把提示词写成“可插拔的乐高”五、分治法:把“庞然大物”拆成可并行的小任务前言:提示词在人工智能时代,提示词(Prompt)已成为连接人类意图与AI能力的核心媒介。优质的

- 阿里巴巴下一个亿级流量风口,你准备好了吗?

子铭_47e1

前几天无意间了解到一款APP—淘小铺,开始没怎么在意,但是最近朋友圈以及各大资讯平台突然之间开始刷屏,这才留意起来。淘小铺是阿里巴巴全资的子公司,和天猫、淘宝不一样,它是依靠注册推广会员来完成销量本质上更偏向社交电商。淘小铺的定位是“人人可参与的社区化电商”,让普通人创业变得简单,同时,使顾客分享和购物变得简单。用高质量的供给赋能普通个人“一键创业”。接下来很多人会问“个人如何赚钱呢?”我给大家介

- 感恩日记第十七天

芊芸说心身

感恩日记第十七天2019.02.25感恩感恩烨含老师今晚讲解的金钱关系让我对金钱有了更深刻的理解,也重新定位自己和设定目标感恩国英老师今天导师疯狂训开学典礼的震撼,让我激动不已,那种感觉又回来了感恩今天所做的熏蒸让疲劳疾病离我远去感恩老公对我们婚宴的辛苦付出,让我感动不已感恩一一老师的辛苦付出让更多家庭受益愿望愿我通过导师疯狂训彻底告别惰性与借口愿30万财富源源不断进我口袋愿我成为一个能够真正引领

- 【AI大模型:架构实战】35、企业级AI中台全链路架构设计与实战指南:从数据管理到智能服务

无心水

人工智能AI大模型系统实战AI大模型高手AI大模型企业落地CSDN技术干货AI中台AI入门

在企业智能化转型过程中,AI能力的规模化复用与高效管理成为核心挑战。AI中台作为连接技术与业务的桥梁,通过标准化能力输出、集中化资源管控和全链路治理,解决了"重复建设、资源浪费、安全失控"等痛点。本文基于2025年最新实践,详解企业AI中台的架构设计、关键技术实现、落地路径及避坑指南,助力企业构建支撑千级AI应用的"智能中枢"。一、AI中台核心定位与整体架构企业级AI中台并非简单的技术堆砌,而是以

- 零基础学习性能测试第一章:核心性能指标-吞吐量QPS/TPS

试着

性能测试学习性能测试零基础性能指标QPSTPS

目录零基础学习性能测试:第一章-核心性能指标:吞吐量(QPS/TPS)一、吞吐量核心概念解析1.吞吐量定义与分类2.核心区别与关系二、吞吐量关键价值与工作应用1.吞吐量的业务意义2.实际工作场景应用三、吞吐量测试实战指南1.测试工具选择2.JMeter吞吐量测试全流程3.关键配置参数四、吞吐量瓶颈分析与优化1.瓶颈定位四步法2.常见瓶颈及解决方案3.优化案例:电商系统吞吐量提升五、工作应用模板与工

- 基于深度学习的目标检测:从基础到实践

Blossom.118

机器学习与人工智能深度学习目标检测人工智能音视频语音识别计算机视觉机器学习

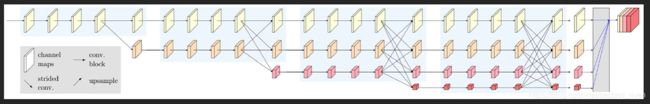

前言目标检测(ObjectDetection)是计算机视觉领域中的一个核心任务,其目标是在图像中定位和识别多个对象的类别和位置。近年来,深度学习技术,尤其是卷积神经网络(CNN),在目标检测任务中取得了显著进展。本文将详细介绍如何使用深度学习技术构建目标检测模型,从理论基础到代码实现,带你一步步掌握目标检测的完整流程。一、目标检测的基本概念(一)目标检测的定义目标检测是指在图像中识别和定位多个对象

- 零基础学习性能测试第一章:核心性能指标-并发量

试着

性能测试学习性能测试零基础性能指标并发量

目录零基础学习性能测试:第一章-核心性能指标:并发量一、并发量核心概念解析1.并发量定义与分类2.并发量关键特性二、并发量测试的核心价值1.业务意义三角模型2.实际工作场景应用三、并发量测试实战指南1.测试工具配置要点2.并发测试四步流程3.JMeter并发测试实操四、并发瓶颈分析与优化1.并发瓶颈定位矩阵2.常见并发问题解决方案3.电商系统并发优化案例五、工作应用模板与工具1.并发测试报告模板2

- 智慧光伏发电信息化系统需求文档

小赖同学啊

testTechnologyPrecious物联网

以下是从产品经理角度撰写的智慧光伏发电信息化系统需求文档,聚焦光伏行业痛点与业务价值,遵循标准PRD结构:智慧光伏发电信息化系统需求文档版本:1.0日期:2025年7月19日作者:产品经理视角一、文档概述1.1产品背景光伏电站运营面临四大挑战:发电损失定位难:组串故障、阴影遮挡等问题人工排查效率低运维成本占比高:占LCOE(平准化度电成本)超15%电网调度协同弱:缺乏精准发电预测,罚款风险高资产收

- 知乎职场类问题关注度最高的...

晓维漫话

文/晓维最近,在琢磨一个问题:职场发展中,哪类问题的关注度最高?说白了,就是什么样的职场问题提问的人最多。于是,搜了下知乎,提问和关注度最高的原来是职业定位问题。职业定位,即使在职业生涯规划中相对其他类问题比较难处理。因为定位关乎一个人的多维度综合因素。但因为关注度比较高,还是没掩盖住想写的欲望,也希望能帮助到更多有职业定位困惑的朋友。也许,单纯提到职业定位还比较官方,但我们一定亲身或者见证过身边

- 2021-9-24每日检视Day307

洒脱转身

每日检视307/365起床:6:20就寝:11:20天气:晴心情:平静纪念日:叫我起床的不是闹钟是梦想2021年度目标年度(2020.11.20-2021.11.20)目标及关键点:在平衡健康、家庭、工作、生活、兴趣、个人发展的基础上,提升情商和财商,重点发展记忆竞技能力,让每一天都成为一部杰作。健康:①身材曲线——香肩美背,腹部肌肉紧实,臀部微翘②神态:眼睛有神,笑容亲和③健身房每周不少于4次。

- 【Oracle】Oracle 11g打补丁时遇到opatch apply命令无法识别

瑞琪姐

大数据模块oracle数据库

⚙️1.使用完整路径执行命令问题原因:若未将$ORACLE_HOME/OPatch加入系统PATH环境变量,直接输入opatchapply会因系统无法定位命令而报错。解决方案:改用绝对路径执行:$ORACLE_HOME/OPatch/opatchapply例如:/u01/app/oracle/product/11.2.0/db_1/OPatch/opatchapply注:此方法在Windows/L

- 拼多多的商业思考

拼图区块链

拼多多除了假货还有什么?这是普遍大家回问的一个问题。但是拼多多的的真的只有假货那么简单吗?把它定位成一个假货平台显然是不公平的。拼多多抓住的第一个关键词是“高频”。在拼多多排名前10的类目中,排到第一的是食品。而淘宝排名第一的是服装。很显然,食品是一个比服务高频多的东西,主要就包含:瓜子零食和水果。拼多多关注的第二个关键词是“拼团”。我们必须承认拼多多上面确实存在很多的假货。但是中国广大的3、4、

- Modbus协议开发应用挑战赛(四)

黑客思维者

网络Modbus协议网络安全系统安全

问题1:ModbusTCP报文头中的“单元标识符”(UnitID)用于在网关后区分多个从站,当网关连接的从站超过255个(UnitID范围0-255)时,该字段的扩展方案及行业实践有哪些?参考解析:扩展方案:多网关分片:部署多个网关,每个网关管理≤255个从站,主站通过网关的IP地址区分不同网关,再结合各网关内的UnitID定位从站。例如:网关A(IP192.168.1.10)管理UnitID1-

- TOMCAT在POST方法提交参数丢失问题

357029540

javatomcatjsp

摘自http://my.oschina.net/luckyi/blog/213209

昨天在解决一个BUG时发现一个奇怪的问题,一个AJAX提交数据在之前都是木有问题的,突然提交出错影响其他处理流程。

检查时发现页面处理数据较多,起初以为是提交顺序不正确修改后发现不是由此问题引起。于是删除掉一部分数据进行提交,较少数据能够提交成功。

恢复较多数据后跟踪提交FORM DATA ,发现数

- 在MyEclipse中增加JSP模板 删除-2008-08-18

ljy325

jspxmlMyEclipse

在D:\Program Files\MyEclipse 6.0\myeclipse\eclipse\plugins\com.genuitec.eclipse.wizards_6.0.1.zmyeclipse601200710\templates\jsp 目录下找到Jsp.vtl,复制一份,重命名为jsp2.vtl,然后把里面的内容修改为自己想要的格式,保存。

然后在 D:\Progr

- JavaScript常用验证脚本总结

eksliang

JavaScriptjavaScript表单验证

转载请出自出处:http://eksliang.iteye.com/blog/2098985

下面这些验证脚本,是我在这几年开发中的总结,今天把他放出来,也算是一种分享吧,现在在我的项目中也在用!包括日期验证、比较,非空验证、身份证验证、数值验证、Email验证、电话验证等等...!

&nb

- 微软BI(4)

18289753290

微软BI SSIS

1)

Q:查看ssis里面某个控件输出的结果:

A MessageBox.Show(Dts.Variables["v_lastTimestamp"].Value.ToString());

这是我们在包里面定义的变量

2):在关联目的端表的时候如果是一对多的关系,一定要选择唯一的那个键作为关联字段。

3)

Q:ssis里面如果将多个数据源的数据插入目的端一

- 定时对大数据量的表进行分表对数据备份

酷的飞上天空

大数据量

工作中遇到数据库中一个表的数据量比较大,属于日志表。正常情况下是不会有查询操作的,但如果不进行分表数据太多,执行一条简单sql语句要等好几分钟。。

分表工具:linux的shell + mysql自身提供的管理命令

原理:使用一个和原表数据结构一样的表,替换原表。

linux shell内容如下:

=======================开始

- 本质的描述与因材施教

永夜-极光

感想随笔

不管碰到什么事,我都下意识的想去探索本质,找寻一个最形象的描述方式。

我坚信,世界上对一件事物的描述和解释,肯定有一种最形象,最贴近本质,最容易让人理解

&

- 很迷茫。。。

随便小屋

随笔

小弟我今年研一,也是从事的咱们现在最流行的专业(计算机)。本科三流学校,为了能有个更好的跳板,进入了考研大军,非常有幸能进入研究生的行业(具体学校就不说了,怕把学校的名誉给损了)。

先说一下自身的条件,本科专业软件工程。主要学习就是软件开发,几乎和计算机没有什么区别。因为学校本身三流,也就是让老师带着学生学点东西,然后让学生毕业就行了。对专业性的东西了解的非常浅。就那学的语言来说

- 23种设计模式的意图和适用范围

aijuans

设计模式

Factory Method 意图 定义一个用于创建对象的接口,让子类决定实例化哪一个类。Factory Method 使一个类的实例化延迟到其子类。 适用性 当一个类不知道它所必须创建的对象的类的时候。 当一个类希望由它的子类来指定它所创建的对象的时候。 当类将创建对象的职责委托给多个帮助子类中的某一个,并且你希望将哪一个帮助子类是代理者这一信息局部化的时候。

Abstr

- Java中的synchronized和volatile

aoyouzi

javavolatilesynchronized

说到Java的线程同步问题肯定要说到两个关键字synchronized和volatile。说到这两个关键字,又要说道JVM的内存模型。JVM里内存分为main memory和working memory。 Main memory是所有线程共享的,working memory则是线程的工作内存,它保存有部分main memory变量的拷贝,对这些变量的更新直接发生在working memo

- js数组的操作和this关键字

百合不是茶

js数组操作this关键字

js数组的操作;

一:数组的创建:

1、数组的创建

var array = new Array(); //创建一个数组

var array = new Array([size]); //创建一个数组并指定长度,注意不是上限,是长度

var arrayObj = new Array([element0[, element1[, ...[, elementN]]]

- 别人的阿里面试感悟

bijian1013

面试分享工作感悟阿里面试

原文如下:http://greemranqq.iteye.com/blog/2007170

一直做企业系统,虽然也自己一直学习技术,但是感觉还是有所欠缺,准备花几个月的时间,把互联网的东西,以及一些基础更加的深入透析,结果这次比较意外,有点突然,下面分享一下感受吧!

&nb

- 淘宝的测试框架Itest

Bill_chen

springmaven框架单元测试JUnit

Itest测试框架是TaoBao测试部门开发的一套单元测试框架,以Junit4为核心,

集合DbUnit、Unitils等主流测试框架,应该算是比较好用的了。

近期项目中用了下,有关itest的具体使用如下:

1.在Maven中引入itest框架:

<dependency>

<groupId>com.taobao.test</groupId&g

- 【Java多线程二】多路条件解决生产者消费者问题

bit1129

java多线程

package com.tom;

import java.util.LinkedList;

import java.util.Queue;

import java.util.concurrent.ThreadLocalRandom;

import java.util.concurrent.locks.Condition;

import java.util.concurrent.loc

- 汉字转拼音pinyin4j

白糖_

pinyin4j

以前在项目中遇到汉字转拼音的情况,于是在网上找到了pinyin4j这个工具包,非常有用,别的不说了,直接下代码:

import java.util.HashSet;

import java.util.Set;

import net.sourceforge.pinyin4j.PinyinHelper;

import net.sourceforge.pinyin

- org.hibernate.TransactionException: JDBC begin failed解决方案

bozch

ssh数据库异常DBCP

org.hibernate.TransactionException: JDBC begin failed: at org.hibernate.transaction.JDBCTransaction.begin(JDBCTransaction.java:68) at org.hibernate.impl.SessionImp

- java-并查集(Disjoint-set)-将多个集合合并成没有交集的集合

bylijinnan

java

import java.util.ArrayList;

import java.util.Arrays;

import java.util.HashMap;

import java.util.HashSet;

import java.util.Iterator;

import java.util.List;

import java.util.Map;

import java.ut

- Java PrintWriter打印乱码

chenbowen00

java

一个小程序读写文件,发现PrintWriter输出后文件存在乱码,解决办法主要统一输入输出流编码格式。

读文件:

BufferedReader

从字符输入流中读取文本,缓冲各个字符,从而提供字符、数组和行的高效读取。

可以指定缓冲区的大小,或者可使用默认的大小。大多数情况下,默认值就足够大了。

通常,Reader 所作的每个读取请求都会导致对基础字符或字节流进行相应的读取请求。因

- [天气与气候]极端气候环境

comsci

环境

如果空间环境出现异变...外星文明并未出现,而只是用某种气象武器对地球的气候系统进行攻击,并挑唆地球国家间的战争,经过一段时间的准备...最大限度的削弱地球文明的整体力量,然后再进行入侵......

那么地球上的国家应该做什么样的防备工作呢?

&n

- oracle order by与union一起使用的用法

daizj

UNIONoracleorder by

当使用union操作时,排序语句必须放在最后面才正确,如下:

只能在union的最后一个子查询中使用order by,而这个order by是针对整个unioning后的结果集的。So:

如果unoin的几个子查询列名不同,如

Sql代码

select supplier_id, supplier_name

from suppliers

UNI

- zeus持久层读写分离单元测试

deng520159

单元测试

本文是zeus读写分离单元测试,距离分库分表,只有一步了.上代码:

1.ZeusMasterSlaveTest.java

package com.dengliang.zeus.webdemo.test;

import java.util.ArrayList;

import java.util.List;

import org.junit.Assert;

import org.j

- Yii 截取字符串(UTF-8) 使用组件

dcj3sjt126com

yii

1.将Helper.php放进protected\components文件夹下。

2.调用方法:

Helper::truncate_utf8_string($content,20,false); //不显示省略号 Helper::truncate_utf8_string($content,20); //显示省略号

&n

- 安装memcache及php扩展

dcj3sjt126com

PHP

安装memcache tar zxvf memcache-2.2.5.tgz cd memcache-2.2.5/ /usr/local/php/bin/phpize (?) ./configure --with-php-confi

- JsonObject 处理日期

feifeilinlin521

javajsonJsonOjbectJsonArrayJSONException

写这边文章的初衷就是遇到了json在转换日期格式出现了异常 net.sf.json.JSONException: java.lang.reflect.InvocationTargetException 原因是当你用Map接收数据库返回了java.sql.Date 日期的数据进行json转换出的问题话不多说 直接上代码

&n

- Ehcache(06)——监听器

234390216

监听器listenerehcache

监听器

Ehcache中监听器有两种,监听CacheManager的CacheManagerEventListener和监听Cache的CacheEventListener。在Ehcache中,Listener是通过对应的监听器工厂来生产和发生作用的。下面我们将来介绍一下这两种类型的监听器。

- activiti 自带设计器中chrome 34版本不能打开bug的解决

jackyrong

Activiti

在acitivti modeler中,如果是chrome 34,则不能打开该设计器,其他浏览器可以,

经证实为bug,参考

http://forums.activiti.org/content/activiti-modeler-doesnt-work-chrome-v34

修改为,找到

oryx.debug.js

在最头部增加

if (!Document.

- 微信收货地址共享接口-终极解决

laotu5i0

微信开发

最近要接入微信的收货地址共享接口,总是不成功,折腾了好几天,实在没办法网上搜到的帖子也是骂声一片。我把我碰到并解决问题的过程分享出来,希望能给微信的接口文档起到一个辅助作用,让后面进来的开发者能快速的接入,而不需要像我们一样苦逼的浪费好几天,甚至一周的青春。各种羞辱、谩骂的话就不说了,本人还算文明。

如果你能搜到本贴,说明你已经碰到了各种 ed

- 关于人才

netkiller.github.com

工作面试招聘netkiller人才

关于人才

每个月我都会接到许多猎头的电话,有些猎头比较专业,但绝大多数在我看来与猎头二字还是有很大差距的。 与猎头接触多了,自然也了解了他们的工作,包括操作手法,总体上国内的猎头行业还处在初级阶段。

总结就是“盲目推荐,以量取胜”。

目前现状

许多从事人力资源工作的人,根本不懂得怎么找人才。处在人才找不到企业,企业找不到人才的尴尬处境。

企业招聘,通常是需要用人的部门提出招聘条件,由人

- 搭建 CentOS 6 服务器 - 目录

rensanning

centos

(1) 安装CentOS

ISO(desktop/minimal)、Cloud(AWS/阿里云)、Virtualization(VMWare、VirtualBox)

详细内容

(2) Linux常用命令

cd、ls、rm、chmod......

详细内容

(3) 初始环境设置

用户管理、网络设置、安全设置......

详细内容

(4) 常驻服务Daemon

- 【求助】mongoDB无法更新主键

toknowme

mongodb

Query query = new Query(); query.addCriteria(new Criteria("_id").is(o.getId())); &n

- jquery 页面滚动到底部自动加载插件集合

xp9802

jquery

很多社交网站都使用无限滚动的翻页技术来提高用户体验,当你页面滑到列表底部时候无需点击就自动加载更多的内容。下面为你推荐 10 个 jQuery 的无限滚动的插件:

1. jQuery ScrollPagination

jQuery ScrollPagination plugin 是一个 jQuery 实现的支持无限滚动加载数据的插件。

2. jQuery Screw

S