- python的schedule模块

weijiuzhu007

python

这里写自定义目录标题一,schedule模块1.什么是schedule模块2.具体应用二,详细源码一,schedule模块1.什么是schedule模块schedule模块进行job管理,具体可以执行定时任务,schedule方法是串行的,也就是说,如果各个任务之间时间不冲突,那是没问题的;如果时间有冲突的话,会串行的执行命令2.具体应用1,安装方法pipinstallschedule2,使用im

- 华为OD机试C卷--手机App防沉迷系统(Java & JS & Python & C)

飞码创造者

华为OD机试题库华为odc语言javajavascriptpython

获取题库不需要订阅专栏,可直接私信我进入CSDN领军人物top1博主的华为OD交流圈观看完整题库、最新面试实况、考试报告等内容以及大佬一对一答疑。题目描述智能手机方便了我们生活的同时,也侵占了我们不少的时间。“手机App防沉迷系统”能够让我们每天合理地规划手机App使用时间,在正确的时间做正确的事。它的大概原理是这样的:1.在一天24小时内,可以注册每个App的允许使用时段2.一个时间段只能使用一

- 【Django DRF Apps】从零搭建一个Django SSE app应用

患得患失949

DjangoDRF封装功能类djangosqlitepythonSSEapp

一、从零开始搭建DjangoSSE应用(一)创建Django项目安装Django首先确保已经安装Django。如果没有安装,可以使用以下命令进行安装:pipinstalldjango创建Django项目创建一个新的Django项目:django-adminstartprojectsse_projectcdsse_project创建Django应用创建一个新的应用来处理SSE:pythonmanag

- StarRocks on AWS Graviton3,实现 50% 以上性价比提升

大数据数据库数据湖云计算云服务

在数据时代,企业拥有前所未有的大量数据资产,但如何从海量数据中发掘价值成为挑战。数据分析凭借强大的分析能力,可从不同维度挖掘数据中蕴含的见解和规律,为企业战略决策提供依据。数据分析在营销、风险管控、产品优化等领域发挥着关键作用,帮助企业提高运营效率、优化业务流程、发现新商机、增强竞争力。低成本高效率的完成对海量数据的分析,及时准确的释放数据价值,已成为企业赢得竞争优势的利器。StarRockson

- 使用scorecardpy库计算woe分箱和iv值

亲持红叶

机器学习风控相关算法人工智能机器学习

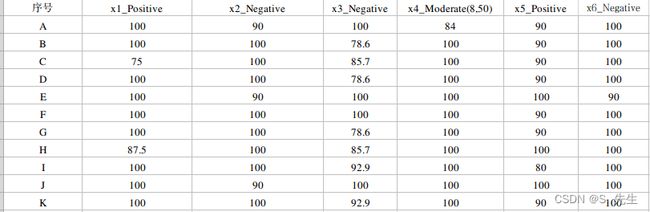

woe分箱_iv值计算基于scorecardpy库,乳腺癌数据集importpandasaspdimportnumpyasnpfromsklearn.datasetsimportload_breast_cancerimportscorecardpyasscfromtqdmimportnotebookcancer=load_breast_cancer()df=pd.DataFrame(cancer.

- 华为OD机试 - 手机App防沉迷系统(Python/JS/C/C++ 2024 D卷 100分)

哪 吒

华为odpythonjavascript算法七日集训

华为OD机试2024E卷题库疯狂收录中,刷题点这里专栏导读本专栏收录于《华为OD机试真题(Python/JS/C/C++)》。刷的越多,抽中的概率越大,私信哪吒,备注华为OD,加入华为OD刷题交流群,每一题都有详细的答题思路、详细的代码注释、3个测试用例、为什么这道题采用XX算法、XX算法的适用场景,发现新题目,随时更新。一、题目描述智能手机方便了我们生活的同时,也侵占了我们不少的时间。“手机Ap

- 对于编程零基础,第一个语言是 Python 的人有什么建议?

cda2024

python开发语言

在当今数字化时代,编程已成为一项必备技能。无论你是想成为一名专业的软件开发人员,还是希望在数据分析、人工智能等领域有所建树,掌握一门编程语言都是至关重要的第一步。对于许多初学者来说,Python是一个理想的选择。它不仅语法简洁易懂,而且拥有强大的社区支持和丰富的库资源。那么,对于编程零基础且选择Python作为第一门语言的人,有哪些实用的建议呢?1.建立正确的学习心态1.1持之以恒学习编程并不是一

- 通达信Python语言接口:如何轻松获取并高效利用?

cda2024

python开发语言

在量化投资和股票分析领域,Python已经成为不可或缺的工具。然而,如何将Python与国内最流行的股票交易软件之一——通达信相结合,成为许多投资者和开发者关心的问题。本文将详细介绍如何获取通达信的Python语言接口,并提供一些实用的技巧和示例代码,帮助你在量化交易中更上一层楼。什么是通达信Python接口?通达信Python接口是通达信官方提供的一个API,允许用户通过Python脚本调用通达

- 华为OD机试E卷 - 手机App防沉迷系统(Java & Python& JS & C++ & C )

算法大师

最新华为OD机试华为odjavapythonc语言c++javascript华为OD机试E卷

最新华为OD机试真题目录:点击查看目录华为OD面试真题精选:点击立即查看题目描述智能手机方便了我们生活的同时,也侵占了我们不少的时间。“手机App防沉迷系统”能够让我们每天合理地规划手机App使用时间,在正确的时间做正确的事。它的大概原理是这样的:在一天24小时内,可以注册每个App的允许使用时段一个时间段只能使用一个AppApp有优先级,数值越高,优先级越高。注册使用时段时,如果高优先级的App

- PyCharm安装PyQt5及工具详细教程

JustLikeRun

pycharmqtidepyqt

PyCharm安装PyQt5及工具详细教程PyCharm是一款功能强大的Python集成开发环境(IDE),而PyQt5是一个用于创建GUI应用程序的流行Python库。在本教程中,我将指导您如何在PyCharm中安装PyQt5及其相关工具,并提供相应的源代码示例。步骤1:安装PyCharm首先,您需要下载并安装PyCharm。您可以从JetBrains官方网站(https://www.jetbr

- Python从0到100(七十三):Python OpenCV-OpenCV实现手势虚拟拖拽

是Dream呀

pythonopencv开发语言

前言:零基础学Python:Python从0到100最新最全教程。想做这件事情很久了,这次我更新了自己所写过的所有博客,汇集成了Python从0到100,共一百节课,帮助大家一个月时间里从零基础到学习Python基础语法、Python爬虫、Web开发、计算机视觉、机器学习、神经网络以及人工智能相关知识,成为学习学习和学业的先行者!欢迎大家订阅专栏:零基础学Python:Python从0到100最新

- 华为OD机试E卷 --第k个排列 --24年OD统一考试(Java & JS & Python & C & C++)

飞码创造者

最新华为OD机试题库2024华为odjavajavascriptc语言python

文章目录题目描述输入描述输出描述用例题目解析JS算法源码java算法源码python算法源码c算法源码c++算法源码题目描述给定参数n,从1到n会有n个整数:1,2,3,…,n,这n个数字共有nl种排列。按大小顺序升序列出所有排列的情况,并——标记,当n=3时,所有排列如下:“123"“132”“213”“231"“312"“321”给定n和k,返回第k个排列。输入描述输入两行,第一行为n,第二行

- 期末python试卷(1)

泰山小张只吃荷园

python网络开发语言开源汇编程序人生学习方法

目录一、判断题二、选择题三、填空题一、判断题1.Python是一种解释型、面向对象的编程语言。2.Python中的变量名只能由字母、下划线、数字组成,且不能以数字开头。3.Python中多分支可使用IF-ELIF和SWITCH-CASE语句来实现。4.表达式中包含多个运算符时,计算顺序取决于运算符的结合顺序和优先级。5.x=’Tom’,那么执行语句x+=’Tom’之后,x的id不变。6.Pytho

- Python调用另一个py文件并传递参数的全面解析

cda2024

pythonjava服务器

在Python编程的世界里,模块化和代码复用是提高开发效率的重要手段。当你面对复杂的项目时,将功能拆分成多个文件不仅有助于团队协作,还能提升代码的可读性和可维护性。然而,如何在一个py文件中调用另一个py文件,并且能够传递参数呢?这正是本文要探讨的核心问题。通过本文,你将了解到几种常见的方法及其应用场景,帮助你在实际开发中更加游刃有余。1.使用import语句1.1基本用法最直观的方法就是使用im

- 使用Python开发SolidWorks API

SolidWorksAPI

SolidWorks二次开发SolidworksAPIpython

使用Python开发SolidWorksAPI介绍本文介绍了如何使用Python与SolidWorksAPI进行交互,创建零件草图、特征及插入文本。我们将通过一个简单的示例,展示如何在SolidWorks中进行自动化操作,利用Python脚本创建一个带有矩形特征的零件,并向草图中插入文本。前提条件安装了SolidWorks和Python。配置了pywin32库来与SolidWorks进行交互。可以

- 库存python whl文件免费下载(2)

科技小游侠

pythonpython

库存pythonwhl文件免费下载(1)库存pythonwhl文件免费下载(2)库存pythonwhl文件免费下载(3)库存pythonwhl文件免费下载(4)库存pythonwhl文件免费下载(5)最近发现收藏的whl下载链接https://www.lfd.uci.edu/~gohlke/pythonlibs/已经走丢了,网上检索了下,还可以下载到历史的whl文件,为了防止下载链接再次失效,索性

- Python处理Excel数据

王肇朋

excelExcelEXCELofficepythonPython

Python处理Excel数据2012-08-0210:07:32我来说两句收藏我要投稿前段时间做了个小项目,帮个海洋系的教授做了个数据处理的软件。基本的功能很简单,就是对Excel里面的一些数据进行过滤,统计,对多个表的内容进行合并等。之前没有处理Excel数据的经验,甚至于自己都很少用到Excel。记得《Python核心编程》的最后一章里有讲到用Win32COM操作office,看了一下讲的不

- python正则表达式re关于数字、字母、特殊字符、汉字的匹配方式

乙龙

python开发语言

在Python中,正则表达式是通过re模块来实现的。正则表达式是一种强大的文本处理工具,用于匹配、搜索、替换或分割字符串。以下是一些基本的正则表达式模式,用于筛选不同类型的字符:数字(\d):匹配任意数字(0-9)。示例:\d可以匹配“123”中的每个‘1’,‘2’,‘3’。字母([a-zA-Z]):匹配任意大小写的英文字母。示例:[a-zA-Z]可以匹配“HelloWorld”中的每个‘H’,‘

- python中的两种循环

怎么昵称都被占用啊

python练习python

python中的两种循环for循环(计数循环)while循环(条件循环)两种循环的区别range函数跳出循环break示例continue示例循环嵌套循环练习循环,三大语言结构之一,当它满足条件时反复执行某一段代码的过程,在python中有两种循环命令,分别为for循环和while循环for循环(计数循环)python中常用的循环结构之一,可以遍历一个可迭代对象中的元素。因为for循环的循环次数是

- YOLOv10-1.1部分代码阅读笔记-model.py

红色的山茶花

YOLO笔记深度学习

model.pyultralytics\engine\model.py目录model.py1.所需的库和模块2.classModel(nn.Module):1.所需的库和模块#UltralyticsYOLO,AGPL-3.0licenseimportinspectimportsysfrompathlibimportPathfromtypingimportUnionimportnumpyasnpim

- ValueError: setting an array element with a sequence. The requested array has an inhomogeneous shape

Xiao张不会深度学习

python开发语言

1.错误报错ValueError:settinganarrayelementwithasequence.Therequestedarrayhasaninhomogeneousshapeafter1dimensions.Thedetectedshapewas(6,)+inhomogeneouspart.2.问题原因numpy版本原因导致的报错。3.解决办法卸载现有版本numpy,安装numpy1.2

- 《python基于时间序列分析的降雨量预测系统》毕业设计项目

陈辰学长

python课程设计开发语言

大家好,我是陈辰学长,一名在Java圈辛勤劳作的码农。今日要和大家分享的是一款《python基于时间序列分析的降雨量预测系统》毕业设计项目。项目源码以及部署相关事宜,请联系陈辰学长,文末会附上联系信息哦。作者:陈辰学长个人简介:在Java领域已沉浸十余年,对Java、微信小程序、Python、Android等技术颇为精通。若大家在这些领域有任何问题,欢迎一起交流探讨!各类成品Java毕业设计丰富多

- dlib库的whl文件下载

杭林菲

dlib库的whl文件下载【下载地址】dlib库的whl文件下载dlib库的whl文件下载项目地址:https://gitcode.com/open-source-toolkit/f2aaf资源文件介绍本仓库提供了一个dlib库的whl文件下载,文件名为:dlib-19.7.0-cp36-cp36m-win_amd64.rar。该文件适用于Windows64位系统,Python版本为3.6。文件描

- chatgpt赋能python:用Python安装Jupyter:让数据科学变得更加高效!

aijinglingchat

ChatGptpythonchatgptjupyter计算机

用Python安装Jupyter:让数据科学变得更加高效!对于数据科学家而言,jupyter是不可或缺的工具之一。它是一个基于web的交互式计算环境,可以帮助我们在Python中以一种轻松、方便、可交互的方式进行编程和数据分析。今天,我们将向您介绍在Python中如何安装jupyter。安装Python要安装jupyter,首先需要安装Python。如果您已经安装了Python,请跳到下一步。您可

- Kylin入门教程

-龙川-

介绍学习笔记kylin

引言ApacheKylin是一个开源的分布式分析引擎,提供Hadoop上的多维分析(OLAP)能力,使得超大规模数据集的实时查询和分析成为可能。它通过预计算数据立方体来加速查询,使得复杂查询可以在亚秒级响应。本文将详细介绍Kylin的基本概念、安装与配置、基本操作及高级功能,帮助你全面掌握这款强大的数据分析工具。第一部分:Kylin简介1.1什么是Kylin?Kylin是由eBay开发并捐赠给Ap

- [dlib][python]dlib所有whl文件下载地址汇总

Xiao张不会深度学习

python开发语言深度学习

dlib库的wheel文件3.7-3.12GitHub-z-mahmud22/Dlib_Windows_Python3.x:Dlibcompiledbinary(.whl)forPython3.7-3.12andWindowsx64这里存储了适用于python3.7-3.12的wheel文件下载wheel文件之后,比如:dlib-19.22.99-cp310-cp310-win_amd64.whl

- Python剪辑视频小妙招(moivepy库)

对不起,我辜负了你

python

起因最近一直在b站上投稿喜羊羊与灰太狼的视频,但是苦于需要手动裁剪视频的片头和片尾,裁剪的多了就发现喜羊羊与灰太狼的视频片头几乎都是1分25秒结束,也就是持续85秒,片尾也差不多是持续1分02秒差不多也就是62秒,于是开始思考有没有什么方法可以替代人类进行自动化批量裁剪?思路发展迭代与确定一开始是想使用Premier里面的预设来做的,结果发现Premier里面高版本的导出变成了各种网站的标准,相比

- Python 实战-优化排班表节省成本

奔向理想的星辰大海

技术研发pythoniosobjective-c

1.基础概念:理解排班表排班表,顾名思义,就是安排员工工作时间的表格。在餐馆中,它通常需要考虑员工的可用性、工作时间限制、用餐高峰时段等因素。2.使用列表存储员工信息首先,我们需要一个数据结构来存储员工信息。Python中的列表是一个不错的选择。#员工信息列表,包括姓名、可用时间段employees=[{"name":"张三","available":[(9,17),(20,23)]},{"nam

- No module named ‘moviepy.editor‘

weixin_66009678

python

python3.7版本后不支持frommoviepy.editor引用方式,由于是moviepy2.0.0版本修改方法:frommoviepy.editorimportVideoFileClip,clips_array改为frommoviepyimport*

- 安装python3.12.2环境(实验机器银河麒麟高级服务器)

Red丶哞

桌面运维Pythonlinux运维服务器

1.下载官网Python安装包wgethttps://www.python.org/ftp/python/3.12.2/Python-3.12.2.tar.xz1.1解压tar-xfPython-3.12.2.tar.xz解压完后切换到Python-3.12.2文件夹(这里根据自己解压的文件夹路径)cd/usr/packages/Python-3.12.2/1.2升级软件包管理器CentOS系统:

- java杨辉三角

3213213333332132

java基础

package com.algorithm;

/**

* @Description 杨辉三角

* @author FuJianyong

* 2015-1-22上午10:10:59

*/

public class YangHui {

public static void main(String[] args) {

//初始化二维数组长度

int[][] y

- 《大话重构》之大布局的辛酸历史

白糖_

重构

《大话重构》中提到“大布局你伤不起”,如果企图重构一个陈旧的大型系统是有非常大的风险,重构不是想象中那么简单。我目前所在公司正好对产品做了一次“大布局重构”,下面我就分享这个“大布局”项目经验给大家。

背景

公司专注于企业级管理产品软件,企业有大中小之分,在2000年初公司用JSP/Servlet开发了一套针对中

- 电驴链接在线视频播放源码

dubinwei

源码电驴播放器视频ed2k

本项目是个搜索电驴(ed2k)链接的应用,借助于磁力视频播放器(官网:

http://loveandroid.duapp.com/ 开放平台),可以实现在线播放视频,也可以用迅雷或者其他下载工具下载。

项目源码:

http://git.oschina.net/svo/Emule,动态更新。也可从附件中下载。

项目源码依赖于两个库项目,库项目一链接:

http://git.oschina.

- Javascript中函数的toString()方法

周凡杨

JavaScriptjstoStringfunctionobject

简述

The toString() method returns a string representing the source code of the function.

简译之,Javascript的toString()方法返回一个代表函数源代码的字符串。

句法

function.

- struts处理自定义异常

g21121

struts

很多时候我们会用到自定义异常来表示特定的错误情况,自定义异常比较简单,只要分清是运行时异常还是非运行时异常即可,运行时异常不需要捕获,继承自RuntimeException,是由容器自己抛出,例如空指针异常。

非运行时异常继承自Exception,在抛出后需要捕获,例如文件未找到异常。

此处我们用的是非运行时异常,首先定义一个异常LoginException:

/**

* 类描述:登录相

- Linux中find常见用法示例

510888780

linux

Linux中find常见用法示例

·find path -option [ -print ] [ -exec -ok command ] {} \;

find命令的参数;

- SpringMVC的各种参数绑定方式

Harry642

springMVC绑定表单

1. 基本数据类型(以int为例,其他类似):

Controller代码:

@RequestMapping("saysth.do")

public void test(int count) {

}

表单代码:

<form action="saysth.do" method="post&q

- Java 获取Oracle ROWID

aijuans

javaoracle

A ROWID is an identification tag unique for each row of an Oracle Database table. The ROWID can be thought of as a virtual column, containing the ID for each row.

The oracle.sql.ROWID class i

- java获取方法的参数名

antlove

javajdkparametermethodreflect

reflect.ClassInformationUtil.java

package reflect;

import javassist.ClassPool;

import javassist.CtClass;

import javassist.CtMethod;

import javassist.Modifier;

import javassist.bytecode.CodeAtt

- JAVA正则表达式匹配 查找 替换 提取操作

百合不是茶

java正则表达式替换提取查找

正则表达式的查找;主要是用到String类中的split();

String str;

str.split();方法中传入按照什么规则截取,返回一个String数组

常见的截取规则:

str.split("\\.")按照.来截取

str.

- Java中equals()与hashCode()方法详解

bijian1013

javasetequals()hashCode()

一.equals()方法详解

equals()方法在object类中定义如下:

public boolean equals(Object obj) {

return (this == obj);

}

很明显是对两个对象的地址值进行的比较(即比较引用是否相同)。但是我们知道,String 、Math、I

- 精通Oracle10编程SQL(4)使用SQL语句

bijian1013

oracle数据库plsql

--工资级别表

create table SALGRADE

(

GRADE NUMBER(10),

LOSAL NUMBER(10,2),

HISAL NUMBER(10,2)

)

insert into SALGRADE values(1,0,100);

insert into SALGRADE values(2,100,200);

inser

- 【Nginx二】Nginx作为静态文件HTTP服务器

bit1129

HTTP服务器

Nginx作为静态文件HTTP服务器

在本地系统中创建/data/www目录,存放html文件(包括index.html)

创建/data/images目录,存放imags图片

在主配置文件中添加http指令

http {

server {

listen 80;

server_name

- kafka获得最新partition offset

blackproof

kafkapartitionoffset最新

kafka获得partition下标,需要用到kafka的simpleconsumer

import java.util.ArrayList;

import java.util.Collections;

import java.util.Date;

import java.util.HashMap;

import java.util.List;

import java.

- centos 7安装docker两种方式

ronin47

第一种是采用yum 方式

yum install -y docker

- java-60-在O(1)时间删除链表结点

bylijinnan

java

public class DeleteNode_O1_Time {

/**

* Q 60 在O(1)时间删除链表结点

* 给定链表的头指针和一个结点指针(!!),在O(1)时间删除该结点

*

* Assume the list is:

* head->...->nodeToDelete->mNode->nNode->..

- nginx利用proxy_cache来缓存文件

cfyme

cache

user zhangy users;

worker_processes 10;

error_log /var/vlogs/nginx_error.log crit;

pid /var/vlogs/nginx.pid;

#Specifies the value for ma

- [JWFD开源工作流]JWFD嵌入式语法分析器负号的使用问题

comsci

嵌入式

假如我们需要用JWFD的语法分析模块定义一个带负号的方程式,直接在方程式之前添加负号是不正确的,而必须这样做:

string str01 = "a=3.14;b=2.71;c=0;c-((a*a)+(b*b))"

定义一个0整数c,然后用这个整数c去

- 如何集成支付宝官方文档

dai_lm

android

官方文档下载地址

https://b.alipay.com/order/productDetail.htm?productId=2012120700377310&tabId=4#ps-tabinfo-hash

集成的必要条件

1. 需要有自己的Server接收支付宝的消息

2. 需要先制作app,然后提交支付宝审核,通过后才能集成

调试的时候估计会真的扣款,请注意

- 应该在什么时候使用Hadoop

datamachine

hadoop

原帖地址:http://blog.chinaunix.net/uid-301743-id-3925358.html

存档,某些观点与我不谋而合,过度技术化不可取,且hadoop并非万能。

--------------------------------------------万能的分割线--------------------------------

有人问我,“你在大数据和Hado

- 在GridView中对于有外键的字段使用关联模型进行搜索和排序

dcj3sjt126com

yii

在GridView中使用关联模型进行搜索和排序

首先我们有两个模型它们直接有关联:

class Author extends CActiveRecord {

...

}

class Post extends CActiveRecord {

...

function relations() {

return array(

'

- 使用NSString 的格式化大全

dcj3sjt126com

Objective-C

格式定义The format specifiers supported by the NSString formatting methods and CFString formatting functions follow the IEEE printf specification; the specifiers are summarized in Table 1. Note that you c

- 使用activeX插件对象object滚动有重影

蕃薯耀

activeX插件滚动有重影

使用activeX插件对象object滚动有重影 <object style="width:0;" id="abc" classid="CLSID:D3E3970F-2927-9680-BBB4-5D0889909DF6" codebase="activex/OAX339.CAB#

- SpringMVC4零配置

hanqunfeng

springmvc4

基于Servlet3.0规范和SpringMVC4注解式配置方式,实现零xml配置,弄了个小demo,供交流讨论。

项目说明如下:

1.db.sql是项目中用到的表,数据库使用的是oracle11g

2.该项目使用mvn进行管理,私服为自搭建nexus,项目只用到一个第三方 jar,就是oracle的驱动;

3.默认项目为零配置启动,如果需要更改启动方式,请

- 《开源框架那点事儿16》:缓存相关代码的演变

j2eetop

开源框架

问题引入

上次我参与某个大型项目的优化工作,由于系统要求有比较高的TPS,因此就免不了要使用缓冲。

该项目中用的缓冲比较多,有MemCache,有Redis,有的还需要提供二级缓冲,也就是说应用服务器这层也可以设置一些缓冲。

当然去看相关实现代代码的时候,大致是下面的样子。

[java]

view plain

copy

print

?

public vo

- AngularJS浅析

kvhur

JavaScript

概念

AngularJS is a structural framework for dynamic web apps.

了解更多详情请见原文链接:http://www.gbtags.com/gb/share/5726.htm

Directive

扩展html,给html添加声明语句,以便实现自己的需求。对于页面中html元素以ng为前缀的属性名称,ng是angular的命名空间

- 架构师之jdk的bug排查(一)---------------split的点号陷阱

nannan408

split

1.前言.

jdk1.6的lang包的split方法是有bug的,它不能有效识别A.b.c这种类型,导致截取长度始终是0.而对于其他字符,则无此问题.不知道官方有没有修复这个bug.

2.代码

String[] paths = "object.object2.prop11".split("'");

System.ou

- 如何对10亿数据量级的mongoDB作高效的全表扫描

quentinXXZ

mongodb

本文链接:

http://quentinXXZ.iteye.com/blog/2149440

一、正常情况下,不应该有这种需求

首先,大家应该有个概念,标题中的这个问题,在大多情况下是一个伪命题,不应该被提出来。要知道,对于一般较大数据量的数据库,全表查询,这种操作一般情况下是不应该出现的,在做正常查询的时候,如果是范围查询,你至少应该要加上limit。

说一下,

- C语言算法之水仙花数

qiufeihu

c算法

/**

* 水仙花数

*/

#include <stdio.h>

#define N 10

int main()

{

int x,y,z;

for(x=1;x<=N;x++)

for(y=0;y<=N;y++)

for(z=0;z<=N;z++)

if(x*100+y*10+z == x*x*x

- JSP指令

wyzuomumu

jsp

jsp指令的一般语法格式: <%@ 指令名 属性 =”值 ” %>

常用的三种指令: page,include,taglib

page指令语法形式: <%@ page 属性 1=”值 1” 属性 2=”值 2”%>

include指令语法形式: <%@include file=”relative url”%> (jsp可以通过 include

![]()

![]()

![]()

![]()

![]()