评估行人行动预测的基准——Benchmark for Evaluating Pedestrian Action Prediction

评估行人行动预测的基准——Benchmark for Evaluating Pedestrian Action Prediction

Date of Conference: 3-8 Jan. 2021

Date Added to IEEE *Xplore*: 14 June 2021

DOI: 10.1109/WACV48630.2021.00130

Authors:Iuliia Kotseruba,York University;Amir Rasouli,York University;John K. Tsotsos,York University

论文链接

文章目录

-

- 摘要

- 1.介绍

- 2.相关工作

-

- 2.1.行为预测

- 2.2.穿行预测评估

- 3.标准

- 4.基线模型和先进模型

- 5.评估

-

- 5.1.训练

- 5.2.讨论结果

- 6.提出的模型 (PCPA)

-

- 6.1结果

- 7.总结

- 参考

摘要

行人动作预测已经成为了热门的研究课题,同时也产生了许多新的算法解决方案。然而,由于缺乏公开可用的标准和通用的训练评估程序,评测当今先进的解决方案十分困难。为此,我们引入一个基于两个公开数据集的行人行为理解基准。使用上述评价程序,我们对一些基线模型(一些简单的基础模型)和最先进的模型进行排名,并分析他们在各个方面的性能。基于上面的评测,我们提出一个新的模型用与行人穿行预测,此模型使用注意力机制有效地结合隐形和显现特征。在后面我们还会

展示新模型的预测效果。模型代码链接:https://github.com/ykotseruba/PedestrianActionBenchmark.

1.介绍

在辅助和自动驾驶系统领域,预测行人动作或者穿行的能力对系统进行未来可靠的路径规划来说是十分重要的。在过去十年中,行人动作预测课题在机器视觉和机器人动力学领域收到很大的关注。在此领域的努力研究下,许多方法都在报告中展现了他们在行人穿行预测的成果。

为了行人动作预测更长远的发展,十分有必要对现存的优秀算法进行评估,这就需要一个通用的评价指南。到目前为止,由于缺乏一致的评价标准,即使使用相同的数据集评估模型的性能,这种比较也很困难,甚至是不可能的[47]。例如,有的研究进行连续预测是在穿行开始之后,而有的是在穿行开始前,这些研究还有可能使用不一样的数据拆分和抽样程序。为此,我们提出一个新的标准用于行人动作预测,这个标准基于两个公开可用的行人行为理解数据库:自主驾驶的联合注意Joint Attention for Autonomous Driving(JAAD)[44] 行人意图评估 Pedestrian Intention Estimation(PIE)[42].我们根据行人行为研究制定评估协议,对线性(基线)模型和最先进的模型进行评估。另外在相同的条件下测试这些算法并对其预测结果进行排序,我们还检查不同数据属性对两个数据集的影响。

最后,基于测试结果和数据分析我们提出一个新模型用于行人穿行预测,此模型性能在此评测标准下优于现在的算法。作为我们支持未来行人动作预测研究工作的一部分,我们将公开所有算法的基准代码。

2.相关工作

2.1.行为预测

行为预测在许多领域中都是一个感兴趣的话题,如辅助机器人[35,4,6,64]、监控[27,25,17,33]、运动预测[29,39,10]和自动驾驶系统[46,42,32,62]。行为预测的结果可以是隐含的未来轨迹或姿势 [4, 61, 25, 42, 39],也可以是明确的预测未来动作或事件 [35, 46, 27, 17, 10]。

动作预测。动作预测有着广泛的应用,包括人-物体[23,16,1,63]和人-人[17,11,48]交互,事故预测[60,54,55]和道路交通理解[8,18,46,28]。这些方法在本质上与动作识别算法中使用的算法是相似的。一些常用的学习架构包括 2D/3D 卷积网络 [8、18、23]、循环网络 [55、16、63] 或两者的组合 [1](有关详细信息,请参见 [41])。

行人穿行预测是动作预测的子问题,此预测目的是预测给定行人是否会在未来某个时间过马路。穿行预测算法依赖各种数据模式和架构。例如,(1)在一项早期工作中,使用CNN对交通场景及观察到的行人行走动作进行卷积,用卷积后的静态表示作为输入来预测特定帧的过马路动作。(2)最近的方法利用了序列分析技术。在[49,36]中,作者使用DenseNet的架构来进行行人图像序列的预测(与[36]中的姿势特征一起)。(3)在[46]中使用多模态方法且输入不同的数据,如场景、轨迹,根据复杂程度的不同,分成不同层次的堆叠GRU网络。作为预测系统的一部分,图模型还经常用于表示身体关节间的连接 [5] (物理上的身体连接)或者关节间的交互[28](物理上可能不连接但有对应关系,如跑步时的手脚协调,而手脚不是直接连接的)的建模。(4)另一组算法依靠生成模型来预测未来的场景表征,而这些表征又被送入一个分类器,以预测是否有行人正在发生穿行事件[18, 9]。

小总结:(1)baseline model(基线模型),基线模型就是一个作为标准线的模型,比如说你要对某个模型进行改进,添加几个模块或者修改结构之类的,那这个模型就叫做baseline model。(2)DenseNet又称稠密网络,是从CNN发展出来的,此处内容较多建议单独抽出来学习,DenseNet应该是当时性能优异的卷积网络模型(现在不知道)。(3)关键点在于多样化的输入,通过从视频中区分出背景,轨迹,动作等信息,并融合使用于预测。(4)表述其实很简单,就是不过结果如何,先使用算法预测,这个表征可能是直观的图像,也可能是抽象的代码,但分类器会识别。这里面其实还涉及到框架是怎样预测,分类器也需要训练。

2.2.穿行预测评估

因为评价标准不一,比较不同的行人穿行算法十分困难。即使使用相同的数据库这些差异仍然存在。在Table 1 列出了最近在JAAD和PIE训练的的模型,有关“观察终点和范围”和“预测范围”的总结。

Table 1: Pedestrian action prediction models trained and evaluated on JAAD and PIE datasets. Observation endpoint即观察终点,表明是否对整个行人轨迹进行了采样,或者只对穿行动作之前的帧进行了采样(此类算法会利用完全观察视频提取一些全局特征,有的是直接用于预测这没有实际意义后面会提到,有的则是由于训练,这样的预测是就可以只用穿行发生前的观察内容进行预测)。Observation length (s)即观察长度单位为秒。Prediction horizon即预测范围单位为秒。

观察帧(观察终点)的选择方式存在显着差异。有一半的方法只适用穿行发生之前的帧进行训练和评估。例如在[57]中就是使用行人开始穿行之前的最后一帧用于预测行为。[34] 观察从穿行前 2 秒到穿行开始后 0.5 秒。其余模型对整个视频行采样。这有利于训练,因为有更多可用数据。然而在实际中,在穿行开始发生的这个时间点是最关键的,因为车辆需要决定避让还是继续行驶。使用整个轨迹也会影响评估,因为如果动作已经在进行中,预测就不再适用。在之前的实验中和本位5.2节会证明,当观察越久,行动预测会逐渐变得容易(就TTE而言)。因为观察越久,可以观察到更多的视觉线索。当行人已经在过马路时,大多数模型都能达到很高的预测准确率,提高了它们的总分,这不能表现出实际最需要的性能,也就是在穿行发生前进行预测的性能。为了缓解这种情况,一些作者对样本细分为更细致的类别,例如在[34]和[37]中的停止、连续穿行叉、开始和站立,并评估每个子集上的模型。

观察长度也有许多不同,从一帧[57]到300帧(10s)[5],大部分都是在0.5s左右( 30 fps 时 15 - 16 帧)。在预测长度方面,三分之一的模型预测观察后的一帧内容,其余的都预测了0.5s~3s未来的穿行动作,这对于实际场景来说更可取,因为它可以让驾驶员或自动驾驶汽车有时间响应意外事件。

为了解决上述的不同点,我们作出一下贡献:(1)为行人过马路预测任务建立以行为学文献为基础的共同评价标准。(2)对基线和先进模型进行实验(3)分析它们在各种数据属性方面的表现(4)一种预测更准确的新模型

3.标准

穿行动作预测任务。我们将行人动作预测制定为二分类问题,此目标是预测行人是否会在某个时间t开始过马路根据长度为m的观察视频。我们将对视频进行两种定义:1)在某个时间行人开始过马路;2)直到观察到最后一帧行人都不会过马路。

数据库。对于这个基准,我们使用两个大型公共自然数据集来研究交通中的行人行为:自动驾驶联合关注 (JAAD) [44] 和行人意图估计 (PIE) [42]因为它们可以免费供学术界和工业界不受限制地使用。JAAD有346段行人过马路前的动作视频组成,这些视频在几个不同国家和不同天气拍摄。PIE 包含在加拿大多伦多天气晴朗时录制的 6 小时连续镜头。

与JAAD关注行人穿行意图不同,PIE提供在马路旁所有人的注释,标识出谁可能会或可能不会试图在此车辆前面过马路。作为结论,两个数据库都存在不平衡:JADD 行为数据库(JAAD beh)都是正在穿越(495)或即将穿越(191)的人,为了完善JAAD数据库 ( J A A D a l l JAAD_{all} JAADall) 加入了2100条其他的行人视频,他们是一些远离路口或者不过马路的行人。与JAAD类似,PIE包含太多的不过马路的行人(1322不过 VS 512过)但是它们在外观、他们表现出的行为类型以及相对于路边的位置方面更加多样化。

数据抽样。在 [45] 中数据拆分,将323段视频(不包含较低分辨率及恶劣天气和夜间录制的视频)分为177,117和29段(我觉得这里测试和验证数量弄反了),分别用于训练、测试和分别验证。我们也采用一样的拆分方式,将 J A A D b e h JAAD_{beh} JAADbeh分为214,48和276段,将 J A A D a l l JAAD_{all} JAADall分为1355,202和1023段。在PIE数据库我们参考[42]中的拆分:将set01, set02 和 set06用于训练,set04 和 set05用于验证,set03用于测试。PIE中的行人轨迹数量为880,243和719分别用于训练,检验和测试

如图一所示,对每个行人的观察数据进行采样 ,使最后一帧观察在穿行发生12秒前(3060帧)(如数据集注释中提供的)。这种time-to-event (TTE)是由交通研究推动的47]。当TTE小于2秒时行人不太可能穿过[43],但应为紧急机动分配一些时间。由于大多数城市情景和人类动态的不可预测性,更长的预测范围是不切实际的。所有模型的观察长度固定为 16 帧。 PIE 的样本重叠设置为 0.6,JAAD 的样本重叠设置为 0.8。

Figure 1: Crossing prediction task: given a set of observation frames predict action some time in the future to give the driver or autonomous vehicle sufficient time to react to pedestrian behavior

特征。观察在JAAD和PIE数据集中注释的几个明确特征:界限盒坐标bounding box coordinates,此车辆速度ego-vehicle speed(PIE中的sensor data,JAAD中的qualitative labels),以及行人pedestrians和场景scene的各种属性。

另外,我们的姿势信息由Openpose[6]生成(18个身体关节坐标串联成一个36D的 特征向量),整个场景的光流计算使用FlowNet2 [21]。

生成了几类视觉特征:scene-整个场景;local box-画面裁剪成边界框的大小;local context-图像区域为边界框的1.5大小;local surround-行人边界框内的区域被灰化的地方。

指标。我们使用标准二元分类指标报告结果:准确度accuracy、ROC 曲线、AUC、recall、 F1。其中

F1 = 2∗(precision∗recall)/precision+recall

4.基线模型和先进模型

除了在2.2节中介绍的几个模型外,我们还加入了识别领域中一些基线模型。在 [18, 9]中行人穿行方法,此方法不是针对单个行人,因此不包括在标准测试中。

Static一种基线模型,使用VGG16 [53] and ResNet50 [19]后端 和 全连接(fc)层进行预测,并只使用观察序列的最后一帧。

Are They Going to Cross (ATGC) [44]。此结构由三个CNN流构成,这三个CNN流对每一帧的场景特征、行人步态和头部姿势进行编码整合成一个共享表示,将其作为SVM的输入。最终预测被计算为所有观察帧的平均值。

ConvLSTM[51]一个将一堆图像作为输入的模型,使用预训练的 CNN 对其进行预处理,并将提取的特征输入卷积 LSTM。 最后的隐性状态被输入到fc层进行预测。

SingleRNN (RNN)[26].输入特征被连接成单个向量并输入循环网络(GRU [13] 或 LSTM [20]),然后是用于动作预测的 fc 层。

Stacked RNN[59].一堆 RNN 层,其中每个 RNN 都从下面的层接收 RNN 的隐藏状态

Multi-stream RNN (MultiRNN) [3]是由独立处理每种特征类型的独立RNN流组成。最后,将 RNN 的隐藏状态连接起来并输入到 fc 层进行预测

Hierarchical RNN[14].一种架构,其中单独的 RNN 分支独立处理每种特征类型。相应的隐藏状态被连接起来并馈送到另一个 RNN 层,然后是 fc 层进行分类。

Stacked with multilevel Fusion RNN(SFRNN) [46].Stacked RNN改良版,在此模型,特征被分层处理,并在没一层逐渐融合,更复杂的特征在底层馈送,更简单的特征在顶部融合生成。

Convolutional 3D (C3D) [56],以堆叠RBG帧作为输入,通过输入特征进入fc层进行预测。

Inflated 3D (I3D) [7]以RGB图像作为输入,最后通过fc进行预测。

TwoStream[52]使用两个CNN流平行处理RBG图像和光流(optical flow),并融合两种特征生成预测。对序列中的每一帧进行预测并取平均值

5.评估

5.1.训练

为了对在PIE和JAAD的预训练进行建模,我们使用对应论文中指定的超参数。对于其余模型,我们通过改变模型架构(例如骨干、隐藏单元的数量)、特征类型(光流与 rgb)、学习率和 epoch 数来执行超参数探索,并选择最佳模型来报告结果 。为了抵消数据库造成的影响,我们使类权重与每个类样本所占百分比成反比。

5.2.讨论结果

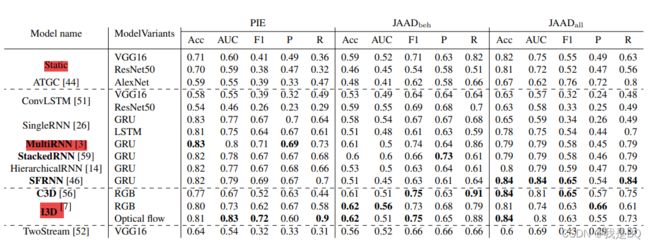

Table 2: Evaluation results for baseline and state-of-the-art models and their variants on PIE and JAAD datasets. J A A D b e h JAAD_{beh} JAADbeh 是数据图的子库(只包含有过马路意图的行人片段), J A A D a l l JAAD_{all} JAADall 包含所有类型的行人片段.。虚线分隔不同类型的架构: static, recurrent, 3D convolutional 和 two-stream.

Table 2总结了所以模型及其变种的评估结果。我们将这些模型分为四个组:static, recurrent, 3D convolution 和 two-stream。在下面的分析中,我们选择每个分类性能最优的模型。Static (使用h ResNet-50 )、MultiRNN 和 I3D(使用光流特征训练)。由于双流系统的性能较差我们不作分析。

不同架构的性能。尽管动作预测时一个有关时空的问题,但这个问题仍有可能只使用一张图片进行预测。如事实所示,最简单的Static模型表现由于许多在 JAAD 中时间模型和少量在PIE的时间模型。这结果部分归因于 JAAD 数据库的行人都有明确的过马路意图,然而PIE的行人更多样和包含没有过马路意图的行人。因此,PIE 中的样本在外观、轨迹、姿势和环境方面更加多样化,使用 Static 模型更难以捕捉。鉴于 JAAD 也比 PIE 小,在PIE中它可能有足够的数据来学习时间模式。

在recurrent模型中,ConvLSTM 是迄今为止在小组中最差的模型,甚至比staic模型还差。其他的 recurrent 模型将视觉信息与娶她显性特征结合起来,如姿势、轨迹和本车速度。这些模型的性能都十分相近在所有数据库中。这表明特定的架构(GRU 与 LSTM)的选择或特征的组合方式(例如并行、堆叠或分层)没有显着影响。

3D convolutional 网路与 ConvLSTM 相似,都依赖于视觉信息。C3D 和d I3D 处理视觉信息更高效,并与使用额外数据的循环模型获得相当的结果。在I3D的案例中,我们考虑使用光流图来替代RGB图来获得更好的结果。

即使遵循最佳的实践,TwoStream 模型仍是所有穿行动作预测性能最差的[58]。可能是因为它需要更多更多样的训练数据。

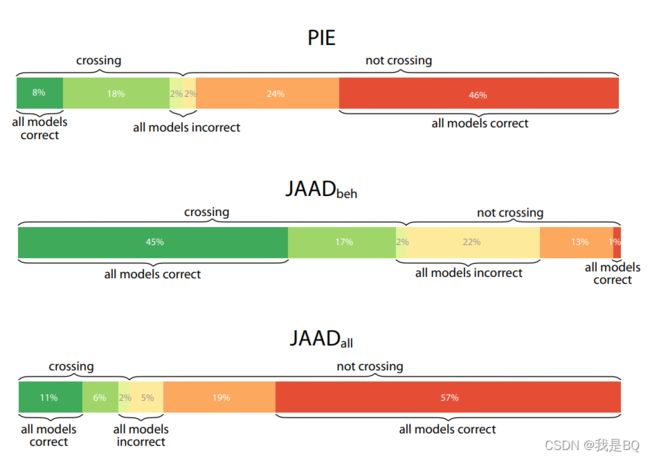

Figure 2:PIE和JAAD中穿行和不穿行的比例,以及被 所有all/一些/没有none 模型预测正确的比例。

模型协议。Figure 2 显示了那些穿越和未穿越行人样本被所有模型正确分类,部分模型或没有模型正确分类(分别称为简单、中等和困难样本)。我们看了样本的各种数据属性的分布情况,然而并没有发现数据属性与模型协议有强相关性。例如,各种 TTE、遮挡和边界框大小在简单、中等和困难集中的分布非常相似。

同样的,模型协议跟场景的语义属性也没有强相关性。例如,我们可以合理地假设,分析无信号灯路口的行人行为或乱穿马路的行人的行为可能比分析有信号灯的路口更困难,因为那里的交通信号和标志界定了使用者的行为。事实上,在 JAAD 中,乱穿马路的行人(远离十字路口)更难分类,而在 PIE 中,十字路口是否存在信号或斑马线与样本的难度无关。

其他的因素,如行人相对于路边的距离、他们面对的方向以及他们是否观察到交通,也类似地分布在简单、中等和困难的集合中。

小总结:图二中的简单、中等和困难的集合的分类与TTE、遮挡和边界框及场景语义(斑马线,红绿灯)没有直接关系。

J A A D b e h JAAD_{beh} JAADbeh 和 J A A D a l l JAAD_{all} JAADall 的性能差距。如第 3 节所述, J A A D a l l JAAD_{all} JAADalll 通过添加在人行道上检测到的额外行人来扩展带有行为注释的样本集 ( J A A D b e h JAAD_{beh} JAADbeh),从而不穿行样本的数量增加了 15 倍以上。在拥有更多的训练数据的情况下,各个模型性能都有了显著的提升,提升幅度在10%~20%。但也为 J A A D a l l JAAD_{all} JAADalll 带来了不利的影响。比如,在两个数据集共有的不穿行样本集中, J A A D b e h JAAD_{beh} JAADbeh的错误分类率从为3%,而 J A A D a l l JAAD_{all} JAADall 中的错误分类率为 3.8%。

由此错误分类的危险同样存在于穿行数据集中,令人担忧的是,困难穿行样本的比例从 J A A D b e h JAAD_{beh} JAADbeh 的 3% 显着增加到 J A A D a l l JAAD_{all} JAADall 的 10%。同时,所有模型正确分类的简单穿行样本数量从 J A A D b e h JAAD_{beh} JAADbeh 的 69% 下降到 J A A D a l l JAAD_{all} JAADall 的 40%。通过分析 J A A D b e h JAAD_{beh} JAADbeh 和 AADall 中的困难样本集的交集,可以得出类似的结论。重叠部分约占两组并集的 30%,包括穿行和不穿行样本,所有模型在较大的 J A A D a l l JAAD_{all} JAADall 数据集上训练仍然很困难。与在 J A A D b e h JAAD_{beh} JAADbeh 上训练的模型相比,在 J A A D a l l JAAD_{all} JAADall 上训练的模型在分类不穿行人方面明显更好(简易集包括 J A A D a l l JAAD_{all} JAADall 中 70% 的不穿行人,而在 J A A D b e h JAAD_{beh} JAADbeh 中只有 1%)。然而这大部分的提升是由于正确预测添加进去的不穿行样本,这些行人的属性相当一致(远离道路并在交通旁移动),这有助于区分它们。与此同时,在道路附近仍有很大一部分行人无意过马路,这些行人被错误分类,占困难样本重叠部分的40%。

Figure 3:在 J A A D b e h JAAD_{beh} JAADbeh和 J A A D a l l JAAD_{all} JAADall交集中的困难集合(包括穿行与不穿行),同时也是在所有模型预测错误的样本。

Figure 3展示了难以预测的穿行样本和不穿行示例。这些穿行样本之所以在所有模型都难以预测是因为它们通常是对比度低、遮挡和拥挤的。而不穿行样本主要由于行人在车辆旁边或者前面。

这些研究结果表明,添加不相关的行人会增加训练数据的总量并提高结果,但不会提高模型在最重要样本上的性能。总的来说, J A A D a l l JAAD_{all} JAADall上大部分的性能提升是由于大量对不穿行行人的正确分类,但代价是靠近道路的行人分类率降低。尽管我们不知道PIE是否也是这种情况,但在未来的数据收集和注释时可以考虑下这一点。

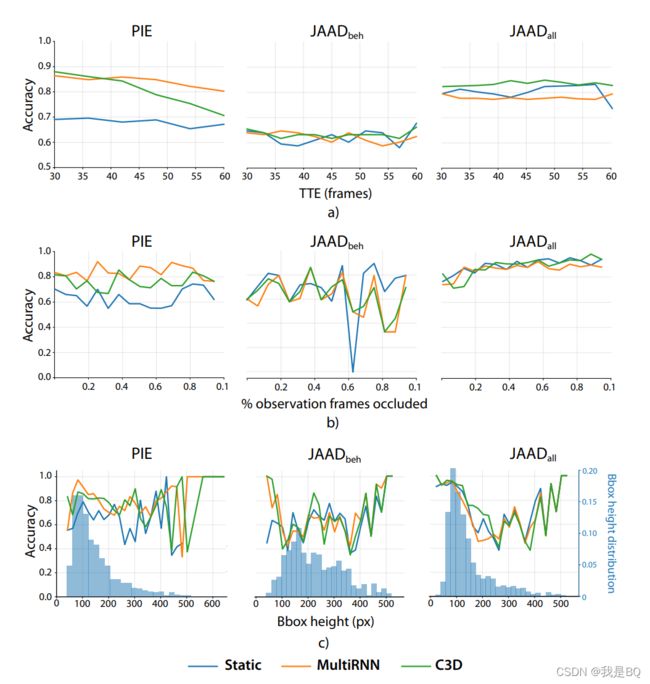

Figure 4:影响因素 a) TTE, b) 遮挡 和 c) PIE、 J A A D b e h JAAD_{beh} JAADbeh 和 J A A D a l l JAAD_{all} JAADall 数据集中模型精度的边界框高度(视频截取出行人的分辨率的高)。在 c) 中,数据集中边界框的分布以蓝色显示,对应的右轴

事件发生时间(TTE)的影响。尽管样本中不同的TTE均匀分布在所有数据库中,但 TTE 和准确性之间存在相关性,如Figure 4所示。在PIE数据库中我们明显可以以看到随着TTE的提高(30帧到60帧)所有模型的准确率逐渐下降(最多20%)。在 J A A D b e h JAAD_{beh} JAADbeh也出现了相识的趋势,但在不同的模型中并不那么突出或一致。有一种可能时因为JAADbaeh中的车辆移动速度比PIE中的慢,所以即使在较高的 TTE 下,精确度仍然很高(请参见图 4c 中所示的 J A A D b e h JAAD_{beh} JAADbeh 中的行人边界框高度分布)。在 J A A D a l l JAAD_{all} JAADalll 中,由于人行道上有大量不穿行行人样本,这些样本很容易与与车辆交互的行人区分开来,因此这种趋势不存在。

遮挡的影响。 在三种数据库中绝大多数观察视频都时没有遮挡的(PIE 82%, J A A D b e h JAAD_{beh} JAADbeh 85%, J A A D a l l JAAD_{all} JAADall 75%)。只有1%-2%的样本超过一半的观察帧被完全或者部分遮挡。正如预期的那样,由于训练和测试的遮挡数据较少,模型的准确性上下波动,遮挡对准确的影响不可预测(图 4b)。

行为研究表明,行人或场景的某些部分可能比其他部对穿行预测更有帮助。相似的,计算模型同样受到遮挡的影响(例如 图 3 中一些受到遮挡的困难穿行样本)。然而,由于注释不提供被遮挡元素的特定位置,因此无法进行更深入的调查。

尺度的影响。图 4c 显示了边界框高度的分布情况,以及其对准确度的影响。在PIE中,大部分的训练和测试 数据都集中在[80, 120]px范围内。请注意,高度小于 80 px 的较小边界框的性能会显着下降,这可能是由于可用的视觉信息不足(尤其是对于 3D 卷积模型)。同时,一些模型在 PIE 数据集中 > 500 px 和 J A A D a l l JAAD_{all} JAADall 中 > 400 px 的大边界框上取得了近乎完美的性能。这些是靠近车辆的行人样本,而车辆本身通常是静止的或非常缓慢地移动,从而在观察中产生较少的噪音。

在 J A A D b e h JAAD_{beh} JAADbeh 中,不同尺度的行人在训练和测试数据中分布更均匀,性能波动可能是由其他因素引起的。. 在 J A A D a l l JAAD_{all} JAADall 中,添加场景中可见的其他不穿行的行人,因此增加了 [20, 150] px [44] 范围内的样本比例,与 J A A D b e h JAAD_{beh} JAADbeh 相比,这提高了所有模型在该范围内的准确度。

6.提出的模型 (PCPA)

基于表 2 中总结的基准测试结果,其中表现最好的模型使用 RNN 和 3D 卷积,我们提出一种新的模型:注意力机制行人穿行预测(PCPA)。我们的模型使用3D卷积编码视觉数据和独立RNN处理平行显式特征,例如姿势、位置和车辆速度。尽管I3D在各个数据库总的表型都比C3D优秀,由于I3D较大的尺寸,I3D 与 RNN 相结合显示出过度拟合的趋势,尤其是在 JAAD 数据集上。因此,对于下面的所有实验,我们使用 C3D 来计算 3D 卷积特征。

鉴于过去在许多视觉任务中成功应用注意力,我们添加了受 [31, 2] 启发的注意力机制。在一个例子中,它被应用于RNN分支的隐藏状态(时间注意Temporal attention)和再次应用于分支的输出(模式注意Modality attention)。模型示意图如图5所示,实现细节如下。

Figure 5:提出的模型的示意图。

该模型预测穿行动作 A ∈ {0, 1} 给定的观察包含以下特征:

1)行人 i 周围的军部视觉环境Cobs,c时从RGB图像中截取的行人周围环境

C o b s = { c i t − m , c i t − m + 1 , . . . , c i t } C_{obs}=\{c_{i}^{t-m},c_{i}^{t-m+1},...,c_{i}^{t}\} Cobs={cit−m,cit−m+1,...,cit}

2)轨迹 Lobs ,其中 l是由左上角和右下角点定义的 2D 边界框

L o b s = { l i t − m , l i t − m + 1 , . . . , l i t } L_{obs}=\{l_{i}^{t-m},l_{i}^{t-m+1},...,l_{i}^{t}\} Lobs={lit−m,lit−m+1,...,lit}

3) 行人的姿势 Pobs ,其中 p 是 OpenPose 检测到的 18 个关节的 2D 坐标的 36D 矢量

P o b s = { l p i t − m , p i t − m + 1 , . . . , p i t } P_{obs}=\{lp_{i}^{t-m},p_{i}^{t-m+1},...,p_{i}^{t}\} Pobs={lpit−m,pit−m+1,...,pit}

4)车辆的速度Sobs ,t 是事件前 30 - 60 帧 (∼ 0.5 - 1s) 的时间(穿行或不穿行)

S o b s = { s i t − m , s i t − m + 1 , . . . , s i t } S_{obs}=\{s_{i}^{t-m},s_{i}^{t-m+1},...,s_{i}^{t}\} Sobs={sit−m,sit−m+1,...,sit}

每个 RNN 编码器产生一个向量 c = q ( { h 1 , . . . , h m } ) c = q(\{h_{1},...,h_{m}\}) c=q({h1,...,hm}),隐藏状态 h i = f ( x i , h i − 1 ) h_{i} = f(x_{i},h_{i-1}) hi=f(xi,hi−1),其中 f f f 和 q q q 是非线性函数。

注意力权重向量 α 的长度与观察内容长度 m 相同,α 的计算得分会考虑到观察值的最后一个隐藏状态( h m h_{m} hm)与之前每个隐藏状态。这样做时,他将作用于时间注意Temporal attention块中,改变了观察中的帧相对于最后看到的帧的重要性。权重表示如下:

α = e x p ( s ( h m , h ‾ i ) ) ∑ i ′ = 1 T e x p ( s ( h m , h ‾ i ′ ) ) \alpha = \frac{exp(s(h_{m},\overline{h}_{i}))}{\sum_{i'=1}^{T} exp(s(h_{m},\overline{h}'_{i}))} α=∑i′=1Texp(s(hm,hi′))exp(s(hm,hi))

此处的 h m h_{m} hm是编码器的最后一个隐藏状态, s ( h m , h ‾ i ) = h i T W h ‾ i s(h_{m},\overline{h}_{i})= {h}_{i}^{T}W\overline{h}_{i} s(hm,hi)=hiTWhi是评分函数,W 为可训练的权重矩阵。

将最后一个隐藏状态 h m h_{m} hm与所有‘注意力加权隐藏状态 c t = ∑ i a i h ‾ i {c}_{t} = \sum_{i}{a}_{i}\overline{h}_{i} ct=∑iaihi( 在最后一个观察帧之前观察到的环境表示)链接一起,以此作为前馈网络以产生注意力输出向量 a:

a = f ( c m , h m ) = t a h n ( W c [ c m : h m ] ) a = f({c}_{m},{h}_{m}) = tahn({W}_{c}[{c}_{m}:{h}_{m}]) a=f(cm,hm)=tahn(Wc[cm:hm]).

然后,我们将相同的注意力机制应用于 RNN 流的加权输出和 3D 卷积分支(通过具有sigmoid 激活的FC层展平3D图像,将维度减少到与隐藏层相同)的输出,即将新的变量定义为 c = { C ‾ , h ‾ L , h ‾ P , h ‾ S } c = \{\overline{C},\overline{h}_{L},\overline{h}_{P},\overline{h}_{S}\} c={C,hL,hP,hS},其中 h ‾ \overline{h} h 是RNN流最后隐藏状态的权重。这机制作用于模式注意Modality attention块。

然后将模态注意Modality attention块的输出传递给 FC 层,用于预测给定观察的交叉动作 A。

执行。我们使用具有 256 个隐藏单元的 GRU 来编码非视觉特征,并使用在 Sports-1M 数据集 [22] 上预先训练的权重的 C3D 网络来编码视觉特征(局部环境,如第 3 节中定义)。在最后的FC预测层使用参数为0.001的L2正则化,在只有的注意力模块使用以0.5概率进行随机丢弃(dropout)。车辆速度特征仅在 PIE 数据集中使用,在 JAAD 中省略。

PS:L2正则化和随机丢弃都是为了防止过拟合。

训练。我们使用 Adam 优化器 [24]、二元交叉熵损失和批量大小设置为 8 来训练模型。在我们在PIE中以 5 ⋅ 1 0 − 5 {5 \cdot 10^{-5}} 5⋅10−5 的学习速率进行60次迭代训练,在JAAD以 5 ⋅ 1 0 − 7 {5 \cdot 10^{-7}} 5⋅10−7 的学习速率进行80次迭代训练。

6.1结果

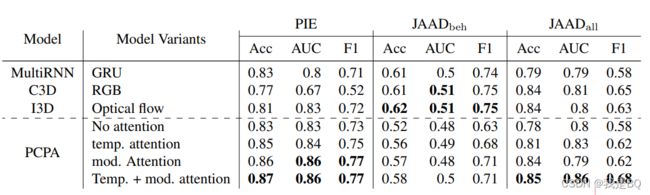

Table 3:使用不同类型的注意力机制训练的新模型 PCPA 的结果。 其他模型的结果显示在虚线上方以进行比较。

在 Table 3 中列出了使用时间和模式注意模型的结果。结果在PIE数据库中得到最大的提升,准确度提高4%,F1分数提高6%。在 J A A D a l l JAAD_{all} JAADall 上,我们的模型在某些指标上的表现与最先进的水平相当。由于注意力机制引入了更多的参数,因此在更大和更多样的数据库中的表现更优秀。在 J A A D b e h JAAD_{beh} JAADbeh中的性能不太好,因为它的训练数据最少且有明星的重叠。

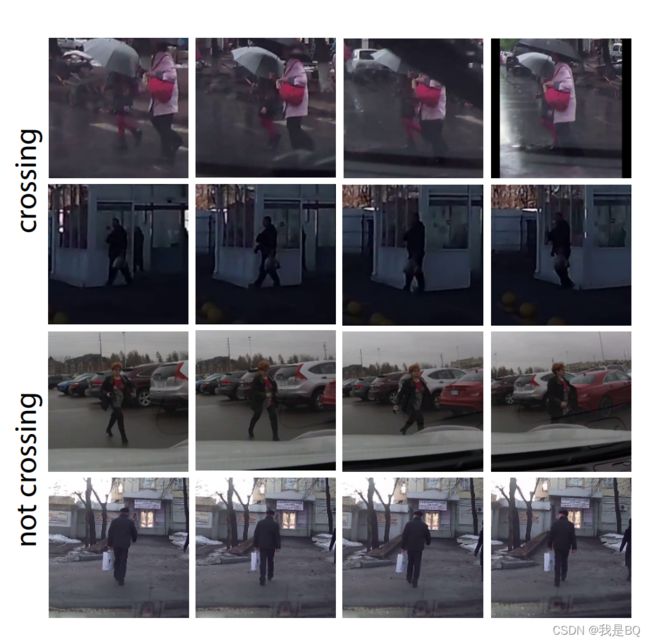

Figure 6 :来自 JAAD 和 PIE 的横穿和非横穿行人示例。 由所提出的模型正确分类的样本以绿色轮廓显示,错误分类的案例以红色突出显示。

Figure 6 展示了新模型成功与失败的示例。部分穿心分类示例来自困难样本集( 5.2 节),如行人没有面向车辆和明显的模糊。对行人在对话(底行)错误分类,因为这需要模型对场景中目标之间的交互进行建模。

注意力机制的影响。Table 3 也展示了 PCPA 模型不同类型注意力机制带来的影响。我们可以发现,将时间注意和模式注意单独分开进行实验的所有指标都有所提升,当两种机制结合使用时,可以实现额外的提升。应该注意的是,引入注意力机制使模型变得更复杂,需要更多参数,因此也需要更多更多样的数据用于训练来避免过拟合。

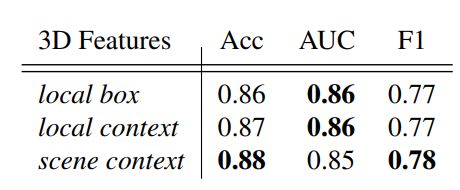

Table 4: 在具有不同视觉特征的 PIE 数据集上训练的最终 PCPA 模型的结果。

视觉环境的影响。除了注意力,我们还尝试了第 3 节中定义的各种视觉特征。在JAAD数据库中,训练各种不同的视觉环境带来很小的影响,这可能是由于数据库缺乏多样化的样本。 Table 4 展示了在 PIE 执行的结果。使用行人环境和场景环境都有卓越的效果,除了使用边界框环境。

7.总结

我们提出一个新的评价协议用于基准行人动作预测算法。我们使用新的标准实验和评估了一些基线和先进模型。是有两个公开可用的数据库,PIE 和 JAAD,我们分析static, recurrent, 3D convolutional 和 two-stream结构在不同数据属性下的性能,例如事件发生时间(TTE)、遮挡和截图大小。我们发现很难将样本的预测难度归于特定数据属性。此外,我们没有观察到模型协议的一致性。

基于基准测试结果,我们提出了一个新的混合模型,结合recurrent 和 3D卷积方法,并是有时间和模型注意力机制。所提出的模型在 PIE 和 JAAD 数据集上都达到了最先进的水平。

致谢。此项工作收到以下机构支持:加拿大自然科学与工程研究委员会 (NSERC),NSERC 加拿大机器人网络 (NCRN)、空军科学研究办公室 (美国) 和由JKT赠款的加拿大研究主席计划。

参考

[1] Edoardo Alati, Lorenzo Mauro, Valsamis Ntouskos, and Fiora Pirri. Help by predicting what to do. In IEEE Interna tional Conference on Image Processing (ICIP), 2019.

[2] Dzmitry Bahdanau, Kyunghyun Cho, and Yoshua Bengio. Neural machine translation by jointly learning to align and translate. arXiv preprint arXiv:1409.0473, 2014.

[3] Apratim Bhattacharyya, Mario Fritz, and Bernt Schiele. Long-term on-board prediction of people in traffic scenes un der uncertainty. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 4194–4202, 2018.

[4] Judith Butepage, Hedvig Kjellstr ¨ om, and Danica Kragic. ¨ Anticipating many futures: Online human motion prediction and generation for human-robot interaction. In IEEE interna tional conference on robotics and automation (ICRA), 2018.

[5] Pablo Rodrigo Gantier Cadena, Ming Yang, Yeqiang Qian, and Chunxiang Wang. Pedestrian Graph: Pedestrian Cross ing Prediction Based on 2D Pose Estimation and Graph Con volutional Networks. In IEEE Intelligent Transportation Sys tems Conference (ITSC), pages 2000–2005, 2019.

[6] Zhe Cao, Tomas Simon, Shih-En Wei, and Yaser Sheikh. Re altime multi-person 2D pose estimation using part affinity fields. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 7291–7299, 2017.

[7] Joao Carreira and Andrew Zisserman. Quo vadis, action recognition? A new model and the kinetics dataset. In IEEE Conference on Computer Vision and Pattern Recog nition (CVPR), pages 6299–6308, 2017.

[8] Sergio Casas, Wenjie Luo, and Raquel Urtasun. Intentnet: Learning to predict intention from raw sensor data. In Con ference on Robot Learning (CORL), 2018.

[9] Mohamed Chaabane, Ameni Trabelsi, Nathaniel Blanchard, and Ross Beveridge. Looking ahead: Anticipating pedes trians crossing with future frames prediction. In IEEE Win ter Conference on Applications of Computer Vision (WACV), pages 2297–2306, 2020. [10] Junwen Chen, Wentao Bao, and Yu Kong. Group activity prediction with sequential relational anticipation model. In European Conference on Computer Vision (ECCV), 2020.

[11] Lei Chen, Jiwen Lu, Zhanjie Song, and Jie Zhou. Part activated deep reinforcement learning for action prediction. In European Conference on Computer Vision (ECCV), 2018.

[12] Wenxiang Chen, Xiangling Zhuang, Zixin Cui, and Guo jie Ma. Drivers recognition of pedestrian road-crossing intentions: Performance and process. Transportation Re search Part F: Traffic Psychology and Behaviour, 64:552– 564, 2019.

[13] Kyunghyun Cho, Bart Van Merrienboer, Dzmitry Bahdanau, ¨ and Yoshua Bengio. On the properties of neural machine translation: Encoder-decoder approaches. arXiv preprint arXiv:1409.1259, 2014.

[14] Yong Du, Wei Wang, and Liang Wang. Hierarchical recur rent neural network for skeleton based action recognition. In IEEE Conference on Computer Vision and Pattern Recogni tion (CVPR), pages 1110–1118, 2015.

[15] Zhijie Fang and Antonio M Lopez. Is the pedestrian going to ´ cross? Answering by 2D pose estimation. In IEEE Intelligent Vehicles Symposium (IV), pages 1271–1276, 2018.

[16] Antonino Furnari and Giovanni Maria Farinella. What would you expect? anticipating egocentric actions with rolling unrolling lstms and modality attention. In IEEE Interna tional Conference on Computer Vision (ICCV), 2019.

[17] Harshala Gammulle, Simon Denman, Sridha Sridharan, and Clinton Fookes. Predicting the future: A jointly learnt model for action anticipation. In IEEE International Conference on Computer Vision (ICCV), 2019.

[18] Pratik Gujjar and Richard Vaughan. Classifying pedestrian actions in advance using predicted video of urban driving scenes. In International Conference on Robotics and Au tomation (ICRA), pages 2097–2103, 2019.

[19] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. Deep residual learning for image recognition. In Proceed ings of the IEEE conference on computer vision and pattern recognition, pages 770–778, 2016.

[20] Sepp Hochreiter and Jurgen Schmidhuber. Long short-term ¨ memory. Neural computation, 9(8):1735–1780, 1997.

[21] Eddy Ilg, Nikolaus Mayer, Tonmoy Saikia, Margret Keu per, Alexey Dosovitskiy, and Thomas Brox. Flownet 2.0: Evolution of optical flow estimation with deep networks. In IEEE Conference on Computer Vision and Pattern Recogni tion (CVPR), pages 2462–2470, 2017. [22] Andrej Karpathy, George Toderici, Sanketh Shetty, Thomas Leung, Rahul Sukthankar, and Li Fei-Fei. Large-scale video classification with convolutional neural networks. In IEEE conference on Computer Vision and Pattern Recognition (CVPR), pages 1725–1732, 2014.

[23] Qiuhong Ke, Mario Fritz, and Bernt Schiele. Time conditioned action anticipation in one shot. In IEEE Confer ence on Computer Vision and Pattern Recognition (CVPR), 2019.

[24] Diederik P Kingma and Jimmy Ba. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980, 2014.

[25] Vineet Kosaraju, Amir Sadeghian, Roberto Martin-Martin, Ian Reid, Hamid Rezatofighi, and Silvio Savarese. Social bigat: Multimodal trajectory forecasting using bicycle-gan and graph attention networks. In Advances in Neural Infor mation Processing Systems (NeurIPS), 2019.

[26] Iuliia Kotseruba, Amir Rasouli, and John K Tsotsos. Do They Want to Cross? Understanding Pedestrian Intention for Behavior Prediction. In IEEE Intelligent Vehicles Symposium (IV), 2020.

[27] Junwei Liang, Lu Jiang, Juan Carlos Niebles, Alexander G. Hauptmann, and Li Fei-Fei. Peeking into the future: Pre dicting future person activities and locations in videos. In IEEE Conference on Computer Vision and Pattern Recogni tion (CVPR), 2019.

[28] Bingbin Liu, Ehsan Adeli, Zhangjie Cao, Kuan-Hui Lee, Abhijeet Shenoi, Adrien Gaidon, and Juan Carlos Niebles. Spatiotemporal Relationship Reasoning for Pedestrian In tent Prediction. IEEE Robotics and Automation Letters, 5(2):3485–3492, 2020.

[29] Chaochao Lu, Michael Hirsch, and Bernhard Scholkopf. Flexible spatio-temporal networks for video prediction. In IEEE Conference on Computer Vision and Pattern Recogni tion (CVPR), 2017.

[30] Ren C Luo and Licong Mai. Human intention inference and on-line human hand motion prediction for human-robot col laboration. In IEEE/RSJ International Conference on Intel ligent Robots and Systems (IROS), pages 5958–5964, 2019.

[31] Minh-Thang Luong, Hieu Pham, and Christopher D Man ning. Effective approaches to attention-based neural machine translation. arXiv preprint arXiv:1508.04025, 2015.

[32] Srikanth Malla, Behzad Dariush, and Chiho Choi. Titan: Future forecast using action priors. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2020.

[33] Karttikeya Mangalam, Harshayu Girase, Shreyas Agarwal, Kuan-Hui Lee, Ehsan Adeli, Jitendra Malik, and Adrien Gaidon. It is not the journey but the destination: Endpoint conditioned trajectory prediction. In ECCV, 2020.

[34] Satyajit Neogi, Michael Hoy, Kang Dang, Hang Yu, and Justin Dauwels. Context model for pedestrian intention pre diction using factored latent-dynamic conditional random fields. IEEE Transactions on Intelligent Transportation Sys tems, 2019.

[35] Chonhyon Park, Jan Ondˇrej, Max Gilbert, Kyle Freeman, and Carol O’Sullivan. Hi robot: Human intention-aware robot planning for safe and efficient navigation in crowds. In IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), pages 3320–3326, 2016.

[36] Francesco Piccoli, Rajarathnam Balakrishnan, Maria Jesus Perez, Moraldeepsingh Sachdeo, Carlos Nunez, Matthew Tang, Kajsa Andreasson, Kalle Bjurek, Ria Dass Raj, Ebba Davidsson, et al. FuSSI-Net: Fusion of Spatio-temporal Skeletons for Intention Prediction Network. arXiv preprint arXiv:2005.07796, 2020.

[37] Dnut¸ Ovidiu Pop. Detection of pedestrian actions based on deep learning approach. Studia UBB Informatica, 2019.

[38] Danut¸ Ovidiu Pop, Alexandrina Rogozan, Clement Chate- ˘ lain, Fawzi Nashashibi, and Abdelaziz Bensrhair. Multi-Task Deep Learning for Pedestrian Detection, Action Recogni tion and Time to Cross Prediction. IEEE Access, 7:149318– 149327, 2019.

[39] Mengshi Qi, Jie Qin, Yu Wu, and Yi Yang. Imitative non autoregressive modeling for trajectory forecasting and impu tation. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2020.

[40] Adithya Ranga, Filippo Giruzzi, Jagdish Bhanushali, Emi lie Wirbel, Patrick Perez, Tuan-Hung Vu, and Xavier Perot- ´ ton. VRUNet: Multi-Task Learning Model for Intent Predic tion of Vulnerable Road Users. In International Symposium on Electronic Imaging: Autonomous Vehicles and Machines, pages 1–9, 2020.

[41] Amir Rasouli. Deep learning for vision-based prediction: A survey. arXiv:2007.00095, 2020.

[42] Amir Rasouli, Iuliia Kotseruba, Toni Kunic, and John K Tsotsos. PIE: A Large-Scale Dataset and Models for Pedes trian Intention Estimation and Trajectory Prediction. In IEEE International Conference on Computer Vision (ICCV), pages 6262–6271, 2019.

[43] Amir Rasouli, Iuliia Kotseruba, and John K Tsotsos. Agree ing to cross: How drivers and pedestrians communicate. In 2017 IEEE Intelligent Vehicles Symposium (IV), pages 264– 269. IEEE, 2017.

[44] Amir Rasouli, Iuliia Kotseruba, and John K Tsotsos. Are they going to cross? A benchmark dataset and baseline for pedestrian crosswalk behavior. In IEEE International Conference on Computer Vision Workshops (ICCVW), pages 206–213, 2017.

[45] Amir Rasouli, Iuliia Kotseruba, and John K Tsotsos. It’s not all about size: On the role of data properties in pedes trian detection. In European Conference on Computer Vision (ECCV), 2018.

[46] Amir Rasouli, Iuliia Kotseruba, and John K Tsotsos. Pedes trian Action Anticipation using Contextual Feature Fusion in Stacked RNNs. 2019.

[47] Amir Rasouli and John K Tsotsos. Autonomous vehicles that interact with pedestrians: A survey of theory and prac tice. IEEE Transactions on Intelligent Transportation Sys tems, 21(3):900–918, 2020.

[48] Mohammad Sadegh Aliakbarian, Fatemeh Sadat Saleh, Mathieu Salzmann, Basura Fernando, Lars Petersson, and Lars Andersson. Encouraging lstms to anticipate actions very early. In IEEE International Conference on Computer Vision (ICCV), 2017.

[49] Khaled Saleh, Mohammed Hossny, and Saeid Nahavandi. Real-time intent prediction of pedestrians for autonomous ground vehicles via spatio-temporal densenet. In Inter national Conference on Robotics and Automation (ICRA), pages 9704–9710, 2019.

[50] Sarah Schmidt and Berthold Faerber. Pedestrians at the kerb– recognising the action intentions of humans. Transporta tion Research Part F: Traffic Psychology and Behaviour, 12(4):300–310, 2009.

[51] Xingjian Shi, Zhourong Chen, Hao Wang, Dit-Yan Yeung, Wai-Kin Wong, and Wang-chun Woo. Convolutional LSTM network: A machine learning approach for precipitation nowcasting. In Advances in Neural Information Processing Systems (NeurIPS), pages 802–810, 2015.

[52] Karen Simonyan and Andrew Zisserman. Two-stream con volutional networks for action recognition in videos. In Ad vances in Neural Information Processing Systems (NeurIPS), pages 568–576, 2014.

[53] Karen Simonyan and Andrew Zisserman. Very deep convo lutional networks for large-scale image recognition. arXiv preprint arXiv:1409.1556, 2014.

[54] Mark Strickland, Georgios Fainekos, and Heni Ben Amor. Deep predictive models for collision risk assessment in au tonomous driving. In International Conference on Robotics and Automation (ICRA), 2018.

[55] Tomoyuki Suzuki, Hirokatsu Kataoka, Yoshimitsu Aoki, and Yutaka Satoh. Anticipating traffic accidents with adaptive loss and large-scale incident db. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018.

[56] Du Tran, Lubomir Bourdev, Rob Fergus, Lorenzo Torresani, and Manohar Paluri. Learning spatiotemporal features with 3D convolutional networks. In IEEE International Confer ence on Computer Vision (ICCV), pages 4489–4497, 2015.

[57] Dimitrios Varytimidis, Fernando Alonso-Fernandez, Boris Duran, and Cristofer Englund. Action and intention recogni tion of pedestrians in urban traffic. In International Confer ence on Signal-Image Technology & Internet-Based Systems (SITIS), pages 676–682, 2018.

[58] Limin Wang, Yuanjun Xiong, Zhe Wang, and Yu Qiao. To wards good practices for very deep two-stream convnets. arXiv preprint arXiv:1507.02159, 2015.

[59] Joe Yue-Hei Ng, Matthew Hausknecht, Sudheendra Vi jayanarasimhan, Oriol Vinyals, Rajat Monga, and George Toderici. Beyond short snippets: Deep networks for video classification. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 4694–4702, 2015.

[60] Kuo-Hao Zeng, Shih-Han Chou, Fu-Hsiang Chan, Juan Car los Niebles, and Min Sun. Agent-centric risk assessment: Accident anticipation and risky region localization. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017.

[61] Pu Zhang, Wanli Ouyang, Pengfei Zhang, Jianru Xue, and Nanning Zheng. Sr-lstm: State refinement for lstm towards pedestrian trajectory prediction. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2019.

[62] Zhishuai Zhang, Jiyang Gao, Junhua Mao, Yukai Liu, Dragomir Anguelov, and Congcong Li. Stinet: Spatio temporal-interactive network for pedestrian detection and trajectory prediction. In IEEE Conference on Computer Vi sion and Pattern Recognition (CVPR), 2020. [63] He Zhao and Richard P. Wildes. On diverse asynchronous activity anticipation. In European Conference on Computer Vision (ECCV), 2020.

[64] Siyu Zhou, Mariano J Phielipp, Jorge A Sefair, Sara I Walker, and Heni Ben Amor. Clone swarms: Learning to predict and control multi-robot systems by imitation. In IEEE/RSJ International Conference on Intellig.