MACHINE LEARNING FOR SPACE–AIR–GROUND INTEGRATED NETWORK ASSISTED VEHICULAR NETWORK

难点:高异质性使得其网络状态高度动态,其丰富的资源难以管理。

机器学习在SAGIN辅助车辆网络中的应用

在高度动态环境中无线电配置和波束形成问题

新问题:通信成本和移动节点协调;管理资源池的成本高;空间庞大难以集中处理网络节点;对各种计算卸载节点进行资源分配

解决:[11]深度模仿学习卸载和缓存算法;利用联邦学习的训练方法,在SAGIVN的边缘部署分布式计算节点;[12]基于学习的队列感知任务卸载和资源分配算法,该算法采用了强化学习中的参与者批评算法;联邦强化学习

[11]

在本文中,我们考虑了一种细粒度的任务划分方式[23],并将一个计算任务o,(o∈O)分割为多个子任务。设o =(V,D),其中V表示子任务集,D表示子任务之间的数据依赖关系。设|V|表示任务o中的子任务的数量。LEO卫星m在接收到车辆的任务要求后,可以将子任务v(v∈V)卸载到地面站,或在卫星中本地执行,以深度神经网络(DNN)模型划分[2]为例。为了减少边缘智能应用在终端设备上执行的负担,DNN模型划分可以将一个DNN训练阶段(即计算任务o)分割为多个子任务(即DNN的隐藏层),如图2所示。通过动态地将资源密集型的子任务卸载到更丰富的服务器(即ECSAGINs中的地面站),DNN模型分区可以加快推理过程。

3.机器学习在SAGIN辅助车辆网络交通控制中的应用

交通控制:网络路由、拥塞控制和流量卸载

问题:车辆网络的高机动性和道路交通拥堵使得车辆通信不稳定(影响丢包率、吞吐量);道路交通预测,需要实时的车辆拓扑结构和道路交通状态信息;车辆网络的容量有限,无法满足用户密集型区域的网络需求

解决:SAGIN中的节点可以为车辆网络提供中继节点,有效地减少了传输跳数,使通信链路更加稳定;卫星和无人机辅助的车辆定位可以获得实时的车辆定位拓扑结构和车辆状态信息;SAGIN提供的丰富资源池可以解决用户密集地区车辆网络的拥塞问题

新问题:高度异构的网络和巨大的网络空间,使得实时收集全局信息具有挑战性;如何智能地调度和协作这些异构网络中的节点

解决:联邦学习无需全局节点;强化学习动态适应网络环境[14]

4.机器学习在SAGIN辅助车辆网络数据缓存中的应用

问题:车载网络辅助缓存并不能有效地解决用户密集型地区数据流量快速增长的问题

解决:基站可用作边缘缓存;无人机和HAP可以为缺乏基础设施的偏远地区提供通信和缓存服务;卫星可以跨整个网络提供有效的通信;SAGIN中的BS和无人机可以存储许多数据集

新问题:如何在SAGIVN中做出有效的缓存决策

解决:机器学习通过用户移动设备收集的信息训练,可以预测用户数据需求的分布;通过结合网络状态和用户需求,机器学习动态地分配高速缓存资源;强化学习定义了控制算法性能的奖励函数

5.机器学习在SAGIN辅助车辆网络安全中的应用

问题:通信的不稳定性使得传统的基于声誉的安全系统无法发挥作用;高度动态特性也使车辆在真实环境中的位置不可预测,进一步影响了安全信息的交互作用;由于地形障碍,车辆无法传输实时信息,犯罪分子可能会抓住机会入侵网络,影响救援效率

解决:BSs、无人机和卫星可作为安全信息交换的中继节点;无人机和卫星可以在道路上发生紧急情况下为车辆提供通信和精确定位,并能快速完成安全信息的交换。

问题:传统的车载网络认证和加密需要较大的计算和存储开销,不适用于SAGIVN

解决:提出了一种用于空地节点[15]物理层信号特征提取和识别的度量深度学习算法,解决了传统方法中的存储开销问题;联邦学习中的每个边缘节点都可以在本地收集数据和训练,有效地保证了数据的安全性。

6.案例研究:在SAGIN辅助的车辆网络中,基于联邦强化学习的交通卸载

挑战:资源池的管理(如:资源分配);动态环境中做出卸载决策

拓展: 2.1.马尔可夫决策过程(MDP) - 知乎 (zhihu.com)

状态空间S:多维数组(网络节点周围的一跳和两跳邻居节点的相关信息) 动作空间A:四维向量(第一个元素表示设备根据原始路由路径将数据包传输到下一个设备,向量中的其他元素表示所选的卸载节点,包括所有相邻的无人机、LEOs和GEOs) 奖励函数R:两种情况,当包根据路由路径到达目的地时,奖励值为包延迟的倒数,当包丢失时,奖励值为包延迟的负数。

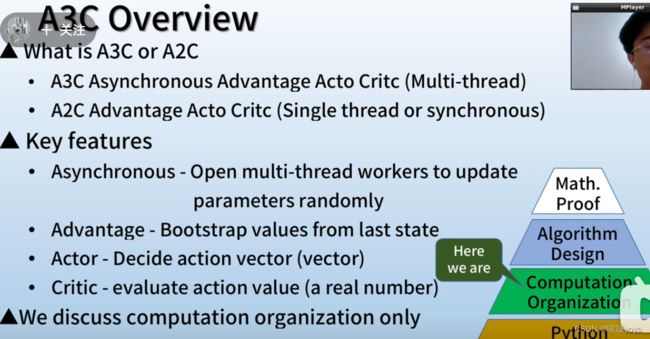

解决方案:提出了一种基于联邦强化学习(FRL)的流量卸载方法,该方法使用异步优势参与者批评(A3C)算法来解决建模和状态空间爆炸问题

A3C:

异步:每个工人(执行绪)可以随机的上传或下载学习参数,不需要等待其他的执行绪进度

优势:在评价动作价值的时候可以不需要跑完全部的游戏过程

演员:动作向量,随机模型的神经网络输出

评论家:价值函数

交通卸载的联邦强化学习过程: 本地训练阶段: BSs作为边缘学习者,从周围的一跳和两跳邻居中收集状态信息,同时接收和转发来自终端和车辆的数据包,并将其作为本部训练模型的输入。 当本地训练达到阈值时,边缘节点将把局部模型矩阵上传到中心学习器。 本地行为者网络根据状态信息做出卸载决策。(当本地训练节点周围的可连接节点集包括无人机和LEO时,代理根据该无人机和LEO的当前状态信息(例如,当前队列大小、队列的最大负载、信道条件)做出最佳卸载决策,以获得良好的奖励值,即BS选择将数据包发送给无人机或LEOs) 评论网络根据代理所做出的卸载决定给出奖励值,从而判断行为是好是坏。评论家网络每次计算累积折扣奖励,并更新行为者网络和批评网络的梯度。

在收集了多个本地网络模型后: 中心学习者对本地模型进行了集成,并更新了全局模型,将最新的全局模型分布到每个边缘训练节点,以更新本地网络模型。在每个边缘节点更新最新的网络模型之后,本地代理将继续与本地环境进行交互。

实验参数设定、实验结果...