Hadoop集群搭建完全分布式搭建---------虚拟机版本

大数据自学——之Hadoop集群搭建分布式搭建小白超详细安装教程

小蜡笔的安装工具:

VMwara(以管理员身份运行哦)、Xshell、Xftp

一、准备工作:

1.虚拟机安装三台linux 本次测试是 Centos 6.5,(三台虚拟机的系统时间保持一致)

安装第一台虚拟机,并将该虚拟机默认设为主节点,小蜡笔命名为:master

(1)配置主机ip

(2)修改主机名命令:

(2)修改主机名命令: vim /etc/sysconfig/network

2.安装jdk1.8.0

1.在usr目录下创建soft/java目录将jdk包通过xftpc传进虚拟机中该目录

makdir /usr/soft/java (注意:可能会创建失败,可以分级创建先创建soft再创建java,这是小蜡笔的目录,大家可以更改为自己的路径哦!)

2.在/usr/soft/java/目录下解压安装包:

解压命令: tar -zxvf dk-8u171-linux-x64.tar.gz

3.配置java环境变量: vim /etc/profile 配置环境变量然后在source /etc/profile 检验jdk是否安装成功。

export JAVA_HOME=/usr/soft/java/jdk1.8.0_171

export PATH=.:$JAVA_HOME/bin:$PATH

3.克隆虚拟机

*在vmware设置-克隆(虚拟机要关机,jdk要配置好)

*选择克隆当前状态的虚拟机,克隆完之后,点击重新生成mac地址

克隆2台虚拟机完成后:新的2台虚拟机,请务必依次修改2台虚拟机的ip地址和主机名称(小蜡笔设置为node1、node2)

最后在依次重启三台虚拟机:重启命令:reboot

二、重启完成后依次在虚拟机上执行下面命令

1.设置ip(上述步骤)(三台都要操作)

使用命令 重启网卡:service network restart

2.关闭防火墙(三台都要操作),使用命令:service iptables stop

3.关闭防火墙的自动启动(三台都要操作),使用命令:chkconfig iptables off

(以下的所有步骤都在master主机上完成)

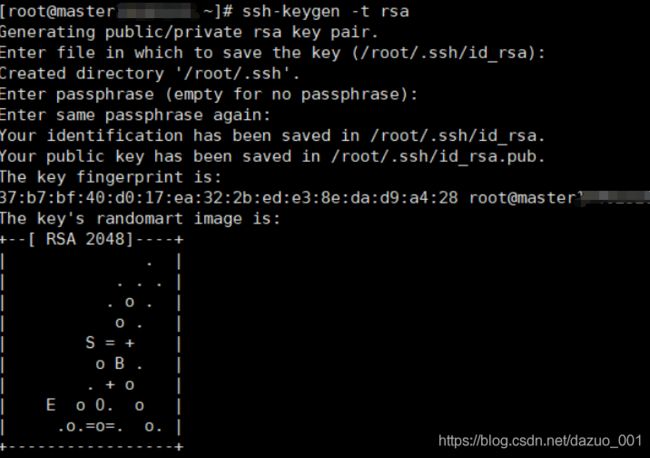

4.设置ssh免密码登录(只在Master 这台主机操作)

4.1主节点执行命令ssh-keygen -t rsa 产生密钥 一直回车

执行命令

ssh-copy-id -i node1

ssh-copy-id -i node2

实现免密码登录到子节点。

4.2 实现主节点master本地免密码登录

首先进入到/root 命令:cd /root

再进入进入到 ./.ssh目录下

命令:cd ./.ssh/

然后将公钥写入本地执行命令:

然后将公钥写入本地执行命令:

cat ./id_rsa.pub >> ./authorized_keys

5.设置主机名与ip的映射,修改配置文件命令:vim /etc/hosts

5.1将hosts文件拷贝到node1和node2节点

命令:

scp /etc/hosts node1:/etc/hosts

scp /etc/hosts node2:/etc/hosts

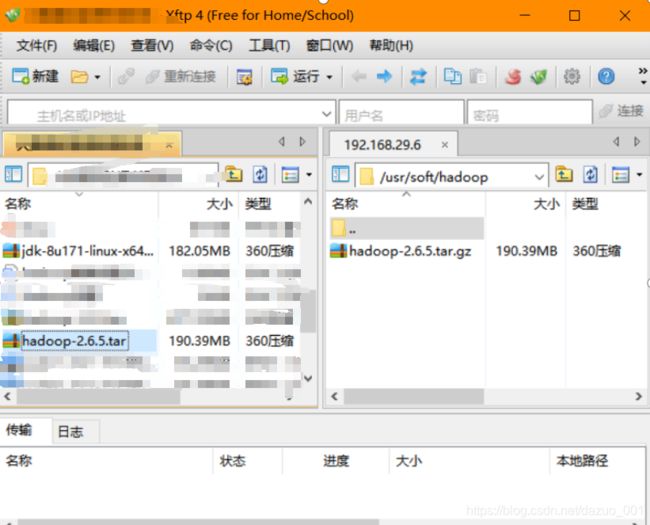

三、Hadoop集群分布式搭建(以下步骤都在master主机上完成)

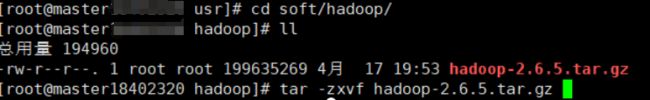

1.将hadoop的jar包先上传到虚拟机/usr/soft/hadoop/目录下,主节点master。可以使用xftp拖拽

2.解压。

2.解压。tar -zxvf hadoop-2.6.5.tar.gz 解压完后会出现 hadoop-2.6.5的目录

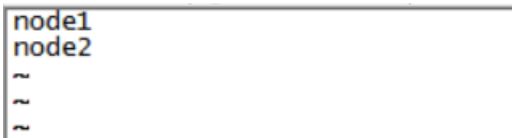

3.修改master中hadoop的一个配置文件/usr/soft/hadoop/hadoop-2.6.5/etc/hadoop/slaves 删除原来的所有内容,修改为如下

3.修改master中hadoop的一个配置文件/usr/soft/hadoop/hadoop-2.6.5/etc/hadoop/slaves 删除原来的所有内容,修改为如下

4.,修改hadoop的几个组件的配置文件 进入/usr/soft/hadoop/hadoop-2.6.5/etc/hadoop 目录下(请一定要注意配置文件内容的格式,可以直接复制过去粘贴。不要随意改会出错)

- 修改hadoop-env.sh文件

export JAVA_HOME=/usr/soft/java/jdk1.8.0_171

输入完后 按住Esc键后输入:wq (保存并退出,注意冒号不要丢了)

- 修改 core-site.xml

<configuration>

<! ****************输入以下内容********>

<property>

<name>fs.defaultFSname>

<value>hdfs://master:9000value>

property>

<property>

<name>hadoop.tmp.dirname>

<value>/usr/soft/hadoop/hadoop-2.6.5/tmpvalue>

property>

<property>

<name>fs.trash.intervalname>

<value>1440value>

property>

<! *******************************>

configuration>

- 修改 hdfs-site.xml 将dfs.replication设置为1

<configuration>

<! ****************输入以下内容********>

<property>

<name>dfs.replicationname>

<value>1value>

property>

<property>

<name>dfs.permissionsname>

<value>falsevalue>

property>

<! *******************************>

configuration>

- 修改文件yarn-site.xml

<configuration>

<! ****************输入以下内容********>

<property>

<name>yarn.resourcemanager.hostnamename>

<value>mastervalue>

property>

<property>

<name>yarn.nodemanager.aux-servicesname>

<value>mapreduce_shufflevalue>

property>

<property>

<name>yarn.log-aggregation-enablename>

<value>truevalue>

property>

<property>

<name>yarn.log-aggregation.retain-secondsname>

<value>604800value>

property>

<! *******************************>

configuration>

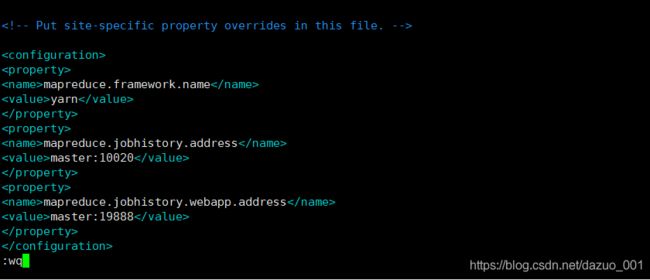

- 修改 mapred-site.xml(将mapred-site.xml.template 复制一份为 mapred-site.xml

命令:cp mapred-site.xml.template mapred-site.xml)

<configuration>

<! ****************输入以下内容********>

<property>

<name>mapreduce.framework.namename>

<value>yarnvalue>

property>

<property>

<name>mapreduce.jobhistory.addressname>

<value>master:10020value>

property>

<property>

<name>mapreduce.jobhistory.webapp.addressname>

<value>master:19888value>

propert>

<! *******************************>

configuration>

5.将hadoop的安装目录分别拷贝到其他子节点

scp -r /usr/soft/hadoop/hadoop-2.6.5 node1:/usr/soft/hadoop/hadoop-2.6.5

scp -r /usr/soft/hadoop/hadoop-2.6.5 node2:/usr/soft/hadoop/hadoop-2.6.5

**

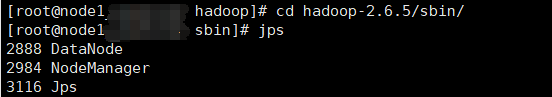

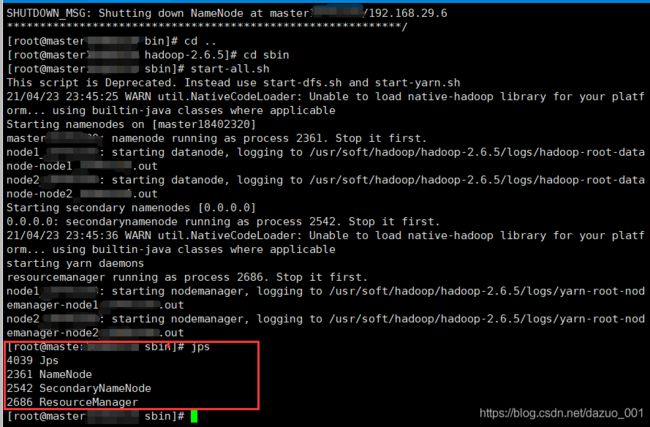

四、 启动hadoop

**

首先看下hadoop-2.6.5目录下有没有tmp文件夹。

如果没有 执行一次格式化命令:

cd /usr/soft/hadoop/hadoop-2.6.5目录下

执行命令:

./bin/hdfs namenode -format

会生成tmp文件。

然后

/usr/local/soft/hadoop-2.6.5目录下

启动执行:./sbin/start-all.sh

启动完成后验证进程

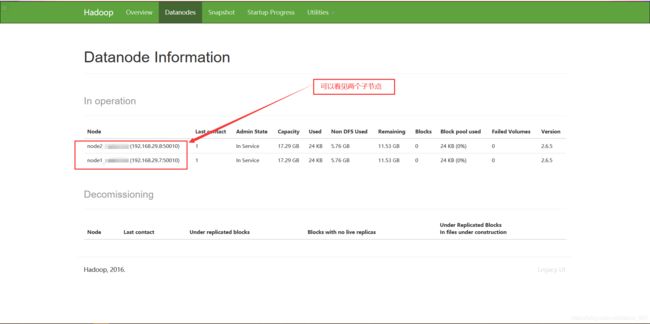

五、 验证hdfs

可以登录浏览器地址:192.168.29.6:50070 (ip地址是master的地址,50070是Hadoop的默认端口号)

看到下面页面证明 hdfs装好了

下图是我刚装好的hadoop应该是空的什么都没有

************ 如果第一次启动失败了,请重新检查配置文件或者哪里步骤少了*****

再次重启的时候

需要手动将每个节点的tmp目录删除:

rm -rf /usr/soft/hadoop/hadoop-2.6.5/tmp

然后执行将namenode格式化

在主节点执行命令:

./bin/hdfs namenode -format

执行后会出现下图的提示:

老铁们,到这里我们的hadoop就已经全部装好了哦!可能部分铁子们还想装个MySQL以及Hive,这里呢,小蜡笔呢,也有一篇自学的博客关于这个安装的教程,,,附上链接:https://blog.csdn.net/dazuo_001/article/details/115980579