基于CentOS搭建hadoop-3.1.3的伪分布式集群

这里写自定义目录标题

- 欢迎使用Markdown编辑器

-

- 新的改变

- 功能快捷键

- 合理的创建标题,有助于目录的生成

- 如何改变文本的样式

- 插入链接与图片

- 如何插入一段漂亮的代码片

- 生成一个适合你的列表

- 创建一个表格

-

- 设定内容居中、居左、居右

- SmartyPants

- 创建一个自定义列表

- 如何创建一个注脚

- 注释也是必不可少的

- KaTeX数学公式

- 新的甘特图功能,丰富你的文章

- UML 图表

- FLowchart流程图

- 导出与导入

-

- 导出

- 导入

- 开始前的一些相关说明

-

- 准备工作:

- ## Hadoop和jdk安装无误后就可以开始下一步的准备工作啦

欢迎使用Markdown编辑器

你好! 这是你第一次使用 Markdown编辑器 所展示的欢迎页。如果你想学习如何使用Markdown编辑器, 可以仔细阅读这篇文章,了解一下Markdown的基本语法知识。

新的改变

我们对Markdown编辑器进行了一些功能拓展与语法支持,除了标准的Markdown编辑器功能,我们增加了如下几点新功能,帮助你用它写博客:

- 全新的界面设计 ,将会带来全新的写作体验;

- 在创作中心设置你喜爱的代码高亮样式,Markdown 将代码片显示选择的高亮样式 进行展示;

- 增加了 图片拖拽 功能,你可以将本地的图片直接拖拽到编辑区域直接展示;

- 全新的 KaTeX数学公式 语法;

- 增加了支持甘特图的mermaid语法1 功能;

- 增加了 多屏幕编辑 Markdown文章功能;

- 增加了 焦点写作模式、预览模式、简洁写作模式、左右区域同步滚轮设置 等功能,功能按钮位于编辑区域与预览区域中间;

- 增加了 检查列表 功能。

功能快捷键

撤销:Ctrl/Command + Z

重做:Ctrl/Command + Y

加粗:Ctrl/Command + B

斜体:Ctrl/Command + I

标题:Ctrl/Command + Shift + H

无序列表:Ctrl/Command + Shift + U

有序列表:Ctrl/Command + Shift + O

检查列表:Ctrl/Command + Shift + C

插入代码:Ctrl/Command + Shift + K

插入链接:Ctrl/Command + Shift + L

插入图片:Ctrl/Command + Shift + G

查找:Ctrl/Command + F

替换:Ctrl/Command + G

合理的创建标题,有助于目录的生成

直接输入1次#,并按下space后,将生成1级标题。

输入2次#,并按下space后,将生成2级标题。

以此类推,我们支持6级标题。有助于使用TOC语法后生成一个完美的目录。

如何改变文本的样式

强调文本 强调文本

加粗文本 加粗文本

标记文本

删除文本

引用文本

H2O is是液体。

210 运算结果是 1024.

插入链接与图片

链接: link.

图片: ![]()

带尺寸的图片: ![]()

居中的图片: ![]()

居中并且带尺寸的图片: ![]()

当然,我们为了让用户更加便捷,我们增加了图片拖拽功能。

如何插入一段漂亮的代码片

去博客设置页面,选择一款你喜欢的代码片高亮样式,下面展示同样高亮的 代码片.

// An highlighted block

var foo = 'bar';

生成一个适合你的列表

- 项目

- 项目

- 项目

- 项目

- 项目1

- 项目2

- 项目3

- 计划任务

- 完成任务

创建一个表格

一个简单的表格是这么创建的:

| 项目 | Value |

|---|---|

| 电脑 | $1600 |

| 手机 | $12 |

| 导管 | $1 |

设定内容居中、居左、居右

使用:---------:居中

使用:----------居左

使用----------:居右

| 第一列 | 第二列 | 第三列 |

|---|---|---|

| 第一列文本居中 | 第二列文本居右 | 第三列文本居左 |

SmartyPants

SmartyPants将ASCII标点字符转换为“智能”印刷标点HTML实体。例如:

| TYPE | ASCII | HTML |

|---|---|---|

| Single backticks | 'Isn't this fun?' |

‘Isn’t this fun?’ |

| Quotes | "Isn't this fun?" |

“Isn’t this fun?” |

| Dashes | -- is en-dash, --- is em-dash |

– is en-dash, — is em-dash |

创建一个自定义列表

-

Markdown

- Text-to- HTML conversion tool Authors

- John

- Luke

如何创建一个注脚

一个具有注脚的文本。2

注释也是必不可少的

Markdown将文本转换为 HTML。

KaTeX数学公式

您可以使用渲染LaTeX数学表达式 KaTeX:

Gamma公式展示 Γ ( n ) = ( n − 1 ) ! ∀ n ∈ N \Gamma(n) = (n-1)!\quad\forall n\in\mathbb N Γ(n)=(n−1)!∀n∈N 是通过欧拉积分

Γ ( z ) = ∫ 0 ∞ t z − 1 e − t d t . \Gamma(z) = \int_0^\infty t^{z-1}e^{-t}dt\,. Γ(z)=∫0∞tz−1e−tdt.

你可以找到更多关于的信息 LaTeX 数学表达式here.

新的甘特图功能,丰富你的文章

- 关于 甘特图 语法,参考 这儿,

UML 图表

可以使用UML图表进行渲染。 Mermaid. 例如下面产生的一个序列图:

这将产生一个流程图。:

- 关于 Mermaid 语法,参考 这儿,

FLowchart流程图

我们依旧会支持flowchart的流程图:

- 关于 Flowchart流程图 语法,参考 这儿.

导出与导入

导出

如果你想尝试使用此编辑器, 你可以在此篇文章任意编辑。当你完成了一篇文章的写作, 在上方工具栏找到 文章导出 ,生成一个.md文件或者.html文件进行本地保存。

导入

如果你想加载一篇你写过的.md文件,在上方工具栏可以选择导入功能进行对应扩展名的文件导入,

继续你的创作。

开始前的一些相关说明

在整个过程中用到的jdk是jdk1.8.0_162版本,hadoop是hadoop-3.1.3版本,此外该过程仅仅部署了伪分布式,单机版和全分布式最好参考其他资料,因为这里边也没有!!!此外虚拟机安装用的是VMware16和CentOS7

准备工作:

删除linux自带openjdk

-

查看现有的jdk

-

删除命令:共三条,主要还是看你有几个openjdk的东西,关于openjdk的都删掉`

-

rpm -e --nodeps java-1.8.0-openjdk-headless-1.8.0.262.b10-1.el7.x86_64 -

rpm -e --nodeps java-1.7.0-openjdk-headless-1.7.0.262.6.22.2.el7_8.x86_64 -

rpm -e --nodeps java-1.8.0-openjdk-1.8.0.262.b10-1.el7.x86_64 -

再次查看是否成功删除:

-

rpm -qa|grep java -

配置jdk环境变量

-

gedit /etc/profile#在终端输入该命令 -

#在profile文件尾部写入代码:

-

export JAVA_HOME=/usr/java/jdk1.8.0_67#解压jdk文件的绝对路径

export PATH=$JAVA_HOME/bin:$PATH#此行代码无需改动

source /etc/profile#回到终端使用此命令使刚才对profile文件的改动生效

安装hadoop

- 解压和配置

cd /usr/local#在终端输入该行命令,进入local文件夹,每个人可以有不同设置mkdir hadoop#接着上一步创建一个名为hadoop的文件夹,用以存放我们即将解压的hadoop3.1.3压缩文件tar -zxvf /home/litengfei/Desktop/hadoop-3.1.3.tar.gz#接着上一行命令输入此行命令解压压缩文件,这里因为我的压缩文件和当前目录不一致,因此写出了压缩文件的绝对路径cd /usr/local/hadoop#在终端输入该命令,进入存放hadoop-3.1.3文件的目录vim /etc/profile.d/my_env.sh#接着输入该命令,在profile文件顶部写入代码:- `

#HADOOP_HOME

export HADOOP_HOME=/usr/local/hadoop/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

source /etc/profile#回到终端使用此命令使刚才对profile文件的改动生效

- 测试hadoop是否安装成功

hadoop version#终端输入该行命令,出现版本信息,证明安装无误。注意中间无“-”,我也不知道为啥

rm -f /home/litengfei/Desktop/hadoop-3.1.3.tar.gz#安装成功以后就可以在终端运行此命令删除压缩包啦,jdk的压缩包同理删除

## Hadoop和jdk安装无误后就可以开始下一步的准备工作啦

(一)创建存放数据目录

mkdir temp#命令行进入hadoop文件夹后创建名为temp的文件夹用以存放数据目录

cd /usr/local/hadoop/temp#命令行输入

mkdir dfs#命令行输入

ls#命令行输入

mkdir name#命令行输入

ls命令行输入

cd /usr/local/hadoop/temp/dfs#命令行进入dfs文件夹创建存放数据block的目录

mkdir data#命令行输入

(二)修改usr/local/hadoop/hadoop-3.1.3/etc/hadoop文件夹下的core-site.xml文件

#首先,我们修改Nodename所在的主机名为master

hostname#命令行输入查看当前主机名

gedit /etc/sysconfig/network#修改文件内容以达到修改主机名的目的

在文件中写入代码:

NETWORKING=yes

HOSTNAME=master

hostname master#命令行输入命令,使对文件的修改生效

hostname#查看修改后的主机名,验证是否成功修改

gedit /etc/hostname#为彻底改变主机名,请重启虚拟机,再打开该文件将里面内容改为master

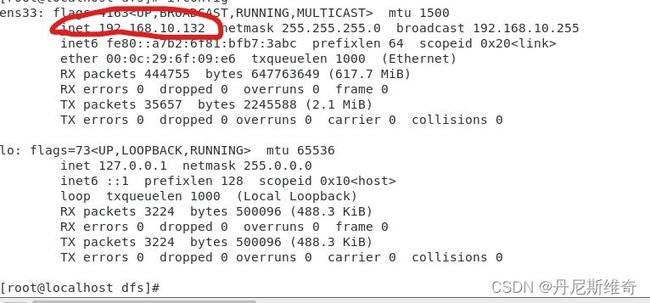

#其次查看自己的ip地址为后面工作做准备

ifconfig#命令行输入查看自己的ip地址

#########可以打开core-site.xml文件写入用于配置的代码啦###########

gedit /usr/local/hadoop/hadoop-3.1.3/etc/hadoop/core-site.xml#写文件命令

在图上位置写下代码

<property>

<!-- 指定hadoop运行时产生文件的存储路径-->

<name>hadoop.tmp.dir</name>

<value>/opt/module/temp</value>#这个路径要与你自己的一致,建议前后配置同我一样,就可以无脑复制啦,不一样的要注意

<description>A base for other temporary directories.</description>

</property>

<property>

<!--hdfs namenode的通信地址-->

<name>fs.defaultFS</name>

<value>hdfs://192.168.119.129:9000</value>#这里要用到自己的ip地址,端口号用默认的即可

</property>

<property>

<name>hadoop.http.staticuser.user</name>

<value>root</value>

注:这个我忘了截图了,不过和下边的位置一样

(三)修改/usr/local/hadoop/hadoop-3.1.3/etc/hadoop文件夹下的hdfs-site.xml配置文件

gedit /usr/local/hadoop/hadoop-3.1.3/etc/hadoop/hdfs-site.xml#命令行写配置文件

将以下代码放入图上位置:

<property>

<!--指定HDFS储存数据的副本数目,默认情况下为3份-->

<name>dfs.replication</name>

<value>1</value>#因为搭的是伪分布式,所以值为1,全分布式这里会有不同

</property>

<property>

<!--name node 存放 name table 的目录-->

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>#要和自己设置的一致

</property>

<property>

<!--data node 存放数据 block 的目录-->

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>#这里的值要与自己前边设置的一致,还是建议和我一样,无脑复制yyds

</property>

<property>

<!--设置监控页面的端口及地址-->

<name>dfs.http.address</name>

<value>0.0.0.0:50070</value>#这里的值为默认的,不用做改动

</property>

(四)修改usr/local/hadoop/hadoop-3.1.3/etc/hadoop文件夹下的mapred-site.xml配置文件

gedit /usr/local/hadoop/hadoop-3.1.3/etc/hadoop/mapred-site.xml#命令行输入,写配置文件

将以下代码输入到图上位置

<property>

<!-- 指定mapreduce 编程模型运行在yarn上 -->

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

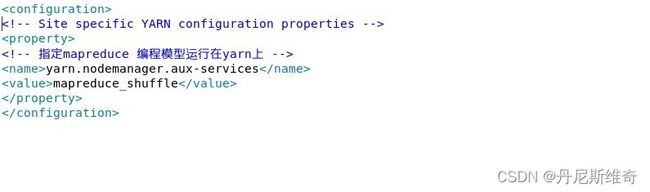

(五)修改usr/local/hadoop/hadoop-3.1.3/etc/hadoop文件夹下的yarn-site.xml配置文件

gedit /usr/local/hadoop/hadoop-3.1.3/etc/hadoop/yarn-site.xml#命令行输入,写配置文件

将以下代码写入图上位置:

######以下代码直接复制上去即可无个体差异性######

<!-- Site specific YARN configuration properties -->

<property>

<!-- 指定mapreduce 编程模型运行在yarn上 -->

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

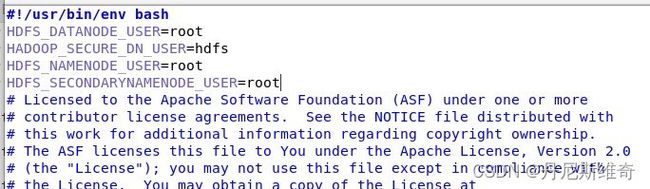

(六)编辑开始和关闭脚本

gedit /usr/local/hadoop/hadoop-3.1.3/sbin/start-dfs.sh#命令行输入

将以下代码复制到图上位置:

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

gedit /usr/local/hadoop/hadoop-3.1.3/sbin/stop-dfs.sh#命令行输入

将以下代码复制到图上位置:

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

gedit /usr/local/hadoop/hadoop-3.1.3/sbin/start-yarn.sh#命令行输入

将以下代码复制到图上位置:

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

gedit /usr/local/hadoop/hadoop-3.1.3/sbin/stop-yarn.sh#命令行输入

将以下代码复制到图上位置:

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

(七)格式化namenode,格式化一次即可

cd /usr/local/hadoop/hadoop-3.1.3/etc/hadoop#命令行输入,切换至该目录下

hadoop namenode -format#命令行输入格式化命令

注:这个过程需要一会,不用担心,耐心等待

(八)启动hadoop#啊啊啊,太激动了,终于可以启动了!!!

start-all.sh#命令行输入

jps#命令行输入,检查是否启动。图示都要出现,少一个都不行

最后放上我的参考材料,嗯…小白一个,跟这这位作者的步骤一步一步搭的,给出了一些细节性的说明。中间也出现了许多小问题,比如虚拟机不行啦,不会挂载U盘啦…,一点一点摸索的,整个过程成长不少,小伙伴们坚持就是胜利!!!必拿下!

链接的原作若看到,介意可联系我删除,也可以一起交流学习鸭

参考资料:http://t.csdn.cn/xCZ2b

mermaid语法说明 ↩︎

注脚的解释 ↩︎