序列模型(自回归模型,马尔可夫模型,因果关系)

李沐老师《动手学深度学习 PyTorch版》课程,小破站也有视频51 序列模型【动手学深度学习v2】_哔哩哔哩_bilibili

主要参考8.1. 序列模型 — 动手学深度学习 2.0.0 documentation

目录

1.基本原理

1.1自回归模型

1.2马尔可夫模型

1.3因果关系

2.训练

3.预测

4.总结

1.基本原理

自然语言处理的输入输出基本上都是序列,序列问题是自然语言处理最本质的问题。

序列模型:就是输入输出均为序列数据的模型,序列模型将输入序列数据转换为目标序列数据。

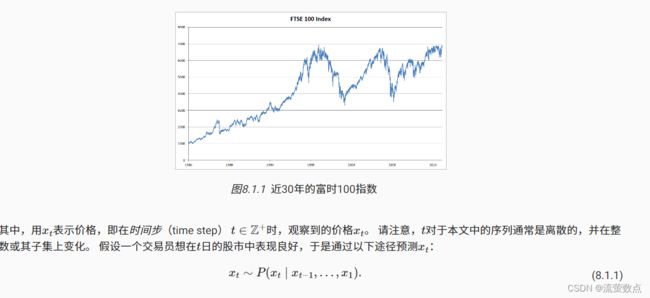

我们需要统计工具和新的深层神经网络结构来处理序列数据。为了简单起见,我们以下图所示的股票价格(富时100指数)为例。

李沐老师总结:

- 时序模型中,当前数据与之前的观察数据是相关的

- 自回归模型使用自身过去数据来预测未来

- 马尔科夫模型假设当前数据只根最近少数数据相关

- 潜变量模型(RNN等)使用潜变量来概括历史信息

1.1自回归模型

为了实现这个预测,交易员可以使用回归模型, 例如在 3.3节中训练的模型。 仅有一个主要问题:输入数据的数量, 输入xt−1,…,x1本身因t而异。 也就是说,输入数据的数量这个数字将会随着我们遇到的数据量的增加而增加, 因此需要一个近似方法来使这个计算变得容易处理。 本章后面的大部分内容将围绕着如何有效估计 P(xt∣xt−1,…,x1)展开。 简单地说,它归结为以下两种策略。

第一种策略,假设在现实情况下相当长的序列 xt−1,…,x1可能是不必要的, 因此我们只需要满足某个长度为τ的时间跨度, 即使用观测序列xt−1,…,xt−τ。 当下获得的最直接的好处就是参数的数量总是不变的, 至少在t>τ时如此,这就使我们能够训练一个上面提及的深度网络。 这种模型被称为自回归模型(autoregressive models), 因为它们是对自己执行回归。

第二种策略,如 图8.1.2所示, 是保留一些对过去观测的总结ht, 并且同时更新预测x^t和总结ht。 这就产生了基于x^t=P(xt∣ht)估计xt, 以及公式ht=g(ht−1,xt−1)更新的模型。 由于ht从未被观测到,这类模型也被称为 隐变量自回归模型(latent autoregressive models)。

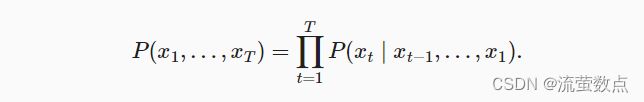

这两种情况都有一个显而易见的问题:如何生成训练数据? 一个经典方法是使用历史观测来预测下一个未来观测。 显然,我们并不指望时间会停滞不前。 然而,一个常见的假设是虽然特定值xt可能会改变, 但是序列本身的动力学不会改变。 这样的假设是合理的,因为新的动力学一定受新的数据影响, 而我们不可能用目前所掌握的数据来预测新的动力学。 统计学家称不变的动力学为静止的(stationary)。 因此,整个序列的估计值都将通过以下的方式获得:

注意,如果我们处理的是离散的对象(如单词), 而不是连续的数字,则上述的考虑仍然有效。 唯一的差别是,对于离散的对象, 我们需要使用分类器而不是回归模型来估计P(xt∣xt−1,…,x1)。

1.2马尔可夫模型

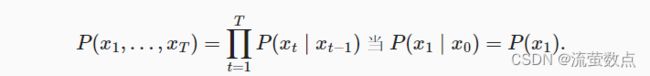

回想一下,在自回归模型的近似法中, 我们使用xt−1,…,xt−τ 而不是xt−1,…,x1来估计xt。 只要这种是近似精确的,我们就说序列满足马尔可夫条件(Markov condition)。 特别是,如果τ=1,得到一个 一阶马尔可夫模型(first-order Markov model), P(x)由下式给出:

当假设xt仅是离散值时,这样的模型特别棒, 因为在这种情况下,使用动态规划可以沿着马尔可夫链精确地计算结果。 例如,我们可以高效地计算P(xt+1∣xt−1):

利用这一事实,我们只需要考虑过去观察中的一个非常短的历史: P(xt+1∣xt,xt−1)=P(xt+1∣xt)。

1.3因果关系

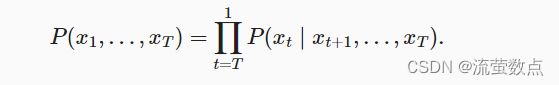

原则上,将P(x1,…,xT)倒序展开也没什么问题。 毕竟,基于条件概率公式,我们总是可以写出:

事实上,如果基于一个马尔可夫模型, 我们还可以得到一个反向的条件概率分布。 然而,在许多情况下,数据存在一个自然的方向,即在时间上是前进的。 很明显,未来的事件不能影响过去。 因此,如果我们改变xt,可能会影响未来发生的事情xt+1,但不能反过来。 也就是说,如果我们改变xt,基于过去事件得到的分布不会改变。 因此,解释P(xt+1∣xt)应该比解释P(xt∣xt+1)更容易。 例如,在某些情况下,对于某些可加性噪声ϵ, 显然我们可以找到xt+1=f(xt)+ϵ, 而反之则不行 (Hoyer et al., 2009)。 而这个向前推进的方向恰好也是我们通常感兴趣的方向。

2.训练

首先,我们生成一些数据:使用正弦函数和一些可加性噪声来生成序列数据, 时间步为1,2,…,1000。

pip install mxnet==1.7.0.post1pip install d2l==0.17.6%matplotlib inline

from mxnet import autograd, gluon, init, np, npx

from mxnet.gluon import nn

from d2l import mxnet as d2l

npx.set_np()

T = 1000 # 总共产生1000个点

time = np.arange(1, T + 1, dtype=np.float32)

x = np.sin(0.01 * time) + np.random.normal(0, 0.2, (T,))

d2l.plot(time, [x], 'time', 'x', xlim=[1, 1000], figsize=(6, 3))接下来,我们将这个序列转换为模型的特征-标签(feature-label)对。 基于嵌入维度τ,我们将数据映射为数据对yt=xt 和xt=[xt−τ,…,xt−1]。 这比我们提供的数据样本少了τ个, 因为我们没有足够的历史记录来描述前τ个数据样本。 一个简单的解决办法是:如果拥有足够长的序列就丢弃这几项; 另一个方法是用零填充序列。 在这里,我们仅使用前600个“特征-标签”对进行训练。

tau = 4

features = np.zeros((T - tau, tau))

for i in range(tau):

features[:, i] = x[i: T - tau + i]

labels = x[tau:].reshape((-1, 1))

batch_size, n_train = 16, 600

# 只有前n_train个样本用于训练

train_iter = d2l.load_array((features[:n_train], labels[:n_train]),

batch_size, is_train=True)在这里,我们使用一个相当简单的架构训练模型: 一个拥有两个全连接层的多层感知机,ReLU激活函数和平方损失。

# 一个简单的多层感知机

def get_net():

net = nn.Sequential()

net.add(nn.Dense(10, activation='relu'),

nn.Dense(1))

net.initialize(init.Xavier())

return net

# 平方损失

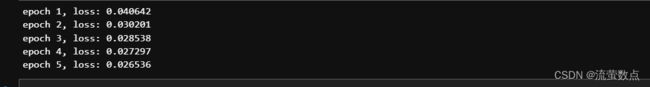

loss = gluon.loss.L2Loss()现在,准备训练模型了。

3.预测

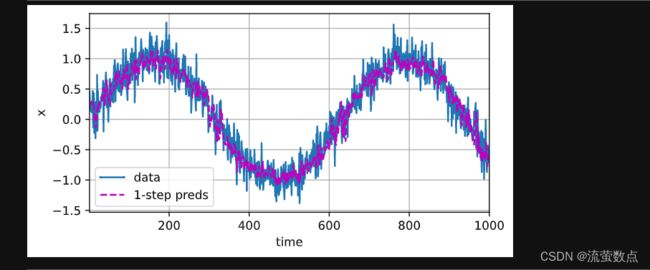

由于训练损失很小,因此我们期望模型能有很好的工作效果。 让我们看看这在实践中意味着什么。 首先是检查模型预测下一个时间步的能力, 也就是单步预测(one-step-ahead prediction)。

onestep_preds = net(features)

d2l.plot([time, time[tau:]],

[x.asnumpy(), onestep_preds.asnumpy()], 'time',

'x', legend=['data', '1-step preds'], xlim=[1, 1000],

figsize=(6, 3))正如我们所料,单步预测效果不错。 即使这些预测的时间步超过了600+4(n_train + tau), 其结果看起来仍然是可信的。 然而有一个小问题:如果数据观察序列的时间步只到604, 我们需要一步一步地向前迈进:

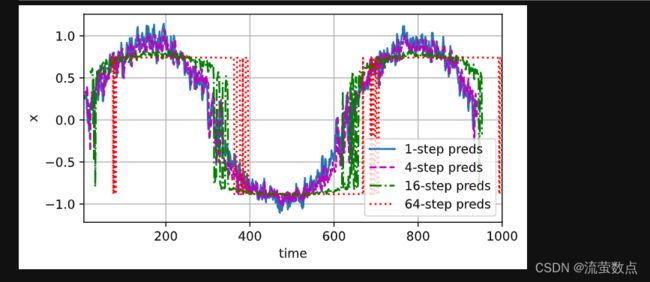

通常,对于直到xt的观测序列,其在时间步t+k处的预测输出x^t+k 称为k步预测(k-step-ahead-prediction)。 由于我们的观察已经到了x604,它的k步预测是x^604+k。 换句话说,我们必须使用我们自己的预测(而不是原始数据)来进行多步预测。 让我们看看效果如何。

multistep_preds = np.zeros(T)

multistep_preds[: n_train + tau] = x[: n_train + tau]

for i in range(n_train + tau, T):

multistep_preds[i] = net(

multistep_preds[i - tau:i].reshape((1, -1)))

d2l.plot([time, time[tau:], time[n_train + tau:]],

[x.asnumpy(), onestep_preds.asnumpy(),

multistep_preds[n_train + tau:].asnumpy()], 'time',

'x', legend=['data', '1-step preds', 'multistep preds'],

xlim=[1, 1000], figsize=(6, 3))如上面的例子所示,绿线的预测显然并不理想。 经过几个预测步骤之后,预测的结果很快就会衰减到一个常数。 为什么这个算法效果这么差呢?事实是由于错误的累积: 假设在步骤1之后,我们积累了一些错误ϵ1=ϵ¯。 于是,步骤2的输入被扰动了ϵ1, 结果积累的误差是依照次序的ϵ2=ϵ¯+cϵ1, 其中c为某个常数,后面的预测误差依此类推。 因此误差可能会相当快地偏离真实的观测结果。 例如,未来24小时的天气预报往往相当准确, 但超过这一点,精度就会迅速下降。 我们将在本章及后续章节中讨论如何改进这一点。

基于k=1,4,16,64,通过对整个序列预测的计算, 让我们更仔细地看一下k步预测的困难。

max_steps = 64

features = np.zeros((T - tau - max_steps + 1, tau + max_steps))

# 列i(i=tau)是来自(i-tau+1)步的预测,其时间步从(i)到(i+T-tau-max_steps+1)

for i in range(tau, tau + max_steps):

features[:, i] = net(features[:, i - tau:i]).reshape(-1)

steps = (1, 4, 16, 64)

d2l.plot([time[tau + i - 1: T - max_steps + i] for i in steps],

[features[:, tau + i - 1].asnumpy() for i in steps], 'time', 'x',

legend=[f'{i}-step preds' for i in steps], xlim=[5, 1000],

figsize=(6, 3)) 以上例子清楚地说明了当我们试图预测更远的未来时,预测的质量是如何变化的。 虽然“4步预测”看起来仍然不错,但超过这个跨度的任何预测几乎都是无用的。

4.总结

-

内插法(在现有观测值之间进行估计)和外推法(对超出已知观测范围进行预测)在实践的难度上差别很大。因此,对于所拥有的序列数据,在训练时始终要尊重其时间顺序,即最好不要基于未来的数据进行训练。

-

序列模型的估计需要专门的统计工具,两种较流行的选择是自回归模型和隐变量自回归模型。

-

对于时间是向前推进的因果模型,正向估计通常比反向估计更容易。

-

对于直到时间步t的观测序列,其在时间步t+k的预测输出是“k步预测”。随着我们对预测时间k值的增加,会造成误差的快速累积和预测质量的极速下降。