【大数据环境搭建(四)】在Centos7上搭建Hive集群(Mysql远程模式)

【大数据环境搭建(四)】在Centos7上搭建Hive集群(Mysql远程模式)

集群配置

使用三节点,master(客户端)、slave1(服务器)、slave2(元数据),

jdk1.8.0_171

zookeeper-3.4.10

hadoop-2.7.3

hive-2.1.1

mysql5.7

一、slave2上安装Mysql

下载wget:

yum -y install wget

1、配置下载源

下载依赖包:

wget https://dev.mysql.com/get/mysql57-community-release-el7-9.noarch.rpm

安装依赖包:

rpm -ivh mysql57-community-release-el7-9.noarch.rpm

2、安装Mysql

yum -y install mysql-server

3、启动服务

开启服务:

systemctl start mysqld

开机自启:

systemctl enable mysqld

4、修改Mysql密码

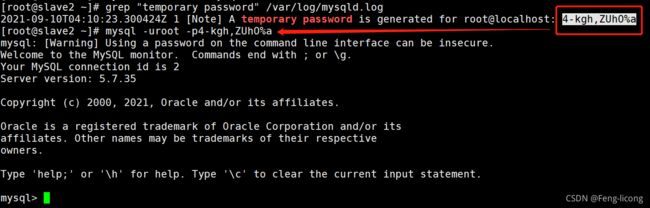

获取初密码:

grep "temporary password" /var/log/mysqld.log

登陆MySQL:

mysql -uroot -p(密码)

set global validate_password_policy=0;

设置密码长度为4:

set global validate_password_length=4;

修改本地密码为123456:

alter user 'root'@'localhost' identified by '123456';

退出:

\q

5、设置远程登录

以新密码登陆MySQL:

mysql -uroot -p123456

创建用户:

create user 'root'@'%' identified by '123456';

允许远程连接:

grant all privileges on *.* to 'root'@'%' with grant option;

刷新权限:

flush privileges;

退出:

\q

二、安装hive(master)

创建工作路径

mkdir /usr/hive

解压hive

tar -zxvf apache-hive-2.1.1-bin.tar.gz -C /usr/hive

分发hive

scp -r /usr/hive root@slave1:/usr/

配置环境变量

vim /etc/profile

在文件末尾添加:

export HIVE_HOME=/usr/hive/apache-hive-2.1.1-bin

export PATH=$PATH:$HIVE_HOME/bin

保存退出

分发/etc/profile文件

scp -r /etc/profile root@slave1:/etc/

生效环境变量(master、slave1)

source /etc/profile

三、slave1上配置hive为服务器端

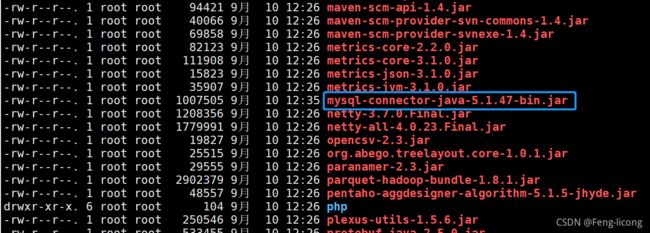

下载Mysql依赖包

进入hive的lib目录:

cd /usr/hive/apache-hive-2.1.1-bin/lib

从网上下载mysql-connector-java-5.1.47-bin.jar包后上传至此目录。

修改配置文件

进入conf目录:

cd /usr/hive/apache-hive-2.1.1-bin/conf

修改hive-env.sh文件:

cp hive-env.sh.template hive-env.sh

vim hive-env.sh

HADOOP_HOME=/usr/hadoop/hadoop-2.7.3

vim hive-site.xml

<configuration>

<property>

<name>hive.metastore.warehouse.dirname>

<value>/user/hive_remote/warehousevalue>

property>

<property>

<name>javax.jdo.option.ConnectionURLname>

<value>jdbc:mysql://slave2:3306/hive?createDatabaseIfNotExist=truevalue>

property>

<property>

<name>javax.jdo.option.ConnectionDriverNamename>

<value>com.mysql.jdbc.Drivervalue>

property>

<property>

<name>javax.jdo.option.ConnectionUserNamename>

<value>rootvalue>

property>

<property>

<name>javax.jdo.option.ConnectionPasswordname>

<value>123456value>

property>

<property>

<name>hive.metastore.schema.verificationname>

<value>falsevalue>

property>

<property>

<name>datanucleus.schema.autoCreateAllname>

<value>truevalue>

property>

configuration>

四、master上配置hive为客户端

更改Hadoop中jline的版本

cp /usr/hive/apache-hive-2.1.1-bin/lib/jline-2.12.jar /usr/hadoop/hadoop-2.7.3/share/hadoop/yarn/lib/

修改配置文件

进入conf目录:

cd /usr/hive/apache-hive-2.1.1-bin/conf

修改hive-env.sh文件:

cp hive-env.sh.template hive-env.sh

vim hive-env.sh

HADOOP_HOME=/usr/hadoop/hadoop-2.7.3

修改hive-site.xml文件:

vim hive-site.xml

<configuration>

<property>

<name>hive.metastore.warehouse.dirname>

<value>/user/hive_remote/warehousevalue>

property>

<property>

<name>hive.metastore.localname>

<value>falsevalue>

property>

<property>

<name>hive.metastore.urisname>

<value>thrift://slave1:9083value>

property>

configuration>

五、启动hive

启动Hadoop集群(master)

start-all.sh

启动hive server服务(slave1)

hive --service metastore

启动hive client(master)

hive

六、测试hive

查看所有数据库;

show databases;

创建hive_test数据库

create database hive_test;

七、关闭集群

关闭hive

快捷键:Ctrl + z (在master、slave1执行)

关闭hadoop

stop-all.sh(在master执行)

关闭虚拟机

shutdown -h now(三台机器都执行)

总结

需要注意的是,

1、本教程的hive集群使用的是远程连接模式,并使MySQL进行元数据管理,所以各个节点的配置均有不同,搭建时应多加注意。

2、启动hive之前应先启动hadoop。

大数据环境搭建系列文章链接

【大数据环境搭建(一)】VMware虚拟机安装Centos7详细教程:

https://blog.csdn.net/weixin_45092204/article/details/118885153

【大数据环境搭建(二)】使用Xshell SSH连接虚拟机详细教程:

https://blog.csdn.net/weixin_45092204/article/details/118932663

【大数据环境搭建(三)】在Centos7上搭建Hadoop集群(完全分布式)

https://blog.csdn.net/weixin_45092204/article/details/119085553

【大数据环境搭建(四)】在Centos7上搭建Hive集群(Mysql远程模式)

https://blog.csdn.net/weixin_45092204/article/details/120218392

后续

此教程是大数据环境的第四篇文章,后续还会发布大数据各种组件的安装及配置教程,以及在安装过程中需要注意的问题。

刚刚要入手大数据的同学可以持续关注我,安装过程中遇到什么问题的同学也可以评论区留言。

要是本教程对你有帮助的话,希望大家能三连 三连 三连!

最后,祝各位同学学习顺利~