使用 XAI 克服 AI、ML 限制

据全球媒体公司福布斯报道,人工智能 (AI) 和机器学习 (ML) 等变革性技术的创新和发展将在 2023 年继续快速发展。

机器学习是人工智能的一种应用,是数据科学领域的关键组成部分。它是使用数学数据和算法帮助计算机在没有人类直接指导的情况下进行学习的过程。更具体地说,机器学习旨在模仿人类学习和做出关键决策的方式。

通过使用统计方法,训练 ML 算法进行分类和预测,这可能随后会推动决策过程,其明显目标是取得积极的结果。

ML 被视为使用和优化越来越多的可用于公司和私营部门、军事、先进医学和许多其他领域的分析和决策支持的数据的重要工具。

对于 ML 算法,就像人类经常遇到的情况一样,在特定领域或努力中的重复和经验会随着时间的推移导致准确性、熟练程度和可预测性的系统性改进。

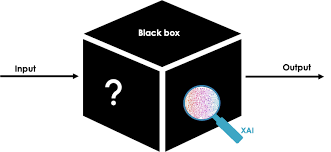

然而,现在公认的是,许多 ML 算法的负面影响之一是所谓的“黑匣子”性质。人们并不总是清楚机器学习算法如何处理现实世界的数据,以及如何——甚至为什么——做出某些决定。

ML 算法极难解释——即使是用科学术语——而且 AI 专家通常无法完全理解 ML 模型。

因此,ML 算法极难解释——即使是用科学术语——而且 AI 专家通常无法完全理解 ML 模型。因此,许多用户发现他们无法完全信任 ML 派生的预测和决策。

在此背景下,预计将在 2023 年取得进展的一项关键创新是一套工具和框架,旨在帮助研究人员、开发人员和用户更好地理解 ML 模型的复杂内部工作原理。这项创新被称为Explainable AI (XAI)。

该术语由美国国防高级研究计划局 (DARPA) 创造,作为一项旨在克服其认为是传统人工智能缺点的研究计划。

现在被视为一项可行的技术,XAI 被比作飞机的副驾驶员,其任务是协助飞行员完成关键的操作检查清单,并作为额外的一双眼睛和耳朵,提醒飞行员任何操作异常。

就像飞行员和副驾驶的类比一样,人工智能技术与人类之间日益密切的相互作用推动了对 XAI 的需求,以及对“可解释性”的需求。

例如,在商业世界中,当必须做出影响新企业方向、新产品设计或地点变更的重要决策时,通常很清楚谁拥有最终决定权并签字同意项目。

如果在线下出现问题,可以询问负责人,并获得有关决定背后的原因及其动机的解释。

另一方面,当企业决策是由基于 ML 算法的传统人工智能系统做出时,错误决策的责任往往不太明确。

根据多产作家和公众演说家 Jonathan Johnson 的说法,可解释性在 ML 领域变得非常重要,因为它通常并不明显。

“可解释性是 [ML 模型] 构建过程中的一个额外步骤,”他说。“就像开车时系好安全带;汽车没有必要运行,但在发生碰撞时提供保险。”

有鉴于此,XAI 在其副驾驶角色中的优势之一是它能够展望未来,并根据应用 ML 算法的传统 AI 系统做出的决策预测结果的准确性和透明度。

另一个好处是 XAI 能够对可能影响大型企业网络的运营效率、安全性或熟练程度的问题提供深入的看法和分析,从而最大限度地减少通过手动方法获得类似结果所需的时间。

对于许多组织而言,XAI 在将 ML 模型投入生产时对于建立信任和信心至关重要,因为它能够帮助人们更好地检查、理解和验证 ML 算法的行为。这是通过“拉开帷幕”来实现的,以便对每项决策背后的复杂数据进行有价值的评估。

作为奖励,XAI 支持者声称该技术擅长调试 ML 模型,目标是在短期内显着改进甚至合理化它们的性能。

这是必要的,因为众所周知,ML 系统会学习不需要的技巧,这些技巧可以在满足明确的预编程目标方面发挥最佳作用,但不会反映其人类系统设计者的隐含需求。

例如,据报道,一个负责图像识别的 AI/ML 系统学会了通过寻找非法捷径来“作弊”以加快进程。

值得庆幸的是,今天 XAI 能够通过使用各种方法来识别此类陷阱,例如特征重要性分数、反事实解释和有影响力的训练数据,而组织和用户通常对这些方法知之甚少。

原文章链接:https://www.itweb.co.za/content/Gb3Bw7WamDbq2k6V