ADTrack: Target-Aware Dual Filter Learning for Real-Time Anti-Dark UAV Tracking

文章目录

- 摘要

- Introduction

- Related Work

- Method

- Experiment

- CONCLUSION

摘要

基于先验相关滤波(CF)的无人机(UAV)跟踪方法主要集中在白天的跟踪上。然而,当夜幕降临时,跟踪器会遇到更加严酷的场景,这很容易导致跟踪失败。为此,本文提出了一种具有抗暗功能的新型跟踪器(ADTrack)。该方法将一种高效的微光图像增强器集成到基于CF的跟踪器中。此外,利用图像光照变化同时生成目标感知掩模。该目标感知掩模可用于联合训练聚焦于目标的滤波器,该聚焦滤波器协助上下文滤波器进行鲁棒跟踪。具体来说,ADTrack采用双重回归,其中上下文过滤器和目标聚焦过滤器相互制约,进行双重过滤器学习。在典型暗景基准上进行了详尽的实验,包括来自权威基准的37个典型夜景序列,即UAVDark和我们新构建的基准UAVDark70。结果表明,ADTrack的跟踪性能优于其它先进的跟踪器,在单CPU上实现了34帧/s的实时速度,极大地扩展了无人机对夜景的鲁棒跟踪。

Introduction

视觉目标跟踪广泛应用于机器人和自动化领域,其目的是预测目标的位置和大小。特别是,在无人机(UAV)上应用跟踪方法促进了基于无人机的广泛应用,例如,防撞[1]、自主空中操纵操作[2]和自主输电线路检查[3]。

目前,适用于部署视觉跟踪器的场景仅限于白天,此时光照条件良好,且目标易于识别,具有典型的几何和辐射特性。随着夜幕降临,摄像机无法获取足够的信息来完成图像的细节,给跟踪器带来了巨大的挑战,也给无人机的通用性和可用性带来了巨大的限制。

与一般的跟踪场景相比,无人机在黑暗环境中的视觉跟踪面临着以下更为严峻的条件:a)目标在黑暗环境中容易融合,使其外部轮廓不清晰;b) 物体的颜色特征通常是无效的,最终导致其内部特征不显著;c) 随机噪声经常出现在夜间拍摄的图像上,严重干扰了跟踪器;d) 无人机有限的计算和存储资源为实时跟踪设置了障碍。由于上述具有挑战性的跟踪条件,目前最先进的(SOTA)方法[4]-[9]无法达到无人机在黑暗中跟踪的要求。

以往的工作很少涉及黑暗环境下的鲁棒跟踪,这对于拓宽无人机的应用范围和使用寿命至关重要。一种直接的策略是将SOTA微光增强方法[10]–[12]与跟踪器[4]、[6]、[8]相结合,即对增强图像进行跟踪。即使是有效的,这种简单的方式也有明显的缺点:a)大多数SOTA微光增强方法耗时,从而给整个算法增加了沉重的负担;b) 仅仅利用预处理图像进行跟踪并不能充分挖掘增强子的潜力;c) 增强图像通常有额外的噪声,干扰跟踪器。

与一般的跟踪场景相比,无人机在黑暗环境中的视觉跟踪面临着以下更为严峻的条件:a)目标在黑暗环境中容易融合,使其外部轮廓不清晰;b) 物体的颜色特征通常是无效的,最终导致其内部特征不显著;c) 随机噪声经常出现在夜间拍摄的图像上,严重干扰了跟踪器;d) 无人机有限的计算和存储资源为实时跟踪设置了障碍。由于上述具有挑战性的跟踪条件,目前最先进的(SOTA)方法[4]-[9]无法达到无人机在黑暗中跟踪的要求。

以往的工作很少涉及黑暗环境下的鲁棒跟踪,这对于拓宽无人机的应用范围和使用寿命至关重要。一种直接的策略是将SOTA微光增强方法[10]–[12]与跟踪器[4]、[6]、[8]相结合,即对增强图像进行跟踪。即使是有效的,这种简单的方式也有明显的缺点:a)大多数SOTA微光增强方法耗时,从而给整个算法增加了沉重的负担;b) 仅仅利用预处理图像进行跟踪并不能充分挖掘增强子的潜力;c) 增强图像通常有额外的噪声,干扰跟踪器。

为此,本文提出了一种具有抗暗功能的新型跟踪器(ADTrack),实现了无人机在夜间的实时跟踪和鲁棒跟踪。具体来说,ADTrack将高速微光图像增强算法嵌入到一个有效的基于CF的跟踪器框架中。令人兴奋的是,可以探索图像增强算法,进一步根据图像的光照信息生成目标感知掩模。ADTrack提出了一种双重回归算法,在训练过程中,上下文过滤器和目标聚焦过滤器相互制约,而在检测阶段,双重过滤器相互补充,实现更精确的定位。此外,该掩模还很好地滤除了增强器带来的噪声。因此,所提出的ADTrack在保证实时跟踪速度的前提下,能够在夜间保持良好的跟踪性能。图1显示了基于CF的基线跟踪器[8]和我们提出的ADTrack在黑暗场景中的性能比较。

此外,据我们所知,目前还不存在暗跟踪基准。因此,这项工作提出了一个开创性的无人机暗跟踪基准(UAVDark70),包括70个视频与各种对象。所有高清视频都是商业无人机在夜间拍摄的。这项工作的贡献1可以概括为:

•本文提出了一种新的抗暗跟踪器,它将图像增强方法的第一阶段结合到CF结构中,用于夜间无人机的实时跟踪。

•这项工作利用图像照明方差信息获得创新和有效的掩模,使双回归双滤波器学习和滤除噪声,使基于CF的跟踪器达到一个新的水平。

•在新构建的UAVDark70和UAVDark上进行了大量实验,以证明ADTrack在黑暗中的鲁棒性和效率。

Related Work

A.微光增强方法

微光图像增强算法一般可分为两类。第一种类型,如[10],[11],旨在离线训练一个具有大量数据对的深层神经网络。这些方法的计算量太大,无法集成到无人机实时跟踪器中。另一种是基于retinex理论[13],没有部署大规模的离线训练[12],[14],它探索从整个图像中分离出来的光照和反射率来进行自适应操作。实验证明,文[14]中提出的全局自适应输出在弱光增强方面是有效的,适合于无人机跟踪算法的集成。此外,在本文中,还可以进一步部署全局自适应输出来生成目标感知掩码,以提高鲁棒性。

B.基于CF的跟踪方法

在各种跟踪方法中,基于CF的跟踪器[15]-[17]的流行主要依赖于:a)其在Fourier域的快速元素级积,b)在线训练的滤波器,其在对象外观发生突变时具有良好的自适应性。基于CF的跟踪器由于具有很高的鲁棒性、适应性和跟踪效率,近年来在视觉跟踪领域得到了蓬勃的发展[8]、[15]-[19]。此外,基于CF的跟踪器由于其效率[4]、[20]–[23],在单CPU平台上的实时处理速度至关重要,因此被证明是无人机跟踪的有希望的选择。

具体来说,D。SBolme等人[15]提出了一种研讨会MOSSE方法作为最早的基于CF的跟踪器。JFHen-riques等人[16]引入了核函数和Tikhonov正则化项,用于更稳健的基于CF的跟踪。HK

Galoogahi等人[8]在滤波器训练过程中集成了裁剪矩阵,并使用交替方向乘子法(ADMM)进行优化,使跟踪器能够感知真实的背景信息。针对更具挑战性的无人机跟踪问题,[4]提出了更具自适应性和鲁棒性的自动时空正则化跟踪方法。而基于SOTA-CF的跟踪器通常在白天表现良好,忽略了在黑暗中的鲁棒跟踪。

C基于目标感知的CF跟踪

目标感知掩模的目的是突出目标区域内的重要部分,进行滤波训练。在[17]中,M。Danelljan引入了一种固定的空间惩罚,将滤波器的注意力集中在粗集上学习提取样本的中心区域。A.Lukezic等人[24]提出了一种基于贝叶斯规则的自适应空间可靠性掩模。最近,C。Fu等人[20]采用了一种有效的显著性检测算法来生成有效的掩模。

以往工作的一个巨大缺点是,当产生一个无效或不可靠的掩模时,滤波器中的错误区域会保持较高的权值,导致鲁棒性较差甚至跟踪失败。此外,文献[20]、[24]中所述的在黑暗中拍摄的图像通常不具备生成掩模的足够信息。为此,除了前面的工作外,ADTrack还利用由光照图生成的掩模来训练一个双目标聚焦滤波器来抑制原背景滤波器,具有更强的鲁棒性。

Method

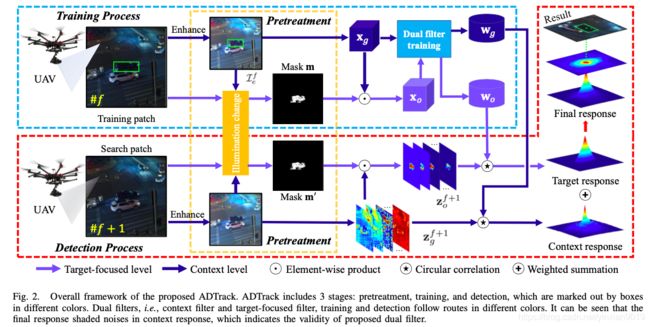

The pipeline of ADTrack consists of three progressive stages: cropped patch pretreatment, dual filter training and weighted response generation. As shown in Fig. 2, when the UAV camera captures the f-th frame in the dark, ADTrack firstly implements image pretreatment to achieve image en- hancement and mask generation. Then, dual filters are jointly trained by focusing on both context and target appearance. As next frame comes, the trained filters generate dual response maps which are fused to obtain the final response for target localization.

ADTrack的流水线由三个阶段组成:裁剪块预处理、双滤波器训练和加权响应生成。如图2所示,当无人机相机在黑暗中拍摄第f帧时,ADTrack首先进行图像预处理,实现图像增强和掩模生成。然后,通过关注上下文和目标外观,联合训练双过滤器。随着下一帧的到来,训练后的滤波器生成双响应映射,融合后得到最终的目标定位响应。

图2.拟建ADTrack的总体框架。ADTrack包括3个阶段:预处理、训练和检测,用不同颜色的方框标出。双过滤器,即上下文过滤器和目标聚焦过滤器,训练和检测遵循不同颜色的路径。可以看出,最终的响应掩盖了上下文响应中的噪声,这表明了所提出的对偶滤波器的有效性。

Target-focused level \

Context level

Element-wise product

Circular correlation

Weighted summation

目标聚焦级别

上下文级别

要素产品

循环相关

加权求和

A.预处理阶段

ADTrack作为一种源于人类前端视觉感知系统的仿生技术,在文献[14]中首次引入增强器来增强微光图像。

当一个弱光图像RGB I∈ 输入Rw×h×3,首先计算像素级世界照明值LW(x,y,I)为:

其中Ψm(I(x,y))表示通道m中位置(x,y)处图像I的像素值,例如ΨR(I(x,y))表示红色通道中的值。信道权重参数αR,αG,αB满足αR+αG+αB=1。然后,对数平均亮度L̃W(I)如[25]所示:

其中δ是一个小值,以避免零值。最后,全局适应因子Lg(x,y,I)的定义如[14]所示:

其中LWmax(I)=max(LW(x,y,I))。计算出的因子可以参考改变每个像素的三个强度通道中的像素值来实现图像增强:

其中Ie表示基于原始I的增强图像。令我们兴奋的是,该算法可以用来生成一个目标聚焦掩模。通过简单的偏差,增强后的照度变化Θ(I)可以写成:

因为LW(x,y,I)∈ [0,1],ΘL(I)的值明显随原始照明而变化。由于不同物体的反射率不同,在一幅图像中,在相同的光照条件下,不同物体的光照变化ΘL(I)的变化更大。因此,借助于等式(5),像素类可以被指示为目标或上下文。具体而言,计算ΘL中心区域的平均值μ和标准偏差σ。根据统计学中的三西格玛标准,μ±3σ范围内的像素被视为目标,而其他像素则是背景。然后,生成二值掩模mr,其中一个掩模mr被填充到与分割目标相关的像素中,而另一个掩模mr被填充到零。最终,通过m=mr得到期望的掩模⊙P、 在哪里⊙ 表示元素的乘积。P∈ RW×H是裁剪矩阵,提取原始掩模MR中间的目标尺寸区域的值,并将剩余区域的值设置为0,以屏蔽背景中类似亮度对象的干扰。

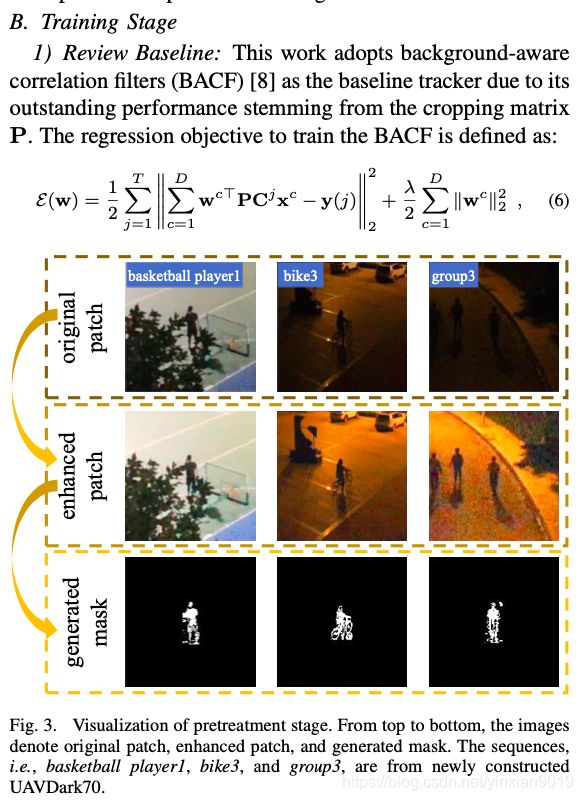

注1:掩模不仅能从背景中鲁棒地分割出物体,而且能屏蔽增强器带来的噪声,即式(5)。图3展示了预处理阶段的典型示例。

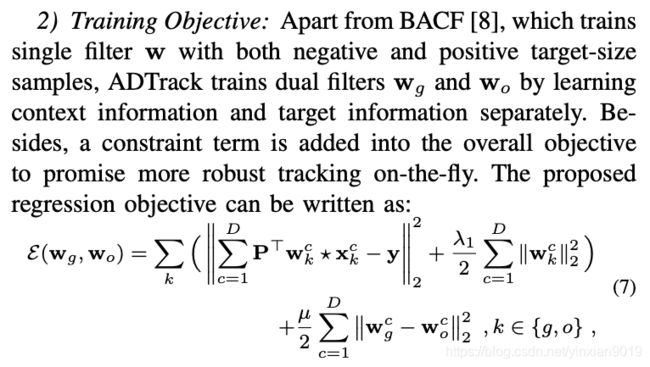

B. Training Stage

- Review Baseline: This work adopts background-aware

correlation filters (BACF) [8] as the baseline tracker due to its outstanding performance stemming from the cropping matrix P. The regression objective to train the BACF is defined as:

B训练阶段

1) 审查基准:这项工作采用背景意识

相关滤波器(BACF)[8]作为基线跟踪器,由于其优异的性能来源于裁剪矩阵P。训练BACF的回归目标定义为:

图3。

表示原始面片、增强面片和生成的遮罩。序列,即basketball player1、bike3和group3,来自新建的UAVDark70。

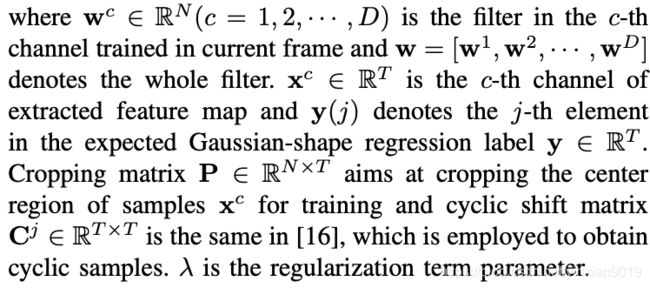

其中wc∈ RN(c=1,2,···,D)是当前帧中训练的第c个信道中的滤波器,w=[w1,w2,···,wD]表示整个滤波器。xc公司∈ RT是提取的特征映射的第c个通道,y(j)表示期望高斯形状回归标签y中的第j个元素∈ 放射治疗。裁剪矩阵P∈ RN×T的目标是裁剪样本xc的中心区域进行训练和循环移位矩阵Cj∈ RT×T与文献[16]相同,用于获得循环样本。λ是正则化项参数。

2) 训练目标:除了BACF[8]训练带有正负目标大小样本的单滤波器w外,ADTrack通过分别学习上下文信息和目标信息来训练双滤波器wg和wo。另外,在总体目标中加入一个约束项,以保证动态跟踪的鲁棒性。提议的

回归目标可以写成:

其中x表示循环相关运算符,其中-

它通过循环移位执行样本扩充。因此,第一项和第三项在形式上等同于式(6)中的第一项。不同地,xg表示上下文特征映射,而xo表示使用掩码m生成的目标区域特征映射,即xo=m⊙ xg公司。式(7)中的第二项和第四项作为正则化项,最后一项可视为约束项,其中wg和wo在训练过程中相互约束。μ是用于控制约束项影响的参数。

注2:为了保持对象的历史外观信息,本工作遵循了文献[8]中的传统方式,采用固定学习率的线性插值策略进行自适应特征更新。

3) 优化:假设给定了wo,ADTrack

首先找到wg的最优解。定义辅助对象

变量v,即v=IN⊗ P⊤工作组∈ RTD,其中⊗

表示N阶同一矩阵中的Kronecker积。

这里,w=[w1⊤,第2页⊤,··· ,西部数据⊤]⊤ ∈ RND公司。然后,gggg

式(7)的增广拉格朗日形式由以下公式表示:

式中θ=[θ1⊤,θ2⊤,··· ,θD⊤]⊤ ∈ RTD是拉格朗日向量,γ表示惩罚因子。然后利用ADMM[26]迭代求解wg、v和θ。

子问题wg′:将式(8)对wg的偏导数设为零,得到闭式解wg′,表示为:

子问题v′:为了有效地得到v的封闭形式,本文首先利用离散傅里叶变换将式(8)转化为Fourier域:

式中,ˆ·表示变量的傅里叶形式,即xˆ=√T英尺x。英尺∈ CT×T是傅里叶矩阵。上标·∗ 表示复共轭。

注3:由于循环相关在式(10)中被转化为逐元素乘积,因此通过在像素之间分离样本,例如x(t)=[x1(t),x2(t),·······,xD(t)]∈ RD(t=1,2,···,t),每个v′(t)可解为:

然后应用Sherman-Morrison公式[27]避免逆运算,将式(11)化为:

其中, …

给定第f帧中的期望滤波器wgf和wof,关于第(f+1)帧中的检测样本zf+1的响应映射R可以通过以下方式获得:

其中F

在第(f+1)帧和zf+1中,c是该帧的第c个信道

o

类似于xo的掩蔽样本。ψ是一个权重参数

控制由上下文筛选器和对象筛选器生成的影响响应映射。最后,在第(f+1)帧的响应图R的峰值处可以找到目标的位置。

Experiment

这部分展示了详尽的实验结果。通常,在第IV-B节中,邀请16个SOTA手工制作的基于CF的跟踪器,即AutoTrack[4]、KCF&DCF[16]、SRDCF[17]、STRCF[9]、BACF[8]、DSST&fDSST[18]、ECO-HC[19]、ARCF-HC&ARCF-H[5]、KCC[28]、MCCT-H[29]、CSR-DCF[24]、STUPLE[30]、STUPLE CA[31]和建议的ADTrack对两个暗跟踪基准进行评估,即:。,UAVDark70和UAVDark,全面论证了所提出的ADTrack的优越性。特别地,在表IV和表V所示的第IV-E节中,还对部署卷积神经网络(CNN)的深度跟踪器进行了评估。

图4。

在基准UAVDark70和UAVDark上。精度图的评价指标为DP,成功率图的评价指标为AUC。显然,ADTrack凭借其对偶回归在两个基准测试中保持其健壮性。

A.实施信息

1) 平台:本文扩展的实验都是在matlabr2019a上进行的。采用的主要硬件包括Intel Core I7-8700K CPU、32GB RAM和NVIDIA RTX 2080 GPU。

2) 参数:为保证评价的公正性和客观性,其他作品的被测跟踪器均保持了官方的初始参数。

ADTrack中回归方程的参数如下,λ1=λ2=0.01,μ设为200;对于ADMM的超参数,ADTrack设置γmax=10000,γ0=1,wg和wo的迭代次数均为3;检测时,权ψ设为0.02。注意,上下文和目标外观都采用学习率η1=0.02来实现特征更新。

3) 特征和尺度估计:ADTrack使用手工制作的特征来表示外观,即灰度、快速的方向梯度直方图(fHOG)[32]和颜色名称(CN)[33]。请注意,灰度和CN特征可以在ADTrack中有效,这要归功于弱光增强。特征提取的单元大小设定为4×4,ADTrack采用[18]提出的尺度滤波器进行精确的尺度估计。

B总体评价

图4显示了实时跟踪器的总体成功率和精度比较。

基准测试UAVDark70是在这项工作中新做的,由70个手动注释的序列组成。所有的场景都是在夜间由专业级无人机拍摄的。在图4(a)中,在中心位置误差(CLE)=20像素的距离精度(DP)下,ADTrack优于所有其他art,并将基线BACF[8]跟踪器提高了10.2%。在曲线下面积(AUC)方面,ADTrack排名第一。图5显示了UAVDark70中一些典型的暗跟踪场景和SOTA跟踪器的性能。

为了保持客观性,本工作从权威的公开基准UAVDT[34]和Visdrone-2019SOT[35](共37个序列)中选取了典型的夜景,并将它们组合成一个新的基准点,即UAVDark。在图4(b)中,ADTrack在DP和AUC方面都优于所有其他方法。具体来说,ADTrack在UAVDark中使基线BACF的DP提高了4.5%以上。

表一显示了前11名手工制作的基于CF的跟踪程序(包括实时和非实时)场地和2个基准测试的平均结果,其中ADTrack优于所有其他手工制作的跟踪程序。此外,ADTrack的速度达到34fps,满足无人机跟踪的实时性要求。

备注5:新制造的UAVDark70中的序列在现实世界的暗跟踪中更为常见,场景通常要暗得多,给跟踪者带来了更多的挑战。

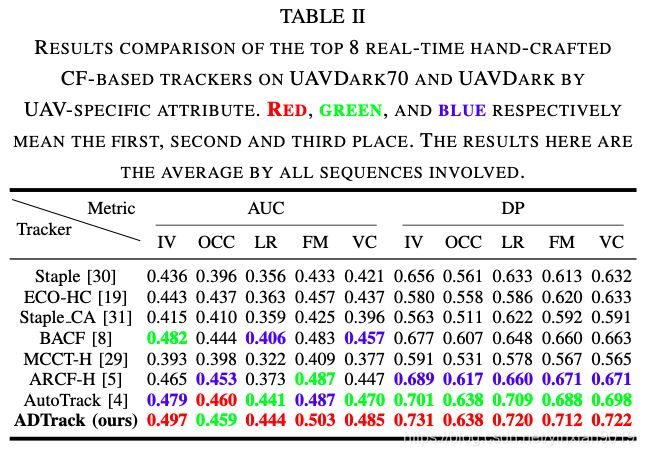

C按属性分析

继文献[21]之后,本文考虑了无人机特殊的跟踪挑战,如低分辨率(LR)、快速运动(FM)、光照变化(IV)、视点变化(VC)和遮挡(OCC)。在UAVDark70中,属性是根据[35]中的相同标准手动注释的。表II显示了UAVDark和UAVDark70中前8个基于CF的实时跟踪器的平均序列结果,其中ADTrack在大多数属性中排名第一。

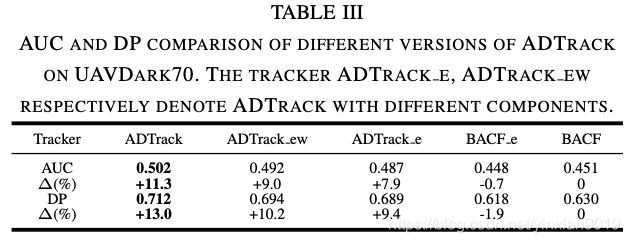

D烧蚀研究

这一部分展示了ADTrack中不同组件在跟踪上的有效性。BACF e表示仅在基线跟踪器BACF上添加增强因子[8]。AD-Track e指没有双滤波器的ADTrack(考虑基线)。ADTrack ew表示在ADTrack e的检测阶段仅加加权求和。ADTrack是指建议的跟踪器的完整版本(包括加权求和和和约束项)。结果显示在表三中,其中很明显,提议的2个组件大大提高了跟踪性能,AUC和DP都提高了3%以上。

注6:BACF e比原BACF差,可能是图像增强引入的噪声所致。而对于ADTrack,掩模可以阻断这种负面效应。

E对抗深海追踪器

本节重点比较ADTrack和deep跟踪器,后者利用离线训练的deep网络进行特征提取或模板匹配。本工作共邀请了10个SOTA深度跟踪器,即Siame-seFC[6]、ASRCF[7]、ECO[19]、UDT+[36]、TADT[37]、UDT[36]、HCFT[38]、IBCCF[39]和DSiam[40],在UAVDark中测试它们的性能。从表四可以看出,ADTrack在DP和AUC方面明显优于大多数深度跟踪器。

备注7:ADTrack仅使用单CPU,仍能达到每秒30帧以上的实时速度,而许多深度跟踪器即使在GPU上也远不能实现实时,这说明ADTrack在无人机实时跟踪方面的优越性。

表五选择了表四中排名前五位的跟踪器来评估它们在新建UAVDark70下的性能。

注8:研究结果表明,SOTA深度跟踪器在现实世界常见的黑暗场景中无法保持其鲁棒性,因为它们使用的CNN是由白天的图像训练的,与在黑暗中在线学习的ADTrack相比,最终处于巨大的劣势。

图5.一些典型跟踪场景的可视化。表示目标的序列,即girl4、group3、running2和signpost6,来自新构建的UAVDark70。显然,当其他跟踪器在黑暗中丢失目标时,ADTrack主要通过其目标感知掩模和双重回归来保证其在黑暗中的鲁棒性。

使用手工制作功能的前11名跟踪器的平均结果。红色、绿色和蓝色分别表示第一、第二和第三名。此表中的FPS值都是在单个CPU上获得的。

UAVDARK70和UAVDARK上前8名基于CF的实时手工跟踪器按UAV特定属性进行的结果比较。红色、绿色和蓝色分别表示第一、第二和第三名。这里的结果是所有相关序列的平均值。

UAVDARK70上不同版本ADTRACK的AUC和DP比较。跟踪器ADTRACK E、ADTRACK EW分别表示具有不同分量的ADTRACK。

UAVDARK上DEEP跟踪器和ADTRACK的AUC、DP和跟踪速度(FPS)比较。*表示GPU速度,在无人机平台中不常用。红色、绿色和蓝色分别表示第一个,

表中前5位跟踪器的AUC和DP比较。在UAVDARK70上。红色、绿色和蓝色分别表示第一、第二和第三名。

CONCLUSION

This work puts forward a novel real-time tracker with anti-dark function, i.e., ADTrack. ADTrack first implements image enhancement and target-aware mask generation based on an image enhancer. With the mask, ADTrack innova- tively proposes dual filters, i.e., the target-focused filter and the context filter, regression model. Thus, the dual filters restrict each other in training and compensate each other in detection, achieving robust real-time dark tracking onboard UAV. In addition, the first dark tracking benchmark, UAVDark70, is also constructed in this work for visual tracking community. The proposed anti-dark tracker and dark tracking benchmark will make an outstanding contribution to the research of UAV tracking in dark conditions in the future.

本文提出了一种具有抗暗功能的实时跟踪器ADTrack。ADTrack首先基于图像增强器实现图像增强和目标感知掩模生成。ADTrack创新性地提出了双重过滤器,即目标聚焦过滤器和上下文过滤器,回归模型。因此,双滤波器在训练中相互制约,在检测中相互补偿,实现了鲁棒的机载无人机实时暗跟踪。此外,本文还为视觉跟踪社区构建了第一个暗跟踪基准UAVDark70。本文提出的抗暗跟踪器和暗跟踪基准将为未来无人机暗跟踪研究做出突出贡献。