面试官:既然你用过MySQL,那你知道什么是慢查询吗?怎么分析?

MySQL中的慢查询与分析工具

- 什么是慢查询

-

- 慢查询配置

- 慢查询解读

- 慢查询分析工具

-

- mysqldumpslow

- pt_query_digest

-

- 语法

- 分析

-

- 总体分析

- 个体分析

什么是慢查询

慢查询,顾名思义,执行很慢的查询。有多慢?超过 long_query_time 参数设定的时间阈值(默认10s),就被认为是慢的,是需要优化的。慢查询被记录在慢查询日志里。

然而,慢查询日志默认是不开启的,也就是说一般人没玩过这功能。如果你需要优化SQL语句,就可以开启这个功能,它可以让你很容易地知道哪些语句是需要优化的(想想一个SQL要10s就可怕)。

慢查询配置

-

long_query_time 指定记录慢查询日志SQL执行时间得阈值(单位:秒,默认10秒)

如果你是处于学习阶段,想要自己看看慢查询日志,可以将阈值设置为0:

set global long_query_time=0; -

log_output 日志存放的地方【TABLE】【FILE】【FILE,TABLE】

配置了慢查询后,它会记录符合条件的SQL

包括: -

查询语句

-

数据修改语句

-

已经回滚的SQL

慢查询解读

第一行:记录时间

第二行:用户名 、用户的IP信息、线程ID号

第三行:执行花费的时间【单位:毫秒】、执行获得锁的时间、获得的结果行数、扫描的数据行数

第四行:这SQL执行的时间戳

第五行:具体的SQL语句

慢查询分析工具

慢查询的日志记录非常多,要从里面找寻一条查询慢的日志并不是很容易的事情,一般来说都需要一些工具辅助才能快速定位到需要优化的SQL语句,下面介绍两个慢查询辅助工具

mysqldumpslow

bin目录下的工具,汇总除查询条件外其他完全相同的SQL,并将分析结果按照参数中所指定的顺序输出。

mysqldumpslow -s r -t 3 ../data/hadoop000-slow.log

-s order (c,t,l,r,at,al,ar)

c:总次数

t:总时间

l:锁的时间

r:总数据行

at,al,ar :t,l,r平均数 【例如:at = 总时间/总次数】

-t 指定取前面几天作为结果输出

pt_query_digest

与mysqldumpslow工具相比,py_query_digest 工具的分析结果更具体,更完善。

有时因为某些原因如权限不足等,无法在服务器上记录查询。这样的限制我们也常常碰到。

进入/usr/local/mysql/data文件夹

下载:

wget https://www.percona.com/get/pt-query-digest

使可执行:

chmod u+x pt-query-digest;

语法

pt-query-digest [OPTIONS] [FILES] [DSN]

–create-review-table 当使用–review参数把分析结果输出到表中时,如果没有表就自动创建。

–create-history-table 当使用–history参数把分析结果输出到表中时,如果没有表就自动创建。

–filter 对输入的慢查询按指定的字符串进行匹配过滤后再进行分析

–limit限制输出结果百分比或数量,默认值是20,即将最慢的20条语句输出,如果是50%则按总响应时间占比从大到小排序,输出到总和达到50%位置截止。

–host mysql服务器地址

–user mysql用户名

–password mysql用户密码

–history 将分析结果保存到表中,分析结果比较详细,下次再使用–history时,如果存在相同的语句,且查

询所在的时间区间和历史表中的不同,则会记录到数据表中,可以通过查询同一CHECKSUM来比较某类型查询的历史变化。

–review 将分析结果保存到表中,这个分析只是对查询条件进行参数化,一个类型的查询一条记录,比较简单。当下次使用–review时,如果存在相同的语句分析,就不会记录到数据表中。

–output 分析结果输出类型,值可以是report(标准分析报告)、slowlog(Mysql slow log)、json、

json-anon,一般使用report,以便于阅读。

–since 从什么时间开始分析,值为字符串,可以是指定的某个”yyyy-mm-dd [hh:mm:ss]”格式的时间点,也可以是简单的一个时间值:s(秒)、h(小时)、m(分钟)、d(天),如12h就表示从12小时前开始统计。

–until 截止时间,配合—since可以分析一段时间内的慢查询。

示例:

- 全部分析

./pt-query-digest hadoop000-slow.log > slow_report.log;

- since用法

24小时前到现在

./pt-query-digest --since=24h hadoop000-slow.log > slow_report.log

某个时间点到某个时间点

./pt-query-digest hadoop000-slow.log --since '2019-09-24 00:00:00' --until '2019-09-25 00:00:00' > slow_report.log;

- filter用法

仅仅分析select语句

./pt-query-digest --filter '$event->{fingerprint} =~ m/^select/i' hadoop000-slow.log> slow_report.log;

针对某个用户

./pt-query-digest --filter '($event->{user} || "") =~ m/^root/i' hadoop000-slow.log> slow_report.log

更多与参考:https://blog.csdn.net/qq_16399991/article/details/82383917

分析

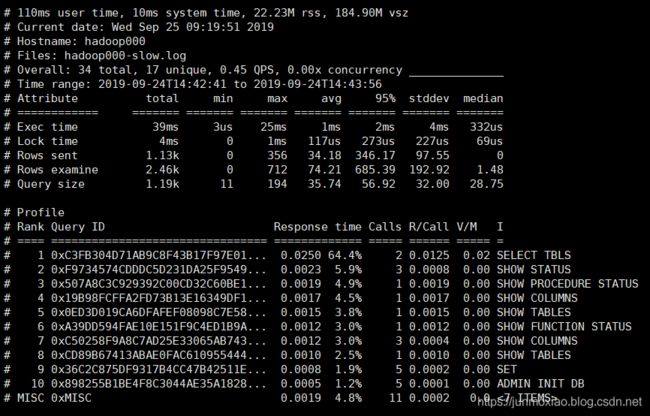

总体分析

体现的是所有慢查询的整体情况

上半部分:总体统计结果

- 该工具执行日志分析的用户时间 user time,系统时间 system time,物理内存占用大小 rss,虚拟内存占用大小 vsz

- Current date:工具执行时间

- Hostname:运行分析工具的主机名

- Files:被分析的文件名

- Overall:总共有多少条查询 total,总共有多少个不同的查询 unique,QPS,并发数

- Time range:sql执行的时间范围

- Exec time:sql执行时长

- Lock time:锁占用时间

- Rows sent:发送到客户端的行数

- Rows examine:select 语句扫描行数

- Query size:查询的字符数

下半部分:查询分组统计结果

- Rank:所有语句的排名,默认按查询时间降序排列,通过–order-by指定

- Query ID:语句的ID,(去掉多余空格和文本字符,计算hash值)

- Response:总的响应时间

- time:该查询在本次分析中总的时间占比

- calls:执行次数,即本次分析总共有多少条这种类型的查询语句

- R/Call:平均每次执行的响应时间

- V/M:Variance-to-Mean,响应时间的平均方差

- I:查询对象

个体分析

参考:Deer——mysql优化、https://blog.csdn.net/qq_16399991/article/details/82383917