CVPR 2022 | 旷视研究院入选论文亮点解读(上)

日前,CVPR 2022 论文接收情况正式出炉。此次旷视研究院表现出色,共有 17 篇论文成功入选。

作为计算机视觉世界三大顶会之一,CVPR 每年都会吸引大量研究机构和高校参会。近年来,CVPR 的论文投稿量持续增加,据官方消息,本届大会大约 2067 篇论文被接收,相比去年,今年的接收率上升 24%。

在恭喜旷厂小伙伴喜提中选的同时,为了帮大家第一时间查阅所关注领域的研究成果,我们整理了此次旷视研究院入选论文的摘要精选,并将分上下期与大家分享,本篇为上期。

学术成果来袭,一起先睹为快吧

01

FS6D: Few-Shot 6D Pose Estimation of Novel Objects

FS6D:用于新物体的少样本 6D 位姿估计

本文提出一个少样本开集 6D 位姿估计问题:对于没见过的新物品,已训练的网络模型只需依据几张 RGBD 图像就能在新测试场景中估算出该物品的 6D 位姿,而无需依赖物品的高精度 CAD 模型以及额外的训练。为了提高模型的泛化性,我们提出一个具有丰富纹理和形态多样性的大型仿真数据集用于网络预训练。同时,我们讨论求解该问题的可行算法并提出一个稠密原型匹配网络用于 6D 位姿估计。在公开数据集上,我们的方法大幅领先于其他可行算法。

关键词:6D位姿估计,少样本学习,数据集和基准

https://fs6d.github.io/

02

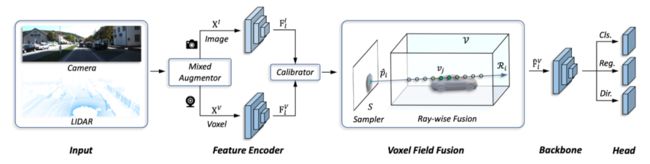

Voxel Field Fusion for 3D Object Detection

体素场融合的三维物体检测方法

本文提出了一种名为体素场融合的用于跨模态 3D 检测的方法。为了保持跨模态信息的一致性,其通过使用光束的方式来表示并在体素场中融合图像特征。因此,我们首先使用可学习的采样器来在图像平面采集重要区域的信息,并使用光束的方式将其投影至体素场中。这一操作在保证了特征空间表示的同时增强了三维空间中上下文交互。接着我们提出使用光束方式的融合来进行跨模态的特征增强,用于在体素场中融合上下文信息。我们所提出的方法在 KITTI 和 nuScenes 数据集上均取得了领先的结果。

关键词:体素场,跨模态特征融合,物体检测

03

Real-time Object Detection for Streaming Perception

用于流感知的实时物体检测

本文证明了使用实时检测模型相比非实时模型在自动驾驶的流感知问题上能够最小的避免算法检测结果和周围环境不一致而带来的决策误差问题。然后进一步分析与证明了在使用实时模型的情况下诸多后处理方法将不再起作用,然后得出实时模型还存在所有的决策误差全都由模型不能感知未来周围环境所导致的。基于以上发现,本文提出一套非常简洁的方法去赋能传统检测器,使其具备感知未来的能力。具体来说,本文提出一个双流感知模块用于捕捉静态信息和动态信息以及一个趋势感知损失为周围物体产生自适应关注权重。基于本文提出的范式,模型的训练和未来预测都是端到端的,并且在推理的时候不会带来额外的时间延迟。本文的架构能够在静止和任何速度的车辆行驶情况下表现鲁棒。该方法在Argoverse-HD数据集上取得精度的最佳结果并且击败了该比赛的最佳成绩。

关键词:object detection, streaming perception, video prediction

04

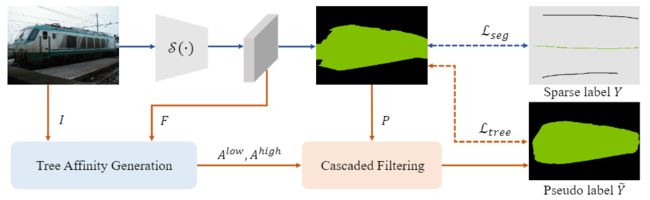

Tree Energy Loss: Towards Sparsely Annotated Semantic Segmentation

树状能量损失函数:解决稀疏标注语义分割问题

语义分割任务往往需要精细的像素级别标注,标注花费昂贵,因此面向稀疏标注的语义分割(仅标注一部分点、线、区域)有着极大的应用需求。为解决这一问题,本文提出了树状能量损失函数。该损失函数将图像表示为一个最小生成树,并对图像低级先验、高级语义的隶属度进行建模,为未标注区域提供语义引导。串联地将低级、高级的隶属度作用到语义分割网络的预测结果上,能够为未标注区域生成伪标签,在线地实现网络自我训练。树状能量损失函数十分高效,能够直接地部署到任意一个语义分割网络中。在PASCAL VOC、Cityscapes和ADE20k等数据集上的实验表明,和已有方法相比,我们的方法在各类稀疏标注场景下,均能够实现先进的语义分割性能,无需多阶段训练策略、交替优化步骤、额外的监督数据以及耗时的后处理步骤。

关键词:树状滤波器,稀疏标注,语义分割,损失函数

05

Progressive End-to-End Object Detection in Crowded Scenes

一种适用于密集场景的渐进式端到端目标检测器

在遮挡场景中,端到端的物体检测框架容易重复检测图像中的物体,由此产生冗余检测框影响性能。为了解决这一问题,本文从 Sparse RCNN 这一端到端物体检测框架入手,通过分析发现其检测结果中:高分检测框中存在的假阳性结果非常少。基于此,本文依据 Sparse RCNN 的原生结构设计了渐进式的端到端物体检测器。该方法的原理是在在优化过程中仅选择低分检测框进行后续的渐进式优化。该方法在遮挡场景数据集 CrowdHuman 上性能 SOTA,在 CityPersons 和 MSCOCO 等数据集上也有显著的性能提升。

关键词:遮挡物体检测,端到端物体检测

06

Focal Sparse Convolutional Networks for 3D Object Detection

用于 3D 目标检测的焦点稀疏卷积神经网络

在 3D 检测任务中,点云/体素数据不均匀地分布在3维空间中,不同位置的数据对任务本身起着截然不同的作用。然而,主流的 3D 检测主干网络,稀疏卷积网络,却在使用同样的方式处理所有的数据。不管是常规的稀疏卷积,还是流形稀疏卷积 (Submanifold Sparse Conv)。在本文中,我们提出了一种可以让网络聚焦到重要信息的稀疏卷积,焦点稀疏卷积 (Focal Sparse Conv)。 该卷积可适用于纯雷达网络和多模态融合网络。该卷积可以直接用于现有的稀疏卷积网络,并首次验证了自适应的稀疏程度学习对 3D 检测任务的重要性。

我们通过大量的实验在 KITTI, nuScenes, 以及 Waymo 数据集上验证了 Focal Sparse Conv 的有效性。我们的方法在 nuScenes test 榜单上取得了单模型 70.1% mAP 的精度,超过了此前公开发表的方法。

关键词:焦点稀疏卷积,可学习稀疏程度

07

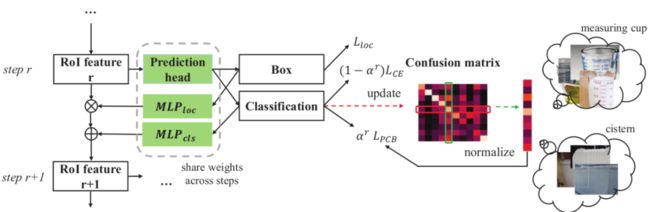

Relieving Long-tailed Instance Segmentation via Pairwise Class Balance

通过成对的类别平衡策略解决长尾实例分割问题

长尾问题的根源是占比不多的头部类的样本数远多于占比不小的尾部类们。直接在这种数据集上训练的模型,其分类预测会有偏差。易把尾部类样本错分成头部类样本. 现有技术提出一些指标去简单指示偏差, 并进行相应建模,达到某种平衡从而提升效果。要么局限于静态的训练集类别分布,不灵活。要么即使考虑了动态统计量,也只是每个类本身的分类情况,没有考虑到类间错分。

我们的 PCB 方法使用混淆矩阵维护训练时类间预测偏差信息。对于训练样本,除基本交叉熵损失外,据其类别从混淆矩阵中取得对抗软类标,施以该软类标的交叉熵损失进行纠偏。我们的方法可无缝插入到前沿的长尾实例分割模型中,均取得不俗提升,部分可达领域最佳效果。

关键词:长尾,实例分割,混淆矩阵,类间平衡

https://arxiv.org/abs/2201.02784

08

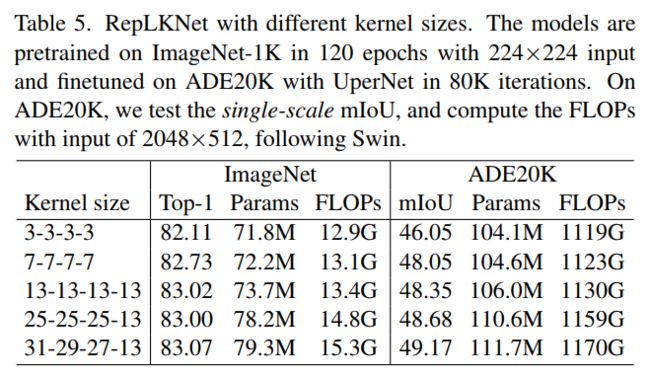

Scaling Up Your Kernels to 31x31: Revisiting Large Kernel Design in CNNs

将卷积核加大到 31x31:重新探索采用大卷积核设计的卷积神经网络

我们重新探索了现代卷积神经网络中的大卷积核设计,表明 kernel size 是一个非常重要的设计维度。在现代结构设计的作用下,超大卷积核既涨点又高效,越大越涨点,甚至大到 31x31 都非常有效。通过一系列探索实验,归纳了在现代模型中应用大卷积的五条准则,如使用 shortcut、采用 depth-wise 卷积和针对性的优化、用小卷积核进行重参数化等。在此之上提出了一种新的架构 RepLKNet,大量使用超大 kernel size,大到 27x27 和 31x31,在大模型和下游任务上取得了亮眼的结果,比 Swin 更好或相当,挑战了诸多行业内的传统认知,远超传统小 kernel 的 CNN。

关键词:卷积,架构设计,kernel size,transformer,结构重参数化

https://arxiv.org/pdf/2203.06717.pdf

09

RepMLPNet: Hierarchical Vision MLP with Re-parameterized Locality

RepMLPNet:一种采用重参数化技术引入局部性的分层 MLP 网络

视觉 MLP 模型的一大本质缺陷是缺少 inductive bais,如局部先验和平移不变性,所以难以训练,需要特殊的训练方法或较大的训练开销。这一工作用结构重参数化在 MLP 的全连接层中引入 inductive bias,大大提升精度和训练效率。训练时的模型包括与全连接层并行的卷积,这一卷积可以通过一系列代数变换等价合并到全连接层中去,从而最终得到的模型既不再包含卷积又具有了局部先验和平移不变性。在此之上,提出一种分层设计的 MLP 网络,超过 ResMLP、gMLP 等模型,而且是第一个可用于语义分割的 MLP 模型。

关键词:MLP、inductive bias、结构重参数化

https://arxiv.org/pdf/2112.11081.pdf

10

Practical Stereo Matching via Cascaded Recurrent Network with Adaptive Correlation

基于自适应相关级联递归网络的实用双目匹配

随着神经网络的不断演进,基于深度学习的立体匹配算法也得到了十分广泛的关注和应用。然而,面对从诸如手机等消费级设备获取的双摄图,要恢复出精确且细节完美的视差图并不容易;对于实际应用中的困难场景例如细小物体、非理想行对齐和主副摄不一致等,现有立体匹配算法的效果往往大打折扣。因此,我们针对立体匹配算法在真实场景的应用进行了深入研究。本文介绍了我们提出的一个新的立体匹配框架 CREStereo,本算法不仅在主流的公开数据集上取得了优异的结果(Middlebury 和 ETH3D 排名第一),并且在真实场景的应用中也有出色的表现。

关键词:立体匹配,自适应,真实场景

- 上篇完 -

.

技术信仰,价值务实

下篇中我们将继续分享入选论文摘要集锦

敬请期待哟!