文章目录

- 实验数据集下载

-

- 下载实验数据集

- 建立一个用于运行本案例的目录dbtaobao

- 数据集的预处理

-

- 删除文件第一行记录,即字段名称

- 获取数据集中双11的前100000条数据

- 导入数据仓库

实验数据集下载

下载实验数据集

- data_format.zip数据集

- 用户行为日志user_log.csv,日志中的字段定义如下:

1. user_id | 买家id

2. item_id | 商品id

3. cat_id | 商品类别id

4. merchant_id | 卖家id

5. brand_id | 品牌id

6. month | 交易时间:月

7. day | 交易事件:日

8. action | 行为,取值范围{0,1,2,3},0表示点击,1表示加入购物车,2表示购买,3表示关注商品

9. age_range | 买家年龄分段:1表示年龄<18,2表示年龄在[18,24],3表示年龄在[25,29],4表示年龄在[30,34],5表示年龄在[35,39],6表示年龄在[40,49],7和8表示年龄>=50,0和NULL则表示未知

10. gender | 性别:0表示女性,1表示男性,2和NULL表示未知

11. province| 收获地址省份

- 回头客训练集train.csv和回头客测试集test.csv,训练集和测试集拥有相同的字段,字段定义如下:

user_id | 买家id

age_range | 买家年龄分段:1表示年龄<18,2表示年龄在[18,24],3表示年龄在[25,29],4表示年龄在[30,34],5表示年龄在[35,39],6表示年龄在[40,49],7和8表示年龄>=50,0和NULL则表示未知

gender | 性别:0表示女性,1表示男性,2和NULL表示未知

merchant_id | 商家id

label | 是否是回头客,0值表示不是回头客,1值表示回头客,-1值表示该用户已经超出我们所需要考虑的预测范围。NULL值只存在测试集,在测试集中表示需要预测的值。

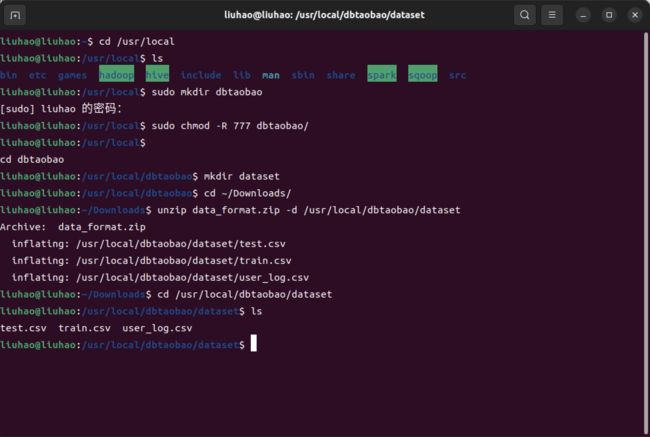

建立一个用于运行本案例的目录dbtaobao

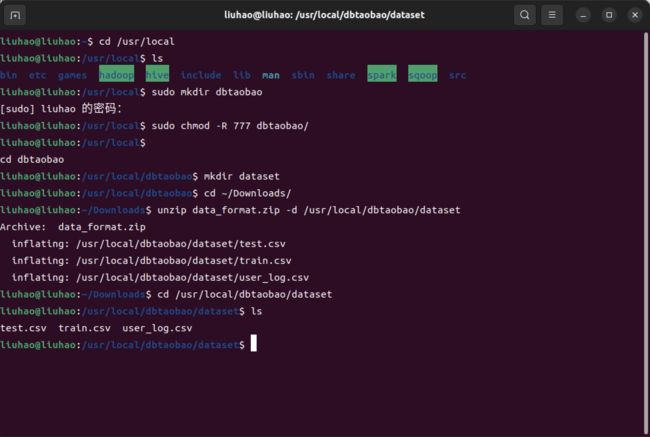

- 把data_format.zip进行解压缩,我们需要首先建立一个用于运行本案例的目录dbtaobao

cd /usr/local

ls

sudo mkdir dbtaobao

sudo chmod -R 777 ./dbtaobao

cd dbtaobao

mkdir dataset

cd ~/下载

ls

unzip data_format.zip -d /usr/local/dbtaobao/dataset

cd /usr/local/dbtaobao/dataset

ls

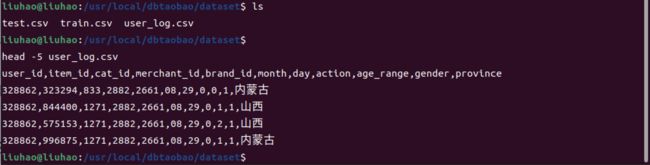

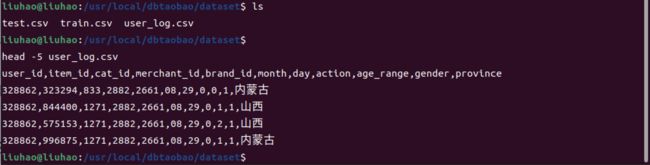

head -5 user_log.csv

数据集的预处理

删除文件第一行记录,即字段名称

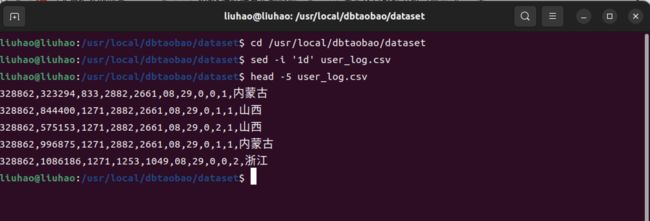

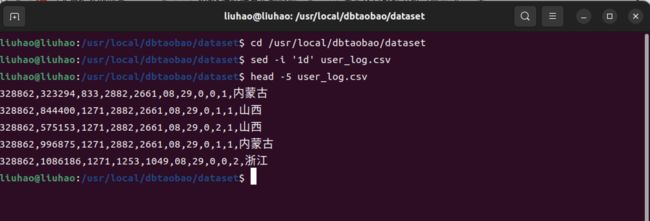

cd /usr/local/dbtaobao/dataset

sed -i '1d' user_log.csv

head -5 user_log.csv

获取数据集中双11的前100000条数据

- 由于数据集中交易数据太大,这里只截取数据集中在双11的前10000条交易数据作为小数据集small_user_log.csv

- 建立一个脚本文件完成上面截取任务,请把这个脚本文件放在dataset目录下和数据集user_log.csv:

cd /usr/local/dbtaobao/dataset

vim predeal.sh

- 使用vim编辑器新建了一个predeal.sh脚本文件,请在这个脚本文件中加入下面代码:

#!/bin/bash

infile=$1

outfile=$2

awk -F "," 'BEGIN{

id=0;

}

{

if($6==11 && $7==11){

id=id+1;

print $1","$2","$3","$4","$5","$6","$7","$8","$9","$10","$11

if(id==10000){

exit

}

}

}' $infile > $outfile

- 执行predeal.sh脚本文件,截取数据集中在双11的前10000条交易数据作为小数据集small_user_log.csv,命令如下:

chmod +x ./predeal.sh

./predeal.sh ./user_log.csv ./small_user_log.csv

导入数据仓库

-

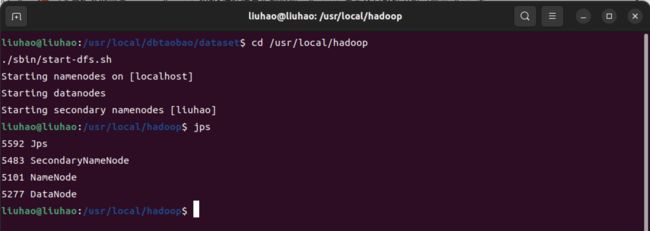

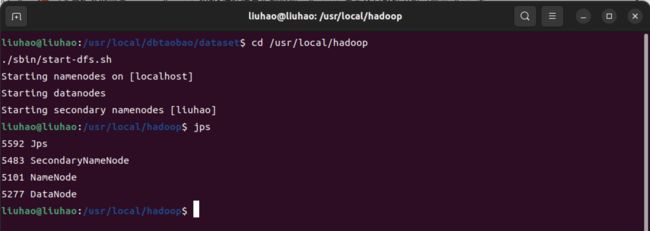

启动HDFS

-

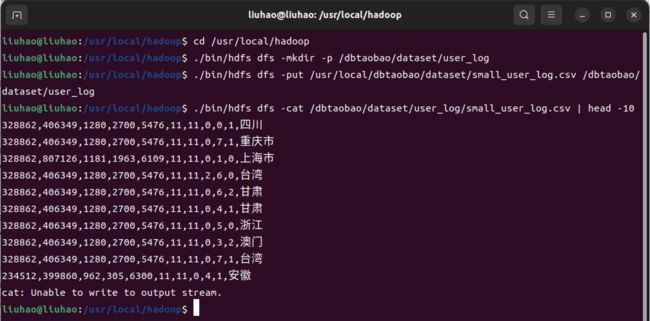

把user_log.csv上传到HDFS中

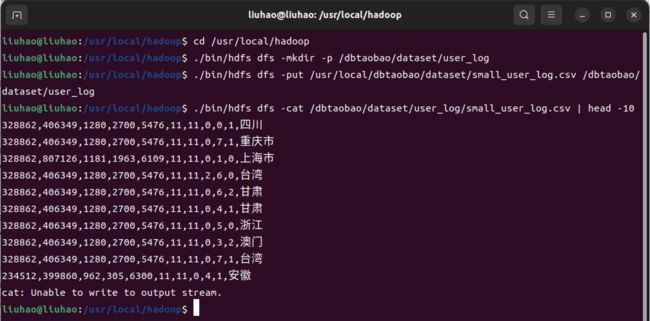

cd /usr/local/hadoop

./bin/hdfs dfs -mkdir -p /dbtaobao/dataset/user_log

cd /usr/local/hadoop

./bin/hdfs dfs -put /usr/local/dbtaobao/dataset/small_user_log.csv /dbtaobao/dataset/user_log

cd /usr/local/hadoop

./bin/hdfs dfs -cat /dbtaobao/dataset/user_log/small_user_log.csv | head -10

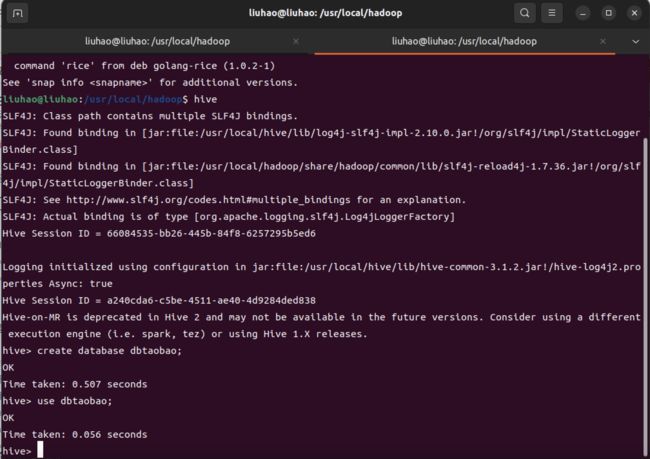

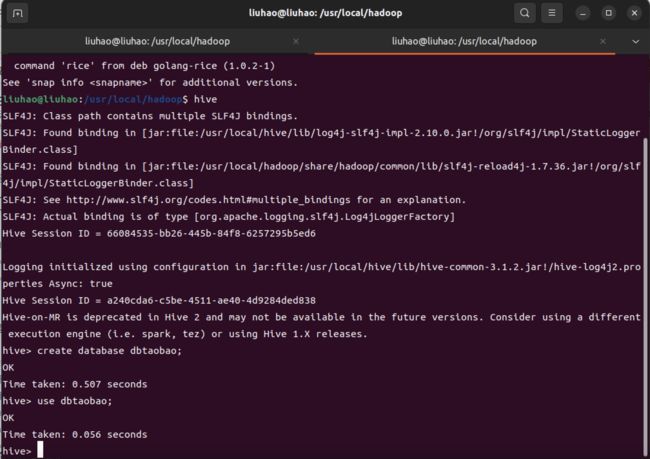

service mysql start

cd /usr/local/hive

./bin/hive

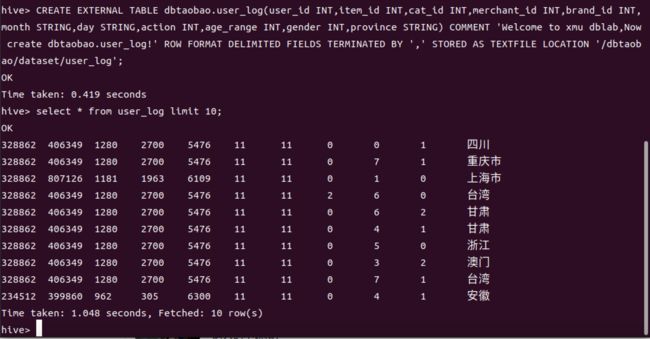

hive> create database dbtaobao;

hive> use dbtaobao;

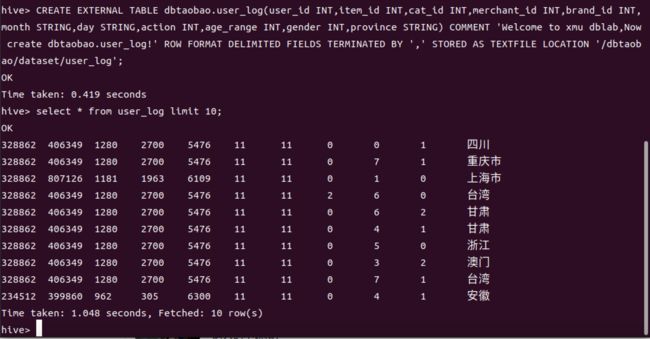

hive> CREATE EXTERNAL TABLE dbtaobao.user_log(user_id INT,item_id INT,cat_id INT,merchant_id INT,brand_id INT,month STRING,day STRING,action INT,age_range INT,gender INT,province STRING) COMMENT 'Welcome to xmu dblab,Now create dbtaobao.user_log!' ROW FORMAT DELIMITED FIELDS TERMINATED BY ',' STORED AS TEXTFILE LOCATION '/dbtaobao/dataset/user_log';

hive> select * from user_log limit 10;