2021-01-26Taming Transformers for High-Resolution Image Synthesis(arXiv2020)(有代码)

转自 https://blog.csdn.net/amusi1994/article/details/112301258

---代码链接 https://github.com/CompVis/taming-transformers

项目主页:https://compvis.github.io/taming-transformers/

VQGAN——利用基于CNN的有效归纳偏置,并结合Transformer结构的表达能力

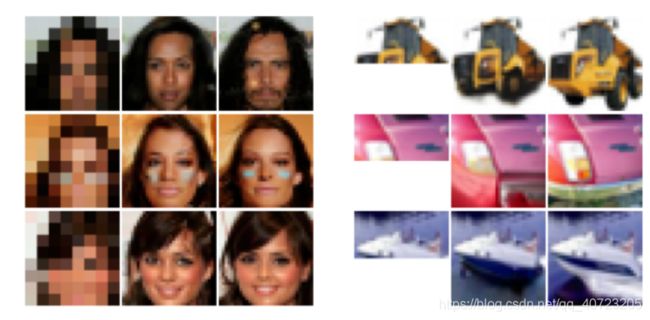

CNN也具有平移不变性和局部敏感性的归纳偏置。但是,后者也决定了卷积神经网络只能关注局部信息的网络结构.它的这种计算机制导致了它在文本信息处理上难以捕捉和存储长距离的依赖信息,也就是缺乏对数据本身的整体把握。人们一方面想扩大卷积核、增加通道数来捕捉长期依赖,一方面还害怕由于扩大模型所导致的维度灾难。相比之下,Transformer背后的Self Attention除了兼具并行计算的优点,还能挖掘长距离依赖,不受优先考虑局部相互作用的归纳偏置的限制,从而具有很强的表达性。此外,由于不存在这种限制,自注意力机制还能根据任务目标和自注意力层的位置来学习最合适的归纳偏置。在“ON THE RELATIONSHIP BETWEEN SELF-ATTENTION AND CONVOLUTIONAL LAYERS”这篇发表在ICLR 2020的论文中,作者提出了理论和经验证据,表明自注意力层可以(并且确实)像卷积层那样起作用:从理论上讲,存在建设性的证据,表明自注意力层可以表示任何卷积层。具体来说,使用相对位置编码的单个多头自注意力层可以重新参数化以表示任何卷积层。实验表明,仅使用自注意力的架构的前几层确实学习了如何在每个查询像素周围加入网格状模式。所以,自注意力机制和卷积层是很相似的。然而,对于高分辨率的输入来说,自注意力机制层的计算量很大,因此它只适用于较小的空间维度输入的数据场景。比如,iGPT补全的图像最大只有64x64像素,而于2018年提出的“Image Transformer”生成的也是分辨率很低的图像,如下图所示。

这是因为,自注意力机制相对于CNN存在普遍性,也意味着它必须学习所有的关系,而CNN被设计成利用图像中强局部相关性的先验知识。因此,由于考虑了所有成对的相互作用,Transformers表达能力的增加相应地带来了计算成本的二次增加。因此,目前的Transformers SOTA模型由于高耗能和高耗时,为将其扩展到处理高分辨率图像带来了根本性的问题。

实际上,基于自注意力机制和卷积层的相似性,Transformer和CNN也可以结合应用,今天要介绍的这篇论文就采用了这样的思想。

此外,这也是第一个语义引导生成百万像素图像的Transformer架构。

论文:Taming Transformers for High-Resolution Image Synthesis

作者受到上文提到的“Transformers倾向于学习卷积结构”的现象的启发,提出了这个问题:“我们是否在每次训练视觉模型时,必须从头开始重新学习已知的关于图像局部结构和规律性的所有知识,或者我们是否能够有效地编码归纳偏置,同时仍然保持Transformers的灵活性?” 作者假设低层次的图像结构是由局部连通性即卷积结构来描述的,而这种结构假设在更高的语义层次上不再有效。

进一步说,CNN不仅表现出很强的局部性偏差,而且通过在所有位置使用共享的权值,还表现出对空间不变性的偏差。而如果需要对输入进行更全面的理解,这些偏差将变得无效。

高分辨率图像合成需要一个能够理解图像全局组件的模型,使其能够生成局部真实和全局一致的模式。因此,本文不是用像素来表示图像,而是将其表示为codebook的感知丰富的图像成分的合成。

这些思想综合起来就是,卷积和Transformer架构可以共同用于建模视觉世界的组成性质:我们使用卷积方法高效地学习上下文丰富的视觉部分的codebook,然后学习其全局组成的模型。这些组合中的远程交互需要一个富有表达力的Transformer 架构来对其一致的可视部分上的分布进行建模。

此外,作者利用对抗性的方法来确保局部部分的字典捕获感知上重要的局部结构,以减轻用Transformer架构建模低层统计的需要。从而让Transformers专注于其独特的优势——建模远程关系——使其能够生成高分辨率图像。作者提出的公式通过调节有关所需目标类别或空间布局的信息,可以直接控制生成的图像内容。

通过学习如3.1节所述的高效的编码,可以显著缩短合成的描述长度,从而能够有效地用3.2节中描述的Transformer架构在图像中建模它们的全局相互关系。在下图中总结的这种方法能够在无条件和有条件的设置中生成真实和一致的高分辨率图像。

作者使用卷积VQGAN来学习上下文丰富的视觉部分的codebook,codebook的组件随后用自回归transformer 架构来建模。离散的codebook提供了这些架构之间的接口,基于patch的判别器实现了强大的压缩能力,同时保持了较高的感知质量。该方法引入了卷积方法在基于transformer的高分辨率图像合成中的有效性。