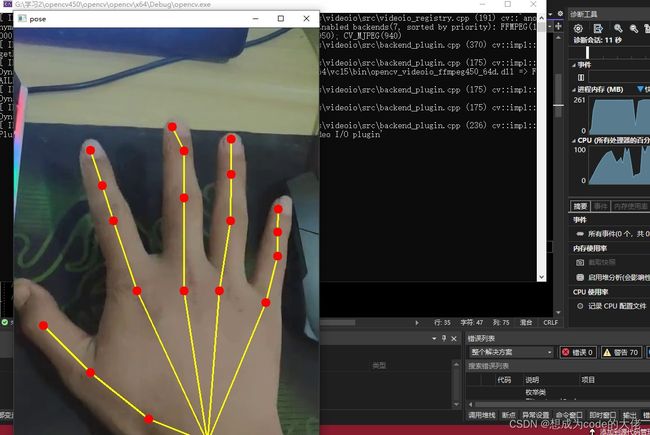

AI入门之神经网络(9)基于c++、opencv的dnn模块的视频手势识别

基于c++、opencv的dnn模块的手势识别

老规矩话不多,实现的方法步骤,细节全在我的代码注释里面,只你跟着注释写,相信你也写得出来的!

#include 识别效果:

B站(这个也是我的账号呦)