【Python机器学习】全连接层与非线性回归、防止过拟合方法的讲解及实战( 附源码)

需要全部代码请点赞关注收藏后评论区留言私信~~~

全连接层与非线性回归

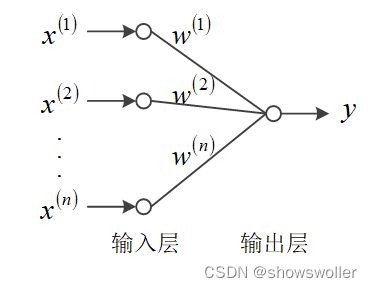

基于全连接层构建的多层神经网络能够用来完成回归和分类人物,在神经网络中一般用下图所示画法来表示神经元模型,神经元由输入层和输出层组成,输入层负责接收信息,并将信息传给输出层,输出层负责求和,产生激励信息并输出

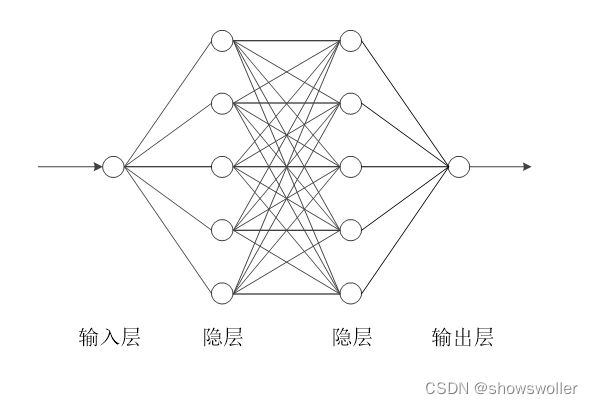

下面给出一个应用多个全连接层组成的神经网络来求解非线性回归问题的示例,该示例用下图所示神经网络来拟合目标函数

采用四层神经网络,输入层节点数为1,第1隐层和第2隐层的神经元个数为5,输出层神经元个数为1.

部分代码如下

from mindspore.common.initializer import Normal

from mindspore import nn, Parameter

class NonLinearNet(nn.Cell):

def __init__(self):

super(NonLinearNet, self).__init__()

self.fc1 = nn.Dense(1, 5, Normal(0.02), Normal(0.02), True)

self.fc2 = nn.Dense(5, 5, Normal(0.02), Normal(0.02), True)

self.fc3 = nn.Dense(5, 1, Normal(0.02), Normal(0.02), True)

self.sigmoid = nn.Sigmoid()

def construct(self, x):

x = self.sigmoid(self.fc1(x))

x = self.sigmoid(self.fc2(x))

x = self.sigmoid(self.fc3(x))

return x

import tensorflow as tf

tf_model = tf.keras.Sequential([

tf.keras.layers.Dense(5, activation='sigmoid', input_shape=(1,), kernel_initializer='random_uniform', bias_initializer='zeros'),

tf.keras.layers.Dense(5, activation='sigmoid', kernel_initializer='random_uniform', bias_initializer='zeros'),

tf.keras.layers.Dense(1, activation='sigmoid', kernel_initializer='random_uniform', bias_initializer='zeros')

])

……

tf_model.compile(optimiaer='sgd', loss='mean_squared_error')

tf_model.fit(X, y1, batch_size=batch_size, epochs=tf_epoch, verbose=1)

tf_model.summary()

神经网络中的过拟合及其抑制

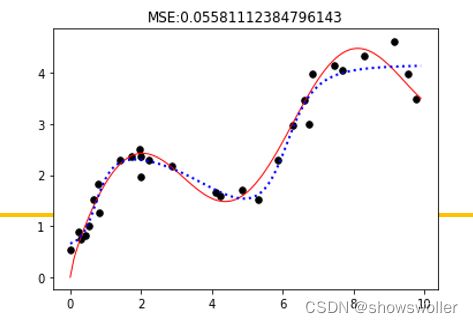

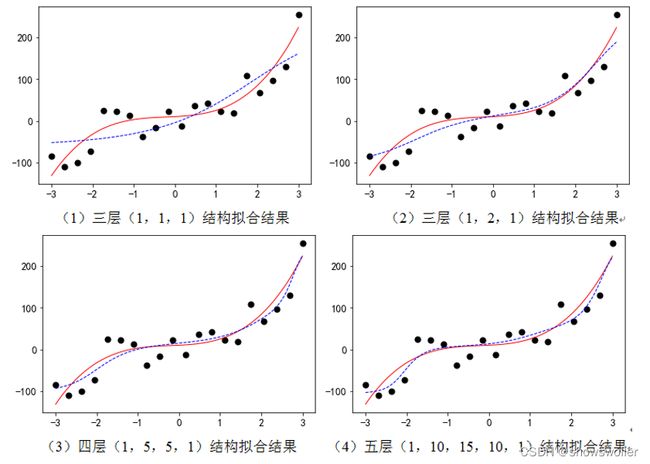

用全连接层神经网络来拟合多项式。该神经网络有三个隐层(层内节点数分别为5、5、1),默认输入层为1个节点。隐层和输出层都采用Sigmoid激活函数。连接系数采用随机初始化,阈值系数置为0。采用均方误差MSE作为损失函数。为方便比较,采用SGD随机梯度下降优化方法,在TensorFlow2框架下实现。共训练5000轮。

如果网络结构过于简单,会欠拟合,如果网络结构过于复杂,则会过拟合

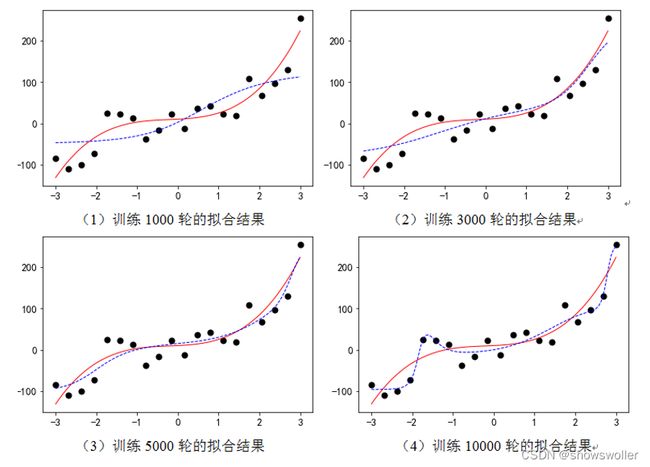

随着训练轮数的增加,拟合结果也从欠拟合变成过拟合

采用Sigmoid激活函数、四层(1,5,5,1)结构、训练轮数为10000,以训练轮数为横坐标、误差值为纵坐标,画出训练误差和测试误差的走向

减少模型规模(减少多层神经网络的层数和节点数)和增加训练样本数量是防止过拟合的重要方法

下面讨论以及过拟合的方法的应用

1:正则化方法的应用

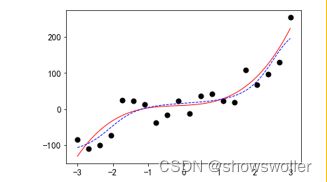

拟合结果如下图 可知比较成功的抑制了过拟合

部分代码如下

model = tf.keras.Sequential([

tf.keras.layers.Dense(5, activation='sigmoid', input_shape=(1,),

kernel_initializer='random_uniform', bias_initializer='zeros'),

tf.keras.layers.Dense(5, activation='sigmoid', kernel_regularizer=regularizers.l2(0.001),

kernel_initializer='random_uniform', bias_initializer='zeros'),

tf.keras.layers.Dense(1, activation='sigmoid',

kernel_initializer='random_uniform', bias_initializer='zeros')

])

2:早停法的应用

过拟合是训练误差低而测试误差高的问题,所以,如果在测试误差升高或不再降低时停止训练,则可以防止模型过度训练。

早停法抑制过拟合就是利用回调机制在每轮训练结束时检查测试误差是否停止减少,如果停止减少则结束训练。

# 验证集

x1 = np.linspace(-3, 3, 100)

y0 = myfun(x1)

y00 = y0.copy()

standard(y0, -131.0, 223.0)

earlyStopping=tf.keras.callbacks.EarlyStopping(monitor='val_loss', min_delta=0.000001, patience=5, verbose=1, mode='min')

model.fit(x, y, batch_size=20, epochs=10000, verbose=1, callbacks=[earlyStopping],

validation_data=(x1, y0))

3:Dropout法的应用

Dropout法是将神经元随机失活,即按预先设定的概率随机选择某些神经元进行失效,不参与本次训练。该方法可以一定程度上抑制过拟合问题。

部分代码如下

model = tf.keras.Sequential([

tf.keras.layers.Dense(5, activation='sigmoid', input_shape=(1,),

kernel_initializer='random_uniform', bias_initializer='zeros'),

tf.keras.layers.Dropout(0.1),

tf.keras.layers.Dense(5, activation='sigmoid',

kernel_initializer='random_uniform', bias_initializer='zeros'),

tf.keras.layers.Dense(1, activation='sigmoid',

kernel_initializer='random_uniform', bias_initializer='zeros')

])

创作不易 觉得有帮助请点赞关注收藏~~~