论文|少样本学习综述

原文题目:Learning from Very Few Samples: A Survey

文章结构:

一、引言

深度学习的领域:

1.视觉2.语言3.语音4.游戏5.人口学6.医学7.植物病理学8.动物学

深度学习的成功取决于:

强大的计算资源、复杂的网络、大规模的数据集。

少样本学习(FSL)的意义:

实际中,医学、军事、金融等一些领域由于无法获取足够的训练样本标签(可能是涉及隐私安全花费等),所以少样本学习很有意义。意义:1.不用依赖大规模样本 2.缩小人类与AI的差距 3.低成本,快速的模型部署。

从优化的角度说明,为什么FSL进展困难?

从本质上讲每个被监督样本形成的约束可以看作是f的正则化,这可以减少泛化误差。

二、概述

2.1进化历史

生成模型:一开始在非深度的阶段,都是用生成模型,尝试去寻找一个联结分布或者条件分布。

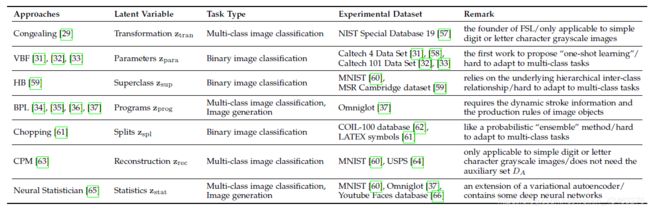

FSL生成模型一些里程碑:1.凝结算法 2.方差贝叶斯 3.贝叶斯程序学习。

在非深度阶段也有判别模型,但他们不是主流。

存在一些基于方法的生成模型,但是基于方法的判别模型才是主要的,比如元学习。后续FSL方法充分利用了深度神经网络在特征表示和端到端模型优化的优势,包括

1.数据增强2.度量学习3.元学习

过去,这些先进的FSL方法已直接应用于或改进以解决计算机视觉,自然语言处理,音频和语音,数据分析,机器人等方面的各种应用。

同时也存在很多与之相关的挑战:半监督FSL,无监督FSL,交叉域FSL,泛化FSL,多模态FSL。

因此发展历程可以总结为:非深度向深度的转变,主流方法的变化,经典元学习的复兴。

2.2注释定义

少样本监督学习的目的是为任务T建立一个映射f,用DT中的信息和DA(辅助集)的知识。DT和DA交集为空。

半监督:训练集中有些样本无标签

无监督:即使是辅助集DA也没有标签

交叉域:DT和DA可能是不同域的,但有一些共同的样本

泛化:当DA和DT两个空间合并时,它的效果要大于只有DT的时候

多模态:多模态匹配、多模态融合

2.3分类

判别模型主要有三类:增强,度量学习,元学习。

增强:1.监督学习 2.无监督学习

元学习:学会学习。元学习现存的五类:1.学会调整 2.学会参数化 3.学会调整 4.学会记忆 5.学会度量

三、基于方法的生成模型

基于生成模型的FSL方法寻求对后验概率p进行建模。 但是,在大多数情况下,数据x和目标y之间的概率关系并不简单。

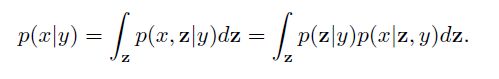

例如,对于FSL图像分类,x表示一张图像,y表示其类别标签,它们之间的数学联系无法直接描述。桥接x和y之间联系的可行策略是引入隐变量z:

几乎所有基于生成模型的FSL方法都遵循这种策略,只是在z形式上有所不同。 z的几种经典形式在上面已经给出。

四、基于方法的判别模型

增强:学一个增强函数A(利用辅助集DA)去强化训练集的样本或者是特征。增强学习常见方法:旋转,翻转,裁剪,平移,在图像中添加噪点。变化后的样本可以看做是新样本。

增强学习主要包括:

1.有监督增强学习

有监督数据增强,即采用预设的数据变换规则,在已有数据的基础上进行数据的扩增,包含单样本数据增强和多样本数据增强。

单样本:所谓单样本数据增强,即增强一个样本的时候,全部围绕着该样本本身进行操作,包括几何变换类,颜色变换类等。

多样本:利用多个样本来产生新的样本

2.无监督增强学习

无监督的数据增强方法包括两类:

(1) 通过模型学习数据的分布,随机生成与训练数据集分布一致的图片

(2) 通过模型,学习出适合当前任务的数据增强方法

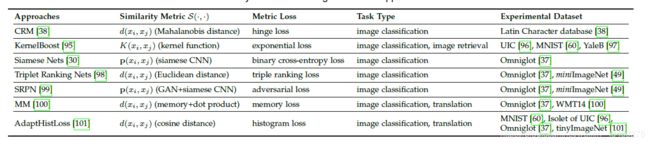

度量学习:在DA和DT之间构造一个相似度量S,相似样本样本得分高,不相似样本得分低。

(关于度量学习从网上找的一点科普:Metric Learning作为经典识别网络的替代方案,可以很好地适应某些特定的图像识别场景。一种较好的做法,是丢弃经典神经网络最后的softmax层,改成直接输出一根feature vector,去特征库里面按照Metric Learning寻找最近邻的类别作为匹配项。)

metric learning的目标是从经验数据集中学习一个变换函数(线性非线性均可)把数据点从原始的向量空间映射到一个新的向量空间,在新的向量空间里相似点的距离更近,非相似点的距离更远(通常会像kernel一样直接定义一个新空间中的度量函数),这些度量函数往往通过最小化相应损失函数得到。例如,如何学习K:

其中当xi,xj为一类时,yij为1,否则为0。获取K通过最小化l。相关文献如上表所示。

元学习:它利用DA来构造许多类似于任务T的任务,并采用跨任务训练策略来提取一些可转移的模型,算法或参数。

元学习包含五个类别:

Learn-to-Measure (L2M):学习如何度量与FSL的metric learning不同,L2M方法采用元学习策略来学习相似性度量标准,metric learning是已知损失去极小化损失函数学习度量。

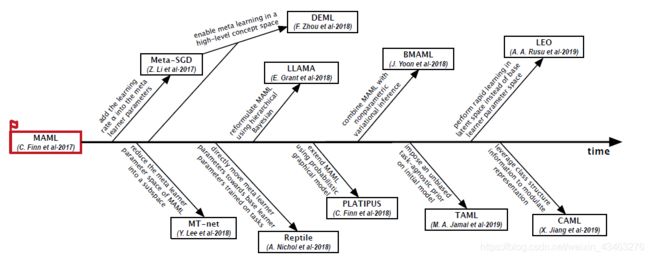

Learn-to-Finetune (L2F):学习如何变得更精细,两个经典方法是MAML与ML LSRTM. 下图为MAML的发展:

Learn-to-Parameterize (L2P):为一个新任务为基础学习者或基础学习者的某些子部分参数化,以便它可以专门解决此任务。元学习器本质上是一个特定于任务的参数生成器。关于学习如何参数化的文献如下:

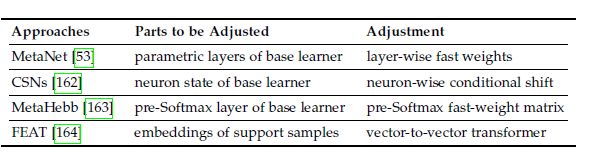

Learn-to-Adjust (L2A):学习调整,如下所示,所调整的不同内容:

Learn-to-Remember (L2R):学会记忆。它的主要思想是将FSL任务的支持样本集建模为序列,并将FSL任务制定为序列学习任务,其中需要查询样本与以前看到的信息(支持样本)匹配。 因此,L2R方法的基础学习者通常需要一个临时网络来处理少量支持样本。几种典型的FSL方法,例如MANN [169],ARC [170],SNAIL [171]和APL [172],都属于L2R。

其他方法:比如多任务方法,添加正则项使得两个任务相似。或者自监督学习利用数据的结构信息作为其自监督来训练网络。

五、其他扩展主题

半监督少样本学习:假定训练集不仅包含NK标记的支持样本,还包含一些属于或不属于C任务的类的未标记的样本。 允许使用半监督训练集来构建FSL系统。框架:

无监督少样本学习:因为收集属于非任务类的未标记辅助集比收集标记数据集更易于实现。

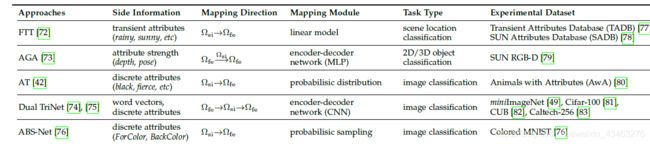

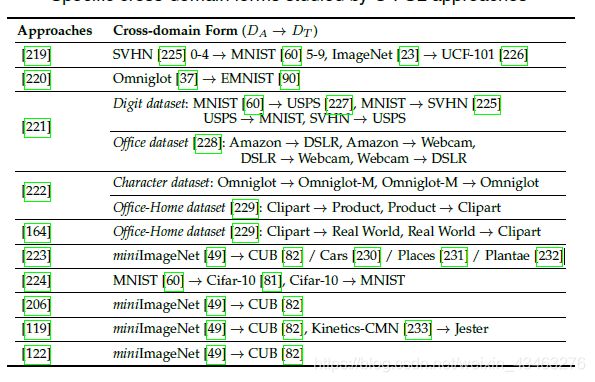

交叉域少样本学习:当要处理的FSL任务来自没有相关辅助样本可用的新颖域时,我们必须利用一些跨域样本作为辅助数据。比如以下表格中给出了辅助学习:

泛化少样本学习:首先为稀疏任务类别扩充训练样本,然后使用原始样本和扩充样本的组合来训练模型。要做到1+1>1的效果。扩充方法可以借鉴上面的数据增强方法。

多模态少样本学习:

多模态匹配:Vanilla FSL寻求从任务模态到硬类标签空间的映射,而M-FSL的多模态匹配旨在学习从一种模态到另一种模态的映射[239],[240],[241]。

例如,给定几个图像句子训练对,要求FSL学习器正确确定描述查询图像的句子[239],[240],或者给定少数语音图像训练对,FSL学习器需要找到正确的句子包含查询语音中说出的单词的可视图像[241]。

多模态融合:

它允许FSL学习器使用来自其他方式的额外信息来帮助学习任务方式。

六、应用

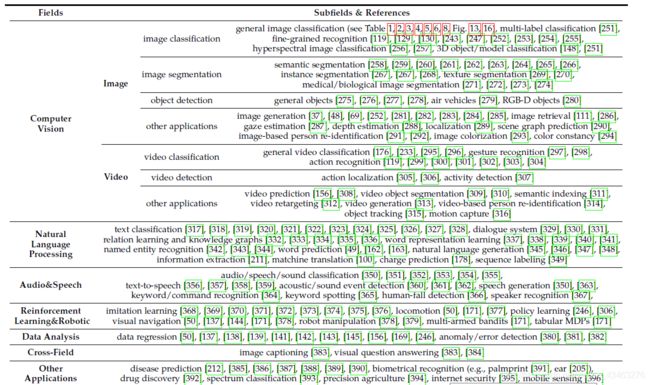

图中给出了相关应用,如计算机视觉,自然语言处理,语音,强化学习,机器人,数据分析,交叉域,以及其他一些应用。

七、未来展望

尽管近年来目睹了FSL在方法和应用上的巨大进步,但由于稀疏样本的内在困难,仍然存在挑战。 我们建议FSL的四个未来发展方向:

1.鲁棒性

2.普遍性:这里提到的普遍性有两层含义。 第一个是FSL方法的模型级通用性和放缩性。

3.理论分析

4.可解释性: 近年来,FSL的激增和成功主要在于深度学习技术,该技术经常因缺乏可解释性而受到批评。