Lexical Simplification with Pretrained Encoders 论文精读

Lexical Simplification with Pretrained Encoders 论文精读

- Information

- Abstract

- 1 Introduction

- 2 Related Work

- 3 Unsupervised Lexical Simplification

-

- 3.1 The BERT model

- 3.2 Simplification Candidate generation

- 3.3 Substitution Ranking

- 3.4 Simplification Algorithm

- 4 Experiments

-

- 4.1 Experiment Setup

- 4.2 Simplification Candidate Generation

- 4.3 FULL LS Pipeline Evaluation

- 4.4 Influence of the Number of Simplification Candidates

- 5 Conclusion

- 6 Acknowledgment

- References[^1]

- 自结

Information

标题: 预训练编码器的词语简化

时间: 2020/10/28

会议: AAAI

作者: Jipeng Qiang1, Yun Li1, Yi Zhu1, Yunhao Yuan1, Xindong Wu2,3

链接: https://arxiv.org/pdf/1907.06226.pdf

Abstract

词语简化(LS)的目的是将句子中的复杂词替换为意义相同的简单词。R:目前的无监督词汇简化方法只依靠复杂词本身而不考虑给定的句子来生成候选替换,这不可避免地会产生大量虚假的候选替换。 R:我们提出了一种简单的LS方法,该方法利用双向编码器表示法(BERT),在生成复杂词的候选替换时,可以同时考虑给定的句子和复杂词。具体地说,我们将原句中的复杂词进行掩盖输入到BERT中,预测被掩盖的词汇。预测的结果将被用作候选替换。 尽管完全无监督,但实验结果表明,与利用语言数据库和并行语料库的基线相比,我们的方法获得了明显的改进,在三个著名的基准上比现有的基准提高了12个百分点以上。

1 Introduction

词语简化(LS)旨在用更简单的替代词替换复杂的词,这可以帮助各种人群,包括儿童(De Belder and Moens2010)、非母语者(Paetzold and Specia2016)、认知障碍者(Feng 2009;Saggion2017)更好地理解文本。 流行的LS系统仍然主要使用一套规则,将复杂单词替换为从精心手工制作的数据库(例如,WordNet)或从可比语料库中自动归纳的常见同义词(Devlin and Tait,1998;de Belder and Moens,2010)。 像WordNet这样的语言数据库被用来产生复杂单词的简单同义词。 (Lesk,1986年;Sinha,2012年;Leroy et al.2013)。 类似维基百科的平行语料库–简单维基百科语料库也被用来提取复杂到简单的单词对应(Biran et al.2011;Yatskar et al.2010;Horn et al.2014)。 然而,语言资源稀缺或生产成本昂贵,如WordNet和简单的维基百科,不可能从中给出所有可能的简化规则。

为了避免对数据库或平行语料库等资源的需求,最近的工作利用词嵌入模型来提取复杂词的简化候选词(Glavaéhics and Hichastajner2015;Paetzold and Specia2016;Paetzold and Specia2017a)。 在给定一个复杂词的情况下,从词嵌入模型中提取出向量在余弦相似度方面与该复杂词更接近的简化候选词。 与基于规则的LS系统相比,该策略取得了更好的效果。 然而,上述方法 只考虑复杂词而不考虑复杂词的上下文来生成简化候选词,这不可避免地会产生大量的虚假候选词,给后续步骤所采用的系统带来混乱。

因此,本文提出了一种与现有LS系统完全不同的直观和创新的思想。 我们利用预训练变压器语言模型Bert(Devlin et al.2018)的最新进展,为复杂单词找到合适的简化。 Bert中使用的掩码语言模型(MLM)随机部分掩码输入的词汇,并根据其上下文预测掩码词。 如果在句子中掩蔽复杂词,则MLM中的思想与LS中生成复杂词候选项的思想是一致的。 因此,我们提出了一种新的LS方法BERT-LS,该方法利用BERT的MLM进行简化候选生成。 更具体地说,我们将原句S中的复杂词W屏蔽后作为新句S’,并将原始序列S和S’串联起来,输入到BERT中,得到被屏蔽词对应的词汇的概率分布。 我们的方法的优点是,它通过考虑整个句子而不仅仅是复杂单词来生成简化候选词。

这里,我们给出了一个如图1所示的例子来说明我们的BERT-LS方法的优点。 对于“John composited these verses . ”句子中的复杂词“composited”和“verses”,基于词嵌入的LS系统(Glava Hixs and Hixistajner 2015;Paetzold and Specia 2017a)生成的两个复杂词的前三个替换候选词只与复杂词本身相关,而不关注原句。 BERT-LS生成的前三个替换候选词不仅与复杂词相关,而且与原句的匹配性也很好。 然后,通过考虑每个候选词出现的频率或顺序,我们可以很容易地选择“wrote”代替“composed”,选择“poems”代替“verses”。 在这种情况下,简化句“John wroted these poems。”比原句更易理解。

本文的贡献如下:

(1)BERT-LS是一种新的基于BERT的LS方法,它可以充分利用BERT的优点来生成替换候选词并对其进行排序。 与现有的方法相比,BERT-LS在生成候选词时考虑的是 整个句子而不是复杂词本身,因此更容易把握句子的衔接和连贯。

(2)BERT-LS是一种 简单、有效、无监督 的LS方法。 1)简单:我们的方法省去了现有LS系统中的许多步骤,如形态变换和替换选择。 2)有效:它在三个基准上获得了最新的结果。 3)无监督:我们的方法不依赖任何平行语料库或语言数据库。

(3)据我们所知,这是 首次尝试 将预训练的Transformer语言模型应用于词语简化任务。 重现结果的 代码 可在https://github.com/qiang2100/BERT-LS获得。

2 Related Work

词语简化(LS)包括识别复杂词和找到这些复杂词的最佳候选替换(Shardlow 2014;Paetzold and Specia,2017b)。 最好的替换需要在保留句子语法和尽可能保持其意义的同时更加简单化,这是一项非常具有挑战性的任务。 流行的词语简化(LS)方法是基于规则的,每个规则包含一个复杂的词及其简单的同义词(Lesk,1986;Pavlick and Callison-Burch,2016;Maddela and Xu,2018)。 为了构造规则,基于规则的系统通常从WordNet中为一组预定义的复杂单词识别同义词,并根据单词的频率(Devlin and Tait 1998;de Belder and Moens 2010)或单词的长度(Bautista et al.2011)从这些同义词中选择“最简单的”。 然而,基于规则的系统需要大量的人工参与来手工定义这些规则,不可能给出所有可能的简化规则。

随着复杂和简化的平行语料库的出现,特别是“普通”英语维基百科(EW)和“简单”英语维基百科(SEW)的结合,LS系统的范式转变是从基于知识的简化到数据驱动的简化(Biran et al.2011;Yatskar et al.2010;Horn et al.2014)。 亚茨卡尔等人(2010)从SEW的编辑历史中识别词汇简化。 他们使用了一种概率方法来识别简化编辑,以区别于其他类型的内容更改。 比兰等人(2011)将EW和SEW中的每一对不同的词作为一个可能的简化对,并基于形态变体和WordNet对其中的一部分进行了过滤。 霍恩等人(2014)还从EW和SEW中生成候选规则,并采用上下文感知的二分类器来决定在特定上下文中是否应该采用候选规则。这些方法类型的主要局限性很大程度上依赖于简化的语料库。

为了完全避免对词汇资源或平行语料库的需求,提出了基于词嵌入的LS系统(Glavaés and Stajneró2015)。 他们提取了前10个词作为候选替换词,这些词的向量在余弦相似度方面与复杂词更接近。 Paetzold和Specia(2016)不采用传统的词嵌入模型,而是采用了在大型数据集中训练的上下文感知词嵌入,其中每个词都用POS标记进行注释。 之后,他们通过将单词嵌入与WordNet和平行语料库相结合来进一步提取复杂单词的候选词(Paetzold and Specia,2017a)。

在研究了现有的基于规则的LS方法和基于嵌入的LS方法后,主要的挑战是它们为复杂词生成简化候选词而不考虑复杂词的上下文,这将不可避免地产生大量的虚假候选词,从而扰乱后续步骤中使用的系统。

在本文中,我们将首先提出一种基于Bert的LS方法,它只需要足够大的规则文本语料库,而不需要任何人工操作。 预训练语言模型(Devlin et al.2018;Lee et al.2019;Lample and Conneau2019)引起了广泛的关注,并被证明能够有效地改善许多下游自然语言处理任务。 我们的方法利用了Bert的最新进展,为复杂的单词生成合适的简化。 我们的方法通过考虑整个句子来生成复杂词的候选词,这样更容易保持句子的衔接和连贯。 在这种情况下,我们的方法取消了现有步骤中的许多步骤,如形态变换和替换选择。 由于它的基本性质,我们的方法可以适用于许多语言。

3 Unsupervised Lexical Simplification

在这一节中,我们简要地总结了Bert模型,然后描述我们如何扩展它来进行词语简化。

3.1 The BERT model

Bert(Devlin et al.2018)是在一个掩码语言建模(MLM)目标上训练的,该目标是一个马尔可夫随机场语言模型在一组具有伪对数似然的离散令牌上的组合(Wang and Cho2019)。 与传统语言建模的目标不同,传统语言建模的目标是在给定历史的情况下预测序列中的下一个单词,掩码语言建模的目标是在给定左右上下文的情况下预测一个单词。 设S=W1,…,WL,…,WL是一组离散的令牌,WL∈V,其中V={V1,…,VM}是词汇表。 给定序列x的联合概率分布可以通过以下方法计算:

其中φL(w)是带参数θ的第L个势函数,Z是配分函数。

第L个词的log势函数由以下定义:

其中WL是第L个词的ont-hot向量,并且S\L=(W1,…,WL-1,[掩码],WL+1,…,WL)

函数F(S\l)∈RM是一个多层双向变压器模型(Vaswani et al.2017)。 详见(Devlin et al.2018)。 该模型被训练成近似最大化伪对数似然

其中D是一组训练示例。 在实践中,我们可以通过抽样令牌和训练句子来随机优化logloss(由F函数预测的softmax计算)。

此外,Bert还使用了一个“下一个句子预测”任务,该任务联合对文本对表示进行预训练。 Bert通过在每个句子之前加上一个特殊的分类标记[CLS],以及用一个特殊的分隔符标记组合句子来实现这一点[SEP]。 与[CLS]令牌相对应的最终隐藏状态被用作总序列表示,我们从中预测分类任务的标签,否则可能会被忽略。

3.2 Simplification Candidate generation

简化候选生成用于产生每个复杂单词的候选替换。 根据掩码语言建模(MLM)的基本性质,我们对句子S中的复杂词W进行了掩码,并利用MLM得到了掩码词W对应的词汇P(·S{W})的概率分布。 因此,我们可以尝试使用MLM进行简化候选人生成。

对于句子S中的复杂词W,我们将掩盖W的S作为一个新的序列S。 如果直接将S输入到MLM中,则复杂词W对应的词汇P(·S’{ti})的概率只考虑上下文,而不考虑复杂词W的影响。

由于Bert采用了“下一个句子预测”,所以他擅长处理句子对。 我们将原始序列S和S’串联成一个句子对,并将句子对S,S输入到BERT中,得到掩码词对应的词汇P(·S,S{W})的概率分布。 这样,掩码词对应的P(·S,S{W})中的高概率词既考虑了复词本身,又能拟合复词的上下文。 最后,我们从p(·s,s{w})中选出前10个词作为简化候选词,不包括w的形态学派生。 在所有实验中,我们使用Bookscorpus和英语Wikipedia1上预先训练的Bert-Large,Uncased(整词掩蔽)。

假设有一个句子“the cat perched on the mat”和复杂词“perched”,我们可以得到前三个简化候选词“sat,seated,hopped”。 请参见图2的插图。 我们可以看出,这三个候选词不仅与复杂词有很强的相关性,而且都具有句子的衔接和连贯性质。 如果我们采用现有的基于词嵌入的最先进的方法(GlavaésandésTajner,2015年),前三个替代词是“atop, overlooking, precariously ”。 很明显,我们的方法产生了更好的候选词。

3.3 Substitution Ranking

词汇简化流水线的替换排序是为了决定适合复杂单词上下文的候选替换中哪一个是最简单的(Paetzold and Specia,2017b)。 我们根据以下特征对候选替换进行排序。 每个特征捕捉候选词替换复杂词的适宜性的一个方面。

BERT预测。 在简化候选生成的这一步中,我们得到了掩码词P(·s,s{w})所对应的词汇量的概率分布。 概率越高,候选词与原句越相关。 可以根据其概率对候选替换进行排序。

语言模型特征。 一个简化候选词应该符合原词前后的单词序列。 不同的N-gram语言模型,我们不能用MLM计算一个句子或词序的概率。 设w=w-m,…,w-1,w,w1,…,wm是原始单词w的上下文。 我们采用了一种新的策略来计算W的可能性,我们首先将原来的W替换为简化候选词。 然后我们从前到后屏蔽一个单词,并输入到MLM中计算交叉熵损失。 最后,我们根据W的平均损失对所有简化候选词进行排序,损失越低的简化候选词是对原词的很好的替代。 我们在复杂单词周围使用大小为5的对称窗口作为上下文。

语义相似度。 该特征被计算为原始单词的FastText2向量和候选替换的FastText向量之间的余弦。 相似度越高,说明两个词越相似。

频率特征。 基于频率的候选排序策略是词汇简化中最受欢迎的选择之一,并且是非常有效的。 一般来说,一个词使用的频率越高,读者对它的熟悉程度就越高。 我们使用来自维基百科3和儿童读物测试(CBT)4的词频估计。 由于维基百科的大小比CBT大,我们只选择维基百科的前1200万文本来匹配大小。

3.4 Simplification Algorithm

整体简化算法BERT-LS如算法1所示。 在本文中,我们并不专注于识别复杂词(Paetzold和Specia2017b),这是一个单独的任务。 对于每个复杂词,我们首先在预处理原始序列(第1-4行)后使用BERT得到简化候选词。 然后,Bert-LS使用每个特征为每个简化候选计算各种排名,然后通过平均每个候选的所有排名来给每个候选打分(第5-13行)。 我们选择所有特征中平均排名最高的候选项作为简化替换(第15行)。

4 Experiments

我们设计实验来回答以下问题:

Q1. 简化候选的有效性: Bert-LS的简化候选生成是否优于现有竞争对手的替代生成?

Q2. LS系统的有效性: Bert-LS的完整管道是否优于最先进的竞争对手的完整管道?

4.1 Experiment Setup

数据集。 我们使用三个广泛使用的词法简化数据集来做实验。

(1)LexmTurk5(Horn et al.2014)。 它由500个英语实例组成。 每个实例包含一个来自维基百科的句子、一个目标复杂词和50个由50个亚马逊机械“Turkers”注释的替换。 由于每个实例的每个复杂单词都是由50个Turkers注释的,所以这个数据集拥有一个很好的黄金简化覆盖面。

(2)BenchLS 6(Paetzold and Specia 2016)。它由来自 LexMTurk 和 LSeval (De Belder and Moens 2010)的929个英语实例组成。LSeval 包含429个实例,其中每个复杂的单词由46个 Turkers 和9个博士生注释。因为 BenchLS 包含两个数据集,所以它提供了在 LS 数据集中最大范围的不同复杂单词。

(3)Nnseval 7(Paetzold and Specia 2017b)。 它由英语的239个实例组成,是Benchls的过滤版本。 这些基准的实例被删除:1)实例中的目标复合词不被非英语母语者视为复合词;2)实例中的任何候选词都被非英语母语者视为复合词。

注意,由于这些数据集已经提供了被人类注释者认为是复杂的目标词,所以我们在评估中没有处理复杂词识别任务。

比较系统。 我们选择以下八个基线进行评估:Devlin(Devlin and Tait 1998),Biran(Biran et al.2011),Yamamoto(Kajiwara et al.2013),Horn(Horn et al.2014),Glavaixys(Glavaixys and Hichistajner 2015),SimplePpdb(Pavlick and Callison-Burch 2016),Paetzoldca(Paetzold and Specia 2016),Paetzold-ne(Paetzold and Specia 2017a)。 这些基线的替换生成策略从WordNet、EW和SEW平行语料库、Merriam词典、EW和SEW平行语料库、词嵌入、上下文感知词嵌入中生成候选词,并结合Newsela平行语料库和上下文感知词嵌入。

4.2 Simplification Candidate Generation

以下三个广泛使用的度量标准用于评估(Paetzold and Specia2015;Paetzold and Specia2016)。

精确度: 在黄金标准中生成的候选人的比例。

召回率: 包含在生成的替换中的黄金标准替换的比例。

F1: 精确度和召回率之间的调和平均值。

结果如表1所示。 LEXMTURK基线的结果来自(Paetzold和SPECIA2017b),基准和NNSEVAL的结果来自(Paetzold和SPECIA2017a)。 可以看到,尽管完全无监督,我们的模型BERT-LS在三个数据集上获得了F1分数大大超过了以前的最佳基线。 将Newsela平行语料库和上下文感知词嵌入相结合的基线Paetzold-NE在精度度量上取得了较好的结果,说明替换生成往往受益于不同资源的组合。 但是,对于资源不足的语言,我们的方法仍然可能创建有竞争力的候选生成词。 结果清楚地表明,BERT-LS在使用BERT对原始文本时提供了很好的F1。

我们还提出了简化候选的定性评价。 我们从LexmTurk中随机选取10个短句作为例子。 表2显示了三种方法产生的前六名候选人。 我们选择最先进的基于两个基线的词嵌入(Glavaés(Glavaés)和Paetzold-ne(Paetzold和Specia2017a))作为比较。 标签中存在的候选人(由人注释)以粗体突出显示。

从表2中,我们观察到,与基于两个基线的词嵌入相比,Bert-LS实现了对复杂词的最佳简化候选。 基线产生了大量的虚假候选项,因为它们只考虑复合体和候选项之间的相似性,而不考虑复合词的上下文。 BERT-LS生成的候选词不需要进行形态变换,就能保持句子的衔接和连贯。

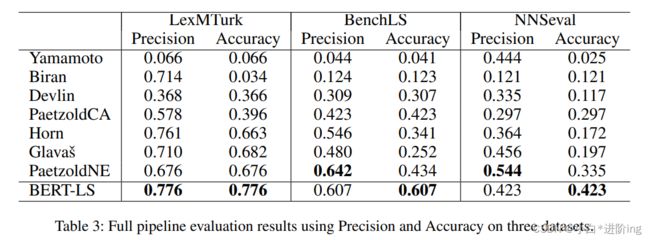

4.3 FULL LS Pipeline Evaluation

在这一节中,我们评估了各种完全LS系统的性能。 我们采用这些工作中使用的以下两个众所周知的度量标准(Horn et al.2014;Paetzold and Specia2017b)。

精确度: 原词替换为原词本身或在金标准中的比例

准确度: 原字替换不是原字,在金标准中的比例。

结果如表3所示。 LEXMTURK基线的结果来自(Paetzold和SPECIA2017b),基准和NNSEVAL的结果来自(Paetzold和SPECIA2017a)。 我们可以看到,我们的BERTLS方法在三个数据集上都达到了最高的精度,比以前的最先进的基线(Paetzold-NE)平均提高了12%。 这表明Bert-LS在促进简单性方面是最精通的。 Paetzold-NE在Benchls和Nnseval上的精确度都高于Bert-Ls,这意味着由于平行语料库中简化规则的不足,两个数据集中的许多复杂词都被原词本身所取代。 总之,即使BERT-LS只使用原始文本进行预训练,而不使用任何资源,BERT-LS仍然是最好的词语简化方法。

4.4 Influence of the Number of Simplification Candidates

在这一部分中,我们试图研究简化候选个数对Bert-LS算法性能的影响。 候选个数分别从1到15个不等。 图3显示了在三个基准上,在不同候选数量的情况下,简化候选(精确度、查全率和F1)和完整LS管道(精确度)的性能。 随着候选个数的增加,精确率下降,召回率上升,F1先上升后下降。 在实验中,为了在精确率和召回率之间取得好的平衡,将候选数设置为7~11,从而获得了最佳的简化候选性能。 整个LS流水线的精确度先增加,最后收敛,这意味着整个LS方法对候选数的敏感性较低。

5 Conclusion

我们利用Bert语言模型的掩码思想,提出了一种简单的基于Bert的词法简化方法。 该方法在生成候选替换词时考虑了复杂词和复杂词的上下文,而不依赖于平行语料库或语言数据库。 实验结果表明,我们提出的BERT-LS算法在三个已知的基准上都取得了最好的性能。 由于Bert可以在原始文本上训练,我们的方法可以应用于许多语言的词语简化任务上。

F:我们的方法的一个局限性是它只能生成复杂词的单个单词的替换,但我们计划扩展它以支持多词表达式。 将来,我们可以用简单的英语语料库对预训练的Bert模型进行微调,然后用微调后的Bert模型进行词语简化。

6 Acknowledgment

本研究得到了国家重点研发计划2016YFB1000900项目的部分资助; 国家自然科学基金资助61703362和91746209; 教育部长江学者和高校创新研究团队计划,资助项目IRT17R32; 江苏省自然科学基金项目BK20170513。

References1

[Bautista et al. 2011] Susana Bautista, Carlos Le´on, Raquel Herv´as, and Pablo Gerv´as. Empirical identification of text simplification strategies for reading-impaired people. In European Conference for the Advancement of Assistive Technology, pages 567–574, 2011.

[Biran et al. 2011] Or Biran, Samuel Brody, and No´emie Elhadad. Putting it simply: a context-aware approach to lexical simplification. In ACL, pages 496–501, 2011.

[De Belder and Moens 2010] Jan De Belder and MarieFrancine Moens. Text simplification for children. In SIGIR Workshop, pages 19–26, 2010.

[Devlin et al. 2018] Jacob Devlin, Ming-Wei Chang, Kenton Lee, and Kristina Toutanova. Bert: Pre-training of deep bidirectional transformers for language understanding. In NAACL, 2018.

[Feng 2009] Lijun Feng. Automatic readability assessment for people with intellectual disabilities. ACM SIGACCESS accessibility and computing, (93):84–91, 2009.

[Glavaˇs and ˇStajner 2015] Goran Glavaˇs and Sanja Stajnerˇ . Simplifying lexical simplification: do we need simplified corpora? In ACL, pages 63–68, 2015.

[Horn et al. 2014] Colby Horn, Cathryn Manduca, and David Kauchak. Learning a lexical simplifier using wikipedia. In ACL (Short Papers), pages 458–463, 2014. [Kajiwara et al. 2013] Tomoyuki Kajiwara, Hiroshi Matsumoto, and Kazuhide Yamamoto. Selecting proper lexical paraphrase for children. In ROCLING, pages 59–73, 2013.

[Lample and Conneau 2019] Guillaume Lample and Alexis Conneau. Cross-lingual language model pretraining. arXiv preprint arXiv:1901.07291, 2019.

[Lee et al. 2019] Jinhyuk Lee,Wonjin Yoon, Sungdong Kim, Donghyeon Kim, Sunkyu Kim, Chan Ho So, and Jaewoo Kang. Biobert: pre-trained biomedical language representation model for biomedical text mining. arXiv preprint arXiv:1901.08746, 2019.

[Leroy et al. 2013] Gondy Leroy, James E Endicott, David Kauchak, Obay Mouradi, and Melissa Just. User evaluation of the effects of a text simplification algorithm using term familiarity on perception, understanding, learning, and information retention. Journal of medical Internet research, 15(7):e144, 2013.

[Lesk 1986] Michael Lesk. Automatic sense disambiguation using machine readable dictionaries: How to tell a pine cone from an ice cream cone. In Proceedings of the 5th Annual International Conference on Systems Documentation, SIGDOC ’86, pages 24–26, New York, NY, USA, 1986. ACM. [Maddela and Xu 2018] Mounica Maddela and Wei Xu. A word-complexity lexicon and a neural readability ranking model for lexical simplification. In EMNLP, pages 3749– 3760, 2018.

[Paetzold and Specia 2015] Gustavo Paetzold and Lucia Specia. Lexenstein: A framework for lexical simplification. In Proceedings of ACL-IJCNLP 2015 System Demonstrations, pages 85–90, 2015.

[Paetzold and Specia 2016] Gustavo H Paetzold and Lucia Specia. Unsupervised lexical simplification for non-native speakers. In AAAI, pages 3761–3767, 2016. [Paetzold and Specia 2017a] Gustavo Paetzold and Lucia Specia. Lexical simplification with neural ranking. In Proceedings of the 15th Conference of the European Chapter ofthe Association for Computational Linguistics: Volume 2, Short Papers, pages 34–40, 2017.

[Paetzold and Specia 2017b] Gustavo H Paetzold and Lucia Specia. A survey on lexical simplification. In Journal of Artificial Intelligence Research, volume 60, pages 549–593, 2017.

[Pavlick and Callison-Burch 2016] Ellie Pavlick and Chris Callison-Burch. Simple ppdb: A paraphrase database for simplification. In Proceedings of the 54th Annual Meeting ofthe Association for Computational Linguistics (Volume 2: Short Papers), pages 143–148, 2016.

[Saggion 2017] Horacio Saggion. Automatic text simplification. Synthesis Lectures on Human Language Technologies, 10(1):1–137, 2017. [Shardlow 2014] Matthew Shardlow. A survey of automated text simplification. International Journal ofAdvanced Computer Science and Applications, 4(1):58–70, 2014.

[Sinha 2012] Ravi Sinha. Unt-simprank: Systems for lexical simplification ranking. In In Proceedings ofthe 1st SemEval, pages 493–496. Association for Computational Linguistics, 2012.

[Vaswani et al. 2017] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser, and Illia Polosukhin. Attention is all you need. In Advances in neural information processing systems, pages 5998–6008, 2017.

[Wang and Cho 2019] AlexWang and Kyunghyun Cho. Bert has a mouth, and it must speak: Bert as a markov random field language model. arXiv preprint arXiv:1902.04094, 2019.

[Yatskar et al. 2010] Mark Yatskar, Bo Pang, Cristian Danescu-Niculescu-Mizil, and Lillian Lee. For the sake of simplicity: Unsupervised extraction of lexical simplifications from wikipedia. In NAACL, pages 365–368, 2010.

自结

总的来说就是当前词语简化生成候选项时仅仅考虑复杂词本身而不考虑整个句子,导致会产生很多虚假候选词,本文利用bert的MLM及下一句预测:利用原句+原句复杂词掩盖输入进bert模型当中,生成候选词,对候选词从多个性能进行综合排序最终输出最优替换,结果均优于之前的嵌入式方法。

扬州大学研一在读学生,本篇笔记仅以帮助自己更好理解论文,也方便日后复查学习。 ↩︎