【CVPR2020图像超分辨率】Cross-Scale Non-Local Attention / CSNLN 阅读笔记

Image Super-Resolution with Cross-Scale Non-Local Attention and Exhaustive Self-Exemplars Mining

本文介绍的是发表在CVPR2020的一篇关于图像超分辨率的文章,其核心是跨尺度非局部注意力机制。

上上周在实验室seminar介绍了这篇文章,为了加强记忆,准备写一篇笔记。

paper:Image Super-Resolution with Cross-Scale Non-Local Attention and Exhaustive Self-Exemplars Mining

code: Cross-Scale-Non-Nocal-Attention

Background

现有的基于非局部注意力机制的方法如RCAN、SAN,都只探索了统一尺度的特征,而忽略了不同尺度间的丰富信息,造成重建结果相对较差。

那么,什么是Cross-Scale呢?

一般来说,在做单图像超分辨率时,我们会将注意力集中在LR图像上,也就是说,我们想尽可能地利用这个LR图像提供的信息,跟LR死磕,这就是Single-Scale;而Cross-Scale的思想是,我们别只盯着LR看了,看看别的吧!于是乎,我们将LR做下采样,希望该下采样的结果和LR之间的相对关系也能为HR的重建提供信息。(之后会细讲)

Introduction

自然图像中广泛存在跨尺度的块相似性,也就是说除了计算与本尺度内其他像素的相似度以外,像素还可以与更大的图像块做匹配。 自然的跨尺度特征对应关系使我们可以直接从LR图像中搜索高频细节,从而实现更加真实,更加准确的重建。

论文主要有以下三点贡献:

1️⃣提出了用于SISR任务的第一个跨尺度非局部(CS-NL)注意力模块,计算图像内部的像素到块以及块到块的相似性,实验证明挖掘跨尺度自相似性可以极大地提高SISR性能。

2️⃣ 提出了一个强大的SEM单元,在单元内部,通过结合局部,尺度内非局部和跨尺度非局部特征相关性,尽可能挖掘更多的的先验信息。

3️⃣该网络在多个图像基准数据集上达到了最佳性能。文章末尾的消融实验进一步验证了该新型网络的有效性。

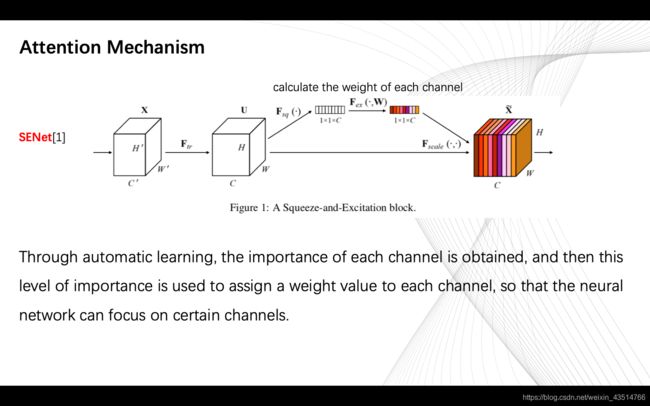

Attention Mechanism

In recent years, there is an emerging trend of applying non-local attention mechanism to solve various computer vision problems. In general, non-local attention in deep CNNs allows the network to concentrate more on informative areas.

下图是注意力机制在卷积神经网络中的一种体现——通道注意力,来自SENet文章。

在计算注意力之前,各通道的权重是相同的,在颜色上看来,都是白色;在加上注意力后,根据重要程度,每个通道被赋予不同的权重,在图上看来,每个通道用不同的颜色表示。

Method

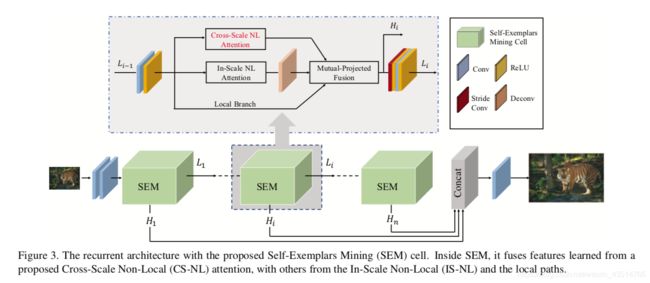

总的网络结构如下图所示。本质上是一个递归神经网络,每个递归单元称为自样本挖掘模块(SEM),它们完全融合了局部,规模内非局部以及新提出的跨尺度非局部(CS-NL)信息。

CS-NL Attention Module

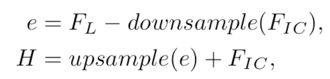

该模块的核心公式:

X:特征图;大小为原始低分辨率图像大小。

Y:下采样后的特征图。

自己画了一个草图来理解(拙劣)

对草图的简要说明:

红色的小方块儿是pxp(p是可调参数)尺寸的,举个例子,如果我们想重建X中的红色小方块的部分(target),首先我们在X的下采样结果Y中搜寻与该target接近的小块儿(不止一个,为了方便,只画了一个,实际上应该是多个结果进行加权),Y中的小块就是与target接近的小块,此时,我们在X中找到对应该小块的“大”块,就是蓝色这块;最后,用蓝色块中的信息辅助重建目标块——SR中的紫色块。(不知道说没说明白,语言表达能力太差)

再看看公式:

黄框里的部分就实现的块匹配(patch-matching),计算各小块的权重。

黄框外的部分就是用得到的权重将原始图映射到目标尺寸,得到重建后的图。

Self-Exemplars Mining (SEM) Cell

这一模块的结构如下图所示。

Local Branch不对Li-1做任何操作,直接搬过来;Cross-Scale NL Attention上一部分已经说了;In-Scale NL Attention计算的是特征图内像素间的非局部相似性。Mutual-Projected Fusion块将三部分的特征进行融合,融合方法见下图。

残差特征RIC表示一个来源中存在而另一来源中不存在的细节。 这种残差间的投影使网络绕过共有信息,仅关注不同源之间的特殊信息,从而提高了网络的判别能力。同时加入了反投影的思路,Mutual-Projected Fusion结构可确保在融合不同特征的同时进行残差学习,与琐碎的加法(adding)或串联(concatenating)操作相比,该融合方法可进行更具判别性的特征学习。

Recurrent Framework

Experiments

训练数据集:DIV2K(800)

测试数据集:Set5, Set14, B100, Urban100, and Manga109

SEM:12个

p = 3

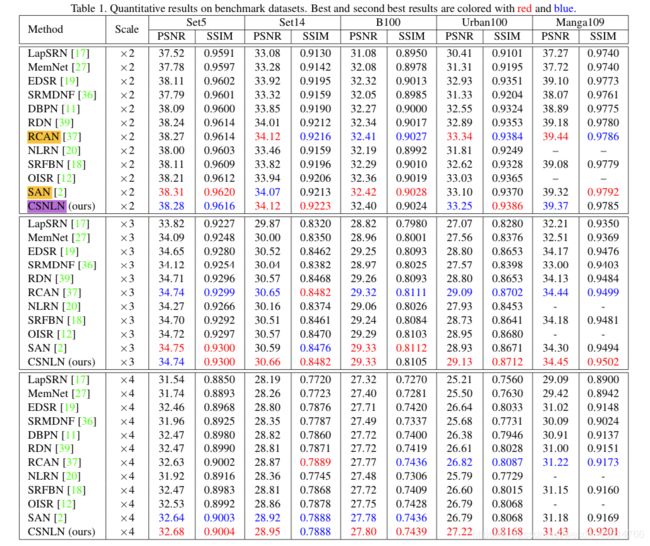

Comparisons with State-of-the-arts

可以看出,与之前的方法相比,CSNLN在各个测试集取得了几乎最好的结果,随着scale增大,CSNLN的表现更好。

(表现较好的这几种方法都用了注意力机制诶嘿嘿)

从上图可以看出,CSNLN对于有较多重复纹理结构的图像有着非常好的重建效果。

Ablation study

Cross-Scale v.s. In-Scale Attention

尺度内注意力仅关注值(intensity)相似的像素,但缺乏相似结构的使用。尺度间注意力可通过充分利用特征中的尺度间重复结构来指导重建(每组图的第三列,相似的结构在特征图中体现出来了)。

Conclusion

作者提出了用于图像超分辨率深度网络的第一个跨尺度非局部(CS-NL)注意力模块。 利用新颖的模块,我们能够充分发现自然图像中广泛存在的跨尺度特征相似性。 通过将其与本地和先前的规模内非局部先验信息融合在一起,同时包含网络学习到的大量外部信息。CSNLN在基准数据集上取得了很好的结果!完毕。

♀️