【论文阅读】DeepGCNs: Can GCNs Go as Deep as CNNs?

【论文阅读】DeepGCNs: Can GCNs Go as Deep as CNNs?

-

- 1. Introduction

- 2. Methodology

-

- 2.1 图上的表征学习

- 2.2 Residual Learning for GCNs

- 2.3 Dense Connections in GCNs

- 2.3 Dilated Aggregation in GCNs

- 3. Experiment

-

-

- Ref.

-

图卷积神经网络(Graph Convolutional Neural networks, GCNs)用于表征非欧几里得空间(non-Euclidean)的数据。但由于梯度消失问题,GCNs的层数通常不深,感知域范围有限,本文提出了一种训练更深GCNs的方法。

1. Introduction

GCN现阶段被广泛应用于social networks、drug discovery、recommendation engines、点云分割、NLP等领域的数据。由于存在梯度消失问题,GCNs的深度通常不超过4层。

对于CNN,ResNet、DenseNet等是能够有效加深网络深度、减弱梯度消失问题的网络结构。本文借鉴CNN中的residual connection、dense connection、dilated convolution(增大感知域) 等结构加深GCN的网络层数,将其增加到了56层。

2. Methodology

2.1 图上的表征学习

图结构被表征为 G = ( V , E ) \mathcal{G=(V,E)} G=(V,E),其中, V \mathcal{V} V 表示无序顶点集合 v ∈ V v\in \mathcal {V} v∈V, E \mathcal{E} E 表示节点的集合 e i , j ∈ E e_{i,j}\in \mathcal E ei,j∈E,其中 e i , j e_{i,j} ei,j表示顶点 v i v_i vi、 v j v_j vj之间的边

- Graph Convolutional Networks

令图的每个节点 v v v 对应一个特征向量 h v ∈ R D h_v\in \mathbb R^D hv∈RD,因此,整个图 G \mathcal G G 可以表达为: h G = [ h v 1 , h v 2 , … , h v N ] T ∈ R N × D h_{\mathcal G}=[h_{v_1}, h_{v_2}, \dots,h_{v_N}]^T\in \mathbb R^{N\times D} hG=[hv1,hv2,…,hvN]T∈RN×D,其中, N N N表示节点数量。第 l l l 层的卷积操作 F \mathcal F F 可以表示为:

其中, G l = ( V l , E l ) \mathcal {G_l = (V_l, E_l)} Gl=(Vl,El) 表示 l l l 层输入, G l + 1 = ( V l + 1 , E l + 1 ) \mathcal {G_{l+1} = (V_{l+1}, E_{l+1})} Gl+1=(Vl+1,El+1) 表示 l l l 层输出, W l a g g \mathcal W_l^{agg} Wlagg表示aggregation函数的可学习参数, W l u p d a t e \mathcal W_l^{update} Wlupdate表示update函数的可学习参数。

aggregation函数用于整合节点邻域的信息,包括mean aggregator、max-pooling aggregator、attention aggregator、LSTM aggregator等;update函数用于对整合的信息进行非线性变换进而计算得到新的节点,包括MLP(multi-layer perceptron)、gated network等。

(1)式过程可以具体写作:

其中, ρ \rho ρ 表示aggregation函数, ϕ \phi ϕ表示update函数, h v l h_{v_l} hvl表示第 l l l层的特征表达, N ( v l ) \mathcal N(v_l) N(vl)表示第 l l l 层节点 v v v 的邻居节点, h u l h_{u_l} hul即为这些邻居节点的表征,且使用参数 W ρ \mathcal W_{\rho} Wρ 来刻画领域关系。 W ϕ \mathcal W_{\phi} Wϕ 表示update函数的参数。

在本文中,使用max-pooling对节点特征进行整合,该整合方式没有需要学习的参数: ρ ( ⋅ ) = m a x ( h u l − h v l ∣ u l ∈ N ( v l ) ) \rho(\cdot)=max(h_{u_l}-h_{v_l}|u_l\in \mathcal N(v_l)) ρ(⋅)=max(hul−hvl∣ul∈N(vl))。update函数采用MLP+BN(batch normalization)+ReLU实现。

- Dynamic Edges

大多数GCNs都使用固定的图结构,但是相关工作表明动态的图卷积能够获得更好的图表征,即图结构在每个层都是可以变化的。

本文提出在每层的feature space都重新计算节点之间的边联系,采用Dilated K-NN方法,其中,Dilated可以增加感知域大小。

2.2 Residual Learning for GCNs

采用residual结构来增加网络的深度,减少梯度消失问题。与公式(1)相比,residual 结构对应的函数为:

相较于公式(1),增加了 ( + G l ) (+\mathcal G_l) (+Gl) 的环节实现residual结构。

2.3 Dense Connections in GCNs

DenseNet提出使用层与层之间的dense connectivity来增加网络内部的信息流动、促进特征的重复利用。本文将DenseNet的思想应用到GCNs中:

其中, T \mathcal T T表示将输入图 G \mathcal G G 和GCN所有层的输出相连,则 G l + 1 \mathcal G_{l+1} Gl+1与前面的所有层输出相连。

2.3 Dilated Aggregation in GCNs

本文使用Dilated k-NN来找到每个GCN层每个节点的dilated neighbors。对于图 G = ( V , E ) \mathcal {G=(V, E)} G=(V,E),设置dilation rate为 d d d,那么Dilated k-NN会在 k × d k\times d k×d范围内返回间隔为 d d d的 k k k个最近邻,近邻的计算可以采用 l 2 \mathcal l_2 l2范数。

令 N ( d ) ( v ) \mathcal N^{(d)}(v) N(d)(v)表示节点 v v v的d-dilated邻居, ( u 1 , u 2 , … , u k × d ) (u_1, u_2, \dots, u_{k\times d}) (u1,u2,…,uk×d)为按序排列好的 k × d k\times d k×d个最近邻,则 N ( d ) ( v ) \mathcal N^{(d)}(v) N(d)(v)表示为:

![]()

新的输出图的边集 E ( d ) \mathcal E^{(d)} E(d)定义在d-dilated vertex neighbor N ( d ) ( v ) \mathcal N^{(d)}(v) N(d)(v)上。具体地,节点 v v v 和节点 u ∈ N ( d ) ( v ) u\in \mathcal N^{(d)}(v) u∈N(d)(v)之间存在边 e ∈ E ( d ) e\in \mathcal E^{(d)} e∈E(d)。然后使用GCN aggregation函数和update函数进行处理。

在使用dilation时,本文进一步采用了stochastic dilation,以 ( 1 − ϵ ) (1-\epsilon) (1−ϵ)概率进行上面地dilated convolution,以 ϵ \epsilon ϵ概率在集合 ( u 1 , u 2 , … , u k × d ) (u_1, u_2, \dots, u_{k\times d}) (u1,u2,…,uk×d)随机采样 k k k个邻居构成k近邻集合。

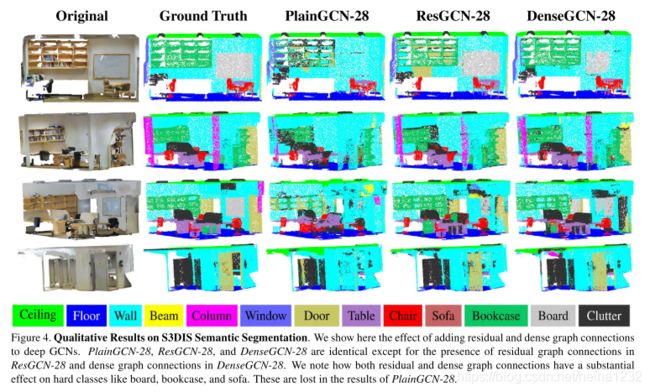

3. Experiment

在点云分割数据集上进行实验,把每个点云中的点看作图中的一个节点,采用GCN进行点云中每个点的分类,得到最终的分割结果。

Ref.

Li G, Muller M, Thabet A, et al. Deepgcns: Can gcns go as deep as cnns?[C]//Proceedings of the IEEE International Conference on Computer Vision. 2019: 9267-9276.