谷粒商城之高级篇知识补充

谷粒商城高级篇之知识补充

前言

本篇主要是完成谷粒商城高级篇开发时,我们需要了解并学习一部分补充的知识,才能更好的完成商城业务。

以后我们将商城任务和额外知识分开来编写,方便商城业务的连贯性。

下面是本篇文章各个章节对应的相应商城业务。

| 章节内容 | 对应商城业务内容 |

|---|---|

| 1 ES | 2.1 商品上架等业务 |

| 3 性能与压力测试 | 2.3 检索业务 |

| 4 缓存与分布式锁 | 2.3 检索业务等业务 |

| 5 异步&线程池 | 2.4 商品详情等业务 |

| 6 分布式事务 | 2.7 订单服务、秒杀服务等 |

| 7 RabbitMQ | 2.7 订单服务、秒杀服务等 |

| 8 SpringCloud Alibaba-Sentinel | 全服务 |

1 ES

1.1 ELASTIC SEARCH

1.1.1简介

https://www.elastic.co/cn/what-is/elasticsearch

全文搜索属于最常见的需求,开源的Elasticsearch 是目前全文搜索引擎的首选。

它可以快速地储存、搜索和分析海量数据。维基百科、Stack Overflow、Github 都采用它Elastic 的底层是开源库Lucene。但是,你没法直接用Lucene,必须自己写代码去调用它的接口。Elastic 是Lucene 的封装,提供了REST API 的操作接口,开箱即用。

REST API:天然的跨平台。

官方文档:https://www.elastic.co/guide/en/elasticsearch/reference/current/index.html

官方中文:https://www.elastic.co/guide/cn/elasticsearch/guide/current/foreword_id.html

社区中文:

https://es.xiaoleilu.com/index.html

http://doc.codingdict.com/elasticsearch/0/

PS:mysql用作持久化存储,ES用作检索。

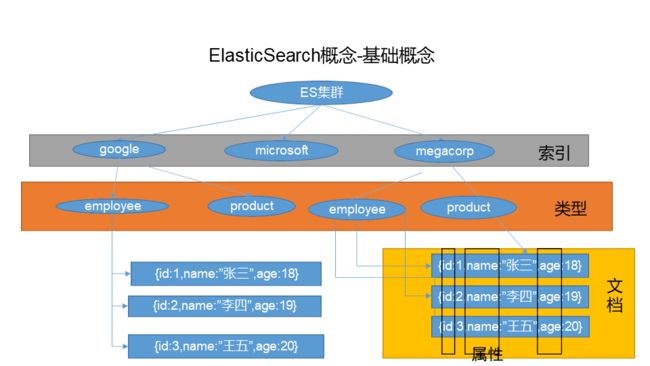

1.1.2 基本概念

1、Index(索引)

动词,相当于MySQL 中的insert;

名词,相当于MySQL 中的Database

2、Type(类型)

在Index(索引)中,可以定义一个或多个类型。

类似于MySQL 中的Table;每一种类型的数据放在一起;

3、Document(文档)

保存在某个索引(Index)下,某种类型(Type)的一个数据(Document),文档是JSON 格

式的,Document 就像是MySQL 中的某个Table 里面的内容;每一行对应的列叫属性。

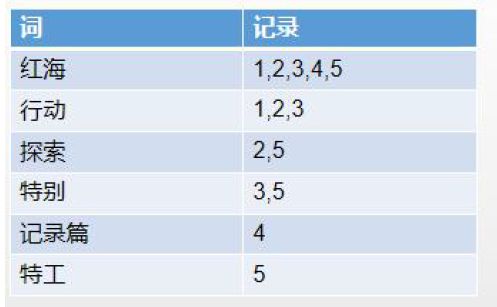

4、倒排索引机制

为什么ES搜索快?

倒排索引

- 保存的记录

- 红海行动

- 探索红海行动

- 红海特别行动

- 红海记录片

- 特工红海特别探索

全文搜索引擎目前主流的索引技术就是倒排索引的方式。

传统的保存数据的方式都是: 记录→单词;

而倒排索引的保存数据的方式是:单词→记录;

例如: 搜索“红海行动”:

数据库中保存的数据如图:

那么搜索引擎是如何能将两者匹配上的呢?

基于分词技术构建倒排索引:

首先每个记录保存数据时,都不会直接存入数据库。系统先会对数据进行分词,然后以倒排索引结构保存:将内容分词就记录到索引中。

然后等到用户搜索的时候,会把搜索的关键词也进行分词,会把“红海行动”分词分成:红海和行动两个词。

这样的话,先用红海进行匹配,得到id=1和id=2的记录编号,再用行动匹配可以迅速定位id为1,3的记录。

那么全文索引通常,还会根据匹配程度进行打分,显然1号记录能匹配的次数更多。所以显示的时候以评分进行排序的话,1号记录会排到最前面。而2、3号记录也可以匹配到。

一些小知识:

关系型数据库中两个数据表是独立的,即使他们里面有相同名称的列也不影响使用,但ES中不是这样的。elasticsearch是基于Lucene开发的搜索引擎,而ES中不同type下名称相同的filed最终在Lucene中的处理方式是一样的。

两个不同type下的两个user_name,在ES同一个索引下其实被认为是同一个filed,你必须在两个不同的type中定义相同的filed映射。否则,不同type中的相同字段名称就会在处理中出现冲突的情况,导致Lucene处理效率下降。

去掉type就是为了提高ES处理数据的效率。

Elasticsearch 7.x

URL中的type参数为可选。比如,索引一个文档不再要求提供文档类型。

Elasticsearch 8.x

不再支持URL中的type参数。

解决:将索引从多类型迁移到单类型,每种类型文档一个独立索引

1.2 Docker 安装elastic search

1、下载镜像文件

docker pull elasticsearch:7.4.2 > 存储和检索数据

docker pull kibana:7.4.2 >可视化检索数据

注意版本要统一

2、创建实例

1、ElasticSearch

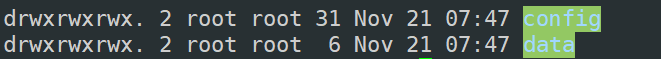

配置

mkdir -p /mydata/elasticsearch/config

mkdir -p /mydata/elasticsearch/data

echo "http.host: 0.0.0.0" >> /mydata/elasticsearch/config/elasticsearch.yml # es可以被远程任何机器访问

chmod -R 777 /mydata/elasticsearch/ # 递归更改权限,es需要访问

启动Elastic search

docker run --name elasticsearch -p 9200:9200 -p 9300:9300 \

-e "discovery.type=single-node" \

-e ES_JAVA_OPTS="-Xms64m -Xmx512m" \

-v /mydata/elasticsearch/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml \

-v /mydata/elasticsearch/data:/usr/share/elasticsearch/data \

-v /mydata/elasticsearch/plugins:/usr/share/elasticsearch/plugins \

-d elasticsearch:7.4.2

# 9200是用户交互端口:发送 http请求,也就是说 RestAPI; 9300是集群心跳端口:分布式集群下节点之间的通信端口

# -e指定是单阶段运行

# -e指定占用的内存大小,生产时可以设置32G

以后在外面装好插件重启即可;

特别注意:

-e ES_JAVA_OPTS=“-Xms64m -Xmx256m” \ 测试环境下,设置ES 的初始内存和最大内存,否则导致过大启动不了ES

1.3 Docker 安装 kibana

docker pull kibana:7.4.2

启动kibana:

docker run --name kibana -e ELASTICSEARCH_HOSTS=http://192.168.11.129:9200 -p 5601:5601 -d kibana:7.4.2

ps:如果想要更改成 root用户,只需执行 su root 或者 su 即可

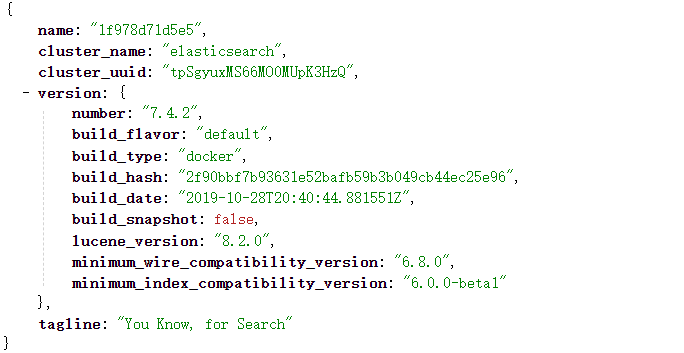

1.4 测试

前面我们已经启动了 es 和 kibana 接下来我们开始进行测试。

访问: http://192.168.56.10:9200

展示的是elastic search 的版本信息

访问: http://192.168.56.10:5601

kibana的界面,看到这个界面就表示启动成功。

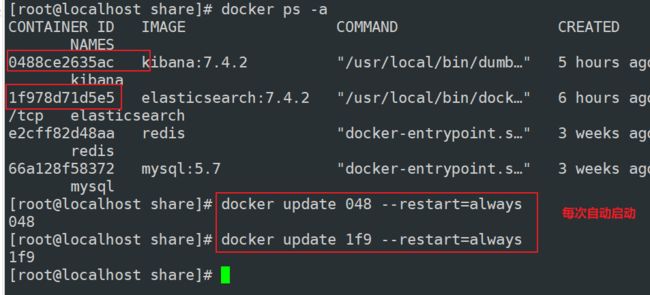

为了每次重启 虚拟机后让 es 和 kibana都自动启动,设置如下:

docker update xxx --restart=always

1.5 初步检索

1.5.1 _cat

- GET /_cat/nodes:查看所有节点

http://192.168.56.10:9200/_cat/indices

127.0.0.1 15 93 1 0.00 0.04 0.05 dilm * 1f978d71d5e5

1f978d71d5e5代表结点

*代表是主节点

- GET /cat/health:查看es 健康状况

http://192.168.56.10:9200/_cat/health

1613741055 13:24:15 elasticsearch green 1 1 0 0 0 0 0 0 - 100.0%

注:green表示健康值正常

- GET /cat/master:查看主节点

http://192.168.56.10:9200/_cat/master

6wqDE9jbS1GgN-bfd38G3A 127.0.0.1 127.0.0.1 1f978d71d5e5

主节点唯一编号

虚拟机地址

- GET /_cat/indices:查看所有索引:等价于mysql数据库的show databases;

http://192.168.56.10:9200/_cat/indices

green open .kibana_task_manager_1 DhtDmKrsRDOUHPJm1EFVqQ 1 0 2 3 40.8kb 40.8kb

green open .apm-agent-configuration vxzRbo9sQ1SvMtGkx6aAHQ 1 0 0 0 230b 230b

green open .kibana_1 rdJ5pejQSKWjKxRtx-EIkQ 1 0 5 1 18.2kb 18.2kb

1.5.2 索引一个文档(保存)

保存一个数据,保存在哪个索引的哪个类型下,指定用哪个唯一标识((哪张数据库哪张表下))

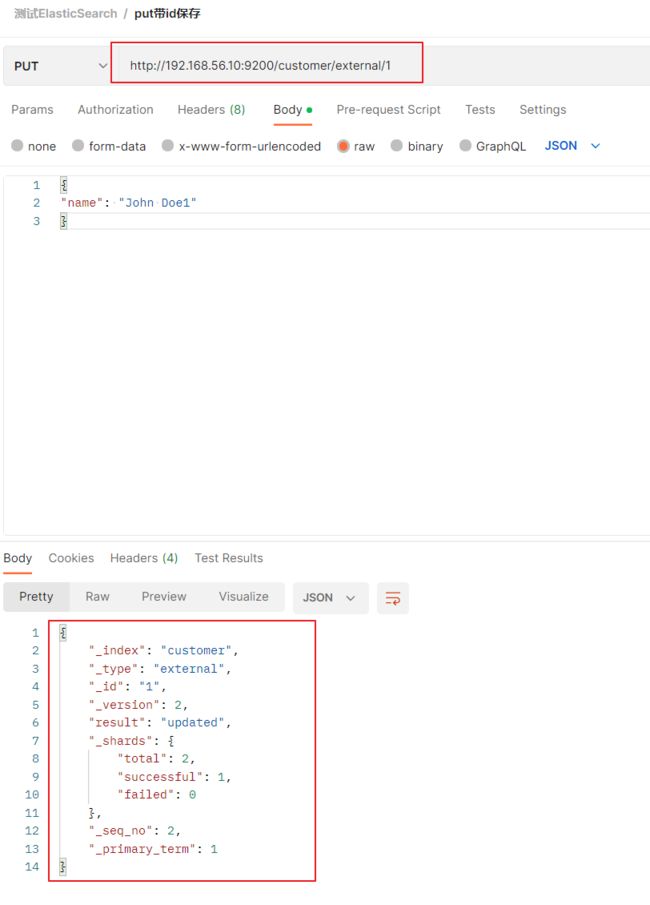

PUT customer/external/1;在customer 索引下的external 类型下保存1 号数据为

{

"name": "John Doe"

}

http://192.168.56.10:9200/customer/external/1

PUT 和POST 都可以进行保存。

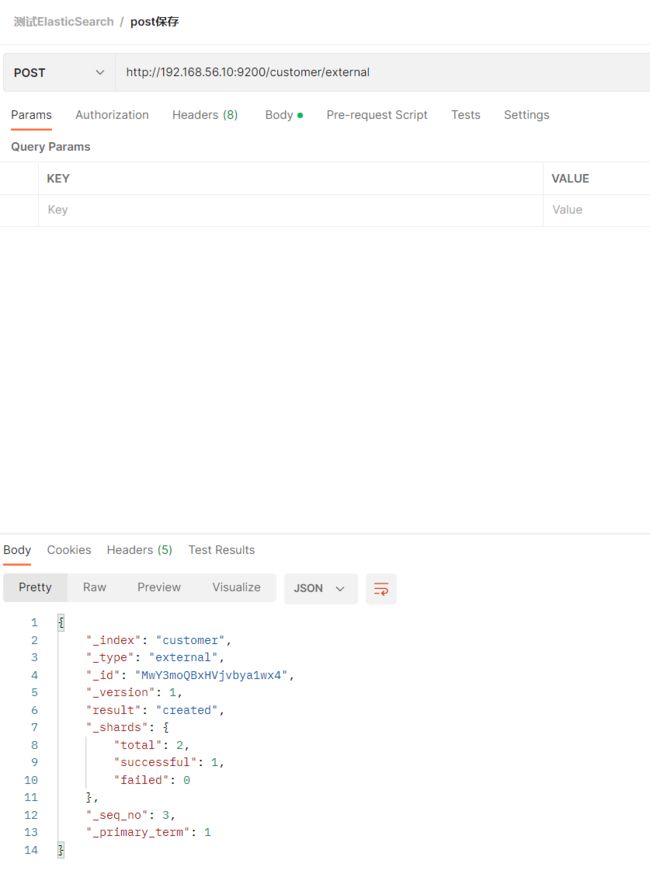

POST 新增。如果不指定id,会自动生成id。指定id 就会修改这个数据,并新增版本号

PUT 可以新增可以修改。PUT 必须指定id(否则报405错误);由于PUT 需要指定id,我们一般都用来做修改

操作,不指定id 会报错。唯一区分是post不指定id时永远为创建

带__表示元数据:例如 _index/_type…

put:新增保存二合一

put 带id 保存:

created表示新建(第一次建立)updated表示更新:发送多次是一个更新操作

post:新增

post不带id:

post是新增操作,每一次都是一个新增操作,id自动生成

post带id:第一次新建(没有数据),第二次就变成了更新操作(有数据)

下面将会具体说明:

put方式:

http://192.168.56.10:9200/customer/external/3

内容:

{

"name": "John Doe1"

}

结果:

{

"_index": "customer",

"_type": "external",

"_id": "3",

"_version": 1,

"result": "created",//第一次新增

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"_seq_no": 5,

"_primary_term": 1

}

第二次发送同样请求,同样内容

结果:

{

"_index": "customer",

"_type": "external",

"_id": "3",

"_version": 2,

"result": "updated",//第二次更新操作

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"_seq_no": 6,

"_primary_term": 1

}

post 方式:

- post不带id:

url:http://192.168.56.10:9200/customer/external

内容:

{

"name": "John Doe"

}

结果:

{

"_index": "customer",

"_type": "external",

"_id": "MwY3moQBxHVjvbya1wx4",

"_version": 1,

"result": "created",//新增

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"_seq_no": 3,

"_primary_term": 1

}

同样的请求和同样的内容

{

"_index": "customer",

"_type": "external",

"_id": "NAZEmoQBxHVjvbyaUAzW",

"_version": 1,

"result": "created",//新增

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"_seq_no": 7,

"_primary_term": 1

}

不带 id 每一次都是新增

post 带 id保存

url:http://192.168.56.10:9200/customer/external/4

内容:

{

"name": "John Doe"

}

结果:

{

"_index": "customer",

"_type": "external",

"_id": "4",

"_version": 1,

"result": "created", //第一次是新增

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"_seq_no": 10,

"_primary_term": 1

}

同url 、同 json 数据测试

结果:

{

"_index": "customer",

"_type": "external",

"_id": "4",

"_version": 2,

"result": "updated",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"_seq_no": 11,

"_primary_term": 1

}

带 id :第一次新增,第二次就是更新操作了

1.5.3 查询文档

GET customer/external/1

结果:

{

"_index": "customer", //在哪个索引

"_type": "external", //在哪个类型

"_id": "1", //记录id

"_version": 2, //版本号

"_seq_no": 1, //并发控制字段,每次更新就会+1,用来做乐观锁

"_primary_term": 1, //同上,主分片重新分配,如重启,就会变化

"found": true,

"_source": { //真正的内容

"name": "John Doe"

}

}

更新携带?if_seq_no=0&if_primary_term=1:乐观锁修改:当序列号匹配的时候,才进行修改,否则不修改(出现409错误)。

1.5.4 更新文档

POST customer/external/1/_update

{

"doc":{

"name": "John Doew"

}

}

或者 POST customer/external/1

{

"name": "John Doe2"

}

或者

PUT customer/external/1

{

"name": "John Doe"

}

-

不同

- POST 操作会对比源文档数据,如果相同不会有什么操作,文档version 不增加

PUT 操作总会将数据重新保存并增加version 版本;

-

带_update 对比元数据如果一样就不进行任何操作。_

-

看场景:

对于大并发更新,不带 update ;

对于大并发查询偶尔更新,带 update ;对比更新,重新计算分配规则。

-

更新同时增加属性

POST customer/external/1/_update{ "doc": { "name": "Jane Doe", "age": 20 } }PUT 和POST 不带_update 也可以

ps:

post 更新 带 _update

如果数据都一样,第二次发送请求就会显示noop(no operation) 没有任何操作,版本,序列号也不会变

只有这个才会检测数据,其他put和post都不会对比原来的数据

post更新 不带 _update

每次都是更新

1.5.5 删除文档&索引

DELETE customer/external/1

DELETE customer

注:elasticsearch并没有提供删除类型的操作,只提供了删除索引和文档的操作。

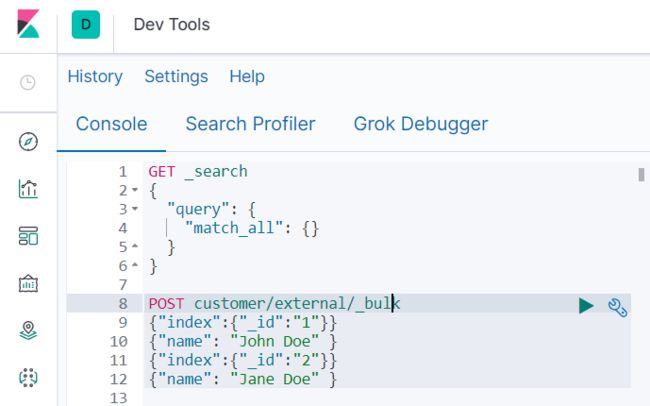

1.5.6 bulk 批量API

POST customer/external/_bulk

{"index":{"_id":"1"}}

{"name": "John Doe" }

{"index":{"_id":"2"}}

{"name": "Jane Doe" }

两行为一个整体

语法格式:

{ action: { metadata }}\n

{ request body }\n

{ action: { metadata }}\n

{ request body }\n

ps: 注意在 postman中测试选择格式json和text均不可,要去kibana里Dev Tools

这里的批量操作,当发生某一条执行发生失败时,其他的数据仍然能够接着执行,也就是说彼此之间是独立的。

bulk api 以此按顺序执行所有的action(动作)。如果一个单个的动作因任何原因失败,它将继续处理它后面剩余的动作。当bulk api返回时,它将提供每个动作的状态(与发送的顺序相同),所以您可以检查是否一个指定的动作是否失败了。

结果:

#! Deprecation: [types removal] Specifying types in bulk requests is deprecated.

{

"took" : 318, 花费了多少ms

"errors" : false, 没有发生任何错误

"items" : [ 每个数据的结果

{

"index" : { 保存

"_index" : "customer", 索引

"_type" : "external", 类型

"_id" : "1", 文档

"_version" : 1, 版本

"result" : "created", 创建

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 0,

"_primary_term" : 1,

"status" : 201 新建完成

}

},

{

"index" : { 第二条记录

"_index" : "customer",

"_type" : "external",

"_id" : "2",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 1,

"_primary_term" : 1,

"status" : 201

}

}

]

}

复杂实例:

POST /_bulk

{ "delete": { "_index": "website", "_type": "blog", "_id": "123" }} delete:删除操作:哪一个索引下的哪一个类型下的id为几的数据

{ "create": { "_index": "website", "_type": "blog", "_id": "123" }}创建操作:哪一个索引下的哪一个类型下的id为几的数据

{ "title": "My first blog post" } 表示真正的内容(是上面创建操作的)

{ "index": { "_index": "website", "_type": "blog" }} 保存

{ "title": "My second blog post" } 真正的内容

{ "update": { "_index": "website", "_type": "blog", "_id": "123", "_retry_on_conflict" : 3} } 更新记录

{ "doc" : {"title" : "My updated blog post"} } 真正的内容

1.5.7 样本测试数据

我准备了一份顾客银行账户信息的虚构的JSON 文档样本。每个文档都有下列的schema

(模式):

{

"account_number": 0,

"balance": 16623,

"firstname": "Bradshaw",

"lastname": "Mckenzie",

"age": 29,

"gender": "F",

"address": "244 Columbus Place",

"employer": "Euron",

"email": "[email protected]",

"city": "Hobucken",

"state": "CO"

}

https://github.com/elastic/elasticsearch/blob/master/docs/src/test/resources/accounts.json?raw=true 导入测试数据

这里老师给的地址失效了:下面是有效的地址

测试数据:https://gitee.com/xlh_blog/common_content/blob/master/es%E6%B5%8B%E8%AF%95%E6%95%B0%E6%8D%AE.json#

POST bank/account/_bulk

查看下上面的导入数据

http://192.168.56.10:9200/_cat/indices

刚导入了1000条

yellow open bank YRnUvuAURQmmNQSC83fcDQ 1 1 1000 0 414.3kb 414.3kb

1.6 进阶检索

1.6.1 SearchAPI

1、检索信息

-

一切检索从**_search** 开始

ES支持两种基本方式检索;

1.通过REST request uri 发送 搜索参数 (uri +检索参数);

2.通过REST request body 来发送它们(uri+请求体)GET bank/search :检索 bank 下所有信息,包括 type 和 docs

GET bank/_search?q=*&sort=account_number:asc :请求参数方式检索

q=* 查询所有

sort 排序字段

asc升序

响应结果解释:

took - Elasticsearch 执行搜索的时间(毫秒)

time_out - 告诉我们搜索是否超时

_shards - 告诉我们多少个分片被搜索了,以及统计了成功/失败的搜索分片

hits - 搜索结果

hits.total - 搜索结果

hits.hits - 实际的搜索结果数组(默认为前10 的文档)

sort - 结果的排序key(键)(没有则按score 排序)

score 和max_score –相关性得分和最高得分(全文检索用)_

检索了1000条数据,但是根据相关性算法–默认只返回10条。

-

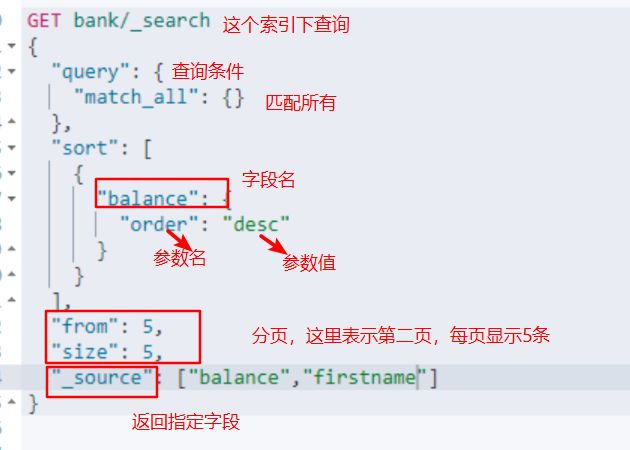

_ uri+请求体进行检索

GET bank/_search { "query": { "match_all": {} }, "sort": [ { "account_number": "asc" }, { "balance": "desc" } ] }第二种方式:携带请求体 是我们主要的使用方式。

HTTP 客户端工具(POSTMAN),get 请求不能携带请求体,我们变为post 也是一样的

我们POST 一个JSON 风格的查询请求体到_search API。

需要了解,一旦搜索的结果被返回,Elasticsearch 就完成了这次请求,并且不会维护任何

服务端的资源或者结果的cursor(游标)。

1.6.2 Query DSL

1)、基本语法格式

Elasticsearch 提供了一个可以执行查询的Json 风格的DSL(domain-specific language 领域特定语言)。这个被称为Query DSL。该查询语言非常全面,并且刚开始的时候感觉有点复杂,真正学好它的方法是从一些基础的示例开始的。

-

一个查询语句的典型结构

QUERY_NAME:{ ARGUMENT:VALUE, ARGUMENT:VALUE, ... } -

如果是针对某个字段,那么它的结构如下:

{ QUERY_NAME:{ FIELD_NAME:{ ARGUMENT:VALUE, ARGUMENT:VALUE,... } } } -

示例

{ "query": { "match_all": {} }, "from": 0, "size": 5, "_source":["balance"], "sort": [ { "account_number": { "order": "desc" } } ] }- query 定义如何查询,

- match_all 查询类型【代表查询所有的所有】,es 中可以在query 中组合非常多的查

询类型完成复杂查询 - 除了query 参数之外,我们也可以传递其它的参数以改变查询结果。如sort,size

- from+size 限定,完成分页功能

- sort 排序,多字段排序,会在前序字段相等时后续字段内部排序,否则以前序为准

- _source为要返回的字段

- 、返回部分字段

GET bank/_search

{

"query": {

"match_all": {}

},

"from": 0,

"size": 5,

"_source": [

"age",

"balance"

]

}

3)、match【匹配查询】

- 基本类型(非字符串),精确匹配

GET bank/_search

{

"query": {

"match": {

"account_number": "20"

}

}

}

match 返回account_number=20 的

- 字符串,全文检索

GET bank/_search

{

"query": {

"match": {

"address": "mill"

}

}

}

最终查询出address 中包含mill lane单词的所有记录。

match 当搜索字符串类型的时候,会进行全文检索,并且每条记录有相关性得分。

- 字符串,多个单词(分词+全文检索)

GET bank/_search

{

"query": {

"match": {

"address": "mill lane"

}

}

}

## 全文检索按照评分进行排序,会对检索条件进行分词匹配。

最终查询出address 中包含mill 或者road 或者mill lane 的所有记录,并给出相关性得分。

ps:

查询条件:

如果是非字符串,表示精确检索如果是字符串类型,是模糊检索—倒排索引

最终都会有一个max_score:最大评分,以及 _score:评分

4)、match_phrase【短语匹配】

将需要匹配的值当成一个整体单词(不分词)进行检索

## 短语匹配

GET bank/_search

{

"query": {

"match_phrase": {

"address": "mill lane"

}

}

}

查出address 中包含mill lane的所有记录,并给出相关性得分。

5)、multi_match【多字段匹配】

## 多字段匹配

GET bank/_search

{

"query": {

"multi_match": {

"query": "mill",

"fields": ["address","city"]

}

}

}

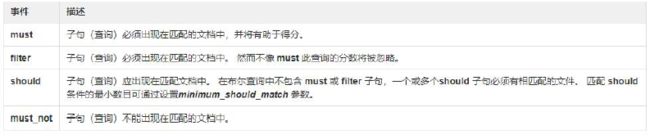

6)、bool【复合查询】

bool 用来做复合查询:

复合语句可以合并任何其它查询语句,包括复合语句,了解这一点是很重要的。这就意味

着,复合语句之间可以互相嵌套,可以表达非常复杂的逻辑。

- must:必须达到must 列举的所有条件

- must_not :必须不是指定的情况

- should:应该达到should 列举的条件,如果达到会增加相关文档的评分,并不会改变

查询的结果。如果query 中只有should 且只有一种匹配规则,那么should 的条件就会

被作为默认匹配条件而去改变查询结果

## 复合查询

GET bank/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"address": "mill"

}

}

],

"must_not": [

{

"match": {

"age": "18"

}

}

],

"should": [

{

"match": {

"lastname": "Wallace"

}

}

],

}

}

}

address 包含mill,如果 lastname 里面有 wallace 最好不过,但是age必须不包含18。

7)、filter【结果过滤】

并不是所有的查询都需要产生分数,特别是那些仅用于“filtering”(过滤)的文档。为了不计算分数Elasticsearch 会自动检查场景并且优化查询的执行。

GET bank/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"address": "mill"

}

}

],

"filter": {

"range": {

"balance": {

"gte": 10000,

"lte": 20000

}

}

}

}

}

}

GET bank/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"address": "mill"

}

}

],

"must_not": [

{

"match": {

"age": "18"

}

}

],

"should": [

{

"match": {

"lastname": "Wallace"

}

}

],

"filter": {

"range": {

"age": {

"gte": 18,

"lte": 30

}

}

}

}

}

}

注意:filter 不会计算相关性得分。

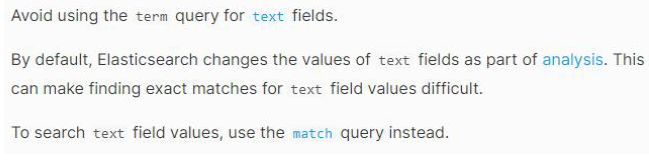

8)、term

和match 一样。匹配某个属性的值。全文检索字段用match,其他非text 字段匹配用term。

ps:非文本字段使用 term 匹配

文本字段使用 match 匹配

ps:字段想要精确匹配:

1.字段.keyword:后面的字符串必须和字段的真实的值一模一样,否则就会查出0条记录2.如果使用match_prashe:因为是短语匹配,所以不需要完全一样

## 推荐非字符串字段使用

GET bank/_search

{

"query": {

"term": {

"balance": {

"value": "32838"

}

}

}

}

## 推荐字符串字段使用

## 字符串字段精确匹配的两种方式

GET bank/_search

{

"query": {

"match": {

"address.keyword": "789 Madison"

}

}

}

GET bank/_search

{

"query": {

"match_phrase": {

"address": "789 Madison"

}

}

}

9)、aggregations(执行聚合)

聚合提供了从数据中分组和提取数据的能力。最简单的聚合方法大致等于SQL GROUP BY 和SQL 聚合函数。在Elasticsearch 中,您有执行搜索返回hits(命中结果),并且同时返回聚合结果,把一个响应中的所有hits(命中结果)分隔开的能力。这是非常强大且有效的,您可以执行查询和多个聚合,并且在一次使用中得到各自的(任何一个的)返回结果,使用一次简洁和简化的API 来避免网络往返。

- 搜索address 中包含mill 的所有人的年龄分布以及平均年龄,但不显示这些人的详情。

GET bank/_search

{

"query": {

"match": {

"address": "mill"

}

},

"aggs": {

"group_by_state": {

"terms": {

"field": "age",

"size": 100

}

},

"aggAvg":{

"avg": {

"field": "age"

}

}

},

"size": 0

}

结果:

{

"took" : 0,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 4,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"aggAvg" : {

"value" : 34.0

},

"group_by_state" : {

"doc_count_error_upper_bound" : 0,

"sum_other_doc_count" : 0,

"buckets" : [

{

"key" : 38,

"doc_count" : 2

},

{

"key" : 28,

"doc_count" : 1

},

{

"key" : 32,

"doc_count" : 1

}

]

}

}

}

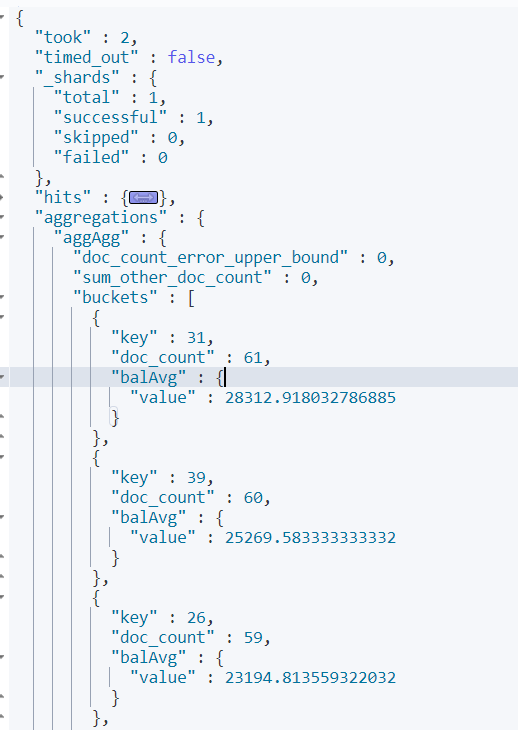

- 按照年龄聚合,并且请求这些年龄段的这些人的平均薪资

GET bank/_search

{

"query": {

"match_all": {}

},

"aggs": {

"aggAgg": {

"terms": {

"field": "age",

"size": 100

},

"aggs": {

"balAvg": {

"avg": {

"field": "balance"

}

}

}

}

}

}

结果:

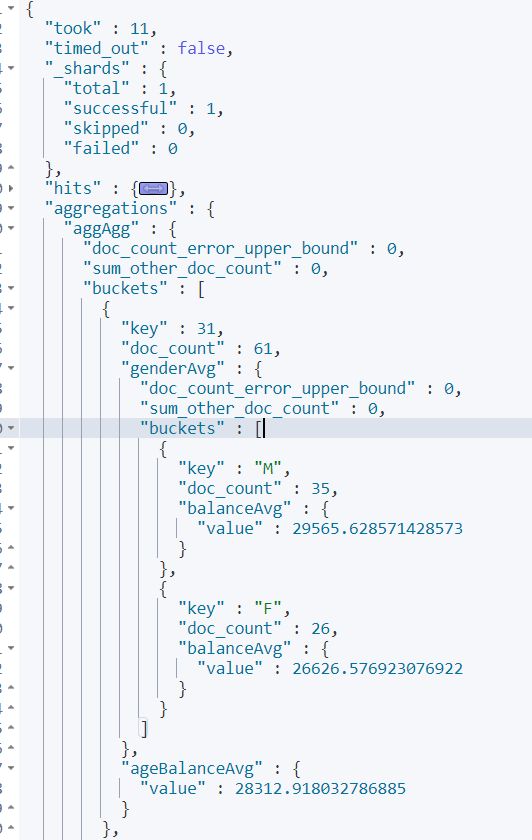

- 查出所有年龄分布,并且这些年龄段中M 的平均薪资和F 的平均薪资以及这个年龄段的总体平均薪资

GET bank/_search

{

"query": {

"match_all": {}

},

"aggs": {

"aggAgg": {

"terms": {

"field": "age",

"size": 100

},

"aggs": {

"genderAvg": {

"terms": {

"field": "gender.keyword"

},

"aggs": {

"balanceAvg": {

"avg": {

"field": "balance"

}

}

}

},

"ageBalanceAvg":{

"avg": {

"field": "balance"

}

}

}

}

}

}

结果:

1.6.3 Mapping

映射定义文档如何被存储检索的。

1)、字段类型

https://www.elastic.co/guide/en/elasticsearch/reference/7.x/mapping-types.html

核心类型–复合类型–地理类型–特定类型–核心数据类型

(1)字符串

text ⽤于全⽂索引,搜索时会自动使用分词器进⾏分词再匹配

keyword 不分词,搜索时需要匹配完整的值

(2)数值型

整型: byte,short,integer,long

浮点型: float, half_float, scaled_float,double

(3)日期类型:date

(4)范围型

integer_range, long_range, float_range,double_range,date_range

gt是大于,lt是小于,e是equals等于。

age_limit的区间包含了此值的文档都算是匹配。

(5)布尔

boolean

(6)⼆进制

binary 会把值当做经过 base64 编码的字符串,默认不存储,且不可搜索复杂数据类型

(1)对象

object一个对象中可以嵌套对象。

(2)数组

Array

嵌套类型

nested 用于json对象数组

2)、映射

Mapping(映射)

Mapping 是用来定义一个文档(document),以及它所包含的属性(field)是如何存储和索引的。比如,使用mapping 来定义:

- 哪些字符串属性应该被看做全文本属性(full text fields)。

- 哪些属性包含数字,日期或者地理位置。

- 文档中的所有属性是否都能被索引(_all 配置)。

- 日期的格式。

- 自定义映射规则来执行动态添加属性。

查看mapping 信息:

GET bank/_mapping

修改mapping 信息:

https://www.elastic.co/guide/en/elasticsearch/reference/current/mapping.html

3)、新版本改变

Es7 及以上移除了type 的概念。

- 关系型数据库中两个数据表示是独立的,即使他们里面有相同名称的列也不影响使用,但ES 中不是这样的。elasticsearch 是基于Lucene 开发的搜索引擎,而ES 中不同type下名称相同的filed 最终在Lucene 中的处理方式是一样的。

- 两个不同type下的两个user_name,在ES 同一个索引下其实被认为是同一个filed,你必须在两个不同的type 中定义相同的filed 映射。否则,不同type 中的相同字段名称就会在处理中出现冲突的情况,导致Lucene 处理效率下降。

- 去掉type 就是为了提高ES 处理数据的效率。

- Elasticsearch 7.x

- URL 中的type 参数为可选。比如,索引一个文档不再要求提供文档类型。

- Elasticsearch 8.x

- 不再支持URL 中的type 参数。

- 解决:

1)、将索引从多类型迁移到单类型,每种类型文档一个独立索引

2)、将已存在的索引下的类型数据,全部迁移到指定位置即可。详见数据迁移

Elasticsearch 7.x

Specifying types in requests is deprecated. For instance, indexing a document no longer requires a document type. The new index APIs are PUT {index}/_doc/{id} in case of explicit ids and POST {index}/_doc for auto-generated ids. Note that in 7.0, _doc is a permanent part of the path, and represents the endpoint name rather than the document type.

The include_type_name parameter in the index creation, index template, and mapping APIs will default to false. Setting the parameter at all will result in a deprecation warning.

The default mapping type is removed.Elasticsearch 8.x

Specifying types in requests is no longer supported.

The include_type_name parameter is removed.

- 创建映射

1、创建索引并指定映射

PUT /my_index

{

"mappings": {

"properties": {

"age":{"type": "integer"},#全文检索

"email":{"type": "keyword"},#精确匹配

"name":{"type": "text"}

}

}

}

第一次存储数据的时候es就猜出了映射

第一次存储数据前可以指定映射

- 添加新的字段映射

PUT /my_index/_mapping

{

"properties":{

"employee_id":{

"type":"keyword",

"index":false #index :false表示这个字段不能被检索,默认 是 true:

}

}

}

这里的 “index”: false,表明新增的字段不能被检索,只是一个冗余字段。

- 更新映射

对于已经存在的映射字段,我们不能更新。更新必须创建新的索引进行数据迁移。 - 数据迁移

先创建出new_twitter 的正确映射。然后使用如下方式进行数据迁移。

6.0以后写法

POST _reindex

{

"source":{

"index":"twitter"

},

"dest":{

"index":"new_twitters"

}

}

老版本写法

POST _reindex

{

"source":{

"index":"twitter",

"twitter":"twitter"

},

"dest":{

"index":"new_twitters"

}

}

举例:将 bank 中的 属性的映射类型修改:

创建新的索引:newbank并且自定义映射

PUT /newbank

{

"mappings": {

"properties": {

"account_number": {

"type": "long"

},

"address": {

"type": "text"

},

"age": {

"type": "integer"

},

"balance": {

"type": "long"

},

"city": {

"type": "text"

},

"email": {

"type": "keyword"

},

"employer": {

"type": "keyword"

},

"firstname": {

"type": "text"

},

"gender": {

"type": "keyword"

},

"lastname": {

"type": "text",

"fields": {

"keyword": {

"type": "keyword",

"ignore_above": 256

}

}

},

"state": {

"type": "keyword"

}

}

}

}

迁移:

## 将旧索引的type 下的数据进行迁移

POST _reindex

{

"source": {

"index": "bank",

"type": "account"

},

"dest": {

"index": "newbank"

}

}

查看:

"hits" : {

"total" : {

"value" : 1000,

"relation" : "eq"

},

"max_score" : 1.0,

"hits" : [

{

"_index" : "newbank",

"_type" : "_doc", # 没有了类型

1.6.4 分词

一个tokenizer(分词器)接收一个字符流,将之分割为独立的tokens(词元,通常是独立的单词),然后输出tokens 流。

例如,whitespace tokenizer 遇到空白字符时分割文本。它会将文本**“Quick brown fox!”** 分割为**[Quick, brown, fox!]**。

该tokenizer(分词器)还负责记录各个term(词条)的顺序或position 位置(用于phrase 短语和word proximity 词近邻查询),以及term(词条)所代表的原始word(单词)的start(起始)和end(结束)的character offsets(字符偏移量)(用于高亮显示搜索的内容)。

Elasticsearch 提供了很多内置的分词器,可以用来构建custom analyzers(自定义分词器)。

关于分词器: https://www.elastic.co/guide/en/elasticsearch/reference/7.6/analysis.html

对于中文,我们需要安装额外的分词器。

1)、安装ik 分词器

注意:不能用默认 elasticsearch-plugin install xxx.zip 进行自动安装

https://github.com/medcl/elasticsearch-analysis-ik/releases?after=v6.4.2 对应es 版本安装

进入es 容器内部plugins 目录

docker exec -it 容器id /bin/bash

wget https://github.com/medcl/elasticsearchanalysisik/releases/download/v7.4.2/elasticsearch-analysis-ik-7.4.2.zip

unzip 下载的文件

rm –rf *.zip

mv elasticsearch/ ik

可以确认是否安装好了分词器

cd ../bin

elasticsearch plugin list:即可列出系统的分词器

所有的语言分词,默认使用的都是“Standard Analyzer”,但是这些分词器针对于中文的分词,并不友好。为此需要安装中文的分词器。

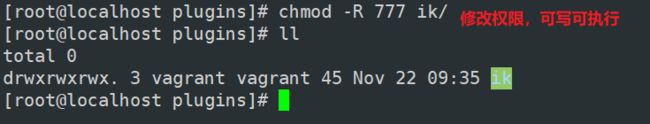

在前面安装的elasticsearch时,我们已经将elasticsearch容器的“/usr/share/elasticsearch/plugins”目录,映射到宿主机的“ /mydata/elasticsearch/plugins”目录下,所以比较方便的做法就是下载“/elasticsearch-analysis-ik-7.4.2.zip”文件,然后解压到目录ik下即可。安装完毕后,需要重启elasticsearch容器。

ps:过程中遇到的Linux 知识合集:

rwx 可读可写可执行

此外,在配置分词器的之前,我们需要使用 Nginx 的 conf 配置文件

参照下面进行:

随便启动一个nginx 实例,只是为了复制出配置

- docker run -p 80:80 --name nginx -d nginx:1.10

- 将容器内的配置文件拷贝到当前目录:docker container cp nginx:/etc/nginx .

- 别忘了后面的点

- 修改文件名称:mv nginx conf 把这个conf 移动到/mydata/nginx 下

- 终止原容器:docker stop nginx

- 执行命令删除原容器:docker rm $ContainerId

- 创建新的nginx;执行以下命令

docker run -p 80:80 --name nginx \

-v /mydata/nginx/html:/usr/share/nginx/html \

-v /mydata/nginx/logs:/var/log/nginx \

-v /mydata/nginx/conf:/etc/nginx \

-d nginx:1.10

- 给nginx 的html 下面放的所有资源可以直接访问;

可以这样理解:安装好nginx,把Nginx当做tomcat来用。

2)、 测试分词器

使用默认分词器

GET _analyze

{

"text":"我是中国人"

}

请观察执行结果:

{

"tokens" : [

{

"token" : "我",

"start_offset" : 0,

"end_offset" : 1,

"type" : "" ,

"position" : 0

},

{

"token" : "是",

"start_offset" : 1,

"end_offset" : 2,

"type" : "" ,

"position" : 1

},

{

"token" : "中",

"start_offset" : 2,

"end_offset" : 3,

"type" : "" ,

"position" : 2

},

{

"token" : "国",

"start_offset" : 3,

"end_offset" : 4,

"type" : "" ,

"position" : 3

},

{

"token" : "人",

"start_offset" : 4,

"end_offset" : 5,

"type" : "" ,

"position" : 4

}

]

}

GET _analyze

{

"analyzer": "ik_smart",

"text":"我是中国人"

}

输出结果:

{

"tokens" : [

{

"token" : "我",

"start_offset" : 0,

"end_offset" : 1,

"type" : "CN_CHAR",

"position" : 0

},

{

"token" : "是",

"start_offset" : 1,

"end_offset" : 2,

"type" : "CN_CHAR",

"position" : 1

},

{

"token" : "中国人",

"start_offset" : 2,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 2

}

]

}

GET _analyze

{

"analyzer": "ik_max_word",

"text":"我是中国人"

}

输出结果:

{

"tokens" : [

{

"token" : "我",

"start_offset" : 0,

"end_offset" : 1,

"type" : "CN_CHAR",

"position" : 0

},

{

"token" : "是",

"start_offset" : 1,

"end_offset" : 2,

"type" : "CN_CHAR",

"position" : 1

},

{

"token" : "中国人",

"start_offset" : 2,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 2

},

{

"token" : "中国",

"start_offset" : 2,

"end_offset" : 4,

"type" : "CN_WORD",

"position" : 3

},

{

"token" : "国人",

"start_offset" : 3,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 4

}

]

}

能够看出不同的分词器,分词有明显的区别,所以以后定义一个索引不能再使用默认的mapping 了,要手工建立mapping, 因为要选择分词器。

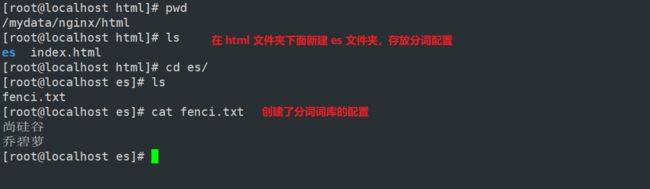

3)、自定义词库

修改 /usr/share/elasticsearch/plugins/ik/config/ 中的 IKAnalyzer.cfg.xml

/usr/share/elasticsearch/plugins/ik/config

DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置comment>

<entry key="ext_dict">entry>

<entry key="ext_stopwords">entry>

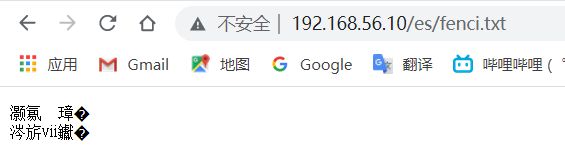

<entry key="remote_ext_dict">http://192.168.56.10/fenci.txtentry>

properties>

原来的xml

DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置comment>

<entry key="ext_dict">entry>

<entry key="ext_stopwords">entry>

properties>

修改 words_location,写上我们自己的地址 :http://192.168.56.10/es/fenci.txt

按照标红的路径利用nginx 发布静态资源,按照请求路径,创建对应的文件夹以及文件,放在

nginx 的html 下,然后重启es 服务器,重启nginx。

ps:

修改完成后,需要重启elasticsearch容器,否则修改不生效。docker restart elasticsearch

更新完成后,es只会对于新增的数据用更新分词。历史数据是不会重新分词的。如果想要历史数据重新分词,需要执行:

POST my_index/_update_by_query?conflicts=proceed

乱码不用关心。

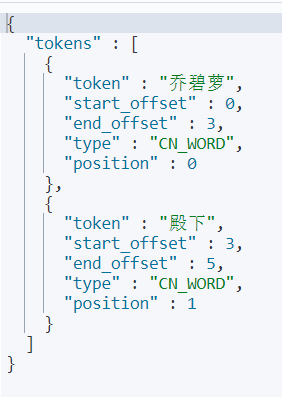

在kibana 中测试分词效果:

## 分词器

POST _analyze

{

"analyzer": "ik_max_word",

"text": "乔碧萝殿下"

}

至此,自定义分词词库我们就配置好了。

1.6.5 Elasticsearch-Rest-Client

1)、9300:TCP

- spring-data-elasticsearch:transport-api.jar;

- springboot 版本不同, transport-api.jar 不同,不能适配es 版本

- 7.x 已经不建议使用,8 以后就要废弃

2)、9200:HTTP

- JestClient:非官方,更新慢

- RestTemplate:模拟发HTTP 请求,ES 很多操作需要自己封装,麻烦

- HttpClient:同上

- Elasticsearch-Rest-Client:官方RestClient,封装了ES 操作,API 层次分明,上手简单

最终选择Elasticsearch-Rest-Client(elasticsearch-rest-high-level-client)

https://www.elastic.co/guide/en/elasticsearch/client/java-rest/current/java-rest-high.html

1.6.6 SpringBoot 整合 ElasticSearch

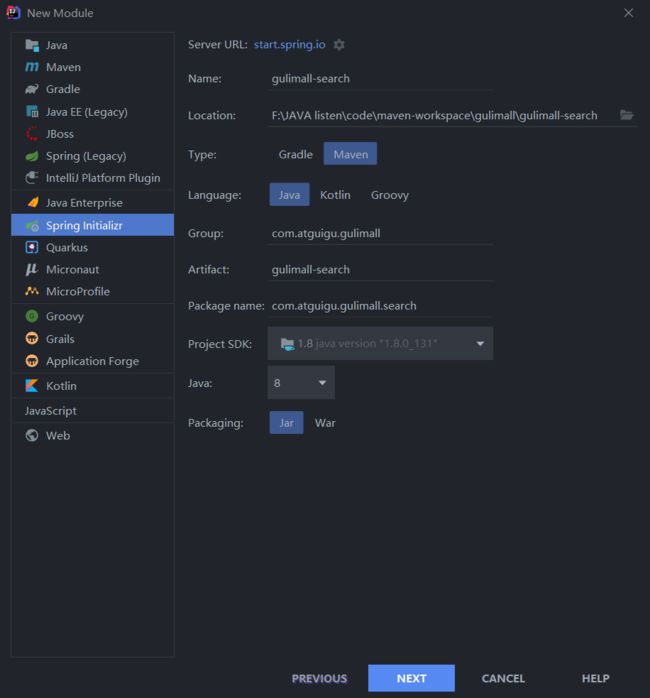

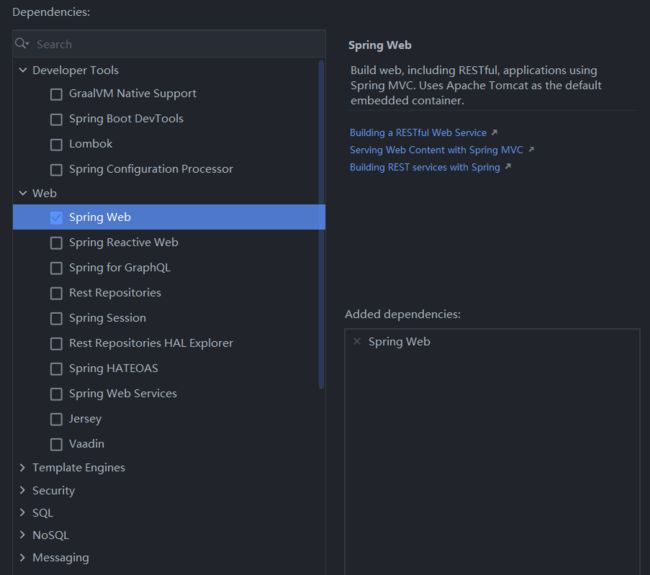

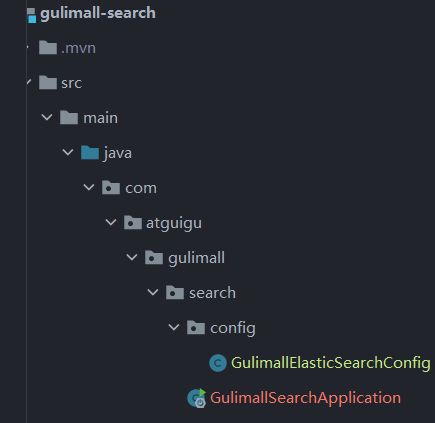

- 新建 gulimall-search模块,勾选 web

- 导入依赖

<properties>

<java.version>1.8java.version>

<elasticsearch.version>7.4.2elasticsearch.version>

properties>

<dependency>

<groupId>com.atguigu.gulimallgroupId>

<artifactId>gulimall-commonartifactId>

<version>0.0.1-SNAPSHOTversion>

dependency>

<dependency>

<groupId>org.elasticsearch.clientgroupId>

<artifactId>elasticsearch-rest-high-level-clientartifactId>

<version>7.4.2version>

dependency>

注意这里我们需要排除 springboot 自带的 ElasticSearch依赖:

/**

* es操作配置

* 1.导入依赖

* 2.编写配置,给容器中注入一个RestHighLevelClient

* 3.参考官方API https://www.elastic.co/guide/en/elasticsearch/client/java-rest/current/java-rest-high-document-index.html

* @author wystart

* @create 2022-11-22 21:48

*/

@Configuration

public class GulimallElasticSearchConfig {

//es添加了安全访问规则,访问es需要添加一个安全头,就可以通过requestOptions设置

public static final RequestOptions COMMON_OPTIONS;

static {

RequestOptions.Builder builder = RequestOptions.DEFAULT.toBuilder();

// builder.addHeader("Authorization", "Bearer " + TOKEN);

// builder.setHttpAsyncResponseConsumerFactory(

// new HttpAsyncResponseConsumerFactory

// .HeapBufferedResponseConsumerFactory(30 * 1024 * 1024 * 1024));

COMMON_OPTIONS = builder.build();

}

@Bean

public RestHighLevelClient esRestClient() {

//自己拆解的

RestClientBuilder builder = null;

// final String hostname, final int port, final String scheme

builder = RestClient.builder(new HttpHost("192.168.56.10", 9200, "http"));

RestHighLevelClient client = new RestHighLevelClient(builder);

//官方给的

// RestHighLevelClient client = new RestHighLevelClient(

// RestClient.builder(

// new HttpHost("192.168.56.10", 9200, "http")));

return client;

}

}

当然我们还需要将 gulimall-search 注册 到nacos:

application.properties

# 注册中心

spring.cloud.nacos.discovery.server-addr=127.0.0.1:8848

spring.application.name=gulimall-search

GulimallSearchApplication 添加 @EnableDiscoveryClient注解

- 测试

@RunWith(SpringRunner.class)//指定以spring驱动的方式跑单元测试

@SpringBootTest

public class GulimallSearchApplicationTests {

@Autowired

RestHighLevelClient client;

//测试能否获取到 es对象

@Test

public void contextLoads() {

System.out.println(client);

}

}

接下来我们开始编写测试类。

https://www.elastic.co/guide/en/elasticsearch/client/java-rest/7.5/java-rest-high-create-index.html

保存方式分为同步和异步,异步方式多了个listener回调

- 测试保存数据

/**

* 测试存储数据到es

* 更新也可以:index 更新和保存二合一

*/

@Test

public void indexData() throws IOException {

IndexRequest indexRequest = new IndexRequest("users");//创建索引

indexRequest.id("1");//数据的id----不写默认自动生成

// indexRequest.source("userName","zhangsan","age",18,"gender","男");

User user = new User();

user.setUserName("zhangsan");

user.setAge(18);

user.setGender("男");

String jsonString = JSON.toJSONString(user);//所有的内容必须转换成 json 数据

indexRequest.source(jsonString, XContentType.JSON);//要保存的内容

//执行创建索引和保存数据

IndexResponse index = client.index(indexRequest, GulimallElasticSearchConfig.COMMON_OPTIONS);

//提取有用的响应数据

System.out.println(index);

}

@Data

class User{

private String userName;

private String gender;

private Integer age;

}

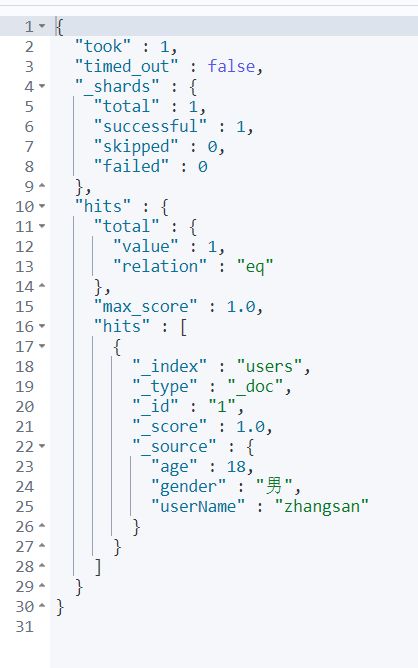

kibana测试:

GET /users/_search

新增成功

- 测试检索数据

https://www.elastic.co/guide/en/elasticsearch/client/java-rest/current/java-rest-high-search.html

根据以下DSL进行检索:

GET bank/_search

{

"query": {

"match": {

"address": "mill"

}

},

"aggs": {

"aggAgg": {

"terms": {

"field": "age",

"size": 10

}

},

"balanceAvg":{

"avg": {

"field": "balance"

}

}

},

"size": 0

}

检索结果:

{

"took" : 0,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 4,

"relation" : "eq"

},

"max_score" : null,

"hits" : [ ]

},

"aggregations" : {

"aggAgg" : {

"doc_count_error_upper_bound" : 0,

"sum_other_doc_count" : 0,

"buckets" : [

{

"key" : 38,

"doc_count" : 2

},

{

"key" : 28,

"doc_count" : 1

},

{

"key" : 32,

"doc_count" : 1

}

]

},

"balanceAvg" : {

"value" : 25208.0

}

}

}

利用java代码进行检索数据:

/**

* 测试从 es 中搜索数据

*/

@Test

public void searchData() throws IOException {

//1.创建检索请求

SearchRequest searchRequest = new SearchRequest();

//指定索引

searchRequest.indices("bank");

//指定DSL,检索条件

// SearchSourceBuilder sourceBuilder 封装的条件

SearchSourceBuilder sourceBuilder = new SearchSourceBuilder();

//1.1 构造检索条件

// sourceBuilder.query();

// sourceBuilder.from();

// sourceBuilder.size();

// sourceBuilder.addRescorer();

sourceBuilder.query(QueryBuilders.matchQuery("address", "mill"));

//1.2 按照年龄的值分布进行聚合

TermsAggregationBuilder ageAgg = AggregationBuilders.terms("aggAgg").field("age").size(10);

sourceBuilder.aggregation(ageAgg);

//1.3 计算平均薪资

AvgAggregationBuilder balanceAvg = AggregationBuilders.avg("balanceAvg").field("balance");

sourceBuilder.aggregation(balanceAvg);

System.out.println("检索条件" + sourceBuilder.toString());

searchRequest.source(sourceBuilder);

//2.执行检索

SearchResponse searchResponse = client.search(searchRequest, GulimallElasticSearchConfig.COMMON_OPTIONS);

//3.分析结果 searchResponse

System.out.println(searchResponse.toString());

//3.1 获取所有查到的数据

SearchHits hits = searchResponse.getHits();

SearchHit[] searchHits = hits.getHits();

for (SearchHit hit : searchHits) {

// "_index": "bank",

// "_type": "account",

// "_id": "970",

// "_score": 5.4032025,

// "_source":

// hit.getIndex();hit.getType();hit.getId();

String string = hit.getSourceAsString();//将获得的记录转换为string

Acount acount = JSON.parseObject(string, Acount.class);//将string 转换为我们创建的Javabean对象

System.out.println("acount:" + acount);

}

//3.2 获取这次检索到的分析信息

Aggregations aggregations = searchResponse.getAggregations();

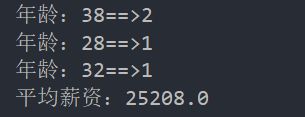

Terms aggAgg = aggregations.get("aggAgg");

for (Terms.Bucket bucket : aggAgg.getBuckets()) {

String keyAsString = bucket.getKeyAsString();

System.out.println("年龄:" + keyAsString + "==>" + bucket.getDocCount());

}

Avg balanceAvg1 = aggregations.get("balanceAvg");

System.out.println("平均薪资:" + balanceAvg1.getValue());

}

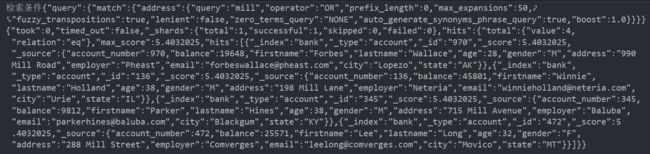

没有加上 聚合条件,检索 address 匹配 mill的结果如下:

检索条件{"query":{"match":{"address":{"query":"mill","operator":"OR","prefix_length":0,"max_expansions":50,"fuzzy_transpositions":true,"lenient":false,"zero_terms_query":"NONE","auto_generate_synonyms_phrase_query":true,"boost":1.0}}},"aggregations":{"aggAgg":{"terms":{"field":"age","size":10,"min_doc_count":1,"shard_min_doc_count":0,"show_term_doc_count_error":false,"order":[{"_count":"desc"},{"_key":"asc"}]}},"balanceAvg":{"avg":{"field":"balance"}}}}

{"took":15,"timed_out":false,"_shards":{"total":1,"successful":1,"skipped":0,"failed":0},"hits":{"total":{"value":4,"relation":"eq"},"max_score":5.4032025,"hits":[{"_index":"bank","_type":"account","_id":"970","_score":5.4032025,"_source":{"account_number":970,"balance":19648,"firstname":"Forbes","lastname":"Wallace","age":28,"gender":"M","address":"990 Mill Road","employer":"Pheast","email":"[email protected]","city":"Lopezo","state":"AK"}},{"_index":"bank","_type":"account","_id":"136","_score":5.4032025,"_source":{"account_number":136,"balance":45801,"firstname":"Winnie","lastname":"Holland","age":38,"gender":"M","address":"198 Mill Lane","employer":"Neteria","email":"[email protected]","city":"Urie","state":"IL"}},{"_index":"bank","_type":"account","_id":"345","_score":5.4032025,"_source":{"account_number":345,"balance":9812,"firstname":"Parker","lastname":"Hines","age":38,"gender":"M","address":"715 Mill Avenue","employer":"Baluba","email":"[email protected]","city":"Blackgum","state":"KY"}},{"_index":"bank","_type":"account","_id":"472","_score":5.4032025,"_source":{"account_number":472,"balance":25571,"firstname":"Lee","lastname":"Long","age":32,"gender":"F","address":"288 Mill Street","employer":"Comverges","email":"[email protected]","city":"Movico","state":"MT"}}]},"aggregations":{"lterms#aggAgg":{"doc_count_error_upper_bound":0,"sum_other_doc_count":0,"buckets":[{"key":38,"doc_count":2},{"key":28,"doc_count":1},{"key":32,"doc_count":1}]},"avg#balanceAvg":{"value":25208.0}}}

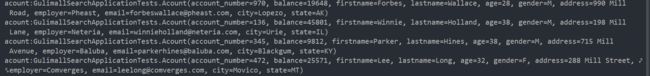

把检索结果封装为java bean(利用Json在线工具生成 Javabean )

@ToString

@Data

static class Acount {

private int account_number;

private int balance;

private String firstname;

private String lastname;

private int age;

private String gender;

private String address;

private String employer;

private String email;

private String city;

private String state;

}

效果展示:

封装成 Javabean 对象输出:

聚合函数输出:

3 性能与压力测试

3.1 性能监控

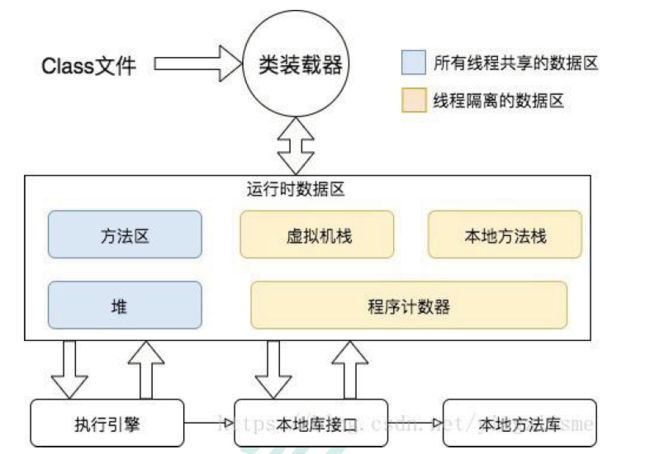

3.1.1 jvm 内存模型

- 程序计数器Program Counter Register:

- 记录的是正在执行的虚拟机字节码指令的地址,

- 此内存区域是唯一一个在JAVA 虚拟机规范中没有规定任何OutOfMemoryError 的区

域

- 虚拟机:VM Stack

- 描述的是JAVA 方法执行的内存模型,每个方法在执行的时候都会创建一个栈帧,

用于存储局部变量表,操作数栈,动态链接,方法接口等信息 - 局部变量表存储了编译期可知的各种基本数据类型、对象引用

- 线程请求的栈深度不够会报StackOverflowError 异常

- 栈动态扩展的容量不够会报OutOfMemoryError 异常

- 虚拟机栈是线程隔离的,即每个线程都有自己独立的虚拟机栈

- 描述的是JAVA 方法执行的内存模型,每个方法在执行的时候都会创建一个栈帧,

- 本地方法:Native Stack

- 本地方法栈类似于虚拟机栈,只不过本地方法栈使用的是本地方法

- 堆:Heap

- 几乎所有的对象实例都在堆上分配内存

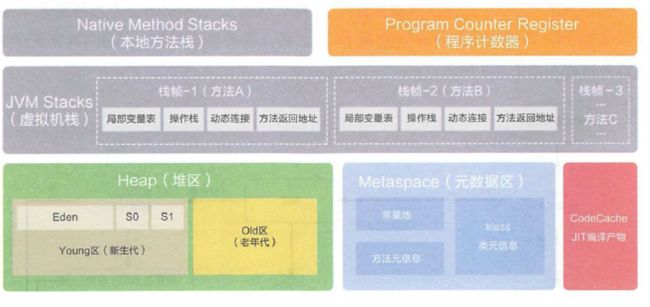

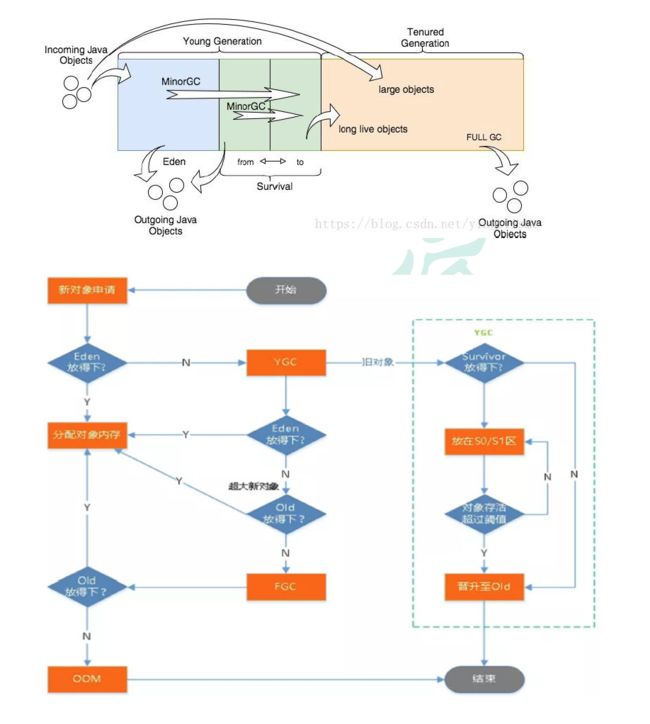

3.1.2 堆

补充知识:

内存中的区域是如何划分的,对象的引用在哪个区域?

Java虚拟机将内存分为两个部分,一个线程共享的,一个线程私有的。线程共享的有方法区和堆,线程私有的有栈、本地方法栈和程序计数器。

堆用来存放对象实例,栈用来存放形参或局部变量。

什么是垃圾回收机制

垃圾回收可以有效的防止内存泄露,有效的使用空闲的内存。

内存泄露是指该内存空间使用完毕之后未回收,内存泄露过多会导致内存溢出,导致应用程序所占内存超出系统限制,最终被系统杀掉。

什么是垃圾

这里的垃圾是指无用的对象或其它数据等已经不被需要,但却无法被GC所释放。

所有的对象实例以及数组都要在堆上分配。堆是垃圾收集器管理的主要区域,也被称为“GC堆”;也是我们优化最多考虑的地方。

堆可以细分为:

-

新生代

- Eden 空间

- From Survivor 空间

- To Survivor 空间

-

老年代

-

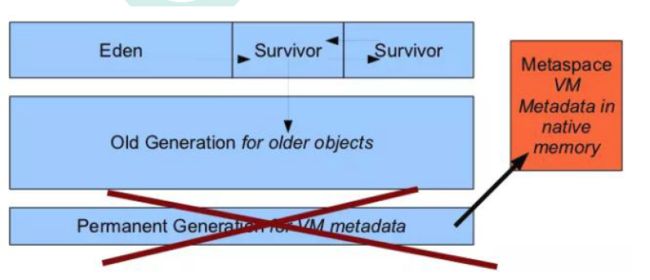

永久代/元空间

- Java8 以前永久代,受jv m 管理,java8 以后元空间,直接使用物理内存。因此,

默认情况下,元空间的大小仅受本地内存限制。

- Java8 以前永久代,受jv m 管理,java8 以后元空间,直接使用物理内存。因此,

垃圾回收

从Java8 开始,HotSpot 已经完全将永久代(Permanent Generation)移除,取而代之的是一

个新的区域—元空间(MetaSpace)。

伊甸园区能放下,就放,放不下,小GC一次,存活的放幸存者区;实在放不下,就放老年代。老年代如果还放不下,就来一个大GC,将新生代和老年代内存清理;放得下就放,放不下就报异常。

YGC触发的时机:伊甸园区的内存不够了;

FGC触发的时间:老年代的内存都不够了;

FGC要比 YGC慢很多我们要避免 FGC次数太多,影响整体性能。

老年代主要放:存活时间久;大对象

伊甸园区GC之后,将放到 幸存者区。

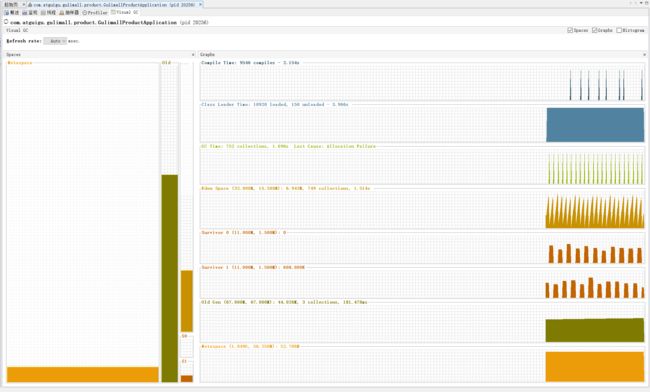

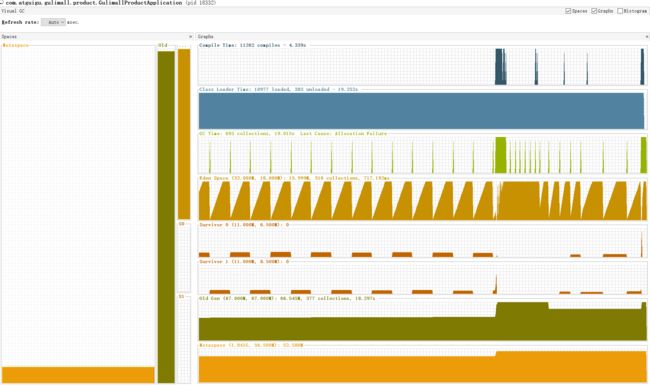

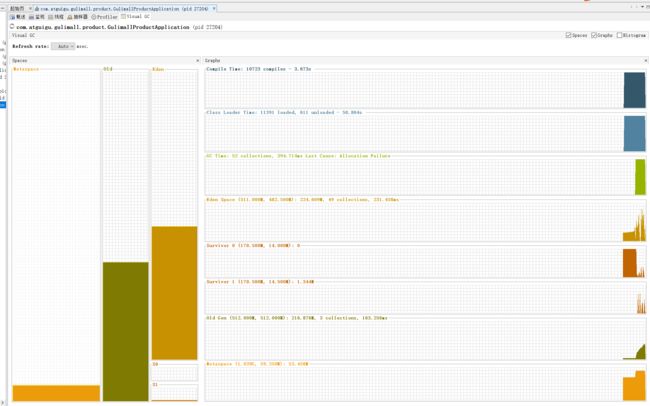

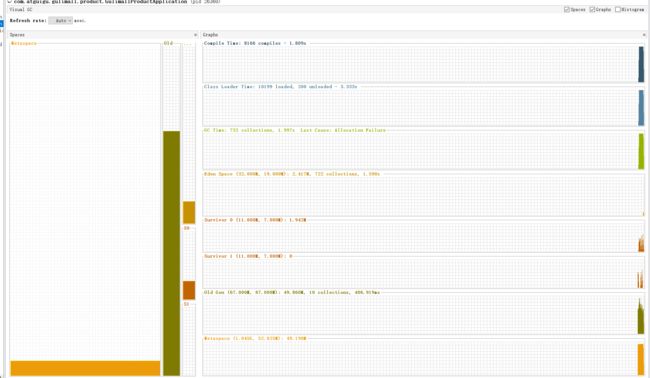

visual GC 垃圾回收机制:

要避免 FGC,因为 FGC比 YGC 花费的时间多很多。

补充知识:

图解Java 垃圾回收机制

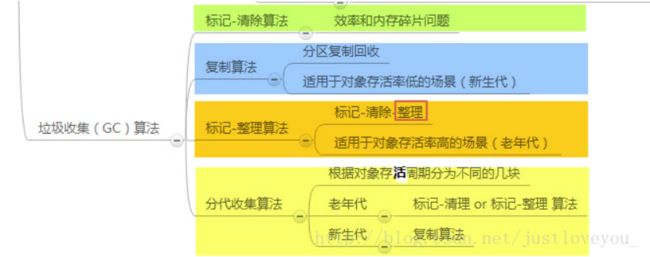

垃圾回收算法共有 4种:①标记清算算法;②复制算法;③标记整理算法;④分代收集算法。

这里主要讲第④种。

1. 分代收集算法

对于一个大型的系统,当创建的对象和方法变量比较多时,堆内存中的对象也会比较多,如果逐一分析对象是否该回收,那么势必造成效率低下。分代收集算法是基于这样一个事实:不同的对象的生命周期(存活情况)是不一样的,而不同生命周期的对象位于堆中不同的区域,因此对堆内存不同区域采用不同的策略进行回收可以提高 JVM 的执行效率。当代商用虚拟机使用的都是分代收集算法:新生代对象存活率低,就采用复制算法;老年代存活率高,就用标记清除算法或者标记整理算法。Java堆内存一般可以分为新生代、老年代和永久代三个模块。

1). 新生代(Young Generation)

新生代的目标就是尽可能快速的收集掉那些生命周期短的对象,一般情况下,所有新生成的对象首先都是放在新生代的。新生代内存按照 8:1:1 的比例分为一个eden区和两个survivor(survivor0,survivor1)区,大部分对象在Eden区中生成。在进行垃圾回收时,先将eden区存活对象复制到survivor0区,然后清空eden区,当这个survivor0区也满了时,则将eden区和survivor0区存活对象复制到survivor1区,然后清空eden和这个survivor0区,此时survivor0区是空的,然后交换survivor0区和survivor1区的角色(即下次垃圾回收时会扫描Eden区和survivor1区),即保持survivor0区为空,如此往复。特别地,当survivor1区也不足以存放eden区和survivor0区的存活对象时,就将存活对象直接存放到老年代。如果老年代也满了,就会触发一次FullGC,也就是新生代、老年代都进行回收。注意,新生代发生的GC也叫做MinorGC,MinorGC发生频率比较高,不一定等 Eden区满了才触发。

2). 老年代(Old Generation)

老年代存放的都是一些生命周期较长的对象,就像上面所叙述的那样,在新生代中经历了N次垃圾回收后仍然存活的对象就会被放到老年代中。此外,老年代的内存也比新生代大很多(大概比例是1:2),当老年代满时会触发Major GC(Full GC),老年代对象存活时间比较长,因此FullGC发生的频率比较低。

3). 永久代(Permanent Generation)

永久代主要用于存放静态文件,如Java类、方法等。永久代对垃圾回收没有显著影响,但是有些应用可能动态生成或者调用一些class,例如使用反射、动态代理、CGLib等bytecode框架时,在这种时候需要设置一个比较大的永久代空间来存放这些运行过程中新增的类。

2.小结:

由于对象进行了分代处理,因此垃圾回收区域、时间也不一样。垃圾回收有两种类型,Minor GC 和 Full GC。

-

Minor GC:对新生代进行回收,不会影响到年老代。因为新生代的 Java 对象大多死亡频繁,所以 Minor GC 非常频繁,一般在这里使用速度快、效率高的算法,使垃圾回收能尽快完成。

-

Full GC:也叫 Major GC,对整个堆进行回收,包括新生代和老年代。由于Full GC需要对整个堆进行回收,所以比Minor GC要慢,因此应该尽可能减少Full GC的次数,导致Full GC的原因包括:老年代被写满、永久代(Perm)被写满和System.gc()被显式调用等。

3. 垃圾收集器

如果说垃圾收集算法是内存回收的方法论,那么垃圾收集器就是内存回收的具体实现。下图展示了7种作用于不同分代的收集器,其中用于回收新生代的收集器包括Serial、PraNew、Parallel Scavenge,回收老年代的收集器包括Serial Old、Parallel Old、CMS,还有用于回收整个Java堆的G1收集器。不同收集器之间的连线表示它们可以搭配使用。

Serial收集器(复制算法): 新生代单线程收集器,标记和清理都是单线程,优点是简单高效;

Serial Old收集器 (标记-整理算法): 老年代单线程收集器,Serial收集器的老年代版本;

ParNew收集器 (复制算法): 新生代收并行集器,实际上是Serial收集器的多线程版本,在多核CPU环境下有着比Serial更好的表现;

Parallel Scavenge收集器 (复制算法): 新生代并行收集器,追求高吞吐量,高效利用 CPU。吞吐量 = 用户线程时间/(用户线程时间+GC线程时间),高吞吐量可以高效率的利用CPU时间,尽快完成程序的运算任务,适合后台应用等对交互相应要求不高的场景;

Parallel Old收集器 (标记-整理算法): 老年代并行收集器,吞吐量优先,Parallel Scavenge收集器的老年代版本;

CMS(Concurrent Mark Sweep)收集器(标记-清除算法): 老年代并行收集器,以获取最短回收停顿时间为目标的收集器,具有高并发、低停顿的特点,追求最短GC回收停顿时间。

G1(Garbage First)收集器 (标记-整理算法): Java堆并行收集器,G1收集器是JDK1.7提供的一个新收集器,G1收集器基于“标记-整理”算法实现,也就是说不会产生内存碎片。此外,G1收集器不同于之前的收集器的一个重要特点是:G1回收的范围是整个Java堆(包括新生代,老年代),而前六种收集器回收的范围仅限于新生代或老年代。

4.内存分配与回收策略

Java技术体系中所提倡的自动内存管理最终可以归结为自动化地解决了两个问题:给对象分配内存 以及 回收分配给对象的内存。一般而言,对象主要分配在新生代的Eden区上,如果启动了本地线程分配缓存(TLAB),将按线程优先在TLAB上分配。少数情况下也可能直接分配在老年代中。总的来说,内存分配规则并不是一层不变的,其细节取决于当前使用的是哪一种垃圾收集器组合,还有虚拟机中与内存相关的参数的设置。

1) 对象优先在Eden分配,当Eden区没有足够空间进行分配时,虚拟机将发起一次MinorGC。现在的商业虚拟机一般都采用复制算法来回收新生代,将内存分为一块较大的Eden空间和两块较小的Survivor空间,每次使用Eden和其中一块Survivor。 当进行垃圾回收时,将Eden和Survivor中还存活的对象一次性地复制到另外一块Survivor空间上,最后处理掉Eden和刚才的Survivor空间。(HotSpot虚拟机默认Eden和Survivor的大小比例是8:1)当Survivor空间不够用时,需要依赖老年代进行分配担保。

2) 大对象直接进入老年代。所谓的大对象是指,需要大量连续内存空间的Java对象,最典型的大对象就是那种很长的字符串以及数组。

3) 长期存活的对象将进入老年代。当对象在新生代中经历过一定次数(默认为15)的Minor GC后,就会被晋升到老年代中。

4) 动态对象年龄判定。为了更好地适应不同程序的内存状况,虚拟机并不是永远地要求对象年龄必须达到了MaxTenuringThreshold才能晋升老年代,如果在Survivor空间中相同年龄所有对象大小的总和大于Survivor空间的一半,年龄大于或等于该年龄的对象就可以直接进入老年代,无须等到MaxTenuringThreshold中要求的年龄。

需要注意的是,Java的垃圾回收机制是Java虚拟机提供的能力,用于在空闲时间以不定时的方式动态回收无任何引用的对象占据的内存空间。也就是说,垃圾收集器回收的是无任何引用的对象占据的内存空间而不是对象本身。

3.1.3 jconsole 与jvisualvm

Jdk 的两个小工具jconsole、jvisualvm(升级版的jconsole);通过命令行启动,可监控本地和

远程应用。远程应用需要配置。

通过 jconsole 命令启动

1、jconsole控制台

2、jvisualvm 能干什么

监控内存泄露,跟踪垃圾回收,执行时内存、cpu 分析,线程分析…

运行:正在运行的

休眠:sleep

等待:wait

驻留:线程池里面的空闲线程

监视:阻塞的线程,正在等待锁

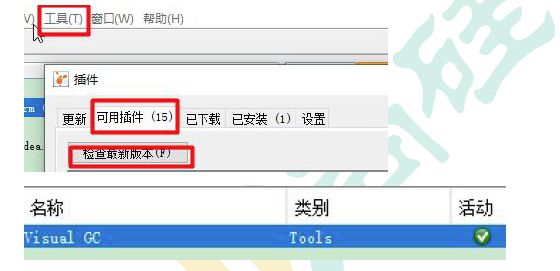

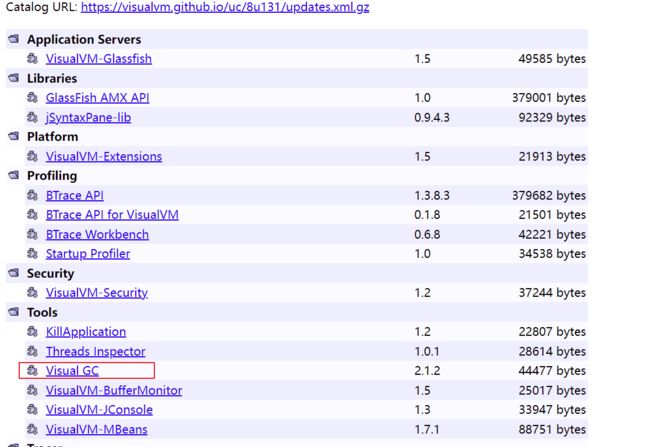

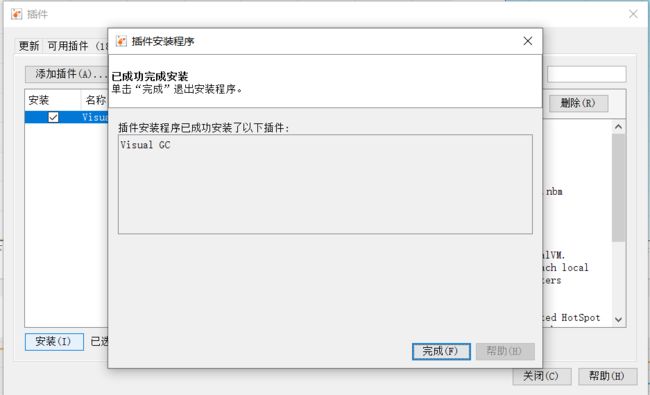

3、安装插件方便查看gc

-

Cmd 启动jvisualvm

-

工具->插件

-

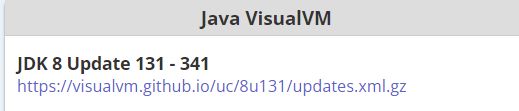

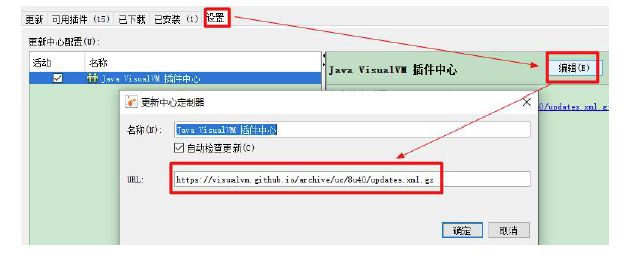

如果503 错误解决:

提示 “https://github.com/visualvm/visualvm.src/releases/download/1.3.9/com-sun-tools-visualvm-modules-visualgc.nbm中出现网络问题”

解决:

jdk安装Visual Gc,报错检查代理设置或稍后重试。服务器目前可能不可用。 您可能还需要确保防火墙不会阻塞网络通信。 您的高速缓存可能已过期。请单击“检查更新”以刷新内容。解决

用解决方式2,下载对应版本GC,然后本地安装。

3.1.4 监控指标

1、中间件指标

- 当前正在运行的线程数不能超过设定的最大值。一般情况下系统性能较好的情况下,线

程数最小值设置50 和最大值设置200 比较合适。 - 当前运行的JDBC 连接数不能超过设定的最大值。一般情况下系统性能较好的情况下,

JDBC 最小值设置50 和最大值设置200 比较合适。 - GC频率不能频繁,特别是FULL GC 更不能频繁,一般情况下系统性能较好的情况下,

JVM 最小堆大小和最大堆大小分别设置1024M 比较合适。

2、数据库指标

- SQL 耗时越小越好,一般情况下微秒级别。

- 命中率越高越好,一般情况下不能低于95%。

- 锁等待次数越低越好,等待时间越短越好。

- 中间件越多,性能损失越大,大多都损失在网络交互了;

- 业务:

- Db(MySQL 优化)

- 模板的渲染速度(缓存)

- 静态资源

3.1.5 JVM 分析&调优

jvm 调优,调的是稳定,并不能带给你性能的大幅提升。服务稳定的重要性就不用多说了,保证服务的稳定,gc 永远会是Java 程序员需要考虑的不稳定因素之一。复杂和高并发下的服务,必须保证每次gc 不会出现性能下降,各种性能指标不会出现波动,gc 回收规律而且干净,找到合适的jvm 设置。Full gc 最会影响性能,根据代码问题,避免full gc 频率。可以适当调大年轻代容量,让大对象可以在年轻代触发yong gc,调整大对象在年轻代的回收频次,尽可能保证大对象在年轻代回收,减小老年代缩短回收时间;

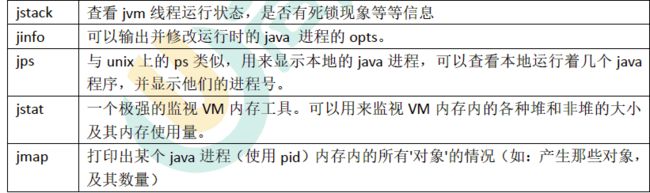

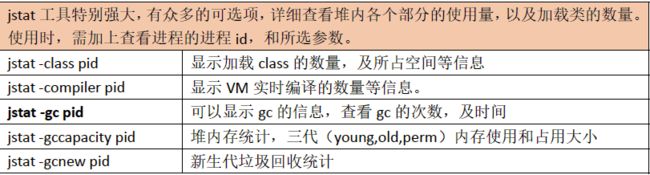

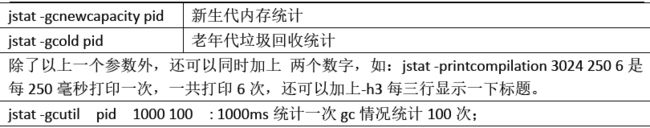

1、几个常用工具

2、命令示例

在使用这些工具前,先用JPS 命令获取当前的每个JVM 进程号,然后选择要查看的JVM。

3、调优项

官方文档:https://docs.oracle.com/javase/8/docs/technotes/tools/unix/java.html#BGBCIEFC

3.2 压力测试

压力测试考察当前软硬件环境下系统所能承受的最大负荷并帮助找出系统瓶颈所在。压测都是为了系统在线上的处理能力和稳定性维持在一个标准范围内,做到心中有数。

使用压力测试,我们有希望找到很多种用其他测试方法更难发现的错误。有两种错误类型是:

内存泄漏,并发与同步。

有效的压力测试系统将应用以下这些关键条件:重复,并发,量级,随机变化。

3.2.1 性能指标

- 响应时间(Response Time: RT)

响应时间指用户从客户端发起一个请求开始,到客户端接收到从服务器端返回的响应结束,整个过程所耗费的时间。 - HPS(Hits Per Second) :每秒点击次数,单位是次/秒。

- TPS(Transaction per Second):系统每秒处理交易数,单位是笔/秒。

- QPS(Query per Second):系统每秒处理查询次数,单位是次/秒。

对于互联网业务中,如果某些业务有且仅有一个请求连接,那么TPS=QPS=HPS,一般情况下用TPS 来衡量整个业务流程,用QPS 来衡量接口查询次数,用HPS 来表示对服务器单击请求。 - 无论TPS、QPS、HPS,此指标是衡量系统处理能力非常重要的指标,越大越好,根据经

验,一般情况下:

金融行业:1000TPS~50000TPS,不包括互联网化的活动

保险行业:100TPS~100000TPS,不包括互联网化的活动

制造行业:10TPS~5000TPS

互联网电子商务:10000TPS~1000000TPS

互联网中型网站:1000TPS~50000TPS

互联网小型网站:500TPS~10000TPS - 最大响应时间(Max Response Time) 指用户发出请求或者指令到系统做出反应(响应)

的最大时间。 - 最少响应时间(Mininum ResponseTime) 指用户发出请求或者指令到系统做出反应(响

应)的最少时间。 - 90%响应时间(90% Response Time) 是指所有用户的响应时间进行排序,第90%的响

应时间。 - 从外部看,性能测试主要关注如下三个指标

吞吐量:每秒钟系统能够处理的请求数、任务数。

响应时间:服务处理一个请求或一个任务的耗时。

错误率:一批请求中结果出错的请求所占比例。

3.2.2 JMeter

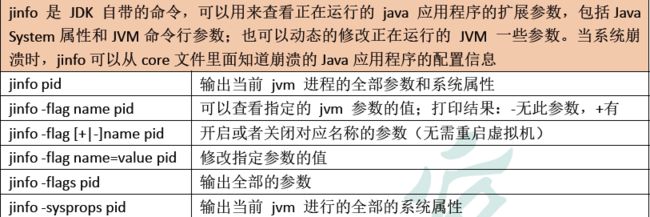

1)、JMeter 安装

https://jmeter.apache.org/download_jmeter.cgi

jmeter 历史版本:https://archive.apache.org/dist/jmeter/binaries/

下载对应的压缩包,解压运行jmeter.bat 即可

注意:Jmeter 启动闪一下就不启动,解决办法:jmeter闪一下就关闭,无法启动

添加 环境变量即可。

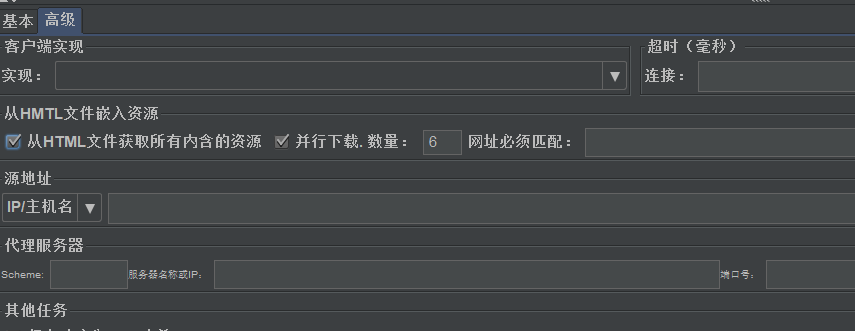

2)、JMeter 压测示例

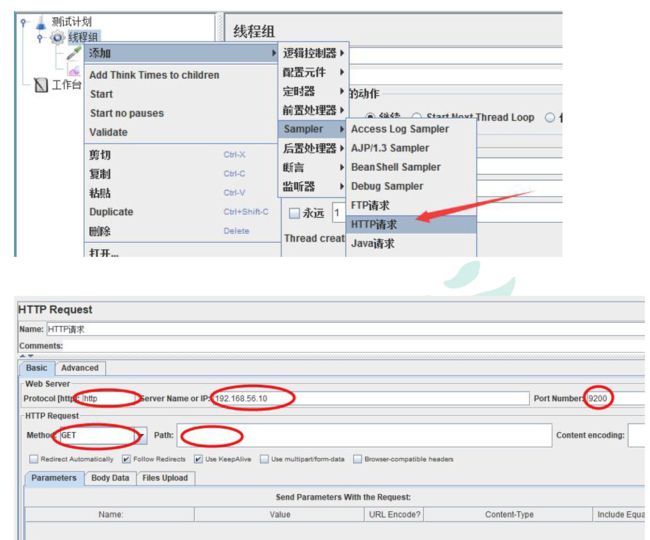

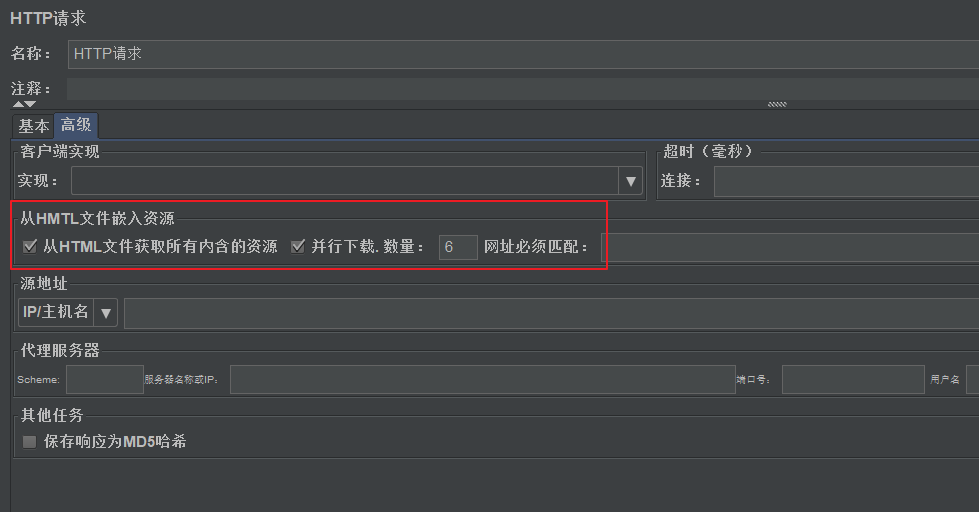

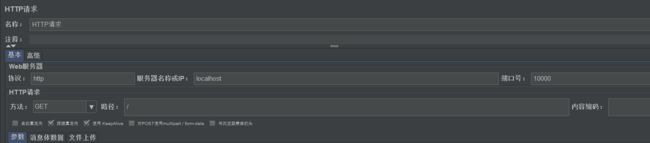

①、添加线程组

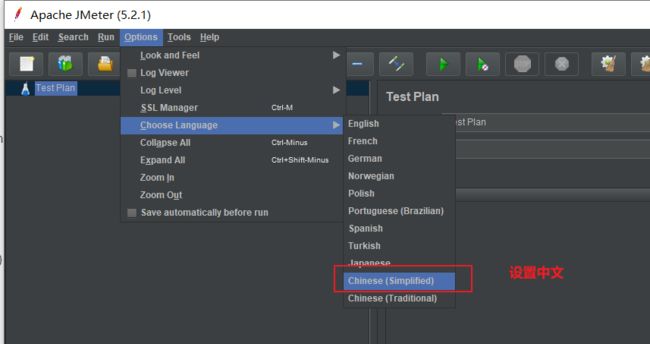

可以设置成中文,方便初学者进行使用熟悉。

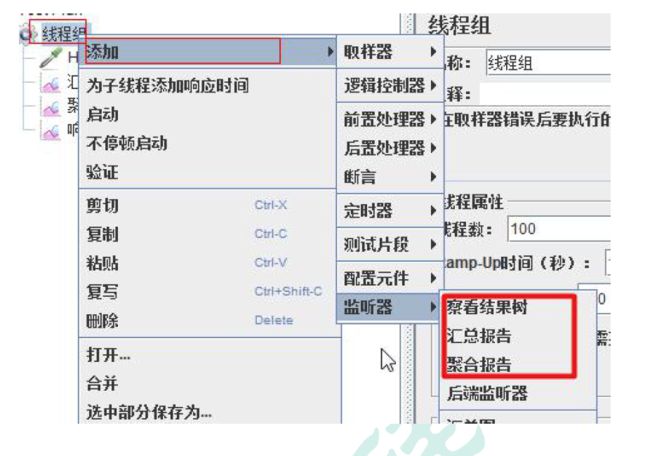

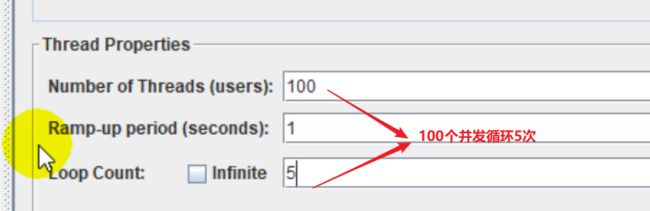

线程组参数详解:

- 线程数:虚拟用户数。一个虚拟用户占用一个进程或线程。设置多少虚拟用户数在这里

也就是设置多少个线程数。 - Ramp-Up Period(in seconds)准备时长:设置的虚拟用户数需要多长时间全部启动。如果

线程数为10,准备时长为2,那么需要2 秒钟启动10 个线程,也就是每秒钟启动5 个

线程。 - 循环次数:每个线程发送请求的次数。如果线程数为10,循环次数为100,那么每个线

程发送100 次请求。总请求数为10*100=1000 。如果勾选了“永远”,那么所有线程会

一直发送请求,一到选择停止运行脚本。 - Delay Thread creation until needed:直到需要时延迟线程的创建。

- 调度器:设置线程组启动的开始时间和结束时间(配置调度器时,需要勾选循环次数为

永远) - 持续时间(秒):测试持续时间,会覆盖结束时间

- 启动延迟(秒):测试延迟启动时间,会覆盖启动时间

- 启动时间:测试启动时间,启动延迟会覆盖它。当启动时间已过,手动只需测试时当前

时间也会覆盖它。 - 结束时间:测试结束时间,持续时间会覆盖它。

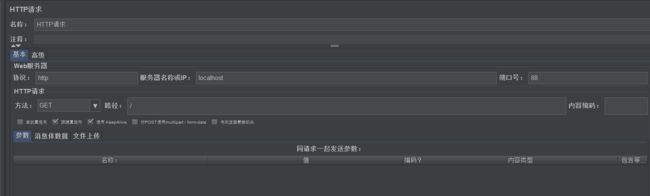

②、添加HTTP 请求

③、添加监听器

④、启动压测&查看分析结果

结果分析

- 有错误率同开发确认,确定是否允许错误的发生或者错误率允许在多大的范围内;

- Throughput 吞吐量每秒请求的数大于并发数,则可以慢慢的往上面增加;若在压测的机

器性能很好的情况下,出现吞吐量小于并发数,说明并发数不能再增加了,可以慢慢的

往下减,找到最佳的并发数; - 压测结束,登陆相应的web 服务器查看CPU 等性能指标,进行数据的分析;

- 最大的tps,不断的增加并发数,加到tps 达到一定值开始出现下降,那么那个值就是

最大的tps。 - 最大的并发数:最大的并发数和最大的tps 是不同的概率,一般不断增加并发数,达到

一个值后,服务器出现请求超时,则可认为该值为最大的并发数。 - 压测过程出现性能瓶颈,若压力机任务管理器查看到的cpu、网络和cpu 都正常,未达

到90%以上,则可以说明服务器有问题,压力机没有问题。 - 影响性能考虑点包括:

数据库、应用程序、中间件(tomact、Nginx)、网络和操作系统等方面 - 首先考虑自己的应用属于CPU 密集型还是IO 密集型。

3、JMeter Address Already in use 错误解决

windows 本身提供的端口访问机制的问题。

Windows 提供给TCP/IP 链接的端口为1024-5000,并且要四分钟来循环回收他们。就导致

我们在短时间内跑大量的请求时将端口占满了。

- cmd 中,用regedit 命令打开注册表

- 在HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\Tcpip\Parameters 下,

1 .右击parameters,添加一个新的DWORD,名字为MaxUserPort

2 .然后双击MaxUserPort,输入数值数据为65534,基数选择十进制(如果是分布式运行的话,控制机器和负载机器都需要这样操作哦)- 修改配置完毕之后记得重启机器才会生效

windows官方解决办法:https://support.microsoft.com/zh-cn/help/196271/when-you-try-to-connect-from-tcp-ports-greater-than-5000-you-receive-tTCPTimedWaitDelay:30

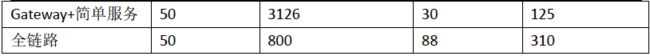

3.3.3 压测与分析

按表格中进行压测。

- 压测中间件

线程数这里统一 都是 50,避免设置太高导致 内存爆满等情况。

- Nginx

压测 1分10秒

汇总报告

聚合报告

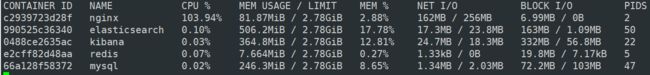

docker stats :实时查看 状态

内存比较浪费,因为 Nginx 基本只做转发,并不实际处理请求,主要是空闲状态。

- 网关压测

![]()

-

压测一个简单服务

IndexController

//压力测试

//简单服务

//搭配中间件

@ResponseBody

@GetMapping("/hello")

public String hello(){

return "hello";

}

![]()

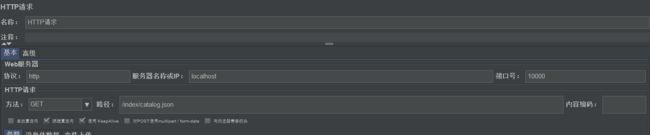

- 简单服务 搭配 网关

- id: product_route

uri: lb://gulimall-product

predicates:

- Path=/api/product/**,/hello

filters:

- RewritePath=/api/(?<segment>/?.*), /$\{segment}

#http://localhost:88/api/product/gory/list/tree http://localhost:10000/product/gory/list/tree

- 网关 + Nginx + 简单服务

- 首页全量数据获取压测(包括静态资源)

- 压测首页一级菜单渲染

![]()

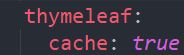

- 压测首页一级菜单渲染开缓存(优化1:开缓存:线上生产时需要;开发时关闭)

略有提升

-

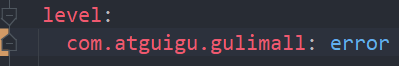

压测 首页开缓存 、数据库优化、日志级别提高(这里的首页就是首页一级分类)

补充:日志等级由低到高:debug

优化2

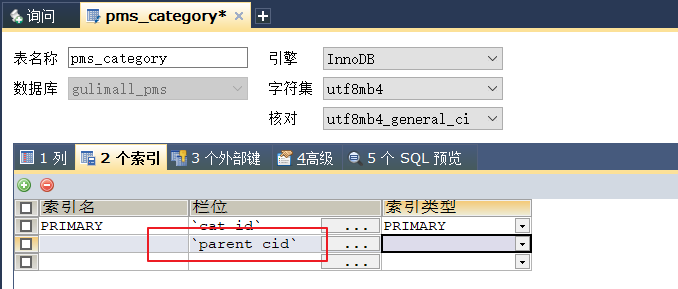

数据库字段 parent_cid 没有索引的条件下

/**

* 查找 1级分类

* parent_cid = 0 或者 cat_level = 1

* @return

*/

@Override

public List<CategoryEntity> getLevel1Categorys() {

long l = System.currentTimeMillis();//压力测试

List<CategoryEntity> categoryEntities = baseMapper.selectList(new QueryWrapper<CategoryEntity>().eq("parent_cid", 0));

System.out.println("消耗时间:" + (System.currentTimeMillis() - l));//测试没有索引的条件下,具体时间耗费

return categoryEntities;

}

优化3

给 parent_cid 添加索引

![]()

- 压测 三级分类数据获取

![]()

![]()

吞吐量实在太低。

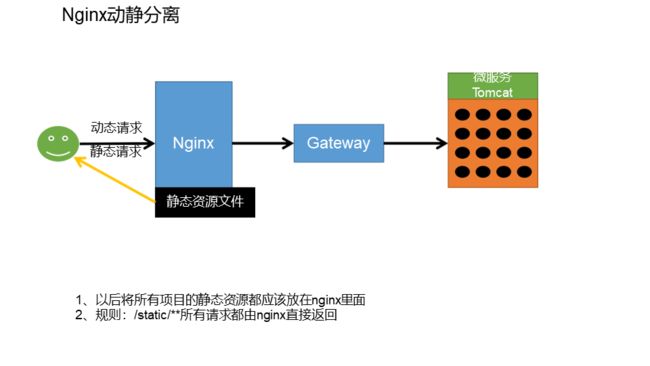

- 动静分离

动态请求转交给 微服务;静态请求直接返回。

后台服务专心处理动态资源,继而可以提升很大的吞吐量。

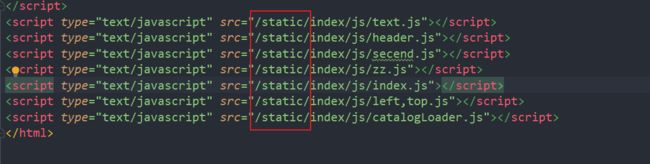

①将静态资源文件 放在 Nginx下:这里将商品服务 static下的index资源复制过来,商品服务下的可以删除。

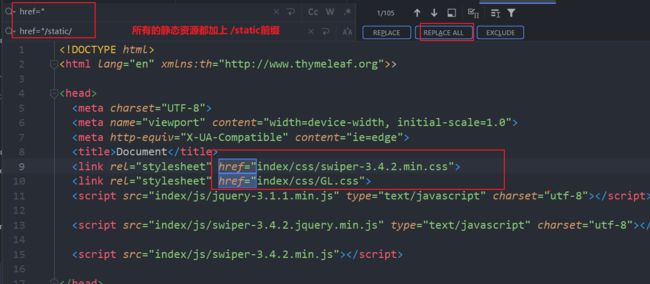

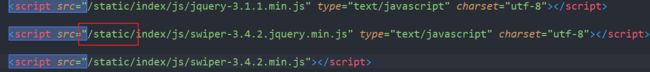

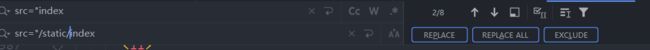

②给index.html中的静态资源加上前缀。

css:

js:

img:

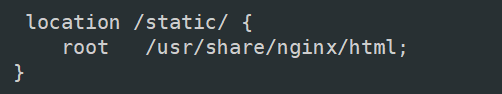

③在 gulimall.conf 中修改,添加 路径

测试

- 在开缓存,日志提高、有索引、动静分离的情况下,首页全量数据压测。

①先将 线程数设置为50进行测试,看优化效果。

![]()

![]()

确实有提升。

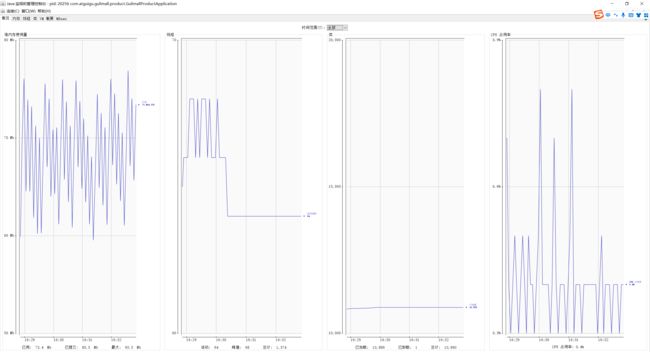

②将线程 设置 为 200,模拟 线上应用内存崩溃宕机。

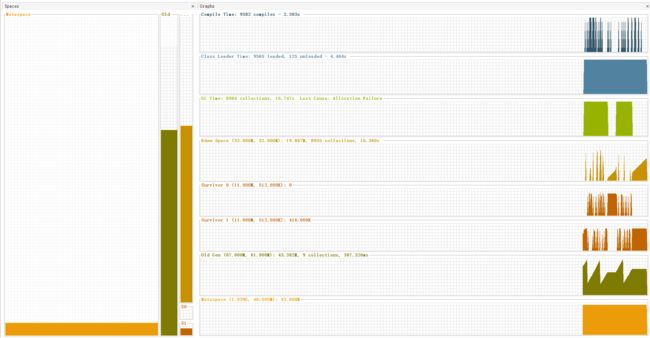

可以看到 老年代以及伊甸园区内存都溢满了,FGC次数频繁:

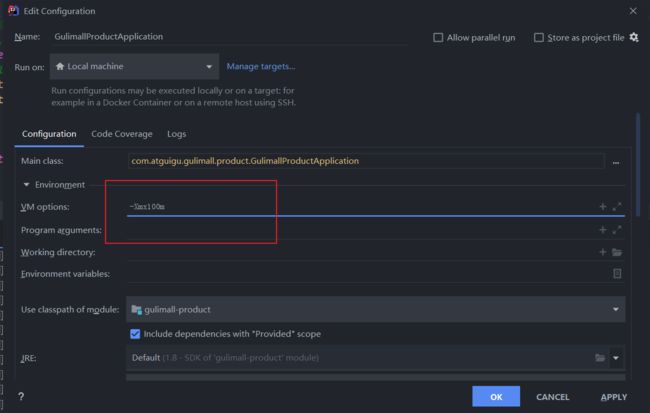

这是因为我们给商品服务设置的内存太小了,仅有100M,所以很容易爆满。

idea控制台报错,堆溢出等问题:

首页访问不了,因为 线上应用期间,CPU 内存爆满、卡死,将应用挤下线。

优化:加大内存,避免 老年代和新生代 内存满了之后一直GC,拖慢时间。

200线程数压测。

伊甸园区内存可能爆满,GC次数多(频繁创建临时对象),老年代GC次数减少。

![]()

![]()

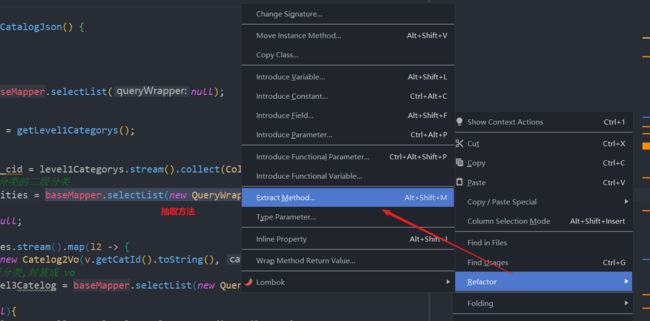

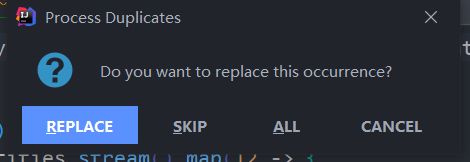

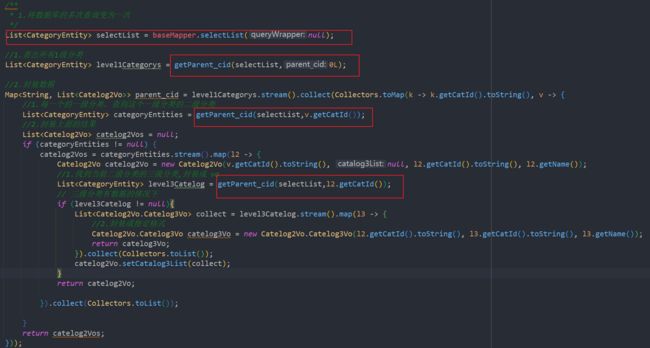

- 优化三级分类查询。

1.将数据库的多次查询变为一次,之前是嵌套查询,导致和数据库做很多次交互

baseMapper.selectList(new QueryWrapper<CategoryEntity>().eq("parent_cid", parentCid));

将上面的查询代码抽取为一个方法,继而减少 查询三级分类这个方法对数据库的多次查询,优化DB操作。

最终结果改造:

@Override

public Map<String, List<Catelog2Vo>> getCatalogJson() {

/**

* 1.将数据库的多次查询变为一次,之前是嵌套查询,导致和数据库做很多次交互

* 后续查询操作从这次查询结果中取结果

*/

List<CategoryEntity> selectList = baseMapper.selectList(null);//不传任何条件,就代表查询所有。

//1.查出所有1级分类

List<CategoryEntity> level1Categorys = getParent_cid(selectList,0L);//1级分类的 父id 是 0

//2.封装数据

Map<String, List<Catelog2Vo>> parent_cid = level1Categorys.stream().collect(Collectors.toMap(k -> k.getCatId().toString(), v -> {

//1.每一个的一级分类,查到这个一级分类的二级分类

List<CategoryEntity> categoryEntities = getParent_cid(selectList,v.getCatId());//将正在遍历的元素v的catId作为 parent_cid的值,就可以找出它的子分类

//2.封装上面的结果

List<Catelog2Vo> catelog2Vos = null;

if (categoryEntities != null) {

catelog2Vos = categoryEntities.stream().map(l2 -> {

Catelog2Vo catelog2Vo = new Catelog2Vo(v.getCatId().toString(), null, l2.getCatId().toString(), l2.getName());

//1.找到当前二级分类的三级分类,封装成 vo

List<CategoryEntity> level3Catelog = getParent_cid(selectList,l2.getCatId());

// 三级分类有数据的情况下

if (level3Catelog != null){

List<Catelog2Vo.Catelog3Vo> collect = level3Catelog.stream().map(l3 -> {

//2.封装成指定格式

Catelog2Vo.Catelog3Vo catelog3Vo = new Catelog2Vo.Catelog3Vo(l2.getCatId().toString(), l3.getCatId().toString(), l3.getName());

return catelog3Vo;

}).collect(Collectors.toList());

catelog2Vo.setCatalog3List(collect);

}

return catelog2Vo;

}).collect(Collectors.toList());

}

return catelog2Vos;

}));

return parent_cid;

}

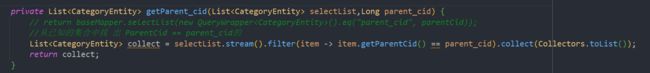

private List<CategoryEntity> getParent_cid(List<CategoryEntity> selectList,Long parent_cid) {

// return baseMapper.selectList(new QueryWrapper().eq("parent_cid", parentCid));

//从已知的集合 selectList (查询所有)中找 出 ParentCid == 指定的值

List<CategoryEntity> collect = selectList.stream().filter(item -> item.getParentCid() == parent_cid).collect(Collectors.toList());

return collect;

}

为了开发期间方便,改为100m

测试:

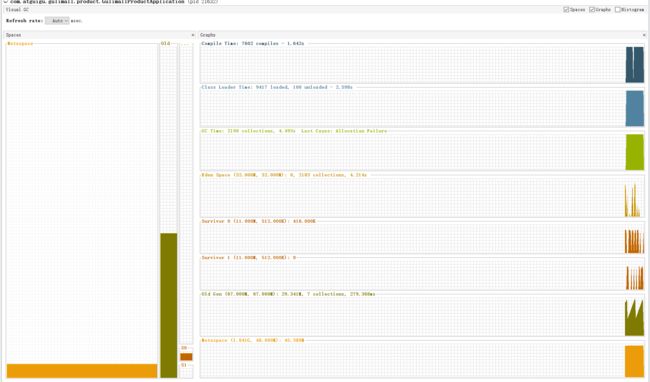

![]()

可以看出,即使优化了业务操作,其吞吐量也不是很高,所以我们接下来使用分布式系统中的性能提升大神器:缓存。合理运用缓存,可以给系统一个质的提升。

总结:

- 中间件越多,性能损失越大,大多都损失在网络交互了;

- 业务:

- Db(MySQL 优化)

- 模板的渲染速度(缓存)

- 静态资源

4 缓存与分布式锁

4.1 缓存

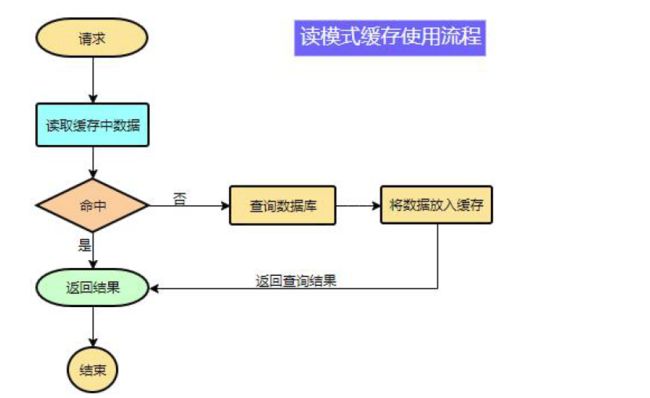

4.1.1 缓存使用

为了系统性能的提升,我们一般都会将部分数据放入缓存中,加速访问。而db 承担数据落盘工作。

哪些数据适合放入缓存?

- 即时性、数据一致性要求不高的

- 访问量大且更新频率不高的数据(读多,写少)

举例:电商类应用,商品分类,商品列表等适合缓存并加一个失效时间(根据数据更新频率来定),后台如果发布一个商品,买家需要5 分钟才能看到新的商品一般还是可以接受的。

data = cache.load(id);//从缓存加载数据

If(data == null){

data = db.load(id);//从数据库加载数据

cache.put(id,data);//保存到cache 中

}

return data;

注意:在开发中,凡是放入缓存中的数据我们都应该指定过期时间,使其可以在系统即使没有主动更新数据也能自动触发数据加载进缓存的流程。避免业务崩溃导致的数据永久不一致问题。

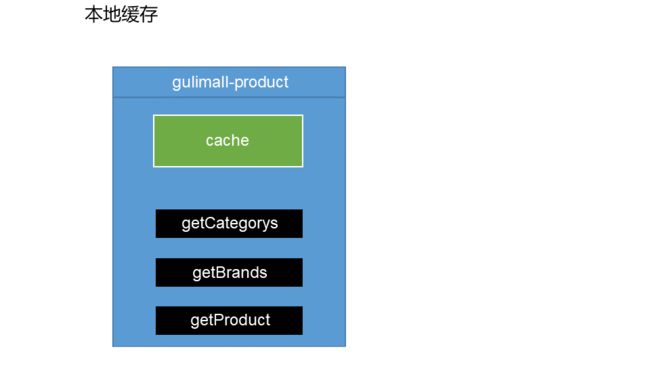

4.1.2 整合redis 作为缓存

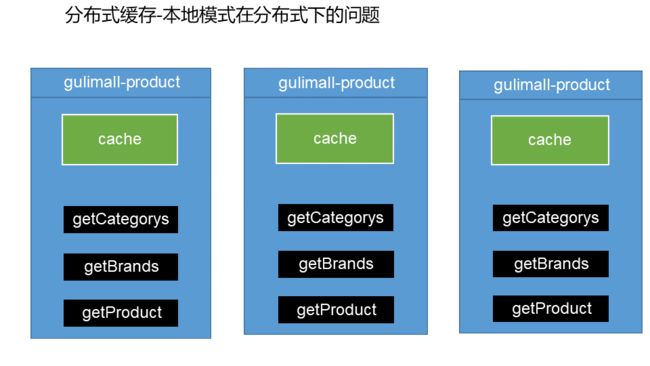

本地缓存的问题:缓存 组件和 项目部署在一起;如果是单体应用,部署在一台机器上,可以有很快的效果,但是在分布式系统下不适用。

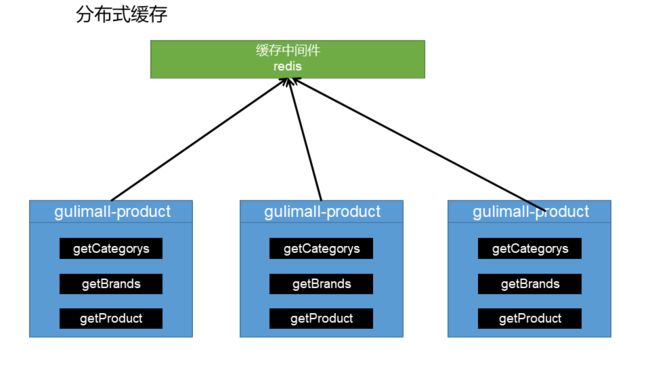

这种方式的问题在于:多台机器之间不能互相使用同一缓存。譬如:①一个请求负载均衡到第一个机器,查出来数据放到缓存中,如果第二次 负载均衡到另外一台机器,那就还得再查一次;②如果一台机器缓存做了修改,其他机器缓存因为负载均衡的原因,不能同时修改,那么就会出现数据一致性问题。

最终的解决方案:使用缓存中间件,集中的向同一个地方缓存数据,就不会出现数据不一致问题。

1、引入依赖:redis的场景启动器

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-data-redisartifactId>

dependency>

2、配置 redis

spring:

redis:

host: 192.168.56.10

port: 6379

3、使用RedisTemplate 操作redis

@Autowired

StringRedisTemplate stringRedisTemplate;

@Test

public void testStringRedisTemplate(){

ValueOperations<String, String> ops = stringRedisTemplate.opsForValue();

//保存

ops.set("hello","world_" + UUID.randomUUID().toString());

//查询

String s = ops.get("hello");

System.out.println(s);

}

redis 保存数据的 5大基本类型:

opsForValue:简单的自变量值

Hash:按照 map形式 kv存储

List: 按照数组存储

Set : 集合

Zset:带排序的集合

效果展示:

![]()

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Djr3vB6y-1672324453424)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233817326-1588767069.png)]

整合Redis总结:

* 6.整合Redis * 1)、引入data-redis-starter * 2)、简单配置redis 的host 等信息 * 3)、使用 springboot自动配置好的 StringRedisTemplate 来操作 redis * redis -> Map;存放数据key,数据值 value *

4.1.3 改造三级分类业务

因为三级分类的数据不会经常变化,所以可以使用缓存。

1、修改 CategoryServiceImpl,将 getCatalogJson 方法 加入缓存逻辑

将之前的 getCatalogJson 方法改名为 getCatalogJsonFromDb

//从数据库查询并封装分类数据

public Map<String, List<Catelog2Vo>> getCatalogJsonFromDb(){}

加入缓存 的 getCatalogJson 方法

@Autowired

StringRedisTemplate redisTemplate;

@Override

public Map<String, List<Catelog2Vo>> getCatalogJson() {

//给缓存中放json字符串,拿出的json字符串,还需要逆转为能用的对象类型:【序列化与反序列化】

//1.加入缓存逻辑,缓存中存的数据时json字符串。

//JSON跨语言,跨平台兼容。

String catalogJSON = redisTemplate.opsForValue().get("catalogJSON");

if (StringUtils.isEmpty(catalogJSON)){

//2.缓存中没有,查询数据库

Map<String, List<Catelog2Vo>> catalogJsonFromDb = getCatalogJsonFromDb();

//3.查到的数据再放入缓存中,将对象转为JSON放在缓存汇总

String s = JSON.toJSONString(catalogJsonFromDb);

redisTemplate.opsForValue().set("catalogJSON",s);

return catalogJsonFromDb;

}

//转为我们指定的对象。

//TypeReference 是一个受保护的方法:protected TypeReference(Type... actualTypeArguments){},所以我们使用匿名内部类的方式创建

Map<String, List<Catelog2Vo>> result = JSON.parseObject(catalogJSON, new TypeReference<Map<String, List<Catelog2Vo>>>() {

});

return result;

}

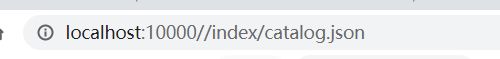

2、效果展示

测试地址:http://gulimall.com//index/catalog.json

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-9yhkWuPY-1672324453424)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233816959-1108505379.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-UG8ElhLt-1672324453424)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233816573-1025484751.png)]

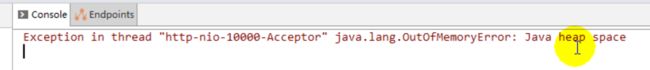

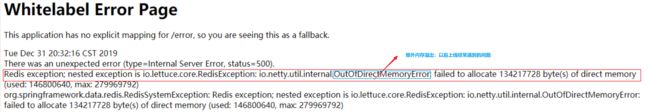

3、堆外内存溢出

- 压力测试

50线程数压测。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-dte4MW5u-1672324453425)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233816027-1338818494.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-UHKYvCss-1672324453425)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233815630-237125882.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-QhT3bC9z-1672324453425)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233815282-707515609.png)]

吞吐量是上来了,但是很多错误。

刷新页面:

Redis exception; nested exception is io.lettuce.core.RedisException: io.netty.util.internal.OutOfDirectMemoryError: failed to allocate 46137344 byte(s) of direct memory (used: 58720256, max: 100663296)

OutOfDirectMemoryError: 堆外内存溢出问题,以后项目上线经常能遇到。

直接内存 就是堆外内存:direct memory

//TODO 产生堆外内存溢出:OutOfDirectMemoryError

//1)、springboot2.0 以后默认使用lettuce 作为操作 redis的客户端。它使用netty进行网络通信。

//2)、lettuce 的bug 导致 netty 堆外内存溢出 -Xmx300m;netty如果没有指定堆外内存,默认使用 -Xmx300m

// 可以通过 -Dio.netty.maxDirectMemory 进行设置

// 解决方法:不能使用 -Dio.netty.maxDirectMemory 只去调大堆外内存。

// 1)、升级 lettuce 客户端。优点:底层使用 netty 进行网络框架,吞吐量大

// 2)、切换使用 jedis。缺点:老版的客户端,很久没有更新了

// 这里使用 切换 jedis,以后线上的时候切换 lettuce,可以通过线上日志的方式进行解决。

//redisTemplate:

// lettuce、jedis操作redis的底层客户端,而spring再次封装成redisTemplate,以后我们使用 redisTemplate 操作redis就行。

这里使用 切换 jedis,以后线上的时候切换 lettuce,可以通过线上日志的方式进行解决。

引入jedis 依赖 ,排除 lettuce

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-data-redisartifactId>

<exclusions>

<exclusion>

<groupId>io.lettucegroupId>

<artifactId>lettuce-coreartifactId>

exclusion>

exclusions>

dependency>

<dependency>

<groupId>redis.clientsgroupId>

<artifactId>jedisartifactId>

dependency>

测试:

老年代经常内存满,这是因为我们内存设置的小的问题。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-uCSKn8Bt-1672324453426)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233812125-1527358074.png)]

可以看出吞吐量确实有显著提升。

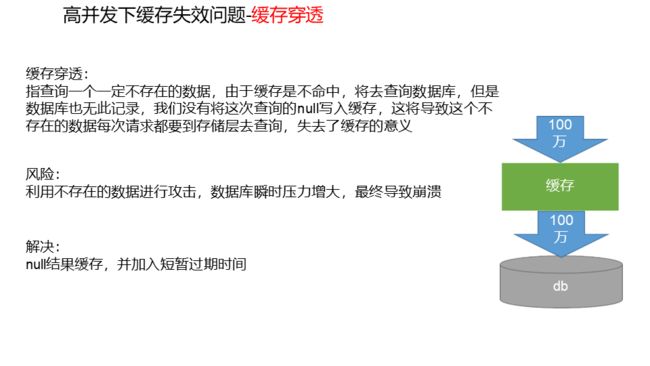

4.1.4 缓存失效问题

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-HvyCsYP1-1672324453426)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233810870-1393688247.png)]

缓存穿透是查询一个永不存在的数据,结果是当大量请求因为查询不到直接转到数据库,导致崩溃;

缓存雪崩是大面积key同时失效,刚好大量请求查询的就是这些过期的key,结果是当大量请求因为查询不到直接转到数据库,导致崩溃;

缓存击穿是某一个key(高频,热点),失效的时候正好大量请求同时进来,结果是当大量请求因为查询不到直接转到数据库,导致崩溃。

官方课件:

先来解决大并发读情况下的缓存失效问题;

1、缓存穿透

- 缓存穿透是指查询一个一定不存在的数据,由于缓存是不命中,将去查询数据库,但是数

据库也无此记录,我们没有将这次查询的null 写入缓存,这将导致这个不存在的数据每次

请求都要到存储层去查询,失去了缓存的意义。- 在流量大时,可能DB 就挂掉了,要是有人利用不存在的key 频繁攻击我们的应用,这就是

漏洞。- 解决:

缓存空结果、并且设置短的过期时间。

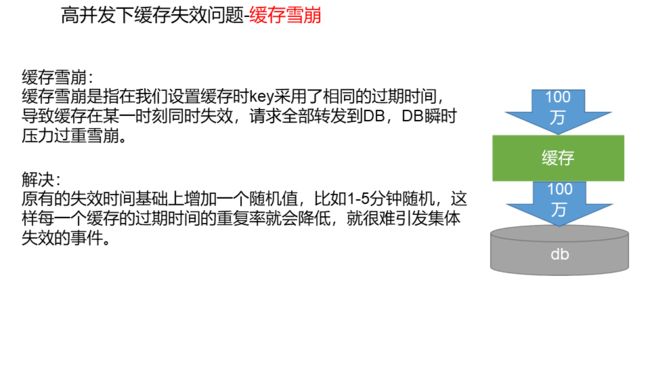

2、缓存雪崩

- 缓存雪崩是指在我们设置缓存时采用了相同的过期时间,导致缓存在某一时刻同时失

效,请求全部转发到DB,DB 瞬时压力过重雪崩。- 解决:

原有的失效时间基础上增加一个随机值,比如1-5 分钟随机,这样每一个缓存的过期时间的

重复率就会降低,就很难引发集体失效的事件。

3、缓存击穿

- 对于一些设置了过期时间的key,如果这些key 可能会在某些时间点被超高并发地访问,

是一种非常“热点”的数据。- 这个时候,需要考虑一个问题:如果这个key 在大量请求同时进来前正好失效,那么所

有对这个key 的数据查询都落到db,我们称为缓存击穿。- 解决:

加锁

缓存穿透和缓存雪崩比较好解决,这里我们先考虑解决 缓存击穿的加锁问题。

4.2 分布式锁

4.2.1 分布式下如何加锁?

本地锁:不管是 方法上加 this,还是同步代码块上加this,这都是将当前实例作为锁的,当前实例在我们容器中是单实例的,但是我们一个项目一个容器:一个商品服务对应一个容器;

比如我们商品服务有10台机器,那我们就有10个容器,就有10把锁:因为this只代表我们当前实例的这个对象,那每一个this都是不同的锁。

最终的结果就是:分布式情况下,有几台机器,就有几个进程进入拿着锁。这里就是有10个进程进入到数据库中查数据。

所以,本地锁只能锁住当前进程。

如果我们想要在大并发情况下,比如80万请求过来,最终只放一个进程进去,就需要分布式锁。

分布式锁处理的比较慢一点,本地锁比较快一点。

本地锁在分布式情况下,缺点就是锁不住所有的请求。其实在当前情况:商品服务下,本地锁也是可以的,因为你比如1000万请求,但是你只有100台机器,你放100个请求到数据库,给数据库带来的压力也不是很大。

分布式锁可以锁住所有的请求。

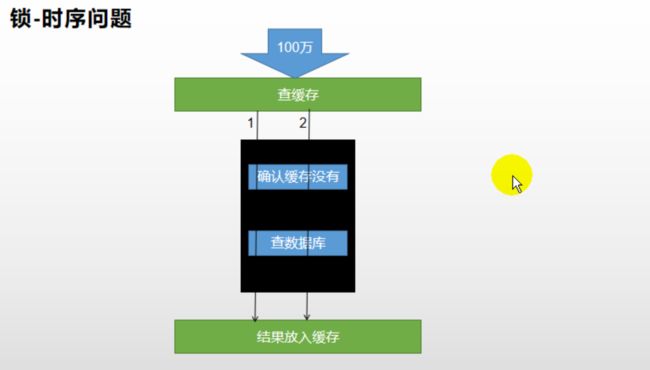

注意,我们需要考虑 锁的时序问题。

问题:当1号线程从数据库中查完数据,释放锁之后,将结果保存到缓存中,保存过程中需要一定的时间;这时如果2号线程拿锁进来,查询,发现缓存中没有,就会查询数据库,继而导致查询2次数据库。

因为第一次 将结果放入缓存,比如刚启动服务等,需要准备线程池等东西,需要有一定的准备时间。

解决方法:将结果放入缓存之后才释放锁。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-UD1MUDlY-1672324453427)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233809468-516739550.png)]

4.2.2 本地锁

①这里我们先测试 本地锁在一个商品服务中:

@Override

public Map<String, List<Catelog2Vo>> getCatalogJson() {

//给缓存中放json字符串,拿出的json字符串,还需要逆转为能用的对象类型:【序列化与反序列化】

/**

* 1、空结果缓存:解决缓存穿透

* 2、设置过期时间(加随机值):解决缓存雪崩

* 3、加锁:解决缓存击穿

*/

//1.加入缓存逻辑,缓存中存的数据时json字符串。

//JSON跨语言,跨平台兼容。

String catalogJSON = redisTemplate.opsForValue().get("catalogJSON");

if (StringUtils.isEmpty(catalogJSON)){

//2.缓存中没有,查询数据库

System.out.println("缓存不命中.....将要查询数据库...");

Map<String, List<Catelog2Vo>> catalogJsonFromDb = getCatalogJsonFromDb();

return catalogJsonFromDb;

}

System.out.println("缓存命中.....直接返回...");

//转为我们指定的对象。

//TypeReference 是一个受保护的方法:protected TypeReference(Type... actualTypeArguments){},所以我们使用匿名内部类的方式创建

Map<String, List<Catelog2Vo>> result = JSON.parseObject(catalogJSON, new TypeReference<Map<String, List<Catelog2Vo>>>() {

});

return result;

}

//从数据库查询并封装分类数据

public Map<String, List<Catelog2Vo>> getCatalogJsonFromDb() {

//1.如果缓存中有就用缓存中的

// Map> catalogJson = (Map>) cache.get("catalogJson");

// if (cache.get("catalogJson") == null){

// //调用业务 xxxxx

// //返回数据又放入缓存

// cache.put("catalogJson",parent_cid);

// }

// return catalogJson;

//只要是同一把锁,就能锁住需要这个锁的所有线程

//1、synchronized (this):SpringBoot所有的组件在容器中都是单例的。this:当前对象

// 也可以加在 方法上: public synchronized Map> getCatalogJsonFromDb() {

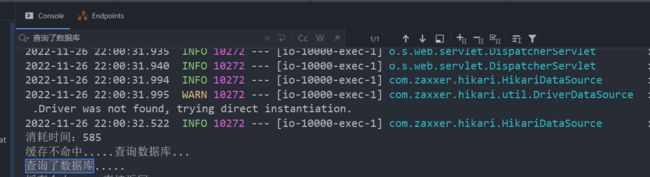

//TODO 本地锁:synchronized,JUC(Lock)----本地锁也叫进程锁,只能锁住当前进程,在分布式情况下,想要锁住所有,必须使用分布式锁。

synchronized (this){

//得到锁以后,我们应该再去缓存中确定一次,如果没有才需要继续查询

String catalogJSON = redisTemplate.opsForValue().get("catalogJSON");

if (!StringUtils.isEmpty(catalogJSON)){

//缓存不为 null ;直接返回

Map<String, List<Catelog2Vo>> result = JSON.parseObject(catalogJSON, new TypeReference<Map<String, List<Catelog2Vo>>>() {

});

return result;

}

System.out.println("查询了数据库.....");

/**

* 1.将数据库的多次查询变为一次,之前是嵌套查询,导致和数据库做很多次交互

* 后续查询操作从这次查询结果中取结果

*/

List<CategoryEntity> selectList = baseMapper.selectList(null);//不传任何条件,就代表查询所有。

//1.查出所有1级分类

List<CategoryEntity> level1Categorys = getParent_cid(selectList,0L);//1级分类的 父id 是 0

//2.封装数据

Map<String, List<Catelog2Vo>> parent_cid = level1Categorys.stream().collect(Collectors.toMap(k -> k.getCatId().toString(), v -> {

//1.每一个的一级分类,查到这个一级分类的二级分类

List<CategoryEntity> categoryEntities = getParent_cid(selectList,v.getCatId());//将正在遍历的元素v的catId作为 parent_cid的值,就可以找出它的子分类

//2.封装上面的结果

List<Catelog2Vo> catelog2Vos = null;

if (categoryEntities != null) {

catelog2Vos = categoryEntities.stream().map(l2 -> {

Catelog2Vo catelog2Vo = new Catelog2Vo(v.getCatId().toString(), null, l2.getCatId().toString(), l2.getName());

//1.找到当前二级分类的三级分类,封装成 vo

List<CategoryEntity> level3Catelog = getParent_cid(selectList,l2.getCatId());

// 三级分类有数据的情况下

if (level3Catelog != null){

List<Catelog2Vo.Catelog3Vo> collect = level3Catelog.stream().map(l3 -> {

//2.封装成指定格式

Catelog2Vo.Catelog3Vo catelog3Vo = new Catelog2Vo.Catelog3Vo(l2.getCatId().toString(), l3.getCatId().toString(), l3.getName());

return catelog3Vo;

}).collect(Collectors.toList());

catelog2Vo.setCatalog3List(collect);

}

return catelog2Vo;

}).collect(Collectors.toList());

}

return catelog2Vos;

}));

//3.查到的数据再放入缓存中,将对象转为JSON放在缓存汇总

String s = JSON.toJSONString(parent_cid);

redisTemplate.opsForValue().set("catalogJSON",s,1, TimeUnit.DAYS);//设置过期时间1天

return parent_cid;

}

}

注意这里需要将结果放入缓存中,然后再释放锁,所以需要将放入缓存的代码放入 同步代码块中。

测试:50个线程

只查询了一次数据库。

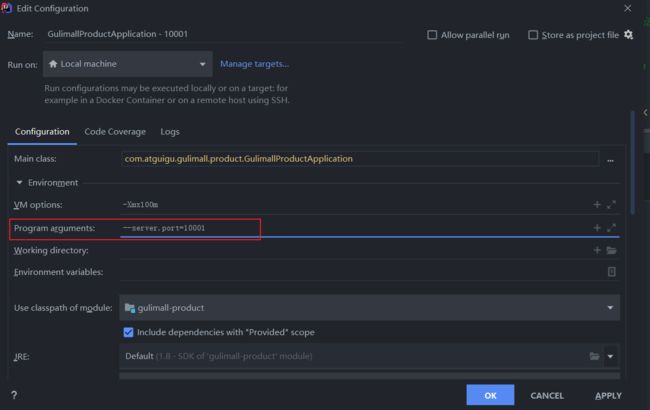

②接下来我们测试 本地锁在 分布式情况下的结果:

设置多个商品服务

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-dZAuP9Uo-1672324453428)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233808068-1727462261.png)]

端口设置:–server.port=10001…

设置 共4个商品服务。

测试:100个并发循环5次。

利用 Nginx 转发给网关,网关负载均衡到每个服务。

结果就是 :4个商品服务,每一个都查询了1次数据库,因为一共有4个进程的原因,本地锁只能锁住当前进程。

4.2.3 分布式锁实现

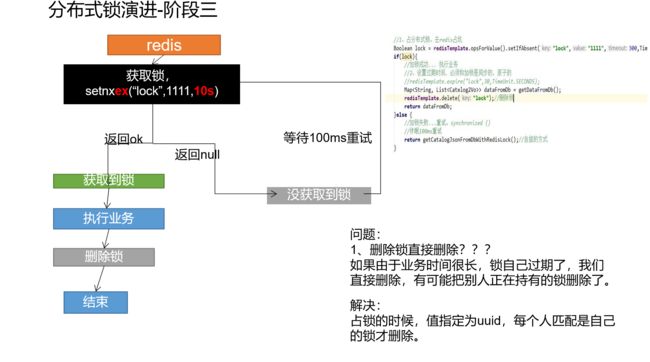

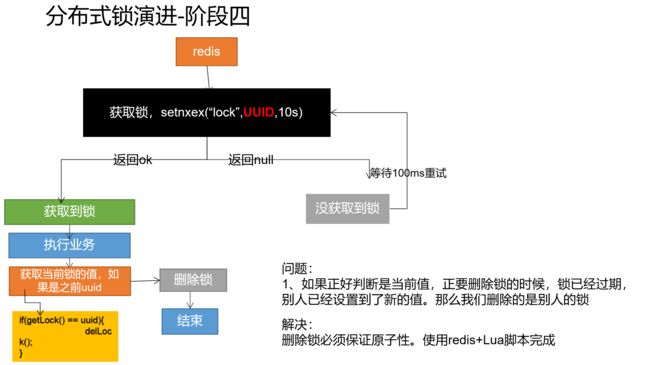

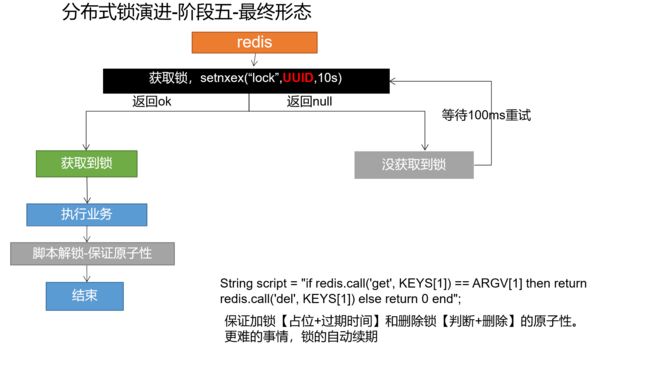

阶段一>阶段 三 :就是为了将加锁做成原子性的。

阶段四—>阶段五:将解锁做成原子性的。

核心:加锁和删锁都要保证原子性。结果就是:原子加锁;原子解锁。

补充:

redis官网对 set命令的解释:

SET key value [EX seconds] [PX milliseconds] [NX|XX]

起始版本:1.0.0

**时间复杂度:**O(1)

Set key to hold the string value. If key already holds a value, it is overwritten, regardless of its type. Any previous time to live associated with the key is discarded on successful SET operation.

将键key设定为指定的“字符串”值。

如果 key 已经保存了一个值,那么这个操作会直接覆盖原来的值,并且忽略原始类型。

当set命令执行成功之后,之前设置的过期时间都将失效

选项

从2.6.12版本开始,redis为SET命令增加了一系列选项:

EXseconds – Set the specified expire time, in seconds.PXmilliseconds – Set the specified expire time, in milliseconds.NX– Only set the key if it does not already exist.XX– Only set the key if it already exist.EXseconds – 设置键key的过期时间,单位时秒PXmilliseconds – 设置键key的过期时间,单位时毫秒NX– 只有键key不存在的时候才会设置key的值XX– 只有键key存在的时候才会设置key的值

注意: 由于SET命令加上选项已经可以完全取代SETNX, SETEX, PSETEX的功能,所以在将来的版本中,redis可能会不推荐使用并且最终抛弃这几个命令。

返回值

simple-string-reply:如果SET命令正常执行那么回返回OK,否则如果加了NX 或者 XX选项,但是没有设置条件。那么会返回nil。

例子

redis> SET mykey "Hello"

OK

redis> GET mykey

"Hello"

redis>

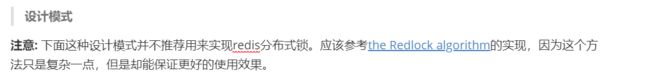

设计模式

注意: 下面这种设计模式并不推荐用来实现redis分布式锁。应该参考the Redlock algorithm的实现,因为这个方法只是复杂一点,但是却能保证更好的使用效果。

命令 SET resource-name anystring NX EX max-lock-time 是一种用 Redis 来实现锁机制的简单方法。

如果上述命令返回OK,那么客户端就可以获得锁(如果上述命令返回Nil,那么客户端可以在一段时间之后重新尝试),并且可以通过DEL命令来释放锁。

客户端加锁之后,如果没有主动释放,会在过期时间之后自动释放。

可以通过如下优化使得上面的锁系统变得更加鲁棒:

- 不要设置固定的字符串,而是设置为随机的大字符串,可以称为token。

- 通过脚步删除指定锁的key,而不是DEL命令。

上述优化方法会避免下述场景:a客户端获得的锁(键key)已经由于过期时间到了被redis服务器删除,但是这个时候a客户端还去执行DEL命令。而b客户端已经在a设置的过期时间之后重新获取了这个同样key的锁,那么a执行DEL就会释放了b客户端加好的锁。

解锁脚本的一个例子将类似于以下:

if redis.call("get",KEYS[1]) == ARGV[1]

then

return redis.call("del",KEYS[1])

else

return 0

end

这个脚本执行方式如下:

EVAL …script… 1 resource-name token-value

redis 中文文档

最终代码结果:

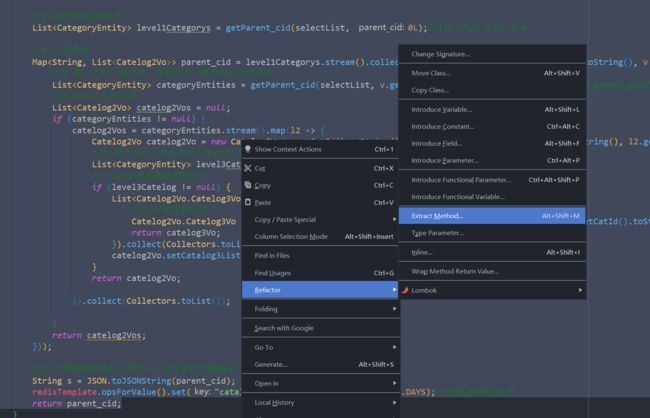

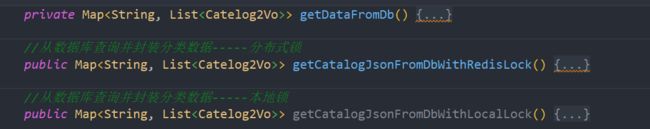

注意:为了后续简单起见,将部分代码抽取成一个方法 getDataFromDb。

private Map<String, List<Catelog2Vo>> getDataFromDb() {

String catalogJSON = redisTemplate.opsForValue().get("catalogJSON");

if (!StringUtils.isEmpty(catalogJSON)) {

//缓存不为 null ;直接返回

Map<String, List<Catelog2Vo>> result = JSON.parseObject(catalogJSON, new TypeReference<Map<String, List<Catelog2Vo>>>() {

});

return result;

}

System.out.println("查询了数据库.....");

/**

* 1.将数据库的多次查询变为一次,之前是嵌套查询,导致和数据库做很多次交互

* 后续查询操作从这次查询结果中取结果

*/

List<CategoryEntity> selectList = baseMapper.selectList(null);//不传任何条件,就代表查询所有。

//1.查出所有1级分类

List<CategoryEntity> level1Categorys = getParent_cid(selectList, 0L);//1级分类的 父id 是 0

//2.封装数据

Map<String, List<Catelog2Vo>> parent_cid = level1Categorys.stream().collect(Collectors.toMap(k -> k.getCatId().toString(), v -> {

//1.每一个的一级分类,查到这个一级分类的二级分类

List<CategoryEntity> categoryEntities = getParent_cid(selectList, v.getCatId());//将正在遍历的元素v的catId作为 parent_cid的值,就可以找出它的子分类

//2.封装上面的结果

List<Catelog2Vo> catelog2Vos = null;

if (categoryEntities != null) {

catelog2Vos = categoryEntities.stream().map(l2 -> {

Catelog2Vo catelog2Vo = new Catelog2Vo(v.getCatId().toString(), null, l2.getCatId().toString(), l2.getName());

//1.找到当前二级分类的三级分类,封装成 vo

List<CategoryEntity> level3Catelog = getParent_cid(selectList, l2.getCatId());

// 三级分类有数据的情况下

if (level3Catelog != null) {

List<Catelog2Vo.Catelog3Vo> collect = level3Catelog.stream().map(l3 -> {

//2.封装成指定格式

Catelog2Vo.Catelog3Vo catelog3Vo = new Catelog2Vo.Catelog3Vo(l2.getCatId().toString(), l3.getCatId().toString(), l3.getName());

return catelog3Vo;

}).collect(Collectors.toList());

catelog2Vo.setCatalog3List(collect);

}

return catelog2Vo;

}).collect(Collectors.toList());

}

return catelog2Vos;

}));

//3.查到的数据再放入缓存中,将对象转为JSON放在缓存汇总

String s = JSON.toJSONString(parent_cid);

redisTemplate.opsForValue().set("catalogJSON", s, 1, TimeUnit.DAYS);//设置过期时间1天

return parent_cid;

}

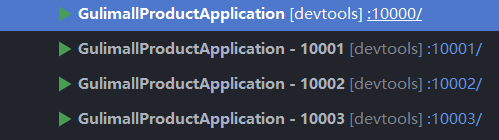

加了分布式锁的查询三级分类代码:

//从数据库查询并封装分类数据-----分布式锁

public Map<String, List<Catelog2Vo>> getCatalogJsonFromDbWithRedisLock() {

//1.占分布式锁。去redis占坑

String uuid = UUID.randomUUID().toString();

Boolean lock = redisTemplate.opsForValue().setIfAbsent("lock", uuid,300,TimeUnit.SECONDS);

if (lock){

System.out.println("获取分布式锁成功....");

//加锁成功...执行业务

//2.设置过期世家你,必须和加锁是同步的,原子的

// redisTemplate.expire("lock",300,TimeUnit.SECONDS);

Map<String, List<Catelog2Vo>> dataFromDb ;

try{

dataFromDb = getDataFromDb();

}finally {

//删除锁:原子性

String script = "if redis.call('get', KEYS[1]) == ARGV[1] then return redis.call('del', KEYS[1]) else return 0 end";

Long lock1 = redisTemplate.execute(new DefaultRedisScript<Long>(script, Long.class), Arrays.asList("lock"), uuid);

}

//获取值对比+对比成功删除=原子操作 lua脚本解锁

// String lockValue = redisTemplate.opsForValue().get("lock");

// if (uuid.equals(lockValue)){

// //删除我自己的锁

// redisTemplate.delete("lock");//删除锁,解除坑位

// }

return dataFromDb;

}else{

System.out.println("获取分布式锁失败....等待重试");

//加锁失败...重试。synchronized():会一直监听,只要别人一释放锁,就会拿到:自旋的方式。

//休眠100ms重试

try {

Thread.sleep(200);

}catch (Exception e){

}

return getCatalogJsonFromDbWithRedisLock();//自旋的方式

}

}

注意:之前测试 本地锁的那个方法改名:getCatalogJsonFromDbWithLocalLock

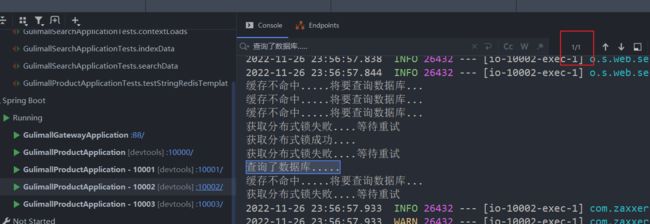

压力测试:100个线程循环5次。

最终的结果:4个分布式项目中只有一个查询了数据库。

之前我们自己编写的简单分布式锁并不是太好,而且之前new的对象,都是在本地进程中的,

使用redisson,创建的对象都是分布式对象,公共的。接下来我们使用 Redisson来设置分布式锁。

4.2.4 整合Redisson作为分布式锁等功能框架

1、简介

Redisson 是架设在Redis 基础上的一个Java 驻内存数据网格(In-Memory Data Grid)。充分的利用了Redis 键值数据库提供的一系列优势,基于Java 实用工具包中常用接口,为使用者提供了一系列具有分布式特性的常用工具类。使得原本作为协调单机多线程并发程序的工具包获得了协调分布式多机多线程并发系统的能力,大大降低了设计和研发大规模分布式系统的难度。同时结合各富特色的分布式服务,更进一步简化了分布式环境中程序相互之间的协作。

redisson使用文档 : https://github.com/redisson/redisson/wiki/

2、引入依赖

<dependency>

<groupId>org.redissongroupId>

<artifactId>redissonartifactId>

<version>3.12.0version>

dependency>

3、编写配置

@Configuration

public class MyRedissonConfig {

/**

* 所有对 Redisson的使用都是通过RedissonClient对象

* @return

* @throws IOException

*/

@Bean(destroyMethod = "shutdown")

public RedissonClient redisson() throws IOException {

//1、创建配置

Config config = new Config();

// Redis url should start with redis:// or rediss:// (for SSL connection)

config.useSingleServer().setAddress("redis://192.168.56.10:6379");

//2、根据Config 创建出 RedissonClient实例

RedissonClient redissonClient = Redisson.create(config);

return redissonClient;

}

}

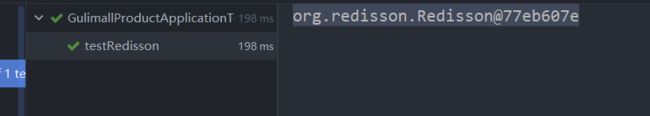

4、测试

@Autowired

RedissonClient redissonClient;

@Test

public void testRedisson() {

System.out.println(redissonClient);

}

5、结果

6、分布式锁之可重入锁

中文官方地址:https://github.com/redisson/redisson/wiki/8.-%E5%88%86%E5%B8%83%E5%BC%8F%E9%94%81%E5%92%8C%E5%90%8C%E6%AD%A5%E5%99%A8

测试:在indexController类下测试

@Autowired

RedissonClient redisson;

@ResponseBody

@GetMapping("/hello")

public String hello(){

//1.获取一把锁,只要锁的名字一样,就是同一把锁,

RLock lock = redisson.getLock("my-lock");

//2.加锁

lock.lock();//阻塞式等待。默认加的锁都是30s时间。

//1)、所得自动续期,如果业务超长,运行期间自动给锁续上新的30s。不用担心业务时间长,锁自动过期被删掉

//2)、加锁的业务只要运行完成,就不会给当前锁续期,即使不手动解锁,锁默认在30s以后自动删除。

try {

System.out.println("加锁成功,执行业务..." + Thread.currentThread().getId());

Thread.sleep(30000);

}catch (Exception e){

}finally {

//3.解锁 假设解锁代码没有运行,Redisson也不会出现死锁

System.out.println("释放锁..." + Thread.currentThread().getId());

lock.unlock();

}

return "hello";

}

}

特点:①看门狗机制,在业务运行期间,自动帮我们的锁续期;

②为了防止死锁,加的锁也是30秒,即使由于业务宕机,没有手动调用解锁,Redisson也会在30秒结束后进行自动解锁。

加锁的方式有两种:

①不指定过期时间

// 最常见的使用方法

lock.lock();

②指定过期时间

// 加锁以后10秒钟自动解锁

// 无需调用unlock方法手动解锁

lock.lock(10, TimeUnit.SECONDS);

源码解析结果分析:

//2.加锁

lock.lock();//阻塞式等待。默认加的锁都是30s时间。

//1)、所得自动续期,如果业务超长,运行期间自动给锁续上新的30s。不用担心业务时间长,锁自动过期被删掉

//2)、加锁的业务只要运行完成,就不会给当前锁续期,即使不手动解锁,锁默认在30s以后自动删除。

lock.lock(10, TimeUnit.SECONDS);//10秒自动解锁,自动解锁时间一定要大于业务的执行时间。

//问题:lock.lock(10, TimeUnit.SECONDS);在所时间到了以后,不会自动续期。

//1、如果我们传递了锁的超时时间,就发送给redis执行脚本,进行占锁,默认超时时间就是我们指定的时间

//2、如果我们未指定锁的超时时间,就使用 30 * 1000【LockWatchdogTimeout看门狗的默认时间】;

// 只要占锁成功,就会启动一个定时任务【重新给锁设置过期时间,新的过期时间就是看门狗的默认时间】,每隔10s都会自动再次续期,续成30s

// internalLockLeaseTime【看门狗时间】 /3,10s

//最佳实战:以后我们还是推荐使用这种方式

//1)、lock.lock(30, TimeUnit.SECONDS);省掉了整个续期操作。手动解锁

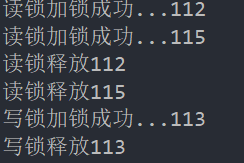

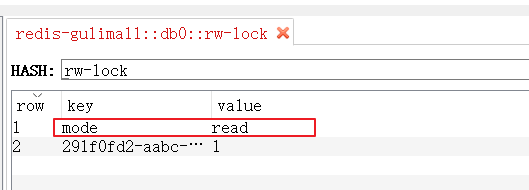

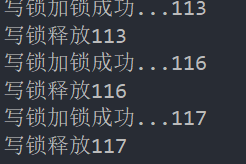

7、分布式锁之读写锁

测试:

indexController中新建 一个读方法,一个写方法。

//测试读写锁

//保证一定能读到最新数据,修改期间,写锁是一个排它锁(互斥锁、独享锁)。读锁是一个共享锁

//写锁没释放读就必须等待

// 读 + 读:相当于无锁,并发读,只会在redis中记录好,所有当前的读锁。他们都会同时加锁成功

// 写 + 读:等待写锁释放

// 写 + 写:阻塞方式

// 读 + 写:有读锁,写也需要等待。

//只要有写的存在,都必须等待。

@ResponseBody

@GetMapping("/write")

public String writeValue() {

RReadWriteLock lock = redisson.getReadWriteLock("rw-lock");

String s = "";

RLock rLock = lock.writeLock();

try {

//1、改数据加写锁,读数据加读锁

rLock.lock();

System.out.println("写锁加锁成功..."+Thread.currentThread().getId());

s = UUID.randomUUID().toString();

Thread.sleep(30000);

redisTemplate.opsForValue().set("writeValue", s);//保存到redis中

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

rLock.unlock();//解锁

System.out.println("写锁释放" + Thread.currentThread().getId());

}

return s;

}

@ResponseBody

@GetMapping("/read")

public String readValue() {

RReadWriteLock lock = redisson.getReadWriteLock("rw-lock");

String s = "";

//加读锁

RLock rLock = lock.readLock();

rLock.lock();

try {

System.out.println("读锁加锁成功..."+Thread.currentThread().getId());

s = redisTemplate.opsForValue().get("writeValue");

Thread.sleep(30000);

} catch (Exception e) {

e.printStackTrace();

} finally {

rLock.unlock();//解锁

System.out.println("读锁释放" + Thread.currentThread().getId());

}

return s;

}

url:http://localhost:10000/write ;http://localhost:10000/read

读 + 写:

当前在什么状态下,redis中也有记录:目前在写状态下。

写 + 读 :

读 + 读 :

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-cYTqFcZf-1672324453433)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233751742-2003709766.png)]

写 + 写:

总结:只要有写的存在,都需要等待。

8、信号量

测试代码:

/**

* 车库停车,

* 3车位

* 信号量也可以用作分布式限流

*

*/

@GetMapping("/park")

@ResponseBody

public String park() throws InterruptedException {

RSemaphore park = redisson.getSemaphore("park");

// park.acquire();//获取一个信号,获取一个值,占一个车位 -> 都是阻塞式方法

boolean b = park.tryAcquire();//获取到了就占车位,获取不到就走 -> 不像 acquire 获取不到就一直阻塞,直到有。

if (b){

//执行业务

}else {

return "error";

}

return "ok=>" + b;

}

@GetMapping("/go")

@ResponseBody

public String go() throws InterruptedException {

RSemaphore park = redisson.getSemaphore("park");

park.release();//获取一个信号,获取一个值,释放一个车位 -> 都是阻塞式方法

return "ok";

}

为了方便测试,我们直接在redis中添加 park,值为3。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-n65DqeCz-1672324453433)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233750418-1788858279.png)]

信号量可以用作分布式限流操作。

9、闭锁

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-SVhjQ0br-1672324453434)(https://img2023.cnblogs.com/blog/3019773/202212/3019773-20221228233749947-579025378.png)]

测试:

/**

* 闭锁测试

*

* 放假,锁门

* 1班没人了,2班没人了...

* 5个班全部走完,我们可以锁大门

*/

@GetMapping("/lockDoor")

@ResponseBody

public String lockDoor() throws InterruptedException {

RCountDownLatch door = redisson.getCountDownLatch("door");

door.trySetCount(5);

door.await();//等待闭锁都完成

return "放假了...";

}

@GetMapping("/gogogo/{id}")

@ResponseBody

public String gogogo(@PathVariable("id") Long id) throws InterruptedException {

RCountDownLatch door = redisson.getCountDownLatch("door");

door.countDown();//计数减一

return id + "班走完了";

}