【论文学习】《MOSNet: Deep Learning-based Objective Assessment for Voice Conversion》

《MOSNet: Deep Learning-based Objective Assessment for Voice Conversion》论文学习

文章目录

- 《MOSNet: Deep Learning-based Objective Assessment for Voice Conversion》论文学习

-

- 摘要

- 1 介绍

- 2 语音转换挑战评估数据

-

- 2.1 2018 年语音转换挑战

- 2.2 数据及其分布和可预测性

- 3 MOSNet

-

- 3.1 模型细节

- 3.2 目标函数

- 4 实验

-

- 4.1 不同模型架构比较

-

- 4.1.1 在话语层面评估结果

- 4.1.2 在系统级评估结果

- 4.2 帧级 MSE 的影响

- 4.3 相似预测实验

- 5 结论

摘要

现有的语音转换客观评价指标并不总是与人的感知相关。因此,用这种准则训练VC模型并不能有效地提高转换后语音的自然度和相似度。在本文中,我们提出了基于深度学习的评估模型来预测人类对转换语音的评价。我们采用卷积神经网络模型和递归神经网络模型建立一个平均意见评分(MOS)预测器,称为MOSNet。在2018年Voice Conversion Challenge (VCC)的大型听力测试结果上对提出的模型进行了测试。实验结果表明,所提出的MOSNet预测得分与人类MOS评分在系统水平上高度相关,而与人类MOS评分在话语水平上相当相关。同时,我们对MOSNet进行了修改,对相似度评分进行了预测,初步结果表明预测的评分与人的评分也有一定的相关性。这些结果表明,所提出的模型可以作为VC系统MOS测量的计算评估器,以减少昂贵的人工评分的需要。

关键词:语音自然评估,客观音质评价,MOS,语音转换,非侵入性

1 介绍

生成语音的质量量化一直是语音合成、语音增强和语音转换(VC)系统中一个长期存在的问题。这些系统的评价报告了客观和主观的测量。在VC界,梅尔-倒谱距离(Mel-cepstral distance, MCD)(《Mel-cepstral distance measure for objective speech quality assessment》)等客观测量方法被广泛用于自动测量转换语音的质量。然而,这些指标并不总是与人类感知相关,因为它们主要测量声学特征的失真。主观评价如平均意见评分(MOS)和相似度评分可以代表VC系统的内在自然度和相似度,但这类评价需要大量的参与者进行听力测试和提供感知评级,耗时和成本高。

为了克服上述问题,人们提出了许多评估算法和模型。例如,在语音增强领域,ITU-T发布的语音质量感知评价(PESQ)(《Per-ceptual evaluation of speech quality (PESQ)-a new method for speech quality assessment of telephone networks and codecs》)是衡量增强语音质量的侵入性评估,因为评估需要黄金参考。有几个非侵入性评估指标(《An evaluation of synthetic speech using the PESQ measure》,《Prediction of perceived sound quality of synthetic speech》,《Objective evaluation measures for speaker-adaptive HMM-TTS systems》,《A hierarchical predictor of synthetic speech naturalness using neural networks》,《Quality-Net: An end-to-end non-intrusive speech quality assessment model based on BLSTM》,《AutoMOS: Learning a non-intrusive assessor of naturalness-of-speech》,《Non-intrusive speech quality assessment using neural networks》,《Single-ended speech quality measurement using machine learning methods》)用于评估增强语音和合成语音的质量。

例如,Fu等人(《Quality-Net: An end-to-end non-intrusive speech quality assessment model based on BLSTM》)提出了Quality-Net作为基于双向长短期记忆(BLSTM)的质量评估模型,以框架方式预测增强语音的话语水平质量。预测分数与PESQ分数之间的高度相关性证实了其作为非侵入性语音增强评估模型的有效性。Yoshimura等人(《A hierarchical predictor of synthetic speech naturalness using neural networks》)提出了一种基于全连接神经网络和卷积神经网络(CNN)的合成语音自然度预测器,用于预测话语级和系统级MOS。该模型是在手工制作的特征和大规模听力测试评分训练。值得注意的是,《A hierarchical predictor of synthetic speech naturalness using neural networks》和《AutoMOS: Learning a non-intrusive assessor of naturalness-of-speech》都报告了在话语水平的人类评价中存在很大的差异,因为听力测试是主观的,听者可能对同一话语提供不同的评价。因此,评估模型很难得到与人类话语水平评分高度相关的结果。然而,系统级的预测将是相对可靠的。以前的工作已经表明了神经网络在模拟人类感知增强合成语音方面的能力。然而,目前还没有针对VC系统的评估模型。我们的目标是使用语音转换挑战(VCC2018) (《The voice conversion challenge 2018: Promoting development of parallel and nonparallel methods》)的大规模听力测试结果,为VC系统开发一个语音自然度和相似度评估模型。

本文提出了一种基于深度学习的端到端语音自然度评估模型,称为MOSNet。为了开发这样的客观度量来建模并与人类的主观评分保持一致,我们研究了卷积神经网络(CNN)、双向长短期记忆(BLSTM)和CNN-BLSTM,因为这些架构已经显示出它们对人类感知建模的能力。我们使用这种架构来提取有价值的特征,然后使用完全连接(FC)层来预测相应的自然度评分。借助VCC 2018的神经网络能力和大规模的人类自然度评价,我们的自然度评价模型的MOS预测在系统级与人类MOS评分之间实现了高相关,在话语级实现了公平相关。此外,我们对MOSNet进行了改进,以预测相似度得分,初步结果表明预测的相似度得分与人类相似度评分具有较好的相关性。实验结果表明,该模型能够较好地度量VC系统的语音自然度和相似度。据我们所知,这是第一个基于深度学习的VC语音质量和相似度评估模型。

论文组织如下:VCC 2018的数据及其分布在第2节。所提出的模型在第3节中给出。实验和结果将在第4节中讨论。最后,本文的结论和未来的工作将在第5部分进行。

2 语音转换挑战评估数据

2.1 2018 年语音转换挑战

2018年Voice Conversion Challenge (VCC)是VCC的第二版,是一项大规模的语音转换挑战。VCC 2018语料库是通过从设备和生产语音(DAPS)数据集(《Can we automatically transform speech recorded on common consumer devices in real-world environments into professional production quality speech? a dataset, insights, and challenges》)中选择部分发言者编写的,这些发言者是由专业的美国英语发言者在清洁和无噪音的环境中录制的。该挑战的参与者需要使用他们的VC系统,通过并行或非并行训练数据训练,将语音信号从源说话人转换为目标说话人。所有参与挑战的并行和非并行VC系统都通过众包听力测试评估了自然度和相似度得分。

VCC 2018的评价如下:共有2572个评价集,每一评价集包含44个话语。总共113168项人类评估完全涵盖了28292份提交的音频样本。每个音频样本由4位听众进行打分。113168项评价分为82304项自然性评价和30864项说话人相似度评价。82304项自然性评价涵盖20580项提交的MOS值范围为1 - 5,最低1分,最高5分。在(《The voice conversion challenge 2018: Promoting development of parallel and nonparallel methods》)中可以找到语料库、听者和评价方法的详细说明。我们将每句话语的四个MOS评分的平均值作为其真实数据评分。

2.2 数据及其分布和可预测性

每个话语的四种MOS评分的均值和标准差直方图如图1所示。可以看出,平均MOS值的分布更接近高斯分布,平均MOS值集中在3.0左右。然而,在提交的话语中,大约有一半的MOS评分的标准差大于1,这表明分数的变异程度更高。这是预期的,因为在进行听力测试时,对同一话语的知觉评级取决于听者的个人经历和偏好。因此,我们确定了考虑数据的内在可预测性和侦听器之间的内在相关性是很重要的。在本研究中,我们使用bootstrap方法(《A hierarchical predictor of synthetic speech naturalness using neural networks》,《An Introduction to the Bootstrap》,《Bootstrap estimates for confidence intervals in ASR performance evaluation》)来验证VCC 2018中人类评估的内在可预测性。

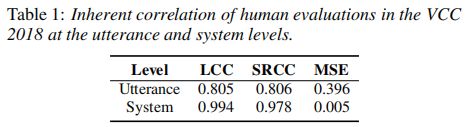

我们进行了1000次重复,以估计每个子集与整个数据集之间的MOS相关性。注意,自然语音的MOS评估被排除在外。对于每个复本,我们从总共267个侦听器中随机抽样134个侦听器,以测量它们的平均MOS为MOSsub。然后,通过线性相关系数(LCC)(《Notes on The History of Correlation》)、Spearman等级相关系数(SRCC(《The proof and measurement of association between two things》)和均方误差(MSE)将MOSsub与MOSall(使用整个MOS评级集计算)进行比较。LCC、SRCC和MSE的平均值见表1。

由此可见,LCC和SRCC在系统层面上较高,而在话语层面上较低。MSE也有类似的趋势。结果表明,虽然不同听者的主观知觉评价在话语水平上存在差异,但在系统水平上具有良好的一致性。分析表明,虽然系统级的MOS是可预测的,但是,话语级的MOS只能在一定程度上被预测,虽然不如系统级的预测好。

3 MOSNet

本文提出了一种基于深度学习的客观评估方法,以MOS为基础对人类感知进行建模,简称MOSNet。以原始幅度谱图作为输入特征,利用CNN、BLSTM和CNN-BLSTM三种基于神经网络的模型,从全连接层和池化机制的输入特征中提取有价值的特征,生成预测MOS。在下面的部分中,我们将详细介绍MOSNet的每个组件。

3.1 模型细节

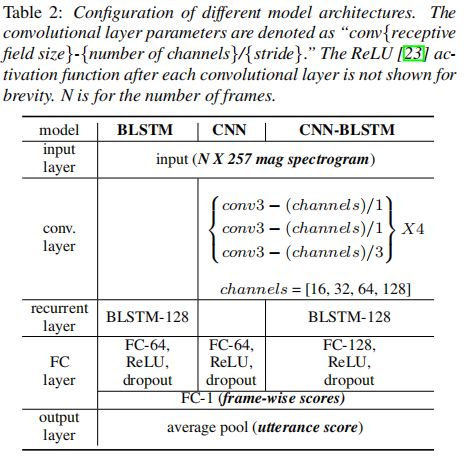

不同MOSNet架构的详细配置如表2所示,包括CNN、BLSTM和CNN-BLSTM。BLSTM架构与Quality-Net(《Quality-Net: An end-to-end non-intrusive speech quality assessment model based on BLSTM》)中使用的架构相同。BLSTM通过时间的前向和后向处理,能够将长期的时间依赖性和序列特征集成为代表性特征。CNN已被广泛应用于时间序列数据建模,并取得了令人满意的效果。CNN通过叠加更多的卷积层来扩展它的接受域。本研究使用的CNN架构有12个卷积层,最后一个卷积层中每个神经元的接受域为25帧(时间尺度约为400ms)。

我们认为,通过考虑25帧的分段,MOSNet可以捕获更多的时间信息来预测质量分数。最近的研究证实了将CNN和RNN (BLSTM)结合用于增强(《Convolutionalrecurrent neural networks for speech enhancement》,《A convolutional recurrent neural network for real-time speech enhancement》)、分类(《Convolutional, long short-term memory, fully connected deep neural networks》,《Temporal attentive pooling for acoustic event detection》)和识别(《Learning the speech front-end with raw waveform CLDNNs》,《Gated convolutional LSTM for speech commands recognition》)任务的有效性。因此,我们还研究了用于MOSNet特征提取的CNN + BLSTM体系结构,在表2和后续讨论中称为CNN-BLSTM。利用提取的特征,我们使用两个FC层将帧特征回归到帧级别标量,以表示每帧的自然度评分。最后,对框架级评分进行全局平均运算,得到话语级自然度评分。

3.2 目标函数

如前一节所述,我们将MOS预测描述为一个回归任务。MOSNet的输入是从语音中提取的光谱特征序列。利用VCC 2018的MOS评价作为ground-truth对模型进行训练。Fu等人(《Quality-Net: An end-to-end non-intrusive speech quality assessment model based on BLSTM》)指出,通过在客观函数中使用框架级预测误差,话语级预测将与人的评价更相关。因此,我们制定了培训MOSNet的目标函数为:

O = 1 S ∑ s = 1 S [ ( Q ^ s − Q s ) 2 + α T s ∑ t = 1 T s ( Q ^ s − q s , t ) 2 ] (1) O = \frac {1}{S} \sum_{s=1}^S[(\hat{Q}_s - Q_s)^2 + \frac {\alpha}{T_s} \sum_{t=1}^{T_s}(\hat{Q}_s - q_{s,t})^2] \tag{1} O=S1s=1∑S[(Q^s−Qs)2+Tsαt=1∑Ts(Q^s−qs,t)2](1) 其中 Q ^ s \hat{Q}_s Q^s和 Q s Q_s Qs分别表示第 s s s个话语的ground-truth MOS和predicted MOS, α \alpha α为权重因子, q s , t q_{s,t} qs,t为 t t t时刻的帧级预测, T s T_s Ts为第 s s s个话语的总帧数, s s s为训练话语数。值得注意的是,公式1中的目标函数结合了话语级MSE和帧级MSE。在《Quality-Net: An end-to-end non-intrusive speech quality assessment model based on BLSTM》中,加权因子( α \alpha α)被用于减轻语音增强任务中严重的帧间MSE变化。我们的初步实验表明,转换后的语音质量比增强后的语音质量更稳定。具体来说,由高MOS VC系统产生的转换语音通常会产生高帧间MOSs,反之亦然。因此,我们在本研究中将权重因子 α \alpha α设为 1 1 1。为了计算帧级的MSE,对语音中的所有帧都使用ground-truth MOS。从实验中可以看出,帧级MSE帮助MOSNet收敛并具有更好的预测精度,这将在下一节中讨论。

4 实验

在本节中,将评估不同的模型体系结构,并讨论在话语和系统级别上的结果。我们首先解释我们的实现细节。整个20580个语音样本(连同相应的MOSs)被分为13580、3000和4000个样本,分别用于训练、验证和测试。所有的语音样本都缩小到16千赫。在特征提取方面,我们每隔256个样本点(即16ms帧移)进行512个样本点(即32ms帧长)的短时傅里叶变换(short-time Fourier transform, STFT),得到每个话语的257维基于帧的光谱特征序列。对于MOSNet,Dropout设置为0.3。该模型由Adam优化器训练,学习率为0.0001,没有批量归一化。我们基于5个epoch验证集的MSE应用了早期停止。

4.1 不同模型架构比较

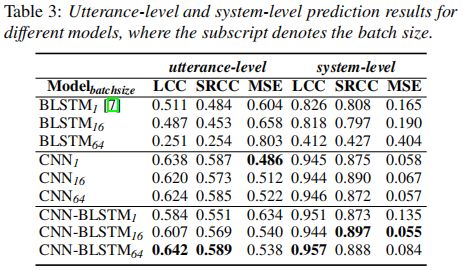

首先,我们打算比较不同模型的预测性能。表3给出了不同批大小的这些模型在话语和系统层面的LCC、SRCC和MSE值。《Quality-Net: An end-to-end non-intrusive speech quality assessment model based on BLSTM》中使用的BLSTM1模型被认为是基线系统。从表3可以看出,BLSTM1的LCC为0.511,随着批大小的增加,BLSTM1的性能急剧下降,因为零填充可能会影响预测性能。其次,当批量大小增加并将LCC从0.511提高到0.638时,基于CNN的模型产生了更稳定的结果。在所有模型中,CNN- BLSTM64的LCC最高,为0.642,说明结合CNN(用于特征提取)和BLSTM(考虑时间依赖性)可以有效地从谱图中提取特征进行MOS预测。CNN-BLSTM64在系统层面的LCC也达到了最高的0.957,非常接近于表1中人类评价的LCC:0.994。

4.1.1 在话语层面评估结果

图2显示了CNN-BLSTM64的语句级别预测的散点图和直方图。从图2(a)可以看出,虽然低 MOS中训练样本较多,但模型避免了低预测,预测主要分布在2 ~ 3分左右。图2(b)显示MOSNet很少预测MOS在3.5 - 4之间,而大部分预测MOS在1.5 - 3.5之间。由于提交系统的平均MOS主要在2 - 3.5之间,因此模型避免预测如此低和高的分数是合理的。这是一个常见的限制,当使用基于MSE的目标函数的数据是在一个高斯分布。可以利用其他目标函数对其进行改进,这是一个值得进一步研究的领域。

4.1.2 在系统级评估结果

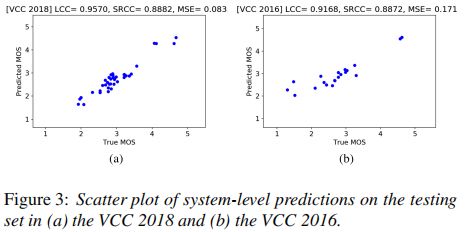

图3(a) 显示了CNN-BLSTM64对VCC 2018系统级预测的散点图。系统级预测与人类评估高度相关。如图3(a)和表3所示的结果证实了所提出的MOSNet替代人类监听器来评估VC系统的有效性。

为了测试MOSNet的泛化性,我们将VCC 2018数据训练的CNN-BLSTM64应用到VCC 2016数据中。系统级预测的散点图如图3(b) 所示。虽然VCC 2016和VCC 2018的音频样本都来自DAPS数据集,但VCC 2016测试选择的说话人与VCC 2018不同。这两个挑战的参与VC系统也不同。由于音频样本的配对对应结果不可访问,我们只能报告系统级的预测结果。图3(b) 显示,MOSNet在系统级预测中实现了足够高效的高相关性0.917,从而确认了其在训练-测试不匹配场景中的泛化能力。

4.2 帧级 MSE 的影响

在这里,我们打算研究公式1中目标函数中使用的帧级MSE的影响。图4和表4显示了有或没有帧级MSE的训练对CNN-BLSTM64模型的影响(表3中的最佳系统)。如图4所示,模型在无帧级MSE训练时,估计的帧级得分变化较大,而在有帧级MSE训练时,估计的帧级得分相对稳定。不稳定的框架预测影响最终的话语水平预测。由表4可知,在框架水平MSE条件下,话语水平预测的LCC为0.6424,而在没有框架水平MSE条件下训练模型时,LCC显著下降至0.5604。

4.3 相似预测实验

转换语音与目标语音测量的相似性是VC系统成功的另一个关键指标。除了预测MOS,我们还尝试扩展MOSNet来预测相似度得分。由于同时有两个输入音频样本,我们应用了一个共享的CNN(与表2所述的架构相同)来提取特征到两个输入样本的潜在向量中。将配对向量组合成一个连接的特征向量,并由两个FC层和一个SoftMax层进行推断,得到最终的预测得分。创建了两个具有不同输出类型的模型:第一个模型有一个标量输出,第二个模型的输出是一个两类向量。

在VCC 2018中,共有30864个相似度评分。每个相似度评分是通过评估一对有4个层次的语音样本得到的。我们将分数1和2合并为标签1(相同的发言者),将分数3和4合并为标签0(不同的发言者)。数据集分为80%和20%进行训练和测试。两种模型的相似性预测结果如表5所示。从表中可以看出,当模型以一个标量输出进行训练时,其准确率为69.6%,明显高于两类模型的66.9%。表5的结果证实了改进的MOSNet可以用来预测与人类评分具有较好相关值的相似度评分。

5 结论

本文提出了一种基于深度学习的VC任务质量评估模型,简称MOSNet。基于VCC 2018的大规模人类感知MOS评价结果,我们的实验结果表明,MOSNet在系统水平上与人类评级具有高相关性,在话语水平上具有公平相关性。我们将VCC 2018数据训练的模型应用到VCC 2016数据中,显示出了良好的MOSNet泛化能力。此外,只需稍加修改,MOSNet就能较好地预测转换后语音相对于目标语音的相似度得分。据我们所知,本文提出的MOSNet是第一个面向VC的端到端语音客观评估模型。未来,我们将考虑人类感知理论,改进MOSNet的模型体系结构和目标函数,以提高与人类评分的相关性。

Lo C C, Fu S W, Huang W C, et al. MOSNet: Deep learning based objective assessment for voice conversion[J]. arXiv preprint arXiv:1904.08352, 2019.