线性分类知识记录

文章目录

-

- 3.1 概述

- 3.2 基础知识

- 3.3 感知机

- 3.4 线性鉴别分析

- 3.5 logistic模型

- 3.6 其他方法:最小距离分类、最小均方误差方法、线性SVM

3.1 概述

在向量空间中根据数据的特征向量和类别标签构造线性分类模型

3.2 基础知识

- n维向量(vector):n个数组成的有序数组,称为一个n维向量, a = ( a 1 , a 2 , . . . , a n ) a=(a_{1},a_{2},...,a_{n}) a=(a1,a2,...,an),其中 a i a_{i} ai称为第i个分量

- 分类问题转化为向量的分类

- 向量空间的定义:所有分量为实数的n维向量构成的集合,称为一个n维向量空间,向量空间又称为线性空间

- 向量空间的几何直观

- 向量的线性相关性(一个向量可以由其他向量构造出来)

- 向量的运算:

- 遵循矩阵运算

- 内积运算:

- a = ( a 1 , a 2 , . . . , a n ) T a=(a_{1},a_{2},...,a_{n})^{T} a=(a1,a2,...,an)T

- b = ( b 1 , b 2 , . . . , b n ) T b=(b_{1},b_{2},...,b_{n})^{T} b=(b1,b2,...,bn)T

- < a , b > = a T b = b T a = ∥ a ∥ ∥ b ∥ c o s φ \left< a,b\right>=a^{T}b=b^{T}a=\left\| a\right\|\left\|b \right\|cos\varphi ⟨a,b⟩=aTb=bTa=∥a∥∥b∥cosφ

- < a , b > / ∥ b ∥ = ∥ a ∥ c o s φ \left< a,b\right>/\left\| b\right\|=\left\| a\right\|cos\varphi ⟨a,b⟩/∥b∥=∥a∥cosφ

- < a , b > / ∥ a ∥ = ∥ b ∥ c o s φ \left< a,b\right>/\left\| a\right\|=\left\| b\right\|cos\varphi ⟨a,b⟩/∥a∥=∥b∥cosφ

- 超平面表达式: g ( x ) = w T x + w 0 = 0 g(x)=w^{T}x+w_{0}=0 g(x)=wTx+w0=0

- 实例(样本): x = ( x 1 , x 2 , . . . , x l ) T x=(x_{1},x_{2},...,x_{l})^{T} x=(x1,x2,...,xl)T

- 权向量(超平面的法向量): w = ( w 1 , w 2 , . . . , w l ) … … T w=(w_{1},w_{2},...,w_{l})……{T} w=(w1,w2,...,wl)……T

- 偏移量: w 0 w_{0} w0

- 线性判别函数: g ( x ) = w T x + w 0 g(x)=w^{T}x+w_{0} g(x)=wTx+w0

- g ( x ) > 0 , x ϵ ω 1 g(x)\gt0, x \epsilon \omega_{1} g(x)>0,xϵω1

- g ( x ) < 0 , x ϵ ω 2 g(x)\lt0, x \epsilon \omega_{2} g(x)<0,xϵω2

- 几何意义:线性函数刻画了样本到超平面的距离

- 向量相似性度量

- Minkovski Metric闵式距离(p-范数)

- D ( x , y ) = [ ∑ i ∣ x i − y i ∣ p ] 1 / p D(x,y)=[\sum_{i}|x_{i}-y_{i}|^{p}]^{1/p} D(x,y)=[∑i∣xi−yi∣p]1/p

- 欧氏距离(p=2)(2-范数)

- D ( x , y ) = [ ( x − y ) T ( x − y ) ] 1 / 2 D(x,y)=[(x-y)^{T}(x-y)]^{1/2} D(x,y)=[(x−y)T(x−y)]1/2

- 城市块(p=1)、曼哈顿距离(1-范数)

- D ( x , y ) = ∑ i ∣ x i − y i ∣ D(x,y)=\sum_{i}|x_{i}-y_{i}| D(x,y)=∑i∣xi−yi∣

- Chobychev距离(p=inf)

- D ( x , y ) = m a x i ∣ x i − y i ∣ D(x,y)=max_{i}|x_{i}-y_{i}| D(x,y)=maxi∣xi−yi∣

- 平方距离/马氏距离

- D ( x , y ) = ( x − y ) T Q ( x − y ) D(x,y)=(x-y)^{T}Q(x-y) D(x,y)=(x−y)TQ(x−y)

- 余弦相似度

- c o s φ = a T b / ∣ a ∣ ∣ b ∣ cos\varphi=a^{T}b/|a||b| cosφ=aTb/∣a∣∣b∣

- Minkovski Metric闵式距离(p-范数)

- 样本的统计量(向量均为列向量)

- 类均值向量

- m i = 1 n i ∑ k = 1 n i x k ( i ) m_{i}=\frac{1}{n_{i}}\sum_{k=1}^{n_{i}}x_{k}^{(i)} mi=ni1∑k=1nixk(i)

- 总均值向量

- n = ∑ i = 1 c P i m i n=\sum_{i=1}^{c}P_{i}m_{i} n=∑i=1cPimi

- m = 1 c ∑ i = 1 c m i m=\frac{1}{c}\sum_{i=1}^{c}m_{i} m=c1∑i=1cmi

- 类内散度矩阵

- S i = 1 n i ∑ k = 1 n i ( x k ( i ) − m i ) ( x k ( i ) − m i ) T S_{i}=\frac{1}{n_{i}}\sum_{k=1}^{n_{i}}(x_{k}^{(i)}-m_{i})(x_{k}^{(i)}-m_{i})^{T} Si=ni1∑k=1ni(xk(i)−mi)(xk(i)−mi)T

- 总类内散度矩阵

- S w = ∑ i = 1 c P i S i = ∑ i = 1 c P i 1 n i ∑ k = 1 n i ( x k ( i ) − m i ) ( x k ( i ) − m i ) T S_{w}=\sum_{i=1}^{c}P_{i}S_{i}=\sum_{i=1}^{c}P_{i}\frac{1}{n_{i}}\sum_{k=1}^{n_{i}}(x_{k}^{(i)}-m_{i})(x_{k}^{(i)}-m_{i})^{T} Sw=∑i=1cPiSi=∑i=1cPini1∑k=1ni(xk(i)−mi)(xk(i)−mi)T

- 类间散度矩阵

- S b = ∑ i = 1 c ( m i − m ) ( m i − m ) T S_{b}=\sum_{i=1}^{c}(m_{i}-m)(m_{i}-m)^{T} Sb=∑i=1c(mi−m)(mi−m)T

- 类均值向量

- 分类问题

- 定义:根据给定训练集 T = { ( x 1 , y 1 ) , . . . , ( x l , y l ) } , x i ϵ C = R n , y i ϵ Y = 1 , 2 , . . . , m , i = 1 , 2 , . . . , l T=\{(x_{1},y_{1}),...,(x_{l},y_{l})\},x_{i}\epsilon C=R^{n}, y_{i}\epsilon Y={1,2,...,m},i=1,2,...,l T={(x1,y1),...,(xl,yl)},xiϵC=Rn,yiϵY=1,2,...,m,i=1,2,...,l,要求寻找C上的决策函数 g ( x ) : C → Y g(x):C\rightarrow Y g(x):C→Y

- 评估方法

- 留出法,数据集分两类,交叉验证

- 交叉验证法,数据集分成k类,其中1类做测试,k-1类做测试;进行k次实验取平均

- 自助法,m次随机取一个样本,共m个样本,放入D‘中;由D’训练,D\D‘测试

- 性能评价

- 错误率与精度

- 查准率、查全率与F1

- ROC与AUC

- 代价敏感错误率与代价曲线

- 比较检验

- 假设检验

- 交叉验证t检验

- McNumber检验

- Friedman检验与Nemenyi检验

- 线性决策的多分类问题:

- 二叉树比对

- k类问题,至少需要预先训练k(k-1)/2个分类器,然后采用二叉树对比测试

- 最大相似性

- y ^ = a r g m a x w c T x \hat{y}=argmaxw_{c}^{T}x y^=argmaxwcTx

- 二叉树比对

3.3 感知机

线性分类:

- 决策函数几何意义:刻画了样本到超平面的距离

- 验证函数 y i ( w i T x i + w 0 ) y_{i}(w_{i}^{T}x_{i}+w_{0}) yi(wiTxi+w0)

- 优化方法:

- 梯度下降(GD) min w J ( w ) = ∑ j J i ( w ) \displaystyle \min_{w}J(w)=\sum_{j}J_{i}(w) wminJ(w)=j∑Ji(w), w = w − η ∂ J ( w ) ∂ w = w − η ▽ J ( w ) = w − η ∑ i ∂ J i ( w ) ∂ w = w − η ∑ i ▽ J i ( w ) w=w-\eta \frac{\partial J(w) }{\partial w}=w-\eta \triangledown J(w)=w-\eta\sum_{i}\frac{\partial J_{i}(w)}{\partial w}=w-\eta\sum_{i}\triangledown J_{i}(w) w=w−η∂w∂J(w)=w−η▽J(w)=w−η∑i∂w∂Ji(w)=w−η∑i▽Ji(w)

- 随机梯度下降(SGD) w = w − η ∂ J i ( w ) ∂ w w=w-\eta \frac{\partial J_{i}(w) }{\partial w} w=w−η∂w∂Ji(w)

感知机结构:

- 输入: x ( n ) = [ + 1 , x 1 ( n ) , x 2 ( n ) , . . . , x m ( n ) ] T x(n)=[+1,x_{1}(n),x_{2}(n),...,x_{m}(n)]^{T} x(n)=[+1,x1(n),x2(n),...,xm(n)]T

- 神经元连接权: w ( n ) = [ b , w 1 ( n ) , w 2 ( n ) , . . . , w m ( n ) ] T w(n)=[b,w_{1}(n),w_{2}(n),...,w_{m}(n)]^{T} w(n)=[b,w1(n),w2(n),...,wm(n)]T

- 神经元局部感受域: v ( n ) = ∑ i = 1 m w i ( n ) x i ( n ) = w T ( n ) x ( n ) v(n)=\sum_{i=1}^{m}w_{i}(n)x_{i}(n)=w^{T}(n)x(n) v(n)=∑i=1mwi(n)xi(n)=wT(n)x(n)

- 硬激活函数:

感知机学习准则:

- 目标:最小化错分样本的误差代价

-

代价函数(错分样本的误差函数)J(w)

- J(w)含义:错分样本到分类超平面误差距离的总和

- 感知机优化:

-

Batch Perception

-

Online Perception

- 误差修正基本规则

- 固定增量的感知机修正

- 固定增量感知器收敛定理:若训练样本线性可分,则感知器训练算法在有限次迭代后可以收敛到正确的解向量w

- 误差修正自适应规则

3.4 线性鉴别分析

简答题:试阐述LDA(线性鉴别分析)的分类思想

答案:给定训练样例集,设法将样例投影到一条直线上,使得同类样例的投影点尽可能接近,异类样例的投影点尽可能远离;在对新样本进行分类时,将其投影到同样的这条直线上,再根据投影点的位置来判断新样本的类别。

基本思想:

- 求线性变换 y = w T x y=w^{T}x y=wTx,使得样本集 { x i } \{x_{i}\} {xi}线性变换成一维变量 { y i } \{y_{i}\} {yi}后,类别间距大,类内间距小

- 假设:如果用各类均值代表类别,类别间最大的方向

- μ 1 = 1 N 1 ∑ x i , μ 2 = 1 N 2 ∑ x i \mu_{1}=\frac{1}{N_{1}}\sum x_{i},\ \ \mu_{2}=\frac{1}{N_{2}}\sum x_{i} μ1=N11∑xi, μ2=N21∑xi

- 问题:只考虑类间,有可能线性不可分

- 目标函数(Fisher Criterion):

- m a x J ( w ) = ( m 1 − m 2 ) 2 S 1 2 + S 2 2 maxJ(w)=\frac{(m_{1}-m_{2})^{2}}{S_{1}^{2}+S_{2}^{2}} maxJ(w)=S12+S22(m1−m2)2

- J = 类别间距 类内平均距离 J=\frac{类别间距}{类内平均距离} J=类内平均距离类别间距

- 样本投影后的类别间距离 ( m 1 − m 2 ) 2 (m_{1}-m_{2})^{2} (m1−m2)2,其中 m i m_{i} mi代表第i类样本投后的均值

- 第k类样本平均值(类心): μ k = 1 ∣ C k ∣ ∑ x i \mu_{k}=\frac{1}{|C_{k}|}\sum x_{i} μk=∣Ck∣1∑xi

- 样本 x i x_{i} xi投影到w方向后,为 y i = w T x i y_{i}=w^{T}x_{i} yi=wTxi

- 投影后的类心:

- m k = 1 ∣ C k ∣ ∑ y i = w T μ k m_{k}=\frac{1}{|C_{k}|}\sum y_{i}=w^{T}\mu_{k} mk=∣Ck∣1∑yi=wTμk

- w方向投影后,类间距: m 1 − m 2 = w T ( μ 1 − μ 2 ) m_{1}-m_{2}=w^{T}(\mu_{1}-\mu_{2}) m1−m2=wT(μ1−μ2)

- ( m 1 − m 2 ) 2 = ( m 1 − m 2 ) ( m 1 − m 2 ) T = w T ( μ 1 − μ 2 ) ( μ 1 − μ 2 ) T w = w T S b w (m_{1}-m_{2})^{2}=(m_{1}-m_{2})(m_{1}-m_{2})^{T}=w^{T}(\mu_{1}-\mu_{2})(\mu_{1}-\mu_{2})^{T}w=w^{T}S_{b}w (m1−m2)2=(m1−m2)(m1−m2)T=wT(μ1−μ2)(μ1−μ2)Tw=wTSbw

- 类间散度矩阵: S b = ( μ 1 − μ 2 ) ( μ 1 − μ 2 ) T S_{b}=(\mu_{1}-\mu_{2})(\mu_{1}-\mu_{2})^{T} Sb=(μ1−μ2)(μ1−μ2)T

- 若考虑先验,可以定义: S b = p ( ω 1 ) p ( ω 2 ) ( μ 1 − μ 2 ) ( μ 1 − μ 2 ) T S_{b}=p(\omega_{1})p(\omega_{2})(\mu_{1}-\mu_{2})(\mu_{1}-\mu_{2})^{T} Sb=p(ω1)p(ω2)(μ1−μ2)(μ1−μ2)T

- 类内距离:投影后各类样本方差 S 1 2 + S 2 2 S_{1}^{2}+S_{2}^{2} S12+S22

- 样本均方差(类别内松散程度):$\sigma {k}^{2} =\sum (x{i}-\mu_{k})^{2}=\sum \tilde{x }_{i}^{2} $

- S k 2 = ∑ ( y i − m k ) 2 = ∑ ( w T ( x i − μ k ) ) 2 = ∑ ( w T x ~ i ) 2 = ∑ ( w T x ~ i ) ( w T x ~ i ) T = ∑ w T x ~ i x ~ i T w = w T ( ∑ x ~ i x ~ i T ) w = w T ( X k X k T ) w S_{k}^{2}=\sum(y_{i}-m_{k})^{2}=\sum(w^{T}(x_{i}-\mu_{k}))^{2}=\sum (w^{T}\tilde{x }_{i})^{2}=\sum(w^{T}\tilde{x}_{i})(w^{T}\tilde{x}_{i})^{T}=\sum w^{T}\tilde{x}_{i}\tilde{x}_{i}^{T}w=w^{T}(\sum\tilde{x}_{i}\tilde{x}_{i}^{T})w=w^{T}(X_{k}X_{k}^{T})w Sk2=∑(yi−mk)2=∑(wT(xi−μk))2=∑(wTx~i)2=∑(wTx~i)(wTx~i)T=∑wTx~ix~iTw=wT(∑x~ix~iT)w=wT(XkXkT)w

- 在投影方向上,类别内距离 S 1 2 + S 2 2 = w T ( X 1 X 1 T ) w + w T ( X 2 X 2 T ) w = w T ( X 1 X 1 T + X 2 X 2 T ) w = w T S w w S_{1}^{2} +S_{2}^{2} =w^{T}(X_{1}X^{T}_{1})w+w^{T}(X_{2}X^{T}_{2})w =w^{T}(X_{1}X^{T}_{1}+X_{2}X^{T}_{2})w=w^{T}S_{w}w S12+S22=wT(X1X1T)w+wT(X2X2T)w=wT(X1X1T+X2X2T)w=wTSww

- 类内散度矩阵: S w = X 1 X 1 T + X 2 X 2 T S_{w}=X_{1}X^{T}_{1}+X_{2}X^{T}_{2} Sw=X1X1T+X2X2T

- 若考虑先验: S w = p ( ω 1 ) X 1 X 1 T + p ( ω 2 ) X 2 X 2 T S_{w}=p(\omega_{1})X_{1}X^{T}_{1}+p(\omega_{2})X_{2}X^{T}_{2} Sw=p(ω1)X1X1T+p(ω2)X2X2T

- m a x J ( w ) = ( m 1 − m 2 ) 2 S 1 2 + S 2 2 = w T S b w w T S w w maxJ(w)=\frac{(m_{1}-m_{2})^{2}}{S_{1}^{2}+S_{2}^{2}}=\frac{w^{T}S_{b}w}{w^{T}S_{w}w} maxJ(w)=S12+S22(m1−m2)2=wTSwwwTSbw

- 求解方法:

3.5 logistic模型

基本思想:

假设likelihood ratio的对数为线性判别函数: l o g ( p ( x ∣ ω i ) p ( x ∣ ω M ) ) = β i , 0 + β i T x , i = 1 , 2 , . . . , M − 1 ⇒ l o g ( p ( x ∣ ω i ) p ( x ∣ ω M ) ) = w i , 0 + w i T x , i = 1 , 2 , . . . , M − 1 log(\frac{p(x|\omega_{i})}{p(x|\omega_{M})})=\beta_{i,0}+\beta_{i}^{T}x,\ i=1,2,...,M-1 \ \Rightarrow \ log(\frac{p(x|\omega_{i})}{p(x|\omega_{M})})=w_{i,0}+w_{i}^{T}x,\ i=1,2,...,M-1 log(p(x∣ωM)p(x∣ωi))=βi,0+βiTx, i=1,2,...,M−1 ⇒ log(p(x∣ωM)p(x∣ωi))=wi,0+wiTx, i=1,2,...,M−1

3.6 其他方法:最小距离分类、最小均方误差方法、线性SVM

最小距离分类器

- 基本思想:每类建立一个原型向量,以最小距离的原型作为分类依据

- 类别的均值向量作为原型向量 m i = 1 n i ∑ k = 1 n i x k ( i ) m_{i}=\frac{1}{n_{i}}\sum_{k=1}^{n_{i}}x_{k}^{(i)} mi=ni1∑k=1nixk(i)

- 决策准则: h ( x ) = a r g min c i ∣ ∣ x − m i ∣ ∣ 2 h(x)=arg \displaystyle \min_{c_{i}}||x-m_{i}||^{2} h(x)=argcimin∣∣x−mi∣∣2

- 决策平面: g ( x ) = w T ( x − x 0 ) = 0 , w = m 1 − m 2 , x 0 = 1 2 ( m 1 + m 2 ) g(x)=w^{T}(x-x_{0})=0,\ w=m_{1}-m_{2},\ x_{0}=\frac{1}{2}(m_{1}+m_{2}) g(x)=wT(x−x0)=0, w=m1−m2, x0=21(m1+m2)

- 决策函数: g ( x ) = w T x + b , w = m 1 − m 2 , b = − 1 2 ( m 1 − m 2 ) T ( m 1 + m 2 ) g(x)=w^{T}x+b,\ w=m_{1}-m_{2},\ b=-\frac{1}{2}(m_{1}-m_{2})^{T}(m_{1}+m_{2}) g(x)=wTx+b, w=m1−m2, b=−21(m1−m2)T(m1+m2)

最小均方误差

-

基本思想:由线性模型拟合类别,最小化样本类别预测误差

-

代价函数: J ( w ) = ∑ ( y i − x i T w ) 2 = ∑ e i 2 , x , w 为增广表示 J(w)=\sum(y_{i}-x_{i}^{T}w)^{2}=\sum e_{i}^{2},\ x,w为增广表示 J(w)=∑(yi−xiTw)2=∑ei2, x,w为增广表示

-

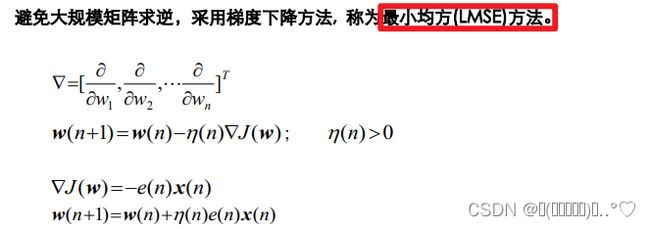

学习算法2:梯度下降算法

线性SVM

-

基本思想:找到最大间隔分类超平面

-

目标:类别集合到分类超平面的最小距离最大化

-

支撑向量:支撑最小距离最大化的样本

-

支撑超平面:由支持向量组成,平行于分类面的超平面

-

样本到分类平面的间隔

- ∣ z ∣ = ∣ g ( x ) ∣ ∣ ∣ w ∣ ∣ |z|=\frac{|g(x)|}{||w||} ∣z∣=∣∣w∣∣∣g(x)∣

- g ( x ) = w T x + b g(x)=w^{T}x+b g(x)=wTx+b

- ∣ g ( x ) ∣ |g(x)| ∣g(x)∣正比于 ∣ ∣ w ∣ ∣ ||w|| ∣∣w∣∣

-

SV到分类超平面的间隔:

- 为了SVM优化目标有唯一解,固定模长,避免w方向重复,固定|g(x)|或固定|w|。

- 选择固定|g(x)|,令|g(x)|=c=1,则 g ( x ) = ± 1 g(x)=\pm1 g(x)=±1

- z = g ( x ) ∣ ∣ w ∣ ∣ , g ( x ) = ± 1 , z ± = ± 1 ∣ ∣ w ∣ ∣ z=\frac{g(x)}{||w||},\ g(x)=\pm1,\ z_{\pm}=\frac{\pm1}{||w||} z=∣∣w∣∣g(x), g(x)=±1, z±=∣∣w∣∣±1

- 支撑超平面的表示 w T x + b = ± 1 w^{T}x+b=\pm1 wTx+b=±1

- 等价表达: y ( w T x + b ) − 1 = 0 , y 为样本 x 的类别标签 y(w^{T}x+b)-1=0,\ y为样本x的类别标签 y(wTx+b)−1=0, y为样本x的类别标签

- SVM期望样本在支撑面的两侧: y i ( w T x i + b ) − 1 ≥ 0 y_{i}(w^{T}x_{i}+b)-1\geq 0 yi(wTxi+b)−1≥0

-

最大间隔问题:

- m a x d = m a x ( z + − z − ) = max w 2 ∣ ∣ w ∣ ∣ max\ d=max(z_{+}-z_{-})=\displaystyle \max_{w}\frac{2}{||w||} max d=max(z+−z−)=wmax∣∣w∣∣2

- 或 m a x d = m a x ( ∣ ∣ z ± ∣ ∣ ) = max w 1 ∣ ∣ w ∣ ∣ max\ d=max(||z_{\pm}||)=\displaystyle \max_{w}\frac{1}{||w||} max d=max(∣∣z±∣∣)=wmax∣∣w∣∣1

-

目标函数:

- min w , b 1 2 ∣ ∣ w ∣ ∣ 2 \displaystyle \min_{w,b}\frac{1}{2}||w||^{2} w,bmin21∣∣w∣∣2

- s . t y i ( w T x i + b ) − 1 ≥ 0 , i = 1 , 2 , . . . , l s.t\ y_{i}(w^{T}x_{i}+b)-1\geq 0,\ i=1,2,...,l s.t yi(wTxi+b)−1≥0, i=1,2,...,l