RSIFNN(基于CNN的遥感图像融合)

研一,耗时8天(我是菜鸡,刚刚入门)

有需要的可以路过观看一下 用的pytorch

论文内容简述

一、基础知识

近年来提出了许多遥感图像融合方法,可分为组件替代、多分辨率分析和稀疏表示三类。

(1)组件替换:的基本思想是将MS图像转换到另一个空间,在将整个数据集反向转换为原始域之前,将PAN图像转换为主组件。

可以看作是一种全局的方法。全局方法可以保留源图像的空间细节,但它可能会造成严重的光谱畸变。

(2)多分辨率分析:首先将每个源图像分解为一个低频子带和一个不同尺度和方向的高频子带序列。然后,根据相应子带的特征选择融合规则,使每个图像的冗余信息和互补信息能够合并。对融合的子带进行逆变换,得到最后阶段的融合数据。

常用的多分辨率分析工具包括拉普拉斯金字塔变换、小波变换、曲波变换、第二代曲线变换和非下采样等值线变换。

基于多分辨率分析的方法可以从不同尺度的分解图像中准确地提取特征,从而减少融合过程中的光晕和混叠伪影。

(3)稀疏表示:首先,根据特定的滑动距离将源图像分成图像块,然后通过字典排序将这些图像块转换为向量。然后,通过预定义字典上向量量化块的线性表达式得到稀疏系数。根据最大活动水平规则[27]等特定的规则,通过融合来自不同源图像的稀疏系数,可以得到融合的稀疏表示。最后,通过字典和融合系数相乘得到融合图像补丁,并积分在一起作为最终的融合结果。特别是基于稀疏表示的方法的融合性能受到所选融合策略的影响

二、本文思想

- 本文提出了一种新的双分支遥感图像融合框架(深度学习)。该框架主要基于卷积神经网络(CNN),为了获得更好的融合结果,扩展了该网络的深度。

- 这个融合网络由两个分支和一个主线程组成。利用两个分支从MS和PAN图像中提取特征,而主线程将从分支中提取的特征进行融合,得到最终结果。

- 整体思想和传统的融合一样:特征提取、特征融合

三、具体流程包括网络设置

- 所有的MS和PAN图像都被归一化到范围[0,1]进行训练和测试

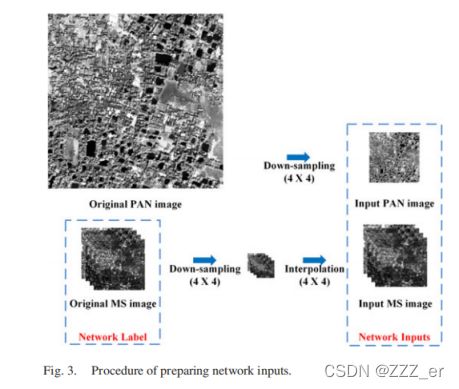

- 获取输入PAN图像:将原始MS图像取均值得到PAN图像

- 获取输入MS图像:将原始MS图像下采样,然后插值(如上图所示)

- 原始的MS图像作为标签

- 网络的输入就是刚刚通过原始MS获得的两个图像:PAN和低分辨率的MS

- 高分辨率和低分辨率MS图像之间存在一个包含必要信息的掩模,该掩模是通过从GIHS中的MS图像中减去PAN图像而直接获得的。

- RSIFNN计算网络最后一层的掩码,称为残差学习。通过将掩模叠加在低分辨率的MS图像上,得到融合结果

2、网络结构图

(只有卷积,relu,去掉了池化,很适合入门)

*两个分支分别卷积,RELU,然后通过cat函数连接,加上残差图像,获得融合结果 *如下图所示

3、特征提取部分

- 该方法设计了两个分支来分别提取MS和PAN图像的特征。

分支一:提取MS图像特征 卷积层数:m = 2

分支二:提取PAN图像特征 卷积层数:p = 8

(层数这样设置的原因:低分辨率的质谱图像包含了足够的光谱信息,因此需要将PAN图像中的更多空间信息注入到融合结果中。因此,设计的网络具有更多的层用于空间信息提取(PAN),保持MS图像的浅层是有意义的) - 网络参数设置

batchsize为128

pieces大小32x32

学习速率为0.0001

动量和权重衰减分别设置为0.9和0.0001

(表格里的4是假设的输入通道,根据实际输入来定)

4、特征融合部分

一个卷积层,然后加上残差图像

5、损失函数

6、质量评估

SAM ERGAS PSNR UIQI RMSE CC

(网上搜公式,直接写就行啦)