Achuan读论文:PARE:一种用于单语言和多语言远程监督关系抽取的简单而又强大的基线

目录

- PARE:一种用于单语言和多语言远程监督关系抽取的简单而又强大的基线

-

- 摘要

- 1. 介绍

- 2. 相关工作

- 3. 段落注意力关系抽取

PARE:一种用于单语言和多语言远程监督关系抽取的简单而又强大的基线

摘要

用于远程监督关系抽取(DS-RE)的神经模型分别对每个在一个实体对包里的句子进行编码。然后将这些信息聚合在一起用于包级别的关系预测。因此,在编码时,这些方法不允许信息从包中的其他句子流动,我们相信他们不能充分利用可用的包数据。作为应对,我们探索了一种简单的基线方法(PARE),其中包中所有的句子被连接成一段句子的段落,并使用BERT进行联合编码。使用有着候选关系的注意力作为查询,聚合了token的上下文嵌入——这个全文的总结预测了候选关系。我们发现,在单语言和多语言的DS-RE数据上,我们发现我们的简单的基线解决方法都优于现存的最先进的DS-RE模型。

1. 介绍

给定一些提到了实体对(e1,e2)的文本t(通常是一个句子),关系抽取(RE)的目标是预测可以从t中推断出的e1和e2的关系。假设B(e1,e2)表示预料中所有提到e1和e2的句子的集合(bag),设R(e1,e2)表示的是一个KB中从e1到e2的所有关系。远程监督(DS)训练给定B(e1,e2)和R(e1,e2)的RE模型,没有句子级别的标注(Mintz et al., 2009)。大多数DS-RE模型都使用了“at-least-one”假设:∀r∈r (e1, e2),∃tr∈B(e1, e2),使tr表示(e1, r, e2),即对于任意一种包含实体e1和e2的关系r,在包含e1和e2的所有句子B中存在一个句子,它表达了e1对e2存在这种关系r。

最近的DS-RE神经网络的方法对每个句子t∈B(e1, e2)进行编码,然后使用聚合嵌入操作对句子嵌入进行聚合——常见的操作时包内注意力(Lin et al., 2016)。各种模型的编码方法(比如,PCNNs, GCNs, BERT)以及损失函数(比如,对比学习、MLM)各不相同,但在对每个句子进行独立于其他句子的这个编码选择上是一致的(Vashishth et al., 2018; Alt et al., 2019; Christou and Tsoumakas, 2021; Chen et al., 2021)。我们假设这种选择导致了对可用数据的次优化使用——来自于其他句子的信息可能帮助到更好的编码给定的句子。

我们通过开发一个简单的极限解决方法来探索这一假设。我们首先通过连接B(e1,e2)中所有句子来构造一个段落。然后我们通过BERT(Devlin et al., 2019)对整个段落进行编码(或者是mBERT用于多语言设置)。这将生成包中每个token的上下文化后的嵌入。为了使这些嵌入能够发现到候选关系,我们使用一个(训练过的)关系查询向量,R,使用注意力机制来生成整个文章的关系发现摘要。然后被用于预测(e1,r,e2)是否是一个有效的预测。

尽管它很简单,但是我们的基线有一些概念上的优势。首先,首先,每个token能够与包中其他句子中的token

交换信息——这会让嵌入具有更多的信息。其次,从原则上讲,该模型至少可以放宽“at-least-one”假设的一部分。例如,如果没有一个句子能独立地表达某一种关系,但是如果不同句子中的多个事实共同预测了这种关系,我们的模型可能会学会抽取出这种关系。

我们将我们的基线模型命名为段落注意力关系抽取,PARE(多语言的DS-RE称为mPARE)。我们在四个DS-RE数据集上进行了实验,其中三个为英语,分别是NYT-10d (Riedelet al.,2010)、NYT-10m和Wiki-20m (Gaoet al.,2021),以及一个多语言数据集DiS-ReX (Bhartiyaet al.,2022)。我们发现,在全部四个数据集上,我们提出的基线显著地优于现存最好的技术,可获得高达5个百分点地AUC增益。进一步的注意力分析和消融实验提供了对模型性能的额外洞察。为了可复制性,我们发布了代码。我们相信我们的工作代表了一个简单但是强大的基线,能够构成更深层次的DS-RE研究的基础。

2. 相关工作

单语言DS-RE:DS-RE的早期工作为这个任务建立了概率图模型(如,(Hoffmann et al., 2011; Ritter et al., 2013))。后来的大多数工作都遵循这个多实例多标签学习框架(Surdeanu et al., 2012),其中,于一个包相关的标签有很多个,并且用“at-least-one”假设来训练模型。大多数用于该任务的神经网络模型分离地对每个句子进行编码,例如分段卷积神经网络(PCNNs)(Zeng et al., 2015)、图卷积网络(如, RESIDE (Vashishth et al., 2018))、GPT(DISTRE (Alt et al., 2019))和BERT(REDSandT (Christou and Tsoumakas, 2021)、CIL(Chen et al., 2021))。他们都使用包内注意力聚合嵌入 (Lin et al., 2016)。除了二元交叉熵,其他损失函数还有掩码语言模型预训练(DISTRE, CIL),PL损失(Qin et al., 2018)和辅助对比学习(CIL)。我们证明相比于DISTRE、RESIDE、CIL和其他自然基线,PARE很有竞争力,而不需要额外的预训练、边信息或是训练期间的辅助损失,这与其他竞争模型很是不同。

为了评估DS-Re,在测试时,模型将对一个不可见的包做出预测。不幸的是,大多数流行的DS-RE数据集(nyt-10d)有一个噪声测试集,因为它是自动注释的(Riedel et al., 2010)。最近,Gao等人(2021)发布了NYT-10m和wiki-20m数据集,他们都有手动标注的测试集。我们在工作中使用了所有这三个数据集。

多语言DS-RE:一个名叫MNRE的双语言DS-RE模型(在英语和普通话上进行测试)在特定语言的CNN中编码器中引入了跨语言注意力(Lin et al., 2017)。最近,Bhartiya等人(2022)发布了一个数据集,DiS-ReX,适用于英语、西班牙语、德语和法语四种语言。我们将mPARE与DiS-ReX上最先进的模型进行比较,后者结合了MNRE架构和mBERT编码器。有关DS-RE模型的详细信息,请参见附录E。

基于句子的包的段落构建:在较高层次上,我们提出的模型通过结合提到给定实体对的包中的句子来构建一篇段落。这个段落构建的思想与Yan等人的工作(2020)有关,但是在任务定义和神经网络模型上有重要区别。首先,他们专注于预测给定查询的尾实体(e1,r,?),而我们的目标是给定实体的关系预测。模型也有一些不同之处,例如,在段落的组织、在使用关系的可训练查询向量、在段落构建策略等。重要的是,他们的架构希望每个候选关系都有一个自然语言问题——这不仅需要一个额外的每个关系的标注(这对于本体中就有很多关系的数据集不可行),而且还会使他们的方法变慢,因为每个关系都需要单独的前向传递。

3. 段落注意力关系抽取

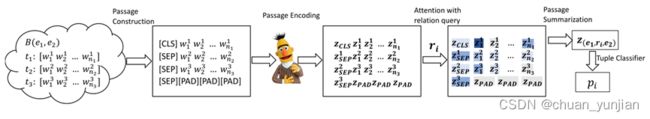

PARE研究了跨句子的注意力在编码时的价值。它使用了三个关键步骤的序列:段落构建、编码和总结,随后是预测。图1说明了一个三个句子的包的这个过程。

段落总结维护每个关系ri(随机初始化)的查询向量Ri。然后计算αij,ri在每个token wj上的标准化注意力,使用点积注意力。最终,计算整个段落的关系注意总结z(e1,ri,e2)=(x+a)n=∑_(j=1)(j=L)▒a_j^i z_j,其中L是输入长度。我们注意到,这个求和还聚合了[CLS]、[SEP]、[PAD]以及实体标记token的嵌入。

元组分类器将通过跟着Sigmoid激活函数的MLP传递z(e1,ri,e2),来返回三元组(e1,ri,e2)的概率pi。这个MLP在所有关系分类中被共享。在推理中,如果pi大于阈值(0.5),则预测为正值.

损失函数是一个每个包的gold和预测标签集之间的简单的二元交叉熵。没有使用额外的损失元素。