6.2 统计学分析方法

统计学分析方法

- 1. 多变量分析方法的选择

-

- 1.1 有因变量,建立有监督模型

-

- 1.1.1 回归预测模型

- 1.1.2 分类预测模型

- 1.2 无因变量,建立无监督模型

- 1.3 其他分析

- 2. 相关分析

-

- 2.1 不同变量类型的相关系数

- 2.2 常用方法

- 2.3 三种重要相关系数

- 偏相关分析与典型相关分析

- 2.4 相关分析的假设检验

- 2.5 偏相关分析的假设检验

- 3.回归分析

-

- 3.1 回归分析的建立步骤

-

- 3.1.1 选择变量

- 3.1.2 确定变量之间关系

- 3.1.3 选择对应的线性或非线性方程,进行各项参数计算

- 3.1.4 回归方程计算,对模型进行全方位检验

-

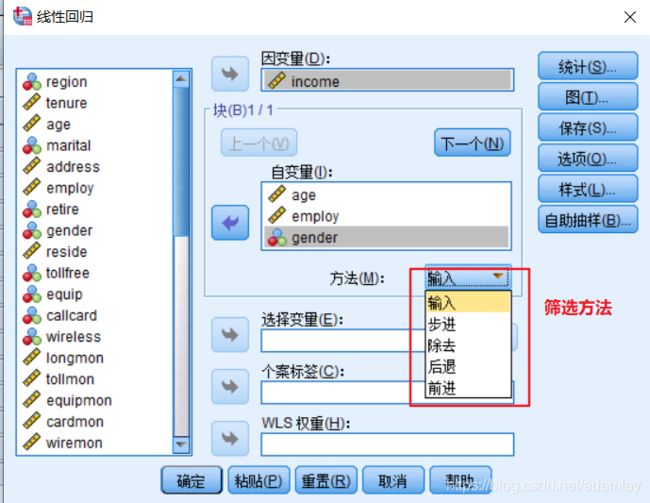

- 线性回归筛选方法

- 3.2 回归分析的SPSS操作

-

- 3.2.1 回归分析前

-

- 画散点图

- 虚拟变量的转换

- 3.2.2 线性回归SPSS

-

- 3.2.2.1 输出解读

- 3.2.3 非线性回归

-

- 3.2.3.1 两种求解方式

- 3.2.3.2 非线性回归计算时注意的几个问题

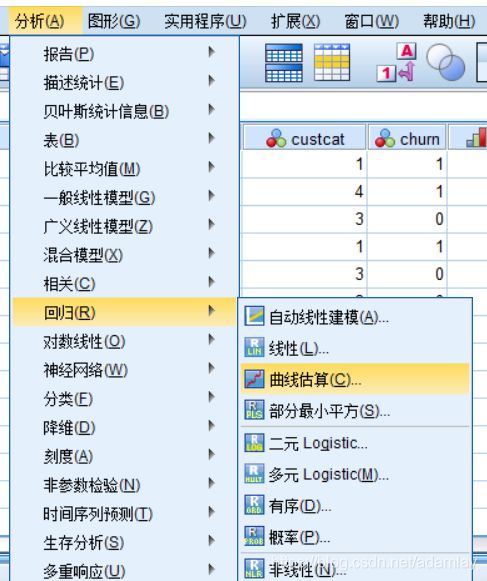

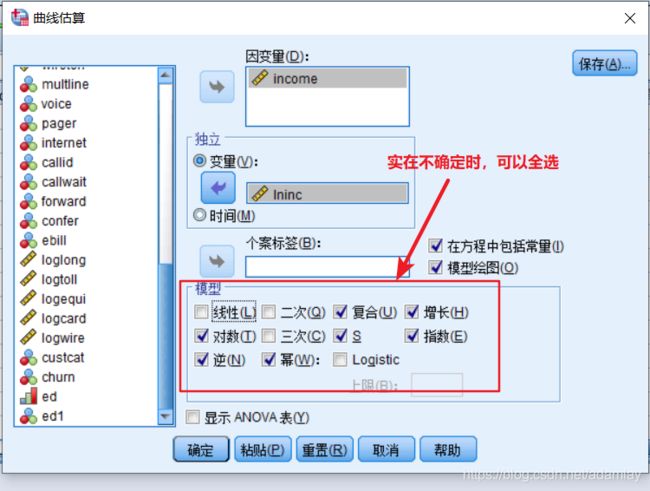

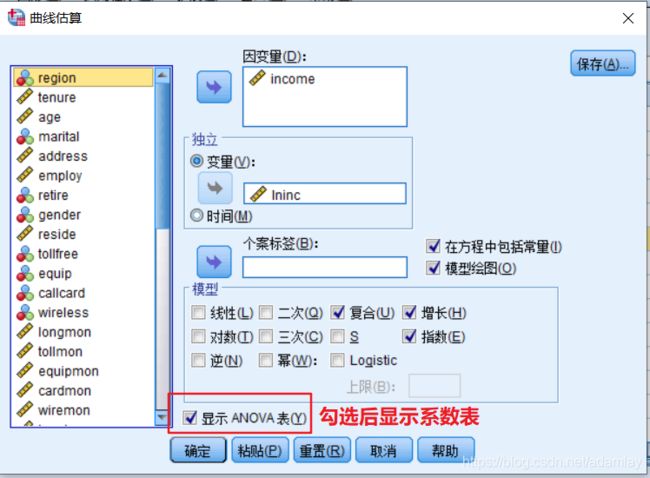

- 3.2.3.3 SPSS操作

- 3.3 回归分析总结

- 4. 因子分析/主成分分析

-

- 4.1 使用场景

- 4.2 前提

- 4.3 因子

- 4.4 过程

- 4.5 SPSS操作

-

- 4.5.1 过程

- 4.5.2 结果解读

- 4.6 基于因子分析法的综合评价案例

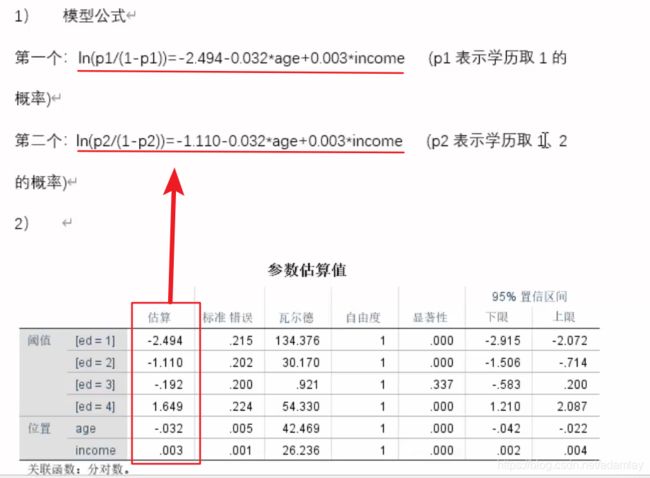

- 5. 逻辑(logistic)回归

-

- 5.1 应用场景

- 5.2 原理

- 5.3 分类

- 5.4 SPSS操作

-

- 5.4.1 二元分类

- 5.4.2 无序多元分类

- 5.4.3 有序多元分类

- 6. 时间序列分析

-

- 6.1 特点

- 6.2 方法

-

- 格兰杰因果检验

- 6.3 要求

- 6.4 预测方法

- 6.5 两种类型的时间序列

- 6.6 ARIMA方法

-

- 6.6.1 适用场景

- 6.6.2 非平稳序列趋势处理方法——差分

- 6.6.3 AR(向量自回归)模型

- 6.6.4 周期性计算——移动平均法

- 6.7 SPSS操作

-

- 6.7.1 定义时间序列

- 6.7.2 普通ARIMA模型

1. 多变量分析方法的选择

1.1 有因变量,建立有监督模型

![]()

有监督模型有两大通用目的:

- 分析哪些自变量对因变量存在显著影响作用;

- 通过选择对因变量存在显著影响的自变量,建立预测因变量取值的预测模型。

1.1.1 回归预测模型

因变量为连续变量,建立的模型称为回归预测模型:

- 自变量为连续变量时,可选择回归分析、方差分析;

- 自变量为分类变量+连续变量,可选择带虚拟变量的回归分析、联合分析、方差分析

1.1.2 分类预测模型

因变量为分类变量(定性数据),建立的模型称为分类预测模型:

- 自变量为连续变量(或连续+分类)时,可选择判别分析、Logistic/probit analysis

- 自变量为定性数据时,可选择对数线性回归(Logit)。预测因变量是如何分类的,在人文社科常用。

1.2 无因变量,建立无监督模型

只要是无监督分析,都叫做描述分析,分析方法得到的结果没有客观标准判断结论是否准确

目的:

1)对人进行分类;

2)对变量/指标进行分类;

3)分析变量与变量之间的测量关系

方法:

- 自变量为连续变量时,选择因子分析(其中一个目的就是对变量/指标分类)、聚类分析(对人分类、对变量/指标分类)

- 自变量为分类变量时,选择对应分析(对人分类)、多维尺度分析(对人分类)

1.3 其他分析

- 当模型中需要加入潜在变量(通过多个客观指标测量的抽象概念整体)、或需要考虑多个变量之间的因果关系分析模型,建立结构方程模型、路径模型、协方差分析。

- 综合评价:通过多个指标对多个评价对象进行排名,可选择层次分析法(AHP)、因子分析等。

2. 相关分析

相关系数是衡量两个变量之间变化趋势的相关性

2.1 不同变量类型的相关系数

- 两个变量都为连续变量,则可用Pearson相关系数。在统计中常用r这个符号来表示。

- 两个变量都为定序变量,则可用GMMA、Spearman、Kendall’s tau-b等相关系数

- 两个变量都为定类变量,则可用LAMMDA等相关系数

- 一个变量为定类变量,一个变量为连续变量,可通过ETA系数来测量相关性

2.2 常用方法

- 散点图

- 计算相关系数

2.3 三种重要相关系数

相关系数表示线性关系,不表示曲线关系。

在统计中,相关系数用 r 这个符号来表示(一般默认为Pearson相关系数)

![]()

| r | 相关性 |

|---|---|

| >0.8 | 极强相关 |

| 0.6-0.8 | 强相关 |

| 0.4-0.6 | 中等相关 |

| 0.2-0.4 | 弱相关 |

| <0.2 | 极弱相关 |

- 普通相关性系数(Pearson相关系数的前身)

- Pearson相关系数:参数检验,针对两个都是连续变量的数据进行相关性判断

- Spearman相关系数:非参数检验(对变量在总体中的分布没有要求),针对两个都是定序变量;小样本时,该系数服从spearman分布,大样本时,近似服从正态分布

- Kendall’s tau-b相关系数:非参数检验(对变量在总体中的分布没有要求),针对两个都是定序变量;小样本时,该系数服从Kendall分布,大样本时,服从正态分布

偏相关分析与典型相关分析

2.4 相关分析的假设检验

SPSS操作:分析-相关-双变量

原假设:两个变量来自总体中不存在显著相关性

研究假设:两个变量来自总体中存在显著相关性

显著性检验目的:是用来判断两个变量在总体中是否存在相关性

相关系数:是计算两个变量在样本数据中的相关性强弱

2.5 偏相关分析的假设检验

注意:计算相关性的变量为连续变量,加入控制的变量同样也是连续变量

SPSS操作:分析-相关-偏相关性

3.回归分析

目的:当需要用一个数学表达式(模型)表示多个因素与另外一个因素之间关系时,可选用回归分析法。

R2:衡量自变量对因变量的解释能力,即模型的解释能力,即r(相关系数)的平方。注意r不一定是一元一次回归模型里x前面的值,x前面的值是要考虑x和y的量纲的。

应用:和有监督模型的两个通用目的相同:

1)分析哪些自变量对因变量存在显著影响作用,R2值可以不要求大于0.8;

2)通过选择对因变量存在显著影响的自变量,建立预测因变量取值的预测模型,模型R2必须要求大于等于0.8。

但是,在人文社科领域,很多回归模型的R2值达不到0.8,也可以用来做预测。在金融领域,必须达到0.9以上。

前提:

3.1 回归分析的建立步骤

3.1.1 选择变量

因变量:根据研究需求或问题推导出来

自变量:

- 前人的研究成果

- 个人经验

3.1.2 确定变量之间关系

-

挨个将自变量与因变量画散点图,判断每个自变量与因变量之间是线性还是非线性关系

-

通过卡方检验、T检验、F检验或相关分析法,挨个分析每个备选的自变量与因变量之间是否存在显著的相关性。将与因变量明显没有相关性的自变量剔除掉,不加入到后期模型中。

3.1.3 选择对应的线性或非线性方程,进行各项参数计算

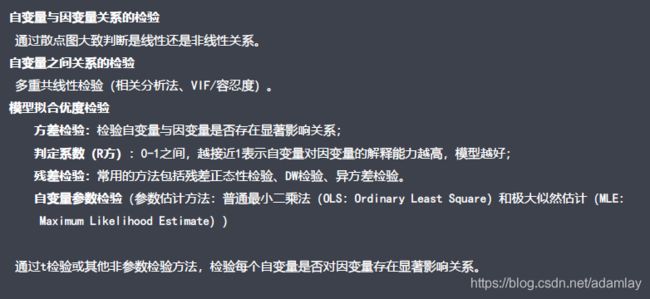

3.1.4 回归方程计算,对模型进行全方位检验

多重共线性检验:检验多个自变量之间是否存在相关性较高的变量,如有,则保留与因变量相关性最高的一个自变量。

模型拟合优度检验:方差检验/判定系数(R2)/残差检验/自变量参数检验

线性回归筛选方法

3.2 回归分析的SPSS操作

3.2.1 回归分析前

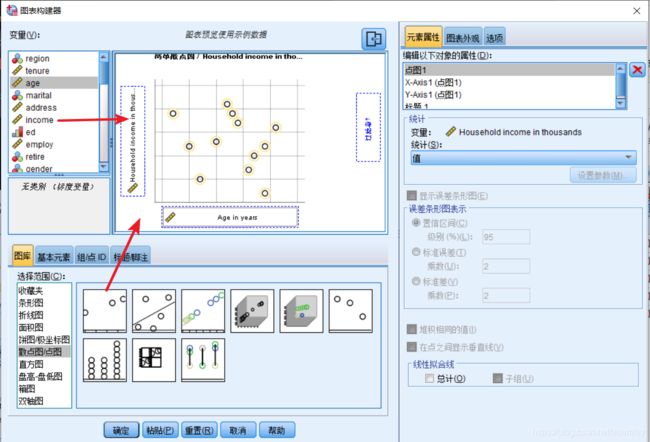

解决问题:分析影响人们家庭收入的因素有哪些,建立预测收入的回归方程

因变量:家庭收入

自变量:年龄、工作年限、性别(因为只有男女01)、学历(变成虚拟变量)

画散点图

虚拟变量的转换

原因:分类变量无法参与到回归模型中的加减乘除运算

操作:将原先的分类编码统一转换为0、1数值

![]()

举例:

Ed(教育程度)=1 2 3 4 5

| 1 | 2 | 3(对照人群) | 4 | 5 | |

|---|---|---|---|---|---|

| Ed1 | 1 | 0 | 0 | 0 | 0 |

| Ed2 | 0 | 1 | 0 | 0 | 0 |

| Ed4 | 0 | 0 | 0 | 1 | 0 |

| Ed5 | 0 | 0 | 0 | 0 | 1 |

3.2.2 线性回归SPSS

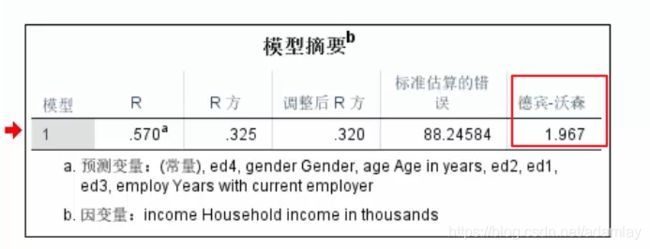

3.2.2.1 输出解读

R2值:衡量自变量对因变量的解释能力,即模型的解释能力

F值:F值对应的概率P值小于0.05,研究假设成立,即至少有一个自变量对因变量存在显著影响

显著性:根据每个自变量的t值,对应的P值是否小于0.05,如小于,则研究假设成立,即自变量对因变量存在显著影响

如上图,可知工作年限和学历对收入有显著影响,而年龄和性别则没有

标准化系数:通过标准化系数来判断自变量对因变量的影响程度大小。

如上图,可知工作年限影响明显大于学历

B:由上图,在其他变量不变的情况下,工作年限每增加一个单位(1年),则因变量家庭收入平均增加6.279个单位;

3) 共线性检验

VIF:通常根据VIF>10,判断自变量之间存在共线性

4) 残差检验

通过逐步回归法,将对因变量没有显著性影响的自变量从模型中删除,得到干净的模型

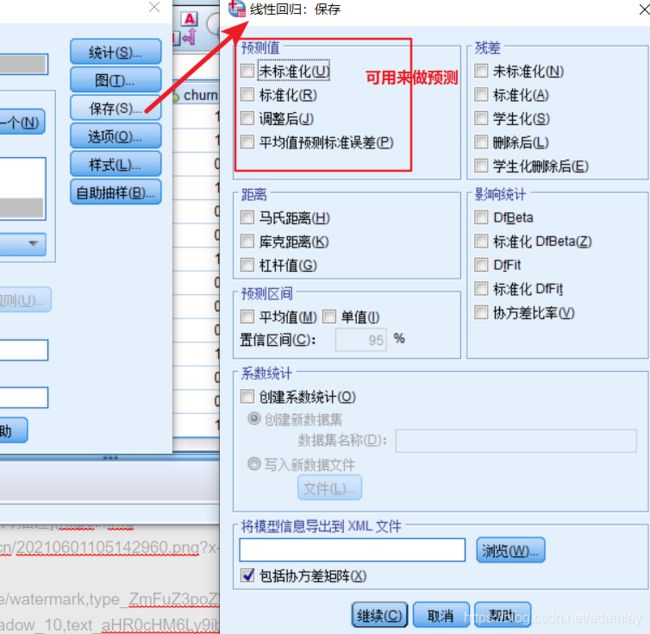

6) 写回归方程

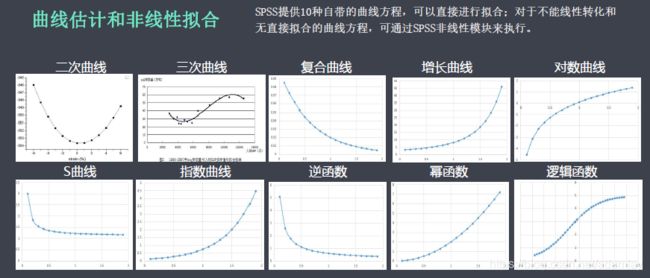

3.2.3 非线性回归

3.2.3.1 两种求解方式

- 直接计算:建立非线性模型

3.2.3.2 非线性回归计算时注意的几个问题

3.2.3.3 SPSS操作

- 散点图判断是否为非线性关系

- 曲线估计,判断哪种非线性回归模型更符合

输出结果可以根据R2来判断最符合(最接近1)的函数

- 输出系数,构造回归方程

得到系数后,在曲线回归的方程及对应线性方程中转换非线性回归方程

- 当得出的模型,其R方达不到1时,可以对方程进行优化,方法是使用非线性方程估计

然后在输出结果中,看R方值是否有提高,有的话就用新的,没有就用原来的

3.3 回归分析总结

回归方程具有特定的形式。例如,因变量表示为截距、自变量的线性组合,及残差的和。不满足这一假设,可能原因:

- 忽略了重要的自变量

- 包含了不相关的自变量

- 非线性-因变量和自变量之间的关系是非线性的

- 变动的参数-数据收集期间,方程中参数不是常数

- 非可加性-自变量中某个给定变量的影响是附随着其它变量的

4. 因子分析/主成分分析

目的:对多个具有较高相似性的变量/指标,进行降维,前提是这些变量/指标之间必须存在一定的相关性/相似性

4.1 使用场景

1) 降维后综合评价

想要知道品牌印象的构造(想通过少数的潜在因子来解释印象)。或者,想要归纳出消费者的若干种态度。

不测量综合满意度,但想通过个别满意度来计算出综合满意度指数。

2) 效度检验:探索性因子分析

对抽象概念的测量工具进行有效性检验,判断哪些指标需要保留或删除,并对保留的指标进行降维划分

3) 降维后做其他分析:消除变量之间的相关性/共线性

由于变量存在较高的相关性,不适合做回归分析、聚类等其他分析,需要用因子分析消除变量间较高的共线性

4.2 前提

样本量大小:

- 样本量与变量数的比例应在5:1以上

- 总样本量不得少于100,而且原则上越大越好

各变量间必须有相关性

- KMO统计量:0.9最佳,0.7尚可,0.6较差,0.5以下放弃

- Bartlett球形检验:若相关矩阵为单位矩阵,则因子分析无效

4.3 因子

所谓因子,是指造成某种现象的原因和先行条件。

因子分析是心理学家为了把握人的心理能力而开发出来的。原来是为了解释多种学力测试的相关关系而着力开发出来的方法。

在心理学中,通过测试相互间的相关关系数表(相关行列)思考如下的问题。

把共同的潜在的部分称为因子(factor)

4.4 过程

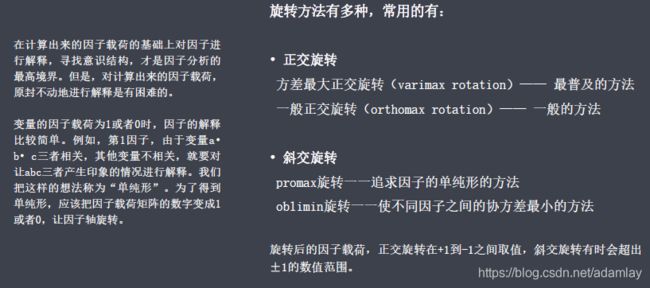

- 使得因子可以更好的代表原来的变量

- 降低或消除提取因子的相关性(常用方差最大正交旋转)

4.5 SPSS操作

![]()

4.5.1 过程

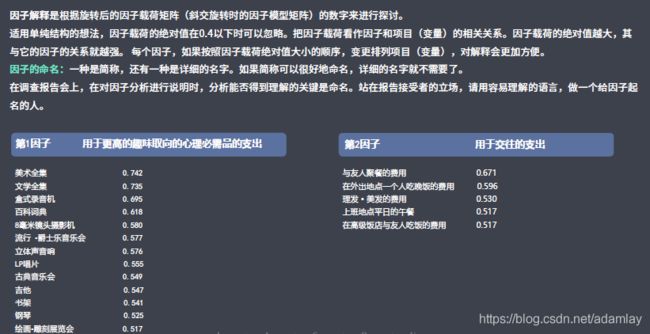

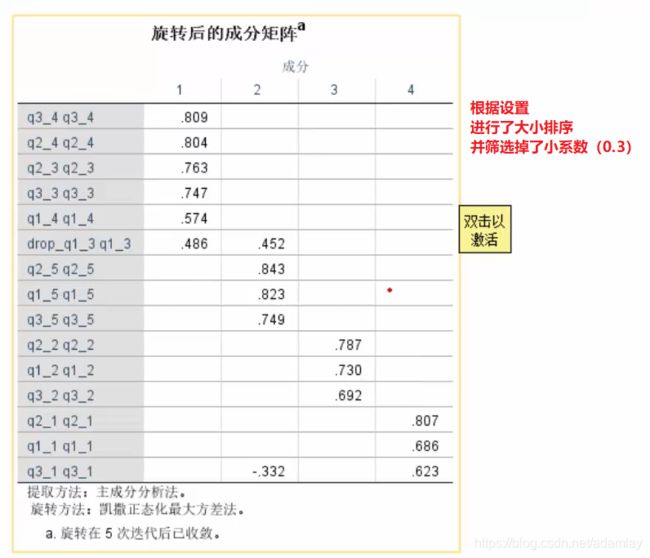

4.5.2 结果解读

- KMO>0.7,适合做因子分析

- 公因子方差

- 累计方差贡献率,达到多少才合适?

如果通过因子分析降维后做综合评价,那么累计方差贡献率要大于80%;效度检验或其他分析,60%以上即可

- 因子划分:根据每个变量在每个因子的取值是否大于0.5

- 效度检验:

第一判断标准:每个变量有且只有一个因子载荷值大于0.5,如果所有因子载荷值均小于0.5,则说明该变量不具有收敛效度,需要删除;

第二判断标准:变量在两个或以上因子中的载荷值同时大于0.5,则说明该变量不具有区分效度,需删除;

第三个判断标准:某变量单独成为一个因子,则说明该变量也不存在收敛效度,需删除 - 因子得分计算(建议放到excel中计算):F1=x1a1+x2a2+……

4.6 基于因子分析法的综合评价案例

苏北防火林带8种主要树种抗火能力的分析

5. 逻辑(logistic)回归

5.1 应用场景

做分类预测模型,且为非参数检验方法。可以用于二分类,无序多分类,有序多分类

5.2 原理

5.3 分类

- 二分类(0、1)

- 无序多元分类(1、2、3、4→转化为虚拟变量进行二分类逻辑回归)

- 有序多元分类

5.4 SPSS操作

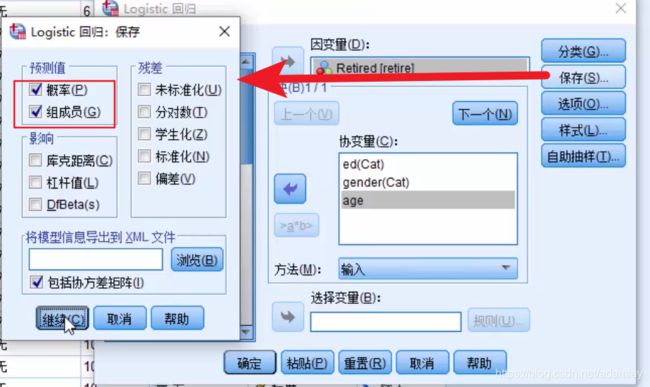

5.4.1 二元分类

结果解读

1) 虚拟变量的转化

2) 无自变量预测

3) 预测结果

4) 根据参数检验中的p<0.5判断自变量对因变量是否有影响

5) 根据Wald值大小,判断自变量对因变量的影响程度排名

6) 精简模型,剔除没有影响的自变量,并进行排名

7)优势比(OR值)大于1,表示该自变量会增加因变量取1的概率,反之会降低因变量取1的概率

即:在其他变量不变的情况下,当年龄增加一个单位(1岁)时,优势比增加1.385倍(年龄越大,退休概率越大)

5.4.2 无序多元分类

步骤

结果解读

5.4.3 有序多元分类

步骤

- 分析-回归-有序回归

- 输出

需要进行平行线检验,检验当因变量划分不同取值时,建立的多个二元Logistic回归,自变量对因变量的影响程度是相同。如果该检验不成立,则不能选择有序多元分类模型,改用无序多元分类模型

6. 时间序列分析

按照时间的顺序把随机事件变化发展的过程记录下来就构成了一个时间序列。

目的:对时间序列进行观察、研究,(1)找寻它变化发展的规律,(2)预测它将来的走势就是时间序列分析。

6.1 特点

![]()

6.2 方法

![]()

格兰杰因果检验

因果关系成立三个条件

- A、B两个事件必须存在相关性

- 原因A必须发生在结果B之前

- 排除其他干扰因素(没有A导致了B,A+C导致了B发生)

6.3 要求

6.4 预测方法

6.5 两种类型的时间序列

6.6 ARIMA方法

Autoregressive-Integrated-Moving Average:即向量自回归-差分-移动平均模型

6.6.1 适用场景

6.6.2 非平稳序列趋势处理方法——差分

ARIMA模型建立的前提是时间序列数据必须为平稳序列,可通过单位根检验(ADF)来判断一个序列是否平稳,如果不平稳,可通过差分进行转换。

通过差分,可以抵消掉数据的增长或降低趋势的影响

6.6.3 AR(向量自回归)模型

6.6.4 周期性计算——移动平均法

周期性的处理方法——移动平均法

![]()

6.7 SPSS操作

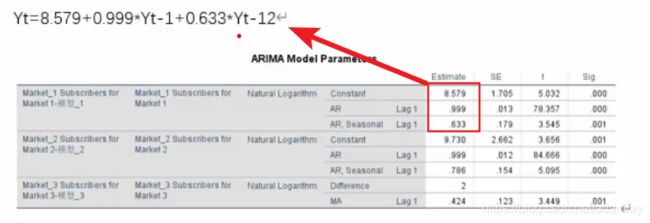

![]()

SPSS建模时选择专家建模法,软件将根据数据特点自动选择适合的建模方法(如上图)

6.7.1 定义时间序列

6.7.2 普通ARIMA模型

- 专家建模器-条件-选择专家模型范围(当结果不理想时,可选择更换模型)

结果解读

1)时间序列假设检验

通过Ljung-Box Q检验,原假设时模型可以很好的模拟原始数据,p>0.05表示模型可以接受,p值越大模型越好

2)模型公式