机器学习中的数据及其处理

目录

数据及其处理

文本数据

词干提取(stemming)和词形还原(lemmatization)

N-gram模型

音频数据

确定数据集规模

数据及其处理

样本:sample,或输入,input

预测:prediction,或输出,output

目标:target,真实值

类别:class

标签:label

真值:ground-truth,或标注,annotation

训练集:training set

测试集:test set

数据蒸馏:data distillation

分类编码:categorical encoding

数据增强:data augumentation

标准化:Standardization

将数据变换为均值为0,标准差为1的分布切记,并非一定是正态的

归一化:Normalization

将一列数据变化到某个固定区间(范围)中,通常,这个区间是[0, 1],广义的讲,可以是各种区间,比如映射到[0,1]一样可以继续映射到其他范围,图像中可能会映射到[0,255],其他情况可能映射到[-1,1];

批标准化:batch normalization

批再标准化:batch renormalization

数据预处理是一种数据挖掘技术,包括数据清洗、数据集成、数据归约、数据变换等多种方法。

在数据挖掘之前使用数据预处理技术先对数据进行一定的处理,将极大提高数据挖掘的质量,降低实际数据挖掘所需的时间。

数据变换方法包括数据平滑、数据聚集、数据泛化、数据规范化等。

数据分析方法包括聚类分析、因子分析、相关分析、方差分析、回归分析等。

缺失数据处理方法包括删除含有缺失值的记录、均值插补、同类均值插补等。

数据治理是指对于数据采集、数据清洗、数据标注到数据交付整个项目生命周期每个阶段进行识别、度量、监控、预警等一系列管理措施。

数据分割是指把逻辑上是统一整体的数据分割成较小的、可以独立管理的物理单元进行存储,以便于重构、重组和恢复,以提高创建索引和顺序扫描的效率。

数据清洗是指发现并纠正数据文件中可识别错误的最后一道程序,包括检查数据一致性,处理无效值和缺失值等。

为了避免在数据传输过程中数据被窃取、被复制等,应对数据传输过程进行压缩、加密等操作。

数据一致性检查是根据每个变量的合理取值范围和相互关系,检查数据是否合乎要求,以及发现超出正常范围、逻辑不合理或者相互矛盾的数据,便于进一步核对和纠正。

文本数据

n-gram:多个连续单词或字符的集合,n-gram之间可重叠

token:标记,将文本分解而成的单元(单词、字符或n-gram)

分词:tokenization,将文本分解成标记的过程

停词:stop words,文本中出现频率相对较高,但是对于文本实际意义没有太大关联的单词

one-hot编码:one-hot encoding

one-hot散列技巧:one-hot hashing trick

标记嵌入:token embedding,通常只用于单词,叫做词嵌入,word embedding

片段的词嵌入:Segmental Embedding

二元语法袋:bag-of-2-grams

三元语法袋:bag-of-3-grams

袋:bag,指我们处理的是标记组成的集合,而不是一个列表或序列,即标记没有特定的顺序

词袋:bag-of-words,一个不保存顺序的分词方法

预训练词嵌入:pretrained word embedding

平行语料:Parallel Corpus,成对的源语言句子和目标语言句子的集合

word2vec:一种词嵌入算法

GloVe:global vectors for word representation,词表示全局向量

TF-IDF(term frequency–inverse document frequency)是一种用于信息检索与数据挖掘的常用加权技术。TF是词频(Term Frequency),IDF是逆文本频率指数(Inverse Document Frequency)

Skig-Gram:跳字模型

连续词袋模型:Continuous Bag Of Words,CBOW

分桶:Bucketing

词干提取(stemming)和词形还原(lemmatization)

词形还原(lemmatization),是把一个任何形式的语言词汇还原为一般形式(能表达完整语义),而词干提取(stemming)是抽取词的词干或词根形式(不一定能够表达完整语义)。词形还原和词干提取是词形规范化的两类重要方式,都能够达到有效归并词形的目的,二者既有联系也有区别。

目标一致。词干提取和词形还原的目标均为将词的屈折形态或派生形态简化或归并为词干(stem)或原形的基础形式,都是一种对词的不同形态的统一归并的过程。 结果部分交叉。词干提取和词形还原不是互斥关系,其结果是有部分交叉的。一部分词利用这两类方法都能达到相同的词形转换效果。如“dogs”的词干为“dog”,其原形也为“dog”。 主流实现方法类似。目前实现词干提取和词形还原的主流实现方法均是利用语言中存在的规则或利用词典映射提取词干或获得词的原形。 应用领域相似。主要应用于信息检索和文本、自然语言处理等方面,二者均是这些应用的基本步骤。

区别。在原理上,词干提取主要是采用“缩减”的方法,将词转换为词干,如将“cats”处理为“cat”,将“effective”处理为“effect”。而词形还原主要采用“转变”的方法,将词转变为其原形,如将“drove”处理为“drive”,将“driving”处理为“drive”。 在复杂性上,词干提取方法相对简单,词形还原则需要返回词的原形,需要对词形进行分析,不仅要进行词缀的转化,还要进行词性识别,区分相同词形但原形不同的词的差别。词性标注的准确率也直接影响词形还原的准确率,因此,词形还原更为复杂。 在实现方法上,虽然词干提取和词形还原实现的主流方法类似,但二者在具体实现上各有侧重。词干提取的实现方法主要利用规则变化进行词缀的去除和缩减,从而达到词的简化效果。词形还原则相对较复杂,有复杂的形态变化,单纯依据规则无法很好地完成。其更依赖于词典,进行词形变化和原形的映射,生成词典中的有效词。 在结果上,词干提取和词形还原也有部分区别。词干提取的结果可能并不是完整的、具有意义的词,而只是词的一部分,如“revival”词干提取的结果为“reviv”,“ailiner”词干提取的结果为“airlin”。而经词形还原处理后获得的结果是具有一定意义的、完整的词,一般为词典中的有效词。 在应用领域上,同样各有侧重。虽然二者均被应用于信息检索和文本处理中,但侧重不同。词干提取更多被应用于信息检索领域,如Solr、Lucene等,用于扩展检索,粒度较粗。词形还原更主要被应用于文本挖掘、自然语言处理,用于更细粒度、更为准确的文本分析和表达

N-gram模型

N-gram是自然语言处理中常见一种基于统计的语言模型。它的基本思想是将文本里面的内容按照字节进行大小为N的滑动窗口操作,形成了长度是N的字节片段序列。每一个字节片段称为gram,在所给语句中对所有的gram出现的频数进行统计。再根据整体语料库中每个gram出现的频数进行比对可以得到所给语句中每个gram出现的概率。N-gram在判断句子合理性、句子相似度比较、分词等方面有突出的表现。

比如:

假设你在和一个外国人交流,他说了一句“I have a gun”,但是由于他的发音不标准,到你耳朵里可能是“I have a gun”、“I have a gull”或“I have a gub”。那么哪句话是正确的呢?。假设你根据经验觉得有80%的概率是“I have a gun”,那么你已经得到一个N-gram的输出。即:

P(****I have a gun) = 80%

N-gram本身也指一个由N个单词组成的集合,各单词具有先后顺序,且不要求单词之间互不相同。最简单的是一元语法unigram(N=1),常用的有 Bi-gram (N=2) 和 Tri-gram (N=3),一般已经够用了。例如在“I love deep learning”这句话里,可以分解的** Bi-gram** 和 Tri-gram :

**Bi-gram : {I, love}, {love, deep}, {love, deep}, {deep, learning}

Tri-gram : **{I, love, deep}, {love, deep, learning}

音频数据

脉冲编码调制:Pulse-code Modulation,PCM

梅尔尺度:Mel-scale

梅尔过滤器:Mel Filter

奈奎斯特采样定理:Nyquist Sampling Theorem

梅尔倒频谱系数:Mel-Frequency Cepstral Coefficients,MFCC

确定数据集规模

取决于:

- 所需解决问题的难易程度

- 所采用的模型的复杂程度(模型参数数量)

- 想要达到什么样的性能

① 最快的方法

查找相关领域的论文资料,别人一般用多少的数据量

② 经验范围

回归分析:要训练出一个性能良好的模型,所需训练样本数量应是模型参数数量的10倍。

缺点:

- 稀疏特征:例如稀疏特征的编码是01001001对于模型的训练能够起到作用的特征是少数的,而不起作用的特征占大多数。依照上述线性规则,若模型对于每个特征分配相应的参数,也就是说对于无用的特征也分配了相应的参数,再根据10倍规则法,获取是模型参数数量10倍的训练样本集,此时的训练样本数量对于最佳的训练模型来说可能是超量的,所以,此时用10倍规则法得到的训练样本集未必能够真实地得出好的训练模型。

- 由于正则化和特征选择技术,训练模型中真实输入的特征的数量少于原始特征数量。

计算机视觉:对于使用深度学习的图像分类,经验法则是每一个分类需要 1000 幅图像,如果使用预训练的模型则可以用更少数据去训练。

③ 在分类任务中确定训练数据量的方法

学习曲线是误差与训练数据量的关系图。我们可以建立一个学习曲线的函数,然后采用非线性回归或者加权非线性回归对学习曲线进行拟合,然后找到期望准确率下的样本数量。

④ 样本容量估计(给定统计检验的检验效能,确定样本数量)

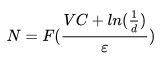

N是所需样本数量, α是一定置信度所对应的的标准正态分布的常数, σ是样本的标准差, e是可接受的误差范围。

⑤ 训练数据规模的统计学习理论

VC 维是模型复杂度的度量,模型越复杂,VC 维越大。

N为所需样本数量,d为失效概率,ε为学习误差

⑥ 一般准则

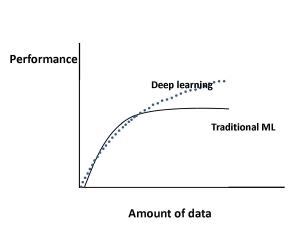

传统的机器学习算法:性能是按照幂律增长的,一段时间后趋于平稳。

深度学习:性能随着数据的增加呈现对数增长