- python第一次作业

1.技术面试题(1)TCP与UDP的区别是什么?**答:1.TCP是面向连接的协议,而UDP是元连接的协议2.TCP协议传输是可靠的,而UDP协议的传输是“尽力而为3.TCP是可以实现流控,而UDP不行4.TCP可以实现分段,而UDP不行5.TCP的传输速率较慢,占用资源较大,UDP传输速率快,占用资源小。TCP/UDP的应用场景不同TCP适合可靠性高的效率要求低的,UDP可靠性低,效率高。(2)

- python

www_hhhhhhh

pythonjava面试

1.技术面试题(1)解释Linux中的进程、线程和守护进程的概念,以及如何管理它们?答:进程:是操作系统进行资源分配的基本单位,拥有独立的地址空间、进程控制块,每个进程之间相互隔离。例如,打开一个终端窗口会启动一个bash进程。线程:是操作系统调度的基本单位,隶属于进程,共享进程的资源,但有独立的线程控制块和栈。线程切换开销远小于进程。例如,一个Web服务器的单个进程中,多个线程可同时处理不同客户

- Python lambda表达式:匿名函数的适用场景与限制

梦幻南瓜

pythonpython服务器linux

目录1.Lambda表达式概述1.1Lambda表达式的基本语法1.2简单示例2.Lambda表达式的核心特点2.1匿名性2.2简洁性2.3即时性2.4函数式编程特性3.Lambda表达式的适用场景3.1作为高阶函数的参数3.2简单的数据转换3.3条件筛选3.4GUI编程中的回调函数3.5Pandas数据处理4.Lambda表达式的限制4.1只能包含单个表达式4.2没有语句4.3缺乏文档字符串4.

- 【python】

www_hhhhhhh

python面试职场和发展

1.技术面试题(1)TCP与UDP的区别是什么?答:TCP(传输控制协议)和UDP(用户数据报协议)是两种常见的传输层协议,主要区别在于连接方式和可靠性。TCP是面向连接的协议,传输数据前需建立连接,通过三次握手确保连接可靠,传输过程中有确认、重传和顺序控制机制,保证数据完整、按序到达,适用于网页浏览、文件传输等对可靠性要求高的场景。UDP是无连接的协议,无需建立连接即可发送数据,不保证数据可靠传

- Python函数的返回值

1.返回值定义及案例:2.返回值与print的区别:print仅仅是打印在控制台,而return则是将return后面的部分作为返回值作为函数的输出,可以用变量接走,继续使用该返回值做其它事。3.保存函数的返回值如果一个函数return返回了一个数据,那么想要用这个数据,那么就需要保存.#定义函数defadd2num(a,b): returna+b#调用函数,顺便保存函数的返回值result=

- python怎么把函数返回值_python函数怎么返回值

python函数使用return语句返回“返回值”,可以将其赋给其它变量作其它的用处。所有函数都有返回值,如果没有return语句,会隐式地调用returnNone作为返回值。python函数使用return语句返回"返回值",可以将其赋给其它变量作其它的用处。所有函数都有返回值,如果没有return语句,会隐式地调用returnNone作为返回值。一个函数可以存在多条return语句,但只有一条

- Python星球日记 - 第8天:函数基础

Code_流苏

Python星球日记python函数def关键字函数参数返回值

引言:上一篇:Python星球日记-第7天:字典与集合名人说:路漫漫其修远兮,吾将上下而求索。——屈原《离骚》创作者:Code_流苏(CSDN)(一个喜欢古诗词和编程的Coder)目录一、函数的定义与调用1.什么是函数?2.如何定义函数-`def`关键字3.函数调用方式二、参数与返回值1.函数参数类型2.如何传递参数3.返回值和`return`语句三、局部变量与全局变量1.变量作用域概念2.局部变

- 华为OD机试2025C卷 - 小明的幸运数 (C++ & Python & JAVA & JS & GO)

无限码力

华为od华为OD机试2025C卷华为OD2025C卷华为OD机考2025C卷

小明的幸运数华为OD机试真题目录点击查看:华为OD机试2025C卷真题题库目录|机考题库+算法考点详解华为OD机试2025C卷100分题型题目描述小明在玩一个游戏,游戏规则如下:在游戏开始前,小明站在坐标轴原点处(坐标值为0).给定一组指令和一个幸运数,每个指令都是一个整数,小明按照指令前进指定步数或者后退指定步数。前进代表朝坐标轴的正方向走,后退代表朝坐标轴的负方向走。幸运数为一个整数,如果某个

- Python 函数返回值

落花雨时

Python基础

#返回值,返回值就是函数执行以后返回的结果#可以通过return来指定函数的返回值#可以之间使用函数的返回值,也可以通过一个变量来接收函数的返回值defsum(*nums):#定义一个变量,来保存结果result=0#遍历元组,并将元组中的数进行累加forninnums:result+=nprint(result)#sum(123,456,789)#return后边跟什么值,函数就会返回什么值#r

- 存档python爬虫、Web学习资料

1python爬虫学习学习Python爬虫是个不错的选择,它能够帮你高效地获取网络数据。下面为你提供系统化的学习路径和建议:1.打好基础首先要掌握Python基础知识,这是学习爬虫的前提。比如:变量、数据类型、条件语句、循环等基础语法。列表、字典等常用数据结构的操作。函数、模块和包的使用方法。文件读写操作。推荐通过阅读《Python编程:从入门到实践》这本书或者在Codecademy、LeetCo

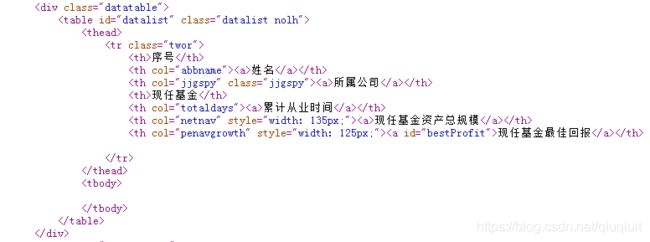

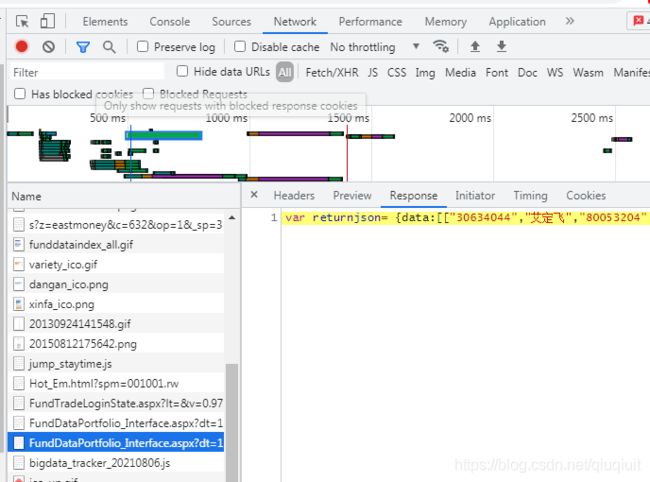

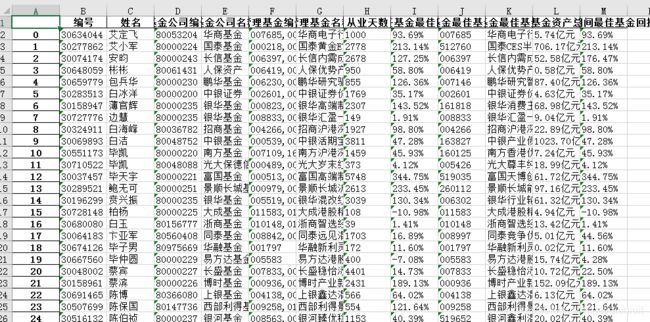

- Python爬虫入门到实战(3)-对网页进行操作

荼蘼

爬虫

一.获取和操作网页元素1.获取网页中的指定元素tag_name()方法:获取元素名称。text()方法:获取元素文本内容。click()方法():点击此元素。submit()方法():提交表单。send_keys()方法:模拟输入信息。size()方法:获取元素的尺寸可进入selenium库文件夹下的webdriver\remote\webelement.py中查看更多的操作方法,2.在元素中输入

- 华为OD 机试 2025 B卷 - 周末爬山 (C++ & Python & JAVA & JS & GO)

无限码力

华为OD机试真题刷题笔记华为od华为OD2025B卷华为OD机考2025B卷华为OD机试2025B卷华为OD机试

周末爬山华为OD机试真题目录点击查看:华为OD机试2025B卷真题题库目录|机考题库+算法考点详解华为OD机试2025B卷200分题型题目描述周末小明准备去爬山锻炼,0代表平地,山的高度使用1到9来表示,小明每次爬山或下山高度只能相差k及k以内,每次只能上下左右一个方向上移动一格,小明从左上角(0,0)位置出发输入描述第一行输入mnk(空格分隔)。代表m*n的二维山地图,k为小明每次爬山或下山高度

- Python,C++,Go开发芯片电路设计APP

Geeker-2025

pythonc++golang

#芯片电路设计APP-Python/C++/Go综合开发方案##系统架构设计```mermaidgraphTDA[Web前端]-->B(Python设计界面)B-->C(GoAPI网关)C-->D[C++核心引擎]D-->E[硬件加速]F[数据库]-->CG[EDA工具链]-->DH[云服务]-->C```##技术栈分工|技术|应用领域|优势||------|----------|------||

- 红队测试-代理和中间人攻击工具

小浪崇礼

BetterCAP-Modular,portableandeasilyextensibleMITMframework.Ettercap-Comprehensive,maturesuiteformachine-in-the-middleattacks.Habu-Pythonutilityimplementingavarietyofnetworkattacks,suchasARPpoisoning,D

- pyside6使用1 窗体、信号和槽

一、概要由于作者前期很多年都在使用C++和Qt框架进行项目的开发工作,故可以熟练的使用Qt框架。Qt框架在界面设计以及跨平台运用方面,有着巨大的优势,而界面设计恰恰是python的短板,故使用pyside6实现python和Qt的互补。1.1pyside6安装更新pip工具:pipinstall--upgradepip命令行执行如下指令:pipinstallpyside6-ihttps://pyp

- python-读写mysql(操作mysql数据库)

importpymysqlimportpandasaspdimporttimeonly_time=time.localtime(time.time())time_now=time.strftime('%Y-%m-%d%H:%M:%S',only_time)dt=time.strftime('%Y%m%d',only_time)t=time.time()tt=int(t)parentId=''sta

- python读写mysql

cavin_2017

Python学习

目前用到的连接数据库,主要实现连个功能:1.根据sql查询2.将dataframe数据通过pandas包写入mysql数据库中1.根据sql查询:通常我们通过sql查询mysql中的表,分三步1.连接数据库2.数据查询3.关闭连接,如果需要查询的步骤较多,将查询封装成函数,通过参数传递sql代码会省事很多。##定义连接数据库函数defmy_db(host,user,passwd,db,sql,po

- python+playwright 学习-91 cookies的获取保存删除相关操作

上海-悠悠

playwrightpython

前言playwright可以获取浏览器缓存的cookie信息,可以将这些cookies信息保存到本地,还可以加载本地cookies。获取cookies相关操作在登录前和登录后分别打印cookies信息,对比查看是否获取成功。fromplaywright.sync_apiimportsync_playwrightwithsync_playwright()asp:browser=p.chromium.

- Python——登录后获取cookie访问页面

尖叫的太阳

importrequestsurl="https://kyfw.12306.cn/otn/view/index.html"#网址首页https://kyfw.12306.cn/otn/view/index.html的cookieheaders={'User-Agent':'Mozilla/5.0(WindowsNT6.1;Win64;x64)','Cookie':'JSESSIONID=3330D

- python request 获取cookies value值的方法

dianqianwei8752

pythonc/c++

importrequestsres=requests.get(url)cookies=requests.utils.dict_from_cookiejar(res.cookies)print(cookies[key])转载于:https://www.cnblogs.com/VseYoung/p/python_cookies.html

- python连接达梦数据库方式

water bucket

python数据库pandas

1、通过jaydebeapi调用jdbcimportpandasaspdimportjaydebeapiif__name__=='__main__':url='jdbc:dm://{IP}:{PORT}/{库名}'username='{username}'password='{password}'jclassname='dm.jdbc.driver.DmDriver'jarFile='{DmJdb

- Python一次性批量下载网页内所有链接

Zhy_Tech

python前端开发语言

需要下载一个数据集,该数据集每一张图对应网页内一条链接,如下图所示。一开始尝试使用迅雷,但是迅雷一次性只能下载30条链接。采用Python成功实现一次性批量下载。importosimportrequestsfrombs4importBeautifulSoup#目标网页的URLurl="https://"#请将此处替换为实际的网页URL#指定下载文件的文件夹路径#使用原始字符串download_fo

- 初探贪心算法 -- 使用最少纸币组成指定金额

是小V呀

C++贪心算法算法c++python

python实现:#对于任意钱数,求最少张数n=int(input("money:"))#输入钱数bills=[100,50,20,10,5,2,1]#纸币面额种类total=0forbinbills:count=n//b#整除面额求用的纸币张数ifcount>0:print(f"{b}纸币张数{count}")n-=count*b#更新剩余金额total+=count#累加纸币数量print(f

- 【Python】Gym 库:于开发和比较强化学习(Reinforcement Learning, RL)算法

彬彬侠

Python基础pythonGym强化学习RLGymnasium

Gym是Python中一个广泛使用的开源库,用于开发和比较强化学习(ReinforcementLearning,RL)算法。它最初由OpenAI开发,提供标准化的环境接口,允许开发者在各种任务(如游戏、机器人控制、模拟物理系统)中测试RL算法。Gym的设计简单且灵活,适合学术研究和工业应用。2022年,Gym被整合到Gymnasium(由FaramaFoundation维护)中,成为主流的强化学习

- Python 虚拟环境完全指南

wsj__WSJ

pythonpython开发语言

为何离不开虚拟环境?在Python开发领域,虚拟环境堪称管理项目依赖的不二利器,其重要性体现在多个关键层面:项目隔离独立运行环境构建:为每一个项目量身打造专属的Python运行环境,使各个项目之间相互隔离,互不干扰。化解依赖版本冲突:有效解决不同项目对同一依赖包的版本需求不一致的难题。例如,项目A基于Django3.2进行开发,而项目B需要Django4.0才能正常运作,通过虚拟环境,两者可并行不

- python学习路线(从菜鸟到起飞)

突突突然不会编了

python学习开发语言

以下是基于2025年最新技术趋势的Python学习路线,综合多个权威资源整理而成,涵盖从零基础到进阶应用的全流程,适合不同学习目标(如Web开发、数据分析、人工智能等)的学习者。路线分为基础、进阶、实战、高级、方向拓展五个阶段,并附学习资源推荐:一、基础阶段(1-2个月)目标:掌握Python核心语法与编程思维,熟悉开发环境。环境搭建安装Python3.10+,配置PyCharm或VSCode开发

- 小白带你部署LNMP分布式部署

刘俊涛liu

分布式

目录前言一、概述二、LNMP环境部署三、配置nginx1、yum安装2、编译安装四、安装1、编译安装nginx2、网络源3、稍作优化4、修改配置文件vim/usr/local/nginx/conf/nginx.conf5、书写测试页面五、部署应用前言LNMP平台指的是将Linux、Nginx、MySQL和PHP(或者其他的编程语言,如Python、Perl等)集成在一起的一种Web服务器环境。它是

- 如何构建FunASR的本地语音识别服务

FunASR简介FunASR是阿里巴巴达摩院开源的高性能语音识别工具包,支持离线识别和实时流式识别两种模式。其核心特点包括:支持多种语音任务:ASR(自动语音识别)、VAD(语音活动检测)、标点恢复、关键词检测等。提供预训练模型:覆盖中文、英文等多语言,支持不同场景(通用、会议、直播等)。支持多种部署方式:本地Python、Docker容器、ONNX推理优化等。开源地址:GitHub-FunASR

- Python 进阶学习之全栈开发学习路线

Microi风闲

【胶水语言】Pythonpython学习开发语言

文章目录前言一、Python全栈开发技术栈1.前端技术选型2.后端框架选择3.数据库访问二、开发环境配置1.工具链推荐2.VSCode终极配置3.项目依赖管理三、现代Python工程实践1.项目结构规范2.自动化测试策略3.CI/CD流水线四、部署策略大全1.传统服务器部署2.容器化部署3.无服务器部署五、性能优化技巧1.数据库优化2.异步处理3.静态资源优化结语前言Python作为当今最流行的编

- Pycharm下载链接

Aderic

杂陈

人生苦短,我用python3.4https://download.jetbrains.8686c.com/python/pycharm-community-2018.1.1.tar.gz后续更新可能就是后面版本号码稍微差异,mark!

- ztree设置禁用节点

3213213333332132

JavaScriptztreejsonsetDisabledNodeAjax

ztree设置禁用节点的时候注意,当使用ajax后台请求数据,必须要设置为同步获取数据,否者会获取不到节点对象,导致设置禁用没有效果。

$(function(){

showTree();

setDisabledNode();

});

- JVM patch by Taobao

bookjovi

javaHotSpot

在网上无意中看到淘宝提交的hotspot patch,共四个,有意思,记录一下。

7050685:jsdbproc64.sh has a typo in the package name

7058036:FieldsAllocationStyle=2 does not work in 32-bit VM

7060619:C1 should respect inline and

- 将session存储到数据库中

dcj3sjt126com

sqlPHPsession

CREATE TABLE sessions (

id CHAR(32) NOT NULL,

data TEXT,

last_accessed TIMESTAMP NOT NULL,

PRIMARY KEY (id)

);

<?php

/**

* Created by PhpStorm.

* User: michaeldu

* Date

- Vector

171815164

vector

public Vector<CartProduct> delCart(Vector<CartProduct> cart, String id) {

for (int i = 0; i < cart.size(); i++) {

if (cart.get(i).getId().equals(id)) {

cart.remove(i);

- 各连接池配置参数比较

g21121

连接池

排版真心费劲,大家凑合看下吧,见谅~

Druid

DBCP

C3P0

Proxool

数据库用户名称 Username Username User

数据库密码 Password Password Password

驱动名

- [简单]mybatis insert语句添加动态字段

53873039oycg

mybatis

mysql数据库,id自增,配置如下:

<insert id="saveTestTb" useGeneratedKeys="true" keyProperty="id"

parameterType=&

- struts2拦截器配置

云端月影

struts2拦截器

struts2拦截器interceptor的三种配置方法

方法1. 普通配置法

<struts>

<package name="struts2" extends="struts-default">

&

- IE中页面不居中,火狐谷歌等正常

aijuans

IE中页面不居中

问题是首页在火狐、谷歌、所有IE中正常显示,列表页的页面在火狐谷歌中正常,在IE6、7、8中都不中,觉得可能那个地方设置的让IE系列都不认识,仔细查看后发现,列表页中没写HTML模板部分没有添加DTD定义,就是<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3

- String,int,Integer,char 几个类型常见转换

antonyup_2006

htmlsql.net

如何将字串 String 转换成整数 int?

int i = Integer.valueOf(my_str).intValue();

int i=Integer.parseInt(str);

如何将字串 String 转换成Integer ?

Integer integer=Integer.valueOf(str);

如何将整数 int 转换成字串 String ?

1.

- PL/SQL的游标类型

百合不是茶

显示游标(静态游标)隐式游标游标的更新和删除%rowtyperef游标(动态游标)

游标是oracle中的一个结果集,用于存放查询的结果;

PL/SQL中游标的声明;

1,声明游标

2,打开游标(默认是关闭的);

3,提取数据

4,关闭游标

注意的要点:游标必须声明在declare中,使用open打开游标,fetch取游标中的数据,close关闭游标

隐式游标:主要是对DML数据的操作隐

- JUnit4中@AfterClass @BeforeClass @after @before的区别对比

bijian1013

JUnit4单元测试

一.基础知识

JUnit4使用Java5中的注解(annotation),以下是JUnit4常用的几个annotation: @Before:初始化方法 对于每一个测试方法都要执行一次(注意与BeforeClass区别,后者是对于所有方法执行一次)@After:释放资源 对于每一个测试方法都要执行一次(注意与AfterClass区别,后者是对于所有方法执行一次

- 精通Oracle10编程SQL(12)开发包

bijian1013

oracle数据库plsql

/*

*开发包

*包用于逻辑组合相关的PL/SQL类型(例如TABLE类型和RECORD类型)、PL/SQL项(例如游标和游标变量)和PL/SQL子程序(例如过程和函数)

*/

--包用于逻辑组合相关的PL/SQL类型、项和子程序,它由包规范和包体两部分组成

--建立包规范:包规范实际是包与应用程序之间的接口,它用于定义包的公用组件,包括常量、变量、游标、过程和函数等

--在包规

- 【EhCache二】ehcache.xml配置详解

bit1129

ehcache.xml

在ehcache官网上找了多次,终于找到ehcache.xml配置元素和属性的含义说明文档了,这个文档包含在ehcache.xml的注释中!

ehcache.xml : http://ehcache.org/ehcache.xml

ehcache.xsd : http://ehcache.org/ehcache.xsd

ehcache配置文件的根元素是ehcahe

ehcac

- java.lang.ClassNotFoundException: org.springframework.web.context.ContextLoaderL

白糖_

javaeclipsespringtomcatWeb

今天学习spring+cxf的时候遇到一个问题:在web.xml中配置了spring的上下文监听器:

<listener>

<listener-class>org.springframework.web.context.ContextLoaderListener</listener-class>

</listener>

随后启动

- angular.element

boyitech

AngularJSAngularJS APIangular.element

angular.element

描述: 包裹着一部分DOM element或者是HTML字符串,把它作为一个jQuery元素来处理。(类似于jQuery的选择器啦) 如果jQuery被引入了,则angular.element就可以看作是jQuery选择器,选择的对象可以使用jQuery的函数;如果jQuery不可用,angular.e

- java-给定两个已排序序列,找出共同的元素。

bylijinnan

java

import java.util.ArrayList;

import java.util.Arrays;

import java.util.List;

public class CommonItemInTwoSortedArray {

/**

* 题目:给定两个已排序序列,找出共同的元素。

* 1.定义两个指针分别指向序列的开始。

* 如果指向的两个元素

- sftp 异常,有遇到的吗?求解

Chen.H

javajcraftauthjschjschexception

com.jcraft.jsch.JSchException: Auth cancel

at com.jcraft.jsch.Session.connect(Session.java:460)

at com.jcraft.jsch.Session.connect(Session.java:154)

at cn.vivame.util.ftp.SftpServerAccess.connec

- [生物智能与人工智能]神经元中的电化学结构代表什么?

comsci

人工智能

我这里做一个大胆的猜想,生物神经网络中的神经元中包含着一些化学和类似电路的结构,这些结构通常用来扮演类似我们在拓扑分析系统中的节点嵌入方程一样,使得我们的神经网络产生智能判断的能力,而这些嵌入到节点中的方程同时也扮演着"经验"的角色....

我们可以尝试一下...在某些神经

- 通过LAC和CID获取经纬度信息

dai_lm

laccid

方法1:

用浏览器打开http://www.minigps.net/cellsearch.html,然后输入lac和cid信息(mcc和mnc可以填0),如果数据正确就可以获得相应的经纬度

方法2:

发送HTTP请求到http://www.open-electronics.org/celltrack/cell.php?hex=0&lac=<lac>&cid=&

- JAVA的困难分析

datamachine

java

前段时间转了一篇SQL的文章(http://datamachine.iteye.com/blog/1971896),文章不复杂,但思想深刻,就顺便思考了一下java的不足,当砖头丢出来,希望引点和田玉。

-----------------------------------------------------------------------------------------

- 小学5年级英语单词背诵第二课

dcj3sjt126com

englishword

money 钱

paper 纸

speak 讲,说

tell 告诉

remember 记得,想起

knock 敲,击,打

question 问题

number 数字,号码

learn 学会,学习

street 街道

carry 搬运,携带

send 发送,邮寄,发射

must 必须

light 灯,光线,轻的

front

- linux下面没有tree命令

dcj3sjt126com

linux

centos p安装

yum -y install tree

mac os安装

brew install tree

首先来看tree的用法

tree 中文解释:tree

功能说明:以树状图列出目录的内容。

语 法:tree [-aACdDfFgilnNpqstux][-I <范本样式>][-P <范本样式

- Map迭代方式,Map迭代,Map循环

蕃薯耀

Map循环Map迭代Map迭代方式

Map迭代方式,Map迭代,Map循环

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 2015年

- Spring Cache注解+Redis

hanqunfeng

spring

Spring3.1 Cache注解

依赖jar包:

<!-- redis -->

<dependency>

<groupId>org.springframework.data</groupId>

<artifactId>spring-data-redis</artifactId>

- Guava中针对集合的 filter和过滤功能

jackyrong

filter

在guava库中,自带了过滤器(filter)的功能,可以用来对collection 进行过滤,先看例子:

@Test

public void whenFilterWithIterables_thenFiltered() {

List<String> names = Lists.newArrayList("John"

- 学习编程那点事

lampcy

编程androidPHPhtml5

一年前的夏天,我还在纠结要不要改行,要不要去学php?能学到真本事吗?改行能成功吗?太多的问题,我终于不顾一切,下定决心,辞去了工作,来到传说中的帝都。老师给的乘车方式还算有效,很顺利的就到了学校,赶巧了,正好学校搬到了新校区。先安顿了下来,过了个轻松的周末,第一次到帝都,逛逛吧!

接下来的周一,是我噩梦的开始,学习内容对我这个零基础的人来说,除了勉强完成老师布置的作业外,我已经没有时间和精力去

- 架构师之流处理---------bytebuffer的mark,limit和flip

nannan408

ByteBuffer

1.前言。

如题,limit其实就是可以读取的字节长度的意思,flip是清空的意思,mark是标记的意思 。

2.例子.

例子代码:

String str = "helloWorld";

ByteBuffer buff = ByteBuffer.wrap(str.getBytes());

Sy

- org.apache.el.parser.ParseException: Encountered " ":" ": "" at line 1, column 1

Everyday都不同

$转义el表达式

最近在做Highcharts的过程中,在写js时,出现了以下异常:

严重: Servlet.service() for servlet jsp threw exception

org.apache.el.parser.ParseException: Encountered " ":" ": "" at line 1,

- 用Java实现发送邮件到163

tntxia

java实现

/*

在java版经常看到有人问如何用javamail发送邮件?如何接收邮件?如何访问多个文件夹等。问题零散,而历史的回复早已经淹没在问题的海洋之中。

本人之前所做过一个java项目,其中包含有WebMail功能,当初为用java实现而对javamail摸索了一段时间,总算有点收获。看到论坛中的经常有此方面的问题,因此把我的一些经验帖出来,希望对大家有些帮助。

此篇仅介绍用

- 探索实体类存在的真正意义

java小叶檀

POJO

一. 实体类简述

实体类其实就是俗称的POJO,这种类一般不实现特殊框架下的接口,在程序中仅作为数据容器用来持久化存储数据用的

POJO(Plain Old Java Objects)简单的Java对象

它的一般格式就是

public class A{

private String id;

public Str