论文阅读“Graph Contrastive Clustering”(ICCV2021)

论文标题

论文作者、链接

作者:Zhong, Huasong and Wu, Jianlong and Chen, Chong and Huang, Jianqiang and Deng, Minghua and Nie, Liqiang and Lin, Zhouchen and Hua, Xian-Sheng

链接:ICCV 2021 Open Access Repository

代码:GitHub - mynameischaos/GCC: Graph Contrastive Clustering (ICCV2021)

Introduction逻辑

论文动机&现有工作存在的问题

有监督的学习需要标签,这意味着需要大量人力去标注

聚类作为无监督学习不需要标签,但是有两个明显的缺点1.对特征无区别2.特征提取和聚类过程分离导致次优解

现有模型学到的特征区别度不够高,没有将潜在的类别信息加入模型

论文核心创新点

假设一个簇中的样本及其增广样本,应该共享相似的特征表示和聚类分配

构造一个基于当前特征的相似图,然后将其应用于表示学习和聚类学习

考虑了潜在类别信息

将图对比学习框架应用于聚类任务设计了GCC,提出 拉普拉斯图对比损失 the graph Laplacian based contrastive loss

相关工作

深度聚类

对比学习

论文方法

一组无标签图片集![]() ,有K个类别

,有K个类别

学习一个映射函数![]() 参数为

参数为![]() ,将图片

,将图片![]() 映射到

映射到![]() ,其中

,其中![]() 是d维的特征向量,并且有

是d维的特征向量,并且有 约束,然后

约束,然后![]() 是K维的概率分布,满足

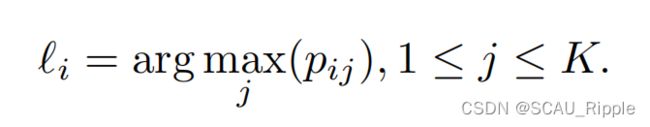

是K维的概率分布,满足 ,也就是分配给所有簇的概率之和为1。根据下列公式计算簇的分配

,也就是分配给所有簇的概率之和为1。根据下列公式计算簇的分配

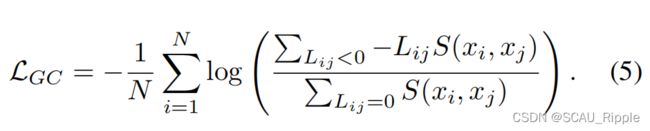

图对比 Graph Contrastive (GC)

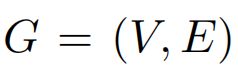

将![]() 定义为

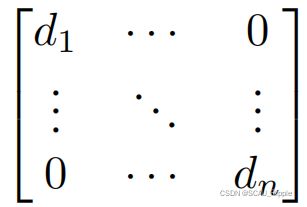

定义为![]() 的阶数,则有D矩阵为:

的阶数,则有D矩阵为:

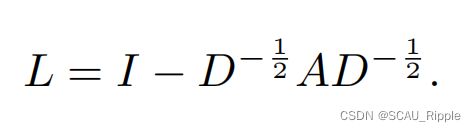

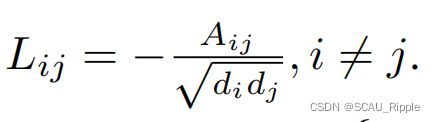

则G的归一化对称图拉普拉斯算子可定义为:

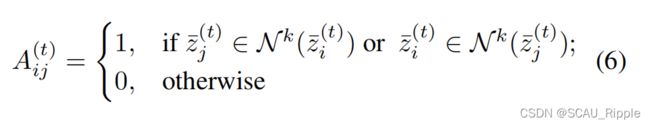

对于N个特征![]() ,在2范数的约束下,如果i与j的领接矩阵

,在2范数的约束下,如果i与j的领接矩阵![]() 则

则![]() 与

与![]() 应该尽量靠近,如果

应该尽量靠近,如果![]() 则远离。假设图可以被划分为几个区,则同一个区中的特征表示的相似性应该比区之间的相似性大,即同区内的特征相似性比区之间大。有如下定义

则远离。假设图可以被划分为几个区,则同一个区中的特征表示的相似性应该比区之间的相似性大,即同区内的特征相似性比区之间大。有如下定义

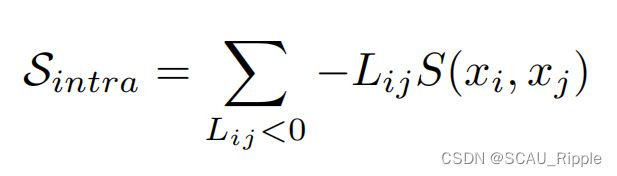

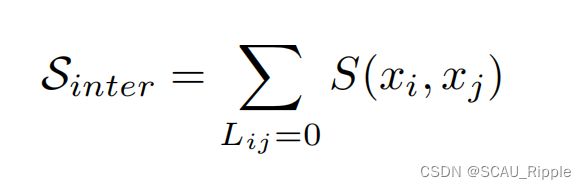

则一个区内的相似性总和为

对  进行最小化,可以使得网络同时增大区内相似性并且减小区间相似性

进行最小化,可以使得网络同时增大区内相似性并且减小区间相似性

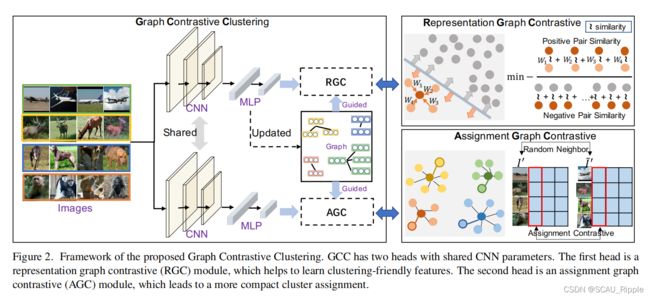

图对比聚类 Graph Contrastive Clustering(GCC)

图特征对比representation graph contrastive (RGC),基于图特征对比学习,学习聚类友好特征。

图分配对比assignment graph contrastive (AGC),利用聚类级图对比学习实现最后的聚类分配。

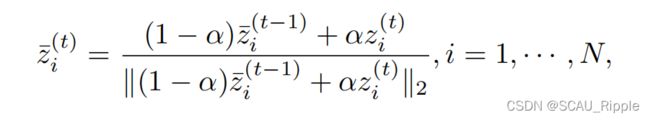

在构造图之前,利用移动平均移动来减少模型波动带来的特征学习偏差

代表模型,并且

代表模型,并且![]() 代表第t个epoch学到的特征表示,则特征表示的平均移动定义为:

代表第t个epoch学到的特征表示,则特征表示的平均移动定义为:

用下公式来构建KNN图

其中![]() 。由此可以得到归一化的拉普拉斯算子

。由此可以得到归一化的拉普拉斯算子![]()

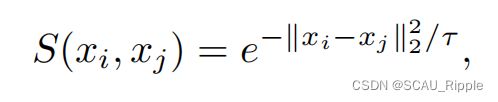

相似函数

使用谱聚类中常用的高斯核函数Gaussian kernel function,来计算两个样本中的相似性

其中![]() 表示方差或者是温度参数。

表示方差或者是温度参数。

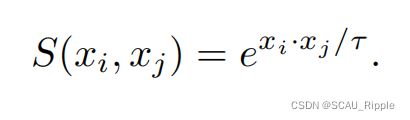

因为有![]()

于是相似函数由上式变成下式

图表示对比

假设有一组经过随机数据增广的图片组![]() ,并且其对应的特征为

,并且其对应的特征为![]() 。根据之前提到的,如果两点在图谱中是相连的,那么

。根据之前提到的,如果两点在图谱中是相连的,那么![]() 和

和![]() 应该尽可能相似

应该尽可能相似

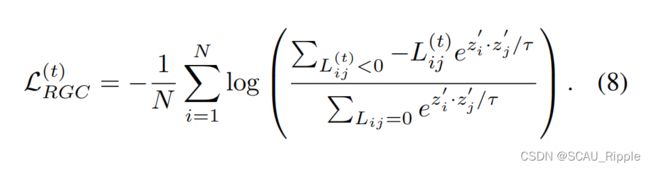

在公式(5)中,令![]() ,则得到RGC的损失函数

,则得到RGC的损失函数

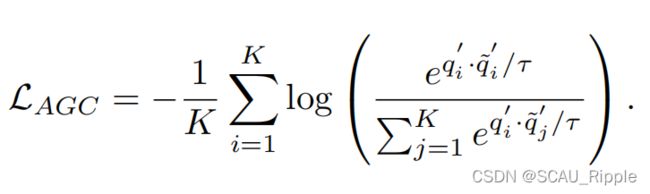

图分配对比

传统的基于聚类的对比学习,图片和它们的增广结果应该尽可能分配到同一个簇中。在模型学习的过程中,图片及其邻居将会有高置信度的簇分配结果。

假设有一组经过随机数据增广的图片组![]() ,并且

,并且![]() 满足

满足![]() 是根据图

是根据图![]() 随机选择的一个邻居

随机选择的一个邻居![]() 。则对于

。则对于![]() 和

和![]() 的概率分配矩阵为

的概率分配矩阵为

那么,![]() 和

和![]() 表示

表示![]() 和

和![]() 中的哪一张图片将会被分配给第i个簇,则AGC的损失函数定义为

中的哪一张图片将会被分配给第i个簇,则AGC的损失函数定义为

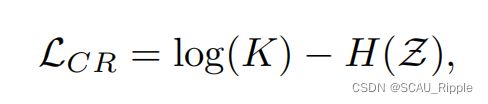

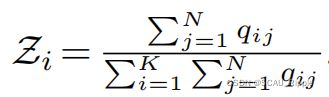

聚类正则化损失

为了防止将所有的样本分配给同一个簇,则需要进行聚类正则化,有

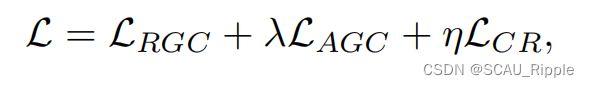

全局损失函数为

其中![]() 和

和![]() 是超参

是超参

算法流程

消融实验设计

图表对比损失的影响

聚类正则化损失的影响

自标签精调的影响

一句话总结

从图谱的内部关系入手,设计了对比学习模型,主要分为两部分:图的邻接关系以及聚类结果