原文地址: VSLAM(1)视觉SLAM的发展现状

01 VSLAM中常用的传感器

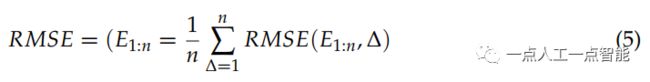

VSLAM中使用的传感器通常包括单目相机、立体相机和RGB-D相机。单目相机和立体相机具有相似的原理,可用于各种室内和室外环境。RGB-D相机作为一种特殊形式的相机,主要通过主动发射红外结构光或计算飞行时间(TOF)来直接获得图像深度。它使用方便,但对光线敏感,大多数情况下只能在室内使用。事件相机作为近年来出现的一种新型相机传感器,可以获取到不同于传统相机的图像。事件相机是“事件”,可以简单到“像素亮度变化”。事件相机输出的变化是像素亮度,基于事件相机的SLAM算法仍处于初步研究阶段。此外,作为一种基于视觉的经典SLAM系统,视觉惯性融合在许多方面都取得了优异的效果。在图1中,我们比较了不同相机的主要功能。

图1 不同相机之间的比较。事件相机不是特定类型的相机,而是可以获取“事件信息”的相机。“传统相机”以恒定的频率工作,并具有明显的缺点,如拍摄高速物体时的迟滞、模糊和过度曝光。然而,事件摄像机,作为一种类似于人眼的基于神经的信息处理方法,并没有这些问题。

02 评估工具和数据集

SLAM问题已经存在了几十年。在过去的几十年中,出现了许多优秀的算法,尽管关注点不同,但每一种算法都在不同程度上促进了SLAM技术的快速发展。一般来说,我们可以从时耗、复杂性和准确性等多个角度评估SLAM算法。不过,我们最关注它的准确性。

ATE(绝对轨迹误差)和RPE(相对姿态误差)是用于评估SLAM精度的两个最重要的指标。

相对姿态误差(RPE)用于计算相同的两个时间戳中姿态变化的差异,适用于估计系统漂移。

绝对轨迹误差(ATE)直接计算相机姿态的实际值与SLAM系统的估计值之间的差。ATE和RPE的基本原理如下:假设:给定的姿势估计值为\(\Delta \) 。下标表示时间t(或帧),其中假设估计姿势的每一帧的时间与真实姿势对齐,并且总帧数相同。

ATE:绝对轨迹误差是估计姿态和真实姿态之间的直接差异,它可以直接反映算法的精度和全局轨迹一致性。需要注意的是,估计姿态和地面真实度通常不在同一坐标系中,因此我们需要首先对它们进行配对:对于立体SLAM和RGB-D SLAM,尺度是均匀的,因此我们必须通过最小二乘法\(S\in SE(3) \)计算从估计姿态到真实姿态的变换矩阵。对于具有尺度不确定性的单目相机,我们需要计算从估计姿态到真实姿态的类似变换矩阵\( S\in Sim(3)\)。因此,帧i的ATE定义如下:

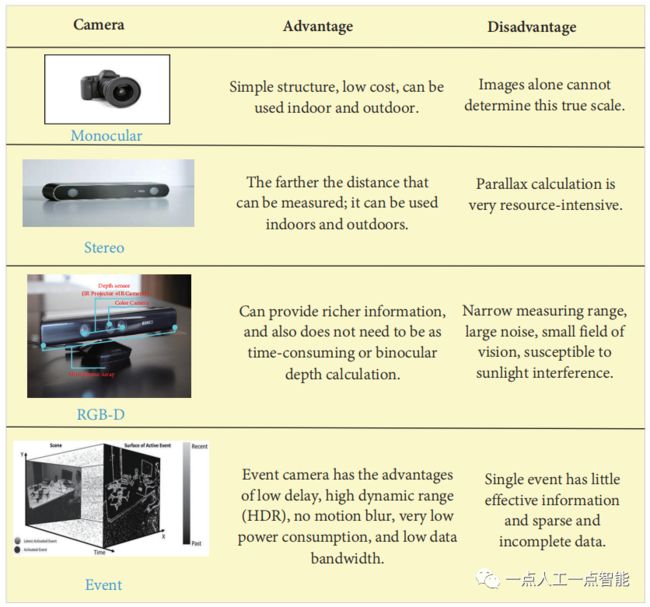

RPE:相对姿态误差主要描述由固定时间差\(\Delta \)分隔的两个帧的精度(与真实姿态相比),这相当于直接测量的里程计的误差。因此,帧I的RPE定义如下:

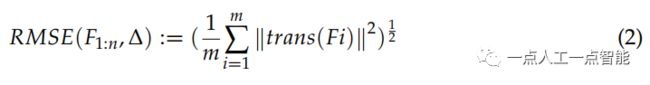

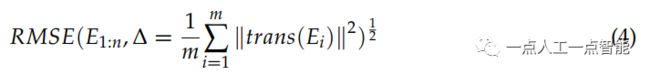

给定总数n和间隔\(\Delta \),我们可以获得\((m=n-\Delta) \)RPE。然后我们可以使用均方根误差RMSE来计算该误差,并获得总体值:

\(trans(E_i)\)表示相对姿态误差的平移部分。我们可以从RMSE值的大小来评估算法的性能。然而,在实践中,我们发现对于\(\Delta \)可以有很多选择。为了全面衡量算法的性能,我们可以遍历计算所有\(\Delta \)的平均RMSE:

EVO是一个SLAM系统评估的Python工具包,可用于各种数据集。它除了ATE和RPE,还可以获得数据,还可以绘制测试算法和实际轨迹的比较图,是一个非常方便的评估工具包。

SLAMBench2是一个公开可用的软件框架,通过可扩展的数据集列表评估当前和未来的SLAM系统。它包括开源和闭源的源代码,同时使用可比较和指定的性能指标列表。它支持多种现有SLAM算法和数据集,如ElasticFusion、ORB-SLAM2和OKVIS,集成新的SLAM算法与数据集非常简单。

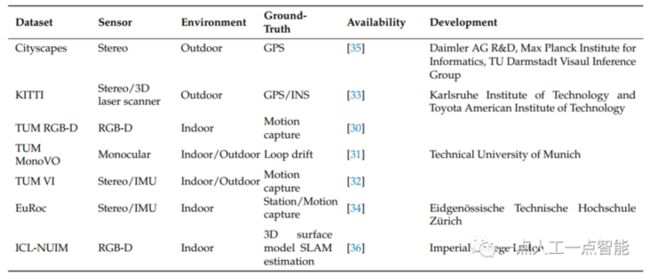

此外,我们还需要使用数据集来测试算法的特定可视化。用于测试SLAM性能各个方面的通用数据集如表1所示。

TUM数据集主要包括多视图数据集、3D目标识别和分割、场景识别、3D模型匹配、VSALM以及各个方向的其他数据。根据应用方向,可分为TUM RGB-D、TUM MonoVO和TUM VI。其中,TUM RGB-D数据集主要包含具有真实地面轨迹的室内图像。此外,它还提供了两种评估轨道局部精度和全局一致性的方法,即相对姿态误差和绝对轨迹误差。TUM MonoVO用于评估包含室内和室外图像的单目系统。由于场景的多样性,地面真实性不可用,但执行了具有相同起始位置的大型序列,从而可以评估循环漂移(cyclic drift)。TUM VI用于视觉惯性里程计的评估。KITTI数据集是卡尔斯鲁厄理工学院和丰田美国理工学院联合创建的著名户外环境数据集。它是世界上自动驾驶场景下最大的计算机视觉算法评估数据集,包括单目视觉、双目视觉、Velodyne激光雷达、POS轨迹等。它是使用最广泛的户外数据集。EuRoc数据集是苏黎世ETH开发的视觉惯性数据集。Cityscape是一个与自动驾驶相关的数据集,专注于像素级场景分割和实例标注。此外,许多数据集用于各种场景,如ICL-NUIM、NYU RGB-D、MS COCO等。

03 基于文献数据的SLAM发展分析

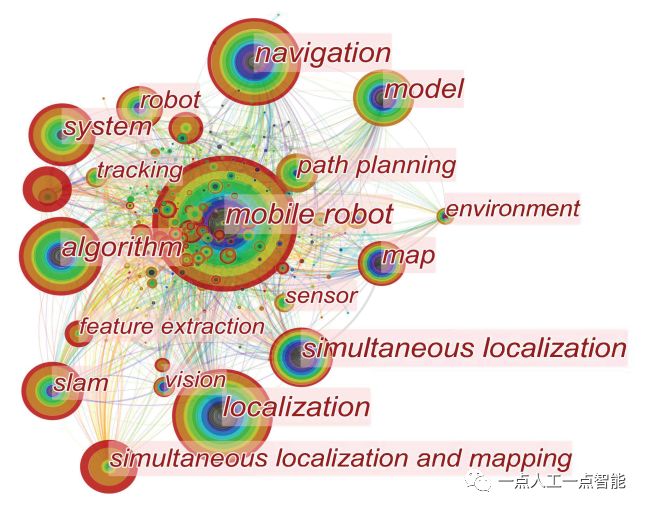

自SLAM问世以来,它已广泛应用于机器人领域。如图2所示,本文选择了过去二十年中与移动机器人相关的近1000篇热门文章,并制作了该关键词热图。圆圈越大,关键字出现的频率越高。圆圈层从内到外显示从过去到现在的时间,颜色越红,越吸引人。连接线表示不同关键词之间存在联系(数据来自科学核心网)。

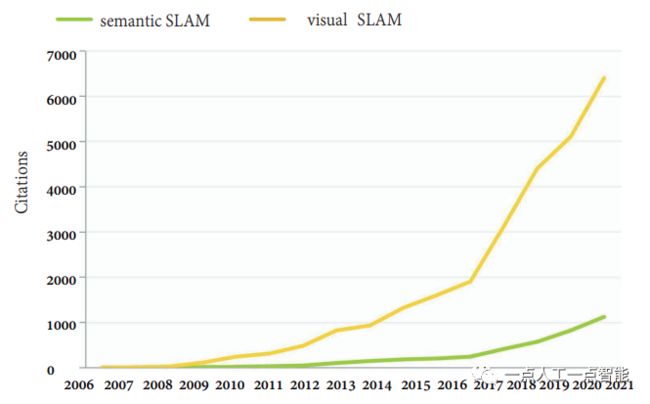

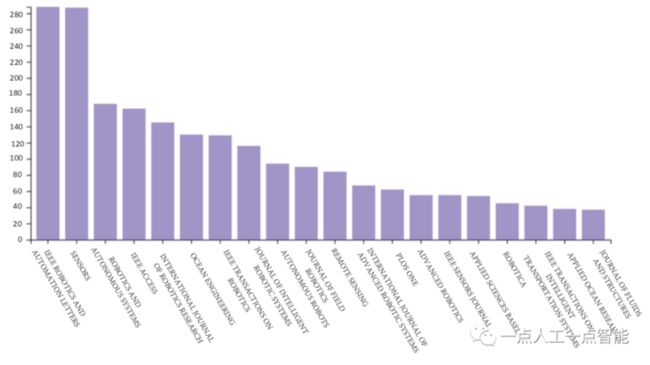

如图3所示,视觉SLAM和语义SLAM相关论文的引用数量正在快速增加。尤其是在2017年前后,视觉SLAM和语义SLAM的引用量激增。传统的VSLAM研究取得了许多进展。为了使机器人能够从更高的层次感知周围环境,语义VSLAM的研究受到了广泛的关注。此外,如图4所示,本文从Web of Science核心集合中选择了大约5000篇文章。从发表的关于SLAM的期刊标题来看,SLAM是机器人学的一个热门话题。

图2 移动机器人领域的热词

图3 最近几年有关可视化SLAM和语义SLAM的科学网文章的引文(数据截至2021年12月)。

图4 科学网关于SLAM的出版物标题

04 杰出学者和团队

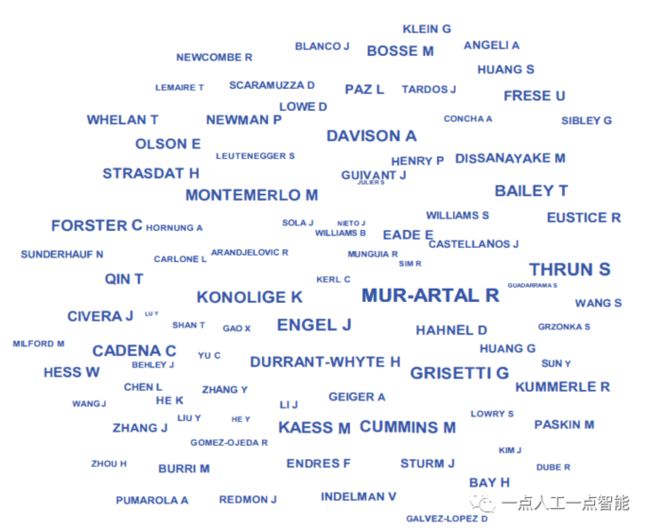

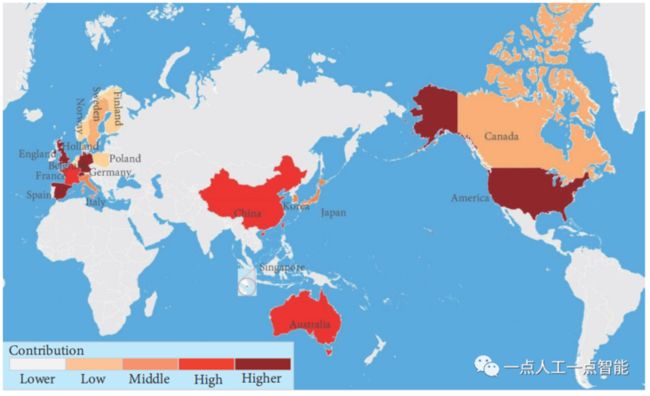

此外,许多学者和团队为SLAM的研究做出了不可磨灭的贡献。如图5所示,我们分析了2000年至2022年的约4000篇文章(数据来自科学网网站)。字体越大表示作者受到的关注最多,反之亦然。它们所属的国家如图6所示。

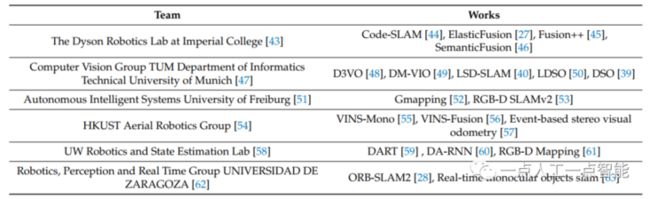

德国慕尼黑工业大学的计算机视觉小组是这一领域的领导者。该团队发布了多种经典的视觉SLAM解决方案,如DSO和LSD-SLAM,这些解决方案提高了视觉SLAM的各个方面的性能。瑞士苏黎世大学的机器人和感知小组也通过开发SVO和VO/VIO轨迹评估工具,为SLAM技术的快速发展做出了贡献。此外,苏黎世联邦理工学院计算机视觉与集成实验室也在这一领域做出了大量努力。此外,他们在大规模户外地图的视觉语义定位领域取得了许多突破性进展。西班牙萨拉戈萨大学机器人、传感和实时组SLAM实验室是SLAM发展的最大贡献者之一。实验室推出的ORB-SLAM系列是视觉SLAM中的标志性方案,对SLAM的研究产生了深远的影响。此外,许多学者和团队的努力推动了视觉语义SLAM的快速发展,并为解决未来的各种问题奠定了基础。表2显示了一些优秀团队的作品及其团队网站,供您参考。您可以通过团队名称后引用的数字查看团队的网站。

表2 一些优秀的团队及其贡献

图5 视觉SLAM领域的杰出学者

图6 不同国家在SLAM领域的贡献(从亮到暗的颜色表示从低到高的贡献)