第一章 Hadoop概述

目录

1.1 为什么要用hadoop

1.2 Hadoop的简要介绍

1.3 谷歌的三篇论文

1.4 Hadoop的发展历史

1.5 Hadoop的组成部分

1.6 Hadoop的生态系统

1.1 为什么要用hadoop

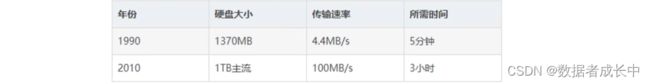

一些数据集的大小远远超过1TB,数据的存储是一个要解决的问题。同时硬盘技术也面临一个技术瓶颈,就是硬盘的传输速度(读数据的速度)的提升远远低于硬盘容量额提升

扩展知识:数据大小单位,从小到大分别是:tybe、kb、mb、Gb、Tb、PB、EB、ZB、DB、NB........单位之间的转换都是满足1024

Hadoop为我们提供了一个可靠的且可扩展的存储和分析平台,此外由于Hadoop运行在商用的硬件上且是开源的,因此Hadoop的使用成本是比较低的,在用户的承受范围内。

1.2 Hadoop的简要介绍

hadoop是Apache基金会旗下一个开源的分布式存储和分布式分析计算平台,使用java语言开发,具有很好的跨平台性,可以运行在商用(廉价)硬盘上,用户无需了解分布式底层的细节,就可以开发分布式程序,充分使用集群的高速计算和存储。

1.3 谷歌的三篇论文

- 2003年发表的《GFS》

基于硬盘不够大,数据存储单份的安全隐患问题,提出的分布式文件系统用于存储的理论思想。 解决了如何存储大数据集的问题。

- 2004年发表的《Mapreduce》

基于 分布式文件系统的计算分析的编程框架模型,移动计算而非移动数据,分而治之。 解决了如何快速分析大数据集问题。

- 2006年发表的《Bigtable》

针对与传统型关系数据库不适合存储非结构化数据的缺点,提出了另一种适合存储大数据集的解决方案。

1.4 Hadoop的发展历史

它起源于 Apache Nutch项目(一个网页爬取工具和搜索引擎系统,后来遇到大数据量的网页存储问题)。

2003年,谷歌发表的一篇论文(描述的是“谷歌分布式文件系统”,简称GFS)给了 Apache Nutch项目的开发者灵感。

2004年, Nutch的开发者开始着手NDFS( Nutch的分布式文件系统)

2004年,谷歌又发表了一篇介绍 Mapreduce系统的论文

2005年,Nuth项目实现了一个 Mapreduce系统

2006年,开发人员将NDFS和 Mapreduce移出Nuth项目形成一个子项目,命名 Hadoop

2008年, Hadoop已称为 Apache的顶级项目。

2008年4月, Hadoop打破世界记录,成为最快排序1TB数据的系统,排序时间为209秒

2009年, Hadoop把1TB数据的排序时间缩矩到62秒。

从此名声大噪,现在很多公司都在使用,如雅虎, last. fm, Face Book,《纽约时报》等等

1.5 Hadoop的组成部分

hadoop2.0以后的四个模块:

Hadoop common:Hadoop模块的通用组件

Hadoop distributed file system:分布式文件系统

Hadoop YARN:作业调度和资源管理框架

Hadoop mapreduce:基于yarn的大型数据集并行计算处理框架

Hadoop3.0新扩展的两个模块:

Hadoop 0zone:Hadoop的对象存储机制

Hadoop submarine:Hadoop的机器学习引擎