章节十四:Scrapy框架

章节十四:Scrapy框架

1. Scrapy是什么

1.1 Scrapy的结构

1.2 Scrapy的工作原理

2. Scrapy的用法

2.1 明确目标与分析过程

2.2 代码实现——创建项目

2.3 代码实现——编辑爬虫

2.4 代码实现——定义数据

2.5 代码实操——设置

2.6 代码实操——运行

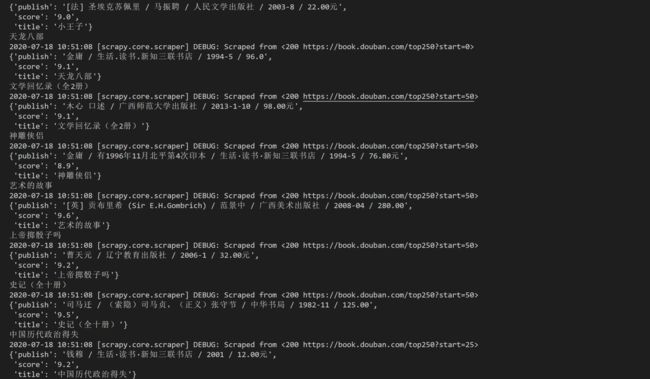

3. 代码实操

4. 复习

5. 习题练习

前两关,我们学习了能提升爬虫速度的进阶知识——协程,并且通过项目实操,将协程运用于抓取薄荷网的食物数据。

可能你在体验开发一个爬虫项目的完整流程时,会有这样的感觉:原来要完成一个完整的爬虫程序需要做这么多琐碎的工作。

比如,要导入不同功能的模块,还要编写各种爬取流程的代码。而且根据不同的项目,每次要编写的代码也不同。

不知道你会不会有这样的想法:能不能有一个现成的爬虫模板,让我们拿来就能套用,就像PPT模板一样。我们不需要管爬虫的全部流程,只要负责填充好爬虫的核心逻辑代码就好。要是有的话,我们编写代码一定会很方便省事。

其实,在Python中还真的存在这样的爬虫模板,只不过它的名字是叫框架。

一个爬虫框架里包含了能实现爬虫整个流程的各种模块,就像PPT模板一开始就帮你设置好了主题颜色和排版方式一样。

这一关,我们要学习的就是一个功能强大的爬虫框架——Scrapy。

1. Scrapy是什么

以前我们写爬虫,要导入和操作不同的模块,比如requests模块、gevent库、csv模块等。而在Scrapy里,你不需要这么做,因为很多爬虫需要涉及的功能,比如麻烦的异步,在Scrapy框架都自动实现了。

我们之前编写爬虫的方式,相当于在一个个地在拼零件,拼成一辆能跑的车。而Scrapy框架则是已经造好的、现成的车,我们只要踩下它的油门,它就能跑起来。这样便节省了我们开发项目的时间。

下面,我们来了解Scrapy的基础知识,包括Scrapy的结构及其工作原理。

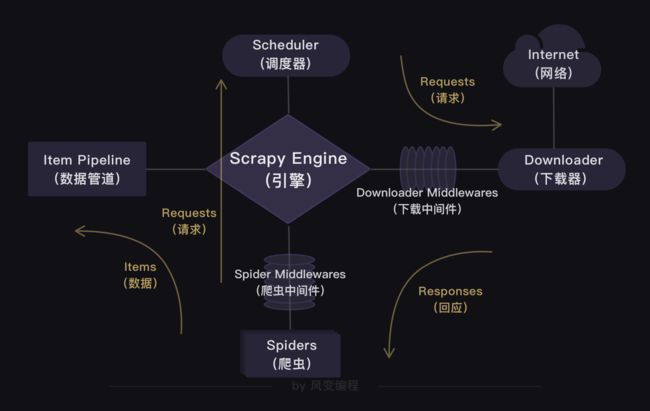

1.1 Scrapy的结构

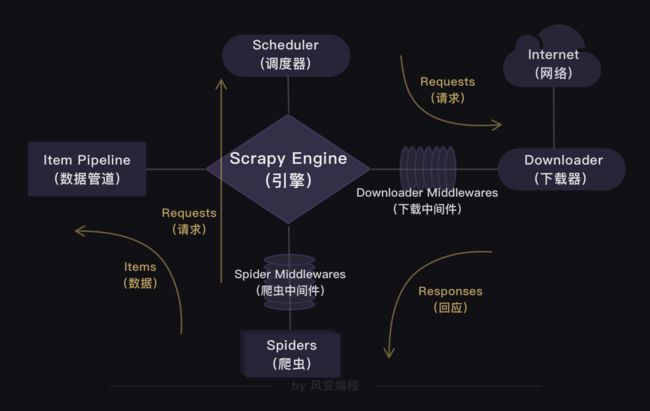

上面的这张图是Scrapy的整个结构。你可以把整个Scrapy框架看成是一家爬虫公司。最中心位置的Scrapy Engine(引擎)就是这家爬虫公司的大boss,负责统筹公司的4大部门,每个部门都只听从它的命令,并只向它汇报工作。

我会以爬虫流程的顺序来依次跟你介绍Scrapy爬虫公司的4大部门。

Scheduler(调度器)部门主要负责处理引擎发送过来的requests对象(即网页请求的相关信息集合,包括params,data,cookies,request headers…等),会把请求的url以有序的方式排列成队,并等待引擎来提取(功能上类似于gevent库的queue模块)。

Downloader(下载器)部门则是负责处理引擎发送过来的requests,进行网页爬取,并将返回的response(爬取到的内容)交给引擎。它对应的是爬虫流程【获取数据】这一步。

Spiders(爬虫)部门是公司的核心业务部门,主要任务是创建requests对象和接受引擎发送过来的response(Downloader部门爬取到的内容),从中解析并提取出有用的数据。它对应的是爬虫流程【解析数据】和【提取数据】这两步。

Item Pipeline(数据管道)部门则是公司的数据部门,只负责存储和处理Spiders部门提取到的有用数据。这个对应的是爬虫流程【存储数据】这一步。

Downloader Middlewares(下载中间件)的工作相当于下载器部门的秘书,比如会提前对引擎大boss发送的诸多requests做出处理。

Spider Middlewares(爬虫中间件)的工作则相当于爬虫部门的秘书,比如会提前接收并处理引擎大boss发送来的response,过滤掉一些重复无用的东西。

1.2 Scrapy的工作原理

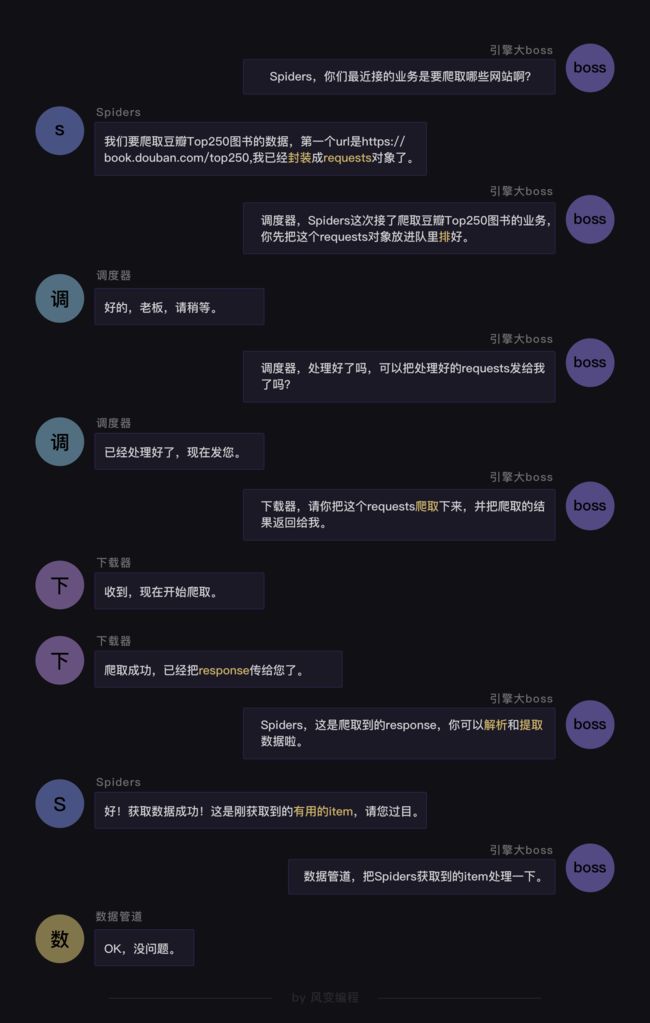

你会发现,在Scrapy爬虫公司里,每个部门都各司其职,形成了很高效的运行流程。

这套运行流程的逻辑很简单,就是:引擎大boss说的话就是最高需求。

上图展现出的也是Scrapy框架的工作原理——引擎是中心,其他组成部分由引擎调度。

在Scrapy里,整个爬虫程序的流程都不需要我们去操心,且Scrapy中的程序全部都是异步模式,所有的请求或返回的响应都由引擎自动分配去处理。

哪怕有某个请求出现异常,程序也会做异常处理,跳过报错的请求,继续往下运行程序。

在一定程度上,Scrapy可以说是非常让人省心的一套爬虫框架。

2. Scrapy的用法

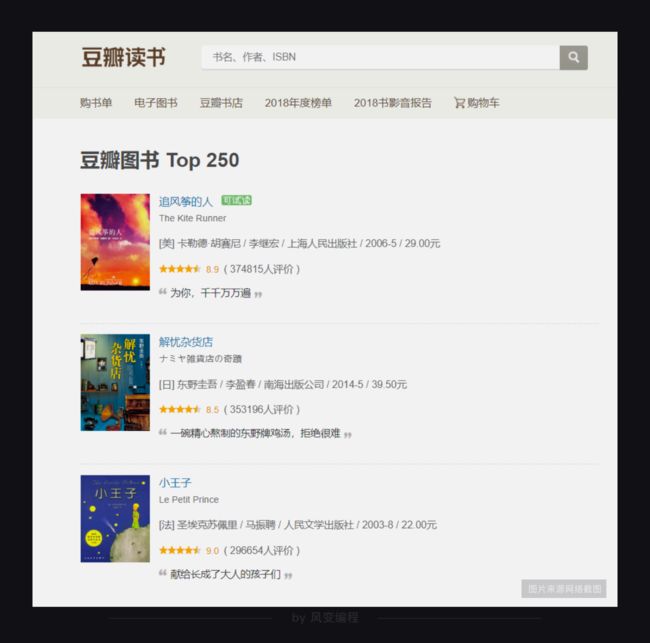

现在,你已经初步了解Scrapy的结构以及工作原理。接下来,为了让你熟悉Scrapy的用法,我们使用它来完成一个小项目——爬取豆瓣Top250图书。

2.1 明确目标与分析过程

依旧是遵循写代码的三个步骤:明确目标、分析过程、代码实现来完成项目。我会在代码实现的步骤重点讲解Scrapy的用法。

首先,要明确目标。请你务必打开以下豆瓣Top250图书的链接。

https://book.douban.com/top250

豆瓣Top250图书一共有10页,每页有25本书籍。我们的目标是:先只爬取前三页书籍的信息,也就是爬取前75本书籍的信息(包含书名、出版信息和书籍评分)。

接着,我们来分析网页。既然我们要爬取书籍信息,我们就得先判断这些信息被存在了哪里。

判断的方法你应该了然于胸。赶紧右击打开“检查”工具,点开Network,刷新页面,然后点击第0个请求top250,看Response.

我们能在里面翻找到书名、出版信息,说明我们想要的书籍信息就藏在这个网址的HTML里。

确定书籍信息有存在这个网址的HTML后,我们就来具体观察一下这个网站。

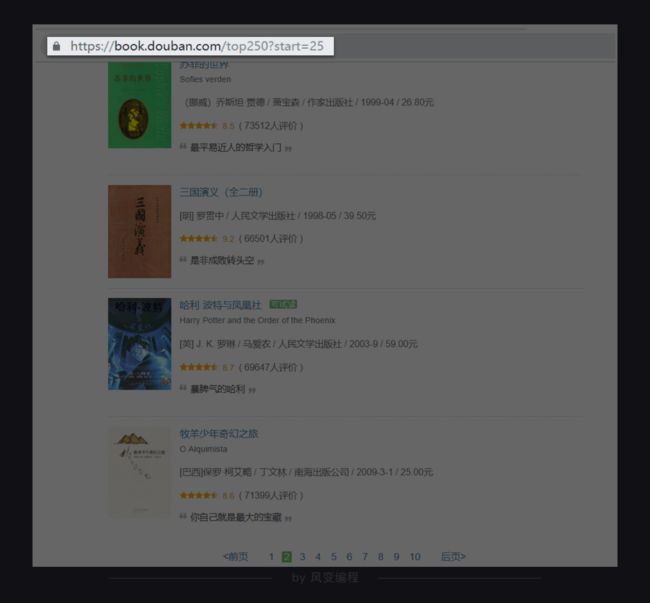

你点击翻到豆瓣Top250图书的第2页。

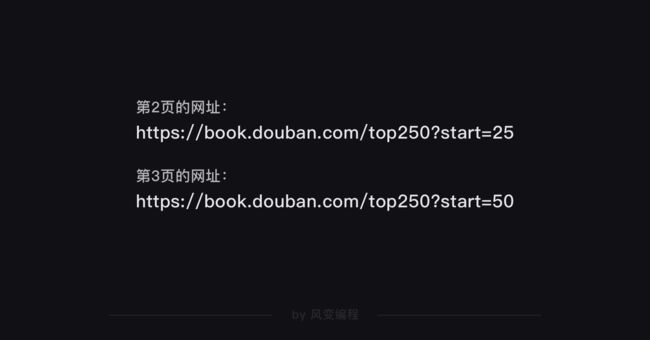

你会观察到,网址发生了变化,后面多了?start=25。我们猜想,后面的数字是代表一页的25本书籍。

你可以翻到第3页,验证一下我们的猜想是不是正确的。

事实证明,我们猜对了。每翻一页,网址后面的数字都会增加25,说明这个start的参数就是代表每页的25本书籍。

这么一观察,我们要爬取的网址的构造规律就出来了。只要改变?start=后面的数字(翻一页加25),我们就能得到每一页的网址。

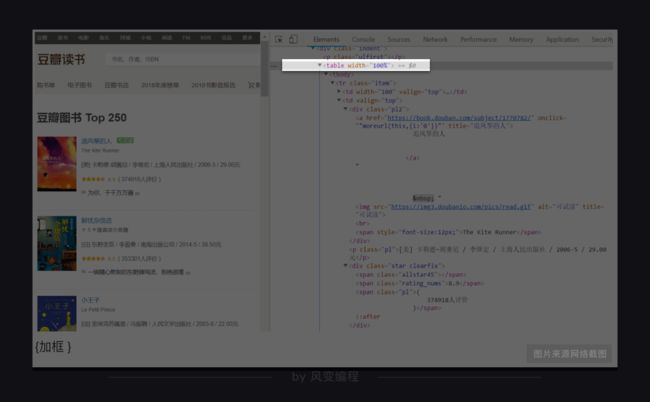

找到了网址的构造规律,我们可以重点来分析HTML的结构,看看等下怎么才能提取出我们想要的书籍信息。

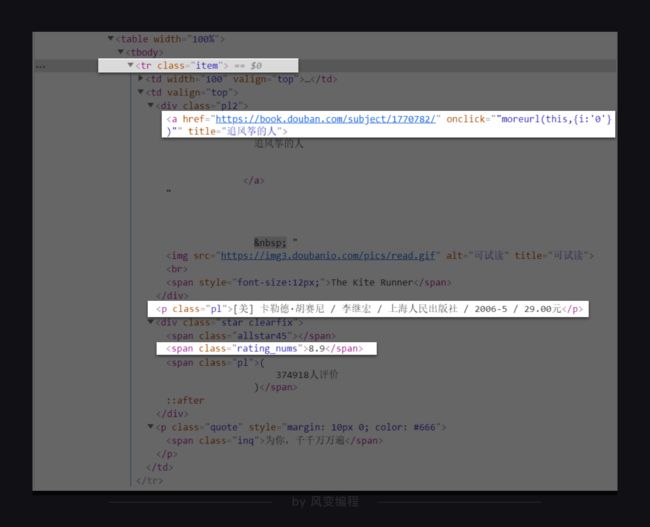

仍旧是右击打开“检查”工具,点击Elements,再点击光标,把鼠标依次移到书名、出版信息、评分处,就能在HTML里找到这些书籍信息。如下图,《追风筝的人》的书籍信息就全部放在标签里。

很快,你就会发现,其实每一页的25本书籍信息都分别藏在了一个标签里。不过这个标签没有class属性,也没有id属性,不方便我们提取信息。

我们得再找一个既方便我们提取,又能包含所有书籍信息的标签。

在标签下的元素刚好都能满足我们的要求,既有class属性,又包含了书籍的信息。

我们只要取出元素下title属性的值、

页面分析完毕,接着进入代码实现的步骤。

2.2 代码实现——创建项目

从这里开始,我会带你使用Scrapy编写我们的项目爬虫。其中会涉及到很多Scrapy的用法,请你一定要认真地看!

提示:课程的终端已经安装好了Scrapy,如果你想着自己本地的电脑使用Scrapy,需要提前安装好它。(安装方法:Windows:在终端输入命令:pip install scrapy;mac:在终端输入命令:pip3 install scrapy,按下enter键)

首先,要在本地电脑打开终端(windows:Win+R,输入cmd;mac:command+空格,搜索“终端”),然后跳转到你想要保存项目的目录下。

假设你想跳转到E盘里名为Python文件夹中的Pythoncode子文件夹。你需要再命令行输入e:,就会跳转到e盘,再输入cd Python,就能跳转到Python文件夹。接着输入cd Pythoncode,就能跳转到Python文件夹里的Pythoncode子文件夹。

然后,再输入一行能帮我们创建Scrapy项目的命令:scrapy startproject douban,douban就是Scrapy项目的名字。按下enter键,一个Scrapy项目就创建成功了。

点击这里

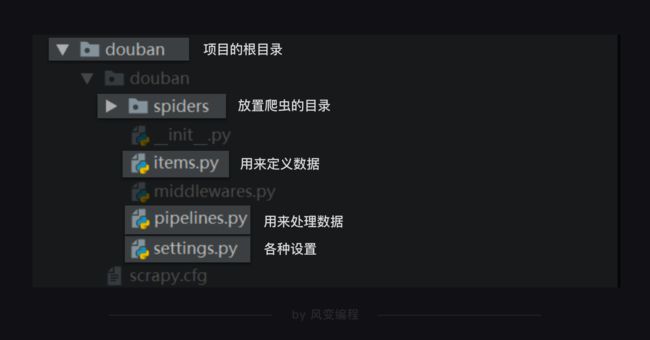

整个scrapy项目的结构,如下图所示:

Scrapy项目里每个文件都有特定的功能,比如settings.py 是scrapy里的各种设置。items.py是用来定义数据的,pipelines.py是用来处理数据的,它们对应的就是Scrapy的结构中的Item Pipeline(数据管道)。

现在或许你还看不懂它们,没关系,事情将会一点点变清晰。我们来讲解它们。

2.3 代码实现——编辑爬虫

如前所述,spiders是放置爬虫的目录。我们可以在spiders这个文件夹里创建爬虫文件。我们来把这个文件,命名为top250。后面的大部分代码都需要在这个top250.py文件里编写。

先在top250.py文件里导入我们需要的模块。

import scrapy

import bs4导入BeautifulSoup用于解析和提取数据,这个应该不需要我多做解释。在第3关、第4关的时候你就已经对它非常熟稔。

导入scrapy是待会我们要用创建类的方式写这个爬虫,我们所创建的类将直接继承scrapy中的scrapy.Spider类。这样,有许多好用属性和方法,就能够直接使用。

接着我们开始编写爬虫的核心代码。

在Scrapy中,每个爬虫的代码结构基本都如下所示:

class DoubanSpider(scrapy.Spider):

name = 'douban'

allowed_domains = ['book.douban.com']

start_urls = ['https://book.douban.com/top250?start=0']

def parse(self, response):

print(response.text)第1行代码:定义一个爬虫类DoubanSpider。就像我刚刚讲过的那样,DoubanSpider类继承自scrapy.Spider类。

第2行代码:name是定义爬虫的名字,这个名字是爬虫的唯一标识。name = 'douban'意思是定义爬虫的名字为douban。等会我们启动爬虫的时候,要用到这个名字。

第3行代码:allowed_domains是定义允许爬虫爬取的网址域名(不需要加https://)。如果网址的域名不在这个列表里,就会被过滤掉。

为什么会有这个设置呢?当你在爬取大量数据时,经常是从一个URL开始爬取,然后关联爬取更多的网页。比如,假设我们今天的爬虫目标不是爬书籍信息,而是要爬豆瓣图书top250的书评。我们会先爬取书单,再找到每本书的URL,再进入每本书的详情页面去抓取评论。

allowed_domains就限制了,我们这种关联爬取的URL,一定在book.douban.com这个域名之下,不会跳转到某个奇怪的广告页面。

第4行代码:start_urls是定义起始网址,就是爬虫从哪个网址开始抓取。在此,allowed_domains的设定对start_urls里的网址不会有影响。

第6行代码:parse是Scrapy里默认处理response的一个方法,中文是解析。

你或许会好奇,这里是不是少了一句类似requests.get()这样的代码?的确是,在这里,我们并不需要写这一句。scrapy框架会为我们代劳做这件事,写好你的请求,接下来你就可以直接写对响应如何做处理,我会在后面为你做示例。

了解完爬虫代码的基础结构,我们继续来完善爬取豆瓣Top图书的代码。

豆瓣Top250图书一共有10页,每一页的网址我们都知道。我们可以选择把10页网址都塞进start_urls的列表里。

但是这样的方式并不美观,而且如果要爬取的是上百个网址,全部塞进start_urls的列表里的话,代码就会非常长。

其实,我们可以利用豆瓣Top250图书的网址规律,用for循环构造出每个网址,再把网址添加进start_urls的列表里。这样代码会美观得多。

完善后的代码如下:

class DoubanSpider(scrapy.Spider):

name = 'douban'

allowed_domains = ['book.douban.com']

start_urls = []

for x in range(3):

url = 'https://book.douban.com/top250?start=' + str(x * 25)

start_urls.append(url)我们只先爬取豆瓣Top250前3页的书籍信息。

接下来,只要再借助parse方法处理response,借助BeautifulSoup来取出我们想要的书籍信息的数据,代码即可完成。

我们前面在分析项目过程的时候,已经知道书籍信息都藏在了哪些元素里,现在可以利用find_all和find方法提取出来。比如,书名是元素下title属性的值;出版信息在

按照过去的知识,我们可能会把代码写成这个模样:

import scrapy

import bs4

from ..items import DoubanItem

class DoubanSpider(scrapy.Spider):

#定义一个爬虫类DoubanSpider。

name = 'douban'

#定义爬虫的名字为douban。

allowed_domains = ['book.douban.com']

#定义爬虫爬取网址的域名。

start_urls = []

#定义起始网址。

for x in range(3):

url = 'https://book.douban.com/top250?start=' + str(x * 25)

start_urls.append(url)

#把豆瓣Top250图书的前3页网址添加进start_urls。

def parse(self, response):

#parse是默认处理response的方法。

bs = bs4.BeautifulSoup(response.text,'html.parser')

#用BeautifulSoup解析response。

datas = bs.find_all('tr',class_="item")

#用find_all提取元素,这个元素里含有书籍信息。

for data in datas:

#遍历data。

title = data.find_all('a')[1]['title']

#提取出书名。

publish = data.find('p',class_='pl').text

#提取出出版信息。

score = data.find('span',class_='rating_nums').text

#提取出评分。

print([title,publish,score])

#打印上述信息。

按照过去,我们会把书名、出版信息、评分,分别赋值,然后统一做处理——或是打印,或是存储。但在scrapy这里,事情却有所不同。

spiders(如top250.py)只干spiders应该做的事。对数据的后续处理,另有人负责。

2.4 代码实现——定义数据

在scrapy中,我们会专门定义一个用于记录数据的类。

当我们每一次,要记录数据的时候,比如前面在每一个最小循环里,都要记录“书名”,“出版信息”,“评分”。我们会实例化一个对象,利用这个对象来记录数据。

每一次,当数据完成记录,它会离开spiders,来到Scrapy Engine(引擎),引擎将它送入Item Pipeline(数据管道)处理。

定义这个类的py文件,正是items.py。

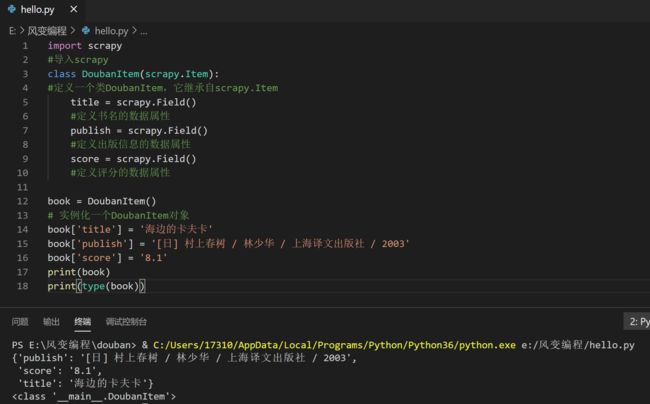

我们已经知道,我们要爬取的数据是书名、出版信息和评分,我们来看看如何在items.py里定义这些数据。代码如下:

import scrapy

#导入scrapy

class DoubanItem(scrapy.Item):

#定义一个类DoubanItem,它继承自scrapy.Item

title = scrapy.Field()

#定义书名的数据属性

publish = scrapy.Field()

#定义出版信息的数据属性

score = scrapy.Field()

#定义评分的数据属性第1行代码,我们导入了scrapy。目的是,我们等会所创建的类将直接继承scrapy中的scrapy.Item类。这样,有许多好用属性和方法,就能够直接使用。比如到后面,引擎能将item类的对象发给Item Pipeline(数据管道)处理。

第3行代码:我们定义了一个DoubanItem类。它继承自scrapy.Item类。

第5、7、9行代码:我们定义了书名、出版信息和评分三种数据。scrapy.Field()这行代码实现的是,让数据能以类似字典的形式记录。你可能不太明白这句话的含义,没关系。我带你来体验一下,你就能感受到是怎样一回事:

import scrapy

#导入scrapy

class DoubanItem(scrapy.Item):

#定义一个类DoubanItem,它继承自scrapy.Item

title = scrapy.Field()

#定义书名的数据属性

publish = scrapy.Field()

#定义出版信息的数据属性

score = scrapy.Field()

#定义评分的数据属性

book = DoubanItem()

# 实例化一个DoubanItem对象

book['title'] = '海边的卡夫卡'

book['publish'] = '[日] 村上春树 / 林少华 / 上海译文出版社 / 2003'

book['score'] = '8.1'

print(book)

print(type(book))你会看到打印出来的结果的确和字典非常相像,但它却并不是dict,它的数据类型是我们定义的DoubanItem,属于“自定义的Python字典”。我们可以利用类似上述代码的样式,去重新写top250.py。如下所示:

import scrapy

import bs4

from ..items import DoubanItem

# 需要引用DoubanItem,它在items里面。因为是items在top250.py的上一级目录,所以要用..items,这是一个固定用法。

class DoubanSpider(scrapy.Spider):

#定义一个爬虫类DoubanSpider。

name = 'douban'

#定义爬虫的名字为douban。

allowed_domains = ['book.douban.com']

#定义爬虫爬取网址的域名。

start_urls = []

#定义起始网址。

for x in range(3):

url = 'https://book.douban.com/top250?start=' + str(x * 25)

start_urls.append(url)

#把豆瓣Top250图书的前3页网址添加进start_urls。

def parse(self, response):

#parse是默认处理response的方法。

bs = bs4.BeautifulSoup(response.text,'html.parser')

#用BeautifulSoup解析response。

datas = bs.find_all('tr',class_="item")

#用find_all提取元素,这个元素里含有书籍信息。

for data in datas:

#遍历data。

item = DoubanItem()

#实例化DoubanItem这个类。

item['title'] = data.find_all('a')[1]['title']

#提取出书名,并把这个数据放回DoubanItem类的title属性里。

item['publish'] = data.find('p',class_='pl').text

#提取出出版信息,并把这个数据放回DoubanItem类的publish里。

item['score'] = data.find('span',class_='rating_nums').text

#提取出评分,并把这个数据放回DoubanItem类的score属性里。

print(item['title'])

#打印书名。

yield item

#yield item是把获得的item传递给引擎。

在3行,我们需要引用DoubanItem,它在items里面。因为是items在top250.py的上一级目录,所以要用..items,这是一个固定用法。

当我们每一次,要记录数据的时候,比如前面在每一个最小循环里,都要记录“书名”,“出版信息”,“评分”。我们会实例化一个item对象,利用这个对象来记录数据。

每一次,当数据完成记录,它会离开spiders,来到Scrapy Engine(引擎),引擎将它送入Item Pipeline(数据管道)处理。这里,要用到yield语句。

yield语句你可能还不太了解,这里你可以简单理解为:它有点类似return,不过它和return不同的点在于,它不会结束函数,且能多次返回信息。

如果用可视化的方式来呈现程序运行的过程,就如同上图所示:爬虫(Spiders)会把豆瓣的10个网址封装成requests对象,引擎会从爬虫(Spiders)里提取出requests对象,再交给调度器(Scheduler),让调度器把这些requests对象排序处理。

然后引擎再把经过调度器处理的requests对象发给下载器(Downloader),下载器会立马按照引擎的命令爬取,并把response返回给引擎。

紧接着引擎就会把response发回给爬虫(Spiders),这时爬虫会启动默认的处理response的parse方法,解析和提取出书籍信息的数据,使用item做记录,返回给引擎。引擎将它送入Item Pipeline(数据管道)处理。

2.5 代码实操——设置

到这里,我们就用代码编写好了一个爬虫。不过,实际运行的话,可能还是会报错。

原因在于Scrapy里的默认设置没被修改。比如我们需要修改请求头。点击settings.py文件,你能在里面找到如下的默认设置代码:

# Crawl responsibly by identifying yourself (and your website) on the user-agent

#USER_AGENT = 'douban (+http://www.yourdomain.com)'

# Obey robots.txt rules

ROBOTSTXT_OBEY = True请你把USER _AGENT的注释取消(删除#),然后替换掉user-agent的内容,就是修改了请求头。

又因为Scrapy是遵守robots协议的,如果是robots协议禁止爬取的内容,Scrapy也会默认不去爬取,所以我们还得修改Scrapy中的默认设置。

把ROBOTSTXT_OBEY=True改成ROBOTSTXT_OBEY=False,就是把遵守robots协议换成无需遵从robots协议,这样Scrapy就能不受限制地运行。

修改后的代码应该如下所示:

# Crawl responsibly by identifying yourself (and your website) on the user-agent

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.98 Safari/537.36'

# Obey robots.txt rules

ROBOTSTXT_OBEY = False现在,我们已经编写好了spider,也修改好了setting。万事俱备,只欠东风——运行Scrapy。

2.6 代码实操——运行

想要运行Scrapy有两种方法,一种是在本地电脑的终端跳转到scrapy项目的文件夹(跳转方法:cd+文件夹的路径名),然后输入命令行:scrapy crawl douban(douban 就是我们爬虫的名字)。

点击这里

另一种运行方式需要我们在最外层的大文件夹里新建一个main.py文件(与scrapy.cfg同级)。

我们只需要在这个main.py文件里,输入以下代码,点击运行,Scrapy的程序就会启动。

from scrapy import cmdline

#导入cmdline模块,可以实现控制终端命令行。

cmdline.execute(['scrapy','crawl','douban'])

#用execute()方法,输入运行scrapy的命令。第1行代码:在Scrapy中有一个可以控制终端命令的模块cmdline。导入了这个模块,我们就能操控终端。

第3行代码:在cmdline模块中,有一个execute方法能执行终端的命令行,不过这个方法需要传入列表的参数。我们想输入运行Scrapy的代码scrapy crawl douban,就需要写成['scrapy','crawl','douban']这样。

至此,Scrapy的用法我们学完啦。

值得一提的是,在本关卡中为了教学方便理解,先写了爬虫,再定义数据。但是,在实际项目实战中,常常顺序却是相反的——先定义数据,再写爬虫。所以,流程图应如下:

细心的你可能会发现,这一关的内容没有涉及到存储数据的步骤。

是的,存储数据需要修改pipelines.py文件。这一关的内容已经很充实,所以这个知识点我们留到下一关再讲。

最后,是这一关的重点知识的复习。

3. 代码实操

top250.py(在spiders文件下)的基本代码结构示例:

#在spiders文件下

import scrapy

import bs4

from ..items import DoubanItem

# 需要引用DoubanItem,它在items里面。因为是items在top250.py的上一级目录,所以要用..items,这是一个固定用法。

class DoubanSpider(scrapy.Spider):

#定义一个爬虫类DoubanSpider。

name = 'douban'

#定义爬虫的名字为douban。

allowed_domains = ['book.douban.com']

#定义爬虫爬取网址的域名。

start_urls = []

#定义起始网址。

for x in range(3):

url = 'https://book.douban.com/top250?start=' + str(x * 25)

start_urls.append(url)

#把豆瓣Top250图书的前3页网址添加进start_urls。

def parse(self, response):

#parse是默认处理response的方法。

bs = bs4.BeautifulSoup(response.text,'html.parser')

#用BeautifulSoup解析response。

datas = bs.find_all('tr',class_="item")

#用find_all提取元素,这个元素里含有书籍信息。

for data in datas:

#遍历data。

item = DoubanItem()

#实例化DoubanItem这个类。

item['title'] = data.find_all('a')[1]['title']

#提取出书名,并把这个数据放回DoubanItem类的title属性里。

item['publish'] = data.find('p',class_='pl').text

#提取出出版信息,并把这个数据放回DoubanItem类的publish里。

item['score'] = data.find('span',class_='rating_nums').text

#提取出评分,并把这个数据放回DoubanItem类的score属性里。

print(item['title'])

#打印书名。

yield item

#yield item是把获得的item传递给引擎。

定义items.py(与spiders文件同级)的代码示例:

import scrapy

#导入scrapy

class DoubanItem(scrapy.Item):

#定义一个类DoubanItem,它继承自scrapy.Item

title = scrapy.Field()

#定义书名的数据属性

publish = scrapy.Field()

#定义出版信息的数据属性

score = scrapy.Field()

#定义评分的数据属性

修改setting.py(与spiders文件同级)文件

#修改前的默认设置

# Crawl responsibly by identifying yourself (and your website) on the user-agent

#USER_AGENT = 'douban (+http://www.yourdomain.com)'

# Obey robots.txt rules

ROBOTSTXT_OBEY = True#修改后的设置

# Crawl responsibly by identifying yourself (and your website) on the user-agent

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.98 Safari/537.36'

# Obey robots.txt rules

ROBOTSTXT_OBEY = False4)运行main.py(与spiders文件同级)的代码示例:

from scrapy import cmdline

#导入cmdline模块,可以实现控制终端命令行。

cmdline.execute(['scrapy','crawl','douban'])

#用execute()方法,输入运行scrapy的命令。5)运行结果

4. 复习

Scrapy的结构——

Scrapy的工作原理——

Scrapy的用法——

5. 习题练习

1.要求:

当当网2018年图书销售榜单链接:http://bang.dangdang.com/books/bestsellers/01.00.00.00.00.00-year-2018-0-1-1

2.目的:

3.知识点回顾

1)定义item的代码示例:

import scrapy

#导入scrapy

class DoubanItem(scrapy.Item):

#定义一个类DoubanItem,它继承自scrapy.Item

title = scrapy.Field()

#定义书名的数据属性

publish = scrapy.Field()

#定义出版信息的数据属性

score = scrapy.Field()

#定义评分的数据属性2)spider的基本代码结构示例:

class DoubanSpider(scrapy.Spider):

name = 'douban'

allowed_domains = ['book.douban.com']

start_urls = ['https://book.douban.com/top250?start=0']

def parse(self, response):

print(response.text)3)修改setting文件

#修改前的默认设置

# Crawl responsibly by identifying yourself (and your website) on the user-agent

#USER_AGENT = 'douban (+http://www.yourdomain.com)'

# Obey robots.txt rules

ROBOTSTXT_OBEY = True#修改后的设置

# Crawl responsibly by identifying yourself (and your website) on the user-agent

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.98 Safari/537.36'

# Obey robots.txt rules

ROBOTSTXT_OBEY = False4)运行scrapy的代码示例:

from scrapy import cmdline

cmdline.execute(['scrapy','crawl','douban'])4.执行结果

你可能感兴趣的:(scrapy,爬虫,python,开发语言)

2025年全国CTF夺旗赛-从零基础入门到竞赛,看这一篇就稳了!

白帽安全-黑客4148

安全 web安全 网络 网络安全 CTF

目录一、CTF简介二、CTF竞赛模式三、CTF各大题型简介四、CTF学习路线4.1、初期1、html+css+js(2-3天)2、apache+php(4-5天)3、mysql(2-3天)4、python(2-3天)5、burpsuite(1-2天)4.2、中期1、SQL注入(7-8天)2、文件上传(7-8天)3、其他漏洞(14-15天)4.3、后期五、CTF学习资源5.1、CTF赛题复现平台5.

2025年全国CTF夺旗赛-从零基础入门到竞赛,看这一篇就稳了!

白帽安全-黑客4148

网络安全 web安全 linux 密码学 CTF

目录一、CTF简介二、CTF竞赛模式三、CTF各大题型简介四、CTF学习路线4.1、初期1、html+css+js(2-3天)2、apache+php(4-5天)3、mysql(2-3天)4、python(2-3天)5、burpsuite(1-2天)4.2、中期1、SQL注入(7-8天)2、文件上传(7-8天)3、其他漏洞(14-15天)4.3、后期五、CTF学习资源5.1、CTF赛题复现平台5.

基于python深度学习遥感影像地物分类与目标识别、分割实践技术应用

xiao5kou4chang6kai4

深度学习 遥感 勘测 python 深度学习 分类

专题一:深度学习发展与机器学习深度学习的历史发展过程机器学习,深度学习等任务的基本处理流程梯度下降算法讲解不同初始化,学习率对梯度下降算法的实例分析从机器学习到深度学习算法专题二深度卷积网络、卷积神经网络、卷积运算的基本原理池化操作,全连接层,以及分类器的作用BP反向传播算法的理解一个简单CNN模型代码理解特征图,卷积核可视化分析专题三TensorFlow与keras介绍与入门TensorFlow

python 快速实现链接转 word 文档

嘿嘿潶黑黑

python word

python快速实现链接转word文档演示代码展示最后演示代码展示fromnewspaperimportArticlefromdocximportDocumentfromdocx.sharedimportPt,RGBColorfromdocx.enum.styleimportWD_STYLE_TYPEfromdocx.oxml.nsimportqn#tkinterGUIimporttkintera

Python入门笔记

「已注销」

计算机

文章目录第0周课程导学第1周Python基本语法元素保留字数据类型语句与函数输入函数第2周Python基本图形绘制turtle库绝对坐标海龟坐标turtle角度坐标体系RGB色彩体系画笔控制函数运动控制函数方向控制函数循环语句第3周基本数据类型整型浮点数科学计数法复数类型数值运算操作符二元操作符有对应的增强赋值操作符数值运算函数字符串类型的表示字符串切片字符串类型及操作字符串类型格式化time库时

pythonxml模块高级用法_Python minidom模块用法示例【DOM写入和解析XML】

Lucy-露西娅

pythonxml模块高级用法

本文实例讲述了Pythonminidom模块用法。分享给大家供大家参考,具体如下:一、DOM写XML文件#-*-coding:utf-8-*-#!python3#导入minidomfromxml.domimportminidom#1.创建DOM树对象dom=minidom.Document()#2.创建根节点。每次都要用DOM对象来创建任何节点。root_node=dom.createElemen

React 渲染 Flash 接口数据

ox0080

# 北漂+滴滴出行 VIP 激励 Web react.js 前端 前端框架

1.后端Python代码使用Flask创建多个接口,每个接口返回不同的数据,并使用自定义装饰器来绑定路由。代码:#app.pyfromflaskimportFlask,jsonifyapp=Flask(__name__)defapi_route(route,methods=['GET']):"""自定义装饰器,用于将函数与HTTP路由绑定"""defdecorator(func):app.rout

LQB---基础练习---十六进制转八进制

「已注销」

# LQB LQB

试题基础练习十六进制转八进制资源限制内存限制:512.0MBC/C++时间限制:1.0sJava时间限制:3.0sPython时间限制:5.0s问题描述给定n个十六进制正整数,输出它们对应的八进制数。输入格式输入的第一行为一个正整数n(1<=n<=10)。接下来n行,每行一个由09、大写字母AF组成的字符串,表示要转换的十六进制正整数,每个十六进制数长度不超过100000。输出格式输出n行,每行为

【2025年】全国CTF夺旗赛-从零基础入门到竞赛,看这一篇就稳了!

网安詹姆斯

web安全 CTF 网络安全大赛 python linux

【2025年】全国CTF夺旗赛-从零基础入门到竞赛,看这一篇就稳了!基于入门网络安全/黑客打造的:黑客&网络安全入门&进阶学习资源包目录一、CTF简介二、CTF竞赛模式三、CTF各大题型简介四、CTF学习路线4.1、初期1、html+css+js(2-3天)2、apache+php(4-5天)3、mysql(2-3天)4、python(2-3天)5、burpsuite(1-2天)4.2、中期1、S

机器学习·文本数据读写处理

AAA顶置摸鱼

python 深度学习 机器学习 人工智能 数据处理

前言在自然语言处理的第一步,需要面对的是各种各样以不同形式表现的文本数据,比如,txt、Excel中的表格数据,还有无法直接打开的pkl文件等。针对这些不同类型的数据,可以基于Python中的基本功能函数或者调用某些库进行读写以及作一些基本的处理。一、文本数据读写方法1.读写TXT文件读取方法:read():读取整个文件,返回字符串。readline():逐行读取,返回字符串。readlines(

LQB(4)-python-DFS搜索

AAA顶置摸鱼

蓝桥杯python组 深度优先 算法 python 蓝桥杯

前言DFS即深度优先搜索(Depth-FirstSearch),是一种用于遍历或搜索树或图的算法,有三种核心的应用场景(基础遍历、回溯、剪枝)。一、DFS-基础遍历1.核心原理深度优先搜索(DFS)是一种遍历或搜索树/图的算法,优先沿着一条路径尽可能深入,直到无法继续再回溯。实现方式:递归:隐式利用系统调用栈。栈模拟:显式使用栈数据结构。2.代码实现(1)递归实现(树结构)classTreeNod

Python中LLM的知识图谱构建:动态更新与推理

二进制独立开发

GenAI与Python 非纯粹GenAI python 知识图谱 开发语言 自然语言处理 人工智能 分布式 机器学习

文章目录引言1.知识图谱的基本概念1.1知识图谱的定义1.2知识图谱的构建流程2.利用LLM进行知识抽取2.1实体识别2.2关系抽取2.3属性抽取3.知识融合3.1实体对齐3.2冲突消解4.知识存储5.知识推理5.1规则推理5.2基于LLM的推理6.动态更新6.1增量更新6.2实时更新7.结论引言随着人工智能技术的飞速发展,知识图谱(KnowledgeGraph,KG)作为一种结构化的知识表示方法

Python's SQLAlchemy and Object-Relational Mapping

zhanglizhuo

Python

Acommontaskwhenprogramminganywebserviceistheconstructionofasoliddatabasebackend.Inthepast,programmerswouldwriterawSQLstatements,passthemtothedatabaseengineandparsethereturnedresultsasanormalarrayofrec

Jira,一个强大灵活的项目和任务管理工具 Python 库

图灵学者

python精华 jira python 开发语言

目录01初识Jira为什么选择Jira?02安装与配置安装jira库配置Jira访问获取APItoken:配置Python环境:03基本操作创建项目创建任务查询任务更新任务删除任务04高级操作处理子任务搜索任务添加附件评论任务05实战案例自动化创建与分配任务自动生成项目报告06结语01初识JiraJira是Atlassian公司开发的一款项目和任务管理工具。它广泛应用于软件开发、IT支持、营销等各

使用LlamaIndex查询 MongoDB 数据库,并获取 OSS (对象存储服务) 上的 PDF 文件,最终用Langchain搭建应用

朴拙Python交易猿

数据库 mongodb pdf

使用LlamaIndex查询MongoDB数据库,并获取OSS(对象存储服务)上的PDF文件,然后利用Langchain搭建应用,涉及多个步骤。下面我们将详细介绍如何将这些步骤结合起来,构建一个系统:1.环境准备首先,确保你已经安装了以下Python库:pipinstallllama_indexpymongolangchainopenaiboto3pdfplumberpymongo:MongoDB

python 连接 jira

我就是我是好孩子啊

python jira 开发语言

Python连接到Jira实例、登录、查询、修改和创建bug首先,你需要安装jiraPython库pip3installjira连接到Jira并登录fromjiraimportJIRAfromjira.exceptionsimportJIRAError#Jira服务器地址,用户名和密码jira_server='https://your-jira-server.com'jira_user='your

python调用接口返回401,带有Python的Jira API在有效凭据上返回错误401

weixin_39743369

python调用接口返回401

IamtryingtousetheJirapythonlibrarytodosomequitebasicthings.Evenbeforedoinganything,theconstructorfails.address='https://myaddress.atlassian.net'options={'server':address}un='

[email protected] '#un='my'#alsod

python邮件发送哪个好_(原创)python发送邮件

加勒比考斯

python邮件发送哪个好

这段时间一直在学习flask框架,看到flask扩展中有一个mail插件,所以今天就给大家演示如果发邮件。首先我注册了一个163邮箱,需要开启smtp功能,(网易的电子邮件服务器)。注册好163邮箱,然后开启smtp功能,如下图所示:开启的过程中需要绑定手机。我最终实现的样子是这样的:使用flask搭建了一个web服务器,然后做了一个网页,将收件人,主题,正文填好之后,点击发送,上面会显示发送结果

如何用 python 获取实时的股票数据?_python efinance(2)

元点三

2024年程序员学习 python java linux

先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!因此收集整理了一份《2024年最新Python全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课

如何用 python 获取实时的股票数据?_python efinance,2024年最新pdf面试简历

元点三

2024年程序员学习 python pdf 面试

先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!因此收集整理了一份《2024年最新Python全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课

python中enumerate()函数的用法

neu_张康

python中enumerate()函数的用法enumerate是翻译过来是枚举的意思,看下它的方法原型:enumerate(sequence,start=0),返回一个枚举对象。sequence必须是序列或迭代器iterator,或者支持迭代的对象。enumerate()返回对象的每个元素都是一个元组,每个元组包括两个值,一个是计数,一个是sequence的值,计数是从start开始的,star

【python】懒人福利,通过Python的JIRA库操作JIRA,自动批量提交关闭bug,提高效率

bulabula2022

# CI持续集成 Python jira

简介:Jira是目前比较流行的基于Java架构的管理系统(Atlassian公司支持),有开源代码,方便做二次开发(可扩展性)。Jira是一款功能非常强大的管理工具,广泛的用来缺陷跟踪、用例管理、需求收集、任务跟踪、工时管理、项目计划管理等工作领域。python有支持操作Jira的第三方包,方便自定义一些自动化操作。需要安装jira库:pipinstalljiraJira认证fromjiraimp

使用Python获取在线股票交易网站的实时交易数据

嵌入式开发项目

2025年爬虫精通专栏 python 开发语言 爬虫

目录步骤1:选择股票交易网站步骤2:使用requests库发送HTTP请求步骤3:解析HTML内容步骤4:提取实时交易数据步骤5:存储和使用数据在金融市场中,实时交易数据对于投资者来说具有重要的价值。实时的股票价格、交易量和其他市场指标可以帮助投资者做出更准确的决策,同时也是进行金融分析和建模的重要数据源。在本篇博客中,我们将学习如何使用Python获取在线股票交易网站的实时交易数据。在开始之前,

【python】连接Jira获取token以及jira对象

唐古乌梁海

python jira

此脚本可以连接Jira,通过Jira的token,Jira对象可以实现与Jira的交互,从而完成jira与pytest的交互,或者其他自动化测试框架也行,例如:将pytest运行结果推送jira;将jira用例与自动化测试用例建立映射关系,将功能用例对应的自动化测试用例脚本路径推送到功能用例的描述栏,或者自动化栏里面#!/usr/bin/envpython#-*-coding:utf-8-*-#@

Python 基础-循环

赔罪

Python 系统学习 python windows 服务器

目录简介breakcontinue小结简介要计算1+2+3,我们可以直接写表达式:>>>1+2+36要计算1+2+3+...+10,勉强也能写出来。但是,要计算1+2+3+...+10000,直接写表达式就不可能了。为了让计算机能计算成千上万次的重复运算,我们就需要循环语句。Python的循环有两种,一种是for...in循环,依次把list或tuple中的每个元素迭代出来,看例子:names=[

【FastAPI 】FastAPI 模板:提供静态文件

iFakeCoder

Flask fastapi python 开发语言

FastAPI是一个现代、快速(高性能)的Web框架,用于基于标准Python类型提示使用Python3.7+构建API。虽然它的主要用例是构建API,但FastAPI还可以轻松提供静态文件和HTML模板,从而让您可以构建全栈Web应用程序。在此博客中,我们将探讨如何使用FastAPI提供静态文件。我们将介绍基础知识并提供演示以帮助您入门。为什么要提供静态文件?静态文件是不经常更改的资产,并按原样

深度学习在医疗影像分析中的革命性应用

Echo_Wish

人工智能 前沿技术 深度学习 人工智能

深度学习在医疗影像分析中的革命性应用引言医疗影像分析是现代医学中不可或缺的一部分,特别是在疾病诊断和治疗过程中发挥了至关重要的作用。随着深度学习技术的发展,医疗影像分析的效率和准确性得到了显著提升。本文将探讨如何利用深度学习技术,特别是Python编程语言,来优化医疗影像分析,展示具体的代码实例,并举例说明其实际应用效果。深度学习与医疗影像分析深度学习(DeepLearning)是一种基于人工神经

DeepSeek使用中的问题及解决方案(部分)

WeiLai1112

DeepSeek 人工智能

1.模型部署与配置问题问题1:环境依赖冲突现象:安装模型依赖库时出现版本不兼容(如Python、PyTorch版本冲突)。解决方案:使用虚拟环境(如conda或venv)隔离依赖。严格按照官方文档的版本要求安装依赖,例如:condacreate-ndeepseekpython=3.9condaactivatedeepseekpipinstalltorch==2.0.1transformers==4

python whoosh

clisy

python 开源 搜索

原文地址:http://whoosh.ca/wikiWhoosh:高效的纯python全文搜索组件Whoosh是一个纯python实现的全文搜索组件。Whoosh不但功能完善,还非常的快。Whoosh的作者是MattChaput,由SideEffectsSoftware公司开发。项目的最初用于Houdini(SideEffectsSoftware公司开发的3D动画软件)的在线帮助系统。SideEf

Python性能优化:懒加载与其他高级技巧

车载testing

pytest数据驱动框架开发 python python 数据库 开发语言

Python性能优化:懒加载与其他高级技巧在软件开发中,我们经常会遇到一些需要大量资源或时间来初始化的对象。如果这些对象在程序的整个生命周期中只被使用一次或很少使用,那么在程序启动时就立即初始化它们将是一种资源浪费。什么是懒加载?懒加载是一种设计模式,它推迟了对象的初始化直到其被实际需要的时候。这种方式可以提高程序的启动速度,减少内存消耗,并在某些情况下提高性能。实现懒加载的步骤定义类和属性:首先

集合框架

天子之骄

java 数据结构 集合框架

集合框架

集合框架可以理解为一个容器,该容器主要指映射(map)、集合(set)、数组(array)和列表(list)等抽象数据结构。

从本质上来说,Java集合框架的主要组成是用来操作对象的接口。不同接口描述不同的数据类型。

简单介绍:

Collection接口是最基本的接口,它定义了List和Set,List又定义了LinkLi

Table Driven(表驱动)方法实例

bijian1013

java enum Table Driven 表驱动

实例一:

/**

* 驾驶人年龄段

* 保险行业,会对驾驶人的年龄做年龄段的区分判断

* 驾驶人年龄段:01-[18,25);02-[25,30);03-[30-35);04-[35,40);05-[40,45);06-[45,50);07-[50-55);08-[55,+∞)

*/

public class AgePeriodTest {

//if...el

Jquery 总结

cuishikuan

java jquery Ajax Web jquery方法

1.$.trim方法用于移除字符串头部和尾部多余的空格。如:$.trim(' Hello ') // Hello2.$.contains方法返回一个布尔值,表示某个DOM元素(第二个参数)是否为另一个DOM元素(第一个参数)的下级元素。如:$.contains(document.documentElement, document.body); 3.$

面向对象概念的提出

麦田的设计者

java 面向对象 面向过程

面向对象中,一切都是由对象展开的,组织代码,封装数据。

在台湾面向对象被翻译为了面向物件编程,这充分说明了,这种编程强调实体。

下面就结合编程语言的发展史,聊一聊面向过程和面向对象。

c语言由贝尔实

linux网口绑定

被触发

linux

刚在一台IBM Xserver服务器上装了RedHat Linux Enterprise AS 4,为了提高网络的可靠性配置双网卡绑定。

一、环境描述

我的RedHat Linux Enterprise AS 4安装双口的Intel千兆网卡,通过ifconfig -a命令看到eth0和eth1两张网卡。

二、双网卡绑定步骤:

2.1 修改/etc/sysconfig/network

XML基础语法

肆无忌惮_

xml

一、什么是XML?

XML全称是Extensible Markup Language,可扩展标记语言。很类似HTML。XML的目的是传输数据而非显示数据。XML的标签没有被预定义,你需要自行定义标签。XML被设计为具有自我描述性。是W3C的推荐标准。

二、为什么学习XML?

用来解决程序间数据传输的格式问题

做配置文件

充当小型数据库

三、XML与HTM

为网页添加自己喜欢的字体

知了ing

字体 秒表 css

@font-face {

font-family: miaobiao;//定义字体名字

font-style: normal;

font-weight: 400;

src: url('font/DS-DIGI-e.eot');//字体文件

}

使用:

<label style="font-size:18px;font-famil

redis范围查询应用-查找IP所在城市

矮蛋蛋

redis

原文地址:

http://www.tuicool.com/articles/BrURbqV

需求

根据IP找到对应的城市

原来的解决方案

oracle表(ip_country):

查询IP对应的城市:

1.把a.b.c.d这样格式的IP转为一个数字,例如为把210.21.224.34转为3524648994

2. select city from ip_

输入两个整数, 计算百分比

alleni123

java

public static String getPercent(int x, int total){

double result=(x*1.0)/(total*1.0);

System.out.println(result);

DecimalFormat df1=new DecimalFormat("0.0000%");

百合——————>怎么学习计算机语言

百合不是茶

java 移动开发

对于一个从没有接触过计算机语言的人来说,一上来就学面向对象,就算是心里上面接受的了,灵魂我觉得也应该是跟不上的,学不好是很正常的现象,计算机语言老师讲的再多,你在课堂上面跟着老师听的再多,我觉得你应该还是学不会的,最主要的原因是你根本没有想过该怎么来学习计算机编程语言,记得大一的时候金山网络公司在湖大招聘我们学校一个才来大学几天的被金山网络录取,一个刚到大学的就能够去和

linux下tomcat开机自启动

bijian1013

tomcat

方法一:

修改Tomcat/bin/startup.sh 为:

export JAVA_HOME=/home/java1.6.0_27

export CLASSPATH=$CLASSPATH:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar:.

export PATH=$JAVA_HOME/bin:$PATH

export CATALINA_H

spring aop实例

bijian1013

java spring AOP

1.AdviceMethods.java

package com.bijian.study.spring.aop.schema;

public class AdviceMethods {

public void preGreeting() {

System.out.println("--how are you!--");

}

}

2.beans.x

[Gson八]GsonBuilder序列化和反序列化选项enableComplexMapKeySerialization

bit1129

serialization

enableComplexMapKeySerialization配置项的含义

Gson在序列化Map时,默认情况下,是调用Key的toString方法得到它的JSON字符串的Key,对于简单类型和字符串类型,这没有问题,但是对于复杂数据对象,如果对象没有覆写toString方法,那么默认的toString方法将得到这个对象的Hash地址。

GsonBuilder用于

【Spark九十一】Spark Streaming整合Kafka一些值得关注的问题

bit1129

Stream

包括Spark Streaming在内的实时计算数据可靠性指的是三种级别:

1. At most once,数据最多只能接受一次,有可能接收不到

2. At least once, 数据至少接受一次,有可能重复接收

3. Exactly once 数据保证被处理并且只被处理一次,

具体的多读几遍http://spark.apache.org/docs/lates

shell脚本批量检测端口是否被占用脚本

ronin47

#!/bin/bash

cat ports |while read line

do#nc -z -w 10 $line

nc -z -w 2 $line 58422>/dev/null2>&1if[ $?-eq 0]then

echo $line:ok

else

echo $line:fail

fi

done

这里的ports 既可以是文件

java-2.设计包含min函数的栈

bylijinnan

java

具体思路参见:http://zhedahht.blog.163.com/blog/static/25411174200712895228171/

import java.util.ArrayList;

import java.util.List;

public class MinStack {

//maybe we can use origin array rathe

Netty源码学习-ChannelHandler

bylijinnan

java netty

一般来说,“有状态”的ChannelHandler不应该是“共享”的,“无状态”的ChannelHandler则可“共享”

例如ObjectEncoder是“共享”的, 但 ObjectDecoder 不是

因为每一次调用decode方法时,可能数据未接收完全(incomplete),

它与上一次decode时接收到的数据“累计”起来才有可能是完整的数据,是“有状态”的

p

java生成随机数

cngolon

java

方法一:

/**

* 生成随机数

* @author

[email protected]

* @return

*/

public synchronized static String getChargeSequenceNum(String pre){

StringBuffer sequenceNum = new StringBuffer();

Date dateTime = new D

POI读写海量数据

ctrain

海量数据

import java.io.FileOutputStream;

import java.io.OutputStream;

import org.apache.poi.xssf.streaming.SXSSFRow;

import org.apache.poi.xssf.streaming.SXSSFSheet;

import org.apache.poi.xssf.streaming

mysql 日期格式化date_format详细使用

daizj

mysql date_format 日期格式转换 日期格式化

日期转换函数的详细使用说明

DATE_FORMAT(date,format) Formats the date value according to the format string. The following specifiers may be used in the format string. The&n

一个程序员分享8年的开发经验

dcj3sjt126com

程序员

在中国有很多人都认为IT行为是吃青春饭的,如果过了30岁就很难有机会再发展下去!其实现实并不是这样子的,在下从事.NET及JAVA方面的开发的也有8年的时间了,在这里在下想凭借自己的亲身经历,与大家一起探讨一下。

明确入行的目的

很多人干IT这一行都冲着“收入高”这一点的,因为只要学会一点HTML, DIV+CSS,要做一个页面开发人员并不是一件难事,而且做一个页面开发人员更容

android欢迎界面淡入淡出效果

dcj3sjt126com

android

很多Android应用一开始都会有一个欢迎界面,淡入淡出效果也是用得非常多的,下面来实现一下。

主要代码如下:

package com.myaibang.activity;

import android.app.Activity;import android.content.Intent;import android.os.Bundle;import android.os.CountDown

linux 复习笔记之常见压缩命令

eksliang

tar解压 linux系统常见压缩命令 linux压缩命令 tar压缩

转载请出自出处:http://eksliang.iteye.com/blog/2109693

linux中常见压缩文件的拓展名

*.gz gzip程序压缩的文件

*.bz2 bzip程序压缩的文件

*.tar tar程序打包的数据,没有经过压缩

*.tar.gz tar程序打包后,并经过gzip程序压缩

*.tar.bz2 tar程序打包后,并经过bzip程序压缩

*.zi

Android 应用程序发送shell命令

gqdy365

android

项目中需要直接在APP中通过发送shell指令来控制lcd灯,其实按理说应该是方案公司在调好lcd灯驱动之后直接通过service送接口上来给APP,APP调用就可以控制了,这是正规流程,但我们项目的方案商用的mtk方案,方案公司又没人会改,只调好了驱动,让应用程序自己实现灯的控制,这不蛋疼嘛!!!!

发就发吧!

一、关于shell指令:

我们知道,shell指令是Linux里面带的

java 无损读取文本文件

hw1287789687

读取文件 无损读取 读取文本文件 charset

java 如何无损读取文本文件呢?

以下是有损的

@Deprecated

public static String getFullContent(File file, String charset) {

BufferedReader reader = null;

if (!file.exists()) {

System.out.println("getFull

Firebase 相关文章索引

justjavac

firebase

Awesome Firebase

最近谷歌收购Firebase的新闻又将Firebase拉入了人们的视野,于是我做了这个 github 项目。

Firebase 是一个数据同步的云服务,不同于 Dropbox 的「文件」,Firebase 同步的是「数据」,服务对象是网站开发者,帮助他们开发具有「实时」(Real-Time)特性的应用。

开发者只需引用一个 API 库文件就可以使用标准 RE

C++学习重点

lx.asymmetric

C++ 笔记

1.c++面向对象的三个特性:封装性,继承性以及多态性。

2.标识符的命名规则:由字母和下划线开头,同时由字母、数字或下划线组成;不能与系统关键字重名。

3.c++语言常量包括整型常量、浮点型常量、布尔常量、字符型常量和字符串性常量。

4.运算符按其功能开以分为六类:算术运算符、位运算符、关系运算符、逻辑运算符、赋值运算符和条件运算符。

&n

java bean和xml相互转换

q821424508

java bean xml xml和bean转换 java bean和xml转换

这几天在做微信公众号

做的过程中想找个java bean转xml的工具,找了几个用着不知道是配置不好还是怎么回事,都会有一些问题,

然后脑子一热谢了一个javabean和xml的转换的工具里,自己用着还行,虽然有一些约束吧 ,

还是贴出来记录一下

顺便你提一下下,这个转换工具支持属性为集合、数组和非基本属性的对象。

packag

C 语言初级 位运算

1140566087

位运算 c

第十章 位运算 1、位运算对象只能是整形或字符型数据,在VC6.0中int型数据占4个字节 2、位运算符: 运算符 作用 ~ 按位求反 << 左移 >> 右移 & 按位与 ^ 按位异或 | 按位或 他们的优先级从高到低; 3、位运算符的运算功能: a、按位取反: ~01001101 = 101

14点睛Spring4.1-脚本编程

wiselyman

spring4

14.1 Scripting脚本编程

脚本语言和java这类静态的语言的主要区别是:脚本语言无需编译,源码直接可运行;

如果我们经常需要修改的某些代码,每一次我们至少要进行编译,打包,重新部署的操作,步骤相当麻烦;

如果我们的应用不允许重启,这在现实的情况中也是很常见的;

在spring中使用脚本编程给上述的应用场景提供了解决方案,即动态加载bean;

spring支持脚本