【论文笔记】MLFF-GAN:A Multilevel Feature Fusion WithGAN for Spatiotemporal Remote Sensing Images

摘要

由于技术和预算的限制,单个遥感卫星的传感器往往难以同时具有高时间和高空间(HTHS)分辨率。在本文中,我们提出了一种新的生成对抗网络(MLFF-GAN)来生成融合HTHS图像。MLFF-GAN主要采用u-net类架构,其生成器由特征提取、特征融合和图像重建三个阶段组成。在特征提取与重建阶段,生成器采用编码和解码结构提取三组多层次特征(MLFs),可以解决高分辨率图像与低分辨率图像之间的巨大分辨率差异。在特征融合阶段,设计了自适应实例归一化(AdaIN)块来学习多时态图像之间的全局分布关系,并使用注意模块(AM)来学习小区域变化时的局部信息权值。所提出的MLFF-GAN在两个陆地卫星和中分辨率成像光谱仪(MODIS)上进行了测试

介绍

随着地球观测技术的不断发展,对时间序列遥感图像的需求不断增加。然而,由于技术和预算的限制,单个卫星产品往往无法同时获得高时间和高空间(HTHS)分辨率。具有高空间分辨率的卫星通常意味着一个较长的重访期。相反,具有短重访周期的卫星通常只能提供低空间分辨率。我们很自然地认为,通过结合多平台卫星数据,可以满足对HTHS数据的这一要求。例如,陆地卫星-8和中分辨率成像光谱仪(MODIS)波段具有相似的光谱响应函数。理论上,陆地卫星图像(高空间分辨率和低时间分辨率30米、16天)和MODIS图像(低空间分辨率和高时间分辨率500米、1天)可以融合生成HTHS图像(30米、1天)。具有地面细节的融合的类似陆地卫星的图像可用于变化检测、陆地覆盖分析、水监测等。一般来说,时空融合在预测时间需要n对高分辨率和低分辨率图像和m个低分辨率图像才能获得m个高分辨率图像。基于这种情况,大量的时空融合算法近年来,主要可以分为三类,基于权重的方法[1]-[5],分解方法[6]-[12],和基于学习的方法(浅学习[13]-[23]如贝叶斯学习和深度学习[24]-[37]如卷积神经网络(CNN))。

基于权重的方法假设对时空图像的像素量可以通过加权汇总来预测地面反射率的变化。典型的基于权重的方法是时空自适应反射率融合模型(STARFM)[1]算法。STARFM通过滑动窗口中像素的频谱、距离和时间来决定权重。增强的STARFM(ESTARFM)[2]考虑混合像素和纯像素之间的差异来修改STARFM的权重。改进版的ESTARFM(mESTARFM)[3]通过搜索相似像素的新方案提高了融合的精度。时空自适应反射率变化映射自适应算法(统计)[4]使用多幅低分辨率图像检测反射率变化,从而更准确地预测局部光谱变化。拟合(RM拟合)、空间滤波(SF)和残差补偿(RC),简称为Fit-FC [5],采用回归模型对两个观测值进行拟合和关联,然后通过空间滤波去除块伪影,最后采用残差补偿来保持光谱信息。

基于权重的方法的优点如下: 1)它们不需要从许多外部数据中学习大量的参数,因此在大多数情况下它们是快速和稳定的,2)它们在符合同质假设的领域中性能良好。缺点如下: 1)他们假设融合中存在均匀区域,这在大多数情况下还不够合理,2)他们重建细节的能力不够强,因为其权重模型类似于低通滤波器,往往会平滑一些细节。

基于解混的方法假设低分辨率图像中的像素是由高分辨率端元件的线性组合组成的。这些方法大多使用像素预分类作为最终成员。多传感器多分辨率技术(MMT)[6]将高分辨率图像分类为最终成员,评估低分辨率图像的丰度,最后在丰度不变的假设下重建图像。时空数据融合方法(STDFA)方法[7]假设土地覆盖类型随时间保持不变。将通过解混得到的两幅相邻高分辨率图像的反射率变化分配给低分辨率图像。在STDFA的基础上,增强的时空数据融合模型(ESTDFM)[8]加强了分类算法,并增加了滑动窗口和时间权重,从而提高了算法的预测能力。为了解决STDFA中的传感器差和空间变异性问题,改进的STDFA(ISTDFA)[9]采用线性回归消除传感器差,并采用加权线性混合模型调整表面反射率的空间变异性。灵活的时空数据融合(FSDAF)[10]结合了解混和加权两种方法。该算法计算均匀区域的光谱变化,通过插值算法预测空间变化,最后利用光谱和空间特征的加权和得到高分辨率图像。SFSDAF(一种增强的包含亚像素类分数变化信息的FSDAF)[11]合并了亚像素类分数变化信息,使其更准确地掌握光谱信息的变化。在FSDAF 2.0 [12]中,通过边缘检测和变化检测,得到了更多的纯像素,这使得解混过程更加准确。同时,也应用变化检测来生成权重,从而得到更准确的预测。基于非混合化的方法具有非常明确的物理意义。它把核聚变作为一个反问题,它是不适定的。这种方法可以在一定程度上重建高空间分辨率图像上的突变和细节。然而,这些方法更强调谱域与空间域的关系,而不是时间域的关系。在时域内,他们通常假设不变量是丰富的。这种丰度不变的假设严重削弱了该方法的能力,因此融合往往表现出由末端成员的分类所产生的块效应。

基于学习的方法是一种数据驱动的方法,利用现有的数据集来训练模型,并找到空间和时间图像之间的关系。稀疏表示或字典学习方法是典型的浅层学习方法,如基于空间空间表示的时空反射率融合模型(SPSTFM)[13]。对这类方法进行了许多改进,如减少图像参考[14],增加正则化[15],以及使用结构稀疏性[16],[17]。贝叶斯方法利用观测数据,通过计算最大后验概率来求解时空融合。Li等人[18]和Huang等人[19],分别采用协方差函数和低通滤波来描述输入的高空间分辨率图像与低空间分辨率图像之间的关系。在[20]-[22]中,从长时间序列中获取信息,分别采用对时间序列图像的贝叶斯概率进行像素分解、联合高斯分布、卡尔曼法对目标图像进行滤波。其他的研究,如[23],使用贝叶斯语来选择训练过的字典。基于深度学习的方法通常使用CNN,CNN在大数据[24]、[25]的支持下具有强大的特征提取能力。通过网络结构和损失函数的设计,可以提高对时空融合的适应性,如使用深度CNN(STFDCNN)[26]、深度卷积时空融合网络(DCSTFN)[27]、增强DCSTFN [28]、双流卷积神经网络(StfNet)[29]、偏驱动时空融合模型(BiaSTF)[31]、空间、传感器和时间时空融合(SSTSTF)[34]。近年来,生成对抗网络(GAN)方法作为深度学习的一个分支,在图像生成[38]-[40]、风格转移[41]、[42]、超分辨率重建[43]、[44]等领域都取得了巨大的成功。GAN方法在图像生成领域具有许多优势。在时空融合中,GAN方法也有了一定的应用。近年来,利用GAN(STFGAN)[35]的遥感图像时空融合方法采用了GAN(SRGAN)[43]超分辨率的思想,解决了时空融合作为超分辨率问题。基于GAN的时空融合模型(GAN-STFM)[36]设计了一种更灵活的条件GAN图像预测方法。CycleGANSTF [37]将图像融合作为数据增强问题,然后选择信息最丰富的图像作为融合结果。基于gan的方法在时空融合方面具有很好的性能。然而,在时空融合中有许多特殊性有待进一步考虑。生成器或鉴别器的体系结构、损失函数、特征提取或融合方案都需要适应于时空融合。

对于遥感时空融合,困难主要来自三个方面:1)时间维度、土地特征变化(洪水、物候等剧烈不确定性和土地类型变化)难以通过相邻时间的图像预测;2)空间维度上,高分辨率图像与低分辨率图像的巨大差异使得重建详细纹理非常困难;3)对于不同的传感器,在成像过程中不可避免地会出现系统误差,如成像条件(大气或太阳天顶角)、器件差异(光谱响应或模传递函数)等。

上述三个困难使其成为时空融合的一个非常具有挑战性的问题。大多数模型驱动的方法,如加权法、基于分解的方法等,只使用少量的内部数据和非常有限的数据先验,因此不能同时综合解决这三个困难点。因此,非常有必要使用更多的外部数据集来学习更多的先验和特征。通过基于学习的方法,在时间、空间和传感器维度上的特征都可以以适当和有效的方式组织起来。

然而,现有的数据驱动或基于学习的方法并没有为遥感时空融合的三个难题提供非常有针对性的改进方案。

在本文中,我们设计了一个GAN帧的编码-解码结构来学习图像融合的多层特征(mlf),并明确地考虑了时空融合的三个差异点。在提出的方案中,考虑了MLF融合GAN(MLFF-GAN)架构、巨大的分辨率差异、巨大的特征变化和传感器的系统误差。设计了一个注意模块(AM)来处理时间维数上图像局部差异的变化,并引入自适应实例归一化(AdaIN)[45]来学习系统误差或全局差异;同时,我们将生成网络的主干结构构造为一个类似u-net的CNN,以处理巨大的分辨率差异。这种综合结构提高了MLFF-GAN融合的特征学习能力和泛化能力。我们还进行了对比实验和消融实验来验证不同部分在MLFF-GAN融合中的有效性。

其余的内容按组织方式排列如下。在第二节中,详细介绍了MLFF-GAN的基本体系结构和损失函数。在第三节中,我们进行了对比实验和烧蚀实验,以验证了所提方法的有效性。在第四节中,我们结束了这篇文章。

方法

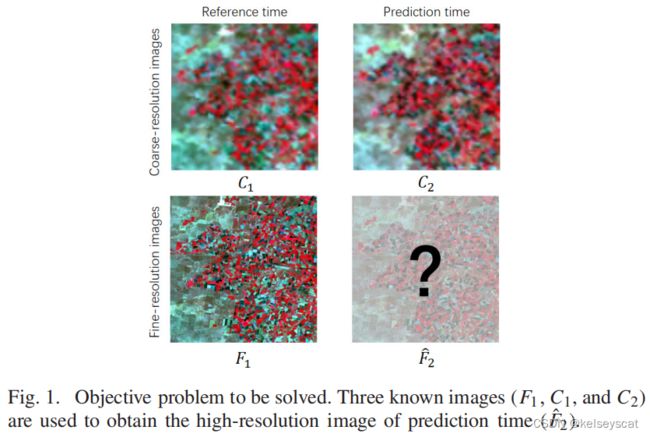

如图1所示,我们通过一对t1时刻的图像F1、C1和t2时刻的低分辨率图像C2来预测t2时刻的高分辨率图像F2。一般来说,在预测阶段,t1和t2是两个接近但不同的时间。

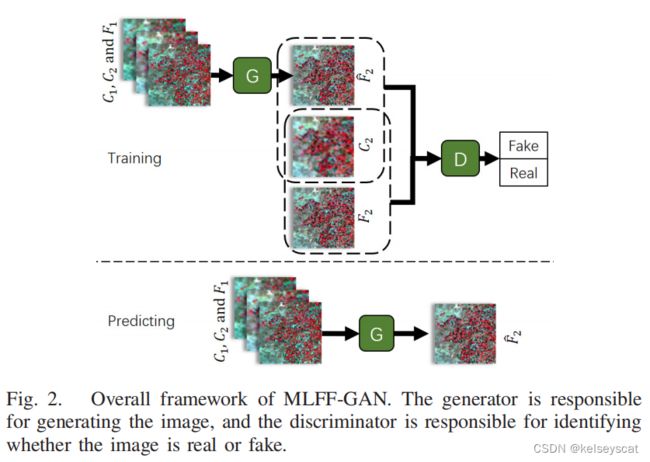

与其他GAN模型类似,如图2所示,MLFFGAN由发生器和鉴别器两部分组成。生成器负责通过输入数据F1、C1和C2生成融合图像,同时鉴别器对生成的图像和真实图像进行判断。交替训练发电机和鉴别器,以提高它们的能力。经过训练后,我们使用生成器来预测融合图像,因此生成器是该方法的关键。该生成器设计为u型网状结构,分为特征提取、特征融合、和图像重建三个阶段。 该鉴别器是一个简单的CNN结构。在下面,我们将详细讨论拟议的MLLF-GAN。

A. 生成的对抗性网络

在说明所提出的MLFF-GAN之前,我们首先需要简单地回顾一下传统GAN的特性。GAN首先是在[38]中提出的,它由生成器G和鉴别器d组成。生成器G学习从噪声z到真实数据x的复杂映射关系,并试图将噪声pz (z)的分布映射到真实数据pdata (x)的分布。鉴别器D通过训练来区分生成的数据G (z)与真实数据x之间的差值,并输出一个0-1范围的矩阵来判断数据是真实的还是假的。对于时空融合问题,由于输入信息的特殊性,保证了GAN训练的稳定性,所采用的MLFF-GAN的GAN损失为最小二乘GAN(LSGAN)。LSGAN的目标函数被表示为

其中,a、b和c都是常数。当b−c=1和b−a=2时,对象函数等同于皮尔逊X^2散度。

在提出的MLFF-GAN中,我们使用条件LSGAN的对象函数作为其基本的GAN框架。发电机的输入端分别为F1、C1和C2。同时,利用鉴别器来保证输出图像的质量。此外,MLFF-GAN不仅受到鉴别器的约束,还受到不同损失函数组合的约束。本节的其余部分将解释MLFF-GAN的发生器、鉴别器和损耗函数的设计。

B.生成器

MLLF-GAN的生成器包括特征提取、特征融合和图像重建三个阶段。该发电机的总体体系结构如图3所示。

我们可以将这三个阶段理解为一个新的U-net框架,它由一个收缩路径(左侧,特征提取)、特征融合(中间部分)和一个扩展路径(右侧,重建)组成。编码-解码(提取和重建)结构负责提高空间维度的分辨率。 特征融合部分分为全局信息转换和局部变化权值学习两个模块。全局信息转换模块主要处理AdaIN的全局分布和系统误差。局部变化权值模块主要通过AM处理时间维度上的局部特征变化。这些模块和编码-解码结构可以作为解决上述三个时空融合中具有挑战性的问题的解决方案。

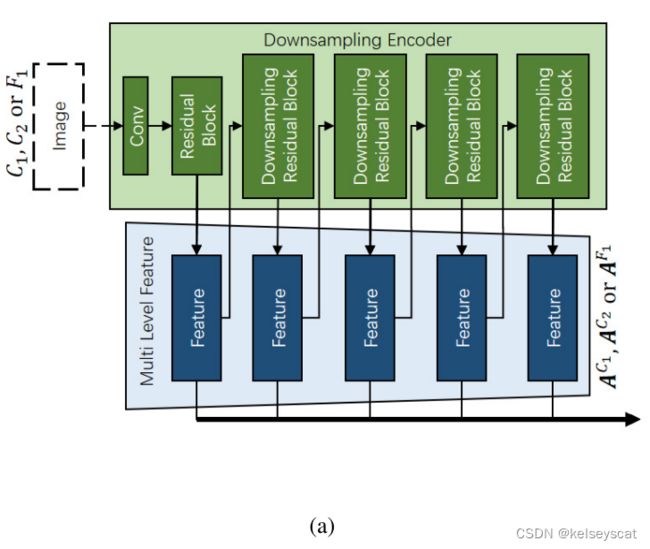

在特征提取阶段,通过连接多个下采样和卷积块来提取多源图像中的时空特征。深度CNN的优点之一是,它可以比传统方法更广泛、更深入地提取图像特征。由于U-net是一种对称结构,提取边和重构边都采用基于残差网络(ResNet)[46]的残差块作为基本块。残差块可以有效地防止梯度分散和梯度爆炸,从而可以顺利地保证模型的训练。与ResNet不同的是,生成器中的残差块去除批归一化,以获得更好的生成图像[47]质量。

如图3所示,通过特征提取阶段提取三组特征:一组空间特征![]() 和两组时间特征

和两组时间特征![]() 和

和![]() ,其中

,其中![]() ,

,![]() ,N是层数。为了获得不同层次的特征,该框架使用残差降采样块,即在残差块后面添加一个步长为2的卷积层。网络的多层数是根据高分辨率图像和低分辨率图像的分辨率放大率确定的。以Landsat和MODIS为例,分辨率比为500/30≈24,因此降采样块数为4,如图4(a).所示利用CNN和降采样,通过特征提取网络获得mlf。该设计对高分辨率图像进行分解,并在同一级别与低分辨率图像进行交换信息,为后续的融合阶段和重建阶段提供特征。

,N是层数。为了获得不同层次的特征,该框架使用残差降采样块,即在残差块后面添加一个步长为2的卷积层。网络的多层数是根据高分辨率图像和低分辨率图像的分辨率放大率确定的。以Landsat和MODIS为例,分辨率比为500/30≈24,因此降采样块数为4,如图4(a).所示利用CNN和降采样,通过特征提取网络获得mlf。该设计对高分辨率图像进行分解,并在同一级别与低分辨率图像进行交换信息,为后续的融合阶段和重建阶段提供特征。

在特征融合阶段,通过全局信息变换和局部变化权值学习对三幅输入图像的mlf进行融合,如图3(中间部分)所示。首先,使用A^F1和A^C2进行全局信息转换,设计用于处理光谱差异或成像条件差异等系统误差。其次,利用A^C1和A^C2来学习局部变化信息的权重,这是为土地覆盖的突变或物候变化而设计的。

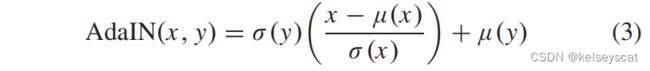

为了获取不同图像中的系统特征和全局特征,全局信息转换使用AdaIN [48]将C2的MLFs的全局分布转换为F1的MLFs。AdaIN最初用于GAN中的风格转换。该公式的记号为

其中,μ(x)为x的平均值,σ (x)为x的方差。通过x和y的均值和方差,AdaIN删除了x,然后将y的样式转换为x。在全局信息变换中,x为AF1的mlf,y为AC2的mlf。通过AdaIN,将F1的纹理和谱分布的总体特征转化为C2的纹理和谱,同时保留F1中各层次特征的空间详细信息。如图3和4(c)所示,转换后的MLFs记为![]() 。

。

AM负责学习时间维度上的局部变化。如图3和4(d)所示(中间部分),AM利用空间注意机制从A^C1和A^C2中学习权重,修改A^F1形成A^F2。利用深度学习的反向传播机制,网络学习在0-1范围内的每个级别i的权值图![]() ,以分配特征的显著性。 权重越大,变化就越大,分配给A^C2的比例也越大;权重越小,变化就越小,分配给ˆA^F1的比例也就越大。对于ˆA^F2 i的每个级别,公式被定义为

,以分配特征的显著性。 权重越大,变化就越大,分配给A^C2的比例也越大;权重越小,变化就越小,分配给ˆA^F1的比例也就越大。对于ˆA^F2 i的每个级别,公式被定义为

其中Mi是第七层的权重图,在MLFFGAN中,其中i=为0、1、2、3和4。每个级别的特征都对应于一个权重图。权值映射是一个由单层输出通道和一个函数的单层卷积输出的0-1矩阵输出。利用MLF ˆA^F2和MLF A^C2的最后一级特征![]() 来指导上采样重构网络。

来指导上采样重构网络。

对于图像重建阶段,重建网络的原理图如图3和4(b)所示。

提取特征后,将A^F1、A^C1、A^C2集成到新的精细特征ˆA^F2中。ˆA^F2将被重建成最终的融合图像ˆF2。

重构阶段与提取阶段对称,作为U-net架构。它由卷积块和上采样块组成。在上采样的过程中,有两组输入流。第一组是来自时刻t2时低空间分辨率图像的降采样编码器特征的最后一个特征(特征![]() ),第二组是由AdaIN和AM生成的融合特征ˆA^F2。

),第二组是由AdaIN和AM生成的融合特征ˆA^F2。

将这两个输入值相结合,通过连续的上采样来重建最终的图像。![]() 和在上采样解码器中产生的一系列新特征被认为是在预测时间t2的高分辨率图像的特征。同时,以ˆA^F2为参考特征,与上采样解码器中生成的特征连接起来,输入到上采样残差块中,如图4(b)所示。

和在上采样解码器中产生的一系列新特征被认为是在预测时间t2的高分辨率图像的特征。同时,以ˆA^F2为参考特征,与上采样解码器中生成的特征连接起来,输入到上采样残差块中,如图4(b)所示。

与提取网络类似,重构网络也使用残差块来保证梯度下降的稳定性。在残差块的前面添加反褶积层,形成上采样残差块,使特征尺寸增加一倍。重构网络中每个块的卷积输入是来自不同模块的特征,然后输出图像通过重构过程进行不同层次的特征。架构有两个优势: 1)大分辨率差异,降采样和上采样之间的空间匹配关系有助于分辨率提高,和2)在预测中等和高分辨率图像在不同的尺度,更有利于学习不变的特征和动态特征图像重建的过程。

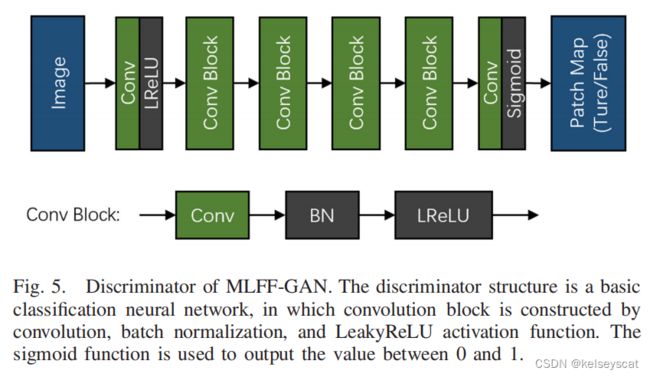

C. 判别器

如图5所示,MLFF-GAN的鉴别器是一个简单的二进制CNN,与PatchGAN [41]基本相同。与[38]中的传统鉴别器不同,在MLLF-GAN中,该鉴别器用于判断图像斑块是真实的观测图像还是融合图像。鉴别器的每个块由多个卷积层、实例归一化层[49]和漏的整流线性单元(LeakyReLU)激活函数组成。卷积操作使接受野的大小保持在70×70。在鉴别器的训练阶段,当其输入为F2和C2时,期望得到所有真矩阵,当其输入为ˆF2和C2时,期望得到所有假矩阵。这个鉴别器的参数比生成器少得多,因为它只需要通过深度网络进行抽象和泛化。由鉴别器提供的对抗性函数可以帮助生成器获得更高质量的结果。此外,对于单个遥感图像中相对位置关系较弱,斑块识别方法具有一定的优势。

D. 损失函数

所提出的MLFF-GAN中发电机的损失函数主要由两种类型组成: GAN损失(LGAN)和图像内容的损失。图像内容损失包括L1损失、频谱损失和结构损失。GAN损失与LSGAN中相应的部分相同,记为

L_GAN更像是一个传统的损失函数,它可以保证输出图像数据集的积分分布与输入图像数据集的积分分布相同。

鉴别器的目的是识别生成的图像是真实的还是假的,所以L_GAN (D)是鉴别器的最终损失。但是,为了保持对生成图像的约束,除了L_GAN (G)之外,图像本身的损失的设计是为了确保生成图像的真实性。我们注意到,有许多方法[28]、[35]、[36]利用自我设计的预训练网络的特征计算出的感知损失来保证图像生成的质量。此外,在自然图像的样式转移和超分辨率[43]、[51]、[52]中,经常使用预先训练好的VGG网络的特征来计算感知损失,以获得更好的图像结果。在实验中,我们发现,利用预先训练好的VGG特征设计的感知损失,会使图像的整体光谱和纹理发生很大的变化,因为自然图像和卫星图像在本质上有很大的不同。此外,利用自设计的预训练网络特征设计的感知损失生成的图像与利用图像内容损失生成的图像,即MLFF-GAN损失生成的图像几乎相同。尽管如此,使用图像内容的损失生成的图像使定量的评价更好。因此,我们的损失函数是直接在图像上计算的,而不是在感知损失函数等特征上计算的。

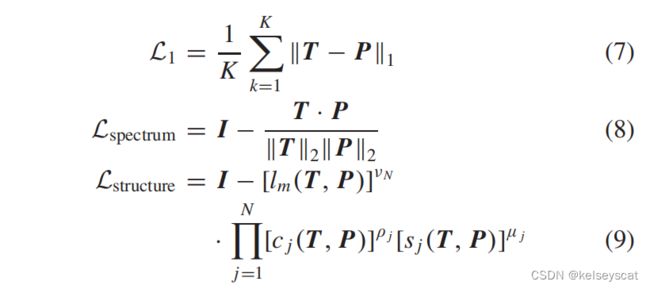

L1损失用于保持生成的图像与真实图像在相同像素位置的值相等,如(7)所示。为了获得生成的遥感图像的光谱真实性和结构真实性,分别计算了真实图像与生成图像之间的余弦相似度和多尺度结构相似度(MS-SSIM)[53]。余弦相似度记为(8)所示,MS-SSIM记为(9)所示

式中,T为地面真值图像矩阵(如F2),P为预测图像矩阵[如G(F1、C1、C2)],![]() 为p范数,K为图像的像素数,I为图像的1的张量。在(9)中,N为最高尺度的个数,l_j、c_j、s_j为亮度、对比度比较和结构比较。ν_N、ρ_j和ν_j为对应的权值系数。

为p范数,K为图像的像素数,I为图像的1的张量。在(9)中,N为最高尺度的个数,l_j、c_j、s_j为亮度、对比度比较和结构比较。ν_N、ρ_j和ν_j为对应的权值系数。

实验和结果

A.研究区域和数据集

在实验中,我们使用了社区灌溉区(CIA)1和较低的Gwydir流域(LGC)2的开源数据集,对所提出的模型进行了测试。

CIA是澳大利亚一个夏季作物种植区的图像数据集。南北方向高度43 km,东西方向宽度51 km。该数据集由陆地卫星-7增强型主题映射器+(陆地卫星-7 ETM+)和MODIS MODTRAN4产品的图像对组成。陆地卫星-7 ETM+的图像大小为1720×2040。对于每一对图像,MODIS图像被插值到与陆地卫星-7图像相同的大小。在CIA和LGC中,陆地卫星-7 ETM+和MODIS图像的带号都是6。在中央情报局的数据集中有17对无云的图像。在CIA中,随着时间的变化,图像中的物候变化很明显。

另一个数据集LGC是关于新威尔士州北部的流域区域的。南北方向高度80 km,东西方向宽度68 km。图像对为陆地卫星-5主题映射器(陆地卫星-5TM)图像和MODIS MOD09GA产品图像。陆地卫星-5tm的图像大小为3200×2720。同样地,MODIS数据被上采样到与陆地卫星图像相同的大小。在LGC数据集中有14对图像。由LGC提供的场景主要是分水岭区域。随着时间的变化,土地覆盖范围发生了显著的变化。

B.实验设置

本文设计了四部分实验来验证所提出的MLFF-GAN方法。首先,我们将MLFF-GAN与五种最先进的算法(FSDAF [10],BiaSTF [31]、增强型DCSTFN(EDCSTFN)[28]、GAN-STFM [36],和SSTSTF [34])进行了比较,以证明其有效性。其次,我们通过消融生成器中其结构的不同部分来说明MLFF-GAN中不同部分的功能。第三,我们还测试了MFLL-GAN的两个图像输入的场景,并将它们与三个图像输入的结果进行了比较。最后,讨论了网络训练和预测的计算负载和时间消耗。

除了GAN-STFM算法[36]外,在时间附近的图像对也被划分为一组。在CIA数据集中,训练数据为11组,由前10对图像组成,测试数据为其他5组,由最后6对图像组成。一组中的两对图像在时间上是相邻的。与CIA数据集类似,在LGC数据集中,训练数据为9组,测试数据为其他4组。在训练阶段,允许将后期的图像对作为已知图像,而允许将前期的低分辨率图像作为预测时输入的MODIS图像。

对于MLFF-GAN生成器,由于陆地卫星图像与MODIS图像的比例比约为16,因此下采样特征提取和上采样图像重建的网络分为四层。生成器的输入是一个六个波段的图像。下采样解码中每个块的信道数分别为16、32、64、128和256。与U-net相似,上采样的数字分别为256、128、64、32和16。此外,输出也是一个六波段的图像。

对于MLFF-GAN鉴别器,输入的波段为低分辨率图像和高分辨率图像,输入波段总数为12个。输出是一个在0-1范围内的矩阵,该值越接近1,图像就越真实。

实验采用4个评价指标:平均绝对误差(MAE)、均方根误差(RMSE)、光谱角映射器(SAM)[54]和SSIM指数[55]。MAE和RMSE是评价预测与地面真实值之间总体差异的指标。RMSE对异常值更为敏感。SAM用于评价结果的光谱失真程度。SAM值越大,光谱差值越大。SSIM用于测量预测和地面真实值之间的SSIM。SSIM值越高,说明两幅图像在纹理结构上更相似。

(10)中的参数α、β、γ和δ的值会影响所提出的融合方法的性能。它们是两种类型的损失,GAN损失和图像内容损失。参数α是GAN损失的权重,它保持了图像的真实性,这具体反映在图像的纹理清晰度上。如果没有α,融合图像将会变得模糊,缺乏一些细节。参数β、γ和δ为图像内容损失的权重。使用β,融合图像不仅具有全局统计意义上的估计,而且还具有局部对应的特征。γ将确保融合图像和输入图像之间的频谱相似性。δ将确保融合图像与输入图像之间的相似纹理结构相似。

在四种损失(L_GAN (G)、L1、L_spectrum和L_structure)中,L1损失是必不可少的,因为它直接计算预测图像与目标图像之间的差值。其他三个损失有助于使结果更好。这四个损失有一定的相关性和L1损失至关重要,我们让{α = 1×10−1,1×10−2,1×10−3},β=1,γ={0,0.5,1,1.5,2},δ={0,0.5,1,1.5,2}和进行了75组实验观察α的影响,γ,和δ的结果。定量指标评价如图6所示。

GAN损失通过不同α值生成的图像对生成图像质量的贡献如图7所示。

综合考虑定量指标和可视化结果,(10)中的参数设置为: α = 0.01和β = γ = δ = 1。

综合考虑定量指标和可视化结果,(10)中的参数设置为: α = 0.01和β = γ = δ = 1。

BiaSTF、GAN-STFM、SSTSTF和MLFF-GAN的训练学习速率设置为2×10−4,edcstfn的训练学习速率设置为1×10−3。在训练数据中,图像的裁剪间隔为200像素,模型的训练代数为200个epoch。

C. 实验结果及分析

在第III-C1和C2节中,我们使用这四个指标(MAE、RMSE、SAM和SSIM)对实验结果进行了定量评价;同时,我们也通过视觉质量比较来验证了所提出的方法。

1)对比实验:选择FSDAF、BiaSTF、EDCSTFN、GAN-STFM和SSTSTF五种方法进行比较。FSDAF是一种基于权重和分解的算法,作为一种非深度学习方法,具有良好的性能。BiaSTF、EDCSTFN、GAN-STFM和SSTSTF都是基于深度学习的方法。BiaSTF和EDCSTFN使用CNN的架构。GAN-STFM使用了GANs的体系结构。SSTSTF是一个多级网络,它由两个CNN网络和一个GAN网络组成。对于FSDAF、EDCSTFN、SSTSTF和MLFF-GAN,输入数据是预测时间的低分辨率图像和一对最近的低-高分辨率图像。对于BiaSTF,需要另外一对参考图像作为输入。对于GAN-STFM,输入数据是预测时间的低分辨率图像和最近的高分辨率图像。需要注意的是,SSTSTF方法与原论文中的方法略有不同。为了与我们的实验进行比较,我们将原论文SSTSTF中的四波段图像改为六波段图像。此外,我们注意到GAN-STFM算法只需要两张输入图像。

表I和表II分别显示了这六种算法在CIA数据集和LGC数据集上的定量指标评价。

对于如表I所示的CIA数据集,在大多数情况下,建议的MLFF-GAN显示出更好的性能。然而,FSDAF算法也表现出了一些良好的性能,在某些情况下,它的定量指标超过了一些深度学习方法。我们认为有两个原因:第一,CIA数据集中的特征是显而易见的,所以像素很容易被划分为正确的类别。对于FSDAF方法,这些类别是其在光谱分解中的最终成员,因此CIA数据集对FSDAF更友好。其次,CIA数据集的数据量相对较小,使得深度学习算法容易过拟合。此外,少量的数据不利于通过EDCSTFN或GAN-STFM等深度体系结构来学习时空特征。

对于如表I所示的CIA数据集,在大多数情况下,建议的MLFF-GAN显示出更好的性能。然而,FSDAF算法也表现出了一些良好的性能,在某些情况下,它的定量指标超过了一些深度学习方法。我们认为有两个原因:第一,CIA数据集中的特征是显而易见的,所以像素很容易被划分为正确的类别。对于FSDAF方法,这些类别是其在光谱分解中的最终成员,因此CIA数据集对FSDAF更友好。其次,CIA数据集的数据量相对较小,使得深度学习算法容易过拟合。此外,少量的数据不利于通过EDCSTFN或GAN-STFM等深度体系结构来学习时空特征。

LGC数据集的容量大于CIA数据,因此在表二中,深度学习算法(EDCSTFN、GAN-STFM和MFLL-GAN)比FSDAF具有更好的性能。SSTSTF在LGC数据集中表现较差。我们认为,上采样方法的不确定性导致了这一结果。BiaSTF在两个数据集中的表现都很差。在深度学习方法中,网络架构需要更适合时空融合才能具有更好的性能。时空融合作为一种不适定问题,仅使用模型驱动方案和手工特性很难获得良好的性能。在训练数据较大的情况下,具有大量参数的深度学习可以找到不同分辨率图像之间的映射关系,从而减少经验模型的预测误差。相对而言,深度学习方法的整体性能优于非深度学习方法,特别是表II。

在表I和表II中,与其他方法相比,MFLL-GAN最明显的优势是SAM指数。对于SSIM指数,MFLL-GAN的优势非常小。GAN-STFM的性能通常没有很大的优势,部分原因是它只使用了两个输入图像。

图8和9是对不同方法的视觉比较。AdaIN和AM的设计允许所提出的MFLL-GAN从局部和全球特征中检测不同区域的变化。图8和9(上)显示了来自不同算法的假颜色(波段4、3和2)的结果的全局图像,以及图。8(a)和9(a)(底部)显示了预测时真实的陆地卫星图像。图8和9(中间)是全局图像中白色框架内的放大区域。图中。8(b)-(g)和9(b)-(g)(底部)是不同方法的地面真相与预测结果之间的所有6个波段的绝对值差之和。图8(a)和9(a)是参考时间的真实图像与当前时间的真实图像之间的差值图。

在图8和9,请注意这些图。8(a)和9(a)(底部)是t1和t2之间的差值,但图8(b)-(g)和9(b)-(g)(底部)是真实图像和预测图像之间的差值,都在t2。

a) 对局部突变特征的融合受益于AM模块的设计: AM通过提取和比较MODIS图像在参考时间和预测时间的特征来生成权重图。该权重用于确定在参考时间注入高分辨率图像的特征或在预测时间注入低分辨率图像的特征时的强度。对于局部变化较强的小区域,高分辨率图像在参考时间的特征权重较大。这样,在该区域的参考时间与高分辨率图像保持融合特征一致,没有明显的变化。例如,在图8(a)的底部,图像中的红色圆圈是深蓝色的,这说明变化很小。对于图8(b)(下)所示的FSDAF算法,最终成员的分类过程不能随动态特征自适应变化,因此当不变的像素被划分为错误的类时,这些区域的偏差会非常明显。我们可以观察到,通过图8(c)-(f)(底部)中的深度学习方法,在这些区域也有很大的误差。由于深度学习方法可能过于依赖所学习到的经验,图8(c)-(f)(底部)在红色圆圈区域有更明显的预测误差。MLFF-GAN在这些领域表现最好,因为它的AM减少了对未改变的特性的误判。红色圆圈区域的部分几乎所有方法都显示出明显的预测误差。虽然对于图8(g)中的MLFF-GAN,红色圆圈区域也预测了错误的变化,并且由于AM模块的约束,错误的预测大大减弱。对于GAN-STFM,由于只取两张图像作为输入,网络会在预测时间将低分辨率图像的信息一定分配到参考时间的高分辨率图像中。不同传感器造成的误差很容易保留,如图8(e)所示,与之前图像差异较小的红圆区域会有较大的预测误差。同样,在LGC数据集上,图9(b)-(f)的红色圆圈区域也显示了与CIA数据集相同的结果。MLFF-GAN在预测时间与参考时间差异较小的情况下,MLFF-GAN的效果较好。

对于局部差异较大的部分,参考时间的高分辨率特征的权重较小,而低分辨率特征的权重较大,使得融合特征在变化较大的区域内具有更多的低分辨率预测时间光谱信息。在LGC数据集的图9(a)(黄色圆圈区域)中,我们可以看到,图9(g)中的MLFF-GAN比图9(c)-(f)在较大的范围内产生了更好的结果。同样,在CIA数据集中的图8(a)(两个黄色圆圈)中,与图8(b)-(f)相比,图8(g)对差异较大的部分的预测误差较小。

b) 全局光谱纹理的重建受益于AdaIN:它保持高分辨率图像的mlf在总体分布(如均值和方差)上的一致。在CIA数据集的图8(b)-(g)(底部左半部分)中,我们可以清楚地看到,与其他算法相比,MLFF-GAN在全局分布中更类似于真实图像。此外,MLFF-GAN在图8(g)的预测误差图中也表现得更好。在图像发生大规模变化的情况下,如LGC,AdaIN的优势更为明显。我们可以看到,在图9(g)(左半部分)中,与图9(b)-(f)相比,总体预测误差较小,与真实图像基本相似。

2)消融研究:共4个消融实验:1)删除U-Net架构(CAC)中的复制和裁剪,在解码器最后一层融合,上采样直到图像生成;2)采用CAC策略,但不添加AM和AdaIN,只对MLF进行平均转移;3)采用CAC,添加AM;4)添加CAC、AM、AdaIN。图中。10和11为视觉质量比较,表III和表IV为定量比较。

表三为CIA数据集上消融实验的定量实验评价。对于CIA数据集,在定量评估方面,当仅使用没有CAC、AM和AdaIN的CNN时,性能最差。只有使用CNN,特征在降采样中丢失了太多的信息,很难重建图像细节。虽然低分辨率图像的光谱信息在底部融合,但没有CAC的帮助,给整个图像的光谱信息带来了太多的不确定性。在表III和表IV中,在添加CAC后,网络可以捕获之前的细节,生成更高质量的图像,大大提高了所有实验日期的融合性能。

在表三中,当添加AM模块来确定使用不同分辨率的图像特征时的权重时,在大多数情况下会提高融合性能。添加AdaIN模块也可以通过确保融合结果与地面真实值之间的全局统计一致性来提高性能。从定量评价中可以看出,总体上,具有AM和AdaIN的发生器性能更好。然而,在4月17日和26日的两张图片中,AdaIN并没有显示出明显的效果。通过对图像的检查,我们发现,在这两个时期,大规模的变化相对较小,因此AdaIN的优势难以发挥出来。相反,只有针对本地特性的AM模块才有机会表现得更好。从4月26日SAM指数的表现可以看出,AdaIN模块对整体性能的影响更加积极。

为了进一步观察注意图在网络中的作用,我们将其输出到4月10日的CIA数据集的实验中,如图12所示。可以看出,注意的权重并不直接对应于图像的差异。公式(4)也意味着来自不同层的特征需要不同的注意权重图。与其他方法相比,M0更平滑,具有更少的噪声,更少的接受域,以及更丰富的权重信息。在M0尺度中,在C2不能反映纹理信息的区域,特别是农田部分,M0基本上给出了该尺度下![]() 的所有权重。在M1尺度中,虽然AM可以在图中可以提供少量的权重,但大部分是噪声,权重基本保持在0.3左右。

的所有权重。在M1尺度中,虽然AM可以在图中可以提供少量的权重,但大部分是噪声,权重基本保持在0.3左右。

这意味着网络给F1更多的权值来选择更多的空间信息,以确保生成图像的质量,而C2只占权值的一小部分,以保持生成结果的光谱质量。在M2尺度中,仍然有很多噪声,但从整体图像来看,弱纹理在C2上的重量明显高于其他部分。在M3和M4尺度中,它们通常不能在CIA数据集中提供具有可解释性的指导信息,它们大多是残余补偿,看起来像噪声。

对于表四中的LGC数据集,由于它是与洪水相关的数据,并且具有广泛的光谱信息变化范围,因此AdaIN模块显示出更强的优势。表三中的CIA数据集包含了许多块农田的局部变化,因此AM块将更有用。

图10和11显示了4月10日在CIA和11月25日在LGC上进行的每个消融实验的预测结果。在视觉比较中,图。10(b)和11(b)(中间)显示没有CAC生成的图像。它们都非常模糊,也缺乏细节。在图10(b)(底部)中,预测图像在较宽的范围内显示的极值较小。此外,在图11(b)(下)中,预测图像显示了很大范围的误差。由于没有CAC的模型只融合了解码器最后一层的特征,缺乏多层结构的信息,在重构过程中往往导致很大范围的预测不准确。在无花果中。10和11,请注意这个图。10(a)和11(a)(底部)是t1和t2之间的差值,但图。10(b)-(e)和11(b)-(e)(底部)是真实图像和预测图像之间的差值,都在t2

对比图10(c)-(e)(下),在AM和AdaIN模型中,部分农田区块的差异较小。然而,在大小为2-3像素的区域(红色区域)的大偏差不能被消除。由于差异权重是由两个低分辨率图像在不同的时间引导的,因此很难在图像之间找到不同的小尺度变化。然而,生成器的输入是两个低分辨率的双边插值图像,因此对于大尺度的变化区域更有效。

将图10(d)和(e)(下)与图11(d)和(e)(下)相比,AdaIN使整个误差图更加“单调”。对于绝对值差值图,如果有更多的深蓝色区域和更少的浅黄色区域,它通常是好的。加入高分辨率特征的AdaIN变换后,融合图像的预测时间总体统计特征与真实图像更相似,说明总体差异较小。

MLFs也是U-net在特征提取和图像重建阶段的重要改进。除了4个烧蚀实验外,为了证明MLF的有效性,我们增加了一个烧蚀实验来去除多级结构。比较计算消费,我们计算参数和乘积累操作[56],[57](MACs)使用256×256的图像6个乐队)的两种情况下,如表五所示。比较网络性能,两个网络的定量评估如表六所示。

网络参数和计算速度在表V,与融合显示大的优势没有融合相比,因为中间特性的大小大大减少和接受域多层次结构可以更好地适合特征融合不同的时间和空间分辨率。使用mlf的融合性能也有了明显的提高,如表六所示。

GAN损失最重要的功能是提高生成图像的质量,降低图像的模糊度。通过消融GAN损失证明了这一功能。如图7所示,生成的具有最优权重的图像具有更好的视觉表达式。此外,我们还注意到,由Piella和Heijmans [58]提出的融合评价指数的一个组成部分可以评价融合图像结果的边缘完整性和锐度。分量(e-SSIM)计算真实图像和融合图像的边缘检测结果之间的SSIM。

如表7和表VIII所示,使用GAN生成的图像对纹理清晰度有明显的优势。另外,对于其他四个指标,采用GAN损失的结果在SAM中只有一定的优势,是否采用GAN损失在MAE、RMSE和SSIM中没有明显的优缺点。

3)计算负荷:为了评估计算负荷,我们分别计算了深度学习方法的参数和mac。MACs是网络计算出具有6个波段的256×256图像所需的乘法累积运算的次数。结果见表九。需要注意的是,由于BiaSTF是一种单波段算法,因此BiaSTF显示了6倍的计算负载。SSTSTF的计算负载是对网络所有阶段的总结。

在5种深度学习算法中,BiaSTF和SSTSTF是多阶段深度学习方法。它们将导致更多的参数和计算。其中,SSTSTF中使用的超分辨率网络需要4.8×106参数和5.1×1010mac。该模型的便利性被非常忽略了。受益于多级网络,即使MLFF-GAN与GAN-STFM具有基本相同的参数数量,甚至比EDCSTFN具有更多的参数,计算的数量也要少得多。MLFF-GAN在测试速度方面具有一定的优势。

4)两输入图像和三输入图像的比较:在GAN-STFM中,模型只需要输入两幅图像就可以预测预测时间的高分辨率图像。我们简化了MLFF-GAN中的融合过程,并设计了两种输入图像的预测模式。新的熔合过程将取代图4(c)和(d).中的结构两个输入图像的融合模式如图13所示。

在两个输入图像的融合模式中,注意权重不是由两个低分辨率融合图像的特征决定的,而是由预测时的低分辨率图像和参考时的高分辨率图像的特征决定的。结果的定量评价如表X所示,为不同日期的所有测试集的平均值。

在三个输入模式下,低分辨率图像的特征均来自一个特征提取网络,该网络具有相同的空间特征水平,可以更好地对不同区域进行比较。总体而言,三个输入的预测模型优于两个输入的预测模型。

结论

本文提出了一种新的基于GANs的时空融合方法。所提出的MLFF-GAN综合考虑了三个难点,其生成器包括特征提取、特征融合和图像重建三个阶段。生成器的主干被设计为一个u-net样结构与编码器-解码器和mlf。在融合阶段,引入AdaIN来优化全局光谱分布,并利用AM来学习局部变化信息的权值。对所提出的MFLL-GAN和其他方法,如FSDAF、BiaSTF、EDCSTFN、GAN-STFM和SSTSTF进行了数量和质量上的比较。同时,在消融实验中评价CAC、AdaIN和AM的有效性。对于大分辨率间隙问题,CAC比传统的CNN具有更好的性能。通过AdaIN和AM,MFLL-GAN在突变区域和全局光谱和纹理特征上都表现出更好的性能。比较并分析了不同方法的计算负荷。我们还测试了一个简化的两个输入模型版本,以实现更灵活的预测。我们发现,由于三个输入模型利用了更多的数据和信息,因此它比两个输入模型具有更多的优势。总体而言,对比实验和消融实验均证实了MFLL-GAN在CIA数据集和LGC数据集上与其他五种方法相比的优势。

时空分辨率的巨大差异仍然是时空融合研究中的一个具有挑战性的问题。我们发现,大多数基于深度学习的方法在CIA数据集上通常比在LGC数据集上有更好的性能。原因可能是CIA的数量大于LGC。如何合理地利用更多的数据来解决空间域与时间域之间的矛盾是本研究的关键。在此基础上,这是一些新的深度结构的研究方向,可以更好地利用更多的历史数据来缓解季节或物候的干扰。