图网络究竟在研究什么?从15篇研究综述看图神经网络GNN的最新研究进展

近年来,由于图结构的强大表现力,用机器学习方法分析图的研究越来越受到重视。图神经网络(GNN)是一类基于深度学习的处理图域信息的方法。

到目前,相关研究的已经非常多了,不过我们回过头来看思考和回顾一下:

解决图(Graph)数据的方法和思路有那些,这些方法和思路跟图像文本有什么异同?

各大顶会提出的图网络模型有什么样的基本假设和主要功能?

常用数据集Cora, Citeseer, Pubmed等有没有统一一致的对比?

图神经网络和图嵌入的区别的是什么?

图网络能做什么,不能做什么,图网络表示的上界在哪里?

节点分类,链接预测,图分类的算法和模型都有哪些?

另外,有的图数据是非常小的,有的图数据(如微信社交网络,微博社交网络)是非常巨大的,那么针对小型图网络与巨型网络分别都有什么样的模型,研究的思路跟一般的图数据有什么区别?

最后,未来还有什么样的研究方向?

本文整理了15篇图神经网络(GNN)相关的文献综述,这15篇相关的文献综述从不同的角度对图神经网络的发展进行了详细的总结和概述。下面是本文整理的列表:

1. Deep Learning on Graphs: A Survey

清华大学 Ziwei Zhang, Peng Cui, Wenwu Zhu

2. Graph Neural Networks: A Review of Methods and Applications

清华大学Jie Zhou, Ganqu Cui, Zhengyan Zhang, Cheng Yang, Zhiyuan Liu, Lifeng Wang, Changcheng Li, Maosong Sun

3. A Comprehensive Survey on Graph Neural Networks

UTS等 Zonghan Wu, Shirui Pan, Fengwen Chen, Guodong Long, Chengqi Zhang, Philip S. Yu

4. A Gentle Introduction to Deep Learning for Graphs

University of Pisa Davide Bacciua , Federico Erricaa , Alessio Michelia , Marco Poddaa

5. LEARNING REPRESENTATIONS OF GRAPH DATA: A SURVEY

UCL Mital Kinderkhedia

6. Graph Neural Networks for Small Graph and Giant Network Representation Learning: An Overview

Information Fusion and Mining Laboratory Jiawei Zhang

7. A Survey on The Expressive Power of Graph Neural Networks

东京大学 Ryoma Sato

8. Relational inductive biases, deep learning, and graph networks

DeepMind;等

9. Adversarial Attack and Defense on Graph Data: A Survey

UIUC等Lichao Sun, Yingtong Dou, Carl Yang等

10. Heterogeneous Network Representation Learning: Survey, Benchmark, Evaluation, and Beyond

UIUC Carl Yang, Yuxin Xiao, Yu Zhang, Yizhou Sun, and Jiawei Han,

11 Automated Machine Learning on Graphs: A Survey

清华大学 Ziwei Zhang, Xin Wang, Wenwu Zhu

12. Graph Self-Supervised Learning: A Survey

Monash University等 Yixin Liu1 , Shirui Pan1 , Ming Jin1 , Chuan Zhou2 , Feng Xia3 , Philip S. Yu

13. Self-Supervised Learning of Graph Neural Networks: A Unified Review

Texas A&M University等 Yaochen Xie, Zhao Xu, Zhengyang Wang, Shuiwang Ji

14. Meta-Learning with Graph Neural Networks: Methods and Applications

Columbia University等

Debmalya Mandal, Sourav Medya, Brian Uzzi, Charu Aggarwal

15. Deep Graph Structure Learning for Robust Representations: A Survey

中科院自动化研究所:Yanqiao Zhu∗ , Weizhi Xu∗ , Jinghao Zhang∗ , Qiang Liu , Shu Wu† and Liang Wang

1. Deep Learning on Graphs: A Survey

时间:2018年12月首发,2020年3月更新至第三版

作者:Ziwei Zhang等

单位:清华大学

篇幅:24页

链接:https://arxiv.org/pdf/1812.04202.pdf

从声学、图像到自然语言处理,深度学习在许多领域都取得了成功。然而,将深度学习应用于无所不在的图数据并非易事,因为图形是一种非欧的数据结构,具有独特的特性。近年来,这一领域的研究取得了很大的进展,极大地推动了图分析技术的发展。在本研究中,作者全面回顾了应用于图深度学习各种方法。总结了现有的图网络类型,将现有的方法分为五类: 图递归神经网络、图卷积网络、图自编码器、图增强学习和图对抗方法。

相关报道与解读:

图网络|漫谈图神经网络模型;

图网络的五类模型(http://suo.im/5G6MdF)

以上五类模型的基本假设和主要功能

近年来不同神经网络的对比与总结

图自编码器总结与对比

图强化学习特性对比

图对抗学习特性对比

相关的学习框架总结:PyG; DGL; AliGraph; Euler

Cora, Citeseer, Pubmed, Reddit, PPI数据集模型性能全面总结

2. Graph Neural Networks: A Review of Methods and Applications

时间:2018年12月;2019年6月第四版

作者:Jie Zhou等

单位:清华大学

篇幅:22页,153篇参考文献

链接:https://arxiv.org/abs/1812.08434

该文总结了图神经网络领域的经典模型与典型应用(文本,图像,物理化学药学,知识图谱),并提出了四个开放性问题。对于希望快速了解这一领域的读者,不妨先从这篇文章看起。

很多学习任务都需要处理图数据,这些数据包含了元素之间丰富的关系信息。建模物理系统,学习分子指纹,预测蛋白质界面,以及疾病分类都需要模型从图形输入中学习。在从文本、图像等非结构化数据学习等领域,对提取出的句子依赖树、图像场景图等结构进行推理是一个重要的研究课题,也需要图形推理模型。图神经网络(GNNs)是一种连接主义模型,它通过在图的节点之间传递消息来获取图的依赖性。与标准神经网络不同的是,图神经网络保留了一种状态,这种状态可以用任意深度表示邻居的信息。虽然原始图神经网络很难训练成定点,但是最近在网络结构、优化技术和并行计算方面的进展使得利用它们进行成功的学习成为可能。

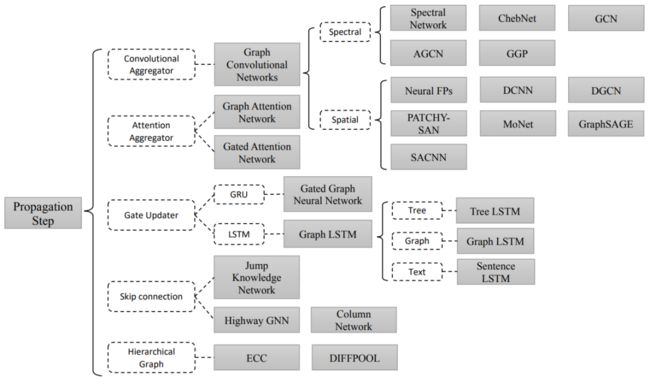

各类的图神经网络的Aggregator和Updater

图网络相关的应用

文章最后提出了图神经网络领域的四个开放问题:

1. 浅层结构。经验上使用更多参数的神经网络能够得到更好的实验效果,然而堆叠多层的 GNN 却会产生 over-smoothing 的问题。具体来说,堆叠层数越多,节点考虑的邻居个数也会越多,导致最终所有节点的表示会趋向于一致。

2. 动态图。目前大部分方法关注于在静态图上的处理,对于如何处理节点信息和边信息随着时间步动态变化的图仍是一个开放问题。

3. 非结构化场景。虽然很多工作应用于非结构化的场景(比如文本),然而并没有通用的方法用于处理非结构化的数据。

4. 扩展性。虽然已经有一些方法尝试解决这个问题,将图神经网络的方法应用于大规模数据上仍然是一个开放性问题。

相关报道与解读:

图神经网络综述:模型与应用(http://suo.im/5V9dkJ, 机器之心)

3. A Comprehensive Survey on Graph Neural Networks

时间:2019年1月首发,2019年12月第四版

作者:Zonghan Wu等

单位:悉尼科技大学等

本文偏向图模型的全面总结,与第一篇可以互补来看。本文对图网络提出了新的分类体系:图卷积网络、图注意力网络、图自编码器、图生成网络和图时空网络。确定了图神经网络和网络嵌入之间的区别,并在不同的图神经网络架构之间建立了联系。

“图嵌入旨在通过保留图的网络拓扑结构和节点内容信息,将图中顶点表示为低维向量空间,以便使用简单的机器学习算法(例如,支持向量机分类)进行处理。许多图嵌入算法通常是无监督的算法,它们可以大致可以划分为三个类别,即矩阵分解、随机游走和深度学习方法。同时图嵌入的深度学习方法也属于图神经网络,包括基于图自动编码器的算法(如DNGR和SDNE)和无监督训练的图卷积神经网络(如GraphSage)。下图描述了图嵌入和图神经网络在本文中的区别”

该综述提供了在图数据上的现代深度学习技术的全面概述。对每一种类型的图神经网络,提供了表征算法的细节描述,并做了必要的对比和对应算法的总结。这篇综述提供了图神经网络的丰富资源,其中包括当前最佳算法、基准数据集、开源代码和实践应用。这篇综述可以作为理解、使用和开发不同实际应用的深度学习方法的实践指南。这篇综述还强调了已有算法的当前限制,指出了这个快速发展领域未来的可能方向。

RecGNNs and ConvGNNs相关总结

GAE相关总结

常用Benchmark数据集总结

相关报道与解读:

- https://zhuanlan.zhihu.com/p/75307407;

- 图网络|漫谈图神经网络模型。

4. A Gentle Introduction to Deep Learning for Graphs

时间:2019年12月

作者:Davide Bacciu等

单位:Department of Computer Science, University of Pisa

篇幅:55页,共计131篇参考文献

链接:https://arxiv.org/pdf/1912.12693.pdf

图、图网络的研究一个经典的并且长期存在的主题,最近已与为深度学习结合引起了相关研究人员的广泛兴趣。相关研究的数量和广度迅速增加,但是缺乏系统化的知识梳理以及缺少对早期研究的关注。这项文献综述旨在作为图深度学习领域的教程。

与最新文献不同的是,本文主要介绍了相关的概念和结构,方便读者学习和查看。论文采用了自上而下思路,介绍了DNGNs(深度神经图网络)、DBGNs(深度贝叶斯图网络)和DGGNs(深度生成图网络),下面是论文的Roadmap。

5. LEARNING REPRESENTATIONS OF GRAPH DATA:

A SURVEY

时间:2019年6月

作者:Mital Kinderkhedia

单位:

Department of Statistical Science, University College London

篇幅:22页,139篇参考文献

链接:https://arxiv.org/pdf/1906.02989.pdf

深度神经网络在目标识别,图像分类和自然语言处理领域显示出了巨大的成功。但是,如何用深度学习设计可学习并且能够有效输出的图网络结构仍然是一个需要研究问题。本文综述的目的是总结和讨论图数据表示学习方法的最新研究进展。

本文首先确定图数据的常用类型,然后回顾图论基础。接下来讨论了图核方法与神经网络之间关系。然后,确定用于学习图数据表示的主要方法,即:内核方法,卷积方法,图神经网络方法,图嵌入方法和概率方法。该部分讨论了每种方法下的各种方法,并通过简要讨论图表示学习未来研究的内容。

下面是本文讨论的相关图数据

图论中部分基本的概念

6. Graph Neural Networks for Small Graph and Giant Network Representation Learning: An Overview

时间:2019年8月首发

作者:Jiawei Zhang

单位:Information Fusion and Mining Laboratory

篇幅:30页,参考文献9

链接:https://arxiv.org/abs/1908.00187

研究的图数据通常可分为两种主要类型,即小型图网络与巨型网络,它们在大小,编号和标签注释方面差异很大。在本文中,作者对于这两种不同类型的图数据,介绍近年来引入的图神经网络。更具体地说,本文介绍的图神经网络包括IsoNN [4],SDBN [7],LF&ER [6],GCN [3],GAT [5],DifNN [8],GNL [1],GraphSage [2]和seGEN [9]。在这些图神经网络模型中,最初为小图提出了IsoNN,SDBN和LF&ER,而其余的则最初为巨人网络提出了。

小规模图网络的方法一览

大规模图网络学习方法一览

大规模图网络下采样方式的图嵌入

7. A Survey on The Expressive Power of Graph Neural Networks

时间:2020年3月

作者:Ryoma Sato

作者单位:Kyoto University / RIKEN AIP

篇幅:41页

链接:https://arxiv.org/abs/2003.04078

图神经网络到底有多么的强大呢?来自日本京都大学学者从较为理论的角度写了一篇相关的研究综述,主要探究图网络与WL test的关系,以及图网络能够解决的问题和图网络不能够解决的问题。

图神经网络是解决各种图学习问题的有效的机器学习模型。尽管它们取得了经验上的成功,但是GNNs的理论局限性最近已经被揭示出来。因此,人们提出了各式各样的GNN模型来攻克这些限制。在该研究综述中,作者全面概述了GNNs的表达能力和可证明的强大的GNNs变体。下面是本文的主要章节:Section 2 GNN不能判别的例子; Section 3 GNN与WL algorithm的联系; Section 4 GNN能够和不能够解决的组合问题; Section 5 GNN, WL algorithm 以及 distributed local algorithm的关系

8. Relational inductive biases, deep learning, and graph networks

时间:2018年6月首发;2018年11月第三版

作者:Peter W. Battaglia等

单位:1DeepMind; 2Google Brain; 3MIT; 4University of Edinburgh

篇幅:40页

链接:https://arxiv.org/pdf/1806.01261.pdf

这篇文章联合了DeepMind、谷歌大脑、MIT和爱丁堡大学的27名作者(其中22人来自DeepMind),用37页的篇幅,对关系归纳偏置和图网络(Graph network)进行了全面阐述。 在论文里,作者探讨了如何在深度学习结构(比如全连接层、卷积层和递归层)中,使用关系归纳偏置(relational inductive biases),促进对实体、对关系,以及对组成它们的规则进行学习。

论文提出了一个新的AI模块——图网络(graph network),对以前各种对图进行操作的神经网络方法的推广和扩展。图网络具有强大的关系归纳偏置,为操纵结构化知识和生成结构化行为提供了一个直接的界面。作者还讨论了图网络如何支持关系推理和组合泛化,为更复杂、可解释和灵活的推理模式打下基础。

相关报道与解读:图网络让深度学习也能因果推理(http://suo.im/5V9FBj)

9. Adversarial Attack and Defense on Graph Data: A Survey

把对抗思想应用到图数据是一个自然的过程,而且其在具体应用场景中也有广泛的案例,例如在在线社交网络中,水军账户通过关注正常账户,发布日常内容,来降低自己在社交网络的中可疑度,从而避免被检测到而封号。

图数据对抗攻击的定义是:给定一个图(节点和边),通过修改这个图,使得这种修改在不被察觉到情况下,能够降低算法(例如节点分类和链接预测)在图数据上面的表现。

和优化问题相似,攻击方的目标是在一定约束的条件下最大可能地干扰算法的表现。在KDD 2018 [1]的文章中,作者将图被修改之后带来的变化定义为perturbations(扰动),即攻击者对图数据的攻击后的扰动必须满足与一些约束。例如,我们加边或者减边不能太多条,要保持图的基本结构等等,这是对抗攻击实现的前提。

[1] Zügner, Daniel, Amir Akbarnejad, and Stephan Günnemann. "Adversarial attacks on neural networks for graph data." In Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining, pp. 2847-2856. ACM, 2018

根据图数据的特点,可以图数据对抗攻击任务分为三类:

节点相关的任务(Node-related Task):对节点分类任务还有对节点嵌入(node embedding)的攻击都属于节点层面的攻击,其目的是让分类器分错,降低其精确率或者召回率。因为节点分类是目前图数据的主要任务,因此大部分图数据对抗攻击论文都有研究到节点分类任务;

链接相关的任务(Link-related Task):链接预测(Link Prediction)是图数据上面的另一个主要任务,推荐系统,知识图谱,社交网络都用到它。对于链接层面的攻击,主要目的让算法预测到错的链接目标;

全图相关的任务(Graph-related Task):全图相关的任务主要是对整个图的分类,常见于对生物结构的分类任务。一般是学习图整体结构的低维嵌入,然后进行分类

相关的章节目录

p 3: 从各种视角对当前的攻击方法进行分类。

p 4:对典型的算法进行回顾。

p 5: 根据防御策略对当前的防治措施进行分类,并且对每一类中的代表性算法进行回顾。

p 6: 基于我们开发的知识库进行相关的研究和探讨,该知识库可以对基于图的攻击和防御提供一个全面的理解。

p 7: 对该领域未来的方向和前景进行探讨。

相关报道与解读:【综述】基于图的对抗式攻击和防御,附22页论文下载

10. 异质图

时间:2020年4月1日

作者:UIUC Carl Yang, Yuxin Xiao, Yu Zhang, Yizhou Sun, and Jiawei Han,

单位:UIUC等 Heterogeneous Network Representation Learning: Survey, Benchmark, Evaluation, and Beyond

这篇论文文章结构如下,第2节首先介绍作者提出的通用HNE范式。随后,第3节对代表性模型进行了概念上的分类和分析。然后,在第4节中提供了基准数据集,并进行了深入的分析。在第5节中,对10种常用的HNE算法进行了系统而全面的实证研究,对HNE的发展现状进行了评价。第六部分是对未来HNE平台使用和研究的展望。

异构网络示例

异构网络示例

算法分类

Proximity-Preserving Methods

如前所述,网络嵌入的一个基本目标是捕获网络拓扑信息。这可以通过在节点之间保留不同类型的邻近性来实现。在HNE中,有两类主要的接近性保护方法:基于随机步法的方法(灵感来自DeepWalk[49])和基于一阶/二阶接近性的方法(灵感来自LINE[72])。

Message-Passing Methods

网络中的每个节点都可以将属性信息表示为特征向量xu。消息传递方法的目标是通过聚合来自u邻居的信息来学习基于xu的节点嵌入eu。在最近的研究中,图神经网络(GNNs)[37]被广泛用于促进这种聚合/消息传递过程。

Relation-Learning方法

异类网络中的每条边都可以看作是一个三元组(u, l, v),由两个节点u, v∈v和一个边缘类型l∈TE(即。,实体和关系,用KG表示)。关系学习方法的目标是学习一个评分函数sl(u, v),该函数对任意三元组求值并输出一个标量来度量该三元组的可接受性。这种思想在KB嵌入中被广泛采用。由于已经有关于KB嵌入算法的调查[81],我们在这里只讨论最流行的方法,并强调它们与HNE的联系。

11. 综述:图上的AutoML

Automated Machine Learning on Graphs: A Survey

清华大学 Ziwei Zhang, Xin Wang, Wenwu Zhu

图机器学习在学术界和工业界都得到了广泛的研究。然而,随着图学习文献的大量涌现,涌现出大量的方法和技术,对于不同的图相关任务,人工设计最优的机器学习算法变得越来越困难。为了解决这一关键挑战,图上的自动机器学习(AutoML)结合了图机器学习和自动学习的优点,正受到学术界的关注。因此,本文对图自动学习方法进行了全面的综述,重点研究了用于图机器学习的超参数优化(HPO)和神经结构搜索(NAS)。本文进一步概述了与自动图机器学习相关的库,并深入讨论了AutoGL,这是第一个用于AutoML on graphs的专用开源库。最后,作者分享了对自动图机学习未来研究方向的看法。据作者所知,这篇论文是第一个关于图上的自动机器学习的系统和全面的综述。

https://arxiv.org/abs/2103.00742

12. 综述:图自监督学习

Graph Self-Supervised Learning: A Survey

Monash University等

Yixin Liu, Shirui Pan, Ming Jin, Chuan Zhou, Feng Xia, Philip S. Yu

最近,基于图的深度学习引起了人们的极大兴趣。但是,大多数工作都集中在(半)监督学习上,导致对标签的依赖度过高,泛化性差和鲁棒性差。为了解决这些问题,自监督学习(SSL)可以通过精心设计的任务提取信息知识,而无需依赖人工标签,这已经成为一种promising的趋势图学习范例。与计算机视觉/自然语言处理等其他领域不同,图上的SSL具有专有的背景,设计思想和分类法。在图自监督学习的保护下,本文对使用SSL技术处理图数据的现有方法进行了及时而全面的回顾。根据其自监督任务的设计,本文将它们分为四类。进一步讨论该研究领域中尚存的挑战和潜在的未来方向。

13. A unified Review: 图神经网络自监督学习

Self-Supervised Learning of Graph Neural Networks: A Unified Review

Texas A&M University等

Yaochen Xie, Zhao Xu, Zhengyang Wang, Shuiwang Ji

https://arxiv.org/abs/2102.10757

在监督模式下训练的深度模型在各种任务上都取得了显著的成功。在标记样本有限的情况下,自监督学习(self-supervised learning, SSL)成为利用大量未标记样本的新范式。SSL在自然语言和图像学习任务中已经取得了很好的效果。最近,利用图神经网络(GNNs)将这种成功扩展到图数据的趋势。

在本综述论文中,作者提供了使用SSL训练GNN的不同方法的统一回顾。具体来说,将SSL方法分为对比模型和预测模型。在这两类中,我们都为方法提供了一个统一的框架,以及这些方法在框架下的每个组件中的不同之处。我们对GNNs SSL方法的统一处理揭示了各种方法的异同,为开发新的方法和算法奠定了基础。我们还总结了不同的SSL设置和每个设置中使用的相应数据集。为了促进方法开发和实证比较,我们为GNNs中的SSL开发了一个标准化测试床,包括通用基线方法、数据集和评估指标的实现。

![]()

14 图上的元学习: 方法和应用

Meta-Learning with Graph Neural Networks: Methods and Applications

Columbia University等

Debmalya Mandal, Sourav Medya, Brian Uzzi, Charu Aggarwal

https://arxiv.org/abs/2103.00137

图神经网络(GNN)是对图数据进行深度神经网络的泛化,GNN已广泛用于从药物发现到推荐系统的各个领域。但是,当可用样本很少时,此类应用上的GNN受限制。元学习一直是解决机器学习中样本不足的重要框架,近年来,研究人员已开始将元学习应用于GNN。在这项工作中,作者对图上不同的元学习方法进行了全面调查,并且根据结构,表示形式和应用对文献进行分类。最后,讨论了一些有意思的研究方向和未解决的问题。

15 综述:图结构学习用于鲁棒性表示

Deep Graph Structure Learning for Robust Representations: A Survey

https://arxiv.org/pdf/2103.03036.pdf

中科院自动化研究所:Yanqiao Zhu∗ , Weizhi Xu∗ , Jinghao Zhang∗ , Qiang Liu, Shu Wu† and Liang Wang

图神经网络(GNN)被广泛用于分析图结构数据。大多数GNN方法对图结构的质量高度敏感,并且通常需要用于学习信息嵌入的完美图结构。但是,图中的噪声无处不在,因此有必要为现实世界中的问题学习可靠的表示形式。为了提高GNN模型的鲁棒性,围绕图结构学习(GSL)的中心概念提出了许多研究,旨在共同学习优化的图结构和相应的表示形式。为此,在提出的调查中,作者广泛回顾了GSL方法在学习鲁棒表示中的最新进展。具体来说,首先定义了GSL的一般范式,然后按模型结构建模方式分类的最新方法进回顾,然后将在其他图形任务中纳入GSL思想的应用程序进行分类。最后,指出了当前研究中的一些问题,并讨论了未来的方向。

15 综述:图结构学习用于鲁棒性表示