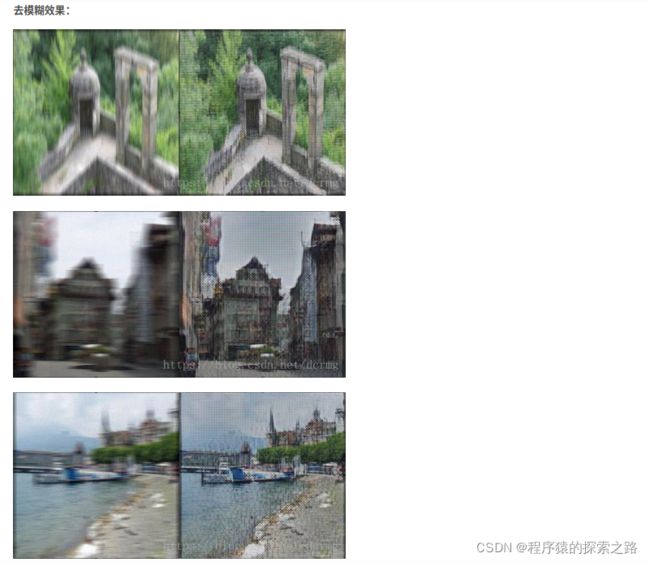

【笔记】生成对抗网络GAN 消除图像模糊(Keras):这个网络的网格应该消除不了,效果不是最优的,想消除网格可以使用其它更优的方法

2017年,乌克兰天主教大学、布拉格捷克理工大学和解决方案提供商Eleks联手公布了一篇论文,文章标题为《DeblurGAN: Blind Motion Deblurring Using Conditional Adversarial Networks》。

这篇文章中,研究人员提出一种基于条件对抗式生成网络和内容损失(content loss)的端对端学习法DeblurGAN,用来去除图像上因为相机和物体相对运动而产生的模糊。

论文地址:https://arxiv.org/abs/1711.07064

pytorch实现: https://github.com/KupynOrest/DeblurGAN

keras实现: https://github.com/RaphaelMeudec/deblur-gan

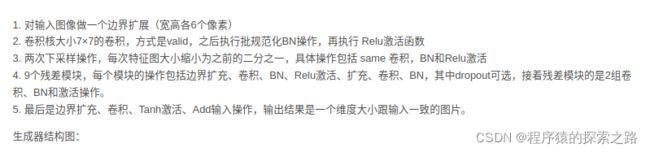

def generator_model():

inputs = Input(shape=image_shape)

x = ReflectionPadding2D((3, 3))(inputs)

x = Conv2D(filters=ngf, kernel_size=(7, 7), padding='valid')(x)

x = BatchNormalization()(x)

x = Activation('relu')(x)

n_downsampling = 2

for i in range(n_downsampling):

mult = 2**i

x = Conv2D(filters=ngf*mult*2, kernel_size=(3, 3), strides=2, padding='same')(x)

x = BatchNormalization()(x)

x = Activation('relu')(x)

mult = 2**n_downsampling

for i in range(n_blocks_gen):

x = res_block(x, ngf*mult, use_dropout=True)

for i in range(n_downsampling):

mult = 2**(n_downsampling - i)

x = Conv2DTranspose(filters=int(ngf * mult / 2), kernel_size=(3, 3), strides=2, padding='same')(x)

x = BatchNormalization()(x)

x = Activation('relu')(x)

x = ReflectionPadding2D((3, 3))(x)

x = Conv2D(filters=output_nc, kernel_size=(7, 7), padding='valid')(x)

x = Activation('tanh')(x)

x = Lambda(lambda z: z*2)(x)

outputs = Add()([x, inputs])

outputs = Lambda(lambda z: z/3)(outputs)

model = Model(inputs=inputs, outputs=outputs, name='Generator')

return model

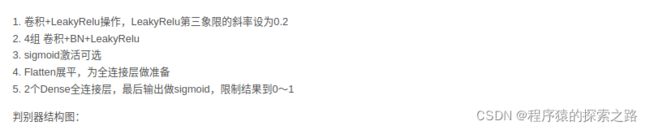

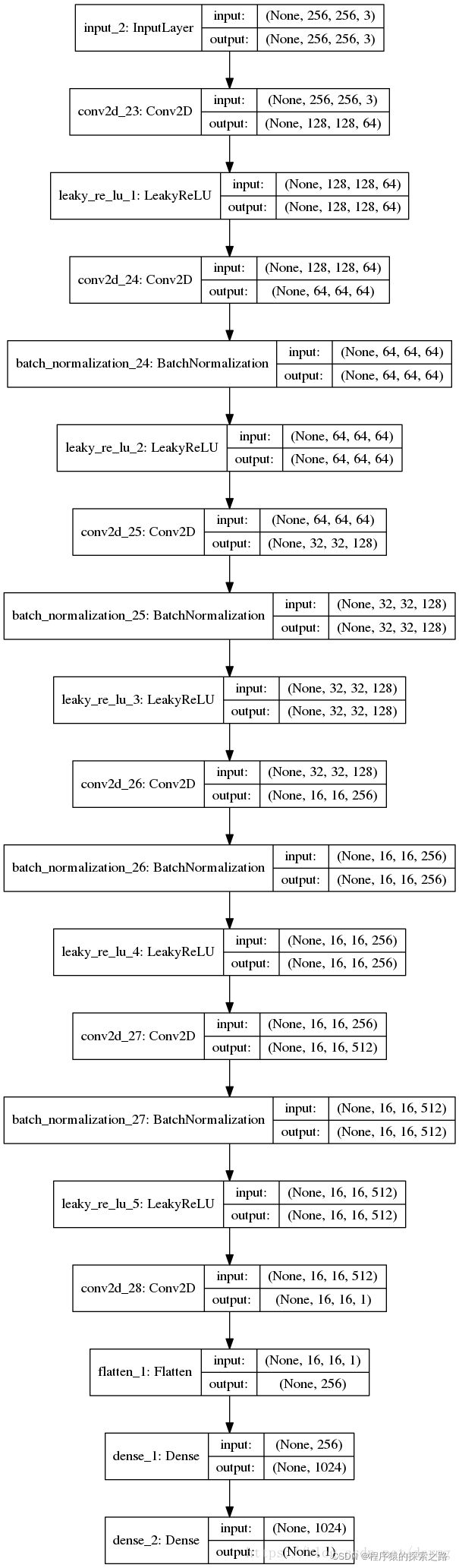

def discriminator_model():

"""Build discriminator architecture."""

n_layers, use_sigmoid = 3, False

inputs = Input(shape=input_shape_discriminator)

x = Conv2D(filters=ndf, kernel_size=(4, 4), strides=2, padding='same')(inputs)

x = LeakyReLU(0.2)(x)

nf_mult, nf_mult_prev = 1, 1

for n in range(n_layers):

nf_mult_prev, nf_mult = nf_mult, min(2**n, 8)

x = Conv2D(filters=ndf*nf_mult, kernel_size=(4, 4), strides=2, padding='same')(x)

x = BatchNormalization()(x)

x = LeakyReLU(0.2)(x)

nf_mult_prev, nf_mult = nf_mult, min(2**n_layers, 8)

x = Conv2D(filters=ndf*nf_mult, kernel_size=(4, 4), strides=1, padding='same')(x)

x = BatchNormalization()(x)

x = LeakyReLU(0.2)(x)

x = Conv2D(filters=1, kernel_size=(4, 4), strides=1, padding='same')(x)

if use_sigmoid:

x = Activation('sigmoid')(x)

x = Flatten()(x)

x = Dense(1024, activation='tanh')(x)

x = Dense(1, activation='sigmoid')(x)

model = Model(inputs=inputs, outputs=x, name='Discriminator')

return modeldef perceptual_loss(y_true, y_pred):

vgg = VGG16(include_top=False, weights='imagenet', input_shape=image_shape)

loss_model = Model(inputs=vgg.input, outputs=vgg.get_layer('block3_conv3').output)

loss_model.trainable = False

return K.mean(K.square(loss_model(y_true) - loss_model(y_pred)))def wasserstein_loss(y_true, y_pred):

return K.mean(y_true*y_pred)