论文精读:FairMOT: On the Fairness of Detection and Re-Identification in MultipleObject Tracking

1.提出背景

以往的工作通常将re-ID视为次要任务,其准确性受到主要检测任务的严重影响。因此,网络偏向于主检测任务,这对re-ID任务不公平。

2. 核心思想

将MOT表示为单个网络中目标检测和reid的多任务学习,因为它允许两个任务的联合优化,并且具有较高的计算效率。然而,我们发现这两个任务倾向于相互竞争,这需要仔细处理。特别是,以往的工作通常将re-ID视为次要任务,其准确性受到主要检测任务的严重影响。因此,网络偏向于主检测任务,这对re-ID任务不公平。为了解决这个问题,我们提出了一种基于无锚定目标检测架构CenterNet的简单而有效的方法,称为FairMOT。请注意,它并不是CenterNet和re-ID的幼稚组合。相反,我们提出了一堆详细的设计,这些设计对于通过彻底的实证研究获得良好的跟踪结果至关重要。

3.主要内容

3.1 Introduction

目标追踪大多数现有方法如试图通过两个独立的模型来解决问题:检测模型首先通过每帧的边界框检测感兴趣的对象,然后关联模型从每个边界框对应的图像区域中提取再识别(re-ID)特征,将检测链接到现有轨迹之一,或根据特征上定义的某些指标创建新的轨迹。

两阶段的目标追踪方法存在可伸缩性问题。当环境中有大量对象时,它们无法实现实时推理速度,因为这两个模型不共享特性,而它们需要对视频中的每个边界框独立地应用re-ID模型。

随着多任务学习的成熟(Kokkinos,2017;Chen等人,2018b),使用单一网络估计对象和学习reid特征的一次性跟踪器吸引了更多的关注(Wang等人,2020b;沃格特兰德等人,2019年)。例如,Voigtlaender等人(Voigtlaender等人,2019年)添加了一个re-ID分支来掩码R-CNN,以为每个提案提取一个re-ID特征(He等人,2017年)。它通过重用re-ID网络的主干特性,减少了推理时间。但与两步模型相比,性能显著下降。事实上,检测精度仍然很好,但跟踪性能下降了很多。例如,ID开关的数量会大幅度增加。结果表明,合并这两个任务是一项重要的任务,应该仔细处理。

本文研究了故障背后的原因,并提出了一个简单而有效的解决方法。我们确定了三个因素来解释这次失败。第一个问题是由锚点引起的。锚点最初是为目标检测而设计的(Renetal.,2015)。然而,我们证明锚不适合提取re-id特征,有两个原因。首先,基于锚的一次性跟踪器,如TrackR-CNN(Voigtlaenderetal.,2019)忽略了re-ID任务,因为它们需要锚来首先检测物体(即,使用RPN(Renetal.,2015)),然后根据检测结果提取re-ID特征(当检测结果不正确时,re-ID特征是无用的)。所以当两个任务之间发生竞争时,它将有利于检测任务。在训练re-ID特征时,锚也引入了很多歧义,因为一个锚可能对应多个身份,而多个锚可能对应一个身份,特别是在拥挤的场景中。

第二个问题是由两个任务之间的特性共享引起的。检测任务和reid任务是两个完全不同的任务,它们需要不同的特性。一般来说,re-ID特性需要更多的低级特性来区分同一个类的不同实例,而检测特性对于不同的实例需要是相似的。一次性跟踪器中的共享特性会导致特征冲突,从而降低每个任务的性能。

第三个问题是由特征维度引起的。re-ID特征的维数通常高达512(Wangetal.,2020b)或1024(Zhengetal.,2017a),远高于目标检测。我们发现,不同维度之间的巨大差异会影响这两个任务的性能。更重要的是,我们的实验表明,为“联合检测和re-ID”网络学习低维re-ID特征可以获得更高的跟踪精度和效率是一个通用的规则。这也揭示了MOT任务和re-ID任务之间的差异,而这在MOT领域中被忽略了。

在这项工作中,我们提出了一种被称为FairMOT的简单方法,它优雅地解决了如图1所示的三个问题。FairMOT建立在CenterNet之上(Zhou等人,2019a)。特别是,检测的re-ID任务和re-ID任务被同等对待,这与之前的“检测优先,re-ID二级”框架基本不同。值得注意的是,它并不是CenterNet和re-id的幼稚组合。相反,我们提出了一堆详细的设计,这些设计对于通过彻底的实证研究获得良好的跟踪结果至关重要。

图1显示了FairMOT的概述。它具有一个简单的网络结构,由两个同质分支组成,分别用于检测对象和提取re-id特征。受(Zhou等人,2019a;劳和邓,2018;Zhou等人,2019b;Duan等人,2019),检测分支以无锚方式实现,以位置感知测量图表示目标中心和大小。类似地,re-ID分支估计每个像素的re-ID特征来描述以像素为中心的对象。请注意,这两个分支是完全齐次的,这与以前采用的以两级级联方式执行检测和re-id的方法基本不同。因此,FairMOT消除了如表1所示的检测分支的不公平劣势,有效地学习了高质量的re-ID特征,获得了检测和re-ID之间的良好权衡。

我们通过评估服务器在MOT挑战基准测试上评估FairMOT。在2DMOT15数据集中,它在所有跟踪器中排名第一。当我们使用我们提出的单图像训练方法进一步预训练我们的模型时,它在所有数据集上都获得了额外的收益。尽管有很强的结果,但该方法非常简单,并且在一个RTX2080TiGPU上运行在30FPS下。阐明了MOT中检测和reid之间的关系,并为一次性视频跟踪网络的设计提供了指导

我们通过评估服务器在MOT挑战基准测试上评估FairMOT。在2DMOT15数据集中,它在所有跟踪器中排名第一。当我们使用我们提出的单图像训练方法进一步预训练我们的模型时,它在所有数据集上都获得了额外的收益。尽管有很强的结果,但该方法非常简单,并且在一个RTX2080TiGPU上运行在30FPS下。阐明了MOT中检测和reid之间的关系,并为一次性视频跟踪网络的设计提供了指导

我们的贡献如下:我们的经验证明,普遍的基于锚定的一次性MOT架构在学习有效的reid特征方面有局限性,但这被忽视了。这些问题严重限制了这些方法的跟踪性能。我们提出FairMOT是为了解决公平性问题。FairMOT是建立在中心网络之上的。虽然所采用的技术本身并不是新颖的,但我们也有了对MOT很重要的新发现。这些作品既新颖又有价值。–我们表明,所实现的公平性允许我们的FairMOT获得高水平的检测和跟踪精度,并在多个数据集上,如2DMOT15、MOT16、MOT17和MOT20,大大优于以前的最先进的方法

3.2 Related Work

表现最佳的MOT方法,通常遵循跟踪检测模式,首先检测每帧中的对象,然后随着时间将它们关联起来。我们根据现有的作品是使用单一模型还是使用单独的模型来检测对象和提取关联特征,将其分为两类。我们讨论了这些方法的优缺点,并将它们与我们的方法进行了比较。

2.1 Detection and Tracking by Separate Models

2.1.1 Detection Methods

大多数基准数据集如MOT17提供检测结果等流行的方法如DPM,Faster R-CNN(任等,2015)和SDP,这样的工作关注跟踪部分可以相当比较相同的对象检测。一些作品如使用大型私人行人检测数据集,以VGG-16为骨干,训练 Faster R-CNN探测器,获得更好的检测性能。一些工作,如(Hanetal.,2020)使用最近开发的更强大的探测器,如级联cate R-CNN(Cai和Vasconcelos,2018)来提高检测性能。

然而,它们可能会在拥挤的场景和快速运动的挑战性情况下失败。一些作品利用复杂的单一对象跟踪方法获得准确的对象位置并减少假阴性。然而,这些方法非常缓慢,特别是当场景中有大量的人时。为了解决轨迹碎片的问题,Zhang等人(Zhangetal.,2020)提出了一个运动评估网络来学习关联轨迹的随机特征。MAT(Hanetal.,2020)是一种增强的SORT,它额外模拟摄像机运动,并使用动态窗口进行远程重新关联。

基于外观线索的方法:最近的一些作品提出裁剪检测图像区域并输入识别网络提取图像特征(标注DeepSort)。然后,他们基于reid特征计算轨迹和检测之间的相似性,并使用匈牙利算法(Kuhn,1955)来完成分配。该方法对快速运动和快速遮挡具有良好的鲁棒性。特别是,它可以重新初始化丢失的轨迹,因为外观特征随着时间的推移相对稳定。

也有一些作品专注于增强外观特征。例如,Bae等人(Bae和Yoon,2014)提出了一种在线外观学习方法来处理外观变化。Tang等人(Tang等人,2017)利用身体姿势特征来增强外观特征。一些方法(Sadeghian等人,2017;Xu等人,2019;Shan等人,2020)提出融合多种线索(即运动、外观和位置),以获得更可靠的相似性。MOTDT(Chenetal.,2018a)提出了一种分层数据关联策略,当外观特征不可靠时,使用IoU来关联对象。少数作品,如(Mahmoudi等人,2019;Zhou等人,2018;Fang等人,2018)也建议使用更复杂的关联策略,如群体模型和rnn。

Offlfline Methods:(或批处理方法)通常通过对整个序列进行全局优化获得更好的结果。例如,Zhang等人(Zhang等人,2008)建立了一个图形模型,其中的节点表示所有帧中的检测。利用最小代价流算法搜索最优分配,该算法利用图的特定结构比线性规划更快地达到最优分配。 Berclaz等人(Berclaz等人,2011)也将数据关联视为一个流优化任务,并使用最短路径算法来解决它,这大大加快了计算速度,减少了需要调整的参数。Milan等人(Milan等人,2013)将多目标跟踪制定为连续能量的最小化,并专注于设计能量函数。能量取决于所有帧中所有目标的位置和运动以及物理约束。MPNTrack(Bras‘o和Leal-Taix’e,2020)提出了可训练的图神经网络来对整个检测集执行全局关联,并使MOT完全可微。LifT(Hornakovaetal.,2020)将MOT定义为一个提升的不相交路径问题,并引入了长距离时间交互的提升边,这显著减少了id开关和重新识别丢失。

Advantages and Limitations:对于通过单独的模型进行检测和跟踪的方法,其主要优点是可以为每个任务分别开发最适合的模型。此外,它们还可以根据检测到的边界框来裁剪图像补丁,并在估计re-ID特征之前,将其大小调整到相同的大小。这有助于处理对象的比例变化。因此,这些方法(Yu等人,2016;Henschel等人,2019年)在公共数据集上取得了最好的性能。然而,它们通常非常缓慢,因为这两个任务需要单独完成,而不需要共享。因此,很难实现在许多应用程序中所需要的视频速率推理。

Joint Detection and Motion Prediction:第二类方法在单一网络中学习检测和运动特征。D&T(feicthhenhofer等人,2017)提出了一种暹罗网络,该网络接收相邻帧的输入,并预测边界框之间的帧间位移。跟踪器(Bergmannetal.,2019)直接利用边界盒回归头来传播区域建议的身份,从而消除盒关联。链跟踪器(Pengetal.,2020)提出了一个端到端模型,使用相邻的帧对作为输入,并生成代表相同目标的盒对。这些基于方框的方法假设边界框在帧之间有很大的重叠,而这在低帧率的视频中是不正确的。与这些方法不同的是,中心跟踪(Zhouetal.,2020)通过成对的输入来预测物体中心的位移,并通过这些点距离进行关联。这些轨迹作为一个额外的基于点的热图输入到网络,然后能够在任何地方匹配对象,即使方框没有任何重叠。然而,这些方法只关联相邻帧中的对象,而没有重新初始化丢失的轨迹,因此有不同的计算处理遮挡情况。

我们的工作属于第一流的。我们研究了一次性跟踪器的关联性能下降的原因,并提出了一种简单的方法来解决这些问题。我们表明,在没有大量工程努力的情况下,跟踪精度得到了显著的提高。并发工作CSTrack(Liangetal.,2020)也旨在从特征的角度缓解两个任务之间的冲突,并提出一个互相关网络模块,使模型能够学习与任务相关的表示。与CSTrack不同的是,我们的方法试图从三个系统的角度来解决这个问题,并获得了明显优于CSTrack的性能。中心跟踪(Zhouetal.,2020)也与我们的工作相关,因为它也使用了基于中心的目标检测框架。但是中心跟踪并不提取外观特征,而只链接相邻帧中的对象。相比之下,FairMOT可以与外观特征进行长期关联,并处理闭塞病例。

多任务学习有大量的文献,多任务学习可用于平衡目标检测和重新识别特征提取任务。不确定性(Kendalletal.,2018)使用任务依赖的不确定性来自动平衡单个任务的损失。在(Sener和Koltun,2018)中提出了MGDA,通过寻找特定任务梯度之间的共同方向来更新共享网络权值。GradNorm(Chenetal.,2018b)通过模拟特定任务梯度的大小来控制多任务网络的训练。我们在实验部分中评估了这些方法。

2.3 Video Object Detection

视频目标检测(VOD)与MOT相关,因为它利用跟踪来提高在具有挑战性的帧中的目标检测性能。虽然这些方法没有在MOT数据集上进行评估,但其中一些想法可能对该领域有价值。所以,我们将在本节中简要地回顾一下它们。Tang等人(Tang等人,2019年)检测视频中的对象管,旨在提高基于相邻帧的具有挑战性的帧中的分类分数。在基准数据集上,对小对象的检测率提高的幅度很大。

这些基于管的方法的一个主要限制是它们非常慢,特别是当视频中有大量的物体时。

3.3 Unfairness Issues in One-shot Trackers

在本节中,我们将讨论在现有的一次性跟踪器中出现的三个不公平问题,它们通常会导致跟踪性能下降。

3.2 Unfairness Caused by Features

对于一次性跟踪器,大多数特征在目标检测和reid任务之间共享。但众所周知,它们实际上需要来自不同层的特性来获得最好的结果。特别是,目标检测需要深度特征来估计对象类和位置,而re-ID需要低级的外观特征来区分同一类的不同实例。从多任务损失优化的角度来看,检测和识别的优化目标存在冲突。因此,平衡这两个任务的损失优化策略是很重要的。

3.3由特征维度造成的不公平性

以前的re-ID工作通常学习非常高的维特征,并在其领域的基准上取得了有希望的结果。然而,我们发现学习低维特征实际上对一次性MOT更好,原因有三:(1)高维re-ID特征由于两个任务的竞争,显著损害了目标检测精度,进而对最终的跟踪精度产生负面影响。因此,考虑到目标检测中的特征维数通常很低(类数+盒位置),我们建议学习低维的re-ID特征来平衡这两个任务;(2)MOT任务不同于re-ID任务。MOT任务只在两个连续的帧之间执行少量的一对一匹配。re-ID任务需要将查询与大量的候选对象进行匹配,因此需要更有区别性和高维的re-ID特征。所以在MOT中,我们不需要高维特征;(3)学习低维reid特征提高了推理速度,如我们的实验所示。

3.4 FairMOT

在本节中,我们将介绍FairMOT的技术细节,包括主干网络、目标检测分支、re-ID分支以及训练细节。

其中N表示图像中物体的数量,σc表示标准偏差。损失函数被定义为带有焦点损失的像素级逻辑回归(Linetal.,2017b):

其中N表示图像中物体的数量,σc表示标准偏差。损失函数被定义为带有焦点损失的像素级逻辑回归(Linetal.,2017b):

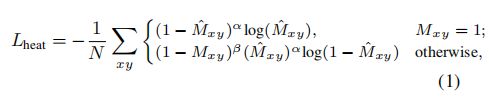

其中,ˆM为估计的热图,α、β为焦损失的预定参数。

4.2.2 Box Offset and Size Heads

盒形偏移头的目的是更精确地定位对象。由于最终的特征图的步幅为4步,因此它将引入多达4个像素的量化误差。该分支估计每个像素相对于对象中心的连续偏移量,以减轻降采样的影响。盒子尺寸头负责估计每个位置的目标盒子的高度和宽度。

表示尺寸和偏移头的输出,分别为Sˆ∈![]() 和O^∈

和O^∈![]() 。对于图像中的每个GT盒

。对于图像中的每个GT盒![]() ,我们计算其大小为

,我们计算其大小为![]() 。类似地,GT偏移量被计算为。表示相应位置的估计大小和偏移量

。类似地,GT偏移量被计算为。表示相应位置的估计大小和偏移量![]() ,分别为ˆsi和ˆoi。然后我们强制两个头l1损失:

,分别为ˆsi和ˆoi。然后我们强制两个头l1损失:

3.4.4 Training FairMOT

我们通过添加损失(即等式(1), Eq.(2)和等式(3))在一起。特别是,我们使用(Kendalletal.,2018)中提出的不确定性损失来自动平衡检测和re-ID任务:

其中w1和w2是平衡这两个任务的可学习参数。具体来说,给定一个有一些对象及其对应id的图像,我们生成热图、框偏移和大小图,以及对象的一个热类表示。将这些与获得训练整个网络的损失的估计措施进行比较。

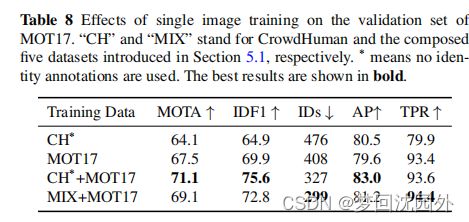

除了上述的标准训练策略外,我们还提出了一种单一的图像训练方法来在图像级FairMOT集上进行训练,如COCO(Linetal.人,2014)和CrowdHoman(Shaoetal.人,2018)。与CenterTrack(Zhouetal.,2020)以两个模拟的连续帧作为输入不同,我们只取一张图像作为输入。我们为每个边界框分配一个唯一的标识,因此将数据集中的每个对象实例视为一个单独的类。我们对整个图像应用不同的变换,包括HSV的增强、旋转、缩放、平移和剪切。单图像训练方法具有显著的经验值。首先,在CrowdHuman数据集上的预先训练的模型可以直接作为跟踪器,在MOT17上获得MOT数据集的可接受的结果(Milanetal.,2016)。这是因为众包人数据集可以提高人的检测性能,并且具有很强的域泛化能力。我们对re-ID特性的训练进一步提高了跟踪器的关联能力。其次,我们可以在其他MOT数据集上进行微调,并进一步提高最终的性能。

3.4.5 Online Inference

在本节中,我们将展示我们如何执行在线推理,特别是我们如何与检测和re-id特性执行关联。

3.5 Experiments

3.5.1 Datasets and Metrics

简要介绍了6个训练数据集:ETH(Ess等人,2008)和CityPerson(Zhangetal.人,2017)数据集只提供框注释,所以我们只训练检测分支。加州理工学院(Doll‘ar等人,2009)、MOT17(米兰等人,2016)、CUHK-SYSU(Xiao等人,2017)和PRW(Zheng等人,2017a)数据集提供了盒子和身份注释,允许我们训练两个分支。ETH中的一些视频也出现在MOT17的测试集中,这些视频被从训练数据集中删除,以进行公平的比较。总体培训策略描述见第4.4节,这与(Wangetal.,2020b)相同。对于我们的方法的自我监督训练,我们使用了CrowdHuman数据集(Shaoetal.,2018),它只包含对象边界框注释。

我们在四个基准测试的测试集上评估了我们的方法:2DMOT15、MOT16、MOT17和MOT20。我们使用平均精度(AP)来评估检测结果。接下来(Wangetal.,2020b),我们使用真阳性率(TPR)的假接受率来评估re-ID特征。特别地,我们提取与地面真值盒对应的re-ID特征,并使用每个特征来检索N个最相似的候选特征。我们报告了假接受率0.1(TPR@FAR=0.1)。需要注意的是,TPR不受检测结果的影响,并且真实地反映了re-id特征的质量。我们使用明确的度量(Bernardin和Stiefelhagen,2008)(即MOTA,IDs)和IDF1(Ristani等人,2016)来评估总体跟踪的准确性。

3.5.2 Implementation Details

我们使用在(Zhouetal.,2019a)中提出的DLA-34的一个变体作为我们的默认主干。在COCO数据集上预先训练的模型参数(Linetal.,2014)用于初始化我们的模型。我们使用Adam优化器(Kingma和Ba,2014)对我们的模型进行了30个时代的训练,起始学习速率为10−4。学习速率在20个时代衰减到10−5。批处理大小被设置为12。我们使用标准的数据增强技术,包括旋转、缩放和颜色抖动。输入图像的大小被调整为1088×608,特征图的分辨率为272×152。在两个RTX2080Ti图形处理器上,训练步骤大约需要30个小时。

3.5.3 Ablative Studies

在本节中,我们将通过仔细设计一些基线方法,对FairMOT中的三个关键因素进行严格的研究,包括无锚reid特征提取、特征融合和特征维度。

5.3.2平衡多任务损失

我们评估了平衡不同任务损失的不同方法,包括不确定性(Kendall等人,2018)、GradNorm(Chen等人,2018b)和MGDA-UB(Sener和Koltun,2018)。我们还评估了通过网格搜索获得的具有固定权值的基线。我们为基于不确定性的方法实现了两个版本。第一个是“不确定性任务”,分别学习检测损失和re-id损失的两个参数。第二种是“不确定性分支”,它分别学习热图损失、盒大小损失、偏移损失和reid损失的四个参数.

结果如表2所示。我们可以看到,“固定”方法得到了最好的MOTA和AP,但最差的id和TPR。这意味着该模型偏向于检测任务。MGDA-UB的TPR最高,而MOTA和AP最低,这表明该模型偏向于re-ID任务。类似的结果也可以在(Wang等,2020b;Vandenhende等,2021)中找到。GradNorm获得了最好的总体跟踪精度(最高的IDF1和第二高的MOTA),这意味着确保不同的任务具有相似的梯度大小有助于处理特征冲突。然而,GradNorm需要更长的训练时间。所以我们使用更简单的不确定性方法它在我们剩下的实验中比GradNorm稍差。

5.3.3 多层功能融合

我们比较的骨干如普通的ResNet,特征金字塔网络(FPN)(林等,2017),高分辨率网络(HRNet)(王等,2020),DLA(周等,2019),HarDNet(曹等,2019)和RegNet(拉多萨沃维奇等,2020)。请注意,这些方法的其他因素,如训练数据集,都被控制为相同的,以便进行公平的比较。特别是,所有方法的最终特征图的步骤都是4。我们对普通的ResNet和RegNet添加了三个上采样操作:

结果如表3所示。我们还列出了ImageNet(拉斯萨科夫斯基等人,2015)分类精度Acc,以证明一个任务中的强主干并不意味着它也将在MOT中获得良好的结果。因此,对MOT进行详细的研究是必要的和有用的。

通过比较ResNet-34和ResNet-50的结果,我们发现盲目使用更大的网络并不能显著改善MOTA测量的总体跟踪结果。特别是,reid特性的质量几乎不能从更大的网络中获益。例如,IDF1仅从67.2%提高到67.7%,TPR分别从90.9%提高到91.9%。此外,ID开关的数量甚至从435个增加到501个。通过比较ResNet-50和RegNetY-4.0GF,我们可以发现使用更强大的主干也能获得非常有限的增益。RegNetY-4.0GF的re-ID度量TPR与ResNet-50(91.9)相同,而ImageNet的分类精度提高了很大程度(79.4vs77.8)。所有这些结果表明,直接使用一个更大或更强大的网络并不能总是提高最终的跟踪精度。

5.3.4特征尺寸

之前的一次性跟踪器,如JDE(Wangetal.,2020b)通常采用两步的方法学习512维re-ID特征。然而,我们在实验中发现,特征维度实际上在平衡检测和跟踪精度方面起着重要的作用。学习低维reid特征对检测精度的危害较小,提高了推理速度。我们在不同的一次性跟踪器上进行了实验,发现低维(即64)reID特征比高维(即512)reID特征获得更好的性能是一个通用的规则。

我们在表6中评估了JDE和FairMOT的re-ID特征维度的多重选择。对于JDE,我们可以看到64在所有指标上都比512获得的性能更好。对于FairMOT,我们可以看到512获得了更高的IDF1和TPR分数,这表明更高维度的re-ID特征具有更强的辨别能力。然而,当我们将维度从512减少到64时,MOTA分数会提高。这主要是由于检测和re-id任务之间的冲突造成的。特别是,我们可以看到,当我们降低reid特征的维数时,检测结果(AP)会得到提高。与re-ID任务不同,低维的re-ID特征在MOT任务上获得了更好的性能和效率

5.3.5 数据关联方法

本节评估数据关联步骤中的三个成分,包括边界框IoU、re-ID特性和卡尔曼滤波器(Kalman,1960)。这些数据被用来计算每对被检测到的盒子之间的相似性。据此,我们使用匈牙利算法(Kuhn,1955)来解决分配问题。表7显示了结果。我们可以看到,只有使用盒子IoU才会导致很多ID开关。对于拥挤的场景和快速的镜头运动尤其如此。单独使用re-ID特性可以显著增加IDF1,并减少ID开关的数量。此外,添加卡尔曼滤波器有助于获得平滑(合理的)轨迹,从而进一步减少了ID开关的数量。当一个对象被部分遮挡时,它的重新id特性就会变得不可靠。在这种情况下,利用盒IoU、re-ID特征和卡尔曼滤波器来获得良好的跟踪性能是很重要的。

我们还提供了不同组件的详细运行时细分,包括检测,re-ID匹配,卡尔曼滤波和IoU匹配。我们在具有不同密度(平均每帧行人数)的序列上测试运行时。结果如图4所示。联合检测和reid所花费的时间受密度的影响最小。在卡尔曼滤波和IoU匹配上花费的时间约为1ms或2ms,可以忽略。reid匹配的时间随密度的增加呈线性增加。这是因为更新每个轨迹的re-ID特性需要花费大量的时间。

5.3.6 re-ID相似性的可视化

我们使用re-ID相似度图来展示图3中re-ID特征的鉴别能力。我们从验证集中随机选择两帧。第一帧包含查询实例,第二个帧包含具有相同ID的目标实例。我们通过计算查询实例的re-ID特征与目标帧的整个re-ID特征图之间的余弦相似度,得到了reID相似度图,分别如第5.3.1节和第5.3.3节所述。通过比较ResNet-34和ResNet-34-det的相似性图,我们可以看到训练Re-ID分支是很重要的。通过比较DLA-34和ResNet-34,我们可以看到多层特征聚合可以得到更具有鉴别性的re-ID特征。在所有的采样策略中,所提出的center和center-bi可以更好地在拥挤的场景中区分目标对象和周围的对象。

2.5.4 单图像训练

2.5.5MOT挑战的结果

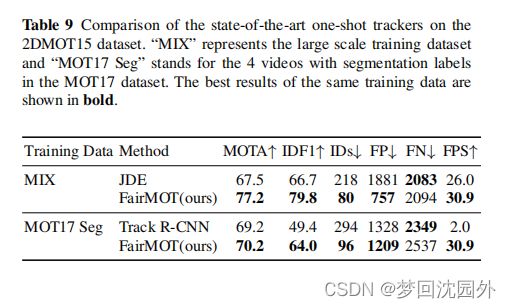

我们比较了我们的方法与最先进的(SOTA)方法,包括一次性方法和双步方法。JDE(Wang等人,2020b)和TrackRCNN(沃格特兰德等人,2019)有两篇已发表的作品,共同执行目标检测和身份特征嵌入。我们将我们的方法与这两者进行了比较。根据之前的工作(Wangetal.,2020b),测试数据集包含了来自2DMOT15的6个视频。FairMOT使用了与他们的论文中描述的两种方法相同的训练数据。特别是,当我们与JDE进行比较时,FairMOT和JDE都使用了第5.1节中描述的大规模组合数据集。由于TrackR-CNN需要分割标签来训练网络,所以它只使用了具有分割标签的MOT17数据集的4个视频作为训练数据。在这种情况下,我们还使用了这4个视频来训练我们的模型。我们使用了明确的度量标准(贝尔纳丁和斯蒂费尔哈根,2008年)和IDF1(Ristani等人,2016年)来衡量它们的性能。

结果如表9所示。我们可以看到,我们的方法显著优于JDE(Wang等人,2020b)。特别是,ID交换机的数量从218个减少到80个,这在用户体验方面有了很大的改善。结果验证了无锚方法比以往基于锚的方法的有效性。这两种方法的推理速度都接近视频速率,而我们的推理速度更快。与TrackR-CCNN(Voigtlaenderetal.,2019)相比,他们的检测结果略优于我们的(FN较低)。然而,FairMOT获得了更高的IDF1分数(64.0vs.49.4)和更少的ID开关(96vs.294)。主要是因为TrackR-CNN遵循“检测优先,re-ID二级”框架,并使用锚点,这也给re-ID任务带来了歧义。

5.5.2与其他SOTA MOT方法的比较

我们将我们的方法与最先进的跟踪器进行了比较,包括表10中的两步方法。由于我们不使用公共检测结果,所以采用了“私有检测器”协议。我们分别报告了2个DMOT15、MOT16、MOT17和MOT20数据集的测试结果。请注意,所有的结果都是直接从官方的MOT挑战评估服务器上获得的。

我们的方法在四个数据集的所有在线和离线跟踪器中排名第一。特别是,它的性能大大优于其他方法。这是一个非常强的结果,特别是考虑到我们的方法非常简单。此外,我们的方法还实现了视频速率推断。相比之下,大多数高性能跟踪器,如(Fangetal.,2018;Yu等人,2016)通常比我们的要慢。我们的方法在最近的局部MOT度量ALTA(Valmadreetal.,2021)中也排名第二,这进一步表明我们的方法实现了非常高的跟踪性能(表10)。

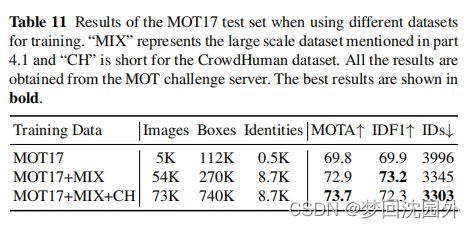

5.5.3训练数据消融研究

我们还在表11中使用不同数量的训练数据来评估FairMOT的性能。当只使用MOT17数据集进行训练时,我们可以实现69.8MOTA,这已经优于使用更多训练数据的其他方法。当我们使用与JDE相同的训练数据时(Wangetal.,2020b),我们可以实现72.9个MOTA,这显著优于JDE。此外,当我们对CrowdHuman数据集进行单次图像训练时,MOTA得分提高到73.7分。结果表明,我们的方法不需要数据,这在实际应用中是一个很大的优势。

2.5.6 Qualitative Results

图5可视化了FairMOT在MOT17测试集上的一些跟踪结果(Milanetal.,2016)。从MOT17-01的结果中可以看出,当两个行人相互交叉时,我们的方法可以利用高质量的re-id特征来分配正确的身份。使用边界盒IoUs的跟踪器(Bewley等人,2016;博钦斯基等人,2017)通常会在这种情况下导致身份开关。从MOT17-03的结果中可以看出,我们的方法在拥挤的场景下表现良好。从MOT17-08的结果中可以看出,当行人被严重遮挡时,我们的方法既能保持正确的身份,又能保持正确的边界框。MOT17-06和MOT17-12的研究结果表明,我们的方法可以处理大规模的变化。这主要归因于使用了多层特征聚合。我们的方法可以像MOT17-07和MOT17-14的结果那样准确地检测小物体。

2.6.总结和未来的工作

从研究为什么之前的一次性法(Wangetal.,2020b)未能获得与两步法相比可比的结果开始,我们发现在目标检测和身份嵌入中使用锚点是结果下降的主要原因。特别是,多个附近的锚点,它们对应于一个物体的不同部分,可能负责估计相同的身份,从而导致网络训练的歧义。此外,我们还发现,在之前的MOT框架中,检测任务和re-ID任务之间存在特征不公平问题和特征维度问题。通过在无锚单镜头深度网络中解决这些问题,我们提出了FairMOT。在几个基准数据集上,它在跟踪精度和推理速度方面都大大优于以前的最先进的方法。此外,FairMOT天生具有训练数据效率,我们提出仅使用边界框标注的图像对多目标跟踪器进行单图像训练,这使得我们的方法在实际应用中更有吸引力(Zhangetal.,2021b)。