FusionGAN:一种生成式红外与可见光图像融合对抗网络

FusionGAN:一种生成式红外与可见光图像融合对抗网络

- FusionGAN:一种生成式红外与可见光图像融合对抗网络

-

-

- 简要介绍

- 损失函数

- 网络架构

- 训练细节

- 实验

- 应用于融合不同分辨率的图像(低分辨率红外图像和高分辨率可见光图像)

- 总结

-

FusionGAN:一种生成式红外与可见光图像融合对抗网络

简要介绍

生成器:生成具有较大红外强度和附加可见梯度的融合图。

鉴别器:强制融合图有更多可见图中的纹理。

特点:端到端。还推广到了不同分辨率的图像。

效果:融合图像清晰、干净,高于平均技术水准。

过去方法的问题/不足:

主要的融合框架包括图像变换、活动水平测量、融合规则设计三个关键部分

现有的方法通常在融合过程中对不同的源图像使用相同的变换或表示。但是对于红外图像和可见光图像可能不合适,因为红外图像中的热辐射和可见光图像中的出现是两种不同现象的表现。此外,现有方法中的活动水平测量和融合规则大多采用人工设计,且越来越复杂,存在执行难度和计算代价的限制

本文方法的好处/过程:

将融合算法定义为保持红外热辐射信息与保持可见外观纹理信息的对抗博弈。更具体地说,它可以被看作是生成器和鉴别器之间的极大极小问题。生成器试图生成一个融合了主要红外强度和附加可见梯度的图像,而鉴别器的目标是强制融合图像,有更多的纹理细节。这使得融合后的图像能够同时保持红外图像的热辐射和可见光图像的纹理细节。此外,生成对抗网络的端到端特性可以避免人工设计复杂的活动水平测量和融合规则。

本方法四个维度的贡献:

- 提出了一种生成式对抗架构,并设计了一种用于红外与可见光图像融合的损失函数。讨论了gan算法用于图像融合的可行性和优越性。据我们所知,这是第一次采用gan算法来处理图像融合任务。

- 本文提出的fusion an是一种端到端模型,融合后的图像无需人工设计活动水平测量或融合规则,即可从输入的源图像自动生成。

- 我们在公共红外和可见光图像融合数据集上进行实验,并与最先进的方法进行定性和定量比较。与以往的方法相比,本文提出的方法可以获得类似于锐化红外图像的结果,具有清晰的高亮目标和丰富的纹理。

- 我们将所提出的fusion an算法推广到不同分辨率的源图像,如低分辨率红外图像和高分辨率可见光图像。它可以产生高分辨率的图像,并且不会受到红外信息上采样带来的噪声的影响。

深度卷积GAN

常规的GANs是不稳定的。五个不同点:首先,在生成器和鉴别器中不使用池层。在鉴别器中采用跨步卷积学习其空间下采样,在发生器中采用分数跨步卷积实现上采样。其次,在生成器和鉴别器中引入批处理归一化层。由于糟糕的初始化往往会产生大量的训练问题,批处理层能够解决这些问题,并避免在更深的模型中消失梯度。第三,在更深层次的模型中,完全连通的层被移除。第四,发电机中除最后一层激活层外,所有激活层均为整流线性单元(ReLU),最后一层为tanh激活。最后,鉴别器中的所有激活层都是漏泄的ReLU激活。这样,训练过程会更加稳定,生成的结果质量也会得到提高。

最小二乘GANs

最小二乘生成式对抗网络LSGANs,它采用最小二乘损失函数作为判别器,LSGANs的目标函数定义如下

a和b分别表示虚假数据和真实数据的标签,c表示生成器希望鉴别器相信虚假数据的值

LSGANs与常规GANs相比有两个优点:

- 一方面,lsgan可以生成比常规GANs更高质量的图像。

- 另一方面,LSGANs在训练过程中比常规GANs更加稳定。

损失函数

-

将红外图像和可见光图像在通道维度上拼接。

-

上图

-

博弈后:融合图会含有越来越多的细节信息(来自可见光图)。直到生成器生成的图无法被辨别器辨别,就得到了我们想要的融合图。

-

损失函数:

-

生成器的损失函数

(红外图用像素强度表达热辐射信息;可见光图partly用梯度信息表现纹理)设计对抗博弈的GAN网络是因为仅仅用content损失是不够的,因为纹理细节并不能被梯度信息完全表示。

基于可见光图去调整融合图,为了使得融合图拥有更多的纹理细节。

网络架构

-

由生成器和辨别器构成,它们的架构是基于卷积神经网络的。

生成器的网络架构:

-

简单的5层卷积神经网络

-

前两层是5 * 5的核,三和四层是3 * 3的核输入是一个没有噪声的拼接图像,最后一层是1*1的核。

-

对于红外和可见光图像的融合,每一次下采样过程都会在源图像中遗漏一些细节信息。因此,我们只引入卷积层而不引入下采样。这也可以保持输入和输出的大小相同,因此,反卷积层在我们的网络中是不必要的。

-

此外,为了避免梯度消失的问题,我们遵循深度卷积GAN规则进行批量归一化和激活函数。

-

为了克服模型对数据初始化的敏感性,我们在前四层采用了批量归一化,使得模型更加稳定,并且可以有效地将梯度反向传播到每一层。

-

在激活函数方面,前四层采用漏式ReLU激活函数,最后一层采用tanh激活函数。

辨别器的网络架构:

- 简单的五层卷积神经网络。

- 为了不引入噪声,只在第一层进行padding。其余三层卷积层不padding。

- 2-4层,用批量标准化层(BN)

- 1-4层,用leaky RELU。

最后一层(第5层)线性层,用于分类。

训练细节

实验

7对图像进行定性评价。

TNO数据集

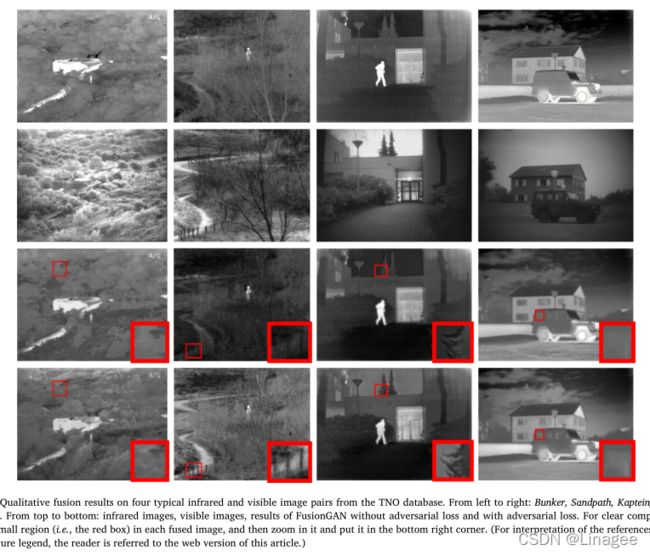

定性结果:

结果表明,所有方法都能在一定程度上很好地融合可见光图像和红外图像的信息。从这个意义上说,我们无法判断哪种方法是最好的还是最坏的。然而,我们也发现除了GTF之外的比较方法,融合后的图像中目标(如建筑物、人或汽车)并不明显,这意味着红外图像中的热辐射信息没有很好地保存下来。这是由于比较方法都集中于挖掘源图像中的细节信息。

相比之下,GTF和我们的方法在融合图像中比在可见光图像中更能突出目标区域,有利于目标的自动检测和定位,更好地保存红外图像信息。

然而,与GTF相比,我们的融合结果明显包含了更丰富的细节信息,更适合于人类的视觉感知。

表明,在同时保存热辐射信息和纹理细节信息方面,我们的fusongan比目前的其他产品有更好的性能。

定量比较:

在这5个评价指标上,fusionongan的平均值最大

而在第二个数据集上,我们的fusongan在大多数图像对上明显有最好的EN、SD、SSIM和SF,这些评价指标的平均值也比其余八个指标大。

最大熵表明融合后的图像比其他8种方法具有更丰富的信息。SD值最大说明融合后的图像对比度最大。最大SSIM表明融合后的图像在结构上更接近红外和可见光图像。而最大的SF表明,我们的融合图像包含丰富的边缘和纹理。虽然该方法的CC和VIF不是最好的,但对比结果表明,融合后的图像与两个源图像有很大的相关性,也更符合人类视觉系统。我们还提供了表1中9个方法的运行时比较。结果表明,与其他8种方法相比,我们的方法可以达到相当的效率。

INO数据集:(视频数据集)

在大多数图像对上,EN、SD、SSIM、CC和VIF评价指标的平均值最大。对于SF的度量,我们的fusongan只排在LPP之后。此外,我们还在表1中提供了不同融合方法的运行时间比较,我们的fusongan与其他8种方法相比,可以取得相当的效率。

对抗性损失的实验验证

采用对抗性损耗的融合结果包含了更多的细节信息,也更符合人眼视觉系统。

事实上,纹理细节不能完全用梯度信息来表示。其他属性如图像对比度、饱和度和光照变化在反映可见图像的细节方面也起着重要作用。然而,它是困难的数学刻画这些性质在一个目标函数的优化。尽管如此,本节的结果表明对抗训练可以帮助利用可见图像中的更多纹理细节,并将它们转移到融合图像中。

应用于融合不同分辨率的图像(低分辨率红外图像和高分辨率可见光图像)

先把源红外图像下采样,作为低分辨率图像。

接着给红外图插值,到与可见光图像相同的分辨率。

以及,重新设计了Lcontent。(把融合图下采样到红外图的分辨率)

所有的八种比较方法,它们都有一个前提,即源图像应该具有相同的分辨率。因此,我们必须先通过下采样可见光图像或上采样红外图像来消除分辨率差异。显然,下采样的可见光图像会导致纹理信息丢失,上采样的红外图像会模糊热辐射信息。但是,为了避免信息的丢失,所有的比较方法都选择在融合前对红外图像进行上采样。

选择了5对典型的图像对进行定性评价:除了GTF,其他方法的红外图像热辐射信息保留地不是很好。而对比GTF,我们的结果含有更多丰富的细节信息,也更符合人眼视觉认知。除此之外,我们方法的融合图比其余八种方法更清晰干净。这是因为我们的fusongan在内容损失(即(13))上不需要下采样或上采样源图像,因此不会受到红外信息上采样带来的噪声。

定量:

本文在计算SSIM、CC和VIF的度量之前,先将可见光图像和融合图像下采样到与对应的红外图像相同的分辨率。

在所有六个指标上,fusiongan的平均值都是最好的。

无论在相同的空间分辨率下还是在不同的分辨率下,我们的fusion an都能同时保留红外图像中的热辐射信息和可见光图像中丰富的纹理细节。与现有的最先进的融合方法相比,我们的结果看起来像是锐化的红外图像,具有清晰的高亮目标和丰富的细节信息。此外,与最先进的技术相比,我们的方法具有相当的效率。

总结

-

对抗过程中,生成器在保留红外辐射信息的同时,不断地将融合图像中的细节信息分布拟合到可见光图像中的细节信息分布。当识别器无法区分融合图像和可见光图像时,认为融合图像中的细节信息分布与可见光图像中的细节信息分布相同,因此融合图像在视觉上具有更多的纹理细节。

-

本文提出了一种基于生成式对抗网络的红外与可见光图像融合方法。它能同时保留红外图像中的热辐射信息和可见光图像中的纹理细节信息。该融合模型是一种端到端的融合模型,可以避免传统融合策略中手工设计复杂的活动水平测量和融合规则。在公共数据集上的实验表明,融合结果看起来像锐化的红外图像,具有清晰的高亮目标和丰富的细节信息,有利于基于图像融合的目标检测和识别系统。在四个评价指标上与8个国家的技术水平进行了定量比较,结果表明,我们的fusiongan不仅可以产生更好的视觉效果,而且可以在源图像中保留最大或近似最大的信息量。

-

是一个处理融合任务的通用框架,目标是融合一幅源图像的像素强度和另一幅源图像的纹理细节。同时,我们也将本方法推广到融合不同分辨率的源图像。

-

进一步目标:运用fusiongan去融合低分辨率多光谱图像和高分辨率全色图像,得到高空间分辨率的多光谱图像。