对于YOLOV5进行inference的前置工作的说明

- 配置环境

首先安装annaconda,进入官网,如图所示。

Annaconda是基于python语言的大型集成库,对于python来说是一个非常好用的应用。

安装完annaconda后我们可以选择安装工作平台,一般来说有pycharm和visual studio code两个选择。

Pycharm界面。

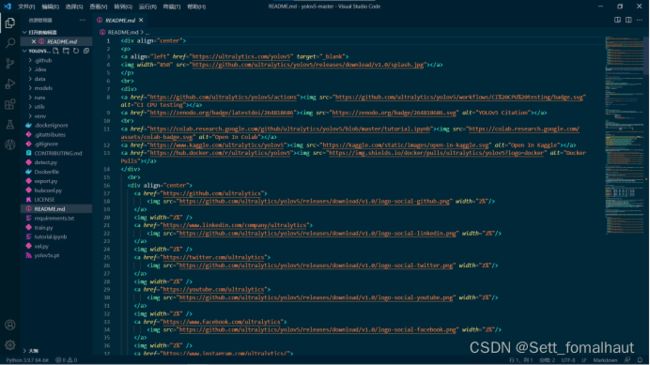

Visual studio code界面。

安装好任意一个工作平台后,我们可以调整设置,找到annaconda中包含的python或者是自行安装的python并把它作为解释器。然后我们就可以开始编程工作了。

- yolov5

首先我们在Github上找到yolov:GitHub - ultralytics/yolov5: YOLOv5 in PyTorch > ONNX > CoreML > TFLite。

下载好之后,我们可以解压出来一个工作组。

打开安装好的工作平台,导入这个工作组。直接选择打开文件夹,然后选定这个文件夹即可。此处以visual studio code为例。

在READEME里一般会有使用方法或者一些事项。简要看过后,我们选择detect.py文件

在import后可能有一些显示未安装的库,如果有,我们直接补充安装即可。安装后可以直接运行这个py文件

然后可以在运行工具栏的拓展里选择添加配置,输入 --source 0 ,则表示用摄像头进行测试。

输入--source data/images,则表示用data/images下的所有图片进行测试

输入--source 1.mp4,则表示用1.mp4视频文件进行测试。

运行时,还可能有下面的提示,这是在下载模型文件。

Downloading https://github.com/ultralytics/yolov5/releases/download/v5.0/yolov5s.pt to yolov5s.pt...

在以上所有步骤完成后,就可以看到摄像头实时监测的成果。(我的电脑没有摄像头,故此处不予图片说明)

- 数据标注

下载标注工具labelme:https://github.com/wkentaro/labelme,然后点击Open Dir,打开待标注图像目录,点击Create Polygons,一般是标注物体的关键点,例如绝缘子的4个顶点,依次点击(可以事先约定好点击的顺序,如果不好约定顺序的,就按同一个方向点击),连成一个闭合多边形;点击Next Image,它会提示你保存。这个软件保存的格式是json文件。打开json文件,你会发现它的内容就是完全符合python的列表 [ ] 和字典 { } 的格式。

最后需要把json的标注文件转换为yolo的txt文件,这里有参考代码:https://github.com/ivder/LabelMeYoloConverter

进行到这一步,所以的前置准备就都完成了,接下来就是要进行一系列的编译和学习,让yolov5能够正常工作。