深度学习—历史发展

深度学习的历史发展

- 1. 导语

- 2. 人工神经网络的历史

-

- 2.1 人工神经网络的劣势

- 2.2 人工神经网络三剑客

- 3. 深度学习发展中的革新事件

- 参考资料

1. 导语

从这一讲开始,我们将进入目前最火热的人工智能领域—深度学习(Deep Learning)。我们前面讲到,从上个世纪80年代开始,多层神经网络被提出,它较好地解决了机器学习中的一些实际问题,但是到了上个世纪90年代,人工神经网络的研究却突然进入了沉寂。这是因为上个世纪90年代中期,以支持向量机为代表的一系列机器学习模型的提出,对人工神经网络这样的算法造成了强烈的冲击。

2. 人工神经网络的历史

2.1 人工神经网络的劣势

和支持向量机相比,多层神经网络的劣势:

- 多层神经网络在数学上不够优美,它的优化算法只能获得局部极值,算法的性能与初始值有关。

- 多层神经网络不可解释训练神经网络获得的参数与实际任务的关联性非常模糊。

- 模型可调整的参数很多,它包括网络层数、每层神经元个数、非线性函数、学习率、优化方法、终止条件等,使得训练神经网络变成了一门艺术,而以支持向量机为代表的方法所需要调整的参数却非常少。

- 如果要训练相对复杂的网络,那么需要大量的训练样本。这与支持向量机基于小规模训练样本而产生的方法是背道而驰的。

2.2 人工神经网络三剑客

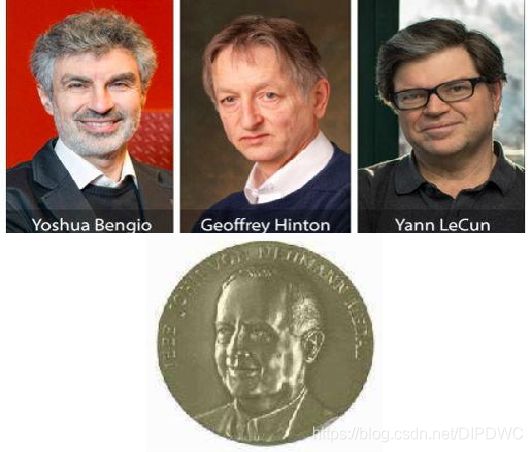

由于这四个方面的劣势,使得人工神经网络的研究进入低潮期,从上个世纪90年代开始到本世纪初的前10年,机器学习方面的重要期刊和会议上,少见神经网络的研究论文。同时,也很少有人继续坚持这个方面的研究,但是研究领域却时常出现另类的学者,下面是三位在人工神经网络这条孤独的道路上前行了20年的学者,他们分别是Geoffrey Hintton、Yann LeCun、Yoshua Bengio。

Geoffrey Hintton作为1986年神经网络后向传播算法的提出者者之一,较早地在人工神经网络领域建立了自己的学术地位,从1987年开始,Geoffrey Hintton在加拿大多伦多大学任教。Yann LeCun是Geoffrey Hintton在多伦多大学的第一个博士后。Yoshua Bengio是Geoffrey Hintton在多伦多大学的同事。

他们三人有一个共识,那就是人工神经网络潜力没有被完全发掘出来,人脑中有850亿~1000亿个神经元,而相比人脑,用计算机构建的神经网络模型过于简单,当年最大规模的人工神经网络的神经元个数顶多在10000左右的量级。

Geoffrey Hintton意识到只有跨越几个数量级去增大神经网络的层数和每层神经元的个数,构建一种深度的神经网络系统,才有可能让人工神经网络的算法发挥出自身的潜力。“深度” 一词在这里第一是指神经网络的层数更多;第二是指每层神经元的个数更多。但具体到什么样的数量级才算深,目前也没有一个统一的定义。

到了本世纪初,计算机的运算速度和存储容量进一步扩展,仿生学派的坚持者们具备了构建更大规模神经网络的物理条件,但是他们遇到了复杂学习模型的参数估计问题。当神经元的个数增加到百万级,待估计的参数将会达到亿级,传统的后向传播算法获得局部极小值不具备典型性,导致在测试样本上的表现会比较差。

Geoffrey Hintton并没有放弃在这条艰巨道路上的探索,他意识到问题的关键不见得是学习模型的复杂性,而在于待估计参数的初始化。传统的后向传播算法,采用随机化权重系数和偏置项的方式对参数进行初始化,在参数个数很多的时候,此方法会以比较大的概率收敛到一个表现比较差的局部极值。如果待估计参数一开始就在一个更优的局部极值附近,那么就有可能克服上述问题获得更好的神经网络模型。经过一系列失败的探索,曙光终于出现,2006年,Geoffrey Hintton在享有盛名的Science杂志上发表了一篇文章,阐述了一种被称为自编码器(Auto-Encoder)的深度神经网络参数初始化方法,并以此对数据进行降维处理,新的方法克服了传统方法的过学习问题,神经网络的研究再一次焕发出生机。从这篇文章开始,深度学习引发的革新持续至今。

3. 深度学习发展中的革新事件

在这场由深度学习引发的革新中,有如下几个值得被关注的事件:

事件一: 2009年,微软美国研究院的Li Deng和Dong Yu等人将深度神经网络和自编码器引入语音识别中,将大词汇连续语音识别系统的识别率提高了10个百分点以上。彻底代替了统治这一领域20多年的基于隐含马尔可夫模型(Hidden Markov Models)和高斯混合模型(Gaussian Mixture Models)的系统。这直接促进了语音识别的落地生根,近年来,语音识别已经在手机、Pad等移动设备中获得了广泛的应用。

事件二: 数据库的构建。Feifei Li等人从2007年开始创造了一个大规模图像识别数据库ImageNet,为深度学习在图像处理领域的发展奠定了数据的基础。

ImageNet包含1000个类,总共有100多万张图片(2009年的规模),现在已经突破千万拖片的量级;图片是正常的图片大小,像素值在250*250左右;同时,ImageNet的构建采用了WordNet结构,拥有多个Node结点,一个节点Node目前含有至少500个对应物体的可供训练的图片/图像。

ImageNet不光有这么多图片,而且对每一张图片都进行了标注,这是一个非常繁琐,需要大量人工的过程,通过两年的时间初步地完成了数据的标注工作。

事件三: 2013年,Geoffrey Hintton的学生Alex Krizhevsk构建了一个包含65万多个神经元,待估计参数超过6000万的大规模神经网络。

他用ImageNet的数据库超过100万张图片进行训练,在ImageNet的测试集上获得了37.5%的Top1错误率(即正确的类不是测试集中排名第一类的百分比)和16.4%的Top5错误率(即正确的类不是测试集中排名前五的百分比)。这比第二名45.7%的Top1错误率和25.8%的Top5错误率搞出了8个百分点。考虑第二名与第三名的差距只有1个百分比左右,这个结果可以说是遥遥领先。

在2013年ImageNet比赛上,他们获得了第一名,而第二名和第三名分别是Goole和Facebook两个大公司的团队。Geoffrey Hintton和他的学生Alex Krizhevsk利用深度学习在图像识别这个任务上打败了两个大公司,这一事件极大地促进了深度学习在工业领域的应用。

事件四: 2016年3月,英国DeepMind公司基于深度学习和强化学习的围棋程序AlphaGo。

在一场五番棋比赛中,以4:1击败了顶尖的职业棋手李世石。成为了第一个不借助让子而击败职业九段起手的计算机围棋程序。这一事件使人工智能走进了公众领域,促进了人功能这一领域的全面火热。

近年来,深度学习领域的研究也获得了越来越广泛的关注,更多的深度学习模型,例如生成对抗网络(Generative Adversarial Networks)、循环神经网络(Recurrent Neural Networks)、图卷积神经网络(Graph Convolutional Neural Networks)。这些架构被提出,同时也被应用到各种机器学习的任务中,促进了图像处理、视频分析、自然语言处理等领域的蓬勃发展。在工业界,深度学习被广泛应用在视频监控、人脸识别、医学图像分析、人机交互、机器人设计等具体的领域。深度学习引发的人工智能革命已经深入到我们生活的方方面面。

在2019年3月,Geoffrey Hintton、Yann LeCun和Yoshua Bengio共同荣获计算机科学领域最高奖“图灵奖”,可谓实至名归。

当然,在繁荣的同时,我们也应该看到深度学习领域已有的问题。正如Yoshua Bengio所说,以前是深度学习的前身人工神经网络的研究很难获得关注,而最近几年却颠倒了过来,不是深度学习的研究很难获得关注,这两种趋势都是不正常的。深度学习有它优势的方面,但是从多层神经网络研究以来所残存的问题,如数学不优美、模型复杂、不可解释、对训练数据量有极高要求等等劣势仍然是客观存在的。在深度学习应用方面蓬勃发展的时候,我们也希望看到其理论方面的突破以及机器学习其他领域相应的发展,构建平衡和多元化的研究生态。

从下一讲开始,我们将介绍深度学习的具体算法和相应的应用细节。

参考资料

- 浙江大学《机器学习》课程—胡浩基老师主讲

如果文章对你有帮助,请记得点赞与关注,谢谢!

![]()