Python数据分析理论与实战完整版本

Python数据分析基础

- 一、Python数据分析初探

- 二、数据获取

-

- 2.1 数据获取的手段

- 2.2 数据仓库

- 2.3 检测与抓取

- 2.4 填写、埋点、日志

- 2.5 计算

- 2.6 数据学习网站

- 三、单因子探索分析与可视化

-

- 3.1 理论铺垫

- 3.2 数据分类

- 3.3 单属性分析

- 3.4 单因子分析实战

- 3.5 可视化

- 小节

- 四、多因子探索分析

-

- 4.1 假设检验

- 4.2 卡方检验

- 4.3 方差检验

- 4.4 相关系数

- 4.5 线性回归

- 4.6 主成分分析

- 4.7 代码实现

- 4.8 交叉分析方法与实现

- 4.9 分组分析方法与实现

- 4.10 相关分析方法与实现

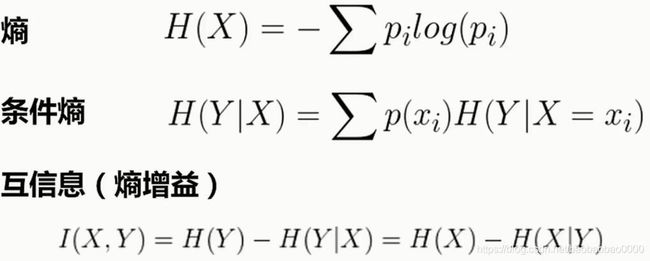

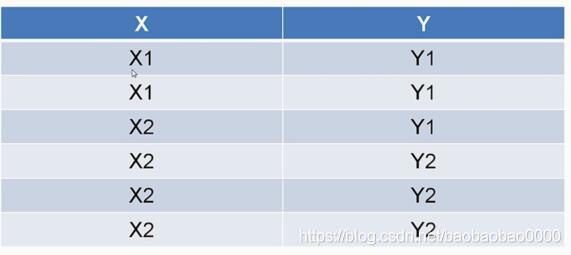

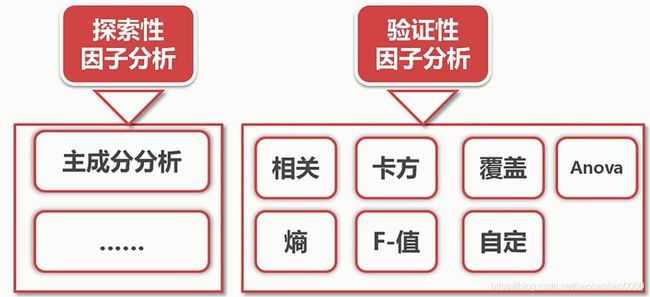

- 4.11 因子分析(成分分析)

- 小结

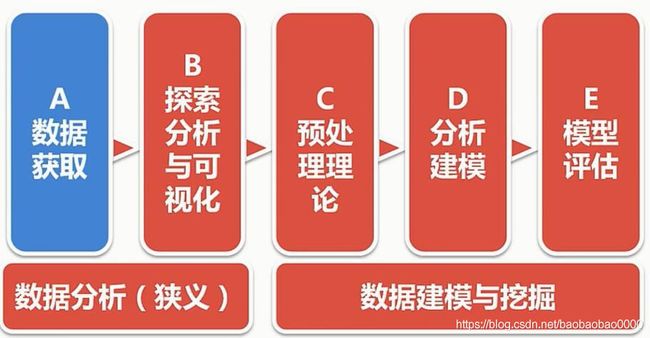

一、Python数据分析初探

本次我们将从以上路线学习数据分析,本次课程使用python 3 编码学习。另外本章节学习所用的数据集可以kaggle上搜索HR.csv即可获得。

Python这门语言是Guido van Rossum在1989圣诞暑假研究出来的一门语言。特点是:简洁,开发效率高,运算速度慢,胶水特性。

二、数据获取

2.1 数据获取的手段

1.数据仓库

2.监测和抓取

3.填写、日志、埋点

4.计算

2.2 数据仓库

什么是数据仓库?

比如我们建立一个买书的网站,我们要建一个数据库存储各个用户信息,书籍信息,根据用户注册购买等行为,整个网站就运行起来了。网站发展很好,规模不断扩大,网站发展的方向就是一个问题。比如接下来该买什么数,给相应的用户推荐他需要的书。这就需要进行分析,数据分析仅仅依靠我们的数据库是不够的。我们需要一个东西把用户交互数据的变动信息记录下来,如记录某用户在几时几分几秒浏览的哪个页面,购买了什么书之类的。文件和日志也能完成这个记录但是不方面查找、比较和抽取特征等操作。所以我们需要一个载体记录业务流程中的每个细节,这就是数据仓库了。

将所有业务数据经汇总处理,构成数据仓库(DW)

1.全部实施的纪录

2.部分维度与数据的整理(数据集市-DM)

数据库 VS 仓库

1.数据库面向业务存储,仓库面向主题存储(主题:较高层次上对分析对象数据的一个完整并且一致的描述)

2.数据库针对应用(OLTP),仓库针对分析(OLAP)

3.数据库组织规范,仓库可能冗余,相对变化大,数据量大

2.3 检测与抓取

常用工具:

urllib、requests、scrapy

PhantomJS、beautifulSoup、Xpath

2.4 填写、埋点、日志

1.用户填写信息

2.APP或网页埋点(特点流程的信息记录点)

3.操作日志

2.5 计算

通过已有数据计算生成衍生数据

2.6 数据学习网站

数据竞赛网站(Kaggle&天池)

数据集网站(ImageNet/Open Images)

统计数据(统计局、政府机关、公司财报等)

三、单因子探索分析与可视化

3.1 理论铺垫

(1)集中趋势:均值、中位数与分位数、众数

四分位数计算方法:

Q1的位置= (n+1) × 0.25

Q2的位置= (n+1) × 0.5

Q3的位置= (n+1) × 0.75

实例1:

数据总量: 6, 47, 49, 15, 42, 41, 7, 39, 43, 40, 36

由小到大排列的结果: 6, 7, 15, 36, 39, 40, 41, 42, 43, 47, 49,一共11项

Q1 的位置=(11+1) × 0.25=3, Q2 的位置=(11+1)× 0.5=6, Q3的位置=(11+1) × 0.75=9,故

Q1 = 15,

Q2 = 40,

Q3 = 43

实例2:

数据总量: 7, 15, 36, 39, 40, 41,一共6项

数列项为偶数项时,四分位数Q2为该组数列的中数,

(n+1)/4= 7/4 =1.75,Q1在第一与第二个数字之间,

3(n+1)/4= 21/4 =5.25, Q3在第五与第六个数字之间,

Q1 = 0.7515+0.257 = 13,

Q2 = (36+39)/2= 37.5,

Q3 = 0.2541+0.7540 = 40.25.

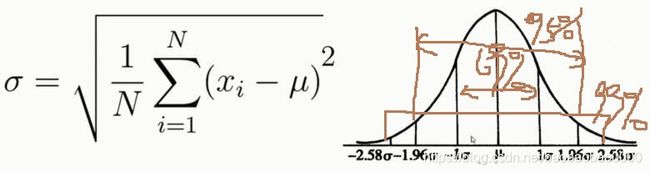

(2)离中趋势:标准差、方差

注意:正太分布离中趋势,在-σ到σ概率未69%,在-1.96σ到1.96σ概率为95%,在-2.58σ到2.58σ概率为99%

(3)数据分布:偏态与峰态

偏态系数:数据平均值偏离状态的衡量

偏态系数 =0表示其数据分布形态与正态分布的偏斜程度相同;

偏态系数 >0表示其数据分布形态与正态分布相比为正偏(右偏),即有一条长尾巴拖在右边,数据右端有较多的极端值,数据均值右侧的离散程度强;均值相对较大。

偏态 <0表示其数据分布形态与正态分布相比为负偏(左偏),即有一条长尾拖在左边,数据左端有较多的极端值,数据均值左侧的离散程度强,均值相对较小。

举个例子,一组数,1 2 3 4 (6) 20,中位数是3,平均数是6。6比大多数数据都要大。偏态系数公式S如下:

峰态系数:数据分布集中强度的衡量,系数公式K如上。峰度又称峰态系数,表征概率密度分布曲线在平均值处峰值高低的特征数,即是描述总体中所有取值分布形态陡缓程度的统计量。直观看来,峰度反映了峰部的尖度。这个统计量需要与正态分布相比较。他的一个重要作用就是判断该分布是否是正态分布。

峰度 =0表示该总体数据分布与正态分布的陡缓程度相同;

峰度 >0表示该总体数据分布与正态分布相比较为陡峭,为尖顶峰;

峰度 <0表示该总体数据分布与正态分布相比较为平坦,为平顶峰。

峰度的绝对值数值越大表示其分布形态的陡缓程度与正态分布的差异程度越大。

(4)正态分布与三大分布

(5)抽样定理:抽样误差、抽样精度

δ²是总体方差,Zα 表示多少概率需要多少倍的σ,Δ²是我们要控制的方差,δ²是总体方差

下面看看实例2:

原教程视频中计算有错误,我计算的是4条。

(6)编码实践上述理论

import pandas as pd

df = pd.read_csv('HR.csv')

df

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | sales | salary | |

|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 0.38 | 0.53 | 2 | 157 | 3 | 0 | 1 | 0 | sales | low |

| 1 | 0.80 | 0.86 | 5 | 262 | 6 | 0 | 1 | 0 | sales | medium |

| 2 | 0.11 | 0.88 | 7 | 272 | 4 | 0 | 1 | 0 | sales | medium |

| 3 | 0.72 | 0.87 | 5 | 223 | 5 | 0 | 1 | 0 | sales | low |

| 4 | 0.37 | 0.52 | 2 | 159 | 3 | 0 | 1 | 0 | sales | low |

| 5 | 0.41 | 0.50 | 2 | 153 | 3 | 0 | 1 | 0 | sales | low |

| 6 | 0.10 | 0.77 | 6 | 247 | 4 | 0 | 1 | 0 | sales | low |

| 7 | 0.92 | 0.85 | 5 | 259 | 5 | 0 | 1 | 0 | sales | low |

| 8 | 0.89 | 1.00 | 5 | 224 | 5 | 0 | 1 | 0 | sales | low |

| 9 | 0.42 | 0.53 | 2 | 142 | 3 | 0 | 1 | 0 | sales | low |

| 10 | 0.45 | 0.54 | 2 | 135 | 3 | 0 | 1 | 0 | sales | low |

| 11 | 0.11 | 0.81 | 6 | 305 | 4 | 0 | 1 | 0 | sales | low |

| 12 | 0.84 | 0.92 | 4 | 234 | 5 | 0 | 1 | 0 | sales | low |

| 13 | 0.41 | 0.55 | 2 | 148 | 3 | 0 | 1 | 0 | sales | low |

| 14 | 0.36 | 0.56 | 2 | 137 | 3 | 0 | 1 | 0 | sales | low |

| 15 | 0.38 | 0.54 | 2 | 143 | 3 | 0 | 1 | 0 | sales | low |

| 16 | 0.45 | 0.47 | 2 | 160 | 3 | 0 | 1 | 0 | sales | low |

| 17 | 0.78 | 0.99 | 4 | 255 | 6 | 0 | 1 | 0 | sales | low |

| 18 | 0.45 | 0.51 | 2 | 160 | 3 | 1 | 1 | 1 | sales | low |

| 19 | 0.76 | 0.89 | 5 | 262 | 5 | 0 | 1 | 0 | sales | low |

| 20 | 0.11 | 0.83 | 6 | 282 | 4 | 0 | 1 | 0 | sales | low |

| 21 | 0.38 | 0.55 | 2 | 147 | 3 | 0 | 1 | 0 | sales | low |

| 22 | 0.09 | 0.95 | 6 | 304 | 4 | 0 | 1 | 0 | sales | low |

| 23 | 0.46 | 0.57 | 2 | 139 | 3 | 0 | 1 | 0 | sales | low |

| 24 | 0.40 | 0.53 | 2 | 158 | 3 | 0 | 1 | 0 | sales | low |

| 25 | 0.89 | 0.92 | 5 | 242 | 5 | 0 | 1 | 0 | sales | low |

| 26 | 0.82 | 0.87 | 4 | 239 | 5 | 0 | 1 | 0 | sales | low |

| 27 | 0.40 | 0.49 | 2 | 135 | 3 | 0 | 1 | 0 | sales | low |

| 28 | 0.41 | 0.46 | 2 | 128 | 3 | 0 | 1 | 0 | accounting | low |

| 29 | 0.38 | 0.50 | 2 | 132 | 3 | 0 | 1 | 0 | accounting | low |

| ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... |

| 14971 | 0.39 | 0.45 | 2 | 140 | 3 | 0 | 1 | 0 | sales | medium |

| 14972 | 0.11 | 0.97 | 6 | 310 | 4 | 0 | 1 | 0 | accounting | medium |

| 14973 | 0.36 | 0.52 | 2 | 143 | 3 | 0 | 1 | 0 | accounting | medium |

| 14974 | 0.36 | 0.54 | 2 | 153 | 3 | 0 | 1 | 0 | accounting | medium |

| 14975 | 0.10 | 0.79 | 7 | 310 | 4 | 0 | 1 | 0 | hr | medium |

| 14976 | 0.40 | 0.47 | 2 | 136 | 3 | 0 | 1 | 0 | hr | medium |

| 14977 | 0.81 | 0.85 | 4 | 251 | 6 | 0 | 1 | 0 | hr | medium |

| 14978 | 0.40 | 0.47 | 2 | 144 | 3 | 0 | 1 | 0 | hr | medium |

| 14979 | 0.09 | 0.93 | 6 | 296 | 4 | 0 | 1 | 0 | technical | medium |

| 14980 | 0.76 | 0.89 | 5 | 238 | 5 | 0 | 1 | 0 | technical | high |

| 14981 | 0.73 | 0.93 | 5 | 162 | 4 | 0 | 1 | 0 | technical | low |

| 14982 | 0.38 | 0.49 | 2 | 137 | 3 | 0 | 1 | 0 | technical | medium |

| 14983 | 0.72 | 0.84 | 5 | 257 | 5 | 0 | 1 | 0 | technical | medium |

| 14984 | 0.40 | 0.56 | 2 | 148 | 3 | 0 | 1 | 0 | technical | medium |

| 14985 | 0.91 | 0.99 | 5 | 254 | 5 | 0 | 1 | 0 | technical | medium |

| 14986 | 0.85 | 0.85 | 4 | 247 | 6 | 0 | 1 | 0 | technical | low |

| 14987 | 0.90 | 0.70 | 5 | 206 | 4 | 0 | 1 | 0 | technical | low |

| 14988 | 0.46 | 0.55 | 2 | 145 | 3 | 0 | 1 | 0 | technical | low |

| 14989 | 0.43 | 0.57 | 2 | 159 | 3 | 1 | 1 | 0 | technical | low |

| 14990 | 0.89 | 0.88 | 5 | 228 | 5 | 1 | 1 | 0 | support | low |

| 14991 | 0.09 | 0.81 | 6 | 257 | 4 | 0 | 1 | 0 | support | low |

| 14992 | 0.40 | 0.48 | 2 | 155 | 3 | 0 | 1 | 0 | support | low |

| 14993 | 0.76 | 0.83 | 6 | 293 | 6 | 0 | 1 | 0 | support | low |

| 14994 | 0.40 | 0.57 | 2 | 151 | 3 | 0 | 1 | 0 | support | low |

| 14995 | 0.37 | 0.48 | 2 | 160 | 3 | 0 | 1 | 0 | support | low |

| 14996 | 0.37 | 0.53 | 2 | 143 | 3 | 0 | 1 | 0 | support | low |

| 14997 | 0.11 | 0.96 | 6 | 280 | 4 | 0 | 1 | 0 | support | low |

| 14998 | 0.37 | 0.52 | 2 | 158 | 3 | 0 | 1 | 0 | support | low |

| 14999 | NaN | 0.52 | 2 | 223 | 5 | 0 | 1 | 0 | support | low |

| 15000 | NaN | 999999.00 | 2 | 159 | 3 | 0 | 1 | 0 | support | nme |

15001 rows × 10 columns

type(df)

pandas.core.frame.DataFrame

type(df["satisfaction_level"])

pandas.core.series.Series

df.mean()

satisfaction_level 0.612834

last_evaluation 67.378197

number_project 3.802813

average_montly_hours 201.048997

time_spend_company 3.498300

Work_accident 0.144590

left 0.238184

promotion_last_5years 0.021265

dtype: float64

type(df.mean())

pandas.core.series.Series

df["satisfaction_level"].mean()

0.6128335222348166

df.median()

satisfaction_level 0.64

last_evaluation 0.72

number_project 4.00

average_montly_hours 200.00

time_spend_company 3.00

Work_accident 0.00

left 0.00

promotion_last_5years 0.00

dtype: float64

df["satisfaction_level"].median()

0.64

df.quantile(q=0.25)

satisfaction_level 0.44

last_evaluation 0.56

number_project 3.00

average_montly_hours 156.00

time_spend_company 3.00

Work_accident 0.00

left 0.00

promotion_last_5years 0.00

Name: 0.25, dtype: float64

df["satisfaction_level"].quantile(q=0.25)

0.44

df.mode()

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | sales | salary | |

|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 0.1 | 0.55 | 4.0 | 135 | 3.0 | 0.0 | 0.0 | 0.0 | sales | low |

| 1 | NaN | NaN | NaN | 156 | NaN | NaN | NaN | NaN | NaN | NaN |

df["satisfaction_level"].mode()

0 0.1

dtype: float64

df["sales"].mode()

0 sales

dtype: object

df.std()

satisfaction_level 0.248631

last_evaluation 8164.679648

number_project 1.232686

average_montly_hours 49.941272

time_spend_company 1.460096

Work_accident 0.351699

left 0.425987

promotion_last_5years 0.144272

dtype: float64

df["satisfaction_level"].std()

0.2486306510611418

df.var()

satisfaction_level 6.181720e-02

last_evaluation 6.666199e+07

number_project 1.519515e+00

average_montly_hours 2.494131e+03

time_spend_company 2.131880e+00

Work_accident 1.236922e-01

left 1.814645e-01

promotion_last_5years 2.081443e-02

dtype: float64

df["satisfaction_level"].var()

0.061817200647087255

df.sum()

satisfaction_level 9191.89

last_evaluation 1.01074e+06

number_project 57046

average_montly_hours 3015936

time_spend_company 52478

Work_accident 2169

left 3573

promotion_last_5years 319

sales salessalessalessalessalessalessalessalessaless...

salary lowmediummediumlowlowlowlowlowlowlowlowlowlowl...

dtype: object

df["satisfaction_level"].sum()

9191.89

df.skew()

satisfaction_level -0.476360

last_evaluation 122.478569

number_project 0.337751

average_montly_hours 0.052887

time_spend_company 1.853157

Work_accident 2.021370

left 1.229385

promotion_last_5years 6.637440

dtype: float64

df["satisfaction_level"].skew() # 偏态系数

-0.4763603412839644

df.kurt() # 峰态系数

satisfaction_level -0.670859

last_evaluation 15000.999987

number_project -0.495699

average_montly_hours -1.134916

time_spend_company 4.772766

Work_accident 2.086216

left -0.488677

promotion_last_5years 42.061224

dtype: float64

df["satisfaction_level"].kurt()

-0.6708586220574557

import scipy.stats as ss

ss.norm # 生成一个正态分布

ss.norm.stats(moments='mvsk')

# mvsk

# m mean

# v var

# s skew

# k kurt

# 下面输出的是标准正太分布的相关参数

(array(0.), array(1.), array(0.), array(0.))

ss.norm.pdf(0.0) # 0.39894228.... pdf 是输入横坐标,输出纵坐标,分布函数在0处的值

0.3989422804014327

ss.norm.ppf(0.9) # 输入参数必须0-1之间。

# 1.28155... ppf 是一个累积值,从负无穷大到某点积分是0.9,这个点是多少。

# 负无穷到正无穷是1,当时0.9的时候,是多少

1.2815515655446004

ss.norm.cdf(2) # 从负无穷到2,它的累积概率是多少

0.9772498680518208

ss.norm.cdf(2) - ss.norm.cdf(-2) # 0.95

0.9544997361036416

ss.norm.rvs(size=10) # 得到10个符合正太分布的数字

array([-0.57057331, -0.7166785 , 0.87394188, 0.24162614, -0.55360322,

2.09826541, 0.40785991, -0.02672143, -0.73308176, -1.1403666 ])

ss.chi2 # 卡方分布,操作和正态分布一样。pdf,ppf等

ss.t # t分布,操作和正态分布一样。pdf,ppf等

ss.f # F分布,操作和正态分布一样。pdf,ppf等

df.sample(n=10) # 抽样10个

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | sales | salary | |

|---|---|---|---|---|---|---|---|---|---|---|

| 12129 | 0.37 | 0.45 | 2 | 151 | 3 | 0 | 1 | 0 | support | low |

| 959 | 0.10 | 0.94 | 7 | 281 | 4 | 0 | 1 | 0 | technical | medium |

| 13851 | 0.51 | 0.52 | 3 | 188 | 3 | 0 | 0 | 0 | technical | high |

| 3398 | 0.64 | 0.50 | 3 | 238 | 4 | 0 | 0 | 0 | technical | low |

| 7820 | 0.12 | 0.84 | 4 | 218 | 6 | 0 | 0 | 0 | technical | medium |

| 9174 | 0.62 | 0.75 | 4 | 183 | 4 | 1 | 0 | 0 | sales | low |

| 14469 | 0.88 | 0.88 | 5 | 232 | 5 | 1 | 1 | 0 | accounting | medium |

| 2096 | 0.86 | 1.00 | 4 | 256 | 3 | 0 | 0 | 0 | technical | medium |

| 12619 | 0.43 | 0.51 | 2 | 141 | 3 | 0 | 1 | 0 | sales | low |

| 1406 | 0.15 | 0.62 | 4 | 257 | 3 | 0 | 1 | 0 | hr | low |

df.sample(frac=0.01) # 按百分比抽样

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | sales | salary | |

|---|---|---|---|---|---|---|---|---|---|---|

| 13585 | 0.98 | 0.89 | 4 | 218 | 2 | 0 | 0 | 0 | sales | medium |

| 14226 | 0.38 | 0.54 | 2 | 143 | 3 | 0 | 1 | 0 | sales | low |

| 8034 | 0.90 | 0.53 | 3 | 270 | 3 | 0 | 0 | 0 | sales | medium |

| 2327 | 0.38 | 0.64 | 3 | 111 | 3 | 0 | 0 | 0 | technical | medium |

| 4455 | 0.68 | 1.00 | 6 | 258 | 5 | 0 | 0 | 0 | sales | low |

| 10915 | 0.98 | 0.67 | 4 | 209 | 6 | 0 | 0 | 0 | marketing | low |

| 14868 | 0.43 | 0.55 | 2 | 130 | 3 | 0 | 1 | 0 | support | high |

| 256 | 0.11 | 0.81 | 6 | 266 | 4 | 1 | 1 | 0 | sales | medium |

| 7548 | 0.96 | 0.78 | 3 | 209 | 2 | 0 | 0 | 0 | product_mng | high |

| 11487 | 0.75 | 0.53 | 4 | 224 | 4 | 1 | 0 | 0 | support | medium |

| 11448 | 0.57 | 0.46 | 3 | 186 | 3 | 1 | 0 | 0 | IT | medium |

| 7752 | 0.13 | 0.74 | 6 | 132 | 4 | 1 | 0 | 0 | technical | medium |

| 859 | 0.10 | 0.93 | 6 | 270 | 4 | 0 | 1 | 0 | sales | low |

| 2908 | 0.73 | 0.75 | 3 | 259 | 4 | 0 | 0 | 0 | marketing | medium |

| 8519 | 0.50 | 0.59 | 4 | 157 | 2 | 0 | 0 | 0 | technical | low |

| 6031 | 0.23 | 0.88 | 5 | 156 | 4 | 0 | 0 | 0 | sales | low |

| 13139 | 0.98 | 0.58 | 3 | 183 | 3 | 0 | 0 | 0 | sales | low |

| 5357 | 0.53 | 0.82 | 5 | 184 | 3 | 0 | 0 | 0 | sales | medium |

| 13446 | 0.65 | 0.62 | 4 | 258 | 2 | 0 | 0 | 0 | support | high |

| 13858 | 0.31 | 0.63 | 4 | 104 | 7 | 1 | 0 | 0 | sales | medium |

| 7008 | 0.56 | 0.68 | 3 | 109 | 3 | 0 | 0 | 0 | IT | low |

| 14682 | 0.44 | 0.53 | 2 | 149 | 3 | 0 | 1 | 0 | sales | low |

| 7519 | 0.18 | 0.86 | 6 | 264 | 3 | 0 | 0 | 0 | technical | high |

| 5014 | 0.92 | 1.00 | 3 | 212 | 2 | 0 | 0 | 0 | support | low |

| 2526 | 0.62 | 0.49 | 4 | 218 | 4 | 0 | 0 | 0 | sales | medium |

| 12563 | 0.10 | 0.77 | 7 | 291 | 4 | 0 | 1 | 0 | accounting | low |

| 11022 | 0.96 | 0.89 | 3 | 142 | 4 | 0 | 0 | 0 | sales | medium |

| 3440 | 0.96 | 0.61 | 3 | 140 | 3 | 0 | 0 | 0 | marketing | low |

| 11761 | 0.88 | 0.83 | 4 | 273 | 10 | 0 | 0 | 0 | sales | medium |

| 42 | 0.40 | 0.46 | 2 | 127 | 3 | 0 | 1 | 0 | technical | low |

| ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... |

| 3556 | 0.75 | 0.66 | 4 | 202 | 2 | 0 | 0 | 0 | support | low |

| 12170 | 0.81 | 0.99 | 4 | 259 | 5 | 0 | 1 | 0 | sales | low |

| 1724 | 0.92 | 0.89 | 4 | 241 | 5 | 0 | 1 | 0 | technical | low |

| 1867 | 0.44 | 0.48 | 2 | 158 | 3 | 0 | 1 | 0 | technical | low |

| 2117 | 0.78 | 0.72 | 5 | 270 | 3 | 1 | 0 | 0 | technical | low |

| 12660 | 0.44 | 0.50 | 2 | 130 | 3 | 0 | 1 | 0 | support | medium |

| 10126 | 0.93 | 0.71 | 4 | 272 | 2 | 0 | 0 | 0 | support | medium |

| 12949 | 0.68 | 0.84 | 3 | 270 | 3 | 0 | 0 | 0 | support | high |

| 14244 | 0.45 | 0.55 | 2 | 140 | 3 | 0 | 1 | 0 | hr | low |

| 14276 | 0.81 | 0.70 | 6 | 161 | 4 | 0 | 1 | 0 | IT | medium |

| 11376 | 0.95 | 0.52 | 3 | 183 | 2 | 1 | 0 | 0 | sales | low |

| 13005 | 0.66 | 0.80 | 4 | 192 | 3 | 0 | 0 | 0 | hr | medium |

| 709 | 0.42 | 0.48 | 2 | 140 | 3 | 0 | 1 | 0 | sales | low |

| 4094 | 0.30 | 0.80 | 6 | 250 | 3 | 0 | 0 | 0 | support | low |

| 4843 | 0.70 | 0.98 | 4 | 176 | 5 | 0 | 0 | 0 | technical | low |

| 268 | 0.38 | 0.56 | 2 | 156 | 3 | 0 | 1 | 0 | technical | low |

| 13334 | 0.99 | 0.86 | 3 | 167 | 2 | 0 | 0 | 0 | sales | low |

| 1154 | 0.39 | 0.53 | 2 | 131 | 3 | 0 | 1 | 0 | sales | medium |

| 5528 | 0.79 | 0.71 | 4 | 222 | 3 | 0 | 0 | 1 | hr | high |

| 2005 | 0.36 | 0.95 | 3 | 206 | 4 | 0 | 0 | 0 | sales | low |

| 2603 | 0.99 | 0.78 | 4 | 140 | 3 | 0 | 0 | 0 | sales | medium |

| 7789 | 0.77 | 0.78 | 2 | 271 | 3 | 0 | 0 | 0 | management | low |

| 11862 | 0.92 | 1.00 | 4 | 261 | 4 | 0 | 0 | 0 | sales | medium |

| 11388 | 0.52 | 0.80 | 3 | 252 | 4 | 0 | 0 | 0 | product_mng | low |

| 12168 | 0.32 | 0.50 | 2 | 135 | 5 | 0 | 1 | 0 | sales | low |

| 8909 | 0.68 | 0.85 | 3 | 250 | 3 | 0 | 0 | 0 | support | low |

| 12594 | 0.10 | 0.77 | 6 | 255 | 4 | 0 | 1 | 0 | management | low |

| 5498 | 0.97 | 1.00 | 5 | 251 | 2 | 0 | 0 | 0 | accounting | medium |

| 10947 | 0.94 | 0.73 | 3 | 196 | 3 | 0 | 0 | 0 | hr | medium |

| 2593 | 0.57 | 0.90 | 3 | 256 | 4 | 0 | 0 | 0 | RandD | low |

150 rows × 10 columns

df["satisfaction_level"].sample(10)

2512 0.22

3650 0.72

2121 0.75

8606 0.91

11965 0.84

13601 0.49

4951 0.50

12429 0.41

8820 0.23

2712 0.92

Name: satisfaction_level, dtype: float64

3.2 数据分类

定类(类别):根据事物离散、无差别属性进行的分类,如:民族

定序(顺序):可以界定数据的大小,但不能测定差值:如:收入的低、中、高

定距(间隔):可以界定数据大小的同时,可测定差值,但无绝对零点(乘除法之类的无意义),如:温度

定比(比率):可以界定数据大小,可测定差值,有绝对零点

3.3 单属性分析

(1)异常值分析

异常值有:离散异常值,连续异常值,知识异常值。

离散异常值:离散属性定义范围外的所有值均为异常值。比如空值;收入的中高低(如果出现其他结果就是异常值),可以标记出来单独处理。

知识异常值:在限定知识与常识范围外的所有值均为异常值。如身高10米的人。

连续异常值:通过四分位数确定。上界Q3 + k(Q3-Q1)> 正常值 >下界Q1 - k(Q3-Q1),k取1.5-3。连续异常值可以舍弃或用边界值代替,具体业务具体分析。

(2)对比分析

通过比较的方式达到认识事实与了解数据的方法。

比什么:比较的对象是数,绝对数与相对数比较。绝对数就是绝对的数字,比如比较收入,比较身高等。相对数是把几个有联系的指标构成一个数,这个数就是相对数,相对数种类较多,常见的有:

结构相对数,创建的各种率,考试通过率,产品合格率等

比例相对数,总体内用不同部分的数值进行比较。比如传统三大产业的比例

比较相对数,同一时空下的相似或同质的指标进行对比,比如不同时期下同一商品的价格。

动态相对数:一般是有时间概念在里面,物理上的速度等

强度相对数:性质不同但有相互联系的属性进行联合,比如人均概念,我们GDP世界第二,人均就十几名了。

怎么比:

时间维度:同比是和去年同时期比较,环比就是和本年度上个月进行比较。

空间维度:现实方位空间(不同国家,城市等),逻辑空间(同公司不同部门)

经验与计划:经验比较,比如失业率达到多少就会社会大乱,我们需要警戒这个数据。

(3)结构分析

可以看成对比分析中比例相对数的分析,主要有两类,静态结构分析和动态结构分析。

静态结构分析就是直接分析总体的组成,比如我国三大产业的比例,即可了解我国产业结构。

动态结构分析就是以时间为轴,分析结构变化趋势。比如三大产业结构从一个五年计划到下一个五年计划占比变化。

(4)分布分析

1.直接获得概率分布:得到的数排列一下,得到一个分布。

2.判断是不是正态分布,如果是可以用正态分布结论分析该问题。可以通过偏态和峰态判断。

3.极大似然:顾名思义极大相似的样子,相似程度的衡量。给出一串数字,如果我们知道它属于正态分布,那一定可以确定一个均值一个方差。在该均值和方差确定的正态分布下,这串数字的这几个点在这个分布的取值也就是他们的概率,这些值的和或积是最大的,这个和或者积(要取对数)就叫做极大似然。确定是正态分布还是T分布或者F分布,那就比较他们在各自分布下的极大似然,哪个极大似然越大就更接近哪个分布。

3.4 单因子分析实战

这里我们对HR.csv进行分析实战

(1)satisfaction_level 的分析

import numpy as np

import pandas as pd

df = pd.read_csv("HR.csv")

df

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | sales | salary | |

|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 0.38 | 0.53 | 2 | 157 | 3 | 0 | 1 | 0 | sales | low |

| 1 | 0.80 | 0.86 | 5 | 262 | 6 | 0 | 1 | 0 | sales | medium |

| 2 | 0.11 | 0.88 | 7 | 272 | 4 | 0 | 1 | 0 | sales | medium |

| 3 | 0.72 | 0.87 | 5 | 223 | 5 | 0 | 1 | 0 | sales | low |

| 4 | 0.37 | 0.52 | 2 | 159 | 3 | 0 | 1 | 0 | sales | low |

| 5 | 0.41 | 0.50 | 2 | 153 | 3 | 0 | 1 | 0 | sales | low |

| 6 | 0.10 | 0.77 | 6 | 247 | 4 | 0 | 1 | 0 | sales | low |

| 7 | 0.92 | 0.85 | 5 | 259 | 5 | 0 | 1 | 0 | sales | low |

| 8 | 0.89 | 1.00 | 5 | 224 | 5 | 0 | 1 | 0 | sales | low |

| 9 | 0.42 | 0.53 | 2 | 142 | 3 | 0 | 1 | 0 | sales | low |

| 10 | 0.45 | 0.54 | 2 | 135 | 3 | 0 | 1 | 0 | sales | low |

| 11 | 0.11 | 0.81 | 6 | 305 | 4 | 0 | 1 | 0 | sales | low |

| 12 | 0.84 | 0.92 | 4 | 234 | 5 | 0 | 1 | 0 | sales | low |

| 13 | 0.41 | 0.55 | 2 | 148 | 3 | 0 | 1 | 0 | sales | low |

| 14 | 0.36 | 0.56 | 2 | 137 | 3 | 0 | 1 | 0 | sales | low |

| 15 | 0.38 | 0.54 | 2 | 143 | 3 | 0 | 1 | 0 | sales | low |

| 16 | 0.45 | 0.47 | 2 | 160 | 3 | 0 | 1 | 0 | sales | low |

| 17 | 0.78 | 0.99 | 4 | 255 | 6 | 0 | 1 | 0 | sales | low |

| 18 | 0.45 | 0.51 | 2 | 160 | 3 | 1 | 1 | 1 | sales | low |

| 19 | 0.76 | 0.89 | 5 | 262 | 5 | 0 | 1 | 0 | sales | low |

| 20 | 0.11 | 0.83 | 6 | 282 | 4 | 0 | 1 | 0 | sales | low |

| 21 | 0.38 | 0.55 | 2 | 147 | 3 | 0 | 1 | 0 | sales | low |

| 22 | 0.09 | 0.95 | 6 | 304 | 4 | 0 | 1 | 0 | sales | low |

| 23 | 0.46 | 0.57 | 2 | 139 | 3 | 0 | 1 | 0 | sales | low |

| 24 | 0.40 | 0.53 | 2 | 158 | 3 | 0 | 1 | 0 | sales | low |

| 25 | 0.89 | 0.92 | 5 | 242 | 5 | 0 | 1 | 0 | sales | low |

| 26 | 0.82 | 0.87 | 4 | 239 | 5 | 0 | 1 | 0 | sales | low |

| 27 | 0.40 | 0.49 | 2 | 135 | 3 | 0 | 1 | 0 | sales | low |

| 28 | 0.41 | 0.46 | 2 | 128 | 3 | 0 | 1 | 0 | accounting | low |

| 29 | 0.38 | 0.50 | 2 | 132 | 3 | 0 | 1 | 0 | accounting | low |

| ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... |

| 14971 | 0.39 | 0.45 | 2 | 140 | 3 | 0 | 1 | 0 | sales | medium |

| 14972 | 0.11 | 0.97 | 6 | 310 | 4 | 0 | 1 | 0 | accounting | medium |

| 14973 | 0.36 | 0.52 | 2 | 143 | 3 | 0 | 1 | 0 | accounting | medium |

| 14974 | 0.36 | 0.54 | 2 | 153 | 3 | 0 | 1 | 0 | accounting | medium |

| 14975 | 0.10 | 0.79 | 7 | 310 | 4 | 0 | 1 | 0 | hr | medium |

| 14976 | 0.40 | 0.47 | 2 | 136 | 3 | 0 | 1 | 0 | hr | medium |

| 14977 | 0.81 | 0.85 | 4 | 251 | 6 | 0 | 1 | 0 | hr | medium |

| 14978 | 0.40 | 0.47 | 2 | 144 | 3 | 0 | 1 | 0 | hr | medium |

| 14979 | 0.09 | 0.93 | 6 | 296 | 4 | 0 | 1 | 0 | technical | medium |

| 14980 | 0.76 | 0.89 | 5 | 238 | 5 | 0 | 1 | 0 | technical | high |

| 14981 | 0.73 | 0.93 | 5 | 162 | 4 | 0 | 1 | 0 | technical | low |

| 14982 | 0.38 | 0.49 | 2 | 137 | 3 | 0 | 1 | 0 | technical | medium |

| 14983 | 0.72 | 0.84 | 5 | 257 | 5 | 0 | 1 | 0 | technical | medium |

| 14984 | 0.40 | 0.56 | 2 | 148 | 3 | 0 | 1 | 0 | technical | medium |

| 14985 | 0.91 | 0.99 | 5 | 254 | 5 | 0 | 1 | 0 | technical | medium |

| 14986 | 0.85 | 0.85 | 4 | 247 | 6 | 0 | 1 | 0 | technical | low |

| 14987 | 0.90 | 0.70 | 5 | 206 | 4 | 0 | 1 | 0 | technical | low |

| 14988 | 0.46 | 0.55 | 2 | 145 | 3 | 0 | 1 | 0 | technical | low |

| 14989 | 0.43 | 0.57 | 2 | 159 | 3 | 1 | 1 | 0 | technical | low |

| 14990 | 0.89 | 0.88 | 5 | 228 | 5 | 1 | 1 | 0 | support | low |

| 14991 | 0.09 | 0.81 | 6 | 257 | 4 | 0 | 1 | 0 | support | low |

| 14992 | 0.40 | 0.48 | 2 | 155 | 3 | 0 | 1 | 0 | support | low |

| 14993 | 0.76 | 0.83 | 6 | 293 | 6 | 0 | 1 | 0 | support | low |

| 14994 | 0.40 | 0.57 | 2 | 151 | 3 | 0 | 1 | 0 | support | low |

| 14995 | 0.37 | 0.48 | 2 | 160 | 3 | 0 | 1 | 0 | support | low |

| 14996 | 0.37 | 0.53 | 2 | 143 | 3 | 0 | 1 | 0 | support | low |

| 14997 | 0.11 | 0.96 | 6 | 280 | 4 | 0 | 1 | 0 | support | low |

| 14998 | 0.37 | 0.52 | 2 | 158 | 3 | 0 | 1 | 0 | support | low |

| 14999 | NaN | 0.52 | 2 | 223 | 5 | 0 | 1 | 0 | support | low |

| 15000 | NaN | 999999.00 | 2 | 159 | 3 | 0 | 1 | 0 | support | nme |

15001 rows × 10 columns

# 提取出列satisfaction_level数据

sl_s = df["satisfaction_level"]

sl_s

0 0.38

1 0.80

2 0.11

3 0.72

4 0.37

5 0.41

6 0.10

7 0.92

8 0.89

9 0.42

10 0.45

11 0.11

12 0.84

13 0.41

14 0.36

15 0.38

16 0.45

17 0.78

18 0.45

19 0.76

20 0.11

21 0.38

22 0.09

23 0.46

24 0.40

25 0.89

26 0.82

27 0.40

28 0.41

29 0.38

...

14971 0.39

14972 0.11

14973 0.36

14974 0.36

14975 0.10

14976 0.40

14977 0.81

14978 0.40

14979 0.09

14980 0.76

14981 0.73

14982 0.38

14983 0.72

14984 0.40

14985 0.91

14986 0.85

14987 0.90

14988 0.46

14989 0.43

14990 0.89

14991 0.09

14992 0.40

14993 0.76

14994 0.40

14995 0.37

14996 0.37

14997 0.11

14998 0.37

14999 NaN

15000 NaN

Name: satisfaction_level, Length: 15001, dtype: float64

# 看看有没有异常值

sl_s[sl_s.isnull()]

14999 NaN

15000 NaN

Name: satisfaction_level, dtype: float64

# 看一下该行所有数据

df[df["satisfaction_level"].isnull()]

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | sales | salary | |

|---|---|---|---|---|---|---|---|---|---|---|

| 14999 | NaN | 0.52 | 2 | 223 | 5 | 0 | 1 | 0 | support | low |

| 15000 | NaN | 999999.00 | 2 | 159 | 3 | 0 | 1 | 0 | support | nme |

sl_s = sl_s.dropna() # 丢弃异常值

sl_s

0 0.38

1 0.80

2 0.11

3 0.72

4 0.37

5 0.41

6 0.10

7 0.92

8 0.89

9 0.42

10 0.45

11 0.11

12 0.84

13 0.41

14 0.36

15 0.38

16 0.45

17 0.78

18 0.45

19 0.76

20 0.11

21 0.38

22 0.09

23 0.46

24 0.40

25 0.89

26 0.82

27 0.40

28 0.41

29 0.38

...

14969 0.43

14970 0.78

14971 0.39

14972 0.11

14973 0.36

14974 0.36

14975 0.10

14976 0.40

14977 0.81

14978 0.40

14979 0.09

14980 0.76

14981 0.73

14982 0.38

14983 0.72

14984 0.40

14985 0.91

14986 0.85

14987 0.90

14988 0.46

14989 0.43

14990 0.89

14991 0.09

14992 0.40

14993 0.76

14994 0.40

14995 0.37

14996 0.37

14997 0.11

14998 0.37

Name: satisfaction_level, Length: 14999, dtype: float64

sl_s.mean() # 均值

0.6128335222348166

sl_s.std() # 标准差

0.2486306510611418

sl_s.quantile(q=0.25) # 四分位数

0.44

sl_s.skew() # 偏度

-0.4763603412839644

sl_s.kurt() # 峰度

-0.6708586220574557

np.histogram(sl_s.values, bins=np.arange(0.0, 1.1, 0.1))

# 第一个参数为要切分的值,bins为分割点,输出结果表示

# 在0-0.1的数有195个,0.1-0.2有1214个以此类推

(array([ 195, 1214, 532, 974, 1668, 2146, 1972, 2074, 2220, 2004],

dtype=int64),

array([0. , 0.1, 0.2, 0.3, 0.4, 0.5, 0.6, 0.7, 0.8, 0.9, 1. ]))

(2)last_evaluation 的分析

le_s = df["last_evaluation"]

le_s

0 0.53

1 0.86

2 0.88

3 0.87

4 0.52

5 0.50

6 0.77

7 0.85

8 1.00

9 0.53

10 0.54

11 0.81

12 0.92

13 0.55

14 0.56

15 0.54

16 0.47

17 0.99

18 0.51

19 0.89

20 0.83

21 0.55

22 0.95

23 0.57

24 0.53

25 0.92

26 0.87

27 0.49

28 0.46

29 0.50

...

14971 0.45

14972 0.97

14973 0.52

14974 0.54

14975 0.79

14976 0.47

14977 0.85

14978 0.47

14979 0.93

14980 0.89

14981 0.93

14982 0.49

14983 0.84

14984 0.56

14985 0.99

14986 0.85

14987 0.70

14988 0.55

14989 0.57

14990 0.88

14991 0.81

14992 0.48

14993 0.83

14994 0.57

14995 0.48

14996 0.53

14997 0.96

14998 0.52

14999 0.52

15000 999999.00

Name: last_evaluation, Length: 15001, dtype: float64

le_s[le_s.isnull()]

Series([], Name: last_evaluation, dtype: float64)

le_s.mean()

67.37819678688086

le_s.std()

8164.679647813715

le_s.median()

0.72

le_s.max()

999999.0

le_s.min()

0.36

le_s.skew()

122.47856947327085

le_s.kurt()

15000.999986811674

le_s[le_s>1]

15000 999999.0

Name: last_evaluation, dtype: float64

le_s = le_s[le_s < 1]

le_s

0 0.53

1 0.86

2 0.88

3 0.87

4 0.52

5 0.50

6 0.77

7 0.85

9 0.53

10 0.54

11 0.81

12 0.92

13 0.55

14 0.56

15 0.54

16 0.47

17 0.99

18 0.51

19 0.89

20 0.83

21 0.55

22 0.95

23 0.57

24 0.53

25 0.92

26 0.87

27 0.49

28 0.46

29 0.50

30 0.62

...

14970 0.93

14971 0.45

14972 0.97

14973 0.52

14974 0.54

14975 0.79

14976 0.47

14977 0.85

14978 0.47

14979 0.93

14980 0.89

14981 0.93

14982 0.49

14983 0.84

14984 0.56

14985 0.99

14986 0.85

14987 0.70

14988 0.55

14989 0.57

14990 0.88

14991 0.81

14992 0.48

14993 0.83

14994 0.57

14995 0.48

14996 0.53

14997 0.96

14998 0.52

14999 0.52

Name: last_evaluation, Length: 14717, dtype: float64

q_low = le_s.quantile(q=0.25)

q_high = le_s.quantile(q=0.75)

q_interval = q_high - q_low

k = 1.5

le_s = le_s[le_s < q_high + k*q_interval][le_s > q_low - k*q_interval]

le_s

0 0.53

1 0.86

2 0.88

3 0.87

4 0.52

5 0.50

6 0.77

7 0.85

9 0.53

10 0.54

11 0.81

12 0.92

13 0.55

14 0.56

15 0.54

16 0.47

17 0.99

18 0.51

19 0.89

20 0.83

21 0.55

22 0.95

23 0.57

24 0.53

25 0.92

26 0.87

27 0.49

28 0.46

29 0.50

30 0.62

...

14970 0.93

14971 0.45

14972 0.97

14973 0.52

14974 0.54

14975 0.79

14976 0.47

14977 0.85

14978 0.47

14979 0.93

14980 0.89

14981 0.93

14982 0.49

14983 0.84

14984 0.56

14985 0.99

14986 0.85

14987 0.70

14988 0.55

14989 0.57

14990 0.88

14991 0.81

14992 0.48

14993 0.83

14994 0.57

14995 0.48

14996 0.53

14997 0.96

14998 0.52

14999 0.52

Name: last_evaluation, Length: 14717, dtype: float64

np.histogram(le_s.values, bins=np.arange(0.0, 1.1, 0.1))

(array([ 0, 0, 0, 179, 1389, 3396, 2234, 2062, 2752, 2705],

dtype=int64),

array([0. , 0.1, 0.2, 0.3, 0.4, 0.5, 0.6, 0.7, 0.8, 0.9, 1. ]))

le_s.mean()

0.7106292043215237

le_s.std()

0.1681755329761668

le_s.median()

0.71

le_s.max()

0.99

le_s.skew()

-0.02356916850081574

le_s.kurt()

-1.2395312667084741

(3)number_project 的分析

# 静态结构分析

np_s = df["number_project"]

np_s

0 2

1 5

2 7

3 5

4 2

5 2

6 6

7 5

8 5

9 2

10 2

11 6

12 4

13 2

14 2

15 2

16 2

17 4

18 2

19 5

20 6

21 2

22 6

23 2

24 2

25 5

26 4

27 2

28 2

29 2

..

14971 2

14972 6

14973 2

14974 2

14975 7

14976 2

14977 4

14978 2

14979 6

14980 5

14981 5

14982 2

14983 5

14984 2

14985 5

14986 4

14987 5

14988 2

14989 2

14990 5

14991 6

14992 2

14993 6

14994 2

14995 2

14996 2

14997 6

14998 2

14999 2

15000 2

Name: number_project, Length: 15001, dtype: int64

np_s[np_s.isnull()]

Series([], Name: number_project, dtype: int64)

np_s.mean()

3.8028131457902807

np_s.std()

1.232685990976685

np_s.median()

4.0

np_s.max()

7

np_s.min()

2

np_s.skew()

0.3377514421511209

np_s.kurt()

-0.4956991171815397

np_s.value_counts()

4 4365

3 4055

5 2761

2 2390

6 1174

7 256

Name: number_project, dtype: int64

np_s.value_counts(normalize=True)

4 0.290981

3 0.270315

5 0.184054

2 0.159323

6 0.078261

7 0.017066

Name: number_project, dtype: float64

np_s.value_counts(normalize=True).sort_index()

2 0.159323

3 0.270315

4 0.290981

5 0.184054

6 0.078261

7 0.017066

Name: number_project, dtype: float64

(4)average_montly_hours 的分析

amh = df["average_montly_hours"]

amh

0 157

1 262

2 272

3 223

4 159

5 153

6 247

7 259

8 224

9 142

10 135

11 305

12 234

13 148

14 137

15 143

16 160

17 255

18 160

19 262

20 282

21 147

22 304

23 139

24 158

25 242

26 239

27 135

28 128

29 132

...

14971 140

14972 310

14973 143

14974 153

14975 310

14976 136

14977 251

14978 144

14979 296

14980 238

14981 162

14982 137

14983 257

14984 148

14985 254

14986 247

14987 206

14988 145

14989 159

14990 228

14991 257

14992 155

14993 293

14994 151

14995 160

14996 143

14997 280

14998 158

14999 223

15000 159

Name: average_montly_hours, Length: 15001, dtype: int64

amh.mean()

201.0489967335511

amh.std()

49.94127150123472

amh.max()

310

amh.min()

96

amh.skew()

0.05288710654474867

amh.kurt()

-1.1349155456035123

amh = amh[amh < amh.quantile(0.75) + 1.5*(amh.quantile(0.75) - amh.quantile(0.25))][amh > amh.quantile(0.25) - 1.5*(amh.quantile(0.75) - amh.quantile(0.25))]

amh

0 157

1 262

2 272

3 223

4 159

5 153

6 247

7 259

8 224

9 142

10 135

11 305

12 234

13 148

14 137

15 143

16 160

17 255

18 160

19 262

20 282

21 147

22 304

23 139

24 158

25 242

26 239

27 135

28 128

29 132

...

14971 140

14972 310

14973 143

14974 153

14975 310

14976 136

14977 251

14978 144

14979 296

14980 238

14981 162

14982 137

14983 257

14984 148

14985 254

14986 247

14987 206

14988 145

14989 159

14990 228

14991 257

14992 155

14993 293

14994 151

14995 160

14996 143

14997 280

14998 158

14999 223

15000 159

Name: average_montly_hours, Length: 15001, dtype: int64

np.histogram(amh.values, bins=10)

(array([ 367, 1240, 2734, 1722, 1628, 1713, 1906, 2240, 1127, 324],

dtype=int64),

array([ 96. , 117.4, 138.8, 160.2, 181.6, 203. , 224.4, 245.8, 267.2,

288.6, 310. ]))

np.histogram(amh.values, bins=np.arange(amh.min(), amh.max()+10, 10))

# bins左闭右开

(array([ 168, 171, 147, 807, 1153, 1234, 1073, 824, 818, 758, 751,

738, 857, 824, 987, 1002, 1045, 935, 299, 193, 131, 86],

dtype=int64),

array([ 96, 106, 116, 126, 136, 146, 156, 166, 176, 186, 196, 206, 216,

226, 236, 246, 256, 266, 276, 286, 296, 306, 316], dtype=int64))

amh.value_counts(bins=np.arange(amh.min(), amh.max()+10, 10))

# bins左开右闭

(146.0, 156.0] 1277

(136.0, 146.0] 1159

(256.0, 266.0] 1063

(236.0, 246.0] 1006

(156.0, 166.0] 993

(246.0, 256.0] 987

(126.0, 136.0] 886

(216.0, 226.0] 874

(266.0, 276.0] 860

(166.0, 176.0] 832

(226.0, 236.0] 814

(176.0, 186.0] 813

(186.0, 196.0] 761

(196.0, 206.0] 755

(206.0, 216.0] 731

(276.0, 286.0] 319

(95.999, 106.0] 187

(286.0, 296.0] 164

(116.0, 126.0] 162

(106.0, 116.0] 162

(296.0, 306.0] 128

(306.0, 316.0] 68

Name: average_montly_hours, dtype: int64

(5)time_spend_company 的分析

tsc_s = df["time_spend_company"]

tsc_s.value_counts()

3 6444

2 3244

4 2557

5 1474

6 718

10 214

7 188

8 162

Name: time_spend_company, dtype: int64

tsc_s.value_counts().sort_index()

2 3244

3 6444

4 2557

5 1474

6 718

7 188

8 162

10 214

Name: time_spend_company, dtype: int64

tsc_s.mean()

3.498300113325778

(6)Work_accident 的分析

wa_s = df["Work_accident"]

wa_s.value_counts()

0 12832

1 2169

Name: Work_accident, dtype: int64

wa_s.mean()

0.14459036064262382

(7)left 的分析

l_s = df["left"]

l_s.value_counts()

0 11428

1 3573

Name: left, dtype: int64

(8)promotion_last_5years 的分析

pl5_s = df["promotion_last_5years"]

pl5_s.value_counts()

0 14682

1 319

Name: promotion_last_5years, dtype: int64

(9)salary 的分析

s_s = df["salary"]

s_s.value_counts()

low 7317

medium 6446

high 1237

nme 1

Name: salary, dtype: int64

s_s.where(s_s == 'nme')

0 NaN

1 NaN

2 NaN

3 NaN

4 NaN

5 NaN

6 NaN

7 NaN

8 NaN

9 NaN

10 NaN

11 NaN

12 NaN

13 NaN

14 NaN

15 NaN

16 NaN

17 NaN

18 NaN

19 NaN

20 NaN

21 NaN

22 NaN

23 NaN

24 NaN

25 NaN

26 NaN

27 NaN

28 NaN

29 NaN

...

14971 NaN

14972 NaN

14973 NaN

14974 NaN

14975 NaN

14976 NaN

14977 NaN

14978 NaN

14979 NaN

14980 NaN

14981 NaN

14982 NaN

14983 NaN

14984 NaN

14985 NaN

14986 NaN

14987 NaN

14988 NaN

14989 NaN

14990 NaN

14991 NaN

14992 NaN

14993 NaN

14994 NaN

14995 NaN

14996 NaN

14997 NaN

14998 NaN

14999 NaN

15000 nme

Name: salary, Length: 15001, dtype: object

s_s.where(s_s != 'nme')

0 low

1 medium

2 medium

3 low

4 low

5 low

6 low

7 low

8 low

9 low

10 low

11 low

12 low

13 low

14 low

15 low

16 low

17 low

18 low

19 low

20 low

21 low

22 low

23 low

24 low

25 low

26 low

27 low

28 low

29 low

...

14971 medium

14972 medium

14973 medium

14974 medium

14975 medium

14976 medium

14977 medium

14978 medium

14979 medium

14980 high

14981 low

14982 medium

14983 medium

14984 medium

14985 medium

14986 low

14987 low

14988 low

14989 low

14990 low

14991 low

14992 low

14993 low

14994 low

14995 low

14996 low

14997 low

14998 low

14999 low

15000 NaN

Name: salary, Length: 15001, dtype: object

s_s.where(s_s != 'nme').dropna()

0 low

1 medium

2 medium

3 low

4 low

5 low

6 low

7 low

8 low

9 low

10 low

11 low

12 low

13 low

14 low

15 low

16 low

17 low

18 low

19 low

20 low

21 low

22 low

23 low

24 low

25 low

26 low

27 low

28 low

29 low

...

14970 medium

14971 medium

14972 medium

14973 medium

14974 medium

14975 medium

14976 medium

14977 medium

14978 medium

14979 medium

14980 high

14981 low

14982 medium

14983 medium

14984 medium

14985 medium

14986 low

14987 low

14988 low

14989 low

14990 low

14991 low

14992 low

14993 low

14994 low

14995 low

14996 low

14997 low

14998 low

14999 low

Name: salary, Length: 15000, dtype: object

(9)sales 的分析

df.rename(columns={'sales': 'department'}, inplace=True)

d_s = df['department']

d_s.head()

0 sales

1 sales

2 sales

3 sales

4 sales

Name: department, dtype: object

d_s.value_counts(normalize=True)

sales 0.275982

technical 0.181321

support 0.148723

IT 0.081795

product_mng 0.060129

marketing 0.057196

RandD 0.052463

accounting 0.051130

hr 0.049263

management 0.041997

Name: department, dtype: float64

3.5 可视化

python可视化工具:matplotlib、seaborn、plotly

import seaborn as sns

import matplotlib.pyplot as plt

sns.set_style(style='whitegrid') # 设置背景网格

sns.set_context(context='poster', font_scale=0.8) # 图变为原图0.8倍

sns.set_palette(sns.color_palette("RdBu", n_colors=7)) # 设置图填充颜色

plt.title("ASLARY") # 标题

plt.xlabel("salary") # 横轴说明

plt.ylabel("Number") # 纵轴说明

plt.xticks(np.arange(len(df['salary'].value_counts())), df["salary"].value_counts().index)

# 横轴标记

plt.axis([0, 4, 0, 10000]) # 界定横轴纵轴最大值最小值

# 给出横纵坐标画出图

plt.bar(np.arange(len(df['salary'].value_counts()))+0.5, df['salary'].value_counts(), width=0.5)

# 遍历标注数字

for x,y in zip(np.arange(len(df["salary"].value_counts()))+0.5, df["salary"].value_counts()):

plt.text(x, y, y, ha="center", va="bottom")

# 运用seaborn画图

sns.countplot(x="salary", hue="department", data=df)

# 先把表格中的异常值处理了

df = df.dropna(axis=0, how='any')

df

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | department | salary | |

|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 0.38 | 0.53 | 2 | 157 | 3 | 0 | 1 | 0 | sales | low |

| 1 | 0.80 | 0.86 | 5 | 262 | 6 | 0 | 1 | 0 | sales | medium |

| 2 | 0.11 | 0.88 | 7 | 272 | 4 | 0 | 1 | 0 | sales | medium |

| 3 | 0.72 | 0.87 | 5 | 223 | 5 | 0 | 1 | 0 | sales | low |

| 4 | 0.37 | 0.52 | 2 | 159 | 3 | 0 | 1 | 0 | sales | low |

| 5 | 0.41 | 0.50 | 2 | 153 | 3 | 0 | 1 | 0 | sales | low |

| 6 | 0.10 | 0.77 | 6 | 247 | 4 | 0 | 1 | 0 | sales | low |

| 7 | 0.92 | 0.85 | 5 | 259 | 5 | 0 | 1 | 0 | sales | low |

| 8 | 0.89 | 1.00 | 5 | 224 | 5 | 0 | 1 | 0 | sales | low |

| 9 | 0.42 | 0.53 | 2 | 142 | 3 | 0 | 1 | 0 | sales | low |

| 10 | 0.45 | 0.54 | 2 | 135 | 3 | 0 | 1 | 0 | sales | low |

| 11 | 0.11 | 0.81 | 6 | 305 | 4 | 0 | 1 | 0 | sales | low |

| 12 | 0.84 | 0.92 | 4 | 234 | 5 | 0 | 1 | 0 | sales | low |

| 13 | 0.41 | 0.55 | 2 | 148 | 3 | 0 | 1 | 0 | sales | low |

| 14 | 0.36 | 0.56 | 2 | 137 | 3 | 0 | 1 | 0 | sales | low |

| 15 | 0.38 | 0.54 | 2 | 143 | 3 | 0 | 1 | 0 | sales | low |

| 16 | 0.45 | 0.47 | 2 | 160 | 3 | 0 | 1 | 0 | sales | low |

| 17 | 0.78 | 0.99 | 4 | 255 | 6 | 0 | 1 | 0 | sales | low |

| 18 | 0.45 | 0.51 | 2 | 160 | 3 | 1 | 1 | 1 | sales | low |

| 19 | 0.76 | 0.89 | 5 | 262 | 5 | 0 | 1 | 0 | sales | low |

| 20 | 0.11 | 0.83 | 6 | 282 | 4 | 0 | 1 | 0 | sales | low |

| 21 | 0.38 | 0.55 | 2 | 147 | 3 | 0 | 1 | 0 | sales | low |

| 22 | 0.09 | 0.95 | 6 | 304 | 4 | 0 | 1 | 0 | sales | low |

| 23 | 0.46 | 0.57 | 2 | 139 | 3 | 0 | 1 | 0 | sales | low |

| 24 | 0.40 | 0.53 | 2 | 158 | 3 | 0 | 1 | 0 | sales | low |

| 25 | 0.89 | 0.92 | 5 | 242 | 5 | 0 | 1 | 0 | sales | low |

| 26 | 0.82 | 0.87 | 4 | 239 | 5 | 0 | 1 | 0 | sales | low |

| 27 | 0.40 | 0.49 | 2 | 135 | 3 | 0 | 1 | 0 | sales | low |

| 28 | 0.41 | 0.46 | 2 | 128 | 3 | 0 | 1 | 0 | accounting | low |

| 29 | 0.38 | 0.50 | 2 | 132 | 3 | 0 | 1 | 0 | accounting | low |

| ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... |

| 14969 | 0.43 | 0.46 | 2 | 157 | 3 | 0 | 1 | 0 | sales | medium |

| 14970 | 0.78 | 0.93 | 4 | 225 | 5 | 0 | 1 | 0 | sales | medium |

| 14971 | 0.39 | 0.45 | 2 | 140 | 3 | 0 | 1 | 0 | sales | medium |

| 14972 | 0.11 | 0.97 | 6 | 310 | 4 | 0 | 1 | 0 | accounting | medium |

| 14973 | 0.36 | 0.52 | 2 | 143 | 3 | 0 | 1 | 0 | accounting | medium |

| 14974 | 0.36 | 0.54 | 2 | 153 | 3 | 0 | 1 | 0 | accounting | medium |

| 14975 | 0.10 | 0.79 | 7 | 310 | 4 | 0 | 1 | 0 | hr | medium |

| 14976 | 0.40 | 0.47 | 2 | 136 | 3 | 0 | 1 | 0 | hr | medium |

| 14977 | 0.81 | 0.85 | 4 | 251 | 6 | 0 | 1 | 0 | hr | medium |

| 14978 | 0.40 | 0.47 | 2 | 144 | 3 | 0 | 1 | 0 | hr | medium |

| 14979 | 0.09 | 0.93 | 6 | 296 | 4 | 0 | 1 | 0 | technical | medium |

| 14980 | 0.76 | 0.89 | 5 | 238 | 5 | 0 | 1 | 0 | technical | high |

| 14981 | 0.73 | 0.93 | 5 | 162 | 4 | 0 | 1 | 0 | technical | low |

| 14982 | 0.38 | 0.49 | 2 | 137 | 3 | 0 | 1 | 0 | technical | medium |

| 14983 | 0.72 | 0.84 | 5 | 257 | 5 | 0 | 1 | 0 | technical | medium |

| 14984 | 0.40 | 0.56 | 2 | 148 | 3 | 0 | 1 | 0 | technical | medium |

| 14985 | 0.91 | 0.99 | 5 | 254 | 5 | 0 | 1 | 0 | technical | medium |

| 14986 | 0.85 | 0.85 | 4 | 247 | 6 | 0 | 1 | 0 | technical | low |

| 14987 | 0.90 | 0.70 | 5 | 206 | 4 | 0 | 1 | 0 | technical | low |

| 14988 | 0.46 | 0.55 | 2 | 145 | 3 | 0 | 1 | 0 | technical | low |

| 14989 | 0.43 | 0.57 | 2 | 159 | 3 | 1 | 1 | 0 | technical | low |

| 14990 | 0.89 | 0.88 | 5 | 228 | 5 | 1 | 1 | 0 | support | low |

| 14991 | 0.09 | 0.81 | 6 | 257 | 4 | 0 | 1 | 0 | support | low |

| 14992 | 0.40 | 0.48 | 2 | 155 | 3 | 0 | 1 | 0 | support | low |

| 14993 | 0.76 | 0.83 | 6 | 293 | 6 | 0 | 1 | 0 | support | low |

| 14994 | 0.40 | 0.57 | 2 | 151 | 3 | 0 | 1 | 0 | support | low |

| 14995 | 0.37 | 0.48 | 2 | 160 | 3 | 0 | 1 | 0 | support | low |

| 14996 | 0.37 | 0.53 | 2 | 143 | 3 | 0 | 1 | 0 | support | low |

| 14997 | 0.11 | 0.96 | 6 | 280 | 4 | 0 | 1 | 0 | support | low |

| 14998 | 0.37 | 0.52 | 2 | 158 | 3 | 0 | 1 | 0 | support | low |

14999 rows × 10 columns

df = df[df["last_evaluation"] <= 1][df["salary"] != 'nme']

df

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | department | salary | |

|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 0.38 | 0.53 | 2 | 157 | 3 | 0 | 1 | 0 | sales | low |

| 1 | 0.80 | 0.86 | 5 | 262 | 6 | 0 | 1 | 0 | sales | medium |

| 2 | 0.11 | 0.88 | 7 | 272 | 4 | 0 | 1 | 0 | sales | medium |

| 3 | 0.72 | 0.87 | 5 | 223 | 5 | 0 | 1 | 0 | sales | low |

| 4 | 0.37 | 0.52 | 2 | 159 | 3 | 0 | 1 | 0 | sales | low |

| 5 | 0.41 | 0.50 | 2 | 153 | 3 | 0 | 1 | 0 | sales | low |

| 6 | 0.10 | 0.77 | 6 | 247 | 4 | 0 | 1 | 0 | sales | low |

| 7 | 0.92 | 0.85 | 5 | 259 | 5 | 0 | 1 | 0 | sales | low |

| 8 | 0.89 | 1.00 | 5 | 224 | 5 | 0 | 1 | 0 | sales | low |

| 9 | 0.42 | 0.53 | 2 | 142 | 3 | 0 | 1 | 0 | sales | low |

| 10 | 0.45 | 0.54 | 2 | 135 | 3 | 0 | 1 | 0 | sales | low |

| 11 | 0.11 | 0.81 | 6 | 305 | 4 | 0 | 1 | 0 | sales | low |

| 12 | 0.84 | 0.92 | 4 | 234 | 5 | 0 | 1 | 0 | sales | low |

| 13 | 0.41 | 0.55 | 2 | 148 | 3 | 0 | 1 | 0 | sales | low |

| 14 | 0.36 | 0.56 | 2 | 137 | 3 | 0 | 1 | 0 | sales | low |

| 15 | 0.38 | 0.54 | 2 | 143 | 3 | 0 | 1 | 0 | sales | low |

| 16 | 0.45 | 0.47 | 2 | 160 | 3 | 0 | 1 | 0 | sales | low |

| 17 | 0.78 | 0.99 | 4 | 255 | 6 | 0 | 1 | 0 | sales | low |

| 18 | 0.45 | 0.51 | 2 | 160 | 3 | 1 | 1 | 1 | sales | low |

| 19 | 0.76 | 0.89 | 5 | 262 | 5 | 0 | 1 | 0 | sales | low |

| 20 | 0.11 | 0.83 | 6 | 282 | 4 | 0 | 1 | 0 | sales | low |

| 21 | 0.38 | 0.55 | 2 | 147 | 3 | 0 | 1 | 0 | sales | low |

| 22 | 0.09 | 0.95 | 6 | 304 | 4 | 0 | 1 | 0 | sales | low |

| 23 | 0.46 | 0.57 | 2 | 139 | 3 | 0 | 1 | 0 | sales | low |

| 24 | 0.40 | 0.53 | 2 | 158 | 3 | 0 | 1 | 0 | sales | low |

| 25 | 0.89 | 0.92 | 5 | 242 | 5 | 0 | 1 | 0 | sales | low |

| 26 | 0.82 | 0.87 | 4 | 239 | 5 | 0 | 1 | 0 | sales | low |

| 27 | 0.40 | 0.49 | 2 | 135 | 3 | 0 | 1 | 0 | sales | low |

| 28 | 0.41 | 0.46 | 2 | 128 | 3 | 0 | 1 | 0 | accounting | low |

| 29 | 0.38 | 0.50 | 2 | 132 | 3 | 0 | 1 | 0 | accounting | low |

| ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... |

| 14969 | 0.43 | 0.46 | 2 | 157 | 3 | 0 | 1 | 0 | sales | medium |

| 14970 | 0.78 | 0.93 | 4 | 225 | 5 | 0 | 1 | 0 | sales | medium |

| 14971 | 0.39 | 0.45 | 2 | 140 | 3 | 0 | 1 | 0 | sales | medium |

| 14972 | 0.11 | 0.97 | 6 | 310 | 4 | 0 | 1 | 0 | accounting | medium |

| 14973 | 0.36 | 0.52 | 2 | 143 | 3 | 0 | 1 | 0 | accounting | medium |

| 14974 | 0.36 | 0.54 | 2 | 153 | 3 | 0 | 1 | 0 | accounting | medium |

| 14975 | 0.10 | 0.79 | 7 | 310 | 4 | 0 | 1 | 0 | hr | medium |

| 14976 | 0.40 | 0.47 | 2 | 136 | 3 | 0 | 1 | 0 | hr | medium |

| 14977 | 0.81 | 0.85 | 4 | 251 | 6 | 0 | 1 | 0 | hr | medium |

| 14978 | 0.40 | 0.47 | 2 | 144 | 3 | 0 | 1 | 0 | hr | medium |

| 14979 | 0.09 | 0.93 | 6 | 296 | 4 | 0 | 1 | 0 | technical | medium |

| 14980 | 0.76 | 0.89 | 5 | 238 | 5 | 0 | 1 | 0 | technical | high |

| 14981 | 0.73 | 0.93 | 5 | 162 | 4 | 0 | 1 | 0 | technical | low |

| 14982 | 0.38 | 0.49 | 2 | 137 | 3 | 0 | 1 | 0 | technical | medium |

| 14983 | 0.72 | 0.84 | 5 | 257 | 5 | 0 | 1 | 0 | technical | medium |

| 14984 | 0.40 | 0.56 | 2 | 148 | 3 | 0 | 1 | 0 | technical | medium |

| 14985 | 0.91 | 0.99 | 5 | 254 | 5 | 0 | 1 | 0 | technical | medium |

| 14986 | 0.85 | 0.85 | 4 | 247 | 6 | 0 | 1 | 0 | technical | low |

| 14987 | 0.90 | 0.70 | 5 | 206 | 4 | 0 | 1 | 0 | technical | low |

| 14988 | 0.46 | 0.55 | 2 | 145 | 3 | 0 | 1 | 0 | technical | low |

| 14989 | 0.43 | 0.57 | 2 | 159 | 3 | 1 | 1 | 0 | technical | low |

| 14990 | 0.89 | 0.88 | 5 | 228 | 5 | 1 | 1 | 0 | support | low |

| 14991 | 0.09 | 0.81 | 6 | 257 | 4 | 0 | 1 | 0 | support | low |

| 14992 | 0.40 | 0.48 | 2 | 155 | 3 | 0 | 1 | 0 | support | low |

| 14993 | 0.76 | 0.83 | 6 | 293 | 6 | 0 | 1 | 0 | support | low |

| 14994 | 0.40 | 0.57 | 2 | 151 | 3 | 0 | 1 | 0 | support | low |

| 14995 | 0.37 | 0.48 | 2 | 160 | 3 | 0 | 1 | 0 | support | low |

| 14996 | 0.37 | 0.53 | 2 | 143 | 3 | 0 | 1 | 0 | support | low |

| 14997 | 0.11 | 0.96 | 6 | 280 | 4 | 0 | 1 | 0 | support | low |

| 14998 | 0.37 | 0.52 | 2 | 158 | 3 | 0 | 1 | 0 | support | low |

14999 rows × 10 columns

(1)简单对比分析操作

# 以部门为单位对比

df.groupby("department").mean()

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | |

|---|---|---|---|---|---|---|---|---|

| department | ||||||||

| IT | 0.618142 | 0.716830 | 3.816626 | 202.215974 | 3.468623 | 0.133659 | 0.222494 | 0.002445 |

| RandD | 0.619822 | 0.712122 | 3.853875 | 200.800508 | 3.367217 | 0.170267 | 0.153748 | 0.034307 |

| accounting | 0.582151 | 0.717718 | 3.825293 | 201.162973 | 3.522816 | 0.125163 | 0.265971 | 0.018253 |

| hr | 0.598809 | 0.708850 | 3.654939 | 198.684709 | 3.355886 | 0.120433 | 0.290934 | 0.020298 |

| management | 0.621349 | 0.724000 | 3.860317 | 201.249206 | 4.303175 | 0.163492 | 0.144444 | 0.109524 |

| marketing | 0.618601 | 0.715886 | 3.687646 | 199.385781 | 3.569930 | 0.160839 | 0.236597 | 0.050117 |

| product_mng | 0.619634 | 0.714756 | 3.807095 | 199.965632 | 3.475610 | 0.146341 | 0.219512 | 0.000000 |

| sales | 0.614447 | 0.709717 | 3.776329 | 200.911353 | 3.534058 | 0.141787 | 0.244928 | 0.024155 |

| support | 0.618300 | 0.723109 | 3.803948 | 200.758188 | 3.393001 | 0.154778 | 0.248991 | 0.008973 |

| technical | 0.607897 | 0.721099 | 3.877941 | 202.497426 | 3.411397 | 0.140074 | 0.256250 | 0.010294 |

df.loc[:, ["last_evaluation", "department"]].groupby("department")

df.loc[:, ["last_evaluation", "department"]].groupby("department").mean()

| last_evaluation | |

|---|---|

| department | |

| IT | 0.716830 |

| RandD | 0.712122 |

| accounting | 0.717718 |

| hr | 0.708850 |

| management | 0.724000 |

| marketing | 0.715886 |

| product_mng | 0.714756 |

| sales | 0.709717 |

| support | 0.723109 |

| technical | 0.721099 |

df.loc[:, ["average_montly_hours", "department"]].groupby("department")["average_montly_hours"].apply(lambda x: x.max()-x.min())

department

IT 212

RandD 210

accounting 213

hr 212

management 210

marketing 214

product_mng 212

sales 214

support 214

technical 213

Name: average_montly_hours, dtype: int64

(2)可视化—直方图

f = plt.figure()

f.add_subplot(1, 3, 1)

# ked分布图是否显示,hist直方图是否显示

sns.distplot(df["satisfaction_level"], bins=10)

f.add_subplot(1, 3, 2)

sns.distplot(df["last_evaluation"], bins=10)

f.add_subplot(1, 3, 3)

sns.distplot(df["average_montly_hours"], bins=10)

(3)可视化—箱线图

sns.boxplot(y=df["time_spend_company"])

# saturation分位数,whis是前面说的k

sns.boxplot(x=df["time_spend_company"], saturation=0.75, whis=3)

# saturation分位数,whis是前面说的k

(4)可视化—折线图

sub_df = df.groupby("time_spend_company").mean()

sns.pointplot(sub_df.index, sub_df["left"])

# 在公司呆的时间和离职率关系

sns.pointplot(x=“time_spend_company”, y=“left”, data=df)

(4)可视化—饼图

lbs = df["department"].value_counts().index # 标签

# autopct添加数据

# colors指定颜色

plt.pie(df["department"].value_counts(normalize=True), labels=lbs, autopct="%1.1f%%", colors=sns.color_palette("Reds"))

#seaborn没有饼图

([,

,

,

,

,

,

,

,

,

],

[Text(0.7117131257442415, 0.8387278620883902, 'sales'),

Text(-0.7361690652250792, 0.8173463815333333, 'technical'),

Text(-1.078295473144608, -0.21743705433031926, 'support'),

Text(-0.6639038295740627, -0.8770585528212437, 'IT'),

Text(-0.220711694218203, -1.0776299680480914, 'product_mng'),

Text(0.1824348726672272, -1.0847661117655236, 'marketing'),

Text(0.5381184913305728, -0.9593896441426228, 'RandD'),

Text(0.8166516060190341, -0.7369397223562675, 'accounting'),

Text(1.004980939261518, -0.4472284782088872, 'hr'),

Text(1.090437030943069, -0.1447310662852455, 'management')],

[Text(0.38820715949685897, 0.4574879247754855, '27.6%'),

Text(-0.40154676285004315, 0.44582529901818174, '18.1%'),

Text(-0.5881611671697861, -0.11860202963471958, '14.9%'),

Text(-0.36212936158585235, -0.4783955742661329, '8.2%'),

Text(-0.12038819684629253, -0.587798164389868, '6.0%'),

Text(0.09950993054576027, -0.5916906064175583, '5.7%'),

Text(0.2935191770894033, -0.5233034422596123, '5.2%'),

Text(0.4454463305558367, -0.40196712128523676, '5.1%'),

Text(0.5481714214153734, -0.24394280629575665, '4.9%'),

Text(0.5947838350598559, -0.07894421797377027, '4.2%')])

# 凸显出sales部门

explodes = [0.1 if i=="sales" else 0 for i in lbs]

plt.pie(df["department"].value_counts(normalize=True), explode=explodes, labels=lbs, autopct="%1.1f%%", colors=sns.color_palette("Reds"))

([,

,

,

,

,

,

,

,

,

],

[Text(0.776414318993718, 0.9149758495509712, 'sales'),

Text(-0.7361690652250792, 0.8173463815333333, 'technical'),

Text(-1.078295473144608, -0.21743705433031926, 'support'),

Text(-0.6639038295740627, -0.8770585528212437, 'IT'),

Text(-0.220711694218203, -1.0776299680480914, 'product_mng'),

Text(0.1824348726672272, -1.0847661117655236, 'marketing'),

Text(0.5381184913305728, -0.9593896441426228, 'RandD'),

Text(0.8166516060190341, -0.7369397223562675, 'accounting'),

Text(1.004980939261518, -0.4472284782088872, 'hr'),

Text(1.090437030943069, -0.1447310662852455, 'management')],

[Text(0.45290835274633545, 0.5337359122380665, '27.6%'),

Text(-0.40154676285004315, 0.44582529901818174, '18.1%'),

Text(-0.5881611671697861, -0.11860202963471958, '14.9%'),

Text(-0.36212936158585235, -0.4783955742661329, '8.2%'),

Text(-0.12038819684629253, -0.587798164389868, '6.0%'),

Text(0.09950993054576027, -0.5916906064175583, '5.7%'),

Text(0.2935191770894033, -0.5233034422596123, '5.2%'),

Text(0.4454463305558367, -0.40196712128523676, '5.1%'),

Text(0.5481714214153734, -0.24394280629575665, '4.9%'),

Text(0.5947838350598559, -0.07894421797377027, '4.2%')])

# salary分布

lbs = df["salary"].value_counts().index # 标签

explodes = [0.1 if i=="low" else 0 for i in lbs] # 强调low单独分隔出来

plt.pie(df["salary"].value_counts(normalize=True), explode=explodes, labels=lbs, autopct="%1.1f%%", colors=sns.color_palette("Reds"))

([,

,

],

[Text(0.04611030952732935, 1.1991137724816998, 'low'),

Text(-0.32247422223497674, -1.051670279124568, 'medium'),

Text(1.06328474507822, -0.28182539077227425, 'high')],

[Text(0.026897680557608782, 0.6994830339476582, '48.8%'),

Text(-0.1758950303099873, -0.5736383340679462, '43.0%'),

Text(0.5799734973153926, -0.1537229404212405, '8.2%')])

小节

可视化还有很多图,散点图,雷达图等,可通过官网查阅学习。此外我们数据分析不应当只考虑某一个属性,而应该考虑多属性之间的联系,以及个体数据和总体数据联系。如某个员工满意度和他对公司评价两者之间有没有联系?某个人的工资和总体平均工资关系等。

四、多因子探索分析

上一章节我们介绍了探索性数据分析中的单因子分析和简单的对比分析概念与实践。我们一定要明白探索性数据分析最重要的作用是把数据的全貌进行展现,让数据分析者能根据数据进行决策。每个属性的数据除了自己本身所具有的性质外,属性与属性之间或者属性与某个已知成熟规律之间也可能会有联系。本章节就让我们着重分析属性与属性之间的常见联系的以及相关的分析方法。下面我们主要介绍这几个方面内容:假设检验与方差检验、相关系数与回归分析以及主成分分析和奇异值分解。

4.1 假设检验

假设检验就是根据一定的假设条件,从样本推断总体或者样本与样本之间的一种方法。换言之,假设检验就是提出一个假设,然后根据数据或者已知的分布性质来推断假设成立的概率有多大。具体步骤如下:

1.在假设检验中,我们常把假设和一个已知的分布关联起来,所以一般情况下,原假设的设定为符合该分布,而备择假设设定不符合该分布。

2.选择检验统计量,这个检验统计量是我们根据数据(如均值,方差等性质)构造的一个转换函数。构造这个函数的目的是让这个数据符合一个已知的分布,这样就可以利用相关的结论。比如,我们可以把一些数据减去它的均值再除以标准差。这样判断转换后的统计量也就是我们所说的检验统计量。其是否符合标准正态分布,即可以判断数据的分布是否是正态分布的概率了。

3.根据显著性水平确定拒绝域,显著性水平一般用希腊字母α表示,就是我们可以接受的失真程度的最大限度。显著性水平和相似度的相加和为1。比如我们确定了某数据属性有95%的可能性是某个分布,那么它的显著性水平就是5%。显著性水平一般是人为定的一个值,这个值定的越低那么就相当于对数据和分布的契合程度要求就越高。这个值我们一般取0.05也就是说要求数据有95%的可能与某分布一致。一旦确定了显著性水平,那么这个已知的分布上就可以画出一段与分布相似性较高的区域,我们叫做接受域。如果上一步说的检验统计量落入了拒绝域,那么H0就可以认为是假的,也就是可以被拒绝掉的。

4.计算p值或者样本统计值做出判断。根据计算的统计量和我们要比较的分布进行判断的过程。判断思路有两种,一个是区间估计的方法,计算一个检验统计量的分布区间,看这个区间是否包含了我们要比较的分布的特征。另一个方法就是计算一个p值,直接和显著性水平进行比较。p值可以理解成比我们计算出来的检验统计量结果更差的概率。如果p值小于α,那么这个假设就可以认为是假的。

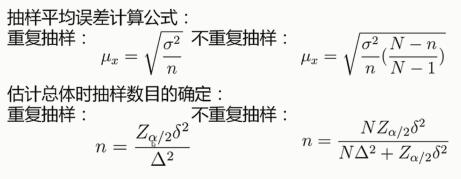

下面我们来看一个例子:

案例如上,一个洗衣粉制造厂,产出如下重量洗衣粉。历史经验告诉我们,洗衣粉标准质量为500g,标准差为2g。那么我们开始进行假设检验。

第一步,我们先确定原假设应尽可能接近于某分布,所以这里我们假设这些样本是符合均值500g标准差2g的正态分布。这就是原假设H0。备择假设就是不符合该正态分布。

第二步,我们就用上述假设构造它的统计量,如上图。它的分子是样本的均值减去我们假设的均值,它的分母则是每袋洗衣粉的误差。那么这个统计量应该是符合标准正态分布的。

第三步,确定显著性水平,我们选择0.05。一旦显著性水平确定了,就可以确定它的接受域,那么接受域以外就是它的拒绝域。拿正态分布图来说,±1.96倍标准差之间的范围,就是95%保证的范围,也就是我们所说的接受域。

第四步,计算检验统计量 计算p值。检验统计量我们可以得到2.23。2.23是通过将上面7组数据代入假设检验量的式子得到后的值的均值。因为得到了2.23.可以看出其已经超过了 0.05所在的1.96σ的范围,从2.23这个点到正无穷,其概率为 0.013,所有就是0.026,0.026小于0.05,它在拒绝域中,所以上面的假设是不能被接受的。计算步骤如下:

(501.8+502.4+499+500.3+504.5+498.2+505.6)/7 = 501.69

(501.69-500)/√(4/7) = 2.23

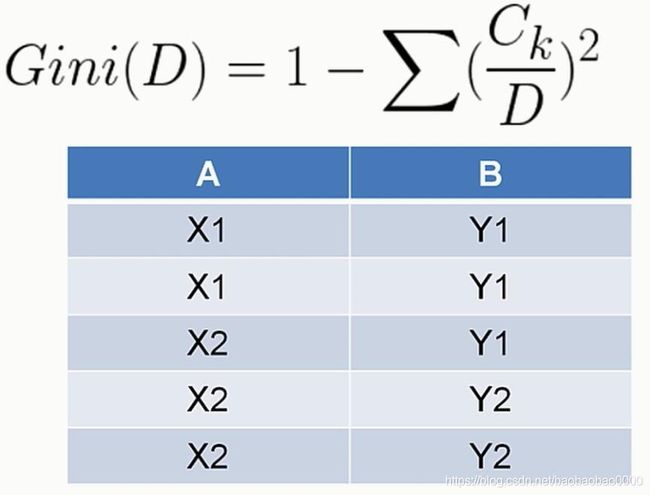

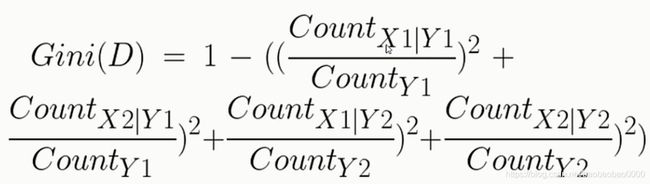

4.2 卡方检验

假设检验的方法有很多,这些方法的差别一般取决于检验统计量的选取上,比如上面我们使用的是μ检验法,还有卡方检验,p分布检验,F检验等流程上是一样的。知识检验时使用的统计量不同,应用的场景也可能有些差异。比如t分布检验常用来比较两组样本分布是否一致,像临床医疗上药物有没有效果就可以用t分布检验。F检验常用在方差分析,后面会介绍。

我们来看一下卡方检验的例子。如我们想看一下化妆这个行为和性别有没有关系。经过调查得到了这个图如下:

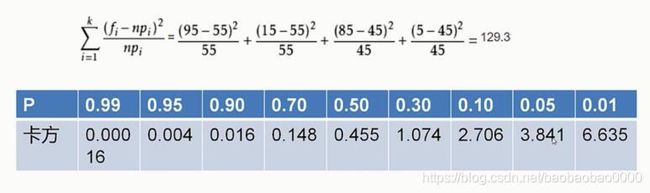

首先我们确定原假设,化妆与性别无关,以及所有的人群中化妆与不化妆的人群中男女分布都是一致的。然后假设检验量就是卡方分布的假设检验量,如上图中的公式,这个fi表示的是实际值,npi表示理论分布,如这张表中男士化妆,实际值是15,理论值是55。因为一共110人男女假设是一致的都是55,男士有100 女士也有100。我们把这些值都计算出来得到129.3,如下所示:

上图的的表示卡方值和p值的对应表,观察一下,发现如果p值取0.05的话,那么卡方值应该是不大于3.841。卡方值129.3明显大于3.841,所以我们可以拒绝原假设,得到的结论是性别与化妆与否是有比较强的关系的。即原假设性别与化妆与否没有关系,就可以被拒绝掉了。使用卡方检验进行这样的分析的方法,也叫做四格表检验法,常用来检验两个因素之间有没有比较强的联系。

4.3 方差检验

前面的例子中我们只研究了一个样本或者两个样本的研究方法。如果有多个样本,检验样本两两之间是不是有差异。一个思路就是用我们之前提到的方法进行两两分析。但这样对比次数可能就会比较大,如果数据样本数量比较多,就比较耗时耗力。还有一种方法就是我们要介绍的方差检验方法。因为它用到了F分布,所以也叫F检验。我们先来看个例子:

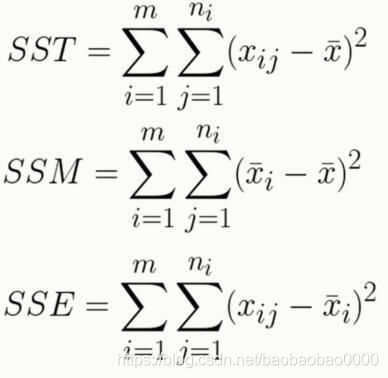

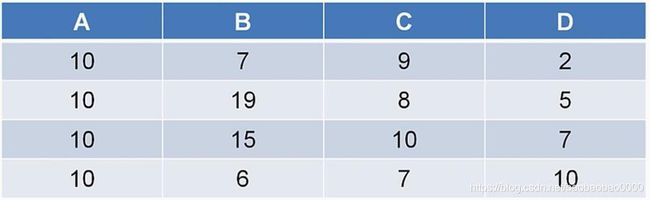

比如有三种电池,我们想看一下它们的寿命的均值是不是有差别。我们就可以使用方差检验方法。这里有两个参数大家需要重点关注一下,如图m,n。下面介绍三个公式。

1.第一个SST是用每个数据的数据值减去也就是刚才所说的那15个数据的均值,也就是每个数据减去均值它的平方和;

2.第二个SSM是指每一组的均值减去总体的均值的平方和;

3.最后一个SSE是每一个数减去它所属的组的平均值的平方和。

4.一般情况下带有SS指的都是平方和。SST就叫做总变差平方和;SSM叫做平均平方和,因为它指的是每个组与整体均值的平方和,所以也叫组间平方和;SSE就是残差平方和,因为它是指每个组内部的平方和,所以也叫组内平方和。

那么方差检验的检验统计量是什么呢?如下图:

知道了检验统计量,下面我们就可以开始我们的方差检验了。

第一步,我们还是确定它的原假设,也就是它们三个的均值是一定的,它们是没有差别的;

第二步,检验统计量我们也可以确定了是F值;

第三步,显著性水平还是设成0.05

第四步,计算

我们可以计算每个组的均值,分别是44.2,30和42.6,总体均值是38.93,然后求得SSM、SSE以及F的值,并且查表得到p的值如下:

p的值为0.00027小于0.05,所以可以拒绝原假设。即他们三者的均值是有差异的,而并不是没有差异的。

4.4 相关系数

1.相关系数是衡量两组数据或者说两组样本的分布趋势,变化趋势一致性程度的因子。相关系数有正相关负相关不相关之分。

2.相关系数越大越接近于1,二者变化趋势越正向同步。也就是说一个变大另一个也变大;一个变小另一个也跟着变小。

3.那么相关系数越小越接近于-1,二者的变化趋势越反向同步,也就是说一个数据变大,另外一个数据就会变小。

4.那么相关系数趋近于0,这二者可以认为是没有相关关系的。

常用的相关系数有两种:皮尔逊相关系数和斯皮尔曼相关系数。

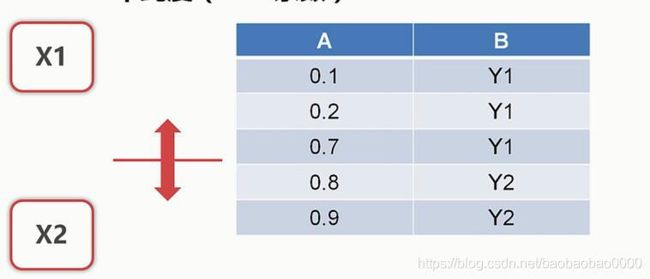

(1)我们先来介绍一下皮尔逊相关系数,皮尔逊相关系数的形式如下:

皮尔逊相关系数它的分子是两组数的斜方差,而分母是两组数据的标准差的积。标准差的级相当于一个归一化因子。那么斜方差的定义展开就像右边的展开式一样。两组数据各减去它的均值,再进行相乘,取它的期望值。再看看上面两组小例子。

我们先计算第一个例子,E(X)=2/3,E(Y)=4/3,求出X-E(x)=(1/3, -2/3, 1/3),Y-E(Y)=(2/3, -4/3, 2/3),再求出他们的期望为:

(1/3 * 2/3 + (-2/3) * (-4/3) + 1/3 * 2/3)/3 = 4/9,分子部分计算完毕

分母部分直接求出他们的方差再开方即可,结果也为4/9。故最后的结果r = 1。下面例子同理可求。

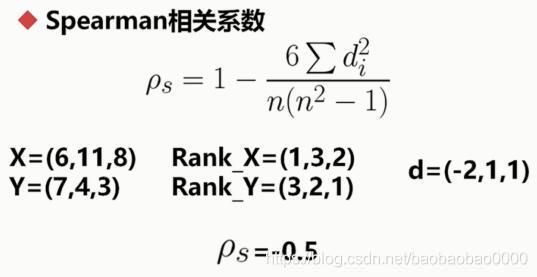

(2)我们再来介绍一下皮尔逊相关系数,皮尔逊相关系数的形式如下:

这里的n指的是每组数据的数量,这里的d指的是两组数据排名后的名次差。下面来看上述图片中的例子。

X值如上,X排名后,从小到大排列6排第一,11排第三,8排第二。同理Y也是如此。然后把排名后的名次做差值得到d。然后带入公式得到ρs = -0.5,那么斯皮尔曼相关系数就是负的0.5。

斯皮尔曼相关系数只跟它的名次差有关。它跟具体的数值关系不是那么大,这点和皮尔逊相关系数是不一样的。比如说我们把x的6换成一个更小的数,那么它的斯皮尔曼相关系数也不变,还是-0.5。同理Y也是如此。所以斯皮尔曼相关系数应用于相对比较的情况下比较适合。

4.5 线性回归

什么是回归?

回归是指确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法。

那么如果所谓的因变量与自变量的这种依赖关系是线性的关系,那么就是线性回归。线性回归最常见的解法就是最小二乘法。最小二乘法的本质就是最小化误差的平方的方法。公式如下:

这个方程相信大家都很熟悉,最小二乘法。那么通过这样的公式,求出它的因子b再求出它的结局a,就可以得到它的回归方程,这个公式高中大学都学过,具体原理可以网上查阅,这里不再赘述。具体可以参考链接:https://blog.csdn.net/weixin_38278993/article/details/100556051。

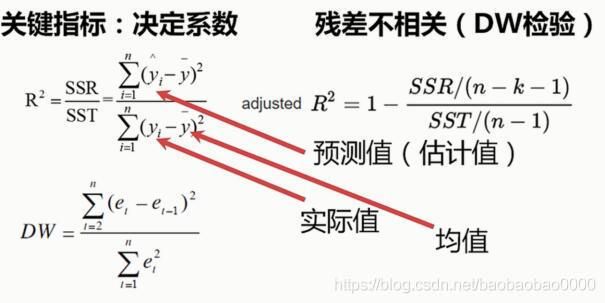

线性回归的效果的判定,主要有以下两种度量:一个是决定系数;另外一个是残差不相关。相关参数如下:

左边的决定系数R²代表一元线性回归的决定系数的定义。那么右边是多元决定系数的定义。这里也有SSR和SST的概念。

注意看y上面带个箭头代表是预测值也叫估计值,这里的yi直接指的就是实际值。你这里的y_8指的就是整体的均值。

那么通过这样的公式就可以得到我们所谓的决定系数。那么决定这个决定系数越接近于1,说明它的回归效果是越好;越接近于0,它的回归效果就越差。那么对于多元线性回归的情况来说,采用了一种叫做校正式的决定系数,就如上图右侧所示,这里的k指的就是参数的个数。

此外,还有一个检验指标就是DW检验,定义如上图。这里的e指的是它的残差,残差就是预测值与实际值的差。比如说有10个回归预测值,就可以得到10组残差,将这些残差值以自变量从小到大的顺序排序,然后代入这个公式得到DW的值。那么这个值的范围是从0~4的。值为2代表残差不相关;接近于4代表残差正相关;接近于零代表残差负相关。

那么好的回归它的残差应该是不相关的,也就是说它的DW值是接近于二的。

4.6 主成分分析

(1)我们在学习矩阵理论的时候,常把一个数据表看做一个空间,看做一个矩阵。那么这个矩阵的行对应每个数据对象的各个属性,矩阵的列就代表一个属性的不同内容。我们也常把每个属性当作由整个这张表构成空间的一个维度,每行所代表的实体代表的就是一个向量,这个表的内容代表的就是一个巨大的空间。下面来看个例子:

(2)这张表里有4个属性,每个属性都是一个维度。每一行的数据都包含4个维度,构成1个向量。虽然每1个向量有4个维度,但维度也是有主要次要之分的,比如维度A或者说是属性A。它就是一个比较次要的维度,因为通过它我们不能把几个对象区分开来,而维度b它的区分度就比较大,就可以认为是个明显的维度,是个主要的成分。更为灵活的可以通过正交变换将一组可能存在相关性的变量转化为一组线性不相关的变量。这一点相信学过线性代数的同学一定非常了解,在转化后的新的维度上,有的尺度被拉伸,有的尺度被收缩,我们取最能代表转化后维度的成分及尺度比较大的维度,就是主成分。

(3)那么相应的分析就是我们这里讲的主成分分析。那么这个变换过程就是PCA变换。PCA变换的一般过程为:

第一步求特征的斜方差矩阵;

第二步求斜方差矩阵的特征值和特征向量;

第三步将特征值按照从大到小的顺序排序,选择其中最大的k个;

第四步将样本点投影到选取的特征向量上

(4)下面让我们来看个例子

那么这张表里就有两个属性,而每条数据所对应的就有两个维度,那么它们构成的空间也就是一个我们所谓的二维空间,下面演示一下PCA变换的一般方法:

第一步求它的斜方差矩阵,即:

COV(X,X) COV(X,Y)

COV(Y,X) COV(Y,Y)

第二步,求它的特征值和特征向量,如上;

第三步,我们可以发现由于第二个特征值1.28,它远大于第一个特征值0.049,所以我们就可以用第二个特征值所代表的特征向量进行转换;

第四步,然后我们用它转换转换成了右边表的这么一个形式,注意这里矩阵相乘的形式是:x减去它的平均值,同时y再减去它的平均值,再和1.28对应特征向量进行相乘,最后得到最右边的矩阵。

这样就得到了它的主成分。再次提醒这不是两个矩阵直接相乘!!!

(5)主成分分析最重要的一个作用就是降维,有的时候我们会得到一个数据量,它的维度特别多,比如说它可能有几百个维度或者几千个维度,那么有些维度就是没有必要的,所以我们这个时候就需要把它最主要的成分提出来。通过主成分分析,我们已尽可能减少了失真,减少了比较大的工作量,使得后续的分析更加的快速简单。

(6)除了基本的PCA方法以外,奇异值分解也是一种常用的线性降维与成分提取的思路。那么奇异值分解也可以认为是一种PCA的方法。下面我们简单介绍一下:

奇异值分解它是将矩阵分解成如下形式:

中间是一个半正定矩阵,奇异值矩阵前后两个是两个酉阵,酉阵在实数域其实就是单位矩阵的意思。如果纠的更深的话,我们可以知道前面这个U代表在当前空间下的一组正交基,而后面V是指在进行变换后的空间下的一组正交基。通过奇异值矩阵的奇异值维度,比如取最大的一些奇异值,去掉一些较小的奇异值,同时缩小U和V的规模,就可以尽可能保留最主要的信息的情况下,减少数据的维度。

奇异值分解的方法涉及到矩阵理论的一些知识,涉及到的理论还是比较深的,比如说它是怎么推导的。这里我们就不多介绍了,感兴趣的可以翻开线性代数自行学习。我们这里先记住这个思路和方法,留着以后需要的时候用。

4.7 代码实现

import numpy as np

import scipy.stats as ss

norm_dist = ss.norm.rvs(size=20) # 得到10个符合正态分布的数字

norm_dist

array([-0.33982896, -0.88293333, 1.13265041, 0.69182951, -1.61654312,

-0.02629395, 0.84198628, -0.02742766, 0.7281102 , -0.66801634,

1.14688624, -1.69580756, -1.67286388, 0.04195395, -0.24226755,

0.86773833, -1.47738387, -3.11796742, 0.07911875, 0.03645439])

ss.normaltest(norm_dist) # p>0.05处于接受域,基于偏度与峰度检验。

NormaltestResult(statistic=2.6216280351175265, pvalue=0.2696005074915336)

# 检验前面男女化妆例子例子,卡方检验

ss.chi2_contingency([[15, 95], [85, 5]])

# 第一个为检验统计量,第二个为p值,第三个为自由度,最后是理论分布

(126.08080808080808, 2.9521414005078985e-29, 1, array([[55., 55.],

[45., 45.]]))

# 独立t分布检验,检验两组值的均值有没有比较大的差异。遗忘的看看看前面内容

ss.ttest_ind(ss.norm.rvs(size=10), ss.norm.rvs(size=20))

Ttest_indResult(statistic=-1.8019008653997095, pvalue=0.08233819563557086)

# 放大值在看看结果。数据量越大,越能看出两个均值没差别

ss.ttest_ind(ss.norm.rvs(size=100), ss.norm.rvs(size=200))

Ttest_indResult(statistic=1.7615634824839101, pvalue=0.07916848366958461)

# 方差检验,继续参考前面例子

ss.f_oneway([49, 50, 39, 40, 43], [28, 32, 30, 26, 34], [38, 40, 45, 42, 48])

F_onewayResult(statistic=17.619417475728156, pvalue=0.0002687153079821641)

# qq图来对比一个分布是否符合一个已知分布。我们得到一个分布,

# 可以找到它的分位数,然后对应的分位数找到正态分布的分位数。横轴是正态分布的分位数的值,

# 纵轴是已知分布的值,这样就可以得到一个曲线。这个图如果正对xy轴角平分线,

# 与角平分线重合,那就是符合分布

from statsmodels.graphics.api import qqplot

from matplotlib import pyplot as plt

plt.show(qqplot(ss.norm.rvs(size=100)))

# qq图默认检验一个分布是否是正态分布,所以输入一个分布也可

# 下图基本处于角平分线上

# 相关系数

import pandas as pd

s1 = pd.Series([0.1, 0.2, 1.1, 2.4, 1.3, 0.3, 0.5])

s2 = pd.Series([0.5, 0.4, 1.2, 2.5, 1.1, 0.7, 0.1])

s1.corr(s2) '

# 求s1 s2相关系数

0.9333729600465923

s1.corr(s2, method="spearman") # 指定斯皮尔曼相关系数

0.7142857142857144

df = pd.DataFrame([s1, s2])

print(df)

df.corr() # 针对列进行计算的

0 1 2 3 4 5 6

0 0.1 0.2 1.1 2.4 1.3 0.3 0.5

1 0.5 0.4 1.2 2.5 1.1 0.7 0.1

| 0 | 1 | 2 | 3 | 4 | 5 | 6 | |

|---|---|---|---|---|---|---|---|

| 0 | 1.0 | 1.0 | 1.0 | 1.0 | -1.0 | 1.0 | -1.0 |

| 1 | 1.0 | 1.0 | 1.0 | 1.0 | -1.0 | 1.0 | -1.0 |

| 2 | 1.0 | 1.0 | 1.0 | 1.0 | -1.0 | 1.0 | -1.0 |

| 3 | 1.0 | 1.0 | 1.0 | 1.0 | -1.0 | 1.0 | -1.0 |

| 4 | -1.0 | -1.0 | -1.0 | -1.0 | 1.0 | -1.0 | 1.0 |

| 5 | 1.0 | 1.0 | 1.0 | 1.0 | -1.0 | 1.0 | -1.0 |

| 6 | -1.0 | -1.0 | -1.0 | -1.0 | 1.0 | -1.0 | 1.0 |

df = pd.DataFrame(np.array([s1, s2]).T) # 转换成array再转置

df.corr()

| 0 | 1 | |

|---|---|---|

| 0 | 1.000000 | 0.933373 |

| 1 | 0.933373 | 1.000000 |

df.corr(method="spearman") # 指定方法斯皮尔曼

| 0 | 1 | |

|---|---|---|

| 0 | 1.000000 | 0.714286 |

| 1 | 0.714286 | 1.000000 |

# 回归实例

x = np.arange(10).astype(np.float).reshape((10, 1))

y = x*3+4 + np.random.random((10, 1))

x

array([[0.],

[1.],

[2.],

[3.],

[4.],

[5.],

[6.],

[7.],

[8.],

[9.]])

y

array([[ 4.29083244],

[ 7.68188036],

[10.0819889 ],

[13.79384548],

[16.69582671],

[19.9952564 ],

[22.96593519],

[25.90420949],

[28.65785762],

[31.68954354]])

from sklearn.linear_model import LinearRegression

reg = LinearRegression()

res = reg.fit(x, y) # 拟合

y_pred = reg.predict(x)

y_pred

array([[ 4.448071 ],

[ 7.49865914],

[10.54924727],

[13.59983541],

[16.65042354],

[19.70101168],

[22.75159982],

[25.80218795],

[28.85277609],

[31.90336423]])

reg.coef_

array([[3.05058814]])

reg.intercept_

array([4.448071])

# PCA变换,还是前面那个例子,忘记的可以向前翻阅,就是data x y那个表格例子

data = np.array([np.array([2.5, 0.5, 2.2, 1.9, 3.1, 2.3, 2, 1, 1.5, 1.1]),

np.array([2.4, 0.7, 2.9, 2.2, 3, 2.7, 1.6, 1.1, 1.6, 0.9])]).T

data

array([[2.5, 2.4],

[0.5, 0.7],

[2.2, 2.9],

[1.9, 2.2],

[3.1, 3. ],

[2.3, 2.7],

[2. , 1.6],

[1. , 1.1],

[1.5, 1.6],

[1.1, 0.9]])

from sklearn.decomposition import PCA

'''

n_components:

意义:PCA算法中所要保留的主成分个数n,也即保留下来的特征个数n

类型:int 或者 string,缺省时默认为None,所有成分被保留。

赋值为int,比如n_components=1,将把原始数据降到一个维度。

赋值为string,比如n_components='mle',将自动选取特征个数n,使得满足所要求的方差百分比。

'''

lower_dim = PCA(n_components=1) # 降维

lower_dim.fit(data) # 修改data维度

PCA(copy=True, iterated_power='auto', n_components=1, random_state=None,

svd_solver='auto', tol=0.0, whiten=False)

lower_dim.explained_variance_ratio_ # 维度的重要性,降维后得到了96%的信息量

array([0.96318131])

lower_dim.fit_transform(data) # 得到转化后的数值

array([[-0.82797019],

[ 1.77758033],

[-0.99219749],

[-0.27421042],

[-1.67580142],

[-0.9129491 ],

[ 0.09910944],

[ 1.14457216],

[ 0.43804614],

[ 1.22382056]])

注意:sklearn的PCA算法是基于奇异值矩阵的

# 下面开始动手写一个具体说明的PCA方法

from scipy import linalg

def myPCA(data, n_components = 10000000):

mean_vals = np.mean(data, axis=0) # 对列求均值

mid = data - mean_vals

cov_mat = np.cov(mid, rowvar=False) # 求协方差矩阵

eig_vals, eig_vects = linalg.eig(np.mat(cov_mat)) # 求出协方差矩阵的特征值特征向量

eig_val_index = np.argsort(eig_vals) # 按照升序(从小到大)进行快速排序,返回的是原数组的下标

eig_val_index = eig_val_index[:-(n_components+1):-1]

eig_vects = eig_vects[:, eig_val_index]

low_dim_mat = np.dot(mid, eig_vects)

return low_dim_mat, eig_vals

data = np.array([np.array([2.5, 0.5, 2.2, 1.9, 3.1, 2.3, 2, 1, 1.5, 1.1]),

np.array([2.4, 0.7, 2.9, 2.2, 3, 2.7, 1.6, 1.1, 1.6, 0.9])]).T

myPCA(data, n_components=1) # 显示结果如下,和我们计算的结果基本一致

(array([[-0.82797019],

[ 1.77758033],

[-0.99219749],

[-0.27421042],

[-1.67580142],

[-0.9129491 ],

[ 0.09910944],

[ 1.14457216],

[ 0.43804614],

[ 1.22382056]]), array([0.0490834 +0.j, 1.28402771+0.j]))

4.8 交叉分析方法与实现

接下来我们基于之前学习到的理论知识来进行属性间的数据分析。我们主要接触以下几种分析方法:

1.交叉分析

2.分组和钻取

3.相关分析

4.因子分析

5.回归分析

6.聚类分析

后面两个分析本章节不讲,后面细说。

(1)交叉分析

我们得到了一张数据表,需要进行分析的时候,最直观的我们有两个分析的切入点。一个是从列的角度进行分析,分析每个属性的特点并进行归纳和总结。另一个从行的角度进行分析,从case即案例的角度进行分析,尤其当数据有了标注的时候,以标注为关注点。案例分析越多,也就越接近于数据整体的质量。这两种分析方法也是最为浅层次的分析,如果仅仅进行这两方面的分析,有时并不能得到最为真实最为客观的结论。这是因为直接使用这种纵向分析和横向分析,忽略了数据间属性间的关联性,也就是说很可能有信息的失真。所以我们需要分析属性和属性之间的关系,得到更多的能反映数据内涵的信息。交叉分析就是一种重要的分析属性和属性之间关系的方法,交叉分析的含义比较广,所涉及到的分析方法也比较多。比如我们可以任意取两列,也就是两个属性,根据我们所学到的假设检验的方法来判断他们之间是否有联系。

也可以直接以一个或几个属性为行,令一个或几个属性为列做成一张交叉表也叫透视表。通过关注这张新生成的表的性质,可以更直观的分析两个属性或者几个属性之间的关系。

(2)下面我们进行代码演示

import pandas as pd

import numpy as np

import scipy.stats as ss

import matplotlib.pyplot as plt

import seaborn as sns

df = pd.read_csv("HR.csv")

df.tail()

| satisfaction_level | last_evaluation | number_project | average_montly_hours | time_spend_company | Work_accident | left | promotion_last_5years | department | salary | |

|---|---|---|---|---|---|---|---|---|---|---|

| 14994 | 0.40 | 0.57 | 2 | 151 | 3 | 0 | 1 | 0 | support | low |

| 14995 | 0.37 | 0.48 | 2 | 160 | 3 | 0 | 1 | 0 | support | low |

| 14996 | 0.37 | 0.53 | 2 | 143 | 3 | 0 | 1 | 0 | support | low |

| 14997 | 0.11 | 0.96 | 6 | 280 | 4 | 0 | 1 | 0 | support | low |

| 14998 | 0.37 | 0.52 | 2 | 158 | 3 | 0 | 1 | 0 | support | low |

# 得到各个部门离职率之间是否有差异,先得到各个部门的离职分布,

# 然后两两间求他们的t检验统计量并求出p值

dp_indices = df.groupby(by = "department").indices

dp_indices

{'IT': array([ 61, 62, 63, ..., 14932, 14933, 14938], dtype=int64),

'RandD': array([ 301, 302, 303, 304, 305, 453, 454, 455, 456,

457, 605, 606, 607, 608, 609, 833, 834, 835,

836, 837, 985, 986, 987, 988, 989, 1061, 1062,

1063, 1064, 1065, 1217, 1218, 1219, 1291, 1292, 1293,

1294, 1295, 1296, 1368, 1369, 1370, 1371, 1372, 1373,

1445, 1446, 1447, 1448, 1449, 1450, 1522, 1523, 1524,

1525, 1526, 1598, 1599, 1600, 1601, 1602, 1675, 1676,

1677, 1678, 1679, 1751, 1752, 1753, 1754, 1755, 1827,

1828, 1829, 1830, 1831, 1903, 1904, 1905, 1906, 1907,

1979, 1980, 1981, 1982, 1983, 2055, 2056, 2057, 2058,

2059, 2131, 2132, 2133, 2134, 2135, 2207, 2208, 2209,

2210, 2211, 2283, 2284, 2285, 2286, 2287, 2359, 2360,

2361, 2362, 2363, 2435, 2436, 2437, 2438, 2439, 2511,

2512, 2513, 2514, 2515, 2588, 2589, 2590, 2591, 2592,

2593, 2665, 2666, 2667, 2668, 2669, 2670, 2742, 2743,

2744, 2745, 2746, 2747, 2819, 2820, 2821, 2822, 2823,

2824, 2896, 2897, 2898, 2899, 2900, 2972, 2973, 2974,

2975, 2976, 3049, 3050, 3051, 3052, 3053, 3125, 3126,

3127, 3128, 3129, 3201, 3202, 3203, 3204, 3205, 3277,

3278, 3279, 3280, 3281, 3353, 3354, 3355, 3356, 3357,

3429, 3430, 3431, 3432, 3433, 3505, 3506, 3507, 3508,

3509, 3581, 3582, 3583, 3584, 3585, 3657, 3658, 3659,

3660, 3661, 3733, 3734, 3735, 3736, 3737, 3809, 3810,

3811, 3812, 3813, 3885, 3886, 3887, 3888, 3889, 3962,

3963, 3964, 3965, 3966, 3967, 4039, 4040, 4041, 4042,

4043, 4044, 4116, 4117, 4118, 4119, 4120, 4121, 4193,

4194, 4195, 4196, 4197, 4198, 4270, 4271, 4272, 4273,

4274, 4346, 4347, 4348, 4349, 4350, 4423, 4424, 4425,

4426, 4427, 4499, 4500, 4501, 4502, 4503, 4575, 4576,

4577, 4578, 4579, 4651, 4652, 4653, 4654, 4655, 4727,

4728, 4729, 4730, 4731, 4803, 4804, 4805, 4806, 4807,

4879, 4880, 4881, 4882, 4883, 4955, 4956, 4957, 4958,

4959, 5031, 5032, 5033, 5034, 5035, 5107, 5108, 5109,

5110, 5111, 5183, 5184, 5185, 5186, 5187, 5259, 5260,

5261, 5262, 5263, 5336, 5337, 5338, 5339, 5340, 5341,

5413, 5414, 5415, 5416, 5417, 5418, 5490, 5491, 5492,

5493, 5494, 5495, 5567, 5568, 5569, 5570, 5571, 5572,

5644, 5645, 5646, 5647, 5648, 5720, 5721, 5722, 5723,

5724, 5797, 5798, 5799, 5800, 5801, 5873, 5874, 5875,

5876, 5877, 5949, 5950, 5951, 5952, 5953, 6025, 6026,

6027, 6028, 6029, 6101, 6102, 6103, 6104, 6105, 6177,

6178, 6179, 6180, 6181, 6253, 6254, 6255, 6256, 6257,

6329, 6330, 6331, 6332, 6333, 6405, 6406, 6407, 6408,

6409, 6481, 6482, 6483, 6484, 6485, 6557, 6558, 6559,

6560, 6561, 6633, 6634, 6635, 6636, 6637, 6710, 6711,

6712, 6713, 6714, 6715, 6787, 6788, 6789, 6790, 6791,

6792, 6864, 6865, 6866, 6867, 6868, 6869, 6941, 6942,

6943, 6944, 6945, 6946, 7018, 7019, 7020, 7021, 7022,

7094, 7095, 7096, 7097, 7098, 7171, 7172, 7173, 7174,

7175, 7247, 7248, 7249, 7250, 7251, 7323, 7324, 7325,

7326, 7327, 7399, 7400, 7401, 7402, 7403, 7475, 7476,

7477, 7478, 7479, 7551, 7552, 7553, 7554, 7555, 7627,

7628, 7629, 7630, 7631, 7703, 7704, 7705, 7706, 7707,

7779, 7780, 7781, 7782, 7783, 7855, 7856, 7857, 7858,

7859, 7931, 7932, 7933, 7934, 7935, 8007, 8008, 8009,

8010, 8011, 8084, 8085, 8086, 8087, 8088, 8089, 8161,

8162, 8163, 8164, 8165, 8166, 8238, 8239, 8240, 8241,

8242, 8243, 8315, 8316, 8317, 8318, 8319, 8320, 8392,

8393, 8394, 8395, 8396, 8468, 8469, 8470, 8471, 8472,

8545, 8546, 8547, 8548, 8549, 8621, 8622, 8623, 8624,

8625, 8697, 8698, 8699, 8700, 8701, 8773, 8774, 8775,

8776, 8777, 8849, 8850, 8851, 8852, 8853, 8925, 8926,

8927, 8928, 8929, 9001, 9002, 9003, 9004, 9005, 9077,

9078, 9079, 9080, 9081, 9153, 9154, 9155, 9156, 9157,

9229, 9230, 9231, 9232, 9233, 9305, 9306, 9307, 9308,

9309, 9381, 9382, 9383, 9384, 9385, 9535, 9536, 9537,

9538, 9539, 9540, 9689, 9690, 9691, 9692, 9693, 9694,

9766, 9767, 9768, 9769, 9770, 10147, 10148, 10149, 10150,

10151, 10223, 10224, 10225, 10226, 10227, 10299, 10300, 10301,

10302, 10303, 10375, 10376, 10377, 10378, 10379, 10451, 10452,

10453, 10454, 10455, 10527, 10528, 10529, 10530, 10531, 10603,

10604, 10605, 10606, 10607, 10679, 10680, 10681, 10682, 10683,

10755, 10756, 10757, 10758, 10759, 10832, 10833, 10834, 10835,

10836, 10837, 10909, 10910, 10911, 10912, 10913, 10914, 10986,

10987, 10988, 10989, 10990, 10991, 11001, 11002, 11003, 11004,

11005, 11006, 11179, 11180, 11181, 11182, 11183, 11184, 11478,

11479, 11480, 11481, 11482, 11483, 11659, 11660, 11661, 11662,

11663, 11664, 12301, 12302, 12303, 12304, 12305, 12453, 12454,

12455, 12456, 12457, 12605, 12606, 12607, 12608, 12609, 12814,

12815, 12816, 12817, 12818, 12890, 12891, 12892, 12893, 12894,

12966, 12967, 12968, 12969, 12970, 13043, 13044, 13045, 13046,

13047, 13048, 13120, 13121, 13122, 13123, 13124, 13125, 13197,

13198, 13199, 13200, 13201, 13202, 13212, 13213, 13214, 13215,

13216, 13217, 13390, 13391, 13392, 13393, 13394, 13395, 13689,

13690, 13691, 13692, 13693, 13694, 13870, 13871, 13872, 13873,

13874, 13875, 14512, 14513, 14514, 14515, 14516, 14664, 14665,

14666, 14667, 14668, 14816, 14817, 14818, 14819, 14820, 14939,

14940, 14941, 14942, 14943], dtype=int64),

'accounting': array([ 28, 29, 30, 79, 105, 106, 107, 155, 181,

182, 183, 224, 225, 232, 258, 259, 260, 308,

334, 335, 336, 377, 378, 384, 410, 411, 412,